"Rapport sur la puissance des machines" je ne sais toujours pas comment l'utiliser. L'industrie de la vidéo IA se « bat » à nouveau ! Le 29 juin, la célèbre plateforme d'IA générative Runway a annoncé que son dernier modèle Gen-3 Alpha avait commencé à tester pour certains utilisateurs.

Cela a rendu les internautes extrêmement heureux : "Juin, quel mois merveilleux !"

"Mai fou, juin fou, tellement fou que je ne peux pas m'arrêter !"

-1-

Runway tue Hollywood

Il y a deux semaines, lorsque la vidéo AI "King" Runway a lancé un nouveau modèle de génération vidéo Gen-3 Alpha, il Aperçu -

sera d'abord sera disponible pour les utilisateurs payants "d'ici quelques jours", et la version gratuite sera également ouverte à tous les utilisateurs à un moment donné dans le futur.

sera d'abord sera disponible pour les utilisateurs payants "d'ici quelques jours", et la version gratuite sera également ouverte à tous les utilisateurs à un moment donné dans le futur.

Gen-3 Alpha est très recherché car par rapport à la génération précédente, il a réalisé des améliorations significatives en termes de lumière et d'ombre, de qualité, de composition, de restauration sémantique du texte, de simulation physique et de cohérence des actions. Même le slogan est "Pour". artistes, par des artistes (nés pour les artistes, nés par des artistes)".

Quel est l'effet du Gen-3 Alpha ? Les internautes impliqués dans les compositions florales ont toujours eu le plus leur mot à dire. Ensuite, profitez-en -

Séquence de film d'un monstre terrifiant s'élevant de la Tamise à Londres :Un ours en peluche triste pleure, pleure jusqu'à ce qu'il soit triste et se mouche avec un mouchoir :

Une jeune britannique vêtue d'une magnifique robe marche dans la rue où se trouve le château, avec des véhicules à grande vitesse et des chevaux lents à ses côtés :

Un énorme lézard, parsemé de magnifiques bijoux et de perles, se promène à travers une végétation dense. Les lézards scintillent dans la lumière et les images sont aussi réalistes qu'un documentaire.

Un énorme lézard, parsemé de magnifiques bijoux et de perles, se promène à travers une végétation dense. Les lézards scintillent dans la lumière et les images sont aussi réalistes qu'un documentaire.

Il y a aussi un crapaud incrusté de diamants recouvert de rubis et de saphirs :

Dans les rues de la ville la nuit, la pluie crée le reflet des néons.

La caméra part de la lumière réfléchie dans la flaque d'eau, monte lentement pour montrer le panneau d'affichage au néon lumineux, puis continue de zoomer en arrière pour montrer toute la rue trempée par la pluie.

Le mouvement de la caméra : viser d'abord le reflet dans la flaque d'eau, puis la soulever et la retirer d'un seul coup pour montrer le paysage urbain par cette nuit pluvieuse.

Lien vidéo : https://www.php.cn/link/dbf138511ed1d9278bde43cc0000e49a

La moisissure jaune qui pousse dans la boîte de Pétri, sous la lumière tamisée et mystérieuse, montre une couleur froide et pleine de dynamique.

Dans la forêt d'automne, le sol est couvert de diverses feuilles tombées orange, jaunes et rouges.

Une légère brise a soufflé et la caméra s'est avancée près du sol. Un tourbillon a commencé à se former, ramassant les feuilles tombées et formant une spirale. La caméra s'élève avec les feuilles tombées et tourne autour de la colonne de feuilles en rotation.

Lien vidéo : https://www.php.cn/link/dbf138511ed1d9278bde43cc0000e49a

Partant d'une perspective basse d'un tunnel couvert de graffitis, la caméra avance régulièrement le long de la route, à travers une courte et sombre Dans la section tunnel, la caméra s'élève rapidement lorsqu'elle apparaît de l'autre côté, montrant un grand champ de fleurs sauvages colorées entouré de montagnes aux sommets enneigés.

Lien vidéo : https://www.php.cn/link/dbf138511ed1d9278bde43cc0000e49a

Un gros plan de jouer du piano, les doigts sautant sur les touches, pas de distorsion des mains, des mouvements fluides, le seul L'inconvénient est qu'il n'y a pas de bague à l'annulaire, mais l'ombre "sort de rien".

Les internautes ont également fait ressortir le co-fondateur de Runway, Cristóbal Valenzuela, qui a généré une vidéo pour sa caméra abeille faite maison.

Placez la caméra sur le dos de l'abeille, et la scène capturée est comme ceci :

Lien vidéo : https://www.php.cn/link/dbf138511ed1d9278bde43cc0000e49a

Mettez-la sur le visage de l'abeille C'est violet :

Lien vidéo : https://www.php.cn/link/dbf138511ed1d9278bde43cc0000e49a

Alors, à quoi ressemble cette caméra de poche ?

Si l'IA continue d'évoluer ainsi, les acteurs hollywoodiens se mettront à nouveau en grève.

-2-

Nouvelle fonction d'image clé de Luma, transition d'image fluide

Le 29 juin, Luma AI a lancé la fonction d'image clé, et d'un simple geste de la main, elle a été directement ouverte à tous les utilisateurs gratuitement.

Les utilisateurs n'ont qu'à télécharger les images de début et de fin et à ajouter des descriptions textuelles, et Luma peut générer des vidéos d'effets spéciaux de niveau hollywoodien.

Par exemple, l'internaute X @hungrydonke a mis en ligne deux photos clés :

|

|

Ensuite, entrez le mot d'invite : Un tas de confettis noirs tombe soudainement (Soudain, un tas de confettis noirs tombe soudainement) L'effet est le suivant -

L'internaute @JonathanSolder3 a d'abord utilisé Midjourney pour générer deux images :

|

|

Utilisez ensuite la fonction d'image clé Luma pour générer une animation de transformation Super Saiyan. Selon l'auteur, Luma n'a pas besoin d'une invite de mise sous tension, entrez simplement « Super Saiyan ».

Lien vidéo : https://www.php.cn/link/dbf138511ed1d9278bde43cc0000e49a

Certains internautes utilisent cette fonction pour compléter la transition de chaque plan, mélangeant ainsi des contes de fées classiques pour générer un segment appelé Animation "Le loup", le guerrier et l'armoire magique.

Lien vidéo : https://www.php.cn/link/dbf138511ed1d9278bde43cc0000e49a

Le diable se transforme en ange :

Orange se transforme en poussin :

Transformation du logo Starbucks :

Lien vidéo : https://www.php.cn/link/dbf138511ed1d9278bde43cc0000e49a

L'industrie vidéo IA est tellement anxieuse. Dieu sait comment Sora peut garder son sang-froid et ne pas se montrer avant maintenant.-3-

Yann LeCun "Bombardment" : Ils ne comprennent pas du tout la physique

Lorsque Sora est sorti en début d'année, le "modèle mondial" est soudainement devenu un concept brûlant.

Plus tard, le Génie de Google a également utilisé la bannière de « modèle mondial ». Lorsque Runway a lancé cette fois Gen-3 Alpha, le responsable a déclaré qu'il « avait franchi une étape importante vers la construction d'un modèle mondial universel ».

Qu’est-ce qu’un modèle mondial exactement ?

En fait, il n'existe pas de définition standard de cela, mais les scientifiques en IA pensent que les humains et les animaux comprendront subtilement les règles de fonctionnement du monde, afin de pouvoir « prédire » ce qui va se passer ensuite et agir. L’étude des modèles mondiaux vise à permettre à l’IA d’acquérir cette capacité.

Beaucoup de gens pensent que les vidéos générées par des applications telles que Sora, Luma et Runway sont assez réalistes et qu'elles peuvent également générer de nouveaux contenus vidéo par ordre chronologique. Ils semblent avoir appris la capacité de « prédire » l'évolution des choses. . Cela coïncide avec l’objectif poursuivi par la recherche sur les modèles mondiaux.

Cependant, Yann LeCun, lauréat du prix Turing, a "versé de l'eau froide".

Il estime : « Produire les vidéos les plus réalistes basées sur des invites ne signifie pas que le système comprend le monde physique, et générer des prédictions causales à partir de modèles du monde est très différent.

Le 1er juillet, Yann LeCun a publié 6 messages. » dans une rangée Modèles génératifs pour les vidéos de bombardement.

Il a retweeté une vidéo de gymnastique générée par l'IA. Les personnages de la vidéo ont soit vu leur tête disparaître de nulle part, soit quatre pattes sont soudainement apparues, et toutes sortes d'images étranges étaient partout.

Lien vidéo : https://www.php.cn/link/dbf138511ed1d9278bde43cc0000e49a

Yann LeCun a déclaré que le modèle de génération vidéo ne comprend pas les principes physiques de base, encore moins la structure du corps humain.

"Sora et d'autres modèles génératifs vidéo ont des problèmes similaires. Il ne fait aucun doute que la technologie de génération vidéo deviendra plus avancée avec le temps, mais un bon modèle mondial qui comprend vraiment la physique ne sera pas génératif "Tous les oiseaux et les mammifères comprennent physique meilleur que n'importe quel modèle de génération vidéo, mais aucun d'entre eux ne peut générer des vidéos détaillées", a déclaré Yann LeCun.

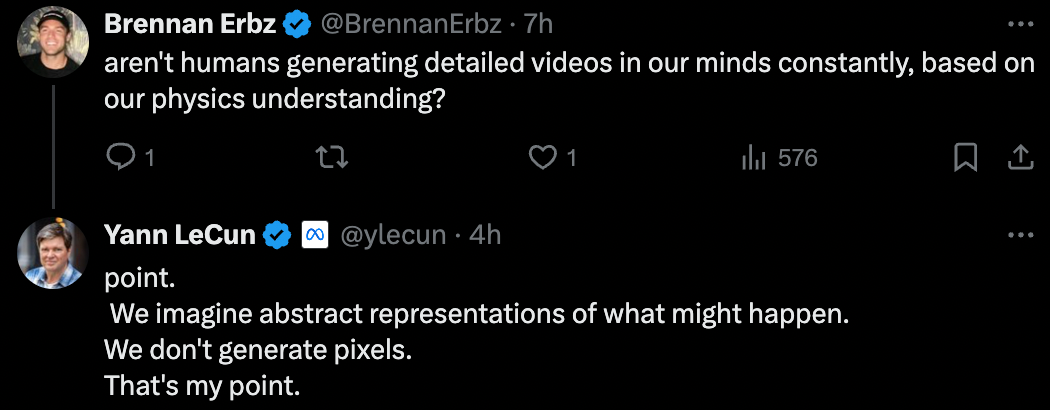

Certains internautes se sont interrogés : les humains ne génèrent-ils pas constamment des « vidéos » détaillées dans leur esprit en fonction de leur compréhension de la physique ?

Yann LeCun a répondu aux questions en ligne : "Nous envisageons des scénarios abstraits qui peuvent se produire, plutôt que de générer des images en pixels. C'est le point que je souhaite exprimer

Yann LeCun rétorque : Non, ils ne le font pas. Ils génèrent simplement des scénarios abstraits de ce qui pourrait arriver, ce qui est très différent de la génération de vidéos détaillées.  À l'avenir, nous proposerons davantage de démonstrations de cas AIGC à travers de nouvelles colonnes, et tout le monde est invité à rejoindre le groupe pour communiquer.

À l'avenir, nous proposerons davantage de démonstrations de cas AIGC à travers de nouvelles colonnes, et tout le monde est invité à rejoindre le groupe pour communiquer.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!