interface Web

interface Web

js tutoriel

js tutoriel

Construire des agents d'IA responsables : équilibrer innovation et éthique

Construire des agents d'IA responsables : équilibrer innovation et éthique

Construire des agents d'IA responsables : équilibrer innovation et éthique

L'intelligence artificielle (IA) transforme les secteurs, avec des agents d'IA autonomes comme AgentForce de Salesforce et des outils open source comme AutoGPT en tête. Ces agents automatisent des tâches complexes, collaborent avec d'autres systèmes et améliorent la productivité. Cependant, à mesure qu’ils deviennent plus autonomes, la nécessité d’un développement responsable de l’IA est essentielle pour résoudre des problèmes tels que les préjugés, la transparence et la responsabilité.

L'adoption rapide des agents d'IA a suscité des débats sur leurs implications éthiques. Bien qu’ils offrent un immense potentiel pour révolutionner des secteurs tels que la santé, l’éducation et la vente, ils présentent également des risques s’ils ne sont pas conçus de manière responsable. Les développeurs, les organisations et les gouvernements doivent travailler ensemble pour garantir que ces systèmes sont à la fois innovants et éthiques.

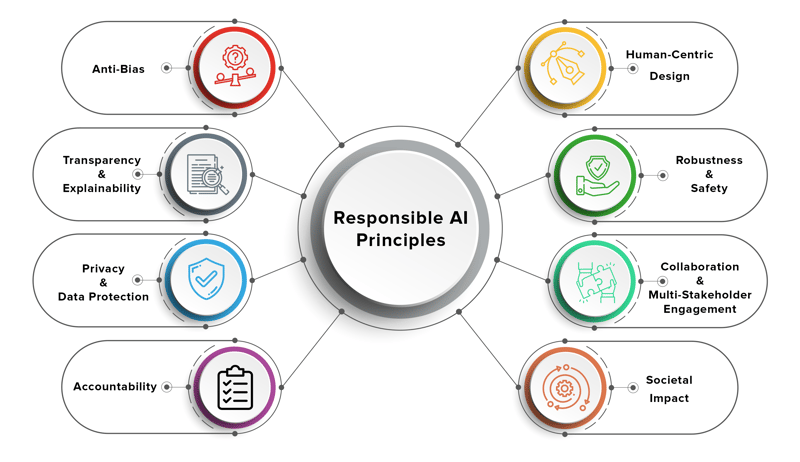

Que signifie créer des agents d’IA responsables ?

Les agents d'IA responsables sont conçus pour être éthiques, transparents et responsables, garantissant qu'ils s'alignent sur les valeurs humaines et minimisent les dommages. Ces agents doivent fonctionner de manière équitable, respecter la vie privée et fournir des explications claires sur leurs décisions.

Les principes clés d’une IA responsable comprennent :

- Équité : éviter les préjugés dans la prise de décision et garantir des résultats équitables pour tous les utilisateurs.

- Transparence : Rendre les décisions d'IA compréhensibles pour les utilisateurs et les parties prenantes.

- Responsabilité : Établir la responsabilité des résultats de l'IA et garantir que les systèmes peuvent être audités.

- Confidentialité : Protéger les données des utilisateurs et garantir des opérations sécurisées.

- Durabilité : Concevoir des systèmes d'IA économes en énergie et respectueux de l'environnement.

Construire une IA responsable n'est pas seulement un défi technique : c'est un effort multidisciplinaire qui nécessite une collaboration entre les développeurs, les éthiciens, les décideurs politiques et les utilisateurs finaux.

Exemples de dilemmes éthiques dans les systèmes d'IA

À mesure que les agents d’IA deviennent plus autonomes, ils sont confrontés à des dilemmes éthiques qui remettent en question leur conception et leur déploiement. Voici quelques exemples concrets :

1. Biais dans la prise de décision

Les agents d’IA formés sur des ensembles de données biaisés peuvent prendre des décisions discriminatoires. Par exemple :

- Un agent de recrutement peut privilégier certaines données démographiques par rapport à d'autres en raison de biais historiques dans les données de recrutement.

- Un agent d'IA financière peut refuser des prêts à des groupes spécifiques sur la base de modèles de notation de crédit biaisés.

2. Manque de transparence

De nombreux agents d'IA fonctionnent comme des « boîtes noires », prenant des décisions difficiles à interpréter ou à expliquer. Par exemple :

- Un agent IA du service client peut faire remonter ou résoudre des problèmes sans fournir de raisonnement clair, ce qui entraîne frustration et méfiance parmi les utilisateurs.

3. Lacunes en matière de responsabilité

Lorsqu’un agent IA commet une erreur, qui est responsable ? Par exemple :

- Si un véhicule autonome contrôlé par un agent IA provoque un accident, la faute en incombe-t-elle au développeur, au constructeur ou à l'utilisateur ?

4. Violations de la vie privée

Les agents d’IA ont souvent besoin d’accéder aux données sensibles des utilisateurs pour fonctionner efficacement. Cependant :

- Un agent commercial IA peut partager par inadvertance des informations confidentielles sur un client, en violation des lois sur la confidentialité telles que le RGPD.

5. Utilisation éthique de l'IA dans les ventes et le marketing

Des outils tels que AgentForce de Salesforce transforment les ventes et le marketing en automatisant la génération de leads et l'engagement client. Cependant :

- Si un agent IA utilise des tactiques de manipulation pour vendre des produits, cela soulève des questions sur les pratiques marketing éthiques.

Ces dilemmes soulignent l’importance d’intégrer des considérations éthiques dans la conception et le déploiement d’agents d’IA.

Cadres et bonnes pratiques pour un développement responsable de l’IA

Pour relever ces défis, les développeurs et les organisations peuvent adopter les cadres et bonnes pratiques suivants :

1. Cadres d'IA éthiques

Plusieurs organisations ont élaboré des lignes directrices pour une IA responsable, notamment :

- Principes d'IA de Google : axés sur l'équité, la confidentialité et la responsabilité.

- Principes de l'IA de l'OCDE : Mettre l'accent sur les valeurs centrées sur l'humain et la transparence.

- Directives éthiques de Salesforce en matière d'IA : visent à instaurer la confiance et à garantir l'équité dans les systèmes d'IA.

2. Atténuation des biais

- Utilisez des ensembles de données diversifiés et représentatifs pour former des agents IA.

- Auditez régulièrement les modèles d'IA pour détecter tout biais et recyclez-les si nécessaire.

- Mettre en œuvre des mesures d'équité pour évaluer l'impact des décisions de l'IA sur différents groupes.

3. Explicabilité et transparence

- Utilisez des techniques telles que S*HAP (SHapley Additive exPlanations)* ou LIME (Local Interpretable Model-agnostic Explanations) pour rendre les décisions d'IA interprétables.

- Fournissez aux utilisateurs des explications claires sur la façon dont les agents d'IA prennent des décisions.

4. Mécanismes de responsabilisation

- Établir des structures de gouvernance claires pour les projets d'IA.

- Attribuez la responsabilité des résultats de l'IA à des équipes ou des individus spécifiques.

- Maintenir des journaux détaillés des actions des agents IA à des fins d'audit.

5. Confidentialité et sécurité

- Utilisez le cryptage et des protocoles sécurisés pour protéger les données des utilisateurs.

- Mettre en œuvre des techniques de confidentialité différentielles pour anonymiser les informations sensibles.

- Se conformer aux réglementations en matière de protection des données telles que le RGPD et le CCPA.

6. Surveillance et commentaires continus

- Surveillez les agents IA en temps réel pour détecter et résoudre les problèmes.

- Recueillez les commentaires des utilisateurs pour améliorer les performances et l'alignement éthique des agents d'IA.

- Mettez régulièrement à jour les modèles d'IA pour refléter l'évolution des normes et des valeurs sociétales.

Le rôle des parties prenantes

Créer des agents d'IA responsables est une responsabilité partagée qui nécessite la collaboration de plusieurs parties prenantes :

Gouvernements

- Promulguer des réglementations pour garantir que les systèmes d'IA sont équitables, transparents et responsables.

- Promouvoir la recherche et le développement en IA éthique.

- Établir des organismes de surveillance pour surveiller le déploiement des agents d'IA.

Organisations

- Élaborer des politiques et des lignes directrices internes pour une IA responsable.

- Investir dans des programmes de formation pour sensibiliser les employés aux pratiques éthiques de l'IA.

- Établissez des partenariats avec des institutions universitaires et des organisations à but non lucratif pour faire progresser la recherche éthique sur l'IA.

Développeurs

- Donner la priorité aux considérations éthiques lors de la conception et du développement des agents d'IA.

- Défendez des pratiques responsables en matière d'IA au sein de leurs organisations.

- Restez informé des dernières avancées en matière de cadres et d'outils d'IA éthiques.

Salesforce et AgentForce : une étude de cas

Salesforce, leader de la gestion de la relation client (CRM), a été à l'avant-garde du développement de l'IA responsable. Leur plateforme AgentForce exploite les agents IA pour automatiser les processus de vente, améliorer l'engagement client et stimuler la croissance de l'entreprise.

Ce qui distingue Salesforce, c'est son engagement en faveur d'une IA éthique. L'entreprise a mis en œuvre des directives solides pour garantir que ses systèmes d'IA sont équitables, transparents et responsables. Par exemple :

- Détection des biais : Salesforce utilise des outils pour identifier et atténuer les biais dans ses modèles d'IA.

- Explicabilité : AgentForce fournit aux utilisateurs des informations claires sur la manière dont les recommandations basées sur l'IA sont faites.

- Confidentialité : Salesforce garantit que les données des clients sont traitées de manière sécurisée et conformément aux réglementations mondiales.

En donnant la priorité à l'IA responsable, Salesforce a établi une référence à suivre pour d'autres organisations.

Conclusion

À mesure que les agents d’IA deviennent plus autonomes, il est essentiel de trouver un équilibre entre innovation et éthique. En abordant des problèmes tels que les préjugés, la transparence et la responsabilité, nous pouvons garantir que les agents d'IA sont non seulement innovants mais également éthiques.

La création d'agents d'IA responsables nécessite un effort de collaboration entre les développeurs, les organisations et les gouvernements. En adoptant des cadres éthiques, en atténuant les préjugés et en garantissant la transparence, nous pouvons créer des systèmes d'IA qui profitent à la société tout en minimisant les dommages. Des outils tels que AgentForce de Salesforce démontrent comment l'IA responsable peut stimuler l'innovation tout en préservant la confiance et l'équité.

L’avenir de l’IA est prometteur, mais c’est à nous de veiller à ce qu’elle soit également responsable.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1659

1659

14

14

1415

1415

52

52

1310

1310

25

25

1258

1258

29

29

1232

1232

24

24

Démystifier javascript: ce qu'il fait et pourquoi c'est important

Apr 09, 2025 am 12:07 AM

Démystifier javascript: ce qu'il fait et pourquoi c'est important

Apr 09, 2025 am 12:07 AM

JavaScript est la pierre angulaire du développement Web moderne, et ses principales fonctions incluent la programmation axée sur les événements, la génération de contenu dynamique et la programmation asynchrone. 1) La programmation axée sur les événements permet aux pages Web de changer dynamiquement en fonction des opérations utilisateur. 2) La génération de contenu dynamique permet d'ajuster le contenu de la page en fonction des conditions. 3) La programmation asynchrone garantit que l'interface utilisateur n'est pas bloquée. JavaScript est largement utilisé dans l'interaction Web, les applications à une page et le développement côté serveur, améliorant considérablement la flexibilité de l'expérience utilisateur et du développement multiplateforme.

L'évolution de JavaScript: tendances actuelles et perspectives d'avenir

Apr 10, 2025 am 09:33 AM

L'évolution de JavaScript: tendances actuelles et perspectives d'avenir

Apr 10, 2025 am 09:33 AM

Les dernières tendances de JavaScript incluent la montée en puissance de TypeScript, la popularité des frameworks et bibliothèques modernes et l'application de WebAssembly. Les prospects futurs couvrent des systèmes de type plus puissants, le développement du JavaScript côté serveur, l'expansion de l'intelligence artificielle et de l'apprentissage automatique, et le potentiel de l'informatique IoT et Edge.

Moteurs JavaScript: comparaison des implémentations

Apr 13, 2025 am 12:05 AM

Moteurs JavaScript: comparaison des implémentations

Apr 13, 2025 am 12:05 AM

Différents moteurs JavaScript ont des effets différents lors de l'analyse et de l'exécution du code JavaScript, car les principes d'implémentation et les stratégies d'optimisation de chaque moteur diffèrent. 1. Analyse lexicale: convertir le code source en unité lexicale. 2. Analyse de la grammaire: générer un arbre de syntaxe abstrait. 3. Optimisation et compilation: générer du code machine via le compilateur JIT. 4. Exécuter: Exécutez le code machine. Le moteur V8 optimise grâce à une compilation instantanée et à une classe cachée, SpiderMonkey utilise un système d'inférence de type, résultant en différentes performances de performances sur le même code.

JavaScript: Explorer la polyvalence d'un langage Web

Apr 11, 2025 am 12:01 AM

JavaScript: Explorer la polyvalence d'un langage Web

Apr 11, 2025 am 12:01 AM

JavaScript est le langage central du développement Web moderne et est largement utilisé pour sa diversité et sa flexibilité. 1) Développement frontal: construire des pages Web dynamiques et des applications à une seule page via les opérations DOM et les cadres modernes (tels que React, Vue.js, Angular). 2) Développement côté serveur: Node.js utilise un modèle d'E / S non bloquant pour gérer une concurrence élevée et des applications en temps réel. 3) Développement des applications mobiles et de bureau: le développement de la plate-forme multiplateuse est réalisé par réact noral et électron pour améliorer l'efficacité du développement.

Python vs JavaScript: la courbe d'apprentissage et la facilité d'utilisation

Apr 16, 2025 am 12:12 AM

Python vs JavaScript: la courbe d'apprentissage et la facilité d'utilisation

Apr 16, 2025 am 12:12 AM

Python convient plus aux débutants, avec une courbe d'apprentissage en douceur et une syntaxe concise; JavaScript convient au développement frontal, avec une courbe d'apprentissage abrupte et une syntaxe flexible. 1. La syntaxe Python est intuitive et adaptée à la science des données et au développement back-end. 2. JavaScript est flexible et largement utilisé dans la programmation frontale et côté serveur.

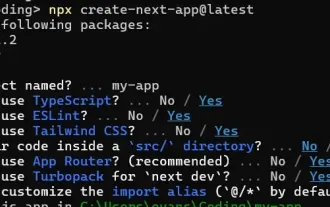

Comment construire une application SaaS multi-locataire avec Next.js (Frontend Integration)

Apr 11, 2025 am 08:22 AM

Comment construire une application SaaS multi-locataire avec Next.js (Frontend Integration)

Apr 11, 2025 am 08:22 AM

Cet article démontre l'intégration frontale avec un backend sécurisé par permis, construisant une application fonctionnelle EdTech SaaS en utilisant Next.js. Le frontend récupère les autorisations des utilisateurs pour contrôler la visibilité de l'interface utilisateur et garantit que les demandes d'API adhèrent à la base de rôles

De C / C à JavaScript: comment tout cela fonctionne

Apr 14, 2025 am 12:05 AM

De C / C à JavaScript: comment tout cela fonctionne

Apr 14, 2025 am 12:05 AM

Le passage de C / C à JavaScript nécessite de s'adapter à la frappe dynamique, à la collecte des ordures et à la programmation asynchrone. 1) C / C est un langage dactylographié statiquement qui nécessite une gestion manuelle de la mémoire, tandis que JavaScript est dynamiquement typé et que la collecte des déchets est automatiquement traitée. 2) C / C doit être compilé en code machine, tandis que JavaScript est une langue interprétée. 3) JavaScript introduit des concepts tels que les fermetures, les chaînes de prototypes et la promesse, ce qui améliore la flexibilité et les capacités de programmation asynchrones.

Construire une application SaaS multi-locataire avec next.js (intégration backend)

Apr 11, 2025 am 08:23 AM

Construire une application SaaS multi-locataire avec next.js (intégration backend)

Apr 11, 2025 am 08:23 AM

J'ai construit une application SAAS multi-locataire fonctionnelle (une application EdTech) avec votre outil technologique quotidien et vous pouvez faire de même. Premièrement, qu'est-ce qu'une application SaaS multi-locataire? Les applications saas multi-locataires vous permettent de servir plusieurs clients à partir d'un chant