Périphériques technologiques

Périphériques technologiques

IA

IA

Déployer Deepseek R1 sur Databricks: un guide étape par étape

Déployer Deepseek R1 sur Databricks: un guide étape par étape

Déployer Deepseek R1 sur Databricks: un guide étape par étape

Déployer le modèle R1 Deepseek sur Databricks: un guide étape par étape

DATABRICKS, une plate-forme d'ingénierie des données populaire, est de plus en plus utilisée pour l'IA et les tâches d'apprentissage automatique. Ce tutoriel vous guide dans le déploiement du modèle R1 Deepseek distribué sur Databricks, un puissant modèle de grande langue souvent préféré pour le déploiement sur site. Cela évite d'envoyer des données aux serveurs externes. Pour une plongée plus profonde dans les fonctionnalités et les comparaisons de Deepseek R1, consultez le Deepseek-R1: fonctionnalités, comparaison, modèles distillés et plus de blog.

Ce guide couvre la configuration du compte, l'enregistrement du modèle à l'aide de l'interface utilisateur et l'accès via le terrain de jeu et les commandes Curl locales. Nouveau sur Databricks? Le cours d'introduction au Databricks fournit un aperçu complet de la plate-forme Databricks Lakehouse et de ses capacités de gestion des données. Pour une compréhension plus approfondie de la gestion des données au sein de Databricks, considérez la gestion des données dans le cours de Databricks.

Enregistrement du modèle R1 Deepseek

- Lancez un ordinateur portable: Après avoir créé votre espace de travail Databricks, cliquez sur "Nouveau" et sélectionnez un ordinateur portable.

- Installez les packages: Installez les bibliothèques Python nécessaires:

%%capture !pip install torch transformers mlflow accelerate torchvision %restart_python

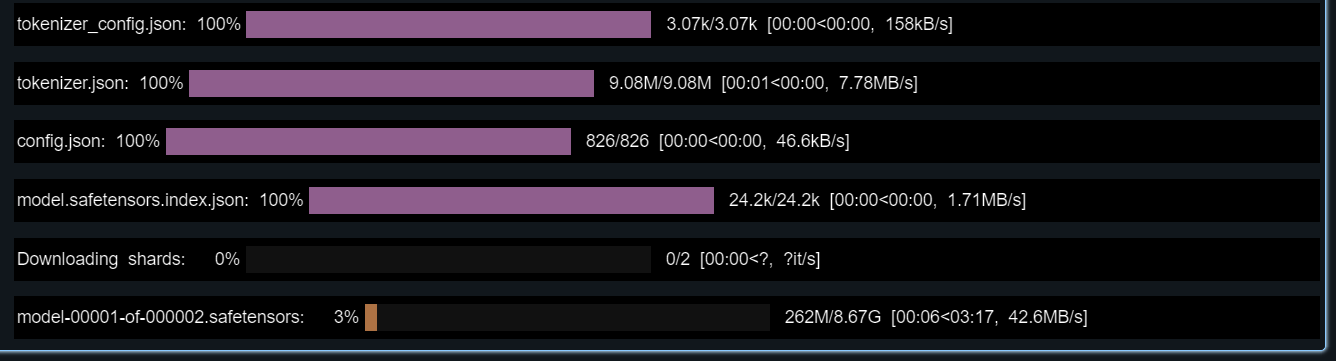

- Modèle de chargement et tokenzer: Chargez le modèle R1 Deepseek et le jeton de la face étreinte:

import pandas as pd import mlflow import mlflow.transformers import torch from mlflow.models.signature import infer_signature from transformers import AutoModelForCausalLM, AutoTokenizer, AutoConfig, pipeline model_name = "deepseek-ai/DeepSeek-R1-Distill-Llama-8B" tokenizer = AutoTokenizer.from_pretrained(model_name) config = AutoConfig.from_pretrained(model_name) model = AutoModelForCausalLM.from_pretrained(model_name, config=config, torch_dtype=torch.float16)

- Testez le modèle: Testez avec un échantillon d'invite et générez une signature pour l'enregistrement du modèle:

text_generator = pipeline("text-generation", model=model, tokenizer=tokenizer)

example_prompt = "How does a computer work?"

example_inputs = pd.DataFrame({"inputs": [example_prompt]})

example_outputs = text_generator(example_prompt, max_length=200)

signature = infer_signature(example_inputs, example_outputs)

print(example_outputs)Sortie attendue (peut varier légèrement):

<code>[{'generated_text': "How does a computer work? What is the computer? What is the computer used for? What is the computer used for in real life?\n\nI need to answer this question, but I need to do it step by step. I need to start with the very basic level and build up from there. I need to make sure I understand each concept before moving on. I need to use a lot of examples to explain each idea. I need to write my thoughts as if I'm explaining them to someone else, but I need to make sure I understand how to structure the answer properly.\n\nOkay, let's start with the basic level. What is a computer? It's an electronic device, right? And it has a central processing unit (CPU) that does the processing. But I think the central processing unit is more efficient, so maybe it's the CPU. Then, it has memory and storage. I remember that memory is like RAM and storage is like ROM. But wait, I think"}]</code>- Environnement conda: Définir un environnement conda:

conda_env = {

"name": "mlflow-env",

"channels": ["defaults", "conda-forge"],

"dependencies": [

"python=3.11",

"pip",

{"pip": ["mlflow", "transformers", "accelerate", "torch", "torchvision"]}

]

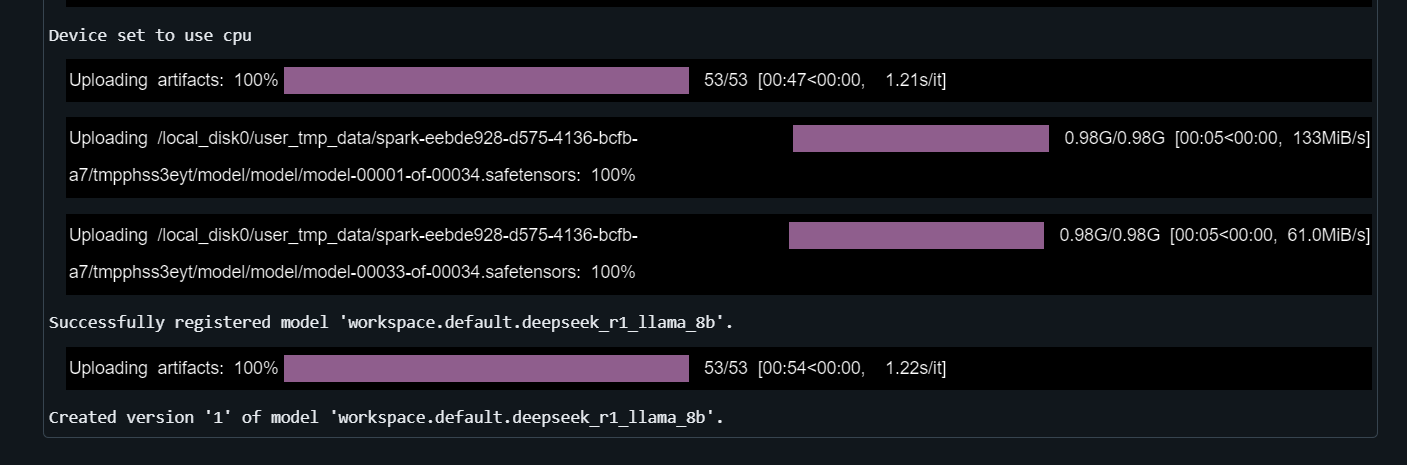

}- Enregistrez le modèle: Enregistrez le modèle à l'aide de

mlflow.transformers.log_model:

with mlflow.start_run() as run:

mlflow.transformers.log_model(

transformers_model=text_generator,

artifact_path="deepseek_model",

signature=signature,

input_example=example_inputs,

registered_model_name="deepseek_r1_llama_8b",

conda_env=conda_env

)

Déployage de profondeur R1

-

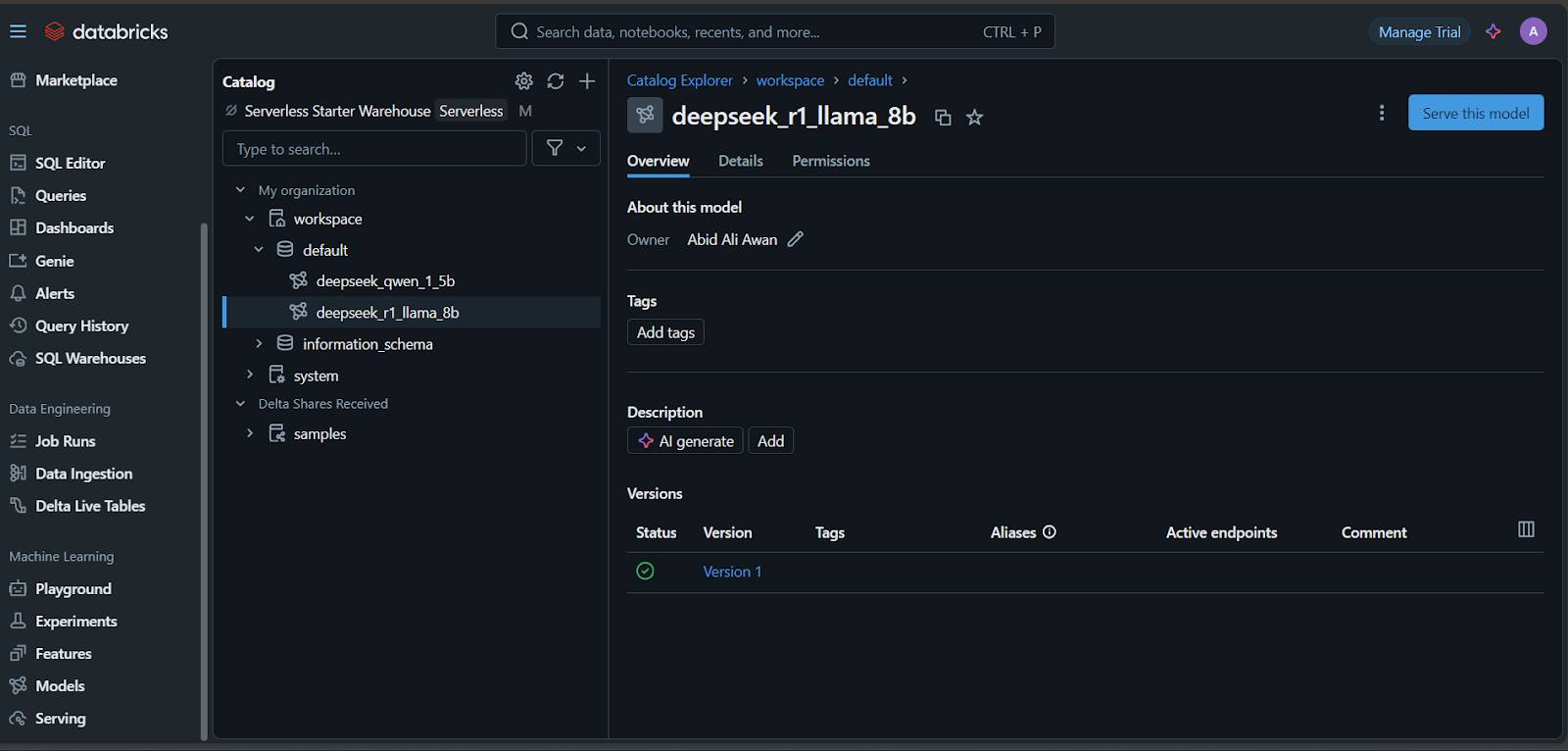

Accédez à des modèles: Dans le tableau de bord Databricks, accédez à l'onglet "Modèles".

-

Servir le modèle: Sélectionnez votre modèle et cliquez sur "Servir ce modèle."

- Configurer le point de terminaison: Nommez votre point de terminaison, choisissez des options de calcul, définissez la concurrence et cliquez sur "Créer".

Pour le réglage fin sur un ensemble de données personnalisé, reportez-vous au tutoriel de profondeur R1 à réglage fin.

Accès au modèle déployé

- Databricks Playground: Testez directement dans le terrain de jeu de Databricks.

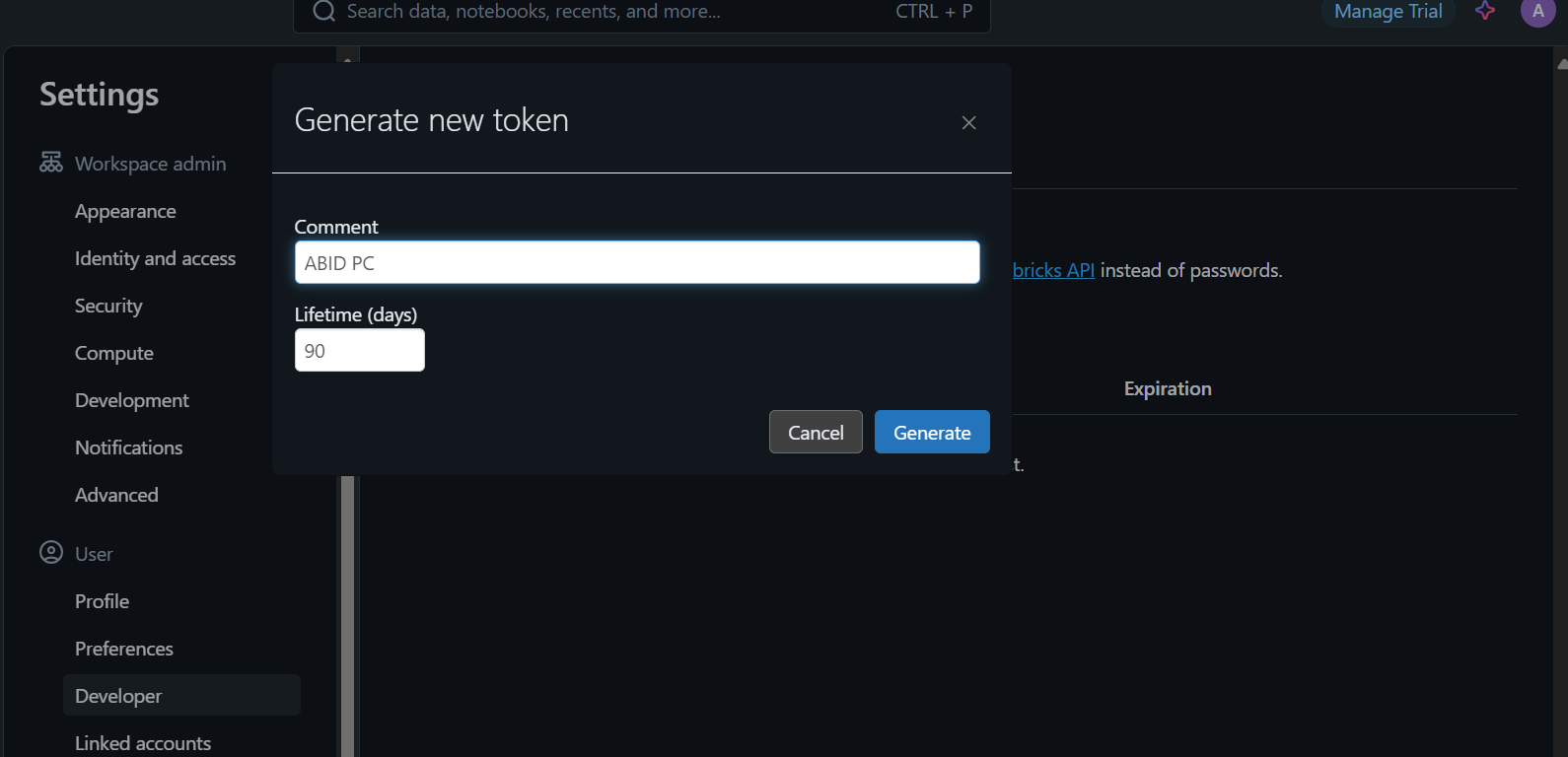

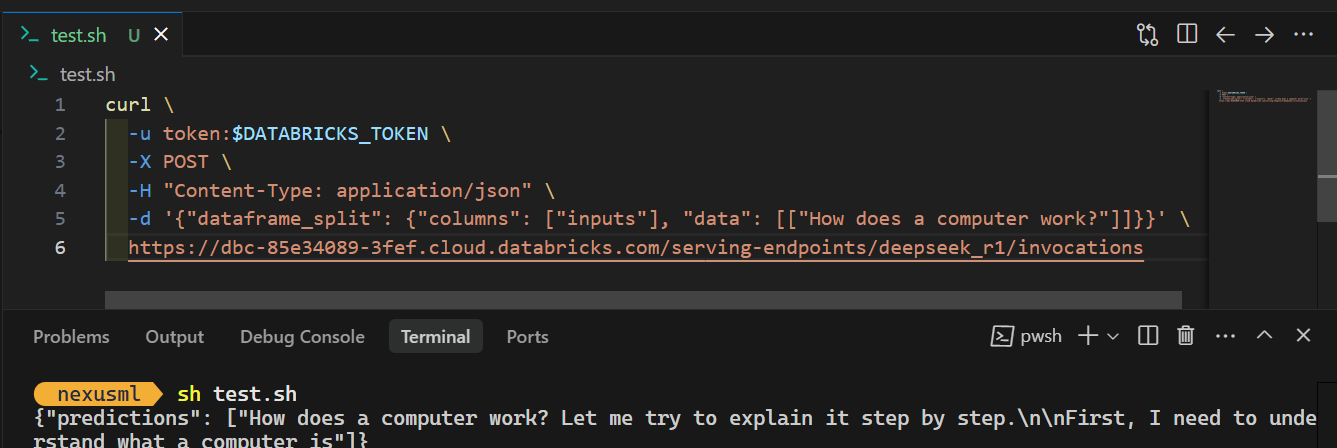

- Commande Curl: Générez une clé API Databricks (Paramètres & gt; développeur), définissez-la en tant que variable d'environnement (

$DATABRICKS_TOKEN), et utilisez Curl:

%%capture !pip install torch transformers mlflow accelerate torchvision %restart_python

Pour plus d'informations sur Deepseek R1 contre V3, consultez le blog Deepseek R1 vs V3. Nouveau sur LLMS? L'introduction à LLMS in Python Course est un excellent point de départ. N'oubliez pas que bien que le déploiement du processeur soit possible, il peut être plus lent.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Meilleurs générateurs d'art AI (gratuit & amp; payé) pour des projets créatifs

Apr 02, 2025 pm 06:10 PM

Meilleurs générateurs d'art AI (gratuit & amp; payé) pour des projets créatifs

Apr 02, 2025 pm 06:10 PM

L'article passe en revue les meilleurs générateurs d'art AI, discutant de leurs fonctionnalités, de leur aptitude aux projets créatifs et de la valeur. Il met en évidence MidJourney comme la meilleure valeur pour les professionnels et recommande Dall-E 2 pour un art personnalisable de haute qualité.

Début avec Meta Llama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Début avec Meta Llama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

META'S LLAMA 3.2: un bond en avant dans l'IA multimodal et mobile Meta a récemment dévoilé Llama 3.2, une progression importante de l'IA avec de puissantes capacités de vision et des modèles de texte légers optimisés pour les appareils mobiles. S'appuyer sur le succès o

Meilleurs chatbots AI comparés (Chatgpt, Gemini, Claude & amp; plus)

Apr 02, 2025 pm 06:09 PM

Meilleurs chatbots AI comparés (Chatgpt, Gemini, Claude & amp; plus)

Apr 02, 2025 pm 06:09 PM

L'article compare les meilleurs chatbots d'IA comme Chatgpt, Gemini et Claude, en se concentrant sur leurs fonctionnalités uniques, leurs options de personnalisation et leurs performances dans le traitement et la fiabilité du langage naturel.

Assistants d'écriture de l'IA pour augmenter votre création de contenu

Apr 02, 2025 pm 06:11 PM

Assistants d'écriture de l'IA pour augmenter votre création de contenu

Apr 02, 2025 pm 06:11 PM

L'article traite des meilleurs assistants d'écriture d'IA comme Grammarly, Jasper, Copy.ai, WireSonic et Rytr, en se concentrant sur leurs fonctionnalités uniques pour la création de contenu. Il soutient que Jasper excelle dans l'optimisation du référencement, tandis que les outils d'IA aident à maintenir le ton

Vendre une stratégie d'IA aux employés: le manifeste du PDG de Shopify

Apr 10, 2025 am 11:19 AM

Vendre une stratégie d'IA aux employés: le manifeste du PDG de Shopify

Apr 10, 2025 am 11:19 AM

La récente note du PDG de Shopify Tobi Lütke déclare hardiment la maîtrise de l'IA une attente fondamentale pour chaque employé, marquant un changement culturel important au sein de l'entreprise. Ce n'est pas une tendance éphémère; C'est un nouveau paradigme opérationnel intégré à P

AV Bytes: Meta & # 039; S Llama 3.2, Google's Gemini 1.5, et plus

Apr 11, 2025 pm 12:01 PM

AV Bytes: Meta & # 039; S Llama 3.2, Google's Gemini 1.5, et plus

Apr 11, 2025 pm 12:01 PM

Le paysage de l'IA de cette semaine: un tourbillon de progrès, de considérations éthiques et de débats réglementaires. Les principaux acteurs comme Openai, Google, Meta et Microsoft ont déclenché un torrent de mises à jour, des nouveaux modèles révolutionnaires aux changements cruciaux de LE

10 extensions de codage générateur AI dans le code vs que vous devez explorer

Apr 13, 2025 am 01:14 AM

10 extensions de codage générateur AI dans le code vs que vous devez explorer

Apr 13, 2025 am 01:14 AM

Hé là, codant ninja! Quelles tâches liées au codage avez-vous prévues pour la journée? Avant de plonger plus loin dans ce blog, je veux que vous réfléchissiez à tous vos malheurs liés au codage - les énumérez. Fait? - Let & # 8217

Choisir le meilleur générateur de voix d'IA: les meilleures options examinées

Apr 02, 2025 pm 06:12 PM

Choisir le meilleur générateur de voix d'IA: les meilleures options examinées

Apr 02, 2025 pm 06:12 PM

L'article examine les meilleurs générateurs de voix d'IA comme Google Cloud, Amazon Polly, Microsoft Azure, IBM Watson et Descript, en se concentrant sur leurs fonctionnalités, leur qualité vocale et leur aptitude à différents besoins.