Recherche de faisceau: une plongée profonde dans ce puissant algorithme de décodage

La recherche de faisceau est un algorithme de décodage crucial dans le traitement du langage naturel (NLP) et l'apprentissage automatique, en particulier pour les tâches de génération de séquences comme la génération de texte, la traduction automatique et le résumé. Il équilibre efficacement l'exploration de l'espace de recherche avec la génération de résultats de haute qualité. Cet article fournit un aperçu complet de la recherche de faisceaux, y compris son mécanisme, sa mise en œuvre, ses applications et ses limitations.

Objectifs d'apprentissage clés:

(Cet article fait partie du blogathon de la science des données.)

Table des matières:

Comprendre la recherche de faisceau

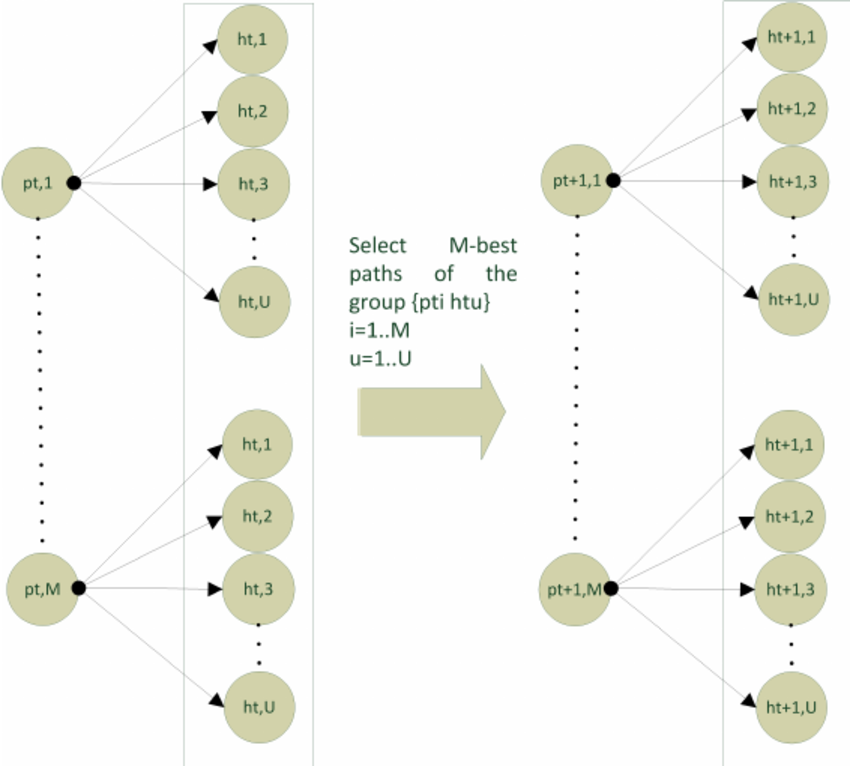

La recherche de faisceau est un algorithme de recherche heuristique utilisé pour décoder les séquences de modèles tels que Transformers et LSTMS. Il maintient un nombre fixe des séquences les plus probables (la "largeur du faisceau") à chaque étape du processus de génération. Contrairement à la recherche gourmand, qui ne considère que le jetons le plus probable, la recherche de faisceau explore plusieurs possibilités simultanément, conduisant à des sorties plus courantes et globalement optimales. Dans la traduction automatique, par exemple, il permet au modèle d'explorer simultanément diverses traductions valides.

Le mécanisme de recherche de faisceau

La recherche de faisceau fonctionne en traversant un graphique où les nœuds représentent les jetons et les bords représentent des probabilités de transition. À chaque étape:

Le concept de largeur de faisceau

La largeur du faisceau ( k ) est un paramètre critique. Un faisceau plus large explore plus de séquences, améliorant potentiellement la qualité de sortie, mais augmente considérablement le coût de calcul. Un faisceau plus étroit est plus rapide mais risque de manquer des séquences supérieures.

L'importance de la recherche de faisceau dans le décodage

La recherche de faisceau est cruciale pour le décodage car:

Implémentation pratique du Python

Ce qui suit fournit une implémentation simplifiée démontrant les principes de base. Une implémentation plus robuste nécessiterait une gestion des erreurs et des calculs de probabilité potentiellement plus sophistiqués.

(Remarque: Les sections de code et les sorties ci-dessous sont reproduites à partir de l'article d'origine et supposons que les bibliothèques nécessaires sont installées. Reportez-vous à l'article d'origine pour les instructions d'installation complètes et les explications détaillées.)

(Étape 1: Installer et importer des dépendances)

<code># Install transformers and graphviz !sudo apt-get install graphviz graphviz-dev !pip install transformers pygraphviz from transformers import GPT2LMHeadModel, GPT2Tokenizer import torch import matplotlib.pyplot as plt import networkx as nx import numpy as np from matplotlib.colors import LinearSegmentedColormap from tqdm import tqdm import matplotlib.colors as mcolors</code>

(Étape 2: Configuration du modèle et du tokenzer)

<code># Load model and tokenizer

device = 'cuda' if torch.cuda.is_available() else 'cpu'

model = GPT2LMHeadModel.from_pretrained('gpt2').to(device)

tokenizer = GPT2Tokenizer.from_pretrained('gpt2')

model.eval()</code>(Étape 3-8: Sections de code restantes pour l'entrée de codage, les fonctions d'assistance, la recherche de faisceau récursive, la meilleure récupération de séquence et le traçage de graphiques sont reproduits à partir de l'article d'origine.)

(les exemples de sortie sont également reproduits à partir de l'article d'origine.)

Défis et limitations de la recherche de faisceau

Malgré ses forces, la recherche de faisceau a des limites:

Conclusion

La recherche de faisceau est un algorithme fondamental dans la PNL moderne, offrant un équilibre entre l'efficacité et la qualité de sortie. Sa flexibilité et sa capacité à générer des séquences cohérentes en font un outil précieux pour diverses applications NLP. Bien qu'il existe des défis, son adaptabilité et son efficacité consolident sa position de pierre angulaire de la génération de séquences.

Questions fréquemment posées

(Le média présenté dans cet article ne appartient pas à l'analyse vidhya et est utilisé à la discrétion de l'auteur.)

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Utilisation de réécriturecond

Utilisation de réécriturecond

Windows ne peut pas terminer la solution de formatage du disque dur

Windows ne peut pas terminer la solution de formatage du disque dur

Quelle est l'inscription dans la blockchain ?

Quelle est l'inscription dans la blockchain ?

Que signifient les caractères pleine chasse ?

Que signifient les caractères pleine chasse ?

Diagramme de base de données

Diagramme de base de données

Comment résoudre l'incompatibilité de charge du serveur

Comment résoudre l'incompatibilité de charge du serveur

Quels sont les logiciels de dessin ?

Quels sont les logiciels de dessin ?

Comment obtenir l'adresse de la barre d'adresse

Comment obtenir l'adresse de la barre d'adresse