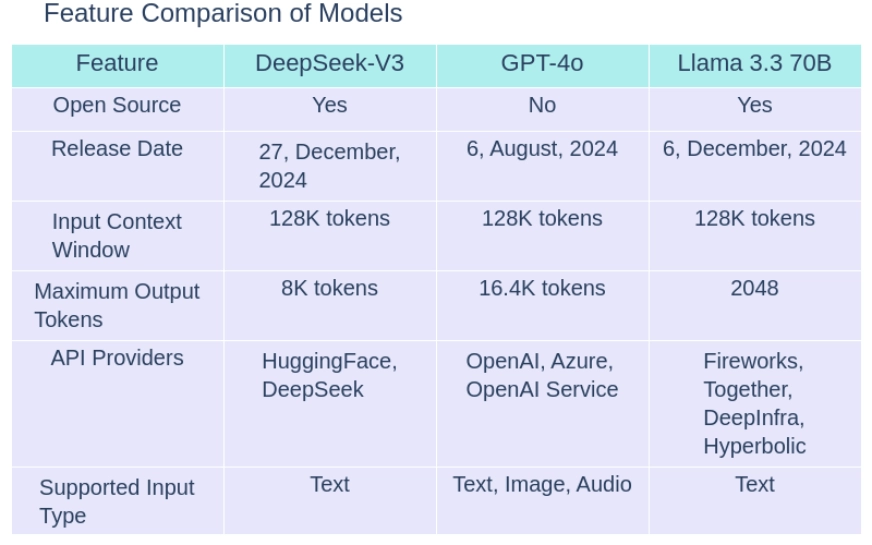

L'évolution des modèles de langage AI a établi de nouvelles normes, en particulier dans le paysage de codage et de programmation. La charge est la charge deepseek-v3 , gpt-4o , et llama 3.3 70b , chacune offrant des avantages uniques. Dans ce blog, nous ferons une comparaison du modèle de langue AI, en nous concentrant sur les architectures, les paramètres, les capacités de codage et les cas d'utilisation pratiques de GPT-4O et ses deux alternatives. Grâce à une analyse détaillée de Deepseek-V3 vs GPT-4O vs Llama 3.3 70b, je découvrirai quel modèle convient le mieux aux tâches de programmation et comment ces progrès façonnent l'avenir de l'IA en 2025.

Deepseek-V3 est un modèle d'IA open-source qui excelle dans les repères de modèle de grande langue avec son architecture de mélange de mélange efficace (MOE). LLAMA 3.3 70B est impressionnant avec son évolutivité et son adaptabilité, ce qui en fait un concurrent fort dans la comparaison des paramètres du modèle AI. Pendant ce temps, GPT-4O se démarque avec ses vastes ressources, donnant à ses concurrents une course pour leur argent.

Maintenant, commençons notre comparaison en comprenant la conception et les architectures des trois modèles.

Deepseek -v3 est un modèle de mélange d'open source (MOE) avec 671 milliards de paramètres, activant 37 milliards de paramètres par jeton. Il exploite l'équilibrage de la charge de pointe et les méthodes de prédiction multi-token, formées sur 14,8 billions de jetons. Atteignant les performances de haut niveau sur plusieurs repères, le modèle maintient l'efficacité de la formation avec un coût de seulement 2,788 millions d'heures de GPU H800.

Deepseek-V3 intègre des capacités de raisonnement de Deepseek-R1 Lite et propose une fenêtre de contexte de 128k. De plus, il peut traiter une variété de types d'entrée, y compris du texte, des données structurées et des entrées multimodales complexes, ce qui le rend polyvalent pour divers cas d'utilisation.

LIRE AUSSI: Création d'une application AI avec Deepseek-V3

GPT-4O est un modèle de langue avancée développé par OpenAI, avec des améliorations architecturales de pointe. Il est formé sur un vaste ensemble de données de jetons d'entrée, ce qui le rend très compétent sur diverses tâches avec une précision impressionnante.

Le modèle prend en charge les entrées multimodales et a des capacités de raisonnement améliorées, fournissant une polyvalence pour de nombreuses applications. Avec une fenêtre de contexte de jetons 128k, il peut générer jusqu'à 16 384 jetons par demande et processus autour de 77,4 jetons par seconde. Sorti en août 2024, ses connaissances s'étendent jusqu'en octobre 2023, ce qui en fait l'un des modèles les plus puissants et adaptables du marché.

Le méta llama 3.3 70 B Multantial Modèle de grande langue (LLM) est un modèle génératif de source ouverte, pré-formé et réglé avec 70 milliards de paramètres. Il est conçu pour être optimisé pour l'efficacité et l'évolutivité. Il utilise des techniques de pointe pour gérer un large éventail de tâches, formées sur plus de 15 billions de jetons.

lama 3.3 70b est un modèle de langage auto-régressif qui utilise une architecture de transformateur optimisée. Le modèle atteint des performances remarquables sur plusieurs repères, ce qui maintient les coûts de formation minimaux avec une allocation de ressources optimisée.

lama 3.3 70b prend en charge une large fenêtre de contexte et intègre des capacités de raisonnement avancées pour une gestion des tâches nuancés et précises. Il est conçu pour traiter les entrées textuelles mais peut également gérer des données structurées, offrant une flexibilité dans diverses applications.

| Benchmark | Description | DeepSeek-V3 | GPT-4o | Llama 3.3 70B |

| MMLU | Massive Multitask Language Understanding- Test knowledge across 57 subjects including maths, history, law and more | 88.5% | 88.7% | 88.5% |

| MMLU-Pro | A more robust MMLU benchmark with more complex reasoning focused questions and reduced prompt sensitivity | 75.9% | 74.68% | 75.9% |

| MMMU | Massive Multitask Multimodal Understanding: Text understanding across text, audio,images and videos | Not available | 69.1% | Not available |

| HellaSwag | A challenging sentence completion benchmark | 88.9% | Not available | Not available |

| HumanEval | Evaluates code generation and problem solving capabilities | 82.6% | 90.2% | 88.4% |

| MATH | Tests Mathematical problem solving abilities across various difficulty levels | 61.6% | 75.9% | 77% |

| GPQA | Test PhD-level knowledge in physics, chemistry and biology that require domain expertise | 59.1% | 53.6% | 50.5% |

| IFEval | Test model’s ability to accurately follow explicit formatting instructions, generate appropriate outputs and maintain consistent instructions | 86.1% | Not available | 92.1% |

Vous pouvez trouver les résultats de leurs tests de référence individuels ici:

En parlant de prix, GPT-4O est environ 30 fois plus cher par rapport à Deepseek-V3 pour les jetons d'entrée et de sortie. Pendant ce temps, l'instruction LLAMA 3.3 70B est environ 1,5 fois plus cher par rapport à Deepseek-V3 pour les jetons d'entrée et de sortie.

Deepseek-V3 excelle dans les repères qui nécessitent une complétion structurée des tâches, tels que MMLU (compréhension massive du langage multitâche) et Humaneval (génération de code). Cependant, il fait face à des défis dans des références comme les mathématiques (résolution mathématique de problèmes), où ses performances ne sont pas aussi compétitives. Il mène également en GPQA (réponse à la question de la question du passage généralisé), surpassant les autres modèles dans ce domaine.

gpt-4o se comporte particulièrement bien dans HumaneVal et MMLU, où il se démarque avec sa capacité à générer des réponses de haute qualité sur divers sujets. Bien qu'il brille dans des tâches basées sur le raisonnement, elle se débat dans des domaines spécialisés tels que les mathématiques et le GPQA, où d'autres modèles fonctionnent mieux.

lama 3.3 70b montre ses forces dans les repères comme les mathématiques et les ifeval (instruction après évaluation). Il démontre des capacités de résolution de problèmes supérieures et suit des instructions complexes plus efficacement que les autres modèles. Ses performances dans d'autres repères comme Humaneval et GPQA sont moins impressionnantes que Deepseek-V3 et GPT-4O.

Maintenant, nous comparerons les capacités d'écriture de code de Deepseek-V3, GPT-4O et LLAMA 3.3 70b. Pour cela, nous allons donner la même invite aux trois modèles et évaluer leurs réponses sur les métriques ci-dessous:

Invite: "Salut, vous êtes un excellent instructeur de code, alors aidez-moi avec cette question.

q. Écrivez le code Python pour trouver le factoriel d'un grand nombre. »

Pour calculer le factoriel d'un grand nombre à l'aide d'un tableau (pour gérer manuellement les opérations de multiplication et de transport), voici une implémentation Python:

def multiply(arr, x):

"""

Multiplies an array representation of a number with an integer x.

: param arr: List of integers representing the digits of the number.

: param x: Integer to multiply with.

:return: Updated array with the result.

"""

carry = 0 # Initialize carry

for i in range(len(arr)):

prod = arr[i] * x + carry

arr[i] = prod % 10 # Store last digit of the product in the array

carry = prod // 10 # Update the carry

# Process carry, add digits to the array

while carry > 0:

arr.append(carry % 10)

carry //= 10

return arr

def factorial_large_number_array(n):

"""

Calculate the factorial of a large number using array representation.

: param n: Integer for which the factorial is to be computed.

:return: Factorial of n as a string.

"""

if n < 0:

return "Factorial is not defined for negative numbers."

if n == 0 or n == 1:

return "1"

arr = [1] # Initialize the array with the first factorial value (1)

for x in range(2, n + 1):

arr = multiply(arr, x)

# The result is stored in reverse order in the array

return ''.join(map(str, reversed(arr)))

# Input a large number

try:

number = int(input("Enter a large number to calculate its factorial: "))

result = factorial_large_number_array(number)

print(f"The factorial of {number} is:\n{result}")

except ValueError:

print("Invalid input! Please enter a valid integer.")

Voici un extrait de code Python qui calcule le factoriel d'un grand nombre à l'aide d'un tableau pour stocker les chiffres.

def multiply(arr, x):

"""

Multiplies an array representation of a number with an integer x.

: param arr: List of integers representing the digits of the number.

: param x: Integer to multiply with.

:return: Updated array with the result.

"""

carry = 0 # Initialize carry

for i in range(len(arr)):

prod = arr[i] * x + carry

arr[i] = prod % 10 # Store last digit of the product in the array

carry = prod // 10 # Update the carry

# Process carry, add digits to the array

while carry > 0:

arr.append(carry % 10)

carry //= 10

return arr

def factorial_large_number_array(n):

"""

Calculate the factorial of a large number using array representation.

: param n: Integer for which the factorial is to be computed.

:return: Factorial of n as a string.

"""

if n < 0:

return "Factorial is not defined for negative numbers."

if n == 0 or n == 1:

return "1"

arr = [1] # Initialize the array with the first factorial value (1)

for x in range(2, n + 1):

arr = multiply(arr, x)

# The result is stored in reverse order in the array

return ''.join(map(str, reversed(arr)))

# Input a large number

try:

number = int(input("Enter a large number to calculate its factorial: "))

result = factorial_large_number_array(number)

print(f"The factorial of {number} is:\n{result}")

except ValueError:

print("Invalid input! Please enter a valid integer.")

Pour calculer le factoriel d'un grand nombre à l'aide d'un tableau de Python, nous pouvons stocker le résultat d'un tableau (ou de liste) pour gérer de très grands nombres qui dépassent la limite des types de données standard. Voici comment vous pouvez l'implémenter:

def multiply(x, res, res_size):

"""Multiplies x with the number represented by res[]"""

carry = 0

for i in range(res_size):

prod = res[i] * x + carry

res[i] = prod % 10

carry = prod // 10

while carry:

res.append(carry % 10)

carry = carry // 10

def factorial(n):

""" Calculates the factorial of a number n"""

res = [1]

res_size = 1

for i in range(2, n + 1):

multiply(i, res, res_size)

res_size = len(res)

return res

def print_factorial(n):

""" Prints the factorial of a number n"""

res = factorial(n)

print("Factorial of", n, "is:")

for digit in reversed(res):

print(digit, end="")

# Example usage:

n = 55

print_factorial(n)

LLAMA 3.3 70B La réponse est fonctionnelle, mais elle manque de gestion des erreurs et de documentation détaillée. Sa structure est moins intuitive et l'utilisation de variables redondantes a un impact sur l'efficacité. Cela en fait le plus faible des trois.

La réponse de Deepseek-V3 est efficace et structurée proprement mais manque de gestion des erreurs robuste et de documentation suffisante. C'est un concurrent fort mais ne fait pas plus de clarté pour les gens de suivre ou de s'adapter facilement.

Recommandations:

‘‘ Salut, vous êtes un excellent instructeur de code, alors aidez-moi avec cette question. q. Étant donné une chaîne S, revenez vrai si le s peut être palindrome après avoir supprimé au plus un personnage. »»

Réponse de GPT-4O

Sortie du code généré

def factorial(n):

# Initialize the result as a list with 1

result = [1]

# Multiply the result list with numbers from 2 to n

for x in range(2, n + 1):

carry = 0

# Multiply each digit in the result list with x

for i in range(len(result)):

product = result[i] * x + carry

result[i] = product % 10 # Store the last digit

carry = product // 10 # Carry over the remaining digits

# Add the remaining carry to the result list

while carry > 0:

result.append(carry % 10)

carry = carry // 10

# Reverse the result list to get the correct order

result.reverse()

return result

# Input: Number to find factorial of

n = int(input("Enter a number: "))

# Compute factorial

factorial_result = factorial(n)

# Convert the list of digits to a string for display

factorial_str = ''.join(map(str, factorial_result))

# Output the result

print(f"Factorial of {n} is: {factorial_str}")

Réponse par Llama 3.3 70b

Réponse par Llama 3.3 70b

Sortie du code généré

def valid_palindrome(s):

"""

Check if the string can become a palindrome by removing at most one character.

: param s: The input string.

:return: True if the string can become a palindrome, otherwise False.

"""

def is_palindrome_range(left, right):

# Helper function to check if a substring is a palindrome

while left < right:

if s[left] != s[right]:

return False

left += 1

right -= 1

return True

left, right = 0, len(s) - 1

while left < right:

if s[left] != s[right]:

# If a mismatch occurs, check by skipping one character

return is_palindrome_range(left + 1, right) or is_palindrome_range(left, right - 1)

left += 1

right -= 1

return True

# Example Usage

s1 = "abca"

print(f"Input: {s1}\nOutput: {valid_palindrome(s1)}")

s2 = "defgd"

print(f"Input: {s2}\nOutput: {valid_palindrome(s2)}") Pour résoudre ce problème, nous devons vérifier si une chaîne peut devenir un palindrome en supprimant au plus un seul caractère. Un palindrome lit les mêmes attaquants et en arrière. Voici comment nous pouvons aborder ceci:

def multiply(arr, x):

"""

Multiplies an array representation of a number with an integer x.

: param arr: List of integers representing the digits of the number.

: param x: Integer to multiply with.

:return: Updated array with the result.

"""

carry = 0 # Initialize carry

for i in range(len(arr)):

prod = arr[i] * x + carry

arr[i] = prod % 10 # Store last digit of the product in the array

carry = prod // 10 # Update the carry

# Process carry, add digits to the array

while carry > 0:

arr.append(carry % 10)

carry //= 10

return arr

def factorial_large_number_array(n):

"""

Calculate the factorial of a large number using array representation.

: param n: Integer for which the factorial is to be computed.

:return: Factorial of n as a string.

"""

if n < 0:

return "Factorial is not defined for negative numbers."

if n == 0 or n == 1:

return "1"

arr = [1] # Initialize the array with the first factorial value (1)

for x in range(2, n + 1):

arr = multiply(arr, x)

# The result is stored in reverse order in the array

return ''.join(map(str, reversed(arr)))

# Input a large number

try:

number = int(input("Enter a large number to calculate its factorial: "))

result = factorial_large_number_array(number)

print(f"The factorial of {number} is:\n{result}")

except ValueError:

print("Invalid input! Please enter a valid integer.")

LLAMA 3.3 70B La réponse est une solution fonctionnelle mais n'a pas la dénomination variable claire et la documentation approfondie trouvée dans GPT-4O. L'absence de commentaires dans la logique principale rend plus difficile à suivre, et il y a place à l'amélioration en termes de lisibilité. Cependant, il est suffisamment efficace pour les petites tâches où la mise en œuvre rapide est la priorité.

La réponse de Deepseek-V3 établit un bon équilibre entre l'efficacité et la simplicité, mais ne manque pas de documentation. Il est concis et rapide, mais il manque suffisamment de détails pour que les autres suivent facilement le code. Son approche peut être bénéfique dans les scénarios où le temps et les ressources sont limités, mais il aurait besoin d'explications plus approfondies et de gestion des erreurs pour rendre le code prêt pour la production.

Recommandations:

Déverrouillez la puissance de Deepseek! Inscrivez-vous aujourd'hui à notre cours de «démarrage avec Deepseek» et apprenez à tirer parti de ce modèle d'IA de pointe pour vos projets. Ne manquez pas - join maintenant et élevez vos compétences en IA!

Lisez également:a. GPT-4O excelle dans le codage du monde réel en raison de sa gestion efficace des erreurs, de sa documentation claire et de sa structure de code bien organisée, ce qui en fait le meilleur choix pour une utilisation pratique.

Q2. Comment ces modèles se comparent-ils en termes de lisibilité au code et de facilité de compréhension?a. GPT-4O se démarque de sa lisibilité, offrant des noms de variables clairs et des commentaires approfondis. En comparaison, LLAMA 3.3 70B et Deepseek-V3 sont fonctionnels mais n'ont pas le même niveau de clarté et de documentation, ce qui peut les rendre plus difficiles à suivre.

Q3. Quel modèle convient le plus à des fins éducatives?a. Le GPT-4O est le choix idéal pour l'éducation, fournissant une documentation approfondie et des explications détaillées qui aident les apprenants à saisir la logique sous-jacente du code.

Q4. Quelles mesures peuvent être prises pour améliorer Deepseek-V3 et Llama 3.3 70b pour correspondre à la qualité de GPT-4O?a. Pour élever leurs performances, les deux modèles devraient se concentrer sur la mise en œuvre d'une gestion des erreurs robuste, en utilisant des noms de variables plus descriptifs et en ajoutant des commentaires et de la documentation détaillés pour améliorer leur lisibilité et leur convivialité globale.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

La différence entre la charge rapide PD et la charge rapide générale

La différence entre la charge rapide PD et la charge rapide générale

Comment partager une imprimante dans Win10

Comment partager une imprimante dans Win10

Paramètres d'accès au WAN

Paramètres d'accès au WAN

Java exporter Excel

Java exporter Excel

Numéro de téléphone mobile virtuel pour recevoir le code de vérification

Numéro de téléphone mobile virtuel pour recevoir le code de vérification

La différence entre les serveurs d'applications légers et les serveurs cloud

La différence entre les serveurs d'applications légers et les serveurs cloud

Collection complète de balises HTML

Collection complète de balises HTML

Le rôle de l'index

Le rôle de l'index