Modernbert: un modèle NLP puissant et efficace

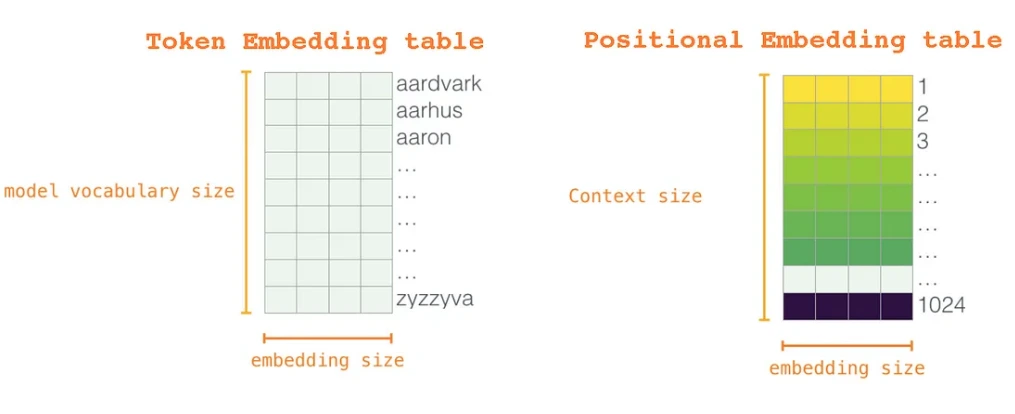

Modernbert améliore considérablement l'architecture Bert d'origine, offrant des performances et une efficacité améliorées pour diverses tâches de traitement du langage naturel (NLP). Ce modèle avancé intègre des améliorations architecturales de pointe et des méthodes de formation innovantes, élargissant ses capacités pour les développeurs dans le domaine de l'apprentissage automatique. Sa durée de contexte étendue de 8 192 jetons - une augmentation substantielle par rapport aux modèles traditionnels - allait pour relever des défis complexes tels que la récupération à long terme et la compréhension du code avec une précision remarquable. Cette efficacité, associée à une utilisation réduite de la mémoire, rend Modernbert idéal pour optimiser les applications NLP, des moteurs de recherche sophistiqués aux environnements de codage alimentés par l'IA.

Les performances supérieures de Modernbert découlent de plusieurs innovations clés:

| Feature | ModernBERT | BERT |

|---|---|---|

| Context Length | 8,192 tokens | 512 tokens |

| Positional Embeddings | Rotary Positional Embeddings (RoPE) | Traditional absolute positional embeddings |

| Activation Function | GeGLU | GELU |

| Training Data | 2 trillion tokens (diverse sources including code) | Primarily Wikipedia |

| Model Sizes | Base (139M parameters), Large (395M parameters) | Base (110M parameters), Large (340M parameters) |

| Speed & Efficiency | Significantly faster training and inference | Slower, especially with longer sequences |

Les capacités de Modernbert s'étendent à diverses applications:

Un système de chiffon simplifié utilisant des intégres modernes et des wesin est démontré ci-dessous. (Remarque: cette section nécessite l'installation de plusieurs bibliothèques et un compte de visage étreint avec un jeton d'autorisation. Le code suppose également l'accès à un ensemble de données approprié et à une clé API OpenAI.) Le code complet est omis ici pour Brevity mais illustre l'intégration de Modernbert pour l'intégration de la génération et de la récupération dans un pipeline de chiffon.

Modernbert présente une progression substantielle dans la PNL, combinant des performances améliorées avec une efficacité améliorée. Sa capacité à gérer de longues séquences et ses diverses données de formation en font un outil polyvalent pour de nombreuses applications. L'intégration de techniques innovantes comme la corde et GEGLU positionnent Modernbert en tant que modèle de premier plan pour lutter contre les TNL complexes et les tâches liées au code.

(Remarque: Les URL de l'image restent inchangées.)

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

La différence entre la charge rapide PD et la charge rapide générale

La différence entre la charge rapide PD et la charge rapide générale

Comment partager une imprimante dans Win10

Comment partager une imprimante dans Win10

Paramètres d'accès au WAN

Paramètres d'accès au WAN

Java exporter Excel

Java exporter Excel

Numéro de téléphone mobile virtuel pour recevoir le code de vérification

Numéro de téléphone mobile virtuel pour recevoir le code de vérification

La différence entre les serveurs d'applications légers et les serveurs cloud

La différence entre les serveurs d'applications légers et les serveurs cloud

Collection complète de balises HTML

Collection complète de balises HTML

Le rôle de l'index

Le rôle de l'index