Le score F-Beta: un guide complet de l'évaluation du modèle dans l'apprentissage automatique

Dans l'apprentissage automatique et la modélisation statistique, l'évaluation avec précision des performances du modèle est cruciale. Bien que la précision soit une métrique commune, elle ne fait souvent pas face à des ensembles de données déséquilibrés, ne capturez pas les compromis entre précision et rappel. Entrez le score F-Beta - une métrique d'évaluation plus flexible qui vous permet de prioriser la précision ou le rappel en fonction de la tâche spécifique. Cet article fournit une explication détaillée du score F-BETA, de son calcul, de ses applications et de sa mise en œuvre dans Python.

Objectifs d'apprentissage:

Table des matières:

Qu'est-ce que le score F-Beta?

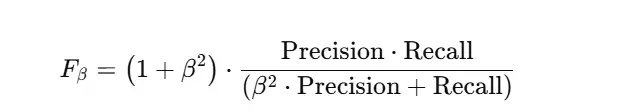

Le score F-Beta fournit une évaluation nuancée de la sortie d'un modèle en considérant à la fois la précision et le rappel. Contrairement au score F1, qui fait en moyenne la précision et le rappel également, le score F-Beta vous permet d'ajuster la pondération du rappel par rapport à la précision à l'aide du paramètre β.

Quand utiliser le score F-Beta

Le score F-Beta est particulièrement utile dans les scénarios exigeant un équilibre minutieux ou une hiérarchisation de la précision et du rappel. Voici quelques situations clés:

Ensembles de données déséquilibrés: dans les ensembles de données avec une distribution de classe asymétrique (par exemple, détection de fraude, diagnostic médical), la précision peut être trompeuse. Le score F-Beta vous permet d'ajuster β pour souligner le rappel (moins de positifs manqués) ou la précision (moins de faux positifs), s'alignant avec le coût associé à chaque type d'erreur.

Priorité spécifique au domaine: différentes applications ont des tolérances variables pour différents types d'erreurs. Par exemple:

Optimisation du compromis de précision-rapport: le score F-Beta fournit une mesure unique pour guider le processus d'optimisation, permettant des améliorations ciblées dans la précision ou le rappel.

Tâches sensibles aux coûts: lorsque les coûts des faux positifs et des faux négatifs diffèrent considérablement, le score F-Beta aide à choisir l'équilibre optimal.

Calcul du score F-Beta

Le score F-Beta est calculé en utilisant la précision et le rappel dérivés d'une matrice de confusion:

| Positif prévu | Négatif prévu | |

|---|---|---|

| Positif réel | Vrai Positif (TP) | Faux négatif (fn) |

| Négatif réel | Faux positifs (FP) | Vrai négatif (TN) |

Applications pratiques du score F-Beta

Le score F-Beta trouve une application généralisée dans de nombreux domaines:

Implémentation de Python

La bibliothèque scikit-learn fournit un moyen simple de calculer le score F-Beta:

De Sklearn.Metrics import fbeta_score, précision_score, rappel_score, confusion_matrix

Importer Numpy comme NP

# Exemple de données

y_true = np.array ([1, 0, 1, 1, 0, 1, 0, 0, 1, 0])

y_pred = np.array ([1, 0, 1, 0, 0, 1, 0, 1, 1, 0])

# Calculer les scores

précision = précision_score (y_true, y_pred)

rappel = rappel_score (y_true, y_pred)

f1 = fbeta_score (y_true, y_pred, beta = 1)

f2 = fbeta_score (y_true, y_pred, beta = 2)

f05 = fbeta_score (y_true, y_pred, bêta = 0,5)

print (f "précision: {précision: .2f}")

print (f "Rappel: {rappel: .2f}")

print (f "f1 Score: {f1: .2f}")

print (f "f2 Score: {f2: .2f}")

print (f "f0.5 Score: {f05: .2f}")

# Matrice de confusion

conf_matrix = confusion_matrix (y_true, y_pred)

print ("\ nconfusion matrice:")

Print (conf_matrix)Conclusion

Le score F-Beta est un outil puissant pour évaluer les modèles d'apprentissage automatique, en particulier lorsqu'il s'agit de jeux de données ou de situations déséquilibrés où le coût de différents types d'erreurs varie. Sa flexibilité dans la précision de pondération et le rappel le rend adaptable à un large éventail d'applications. En comprenant et en utilisant le score F-BETA, vous pouvez améliorer considérablement votre processus d'évaluation du modèle et obtenir des résultats plus robustes et contextuellement pertinents.

Questions fréquemment posées

Q1: À quoi sert le score F-Beta? A1: Pour évaluer les performances du modèle en équilibrant la précision et le rappel en fonction des besoins d'application.

Q2: Comment β affecte-t-il le score F-Beta? A2: les valeurs β plus élevées hiérarchisent le rappel; Les valeurs β plus faibles hiérarchisent la précision.

Q3: Le score F-Beta est-il adapté aux ensembles de données déséquilibrés? A3: Oui, il est très efficace pour les ensembles de données déséquilibrés.

Q4: En quoi le score F-Beta est-il différent du score F1? A4: Le score F1 est un cas particulier du score F-BETA avec β = 1.

Q5: Puis-je calculer le score F-Beta sans bibliothèque? A5: Oui, mais des bibliothèques comme scikit-learn simplifient le processus.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Processus d'achat et de vente de Bitcoin sur Huobi.com

Processus d'achat et de vente de Bitcoin sur Huobi.com

Utilisation de la fonction isalpha

Utilisation de la fonction isalpha

L'ordinateur ne peut pas copier et coller

L'ordinateur ne peut pas copier et coller

La différence entre mysql et sql_server

La différence entre mysql et sql_server

méthode d'appel du service Web

méthode d'appel du service Web

Comment référencer CSS en HTML

Comment référencer CSS en HTML

Comment vider l'espace des documents cloud WPS lorsqu'il est plein ?

Comment vider l'espace des documents cloud WPS lorsqu'il est plein ?

Comment ouvrir le fichier apk

Comment ouvrir le fichier apk