Diffusion stable 3.5: une plongée profonde dans ses modèles et ses méthodes d'accès

La dernière version de Stability.ai, Stable Diffusion 3.5, possède trois modèles personnalisables - de la taille, du grand turbo et du médium - tous optimisés pour le matériel de consommation. Cet article explore ces modèles, leurs méthodes d'accès et leurs capacités.

Présentation du modèle

Table des matières

Modèles stables diffusion 3.5 expliqués

Tous les modèles sont finables et optimisés pour le matériel des consommateurs.

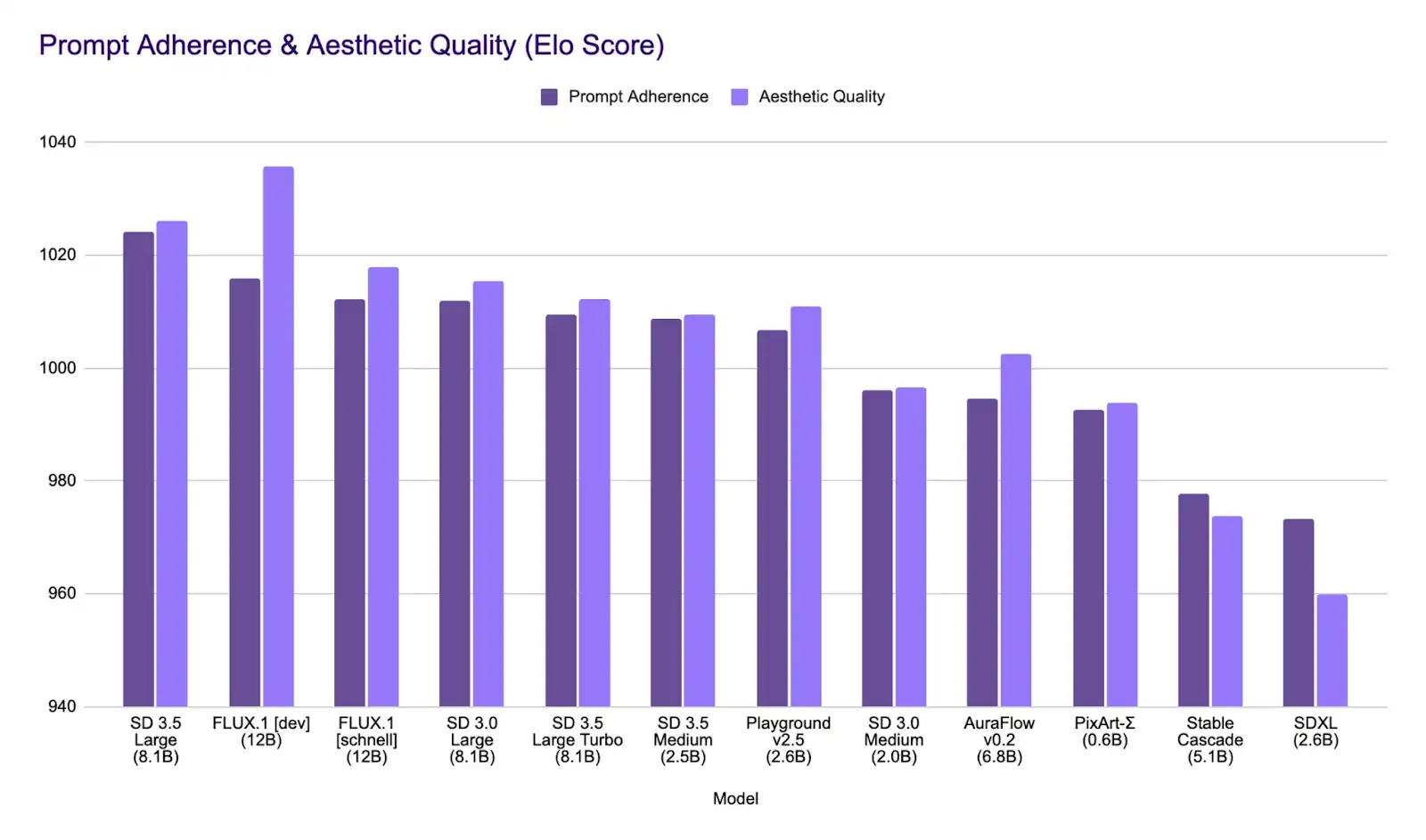

Comparaison du modèle

Diffusion stable 3,5 Grand excelle dans l'adhésion rapide et rivalise avec des modèles plus grands en qualité d'image. Le grand turbo privilégie la vitesse sans sacrifier la qualité, tandis que le milieu offre une option très performante et économe en ressources.

Accéder à une diffusion stable 3.5

Via stabilité.ai plate-forme

Obtenez votre clé API à la plate-forme (25 crédits fournis lors de l'inscription). Utilisez le code Python suivant (Remplacez par votre clé API) dans un environnement jupytre:

Demandes d'importation

Response = requers.Post (

f "https://api.stability.ai/v2beta/stable-image/generate/sd3",

en-têtes = {

"Autorisation": f "Bearer Sk- {api-key}",

"accepter": "image / *"

},

files = {"Aucun": ''},

data = {

"Invite": "Un homme d'âge moyen portant des vêtements formels",

"output_format": "jpeg",

},

)

Si réponse.status_code == 200:

avec open ("./ man.jpeg", 'wb') en tant que fichier:

file.write (réponse.content)

autre:

Soulever une exception (str (réponse.json ()))

(Exemple d'image générée avec l'invite: "Un homme d'âge moyen portant des vêtements formels")

Via le visage étreint

Accédez au modèle directement sur le visage étreint. L'interface permet une inférence immédiate, comme indiqué ci-dessous:

(Exemple d'image générée avec l'invite: "Une forêt avec des arbres rouges")

Pour l'accès à l'API via un visage étreint, suivez ces étapes:

Demandes d'importation

Api_url = "https://api-inference.huggingface.co/models/stabilityai/stable-diffusion-3.5-large"

en-têtes = {"Autorisation": "Bearer Hf_Token"}

Def Query (charge utile):

Response = requers.Post (API_URL, Headers = Headers, JSON = Payse)

Retour Response.Content

image_bytes = query ({

"Entrées": "Un ninja assis au sommet d'un grand bâtiment, 8k",

})

Importer IO

à partir de l'image d'importation PIL

image = image.open (io.bytesio (image_bytes)))

image

(Exemple d'image générée avec l'invite: "Un ninja assis au sommet d'un grand bâtiment, 8k")

Conclusion

Stable Diffusion 3.5 offre une suite polyvalente de modèles de génération d'images répondant à divers besoins et capacités matérielles. Son accessibilité via plusieurs plates-formes simplifie la génération d'images AI de haute qualité.

(Considérez le programme de pinacle Genai pour la formation générative de l'IA.)

Questions fréquemment posées

Q1: Authentification de l'API de la stabilité AI? Utilisez votre clé API dans les en-têtes de demande.

Q2: Erreurs de l'API AI de stabilité commune? Accès non autorisé, paramètres non valides ou dépasser les limites d'utilisation.

Q3: La diffusion stable 3.5 est-elle sans moyenne? Gratuit sous la licence de la communauté de stabilité pour la recherche, l'utilisation non commerciale et les organisations avec moins de 1 million de dollars de revenus. Les plus grandes entités nécessitent une licence d'entreprise.

Q4: Qu'est-ce qui distingue le milieu stable de diffusion 3.5? Amélioration de l'architecture MMDIT-X avec Normalisation QK et double attention pour une génération d'images améliorée entre les résolutions.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

A quoi sert Bitlocker

A quoi sert Bitlocker

Quels types de sélecteurs CSS existe-t-il ?

Quels types de sélecteurs CSS existe-t-il ?

Touches de raccourci de l'écran de verrouillage Windows

Touches de raccourci de l'écran de verrouillage Windows

Comment utiliser la fonction math.round

Comment utiliser la fonction math.round

Comment publier du texte dans WeChat Moments

Comment publier du texte dans WeChat Moments

Utilisation de l'image d'arrière-plan

Utilisation de l'image d'arrière-plan

méthode d'appel du service Web

méthode d'appel du service Web

Comment résoudre l'exception d'argument illégal

Comment résoudre l'exception d'argument illégal

La différence entre la balise d'article et la balise de section

La différence entre la balise d'article et la balise de section