Réseaux de neurones récurrents: LSTM contre GRU - un guide pratique

Je me souviens très bien de rencontrer des réseaux de neurones récurrents (RNN) pendant mes cours. Alors que les données de séquence m'ont initialement captivé, les innombrables architectures sont rapidement devenues déroutantes. La réponse commune du conseiller, «cela dépend», n'a fait qu'amplifier mon incertitude. Une expérimentation approfondie et de nombreux projets plus tard, ma compréhension du moment d'utiliser les LSTM contre GRUS s'est considérablement améliorée. Ce guide vise à clarifier le processus décisionnel de votre prochain projet. Nous nous plongerons dans les détails de LSTMS et GRUS pour vous aider à faire un choix éclairé.

Les réseaux de mémoire à court terme (LSTM), introduits en 1997, abordent le problème du gradient de fuite inhérent aux RNN traditionnels. Leur noyau est une cellule de mémoire capable de conserver des informations sur des périodes prolongées, gérées par trois portes:

Ce contrôle granulaire sur le flux d'informations permet aux LSTM de capturer des dépendances à longue portée dans les séquences.

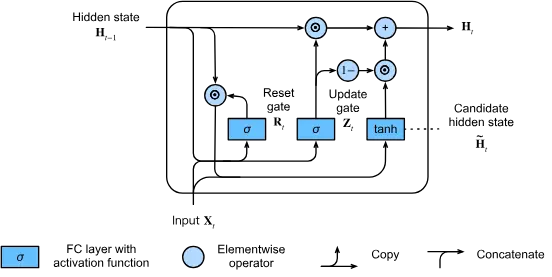

Les unités récurrentes fermées (GRUS), présentées en 2014, simplifient l'architecture LSTM tout en conservant une grande partie de son efficacité. Grus n'utilise que deux portes:

Cette conception rationalisée entraîne une amélioration de l'efficacité de calcul tout en atténuant efficacement le problème du gradient de fuite.

Grus Excel dans:

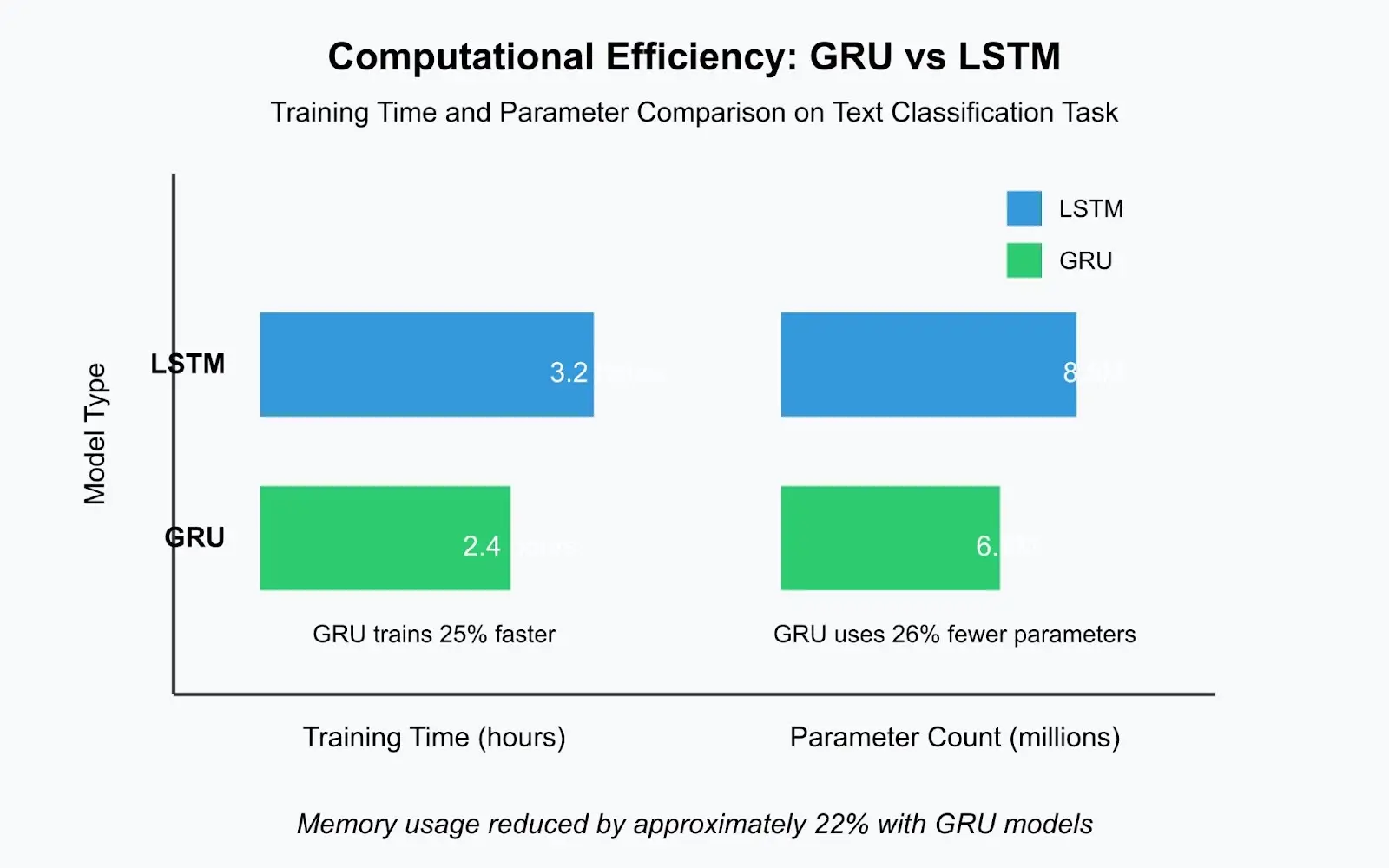

GRUS entraîne généralement 20 à 30% plus rapidement que les LSTM comparables en raison de leur structure plus simple et de moins de paramètres. Dans un récent projet de classification de texte, un modèle GRU s'est formé en 2,4 heures par rapport aux 3,2 heures de LSTM - une différence substantielle pendant le développement itératif.

Les LSTM sont supérieurs pour:

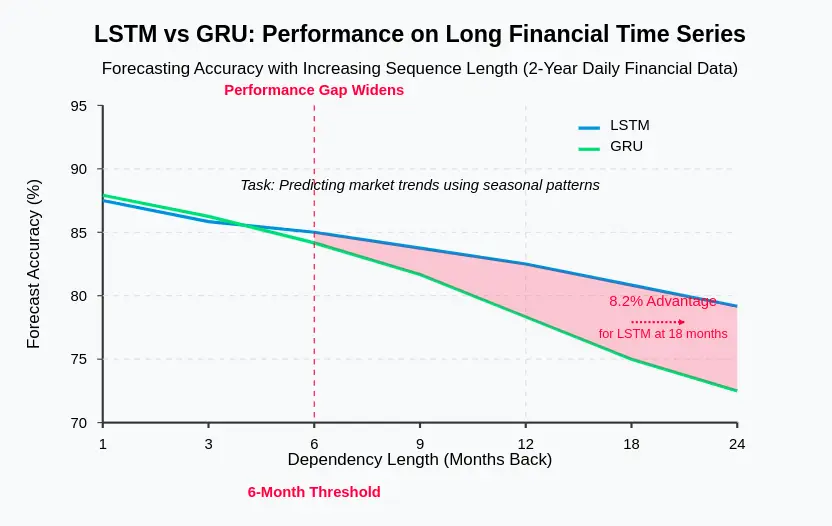

Dans les prévisions de séries chronologiques financières en utilisant des années de données quotidiennes, les LSTM ont systématiquement surpassé GRUS dans la prévision des tendances dépendantes des modèles saisonniers de plusieurs mois auparavant. La cellule de mémoire dédiée dans LSTMS fournit la capacité nécessaire à la rétention à long terme de l'information.

Grus démontre souvent:

GRUS converge fréquemment plus rapidement, atteignant parfois des performances satisfaisantes avec 25% des époques en moins que les LSTM. Cela accélère l'expérimentation et augmente la productivité.

GRUS est avantageux pour:

Un modèle de langue LSTM de production pour une application de service à la clientèle nécessitait 42 Mo de stockage, tandis que l'équivalent GRU n'a besoin que de 31 Mo, une réduction de 26% simplifiant le déploiement sur les appareils Edge.

Pour la plupart des tâches PNL avec des longueurs de séquence modérées (20-100 jetons), GRUS effectue souvent des performances comparables ou mieux que les LSTM tout en s'entraînant plus rapidement. Cependant, pour les tâches impliquant des documents très longs ou une compréhension complexe du langage, les LSTM peuvent offrir un avantage.

Pour les prévisions avec plusieurs modèles saisonniers ou des dépendances à très long terme, les LSTM excellent généralement. Leur cellule de mémoire explicite capture efficacement les modèles temporels complexes.

En reconnaissance vocale avec des longueurs de séquence modérée, GRUS surpasse souvent les LSTM en termes d'efficacité de calcul tout en maintenant une précision comparable.

Lors du choix entre LSTMS et GRUS, considérez ces facteurs:

Considérez les approches hybrides: en utilisant GRUS pour le codage et les LSTM pour le décodage, l'empilement de différents types de couches ou des méthodes d'ensemble. Les architectures basées sur les transformateurs ont largement remplacé les LSTM et GRU pour de nombreuses tâches PNL, mais les modèles récurrents restent précieux pour l'analyse des séries chronologiques et les scénarios où les mécanismes d'attention sont coûteux en calcul.

Comprendre les forces et les faiblesses de LSTMS et GRUS est la clé pour sélectionner l'architecture appropriée. Généralement, le GRUS est un bon point de départ en raison de leur simplicité et de leur efficacité. Passez uniquement aux LSTM si les preuves suggèrent une amélioration des performances pour votre application spécifique. N'oubliez pas que l'ingénierie des caractéristiques efficace, le prétraitement des données et la régularisation ont souvent un impact plus important sur les performances du modèle que le choix entre LSTMS et GRUS. Documentez votre processus décisionnel et vos résultats expérimentaux pour référence future.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Sur quel échange se trouve Sols Inscription Coin ?

Sur quel échange se trouve Sols Inscription Coin ?

Que sont les variables d'environnement

Que sont les variables d'environnement

Les photos Windows ne peuvent pas être affichées

Les photos Windows ne peuvent pas être affichées

Comment utiliser la fonction de longueur dans Matlab

Comment utiliser la fonction de longueur dans Matlab

Comment résoudre l'erreur 1

Comment résoudre l'erreur 1

Comment lire le retour chariot en Java

Comment lire le retour chariot en Java

winkawaksrom

winkawaksrom

Que signifient pleine largeur et demi-largeur ?

Que signifient pleine largeur et demi-largeur ?

Utilisation de la classe Snoopy en php

Utilisation de la classe Snoopy en php