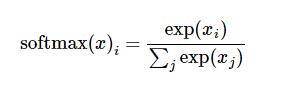

La fonction de régression Softmax est utilisée pour normaliser les résultats de classification. Mais elle est différente de la méthode de normalisation générale en fonction de la proportion. Elle normalise par transformation logarithmique, de sorte que les valeurs plus grandes gagnent davantage au cours du processus de normalisation.

Formule Softmax

Méthode de mise en œuvre de Softmax 1

import numpy as np

def softmax(x):

"""Compute softmax values for each sets of scores in x."""

pass # TODO: Compute and return softmax(x)

x = np.array(x)

x = np.exp(x)

x.astype('float32')

if x.ndim == 1:

sumcol = sum(x)

for i in range(x.size):

x[i] = x[i]/float(sumcol)

if x.ndim > 1:

sumcol = x.sum(axis = 0)

for row in x:

for i in range(row.size):

row[i] = row[i]/float(sumcol[i])

return x

#测试结果

scores = [3.0,1.0, 0.2]

print softmax(scores)

son calcul Les résultats sont les suivants :

[ 0.8360188 0.11314284 0.05083836]

Méthode d'implémentation Softmax 2

import numpy as np def softmax(x): return np.exp(x)/np.sum(np.exp(x),axis=0) #测试结果 scores = [3.0,1.0, 0.2] print softmax(scores)

La méthode d'implémentation de la fonction de régression Softmax en Python ci-dessus (Recommandé) est tout le contenu partagé par l'éditeur. J'espère qu'il pourra vous donner une référence, et j'espère également que vous soutiendrez le site Web PHP chinois.

Pour plus d'articles sur la façon d'implémenter la fonction de régression Softmax sous Python, veuillez faire attention au site Web PHP chinois !