développement back-end

développement back-end

Tutoriel Python

Tutoriel Python

Exemple de diagramme d'utilisation de Python Selenium pour explorer le contenu et stocker la base de données MySQL

Exemple de diagramme d'utilisation de Python Selenium pour explorer le contenu et stocker la base de données MySQL

Exemple de diagramme d'utilisation de Python Selenium pour explorer le contenu et stocker la base de données MySQL

Cet article présente principalement le code d'implémentation de python Selenium explorant le contenu et le stockant dans la Base de données MySQL Les amis qui en ont besoin peuvent se référer à

Je l'ai réussi. plus tôt Un article décrit comment explorer les résumés des blogs CSDN et d'autres informations. Habituellement, après avoir utilisé le robot d'exploration Selenium pour explorer les données, celles-ci doivent être stockées dans du texte TXT, mais cela est difficile à effectuer le traitement et l'analyse des données. Cet article parle principalement de l'exploration des informations de mon blog personnel via Selenium, puis de leur stockage dans la base de données MySQL pour analyser les données, par exemple en analysant la période pendant laquelle il y a plus de blogs, en combinant WordCloud pour analyser le sujet de l'article, le classement des lectures d'articles. , etc. .

Ceci est un article basique. J'espère qu'il vous sera utile. S'il y a des erreurs ou des lacunes dans l'article, veuillez me pardonner. Le prochain article expliquera brièvement le processus d’analyse des données.

1. Résultats de l'exploration

L'adresse explorée est : http://blog.csdn.net/Eastmount

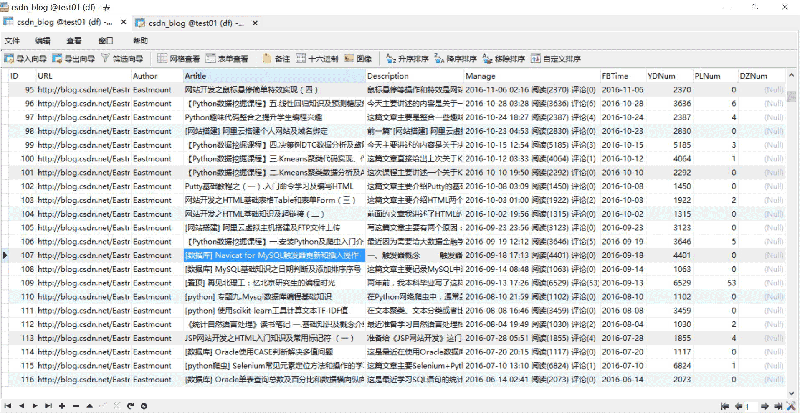

Les résultats de l'exploration et du stockage dans la base de données MySQL sont les suivants :

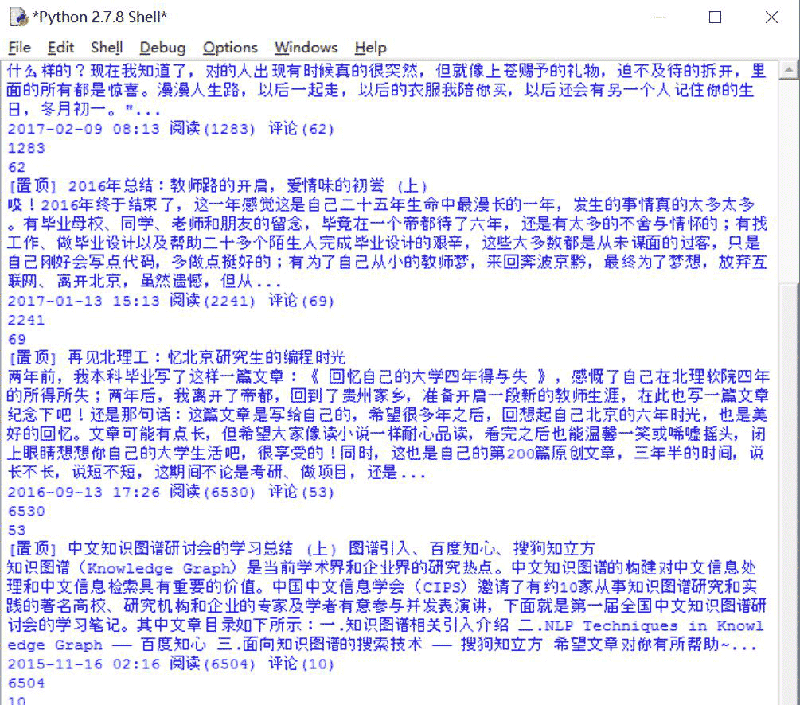

Le processus en cours est comme indiqué ci-dessous Montré :

2. Analyse complète du code

Le code complet est le suivant :

# coding=utf-8

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

import selenium.webdriver.support.ui as ui

import re

import time

import os

import codecs

import MySQLdb

#打开Firefox浏览器 设定等待加载时间

driver = webdriver.Firefox()

wait = ui.WebDriverWait(driver,10)

#获取每个博主的博客页面低端总页码

def getPage():

print 'getPage'

number = 0

texts = driver.find_element_by_xpath("//p[@id='papelist']").text

print '页码', texts

m = re.findall(r'(\w*[0-9]+)\w*',texts) #正则表达式寻找数字

print '页数:' + str(m[1])

return int(m[1])

#主函数

def main():

#获取txt文件总行数

count = len(open("Blog_URL.txt",'rU').readlines())

print count

n = 0

urlfile = open("Blog_URL.txt",'r')

#循环获取每个博主的文章摘信息

while n < count: #这里爬取2个人博客信息,正常情况count个博主信息

url = urlfile.readline()

url = url.strip("\n")

print url

driver.get(url)

#获取总页码

allPage = getPage()

print u'页码总数为:', allPage

time.sleep(2)

#数据库操作结合

try:

conn=MySQLdb.connect(host='localhost',user='root',

passwd='123456',port=3306, db='test01')

cur=conn.cursor() #数据库游标

#报错:UnicodeEncodeError: 'latin-1' codec can't encode character

conn.set_character_set('utf8')

cur.execute('SET NAMES utf8;')

cur.execute('SET CHARACTER SET utf8;')

cur.execute('SET character_set_connection=utf8;')

#具体内容处理

m = 1 #第1页

while m <= allPage:

ur = url + "/article/list/" + str(m)

print ur

driver.get(ur)

#标题

article_title = driver.find_elements_by_xpath("//p[@class='article_title']")

for title in article_title:

#print url

con = title.text

con = con.strip("\n")

#print con + '\n'

#摘要

article_description = driver.find_elements_by_xpath("//p[@class='article_description']")

for description in article_description:

con = description.text

con = con.strip("\n")

#print con + '\n'

#信息

article_manage = driver.find_elements_by_xpath("//p[@class='article_manage']")

for manage in article_manage:

con = manage.text

con = con.strip("\n")

#print con + '\n'

num = 0

print u'长度', len(article_title)

while num < len(article_title):

#插入数据 8个值

sql = '''insert into csdn_blog

(URL,Author,Artitle,Description,Manage,FBTime,YDNum,PLNum)

values(%s, %s, %s, %s, %s, %s, %s, %s)'''

Artitle = article_title[num].text

Description = article_description[num].text

Manage = article_manage[num].text

print Artitle

print Description

print Manage

#获取作者

Author = url.split('/')[-1]

#获取阅读数和评论数

mode = re.compile(r'\d+\.?\d*')

YDNum = mode.findall(Manage)[-2]

PLNum = mode.findall(Manage)[-1]

print YDNum

print PLNum

#获取发布时间

end = Manage.find(u' 阅读')

FBTime = Manage[:end]

cur.execute(sql, (url, Author, Artitle, Description, Manage,FBTime,YDNum,PLNum))

num = num + 1

else:

print u'数据库插入成功'

m = m + 1

#异常处理

except MySQLdb.Error,e:

print "Mysql Error %d: %s" % (e.args[0], e.args[1])

finally:

cur.close()

conn.commit()

conn.close()

n = n + 1

else:

urlfile.close()

print 'Load Over'

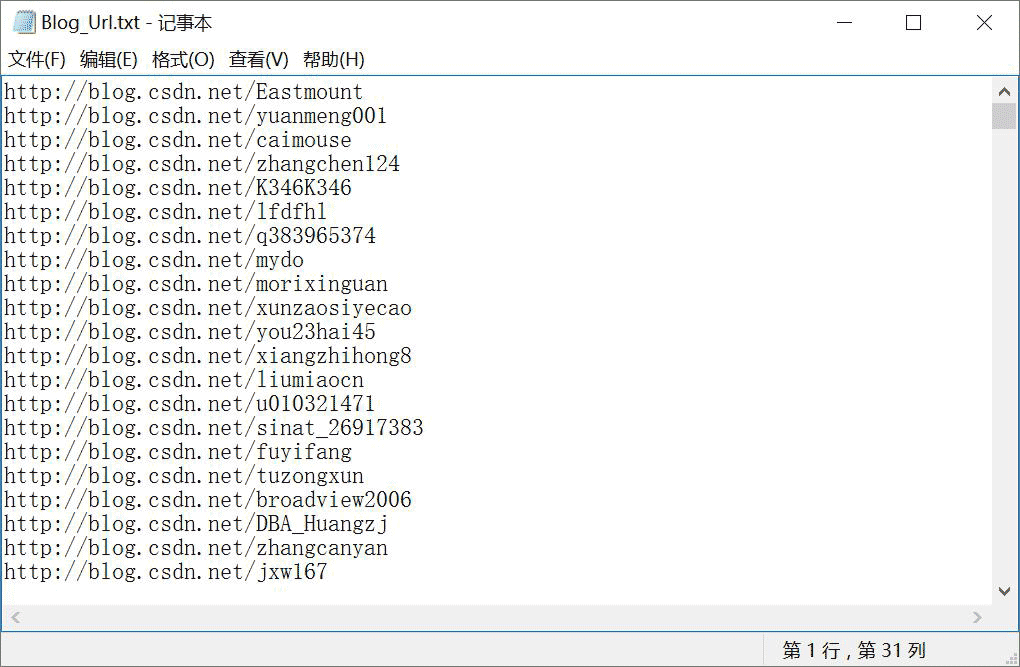

main()Placez l'URL de l'adresse du blog de l'utilisateur qui doit être exploré dans le fichier Blog_Url.txt, comme indiqué dans la figure ci-dessous. Notez qu'ici, l'auteur a pré-écrit un code URL pour explorer tous les experts CSDN, qui a été omis ici pour accéder aux ressources d'autres personnes afin d'augmenter le volume de lecture.

Le processus d'analyse est le suivant.

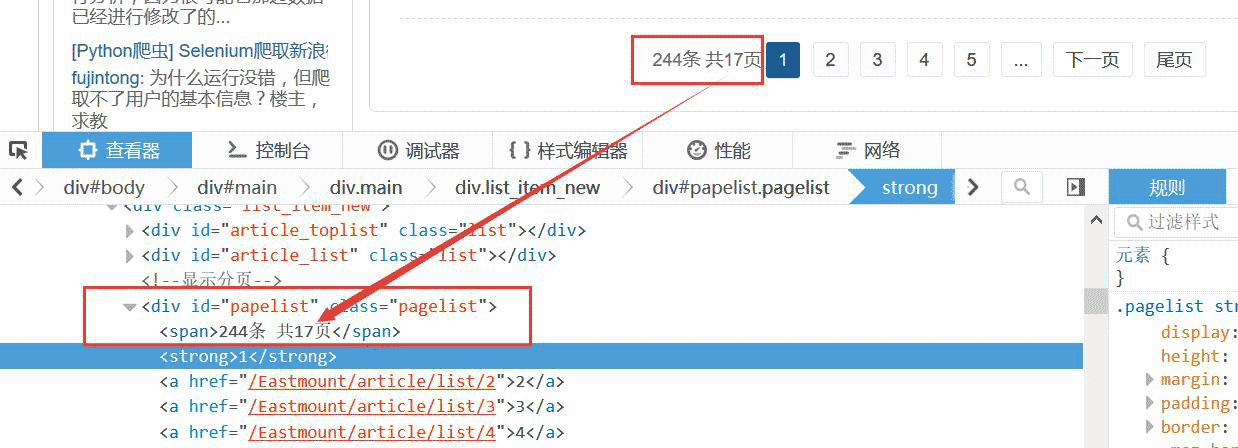

1. Obtenez le numéro de page total du blogueur

Lisez d'abord l'adresse du blogueur à partir de Blog_Url.txt, puis accédez et obtenez le numéro de page total. Le code est le suivant :

#获取每个博主的博客页面低端总页码

def getPage():

print 'getPage'

number = 0

texts = driver.find_element_by_xpath("//p[@id='papelist']").text

print '页码', texts

m = re.findall(r'(\w*[0-9]+)\w*',texts) #正则表达式寻找数字

print '页数:' + str(m[1])

return int(m[1])Par exemple, pour obtenir le numéro de page total de 17 pages, comme indiqué ci-dessous :

2. Analyse de l'arborescence DOM de rotation de page

La page de blog qui se tourne ici utilise une connexion URL, ce qui est plus pratique.

Par exemple : http://blog.csdn.net/Eastmount/article/list/2

Vous n'avez donc besoin que de : 1. Obtenir le numéro de page total 2. Explorer les informations de chaque page ; Définissez l'URL pour qu'elle parcoure la page ; 4. Explorez à nouveau.

Vous pouvez également cliquer sur « Page suivante » pour sauter. S'il n'y a pas de « Page suivante », le saut s'arrêtera, le robot d'exploration se terminera, puis le blogueur suivant sera exploré.

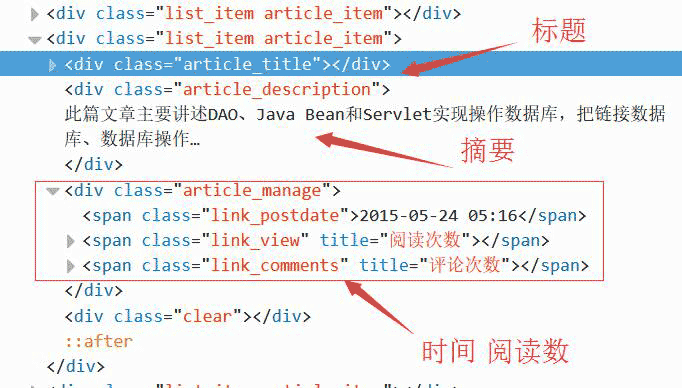

3. Obtenez les détails : titre, résumé, heure

Puis examinez les éléments et analysez chaque page du blog, si vous utilisez Beaut L'exploration IfulSoup signalera une erreur "Interdit".

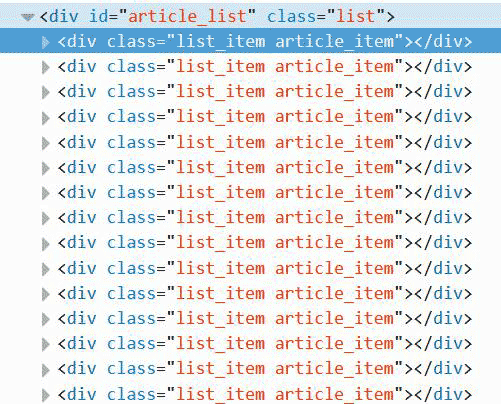

J'ai constaté que chaque article est composé d'un

Vous pouvez explorer en localisant l'emplacement. Ici, vous devez localiser respectivement le titre, le résumé et l'heure.

代码如下所示。注意,在while中同时获取三个值,它们是对应的。

#标题

article_title = driver.find_elements_by_xpath("//p[@class='article_title']")

for title in article_title:

con = title.text

con = con.strip("\n")

print con + '\n'

#摘要

article_description = driver.find_elements_by_xpath("//p[@class='article_description']")

for description in article_description:

con = description.text

con = con.strip("\n")

print con + '\n'

#信息

article_manage = driver.find_elements_by_xpath("//p[@class='article_manage']")

for manage in article_manage:

con = manage.text

con = con.strip("\n")

print con + '\n'

num = 0

print u'长度', len(article_title)

while num < len(article_title):

Artitle = article_title[num].text

Description = article_description[num].text

Manage = article_manage[num].text

print Artitle, Description, Manage 4.特殊字符串处理

获取URL最后一个/后的博主名称、获取字符串时间、阅读数代码如下:

#获取博主姓名 url = "http://blog.csdn.net/Eastmount" print url.split('/')[-1] #输出: Eastmount #获取数字 name = "2015-09-08 18:06 阅读(909) 评论(0)" print name import re mode = re.compile(r'\d+\.?\d*') print mode.findall(name) #输出: ['2015', '09', '08', '18', '06', '909', '0'] print mode.findall(name)[-2] #输出: 909 #获取时间 end = name.find(r' 阅读') print name[:end] #输出: 2015-09-08 18:06 import time, datetime a = time.strptime(name[:end],'%Y-%m-%d %H:%M') print a #输出: time.struct_time(tm_year=2015, tm_mon=9, tm_mday=8, tm_hour=18, tm_min=6, # tm_sec=0, tm_wday=1, tm_yday=251, tm_isdst=-1)

三. 数据库相关操作

SQL语句创建表代码如下:

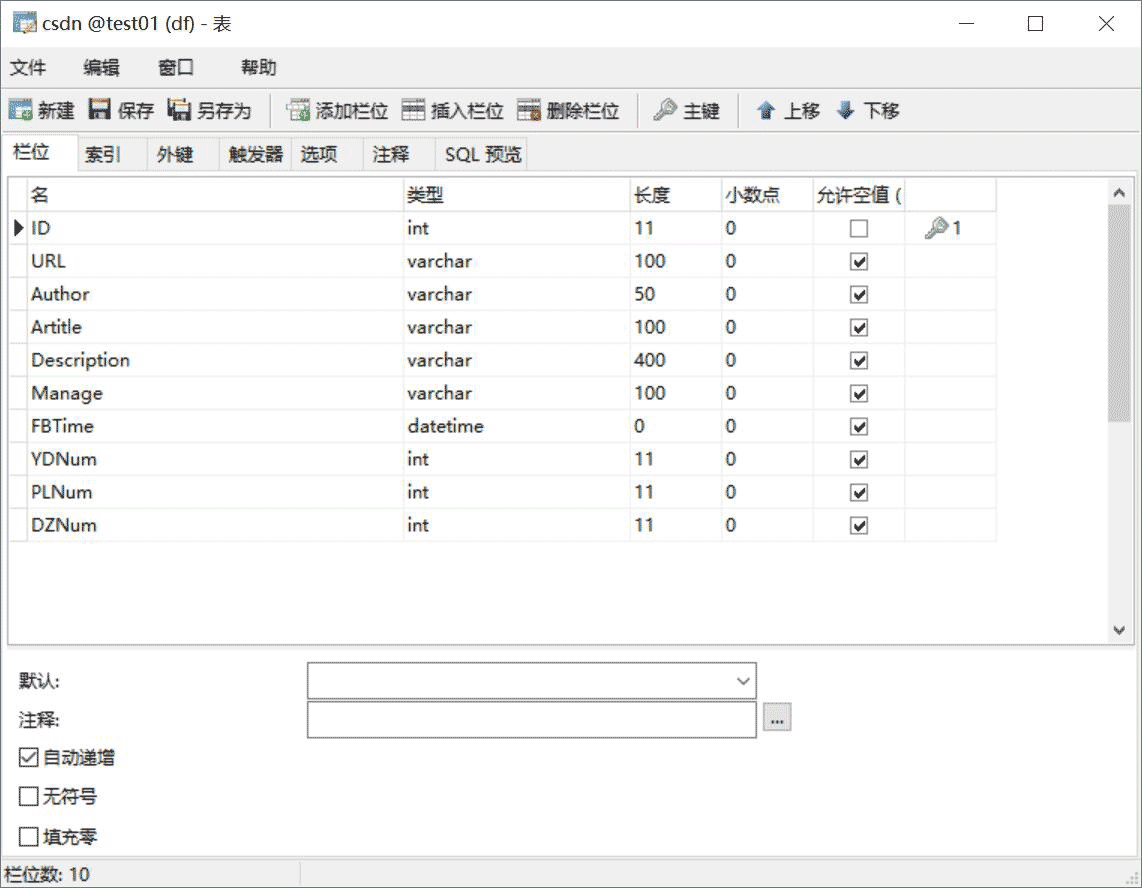

CREATE TABLE `csdn` ( `ID` int(11) NOT NULL AUTO_INCREMENT, `URL` varchar(100) COLLATE utf8_bin DEFAULT NULL, `Author` varchar(50) COLLATE utf8_bin DEFAULT NULL COMMENT '作者', `Artitle` varchar(100) COLLATE utf8_bin DEFAULT NULL COMMENT '标题', `Description` varchar(400) COLLATE utf8_bin DEFAULT NULL COMMENT '摘要', `Manage` varchar(100) COLLATE utf8_bin DEFAULT NULL COMMENT '信息', `FBTime` datetime DEFAULT NULL COMMENT '发布日期', `YDNum` int(11) DEFAULT NULL COMMENT '阅读数', `PLNum` int(11) DEFAULT NULL COMMENT '评论数', `DZNum` int(11) DEFAULT NULL COMMENT '点赞数', PRIMARY KEY (`ID`) ) ENGINE=InnoDB AUTO_INCREMENT=9371 DEFAULT CHARSET=utf8 COLLATE=utf8_bin;

显示如下图所示:

其中,Python调用MySQL推荐下面这篇文字。

python专题九.Mysql数据库编程基础知识

核心代码如下所示:

# coding:utf-8 import MySQLdb try: conn=MySQLdb.connect(host='localhost',user='root',passwd='123456',port=3306, db='test01') cur=conn.cursor() #插入数据 sql = '''insert into student values(%s, %s, %s)''' cur.execute(sql, ('yxz','111111', '10')) #查看数据 print u'\n插入数据:' cur.execute('select * from student') for data in cur.fetchall(): print '%s %s %s' % data cur.close() conn.commit() conn.close() except MySQLdb.Error,e: print "Mysql Error %d: %s" % (e.args[0], e.args[1])

注意,在下载过程中,有的网站是新版本的,无法获取页码。

比如:http://blog.csdn.net/michaelzhou224

这时需要简单设置,跳过这些链接,并保存到文件中,核心代码如下所示:

#获取每个博主的博客页面低端总页码

def getPage():

print 'getPage'

number = 0

#texts = driver.find_element_by_xpath("//p[@id='papelist']").text

texts = driver.find_element_by_xpath("//p[@class='pagelist']").text

print 'testsss'

print u'页码', texts

if texts=="":

print u'页码为0 网站错误'

return 0

m = re.findall(r'(\w*[0-9]+)\w*',texts) #正则表达式寻找数字

print u'页数:' + str(m[1])

return int(m[1])主函数修改:

error = codecs.open("Blog_Error.txt", 'a', 'utf-8')

#循环获取每个博主的文章摘信息

while n < count: #这里爬取2个人博客信息,正常情况count个博主信息

url = urlfile.readline()

url = url.strip("\n")

print url

driver.get(url+"/article/list/1")

#print driver.page_source

#获取总页码

allPage = getPage()

print u'页码总数为:', allPage

#返回错误,否则程序总截住

if allPage==0:

error.write(url + "\r\n")

print u'错误URL'

continue; #跳过进入下一个博主

time.sleep(2)

#数据库操作结合

try:

.....Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

PHP et Python: différents paradigmes expliqués

Apr 18, 2025 am 12:26 AM

PHP et Python: différents paradigmes expliqués

Apr 18, 2025 am 12:26 AM

PHP est principalement la programmation procédurale, mais prend également en charge la programmation orientée objet (POO); Python prend en charge une variété de paradigmes, y compris la POO, la programmation fonctionnelle et procédurale. PHP convient au développement Web, et Python convient à une variété d'applications telles que l'analyse des données et l'apprentissage automatique.

Choisir entre PHP et Python: un guide

Apr 18, 2025 am 12:24 AM

Choisir entre PHP et Python: un guide

Apr 18, 2025 am 12:24 AM

PHP convient au développement Web et au prototypage rapide, et Python convient à la science des données et à l'apprentissage automatique. 1.Php est utilisé pour le développement Web dynamique, avec une syntaxe simple et adapté pour un développement rapide. 2. Python a une syntaxe concise, convient à plusieurs champs et a un écosystème de bibliothèque solide.

Rôle de MySQL: Bases de données dans les applications Web

Apr 17, 2025 am 12:23 AM

Rôle de MySQL: Bases de données dans les applications Web

Apr 17, 2025 am 12:23 AM

Le rôle principal de MySQL dans les applications Web est de stocker et de gérer les données. 1.MySQL traite efficacement les informations utilisateur, les catalogues de produits, les enregistrements de transaction et autres données. 2. Grâce à SQL Query, les développeurs peuvent extraire des informations de la base de données pour générer du contenu dynamique. 3.MySQL fonctionne basé sur le modèle client-serveur pour assurer une vitesse de requête acceptable.

Exemple d'introduction de Laravel

Apr 18, 2025 pm 12:45 PM

Exemple d'introduction de Laravel

Apr 18, 2025 pm 12:45 PM

Laravel est un cadre PHP pour la création facile des applications Web. Il fournit une gamme de fonctionnalités puissantes, notamment: Installation: Installez le Laravel CLI globalement avec Composer et créez des applications dans le répertoire du projet. Routage: définissez la relation entre l'URL et le gestionnaire dans Routes / web.php. Voir: Créez une vue dans les ressources / vues pour rendre l'interface de l'application. Intégration de la base de données: fournit une intégration prête à l'emploi avec des bases de données telles que MySQL et utilise la migration pour créer et modifier des tables. Modèle et contrôleur: le modèle représente l'entité de la base de données et le contrôleur traite les demandes HTTP.

PHP et Python: une plongée profonde dans leur histoire

Apr 18, 2025 am 12:25 AM

PHP et Python: une plongée profonde dans leur histoire

Apr 18, 2025 am 12:25 AM

PHP est originaire en 1994 et a été développé par Rasmuslerdorf. Il a été utilisé à l'origine pour suivre les visiteurs du site Web et a progressivement évolué en un langage de script côté serveur et a été largement utilisé dans le développement Web. Python a été développé par Guidovan Rossum à la fin des années 1980 et a été publié pour la première fois en 1991. Il met l'accent sur la lisibilité et la simplicité du code, et convient à l'informatique scientifique, à l'analyse des données et à d'autres domaines.

Comment exécuter Python avec le bloc-notes

Apr 16, 2025 pm 07:33 PM

Comment exécuter Python avec le bloc-notes

Apr 16, 2025 pm 07:33 PM

L'exécution du code Python dans le bloc-notes nécessite l'installation du plug-in exécutable Python et du plug-in NPEXEC. Après avoir installé Python et ajouté un chemin à lui, configurez la commande "python" et le paramètre "{current_directory} {file_name}" dans le plug-in nppexec pour exécuter le code python via la touche de raccourci "F6" dans le bloc-notes.

Résolvez le problème de la connexion de la base de données: un cas pratique d'utilisation de la bibliothèque Minii / DB

Apr 18, 2025 am 07:09 AM

Résolvez le problème de la connexion de la base de données: un cas pratique d'utilisation de la bibliothèque Minii / DB

Apr 18, 2025 am 07:09 AM

J'ai rencontré un problème délicat lors du développement d'une petite application: la nécessité d'intégrer rapidement une bibliothèque d'opération de base de données légère. Après avoir essayé plusieurs bibliothèques, j'ai constaté qu'ils avaient trop de fonctionnalités ou ne sont pas très compatibles. Finalement, j'ai trouvé Minii / DB, une version simplifiée basée sur YII2 qui a parfaitement résolu mon problème.

Golang vs Python: différences et similitudes clés

Apr 17, 2025 am 12:15 AM

Golang vs Python: différences et similitudes clés

Apr 17, 2025 am 12:15 AM

Golang et Python ont chacun leurs propres avantages: Golang convient aux performances élevées et à la programmation simultanée, tandis que Python convient à la science des données et au développement Web. Golang est connu pour son modèle de concurrence et ses performances efficaces, tandis que Python est connu pour sa syntaxe concise et son écosystème de bibliothèque riche.