développement back-end

développement back-end

Tutoriel Python

Tutoriel Python

Le robot d'exploration Python obtient des sites Web de drames américains

Le robot d'exploration Python obtient des sites Web de drames américains

Le robot d'exploration Python obtient des sites Web de drames américains

Cet article a été rédigé à l'origine par MaNong.com – Xiao Hao Veuillez lire les exigences de réimpression à la fin de l'article pour la réimpression. Bienvenue pour participer à notre plan de contribution payante !

J'ai toujours eu l'habitude de regarder des séries télé américaines. D'un côté, je peux pratiquer mon écoute en anglais et, de l'autre, je passe le temps. Autrefois, il était possible de regarder des films en ligne sur des sites de vidéo, mais depuis l'ordonnance de restriction imposée par l'Administration d'État de la radio, du cinéma et de la télévision, les fictions américaines et britanniques importées ne semblent plus être mises à jour simultanément comme avant. Cependant, en tant que nerd, comment puis-je être prêt à ne pas suivre les drames, alors j'ai vérifié en ligne et trouvé un site Web de téléchargement de drames américains [Tiantian American Drama] qui peut être téléchargé à l'aide de Thunder. Je peux télécharger diverses ressources à volonté. Je suis obsédé par le documentaire haute définition de la BBC, la nature est si belle.

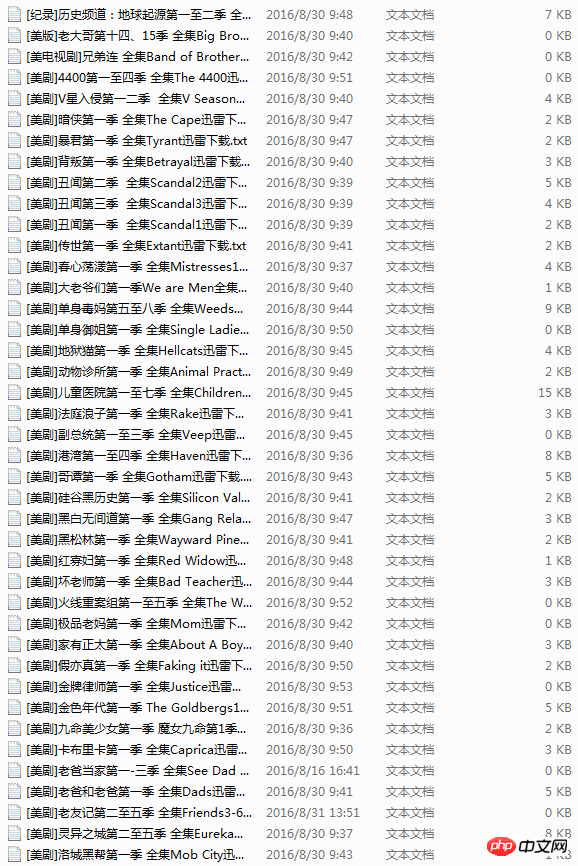

Bien que j'ai trouvé un site Web de ressources qui peut être téléchargé, mais à chaque fois je dois ouvrir le navigateur, saisir l'URL, trouver le drame américain, puis cliquer sur le lien pour télécharger. Après une longue période, le processus devient très fastidieux et parfois le lien du site Web ne peut pas être ouvert, ce qui est un peu gênant. Il se trouve que j'ai appris le crawler Python, alors aujourd'hui, j'ai écrit un robot sur un coup de tête pour récupérer tous les liens de drames américains sur le site Web et les enregistrer dans un document texte. Si vous voulez un drame, ouvrez-le simplement. et copiez le lien vers Vous pouvez le télécharger via Thunder.

En fait, j'avais initialement prévu d'écrire une méthode qui trouve une URL, utilise des requêtes pour ouvrir et explorer le lien de téléchargement, et explore l'ensemble du site à partir de la page d'accueil. Cependant, il y a beaucoup de liens répétés et l'URL du site Web n'est pas aussi régulière que je le pensais. Après avoir écrit pendant longtemps, je n'ai toujours pas écrit le type de robot d'exploration divergent que je souhaite. prêt, alors continuez à travailler dur. . .

Plus tard, j'ai découvert que les liens vers la série télévisée sont tous dans l'article, et qu'il y a un numéro après l'URL de l'article, comme celui-ci http://cn163.net/archives/24016/, J'ai donc intelligemment utilisé l'expérience du robot que j'ai écrite auparavant. La solution est de générer automatiquement l'URL. Le numéro derrière ne peut-il pas être modifié et chaque drame est unique, j'ai donc essayé de savoir combien d'articles il y a. , puis utilisez la fonction range pour générer directement des nombres en continu afin de construire l'URL.

Mais de nombreuses URL n'existent pas, donc elles raccrocheront directement. Ne vous inquiétez pas, nous utilisons des requêtes, et son status_code intégré est utilisé pour déterminer l'état renvoyé par la requête, donc aussi longtemps. comme c'est le statut renvoyé, nous ignorons tous ceux avec le code 404 et explorons les autres liens, ce qui résout le problème d'URL.

Ce qui suit est le code de mise en œuvre des étapes ci-dessus.

def get_urls(self):

try:

for i in range(2015,25000):

base_url='http://cn163.net/archives/'

url=base_url+str(i)+'/'

if requests.get(url).status_code == 404:

continue

else:

self.save_links(url)

except Exception,e:

passLe reste s'est bien passé. J'ai trouvé un robot d'exploration similaire écrit par quelqu'un auparavant sur Internet, mais il n'a exploré qu'un seul article, j'ai donc emprunté ses expressions régulières. J'ai utilisé BeautifulSoup mais l'effet n'était pas aussi bon que la méthode habituelle, j'ai donc abandonné de manière décisive. Il n'y a pas de limite à mon apprentissage. Cependant, l’effet n’est pas si idéal. Environ la moitié des liens ne peuvent pas être explorés correctement et doivent continuer à être optimisés.

# -*- coding:utf-8 -*-

import requests

import re

import sys

import threading

import time

reload(sys)

sys.setdefaultencoding('utf-8')

class Archives(object):

def save_links(self,url):

try:

data=requests.get(url,timeout=3)

content=data.text

link_pat='"(ed2k://\|file\|[^"]+?\.(S\d+)(E\d+)[^"]+?1024X\d{3}[^"]+?)"'

name_pat=re.compile(r'<h2 class="entry_title">(.*?)</h2>',re.S)

links = set(re.findall(link_pat,content))

name=re.findall(name_pat,content)

links_dict = {}

count=len(links)

except Exception,e:

pass

for i in links:

links_dict[int(i[1][1:3]) * 100 + int(i[2][1:3])] = i#把剧集按s和e提取编号

try:

with open(name[0].replace('/',' ')+'.txt','w') as f:

print name[0]

for i in sorted(list(links_dict.keys())):#按季数+集数排序顺序写入

f.write(links_dict[i][0] + '\n')

print "Get links ... ", name[0], count

except Exception,e:

pass

def get_urls(self):

try:

for i in range(2015,25000):

base_url='http://cn163.net/archives/'

url=base_url+str(i)+'/'

if requests.get(url).status_code == 404:

continue

else:

self.save_links(url)

except Exception,e:

pass

def main(self):

thread1=threading.Thread(target=self.get_urls())

thread1.start()

thread1.join()

if __name__ == '__main__':

start=time.time()

a=Archives()

a.main()

end=time.time()

print end-startLa version complète du code, qui utilise également le multi-threading, mais cela semble inutile, probablement à cause du GIL de Python. Il semble y avoir plus de 20 000 drames. Je pensais que cela prendrait beaucoup de temps. Il est temps de l'attraper. La récupération est terminée, mais en excluant les erreurs d'URL et les URL sans correspondance, la durée totale de récupération est inférieure à 20 minutes. Au départ, je voulais utiliser Redis pour explorer deux machines Linux, mais après beaucoup d'agitation, j'ai pensé que c'était inutile, alors je l'ai laissé là et je le ferai plus tard lorsque j'aurai besoin de plus de données.

Un autre problème qui m'a troublé pendant le processus était la sauvegarde des noms de fichiers. Je dois me plaindre ici. Les noms de fichiers au format texte txt peuvent avoir des espaces, mais ils ne peuvent pas avoir de barres obliques inverses, ou de crochets, etc. C'est là le problème. J'ai passé toute la matinée là-dessus. Au début, j'ai pensé que c'était une erreur lors de l'exploration des données. Après une longue vérification, j'ai découvert que le titre du drame analysé contenait une barre oblique. misérable. .

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

PHP et Python: exemples de code et comparaison

Apr 15, 2025 am 12:07 AM

PHP et Python: exemples de code et comparaison

Apr 15, 2025 am 12:07 AM

PHP et Python ont leurs propres avantages et inconvénients, et le choix dépend des besoins du projet et des préférences personnelles. 1.Php convient au développement rapide et à la maintenance des applications Web à grande échelle. 2. Python domine le domaine de la science des données et de l'apprentissage automatique.

Python vs JavaScript: communauté, bibliothèques et ressources

Apr 15, 2025 am 12:16 AM

Python vs JavaScript: communauté, bibliothèques et ressources

Apr 15, 2025 am 12:16 AM

Python et JavaScript ont leurs propres avantages et inconvénients en termes de communauté, de bibliothèques et de ressources. 1) La communauté Python est amicale et adaptée aux débutants, mais les ressources de développement frontal ne sont pas aussi riches que JavaScript. 2) Python est puissant dans les bibliothèques de science des données et d'apprentissage automatique, tandis que JavaScript est meilleur dans les bibliothèques et les cadres de développement frontaux. 3) Les deux ont des ressources d'apprentissage riches, mais Python convient pour commencer par des documents officiels, tandis que JavaScript est meilleur avec MDNWEBDOCS. Le choix doit être basé sur les besoins du projet et les intérêts personnels.

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Docker utilise les fonctionnalités du noyau Linux pour fournir un environnement de fonctionnement d'application efficace et isolé. Son principe de travail est le suivant: 1. Le miroir est utilisé comme modèle en lecture seule, qui contient tout ce dont vous avez besoin pour exécuter l'application; 2. Le Système de fichiers Union (UnionFS) empile plusieurs systèmes de fichiers, ne stockant que les différences, l'économie d'espace et l'accélération; 3. Le démon gère les miroirs et les conteneurs, et le client les utilise pour l'interaction; 4. Les espaces de noms et les CGROUP implémentent l'isolement des conteneurs et les limitations de ressources; 5. Modes de réseau multiples prennent en charge l'interconnexion du conteneur. Ce n'est qu'en comprenant ces concepts principaux que vous pouvez mieux utiliser Docker.

Comment exécuter des programmes dans Terminal Vscode

Apr 15, 2025 pm 06:42 PM

Comment exécuter des programmes dans Terminal Vscode

Apr 15, 2025 pm 06:42 PM

Dans VS Code, vous pouvez exécuter le programme dans le terminal via les étapes suivantes: Préparez le code et ouvrez le terminal intégré pour vous assurer que le répertoire de code est cohérent avec le répertoire de travail du terminal. Sélectionnez la commande Run en fonction du langage de programmation (tel que Python de Python your_file_name.py) pour vérifier s'il s'exécute avec succès et résoudre les erreurs. Utilisez le débogueur pour améliorer l'efficacité du débogage.

Qu'est-ce que VScode pour quoi est VScode?

Apr 15, 2025 pm 06:45 PM

Qu'est-ce que VScode pour quoi est VScode?

Apr 15, 2025 pm 06:45 PM

VS Code est le code Visual Studio Nom complet, qui est un éditeur de code multiplateforme gratuit et open source et un environnement de développement développé par Microsoft. Il prend en charge un large éventail de langages de programmation et fournit une mise en surbrillance de syntaxe, une complétion automatique du code, des extraits de code et des invites intelligentes pour améliorer l'efficacité de développement. Grâce à un écosystème d'extension riche, les utilisateurs peuvent ajouter des extensions à des besoins et des langues spécifiques, tels que les débogueurs, les outils de mise en forme de code et les intégrations GIT. VS Code comprend également un débogueur intuitif qui aide à trouver et à résoudre rapidement les bogues dans votre code.

Python: automatisation, script et gestion des tâches

Apr 16, 2025 am 12:14 AM

Python: automatisation, script et gestion des tâches

Apr 16, 2025 am 12:14 AM

Python excelle dans l'automatisation, les scripts et la gestion des tâches. 1) Automatisation: La sauvegarde du fichier est réalisée via des bibliothèques standard telles que le système d'exploitation et la fermeture. 2) Écriture de script: utilisez la bibliothèque PSUTIL pour surveiller les ressources système. 3) Gestion des tâches: utilisez la bibliothèque de planification pour planifier les tâches. La facilité d'utilisation de Python et la prise en charge de la bibliothèque riche en font l'outil préféré dans ces domaines.

Peut-on exécuter le code sous Windows 8

Apr 15, 2025 pm 07:24 PM

Peut-on exécuter le code sous Windows 8

Apr 15, 2025 pm 07:24 PM

VS Code peut fonctionner sur Windows 8, mais l'expérience peut ne pas être excellente. Assurez-vous d'abord que le système a été mis à jour sur le dernier correctif, puis téléchargez le package d'installation VS Code qui correspond à l'architecture du système et l'installez comme invité. Après l'installation, sachez que certaines extensions peuvent être incompatibles avec Windows 8 et doivent rechercher des extensions alternatives ou utiliser de nouveaux systèmes Windows dans une machine virtuelle. Installez les extensions nécessaires pour vérifier si elles fonctionnent correctement. Bien que le code VS soit possible sur Windows 8, il est recommandé de passer à un système Windows plus récent pour une meilleure expérience de développement et une meilleure sécurité.

Le code Visual Studio peut-il être utilisé dans Python

Apr 15, 2025 pm 08:18 PM

Le code Visual Studio peut-il être utilisé dans Python

Apr 15, 2025 pm 08:18 PM

VS Code peut être utilisé pour écrire Python et fournit de nombreuses fonctionnalités qui en font un outil idéal pour développer des applications Python. Il permet aux utilisateurs de: installer des extensions Python pour obtenir des fonctions telles que la réalisation du code, la mise en évidence de la syntaxe et le débogage. Utilisez le débogueur pour suivre le code étape par étape, trouver et corriger les erreurs. Intégrez Git pour le contrôle de version. Utilisez des outils de mise en forme de code pour maintenir la cohérence du code. Utilisez l'outil de liaison pour repérer les problèmes potentiels à l'avance.