développement back-end

développement back-end

Tutoriel XML/RSS

Tutoriel XML/RSS

RSS et robots d'exploration, explication détaillée de la façon de collecter des données

RSS et robots d'exploration, explication détaillée de la façon de collecter des données

RSS et robots d'exploration, explication détaillée de la façon de collecter des données

Résumé : Avant de pouvoir extraire la valeur des données, elles doivent d'abord passer par des processus tels que la collecte, le stockage, l'analyse et le calcul. L'obtention de données complètes et précises est la base de l'exploration de la valeur des données. Ce numéro de « Big Data Story » du CSDN Cloud Computing Club commencera par les méthodes de collecte de données les plus courantes : les robots RSS et les moteurs de recherche.

Le 30 décembre, l'événement CSDN Cloud Computing Club s'est tenu au 3W Coffee. Le thème de l'événement était "RSS et robots d'exploration : l'histoire du Big Data - En commençant par comment collecter des données". Avant de pouvoir exploiter la valeur des données, elles doivent d'abord passer par des processus tels que la collecte, le stockage, l'analyse et le calcul. L'obtention de données complètes et précises constitue la base de l'exploration de la valeur des données. Peut-être que les données actuelles ne peuvent pas apporter une réelle valeur à l'entreprise ou à l'organisation, mais en tant que décideur clairvoyant, vous devez comprendre que les données importantes doivent être collectées et sauvegardées le plus tôt possible. Ce numéro de « Big Data Story » commencera par les méthodes de collecte de données les plus courantes : les robots RSS et les moteurs de recherche.

L'événement était plein à craquer

Tout d'abord, Cui Kejun, directeur général de la division bibliothèque de Beijing Wanfang Software Co., Ltd., a partagé le thème de « Mise en œuvre RSS à grande échelle Applications initiales de l'agrégation et du téléchargement de sites Web dans la recherche scientifique. » Cui Kejun a travaillé dans le secteur des bibliothèques et de l'information pendant 12 ans et possède une riche expérience dans la collecte de données. Il a principalement partagé le RSS, un moyen important d'agrégation d'informations, et sa technologie de mise en œuvre.

RSS (Really Simple Syndication) est une spécification de format source utilisée pour regrouper des sites Web qui publient fréquemment des données mises à jour, telles que des articles de blog, des actualités, des extraits audio ou vidéo. Les fichiers RSS contiennent du texte intégral ou des extraits de texte, ainsi que des extraits de données et des métadonnées d'autorisation du réseau auquel l'utilisateur est abonné.

L'agrégation de centaines, voire de milliers de graines RSS étroitement liées à un certain secteur vous permettra de comprendre rapidement et de manière complète les derniers développements dans un certain secteur. En téléchargeant des données complètes à partir d'un site Web et en effectuant une exploration de données, vous sera capable de comprendre les tenants et les aboutissants du développement d'un certain sujet dans l'industrie.

Cui Kejun, directeur général du département de bibliothèque de Beijing Wanfang Software Co., Ltd.

Cui Kejun a présenté le rôle du RSS dans l'Institut de La physique des hautes énergies comme exemple. Applications dans les instituts de recherche scientifique. La surveillance des informations sur la physique des hautes énergies cible les institutions homologues de la physique des hautes énergies du monde entier : laboratoires, sociétés industrielles, associations internationales, agences gouvernementales en charge de la recherche scientifique dans divers pays, publications scientifiques complètes clés, projets expérimentaux de physique des hautes énergies et installations expérimentales. . Les types d'informations surveillées sont : actualités, articles, rapports de conférences, analyses et critiques, prépublications, études de cas, multimédia, livres, informations de recrutement, etc.

Les informations sur la littérature sur la physique des hautes énergies utilisent le système de gestion de contenu open source le plus avancé Drupal, la technologie de recherche open source Apache Solr, ainsi que la technologie PubSubHubbub développée par les employés de Google pour s'abonner aux actualités en temps réel et à celles d'Amazon. OpenSearch pour établir un ensemble de physique des hautes énergies Le système de surveillance des informations est différent de l'abonnement et du push RSS traditionnels, et réalise la capture d'informations presque en temps réel et la diffusion active de nouvelles avec n'importe quel mot-clé, n'importe quelle catégorie et condition composée.

Ensuite, Cui Kejun a partagé son expérience dans l'utilisation de technologies telles que Drupal, Apache Solr, PubSubHubbub et OpenSearch.

Ensuite, Ye Shunping, l'architecte et chef d'équipe du département de recherche de Yisou Technology, a donné un partage intitulé "Web Search Crawler Timeliness System", comprenant les principaux objectifs, l'architecture et divers sous-modules de le système de conception des délais.

Ye Shunping, architecte et chef de l'équipe d'exploration du département de recherche de Yisou Technology

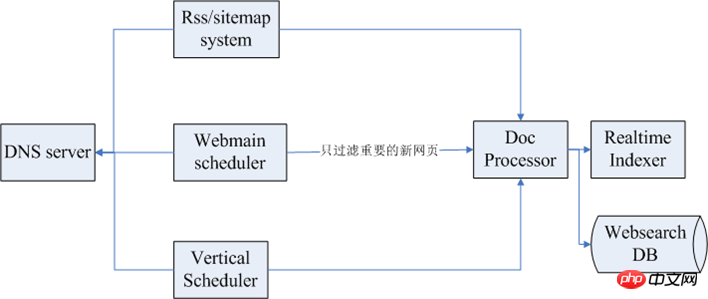

Les différents objectifs des robots d'exploration Web sont une couverture élevée et un faible taux de liens morts Comme pour une bonne efficacité, l'objectif du système d'efficacité des robots d'exploration est similaire, principalement pour parvenir à une inclusion rapide et complète de nouvelles pages Web. La figure suivante montre l'architecture globale du système d'actualité :

Parmi eux, le premier ci-dessus est le sous-système RSS/sitemap, et le suivant est le planificateur Webmain, le système de planification pour l'exploration des pages Web, puis un module de rapidité Vertical Scheduler. L'extrême gauche est le service DNS. Lors de l'exploration, il y a généralement des dizaines, voire des centaines de clusters d'exploration. Si chacun est protégé, la pression sur le DNS sera. être relativement élevé, il existe donc généralement un module de service DNS pour fournir des services globaux. Une fois les données capturées, un traitement ultérieur des données est généralement effectué.

Les modules liés à l'efficacité sont les suivants :

Système RSS/plan du site : le processus d'utilisation du RSS/plan du site par le système de rapidité consiste à extraire des graines, à les explorer régulièrement et à analyser le temps de publication du lien. . Explorez et indexez d'abord les pages Web les plus récentes.

Système d'exploration panoramique : si le système d'exploration panoramique est bien conçu, il contribuera à améliorer la couverture élevée des pages Web sensibles au temps, mais l'exploration panoramique doit raccourcir le cycle de planification autant que possible.

Système de planification des semences : il s'agit principalement d'une bibliothèque de semences urgente. Cette bibliothèque de semences contient certaines informations. Le système de planification analysera en permanence la base de données, puis l'enverra au cluster d'analyse. extraira certains liens, puis les enverra par catégorie, et chaque canal vertical obtiendra des données en temps opportun.

Exploration de graines : implique l'analyse de pages ou d'autres méthodes d'extraction, qui peuvent être construites via des plans de site et des barres de navigation, et en fonction des caractéristiques structurelles de la page et des règles de changement de page.

Mécanisme de mise à jour des graines : enregistrez l'historique d'exploration de chaque graine, suivez les informations du lien, mettez régulièrement à jour le cycle de mise à jour de la graine en fonction des caractéristiques du lien externe de la graine et recalculez le cycle de mise à jour de la graine.

Système d'exploration et analyse JavaScript : utilisez le navigateur pour explorer et créer un cluster d'exploration basé sur l'exploration du navigateur. Ou adoptez un projet open source tel que Qtwebkit.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Compétences de traitement de structures de données volumineuses de PHP

May 08, 2024 am 10:24 AM

Compétences de traitement de structures de données volumineuses de PHP

May 08, 2024 am 10:24 AM

Compétences en matière de traitement de la structure des Big Data : Chunking : décomposez l'ensemble de données et traitez-le en morceaux pour réduire la consommation de mémoire. Générateur : générez des éléments de données un par un sans charger l'intégralité de l'ensemble de données, adapté à des ensembles de données illimités. Streaming : lisez des fichiers ou interrogez les résultats ligne par ligne, adapté aux fichiers volumineux ou aux données distantes. Stockage externe : pour les ensembles de données très volumineux, stockez les données dans une base de données ou NoSQL.

Cinq tendances majeures de développement dans l'industrie AEC/O en 2024

Apr 19, 2024 pm 02:50 PM

Cinq tendances majeures de développement dans l'industrie AEC/O en 2024

Apr 19, 2024 pm 02:50 PM

AEC/O (Architecture, Engineering & Construction/Operation) fait référence aux services complets qui assurent la conception architecturale, la conception technique, la construction et l’exploitation dans le secteur de la construction. En 2024, l’industrie de l’AEC/O est confrontée à des défis changeants au milieu des progrès technologiques. Cette année devrait voir l’intégration de technologies avancées, annonçant un changement de paradigme dans la conception, la construction et l’exploitation. En réponse à ces changements, les industries redéfinissent les processus de travail, ajustent les priorités et renforcent la collaboration pour s'adapter aux besoins d'un monde en évolution rapide. Les cinq tendances majeures suivantes dans l'industrie AEC/O deviendront des thèmes clés en 2024, lui recommandant d'évoluer vers un avenir plus intégré, réactif et durable : chaîne d'approvisionnement intégrée, fabrication intelligente.

Application d'algorithmes dans la construction de 58 plateformes de portraits

May 09, 2024 am 09:01 AM

Application d'algorithmes dans la construction de 58 plateformes de portraits

May 09, 2024 am 09:01 AM

1. Contexte de la construction de la plateforme 58 Portraits Tout d'abord, je voudrais partager avec vous le contexte de la construction de la plateforme 58 Portraits. 1. La pensée traditionnelle de la plate-forme de profilage traditionnelle ne suffit plus. La création d'une plate-forme de profilage des utilisateurs s'appuie sur des capacités de modélisation d'entrepôt de données pour intégrer les données de plusieurs secteurs d'activité afin de créer des portraits d'utilisateurs précis. Elle nécessite également l'exploration de données pour comprendre le comportement et les intérêts des utilisateurs. et besoins, et fournir des capacités côté algorithmes ; enfin, il doit également disposer de capacités de plate-forme de données pour stocker, interroger et partager efficacement les données de profil utilisateur et fournir des services de profil. La principale différence entre une plate-forme de profilage d'entreprise auto-construite et une plate-forme de profilage de middle-office est que la plate-forme de profilage auto-construite dessert un seul secteur d'activité et peut être personnalisée à la demande. La plate-forme de mid-office dessert plusieurs secteurs d'activité et est complexe ; modélisation et offre des fonctionnalités plus générales. 2.58 Portraits d'utilisateurs de l'arrière-plan de la construction du portrait sur la plate-forme médiane 58

Discussion sur les raisons et les solutions au manque de framework Big Data en langage Go

Mar 29, 2024 pm 12:24 PM

Discussion sur les raisons et les solutions au manque de framework Big Data en langage Go

Mar 29, 2024 pm 12:24 PM

À l’ère actuelle du Big Data, le traitement et l’analyse des données sont devenus un support important pour le développement de diverses industries. En tant que langage de programmation doté d'une efficacité de développement élevée et de performances supérieures, le langage Go a progressivement attiré l'attention dans le domaine du big data. Cependant, par rapport à d'autres langages tels que Java, Python, etc., le langage Go prend en charge relativement mal les frameworks Big Data, ce qui a causé des problèmes à certains développeurs. Cet article explorera les principales raisons du manque de framework Big Data dans le langage Go, proposera des solutions correspondantes et l'illustrera avec des exemples de code spécifiques. 1. Allez dans la langue

Premiers pas : utiliser le langage Go pour traiter le Big Data

Feb 25, 2024 pm 09:51 PM

Premiers pas : utiliser le langage Go pour traiter le Big Data

Feb 25, 2024 pm 09:51 PM

En tant que langage de programmation open source, le langage Go a progressivement reçu une attention et une utilisation généralisées ces dernières années. Il est privilégié par les programmeurs pour sa simplicité, son efficacité et ses puissantes capacités de traitement simultané. Dans le domaine du traitement du Big Data, le langage Go a également un fort potentiel. Il peut être utilisé pour traiter des données massives, optimiser les performances et peut être bien intégré à divers outils et frameworks de traitement du Big Data. Dans cet article, nous présenterons quelques concepts et techniques de base du traitement du Big Data en langage Go, et montrerons comment utiliser le langage Go à travers des exemples de code spécifiques.

Traitement du Big Data en technologie C++ : Comment utiliser les bases de données en mémoire pour optimiser les performances du Big Data ?

May 31, 2024 pm 07:34 PM

Traitement du Big Data en technologie C++ : Comment utiliser les bases de données en mémoire pour optimiser les performances du Big Data ?

May 31, 2024 pm 07:34 PM

Dans le traitement du Big Data, l'utilisation d'une base de données en mémoire (telle qu'Aerospike) peut améliorer les performances des applications C++ car elle stocke les données dans la mémoire de l'ordinateur, éliminant ainsi les goulots d'étranglement d'E/S disque et augmentant considérablement les vitesses d'accès aux données. Des cas pratiques montrent que la vitesse de requête lors de l'utilisation d'une base de données en mémoire est plusieurs fois plus rapide que lors de l'utilisation d'une base de données sur disque dur.

Golang et big data : une adéquation parfaite ou en contradiction ?

Mar 05, 2024 pm 01:57 PM

Golang et big data : une adéquation parfaite ou en contradiction ?

Mar 05, 2024 pm 01:57 PM

Golang et big data : une adéquation parfaite ou en contradiction ? Avec le développement rapide de la technologie du Big Data, de plus en plus d’entreprises commencent à optimiser leurs activités et leur prise de décision grâce à l’analyse des données. Pour le traitement du Big Data, des langages de programmation efficaces sont cruciaux. Parmi les nombreux langages de programmation, Golang (langage Go) est devenu l'un des choix populaires pour le traitement du Big Data en raison de sa concurrence, de son efficacité, de sa simplicité et d'autres caractéristiques. Alors, Golang et big data sont-ils parfaitement compatibles ou contradictoires ? Cet article partira de l'application de Golang dans le traitement du Big Data,

Deep mining : utiliser le langage Go pour créer des robots d'exploration efficaces

Jan 30, 2024 am 09:17 AM

Deep mining : utiliser le langage Go pour créer des robots d'exploration efficaces

Jan 30, 2024 am 09:17 AM

Exploration approfondie : Utilisation du langage Go pour un développement efficace de robots Introduction : Avec le développement rapide d'Internet, obtenir des informations est devenu de plus en plus pratique. En tant qu'outil permettant d'obtenir automatiquement des données de sites Web, les robots d'exploration ont attiré une attention et une attention croissantes. Parmi les nombreux langages de programmation, le langage Go est devenu le langage de développement de robots préféré de nombreux développeurs en raison de ses avantages tels qu'une concurrence élevée et des performances puissantes. Cet article explorera l'utilisation du langage Go pour un développement efficace de robots et fournira des exemples de code spécifiques. 1. Avantages du développement de robots d'exploration du langage Go : Concurrence élevée : langage Go