développement back-end

développement back-end

Tutoriel Python

Tutoriel Python

Convertir les données capturées par le robot d'exploration Python en PDF

Convertir les données capturées par le robot d'exploration Python en PDF

Convertir les données capturées par le robot d'exploration Python en PDF

Cet article partage avec vous la méthode et le code d'utilisation du robot d'exploration Python pour convertir le "Tutoriel Python de Liao Xuefeng" en PDF. Les amis dans le besoin peuvent s'y référer

Écrire un robot ne semble pas être plus facile que de l'utiliser. Python. C'est approprié. Il y a tellement d'outils de robot d'exploration fournis par la communauté Python que vous serez ébloui. Avec diverses bibliothèques qui peuvent être utilisées directement, vous pouvez écrire un robot d'exploration en quelques minutes. Tutoriel Python de Liao Xuefeng. Créez un livre électronique PDF que tout le monde pourra lire hors ligne.

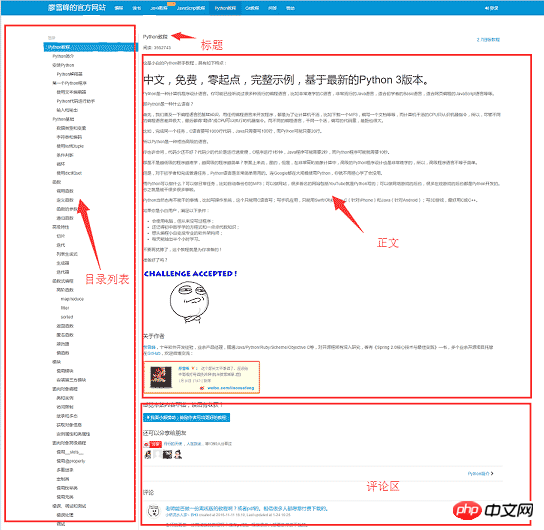

Avant de commencer à écrire un robot, analysons d'abord la structure des pages du site Web 1. Le côté gauche de la page Web est le plan du répertoire du tutoriel, chaque URL correspond à un article à droite, et le le côté supérieur droit est le titre de l'article, au milieu se trouve la partie texte de l'article, le contenu du texte est au centre de nos préoccupations, les données que nous voulons explorer sont la partie texte de toutes les pages Web, en dessous se trouve le commentaire de l'utilisateur zone, la zone de commentaires ne nous est d'aucune utilité, nous pouvons donc l'ignorer.

Préparation des outils

Après avoir déterminé la structure de base du site Web, vous pouvez commencer à préparer les kits d'outils dont dépend le robot sur. request et beautifulsoup sont deux artefacts majeurs des robots d'exploration, reuqests est utilisé pour les requêtes réseau et beautifusoup est utilisé pour exploiter les données html. Avec ces deux navettes, nous pouvons faire notre travail rapidement. Nous n'avons pas besoin d'un crawlerframework comme Scrapy. L'utiliser dans de petits programmes est comme une exagération. De plus, puisque vous convertissez des fichiers HTML en PDF, vous devez également disposer du support de bibliothèque correspondant. wkhtmltopdf est un très bon outil, qui peut être utilisé pour convertir du HTML en PDF sur plusieurs plates-formes. le package Python de wkhtmltopdf. installezles packages de dépendances suivants,

puis installez wkhtmltopdf

pip install requests pip install beautifulsoup pip install pdfkit

installez wkhtmltopdf

plate-forme Windows directement Téléchargez le version stable de wkhtmltopdf à partir du site officiel 2 et installez-le. Une fois l'installation terminée, ajoutez le chemin d'exécution du programme à l'environnement système $PATH variable , sinon pdfkit ne peut pas trouver wkhtmltopdf et l'erreur "Non". "Exécutable wkhtmltopdf trouvé" apparaîtra. Ubuntu et CentOS peuvent être installés directement à l'aide de la ligne de commande

$ sudo apt-get install wkhtmltopdf # ubuntu $ sudo yum intsall wkhtmltopdf # centos

Implémentation du Crawler

Lorsque tout est prêt, vous pouvez commencer à coder, mais vous devez d'abord l'organiser avant d'écrire le code Réfléchissez un instant. Le but du programme est de sauvegarder localement les parties de texte html correspondant à toutes les URL, puis d'utiliser pdfkit pour convertir ces fichiers en fichier pdf. Divisons la tâche. Tout d'abord, enregistrons localement le texte html correspondant à une certaine URL, puis recherchons toutes les URL et effectuons la même opération.

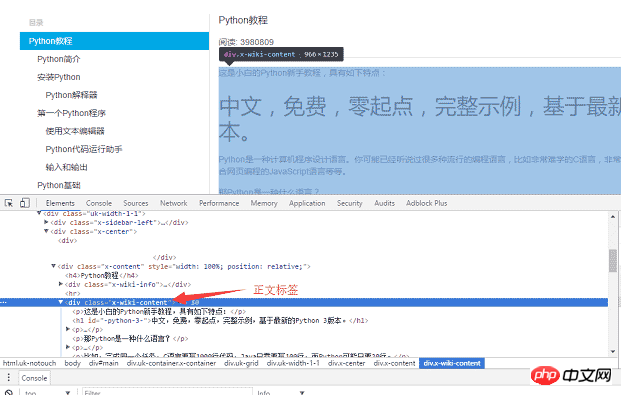

Utilisez le navigateur Chrome pour rechercher la balise dans la partie corps de la page, et appuyez sur F12 pour trouver la balise p correspondant au corps : <p >, où p est le contenu du corps de la page Web. Après avoir utilisé des requêtes pour charger la page entière localement, vous pouvez utiliser beautifulsoup pour faire fonctionner l'élément HTML dom afin d'extraire le contenu du texte.

Le code d'implémentation spécifique est le suivant : utilisez la fonction soup.find_all pour trouver la balise body, puis enregistrez le contenu de la partie du corps dans le fichier a Fichier .html.

def parse_url_to_html(url):

response = requests.get(url)

soup = BeautifulSoup(response.content, "html5lib")

body = soup.find_all(class_="x-wiki-content")[0]

html = str(body)

with open("a.html", 'wb') as f:

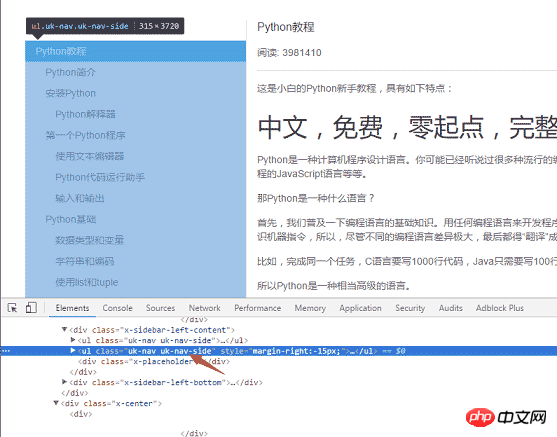

f.write(html)La deuxième étape consiste à analyser toutes les URL sur le côté gauche de la page. Utilisez la même méthode pour trouver l'étiquette du menu de gauche <ul >

La logique spécifique d'implémentation du code : car il y a deux classes uk-nav et uk-nav-side sur le page Attributs, et la véritable liste du répertoire est la deuxième. Toutes les URL ont été obtenues et la fonction de conversion des URL en HTML a été écrite dans un premier temps.

def get_url_list():

"""

获取所有URL目录列表

"""

response = requests.get("http://www.liaoxuefeng.com/wiki/0014316089557264a6b348958f449949df42a6d3a2e542c000")

soup = BeautifulSoup(response.content, "html5lib")

menu_tag = soup.find_all(class_="uk-nav uk-nav-side")[1]

urls = []

for li in menu_tag.find_all("li"):

url = "http://www.liaoxuefeng.com" + li.a.get('href')

urls.append(url)

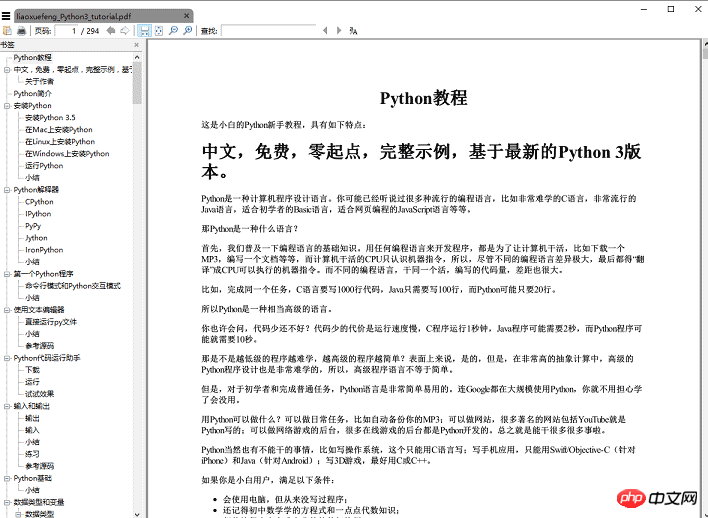

return urlsLa dernière étape consiste à convertir le code HTML en fichier pdf. La conversion en fichier pdf est très simple, car pdfkit a encapsulé toute la logique. Il vous suffit d'appeler la fonction pdfkit.from_file

def save_pdf(htmls):

"""

把所有html文件转换成pdf文件

"""

options = {

'page-size': 'Letter',

'encoding': "UTF-8",

'custom-header': [

('Accept-Encoding', 'gzip')

]

}

pdfkit.from_file(htmls, file_name, options=options)pour exécuter la fonction save_pdf, et le fichier pdf du livre électronique le sera. être généré. Le rendu :

Résumé

Le montant total du code s'élève à moins de 50 lignes, mais attendez, dans en fait, le code donné ci-dessus est omis. Certains détails, comme comment obtenir le titre de l'article, la balise img du contenu du texte utilise un chemin relatif Si vous souhaitez afficher la image normalement dans le. PDF, vous devez changer le chemin relatif en chemin absolu et l'enregistrer. Les fichiers html temporaires téléchargés doivent être supprimés, et ces détails sont tous publiés sur github.

【Recommandations associées】

1. Tutoriel vidéo gratuit Python

2 Tutoriel vidéo orienté objet Python

3 Manuel d'apprentissage Python<.>

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

MySQL doit-il payer

Apr 08, 2025 pm 05:36 PM

MySQL doit-il payer

Apr 08, 2025 pm 05:36 PM

MySQL a une version communautaire gratuite et une version d'entreprise payante. La version communautaire peut être utilisée et modifiée gratuitement, mais le support est limité et convient aux applications avec des exigences de stabilité faibles et des capacités techniques solides. L'Enterprise Edition fournit une prise en charge commerciale complète pour les applications qui nécessitent une base de données stable, fiable et haute performance et disposées à payer pour le soutien. Les facteurs pris en compte lors du choix d'une version comprennent la criticité des applications, la budgétisation et les compétences techniques. Il n'y a pas d'option parfaite, seulement l'option la plus appropriée, et vous devez choisir soigneusement en fonction de la situation spécifique.

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

MySQL a-t-il besoin d'Internet

Apr 08, 2025 pm 02:18 PM

MySQL a-t-il besoin d'Internet

Apr 08, 2025 pm 02:18 PM

MySQL peut s'exécuter sans connexions réseau pour le stockage et la gestion des données de base. Cependant, la connexion réseau est requise pour l'interaction avec d'autres systèmes, l'accès à distance ou l'utilisation de fonctionnalités avancées telles que la réplication et le clustering. De plus, les mesures de sécurité (telles que les pare-feu), l'optimisation des performances (choisissez la bonne connexion réseau) et la sauvegarde des données sont essentielles pour se connecter à Internet.

Comment optimiser les performances MySQL pour les applications de haute charge?

Apr 08, 2025 pm 06:03 PM

Comment optimiser les performances MySQL pour les applications de haute charge?

Apr 08, 2025 pm 06:03 PM

Guide d'optimisation des performances de la base de données MySQL dans les applications à forte intensité de ressources, la base de données MySQL joue un rôle crucial et est responsable de la gestion des transactions massives. Cependant, à mesure que l'échelle de l'application se développe, les goulots d'étranglement des performances de la base de données deviennent souvent une contrainte. Cet article explorera une série de stratégies efficaces d'optimisation des performances MySQL pour garantir que votre application reste efficace et réactive dans des charges élevées. Nous combinerons des cas réels pour expliquer les technologies clés approfondies telles que l'indexation, l'optimisation des requêtes, la conception de la base de données et la mise en cache. 1. La conception de l'architecture de la base de données et l'architecture optimisée de la base de données sont la pierre angulaire de l'optimisation des performances MySQL. Voici quelques principes de base: sélectionner le bon type de données et sélectionner le plus petit type de données qui répond aux besoins peut non seulement économiser un espace de stockage, mais également améliorer la vitesse de traitement des données.

HaDIDB: une base de données légère et évolutive horizontalement dans Python

Apr 08, 2025 pm 06:12 PM

HaDIDB: une base de données légère et évolutive horizontalement dans Python

Apr 08, 2025 pm 06:12 PM

HaDIDB: Une base de données Python évolutive de haut niveau légère HaDIDB (HaDIDB) est une base de données légère écrite en Python, avec un niveau élevé d'évolutivité. Installez HaDIDB à l'aide de l'installation PIP: PiPinStallHaDIDB User Management Créer un utilisateur: CreateUser () pour créer un nouvel utilisateur. La méthode Authentication () authentifie l'identité de l'utilisateur. FromHadidb.OperationMportUserUser_OBJ = User ("Admin", "Admin") User_OBJ.

Méthode de Navicat pour afficher le mot de passe de la base de données MongoDB

Apr 08, 2025 pm 09:39 PM

Méthode de Navicat pour afficher le mot de passe de la base de données MongoDB

Apr 08, 2025 pm 09:39 PM

Il est impossible de visualiser le mot de passe MongoDB directement via NAVICAT car il est stocké sous forme de valeurs de hachage. Comment récupérer les mots de passe perdus: 1. Réinitialiser les mots de passe; 2. Vérifiez les fichiers de configuration (peut contenir des valeurs de hachage); 3. Vérifiez les codes (May Code Hardcode).

MySQL Workbench peut-il se connecter à MariaDB

Apr 08, 2025 pm 02:33 PM

MySQL Workbench peut-il se connecter à MariaDB

Apr 08, 2025 pm 02:33 PM

MySQL Workbench peut se connecter à MARIADB, à condition que la configuration soit correcte. Sélectionnez d'abord "MariADB" comme type de connecteur. Dans la configuration de la connexion, définissez correctement l'hôte, le port, l'utilisateur, le mot de passe et la base de données. Lorsque vous testez la connexion, vérifiez que le service MARIADB est démarré, si le nom d'utilisateur et le mot de passe sont corrects, si le numéro de port est correct, si le pare-feu autorise les connexions et si la base de données existe. Dans une utilisation avancée, utilisez la technologie de mise en commun des connexions pour optimiser les performances. Les erreurs courantes incluent des autorisations insuffisantes, des problèmes de connexion réseau, etc. Lors des erreurs de débogage, analysez soigneusement les informations d'erreur et utilisez des outils de débogage. L'optimisation de la configuration du réseau peut améliorer les performances

MySQL a-t-il besoin d'un serveur

Apr 08, 2025 pm 02:12 PM

MySQL a-t-il besoin d'un serveur

Apr 08, 2025 pm 02:12 PM

Pour les environnements de production, un serveur est généralement nécessaire pour exécuter MySQL, pour des raisons, notamment les performances, la fiabilité, la sécurité et l'évolutivité. Les serveurs ont généralement un matériel plus puissant, des configurations redondantes et des mesures de sécurité plus strictes. Pour les petites applications à faible charge, MySQL peut être exécutée sur des machines locales, mais la consommation de ressources, les risques de sécurité et les coûts de maintenance doivent être soigneusement pris en considération. Pour une plus grande fiabilité et sécurité, MySQL doit être déployé sur le cloud ou d'autres serveurs. Le choix de la configuration du serveur approprié nécessite une évaluation en fonction de la charge d'application et du volume de données.