Exemple de données audio du robot Python

1 : Avant-propos

Cette fois, nous avons exploré les informations de chaque chaîne de toutes les stations de radio sous la colonne populaire de l'Himalaya et diverses informations de chaque donnée audio de la chaîne, puis avons mis les données analysées Enregistrer dans mongodb pour une utilisation ultérieure. Cette fois, la quantité de données est d'environ 700 000. Les données audio incluent l'adresse de téléchargement audio, les informations sur la chaîne, l'introduction, etc., il y en a beaucoup.

J'ai eu mon premier entretien hier. L'autre partie était une entreprise de big data d'intelligence artificielle. J'allais faire un stage pendant les vacances d'été de ma deuxième année. Ils m'ont demandé d'explorer des données audio, alors je suis venu. analyser l'Himalaya. Les données audio descendent. Actuellement, j'attends toujours trois interviews, ou d'être informé de la nouvelle finale de l'interview. (Parce que je peux obtenir une certaine reconnaissance, je suis très heureux quel que soit le succès ou l'échec)

2 : Environnement d'exécution

-

IDE : Pycharm 2017

Python3.6

pymongo 3.4.0

requêtes 2.14.2

-

lxml 3.7.2

BeautifulSoup 4.5.3

Trois : exemple d'analyse

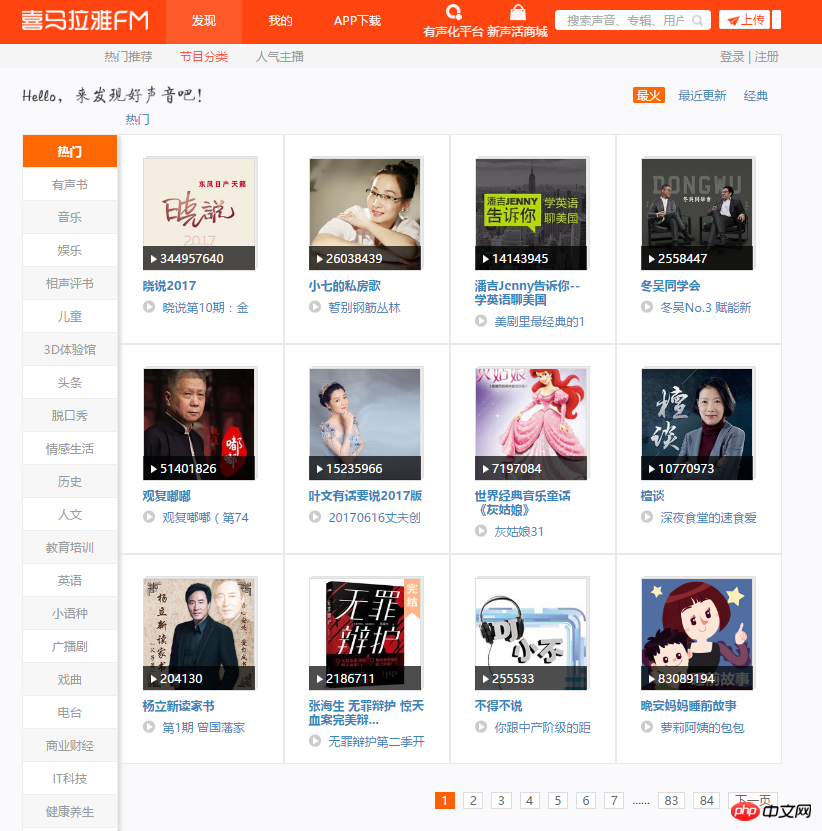

1. Entrez d'abord dans la page principale de cette exploration. Vous pouvez voir 12 chaînes sur chaque page. Il y a beaucoup d'audios sous chaque chaîne, et il y a de nombreuses paginations dans certaines chaînes. Plan d'exploration : parcourez 84 pages, analysez chaque page, récupérez le nom de chaque chaîne, le lien de l'image et enregistrez le lien de la chaîne sur mongodb.

2. Ouvrez le mode développeur, analysez la page et obtenez rapidement l'emplacement des données souhaitées. Le code suivant permet de récupérer les informations de toutes les chaînes populaires et de les enregistrer sur mongodb.

start_urls = ['http://www.ximalaya.com/dq/all/{}'.format(num) for num in range(1, 85)]for start_url in start_urls:html = requests.get(start_url, headers=headers1).text

soup = BeautifulSoup(html, 'lxml')for item in soup.find_all(class_="albumfaceOutter"):content = {'href': item.a['href'],'title': item.img['alt'],'img_url': item.img['src']

}

print(content)

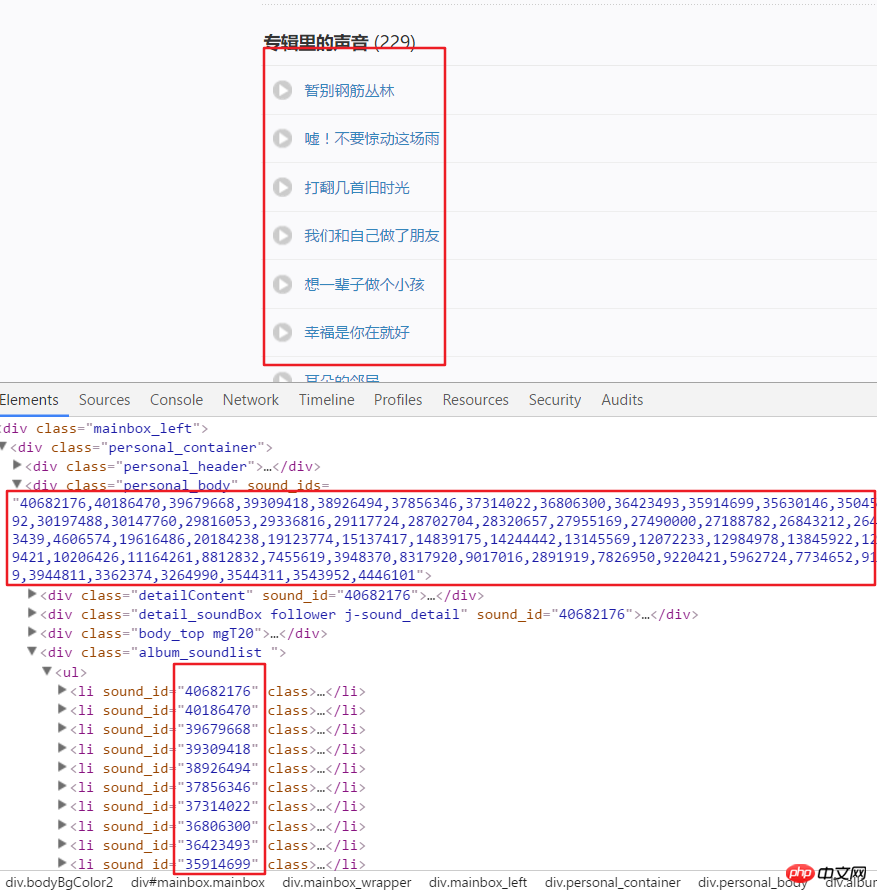

3 Ce qui suit est de commencer à obtenir toutes les données audio de chaque canal, qui ont été obtenues via. la page d'analyse Voici le lien vers la chaîne US. Par exemple, nous analysons la structure de la page après avoir entré ce lien. On peut voir que chaque audio a un identifiant spécifique, qui peut être obtenu à partir des attributs d'un div. Utilisez split() et int() pour convertir en identifiants individuels.

4. Cliquez ensuite sur un lien audio, entrez en mode développeur, actualisez la page et cliquez sur XHR, puis cliquez sur un json. Le lien pour voir cela inclut tous les détails de cet audio.

html = requests.get(url, headers=headers2).text

numlist = etree.HTML(html).xpath('//div[@class="personal_body"]/@sound_ids')[0].split(',')for i in numlist:

murl = 'http://www.ximalaya.com/tracks/{}.json'.format(i)html = requests.get(murl, headers=headers1).text

dic = json.loads(html)

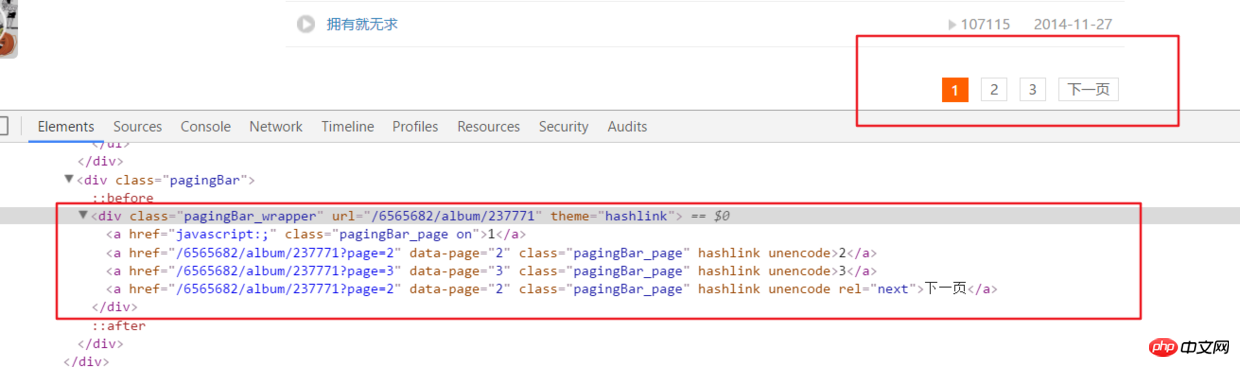

5 Ce qui précède analyse uniquement toutes les informations audio sur la page principale d'une chaîne. , mais en réalité Le lien audio sur la chaîne a de nombreuses paginations.

html = requests.get(url, headers=headers2).text

ifanother = etree.HTML(html).xpath('//div[@class="pagingBar_wrapper"]/a[last()-1]/@data-page')if len(ifanother):num = ifanother[0]

print('本频道资源存在' + num + '个页面')for n in range(1, int(num)):

print('开始解析{}个中的第{}个页面'.format(num, n))

url2 = url + '?page={}'.format(n)# 之后就接解析音频页函数就行,后面有完整代码说明

6. Tout le code

Adresse complète du code github.com/rieuse/learnPython

__author__ = '布咯咯_rieuse'import jsonimport randomimport timeimport pymongoimport requestsfrom bs4 import BeautifulSoupfrom lxml import etree

clients = pymongo.MongoClient('localhost')

db = clients["XiMaLaYa"]

col1 = db["album"]

col2 = db["detaile"]

UA_LIST = [] # 很多User-Agent用来随机使用可以防ban,显示不方便不贴出来了

headers1 = {} # 访问网页的headers,这里显示不方便我就不贴出来了

headers2 = {} # 访问网页的headers这里显示不方便我就不贴出来了def get_url():

start_urls = ['http://www.ximalaya.com/dq/all/{}'.format(num) for num in range(1, 85)]for start_url in start_urls:

html = requests.get(start_url, headers=headers1).text

soup = BeautifulSoup(html, 'lxml')for item in soup.find_all(class_="albumfaceOutter"):

content = {'href': item.a['href'],'title': item.img['alt'],'img_url': item.img['src']

}

col1.insert(content)

print('写入一个频道' + item.a['href'])

print(content)

another(item.a['href'])

time.sleep(1)def another(url):

html = requests.get(url, headers=headers2).text

ifanother = etree.HTML(html).xpath('//div[@class="pagingBar_wrapper"]/a[last()-1]/@data-page')if len(ifanother):

num = ifanother[0]

print('本频道资源存在' + num + '个页面')for n in range(1, int(num)):

print('开始解析{}个中的第{}个页面'.format(num, n))

url2 = url + '?page={}'.format(n)

get_m4a(url2)

get_m4a(url)def get_m4a(url):

time.sleep(1)

html = requests.get(url, headers=headers2).text

numlist = etree.HTML(html).xpath('//div[@class="personal_body"]/@sound_ids')[0].split(',')for i in numlist:

murl = 'http://www.ximalaya.com/tracks/{}.json'.format(i)

html = requests.get(murl, headers=headers1).text

dic = json.loads(html)

col2.insert(dic)

print(murl + '中的数据已被成功插入mongodb')if __name__ == '__main__':

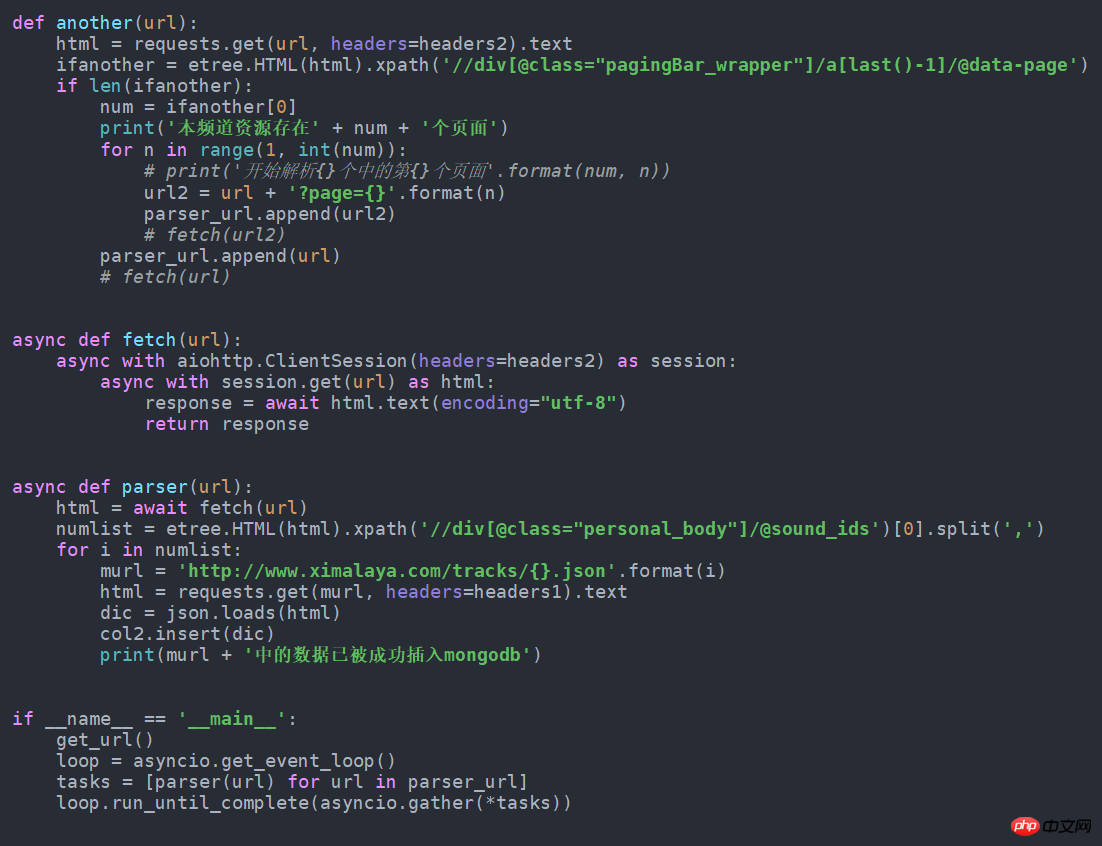

get_url()7. S'il est modifié en forme asynchrone, ce sera plus rapide. Changez-le simplement comme suit. J'ai essayé d'obtenir près de 100 données de plus par minute que la normale. Ce code source est également dans github.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

PHP et Python: différents paradigmes expliqués

Apr 18, 2025 am 12:26 AM

PHP et Python: différents paradigmes expliqués

Apr 18, 2025 am 12:26 AM

PHP est principalement la programmation procédurale, mais prend également en charge la programmation orientée objet (POO); Python prend en charge une variété de paradigmes, y compris la POO, la programmation fonctionnelle et procédurale. PHP convient au développement Web, et Python convient à une variété d'applications telles que l'analyse des données et l'apprentissage automatique.

Choisir entre PHP et Python: un guide

Apr 18, 2025 am 12:24 AM

Choisir entre PHP et Python: un guide

Apr 18, 2025 am 12:24 AM

PHP convient au développement Web et au prototypage rapide, et Python convient à la science des données et à l'apprentissage automatique. 1.Php est utilisé pour le développement Web dynamique, avec une syntaxe simple et adapté pour un développement rapide. 2. Python a une syntaxe concise, convient à plusieurs champs et a un écosystème de bibliothèque solide.

Peut-on exécuter le code sous Windows 8

Apr 15, 2025 pm 07:24 PM

Peut-on exécuter le code sous Windows 8

Apr 15, 2025 pm 07:24 PM

VS Code peut fonctionner sur Windows 8, mais l'expérience peut ne pas être excellente. Assurez-vous d'abord que le système a été mis à jour sur le dernier correctif, puis téléchargez le package d'installation VS Code qui correspond à l'architecture du système et l'installez comme invité. Après l'installation, sachez que certaines extensions peuvent être incompatibles avec Windows 8 et doivent rechercher des extensions alternatives ou utiliser de nouveaux systèmes Windows dans une machine virtuelle. Installez les extensions nécessaires pour vérifier si elles fonctionnent correctement. Bien que le code VS soit possible sur Windows 8, il est recommandé de passer à un système Windows plus récent pour une meilleure expérience de développement et une meilleure sécurité.

L'extension VScode est-elle malveillante?

Apr 15, 2025 pm 07:57 PM

L'extension VScode est-elle malveillante?

Apr 15, 2025 pm 07:57 PM

Les extensions de code vs posent des risques malveillants, tels que la cachette de code malveillant, l'exploitation des vulnérabilités et la masturbation comme des extensions légitimes. Les méthodes pour identifier les extensions malveillantes comprennent: la vérification des éditeurs, la lecture des commentaires, la vérification du code et l'installation avec prudence. Les mesures de sécurité comprennent également: la sensibilisation à la sécurité, les bonnes habitudes, les mises à jour régulières et les logiciels antivirus.

Le code Visual Studio peut-il être utilisé dans Python

Apr 15, 2025 pm 08:18 PM

Le code Visual Studio peut-il être utilisé dans Python

Apr 15, 2025 pm 08:18 PM

VS Code peut être utilisé pour écrire Python et fournit de nombreuses fonctionnalités qui en font un outil idéal pour développer des applications Python. Il permet aux utilisateurs de: installer des extensions Python pour obtenir des fonctions telles que la réalisation du code, la mise en évidence de la syntaxe et le débogage. Utilisez le débogueur pour suivre le code étape par étape, trouver et corriger les erreurs. Intégrez Git pour le contrôle de version. Utilisez des outils de mise en forme de code pour maintenir la cohérence du code. Utilisez l'outil de liaison pour repérer les problèmes potentiels à l'avance.

Comment exécuter des programmes dans Terminal Vscode

Apr 15, 2025 pm 06:42 PM

Comment exécuter des programmes dans Terminal Vscode

Apr 15, 2025 pm 06:42 PM

Dans VS Code, vous pouvez exécuter le programme dans le terminal via les étapes suivantes: Préparez le code et ouvrez le terminal intégré pour vous assurer que le répertoire de code est cohérent avec le répertoire de travail du terminal. Sélectionnez la commande Run en fonction du langage de programmation (tel que Python de Python your_file_name.py) pour vérifier s'il s'exécute avec succès et résoudre les erreurs. Utilisez le débogueur pour améliorer l'efficacité du débogage.

Peut-on utiliser pour mac

Apr 15, 2025 pm 07:36 PM

Peut-on utiliser pour mac

Apr 15, 2025 pm 07:36 PM

VS Code est disponible sur Mac. Il a des extensions puissantes, l'intégration GIT, le terminal et le débogueur, et offre également une multitude d'options de configuration. Cependant, pour des projets particulièrement importants ou un développement hautement professionnel, le code vs peut avoir des performances ou des limitations fonctionnelles.

Python vs JavaScript: la courbe d'apprentissage et la facilité d'utilisation

Apr 16, 2025 am 12:12 AM

Python vs JavaScript: la courbe d'apprentissage et la facilité d'utilisation

Apr 16, 2025 am 12:12 AM

Python convient plus aux débutants, avec une courbe d'apprentissage en douceur et une syntaxe concise; JavaScript convient au développement frontal, avec une courbe d'apprentissage abrupte et une syntaxe flexible. 1. La syntaxe Python est intuitive et adaptée à la science des données et au développement back-end. 2. JavaScript est flexible et largement utilisé dans la programmation frontale et côté serveur.