Ressources recommandées pour les didacticiels vidéo Mahout

Mahout fournit des implémentations évolutives d'algorithmes classiques dans le domaine de l'apprentissage automatique, dans le but d'aider les développeurs à créer des applications intelligentes plus facilement et plus rapidement. Mahout contient de nombreuses implémentations, notamment le clustering, la classification, le filtrage des recommandations et l'exploration fréquente de sous-éléments. De plus, Mahout peut évoluer efficacement vers le cloud en utilisant la bibliothèque Apache Hadoop.

Le style d'enseignement de l'enseignant :

Les cours de l'enseignant sont simples et faciles à comprendre, de structure claire, analysés couche par couche , imbriqué et rigoureux dans l'argumentation , a une structure rigoureuse, utilise le pouvoir logique de la pensée pour attirer l'attention des élèves et utilise la raison pour contrôler le processus d'enseignement en classe. En écoutant les cours de l'enseignant, les étudiants acquièrent non seulement des connaissances, mais reçoivent également une formation à la réflexion, et sont également influencés et influencés par l'attitude académique rigoureuse de l'enseignant

Le point le plus difficile de cette vidéo est la logistique classificateur de régression_Bei Yessian Classifier_1 :

1 Contexte

Tout d'abord, au début de l'article, posons-en quelques-unes. questions , si vous pouvez répondre à ces questions, alors vous n'avez pas besoin de lire cet article, ou votre motivation pour lire est uniquement de trouver des défauts à cet article. Bien sûr, je l'accueille également. Veuillez envoyer un e-mail à "Naive Bayesian". des défauts" au 297314262 @qq.com, je lirai attentivement votre lettre.

D'ailleurs, si après avoir lu cet article, vous ne parvenez toujours pas à répondre aux questions suivantes, veuillez m'en informer par e-mail et je ferai de mon mieux pour répondre à vos doutes.

Le "naïf" dans le classificateur Naive Bayes fait spécifiquement référence aux caractéristiques de ce classificateur

Classificateur Naive Bayes et estimation du maximum de vraisemblance (MLE), maximum postérieur La relation entre la probabilité (MAP)

Classification naïve de Bayes, classification de régression logistique, modèle génératif et modèle de décision

La relation entre l'apprentissage supervisé et l'estimation bayésienne

2 Accord

Donc, ceci. l'article commence. Tout d'abord, concernant les différentes formes d'expression qui peuvent apparaître dans cet article, quelques conventions sont faites ici

Les lettres majuscules, comme X, représentent des variables aléatoires ; si X est une variable multidimensionnelle, alors l'indice ; i représente la i-ème variable de dimension, c'est-à-dire que Xi

les lettres minuscules, telles que Xij, représentent une valeur de la variable (la jème valeur de Xi)

3. apprentissage supervisé

D'accord, alors répondez d'abord à la 4ème question, comment utiliser l'estimation bayésienne pour résoudre des problèmes d'apprentissage supervisé ?

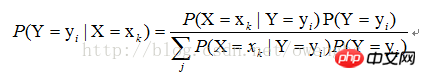

Pour l'apprentissage supervisé, notre objectif est en fait d'estimer une fonction objectif f : La variable, Y, est le résultat réel de la classification de l'échantillon. Supposons que la valeur de l'échantillon |X=xk), trouvez simplement toutes les estimations de P(X=xk|Y=yi) et toutes les estimations de P(Y=yi) basées sur l'échantillon. Le processus de classification ultérieur consiste à trouver le plus grand yi de P(Y=yi|X=xk). On peut voir que l’utilisation de l’estimation bayésienne peut résoudre le problème de l’apprentissage supervisé.

4. Caractéristiques « naïves » des classificateurs

Comme mentionné ci-dessus, la solution de P(X=xk|Y=yi) peut être transformée en solution de P(X1=x1j1|Y=yi), P(X2=x2j2|Y=yi),. .. P (Xn=xnjn|Y=yi), alors comment utiliser la méthode d'estimation du maximum de vraisemblance pour trouver ces valeurs ?

Tout d'abord, nous devons comprendre ce qu'est l'estimation du maximum de vraisemblance. En fait, dans nos manuels de théorie des probabilités, les explications sur l'estimation du maximum de vraisemblance concernent toutes la résolution de problèmes d'apprentissage non supervisés. vous devez comprendre que l'utilisation de l'estimation du maximum de vraisemblance pour résoudre des problèmes d'apprentissage supervisé sous des caractéristiques naïves revient en fait à utiliser l'estimation du maximum de vraisemblance pour résoudre des problèmes d'apprentissage non supervisé dans diverses catégories de conditions.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Recommandé Version 2022 du pilote de carte graphique NVIDIA série 40

Jan 02, 2024 pm 06:43 PM

Recommandé Version 2022 du pilote de carte graphique NVIDIA série 40

Jan 02, 2024 pm 06:43 PM

Version du pilote de la carte graphique NVIDIA 4060 recommandée Lors du choix d'une version du pilote de la carte graphique sur un ordinateur portable, il est généralement recommandé de choisir la version recommandée par le site officiel ou la dernière version. Pour la carte graphique Intel HD Graphics 4060, il est recommandé de choisir le dernier pilote publié sur le site officiel d'Intel pour la mise à jour et l'installation. Les étapes spécifiques sont les suivantes : "Words Play Flowers" est un jeu de puzzle de mots populaire avec de nouveaux niveaux lancés chaque jour. L'un des niveaux s'appelle Nostalgic Cleaning. Nous devons trouver 12 éléments dans l'image qui ne correspondent pas à l'époque. Aujourd'hui, je vais vous apporter un guide pour effacer le niveau de nettoyage nostalgique de "Word Play Flowers" pour aider les joueurs qui ne l'ont pas réussi à réussir le niveau. Jetons un coup d'œil aux étapes spécifiques ! Visitez Intel

Le premier choix des joueurs CS : configuration informatique recommandée

Jan 02, 2024 pm 04:26 PM

Le premier choix des joueurs CS : configuration informatique recommandée

Jan 02, 2024 pm 04:26 PM

1. Processeur Lors du choix d'une configuration informatique, le processeur est l'un des composants les plus importants. Pour jouer à des jeux comme CS, les performances du processeur affectent directement la fluidité et la vitesse de réponse du jeu. Il est recommandé de choisir les processeurs Intel Core i5 ou i7 car ils disposent de puissantes capacités de traitement multicœur et de hautes fréquences, et peuvent facilement répondre aux exigences élevées du CS. 2. Carte graphique La carte graphique est l'un des facteurs importants dans les performances du jeu. Pour les jeux de tir tels que CS, les performances de la carte graphique affectent directement la clarté et la fluidité de l'écran de jeu. Il est recommandé de choisir les cartes graphiques de la série NVIDIA GeForce GTX ou de la série AMD Radeon RX. Elles ont d'excellentes capacités de traitement graphique et une fréquence d'images élevée, et peuvent offrir une meilleure expérience de jeu. 3. Puissance de la mémoire.

Comment me recommander des amis sur Taobao

Feb 29, 2024 pm 07:07 PM

Comment me recommander des amis sur Taobao

Feb 29, 2024 pm 07:07 PM

Dans le processus d'utilisation de Taobao, nous serons souvent recommandés par certains amis que nous connaissons. Voici une introduction à la façon de désactiver cette fonction. Les amis intéressés devraient y jeter un œil. Après avoir ouvert l'application « Taobao » sur votre téléphone mobile, cliquez sur « Mon Taobao » dans le coin inférieur droit de la page pour accéder à la page du centre personnel, puis cliquez sur la fonction « Paramètres » dans le coin supérieur droit pour accéder à la page des paramètres. . 2. Après être arrivé sur la page des paramètres, recherchez « Confidentialité » et cliquez sur cet élément pour entrer. 3. Il y a un « Recommandez-moi des amis » sur la page de confidentialité. Lorsqu'il indique que le statut actuel est « activé », cliquez dessus pour le fermer. 4. Enfin, dans la fenêtre contextuelle, il y aura un bouton de commutation derrière « Me recommander des amis ». Cliquez dessus pour définir le bouton en gris.

Devenez un expert C : cinq compilateurs indispensables recommandés

Feb 19, 2024 pm 01:03 PM

Devenez un expert C : cinq compilateurs indispensables recommandés

Feb 19, 2024 pm 01:03 PM

Du débutant à l'expert : cinq recommandations essentielles du compilateur C Avec le développement de l'informatique, de plus en plus de personnes s'intéressent aux langages de programmation. En tant que langage de haut niveau largement utilisé dans la programmation au niveau système, le langage C a toujours été apprécié des programmeurs. Afin d’écrire du code efficace et stable, il est important de choisir un compilateur en langage C qui vous convient. Cet article présentera cinq compilateurs essentiels du langage C parmi lesquels choisir pour les débutants et les experts. GCCGCC, la collection de compilateurs GNU, est l'un des compilateurs de langage C les plus couramment utilisés.

Recommandation du cône de lumière de Huangquan

Mar 27, 2024 pm 05:31 PM

Recommandation du cône de lumière de Huangquan

Mar 27, 2024 pm 05:31 PM

Le cône lumineux de Huang Quan peut augmenter efficacement les dégâts critiques et la puissance d'attaque du personnage au combat. Les cônes lumineux recommandés par Huang Quan sont : Marcher sur le rivage qui passe, Bonne nuit et Visage endormi, La pluie continue de tomber, Attendez simplement et Détermination comme des perles. of Sweat Shine, ci-dessous, l'éditeur vous apportera des recommandations pour le cône de lumière souterrain du chemin de fer Collapsed Star Dome. Recommandation du cône lumineux de Huangquan 1. Marcher sur la rive qui passe 1. L'arme spéciale de Huangquan peut augmenter les dégâts explosifs. Attaquer l'ennemi peut mettre l'ennemi dans un état de bulle négatif, ce qui augmente les dégâts causés. Les dégâts du coup final sont en outre augmentés. . Il y a à la fois des états négatifs et Les dégâts sont augmentés, il faut dire que c'est une arme spéciale. 2. Le cône lumineux exclusif est tout à fait unique parmi de nombreux cônes lumineux éthérés. Il augmente directement les dégâts directs, provoque des dégâts élevés et améliore l'attribut de dégâts critiques. 3. De plus, le cône lumineux produit également un effet de statut négatif, ce qui peut faire réagir Huangquan lui-même.

Claviers recommandés pour réduire le bruit de frappe dans les jeux

Jan 05, 2024 am 10:36 AM

Claviers recommandés pour réduire le bruit de frappe dans les jeux

Jan 05, 2024 am 10:36 AM

Aller à Recommander un clavier de jeu silencieux Si vous souhaitez profiter d'une expérience silencieuse pendant que vous jouez, vous pouvez envisager d'acheter un clavier de jeu silencieux. Les produits recommandés incluent CherryMXSilent, LogitechG915 et SteelSeriesApexPro. Ces claviers sont silencieux, légers et réactifs. De plus, il est recommandé de choisir un clavier doté de fonctionnalités telles qu'une luminosité de rétroéclairage réglable, des fonctions programmables et une sensation de confort pour répondre à de meilleurs besoins d'utilisation. Reconnu comme le clavier le plus silencieux "Duga K320", c'est un produit électronique très apprécié. Il est connu pour ses excellentes performances et fonctionnalités, ce qui en fait un choix idéal pour de nombreuses personnes. Qu'il s'agisse de jeux, de divertissement ou de travail de bureau, le Duga K320 peut offrir d'excellentes performances. il

Recommandations de l'émulateur Java : ces cinq recommandations sont faciles à utiliser et pratiques !

Feb 22, 2024 pm 08:42 PM

Recommandations de l'émulateur Java : ces cinq recommandations sont faciles à utiliser et pratiques !

Feb 22, 2024 pm 08:42 PM

Un émulateur Java est un logiciel qui peut exécuter des applications Java sur un ordinateur ou un appareil. Il peut simuler la machine virtuelle Java et exécuter le bytecode Java, permettant aux utilisateurs d'exécuter des programmes Java sur différentes plates-formes. Les simulateurs Java sont largement utilisés dans le développement, l'apprentissage et les tests de logiciels. Cet article présentera cinq émulateurs Java utiles et pratiques qui peuvent répondre aux besoins de différents utilisateurs et aider les utilisateurs à développer et à exécuter des programmes Java plus efficacement. Le premier émulateur était Eclipse. Écl

Quel ordinateur les étudiants en sciences de l'information géographique devraient-ils choisir ?

Jan 13, 2024 am 08:00 AM

Quel ordinateur les étudiants en sciences de l'information géographique devraient-ils choisir ?

Jan 13, 2024 am 08:00 AM

Ordinateurs recommandés adaptés aux étudiants se spécialisant en sciences de l'information géographique 1. Recommandation 2. Les étudiants se spécialisant en sciences de l'information géographique doivent traiter de grandes quantités de données géographiques et effectuer des analyses complexes d'informations géographiques, ils ont donc besoin d'un ordinateur très performant. Un ordinateur avec une configuration élevée peut offrir une vitesse de traitement plus rapide et un espace de stockage plus grand, et peut mieux répondre aux besoins professionnels. 3. Il est recommandé de choisir un ordinateur équipé d'un processeur haute performance et d'une mémoire de grande capacité, ce qui peut améliorer l'efficacité du traitement et de l'analyse des données. De plus, choisir un ordinateur doté d’un plus grand espace de stockage et d’un écran haute résolution permet de mieux afficher les données et les résultats géographiques. De plus, étant donné que les étudiants se spécialisant en sciences de l'information géographique peuvent avoir besoin de développer et de programmer un logiciel de système d'information géographique (SIG), choisissez un ordinateur offrant une meilleure prise en charge du traitement graphique.