Comment utiliser l'économiseur de Tensorflow

Cet article présente principalement l'utilisation détaillée de Tensorflow's Saver. Maintenant, je le partage avec vous et le donne comme référence. Venez jeter un oeil

Utilisation de Saver

Introduction générale à Saver

Nous souhaitons souvent sauvegarder les résultats de la formation après la formation d'un modèle. Ces résultats font référence aux paramètres du modèle pour la formation ou le test lors de l'itération suivante. Tensorflow fournit la classe Saver pour cette exigence.2. Instance Saver

Ce qui suit est un exemple de la façon d'utiliser la classe Saverimport tensorflow as tf

import numpy as np

x = tf.placeholder(tf.float32, shape=[None, 1])

y = 4 * x + 4

w = tf.Variable(tf.random_normal([1], -1, 1))

b = tf.Variable(tf.zeros([1]))

y_predict = w * x + b

loss = tf.reduce_mean(tf.square(y - y_predict))

optimizer = tf.train.GradientDescentOptimizer(0.5)

train = optimizer.minimize(loss)

isTrain = False

train_steps = 100

checkpoint_steps = 50

checkpoint_dir = ''

saver = tf.train.Saver() # defaults to saving all variables - in this case w and b

x_data = np.reshape(np.random.rand(10).astype(np.float32), (10, 1))

with tf.Session() as sess:

sess.run(tf.initialize_all_variables())

if isTrain:

for i in xrange(train_steps):

sess.run(train, feed_dict={x: x_data})

if (i + 1) % checkpoint_steps == 0:

saver.save(sess, checkpoint_dir + 'model.ckpt', global_step=i+1)

else:

ckpt = tf.train.get_checkpoint_state(checkpoint_dir)

if ckpt and ckpt.model_checkpoint_path:

saver.restore(sess, ckpt.model_checkpoint_path)

else:

pass

print(sess.run(w))

print(sess.run(b))- isTrain : utilisé pour distinguer la phase d'entraînement et la phase de test, True représente l'entraînement, False représente les tests

- train_steps : représente l'entraînement Le nombre de fois, l'exemple utilise 100

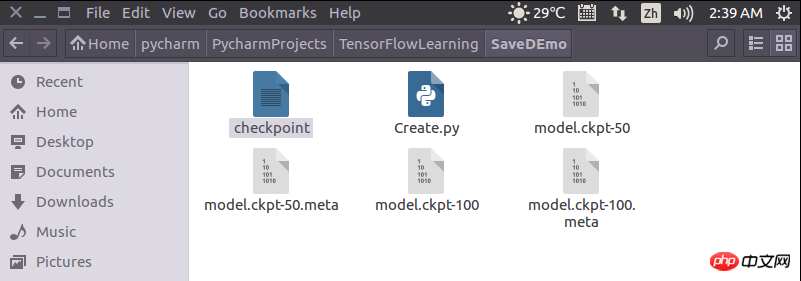

- checkpoint_steps : indique combien de fois enregistrer les points de contrôle pendant l'entraînement, l'exemple utilise 50

- checkpoint_dir : indique le fichier de points de contrôle Le chemin de sauvegarde, le chemin actuel est utilisé dans l'exemple

- sess : représente la session en cours, qui enregistre la valeur de la variable actuelle

- checkpoint_dir + 'model.ckpt' : représente le nom du fichier stocké

- global_step : indique l'étape en cours

Tensorflow utilise des indicateurs pour définir les paramètres de ligne de commande

Sauvegarde et restauration du modèle d'apprentissage Tensorflow1.0 (Saver)_python

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Analyser l'utilisation et la classification des commentaires JSP

Feb 01, 2024 am 08:01 AM

Analyser l'utilisation et la classification des commentaires JSP

Feb 01, 2024 am 08:01 AM

Classification et analyse de l'utilisation des commentaires JSP Les commentaires JSP sont divisés en deux types : commentaires sur une seule ligne : se terminant par, une seule ligne de code peut être commentée. Commentaires multilignes : commençant par /* et se terminant par */, vous pouvez commenter plusieurs lignes de code. Exemple de commentaire sur une seule ligne Exemple de commentaire sur plusieurs lignes/**Ceci est un commentaire sur plusieurs lignes*Peut commenter plusieurs lignes de code*/Utilisation des commentaires JSP Les commentaires JSP peuvent être utilisés pour commenter le code JSP afin de le rendre plus facile à lire

Comment installer Tensorflow dans Conda

Dec 05, 2023 am 11:26 AM

Comment installer Tensorflow dans Conda

Dec 05, 2023 am 11:26 AM

Étapes d'installation : 1. Téléchargez et installez Miniconda, sélectionnez la version appropriée de Miniconda en fonction du système d'exploitation et installez conformément au guide officiel ; 2. Utilisez la commande "conda create -n tensorflow_env python=3.7" pour créer un nouvel environnement Conda. ; 3. Activez l'environnement Conda ; 4. Utilisez la commande "conda install tensorflow" pour installer la dernière version de TensorFlow ; 5. Vérifiez l'installation.

Comment utiliser correctement la fonction exit en langage C

Feb 18, 2024 pm 03:40 PM

Comment utiliser correctement la fonction exit en langage C

Feb 18, 2024 pm 03:40 PM

Comment utiliser la fonction exit en langage C nécessite des exemples de code spécifiques. En langage C, nous devons souvent terminer l'exécution du programme au début du programme, ou quitter le programme sous certaines conditions. Le langage C fournit la fonction exit() pour implémenter cette fonction. Cet article présentera l'utilisation de la fonction exit() et fournira des exemples de code correspondants. La fonction exit() est une fonction de bibliothèque standard en langage C et est incluse dans le fichier d'en-tête. Sa fonction est de terminer l'exécution du programme, et peut prendre un nombre entier

Utilisation de la fonction WPSdatedif

Feb 20, 2024 pm 10:27 PM

Utilisation de la fonction WPSdatedif

Feb 20, 2024 pm 10:27 PM

WPS est une suite logicielle bureautique couramment utilisée et la fonction de table WPS est largement utilisée pour le traitement des données et les calculs. Dans le tableau WPS, il existe une fonction très utile, la fonction DATEDIF, qui permet de calculer le décalage horaire entre deux dates. La fonction DATEDIF est l'abréviation du mot anglais DateDifference. Sa syntaxe est la suivante : DATEDIF(start_date,end_date,unit) où start_date représente la date de début.

Introduction aux fonctions Python : utilisation et exemples de fonction abs

Nov 03, 2023 pm 12:05 PM

Introduction aux fonctions Python : utilisation et exemples de fonction abs

Nov 03, 2023 pm 12:05 PM

Introduction aux fonctions Python : utilisation et exemples de la fonction abs 1. Introduction à l'utilisation de la fonction abs En Python, la fonction abs est une fonction intégrée utilisée pour calculer la valeur absolue d'une valeur donnée. Il peut accepter un argument numérique et renvoyer la valeur absolue de ce nombre. La syntaxe de base de la fonction abs est la suivante : abs(x) où x est le paramètre numérique permettant de calculer la valeur absolue, qui peut être un nombre entier ou un nombre à virgule flottante. 2. Exemples de fonction abs Ci-dessous, nous montrerons l'utilisation de la fonction abs à travers quelques exemples spécifiques : Exemple 1 : Calcul

Introduction aux fonctions Python : utilisation et exemples de la fonction isinstance

Nov 04, 2023 pm 03:15 PM

Introduction aux fonctions Python : utilisation et exemples de la fonction isinstance

Nov 04, 2023 pm 03:15 PM

Introduction aux fonctions Python : utilisation et exemples de la fonction isinstance Python est un langage de programmation puissant qui fournit de nombreuses fonctions intégrées pour rendre la programmation plus pratique et efficace. L'une des fonctions intégrées très utiles est la fonction isinstance(). Cet article présentera l'utilisation et des exemples de la fonction isinstance et fournira des exemples de code spécifiques. La fonction isinstance() est utilisée pour déterminer si un objet est une instance d'une classe ou d'un type spécifié. La syntaxe de cette fonction est la suivante

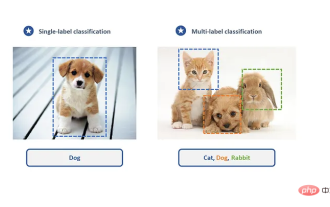

Créez un classificateur d'apprentissage profond pour les photos de chats et de chiens à l'aide de TensorFlow et Keras.

May 16, 2023 am 09:34 AM

Créez un classificateur d'apprentissage profond pour les photos de chats et de chiens à l'aide de TensorFlow et Keras.

May 16, 2023 am 09:34 AM

Dans cet article, nous utiliserons TensorFlow et Keras pour créer un classificateur d'images capable de distinguer les images de chats et de chiens. Pour ce faire, nous utiliserons l'ensemble de données cats_vs_dogs de l'ensemble de données TensorFlow. L'ensemble de données se compose de 25 000 images étiquetées de chats et de chiens, dont 80 % sont utilisées pour l'entraînement, 10 % pour la validation et 10 % pour les tests. Chargement des données Nous commençons par charger l'ensemble de données à l'aide de TensorFlowDatasets. Divisez l'ensemble de données en ensemble d'entraînement, ensemble de validation et ensemble de test, représentant respectivement 80 %, 10 % et 10 % des données, et définissez une fonction pour afficher quelques exemples d'images dans l'ensemble de données. importer

Explication détaillée et introduction à l'utilisation de la fonction MySQL ISNULL

Mar 01, 2024 pm 05:24 PM

Explication détaillée et introduction à l'utilisation de la fonction MySQL ISNULL

Mar 01, 2024 pm 05:24 PM

La fonction ISNULL() dans MySQL est une fonction utilisée pour déterminer si une expression ou une colonne spécifiée est NULL. Il renvoie une valeur booléenne, 1 si l'expression est NULL, 0 sinon. La fonction ISNULL() peut être utilisée dans l'instruction SELECT ou pour un jugement conditionnel dans la clause WHERE. 1. La syntaxe de base de la fonction ISNULL() : ISNULL(expression) où expression est l'expression permettant de déterminer si elle est NULL ou