développement back-end

développement back-end

Tutoriel Python

Tutoriel Python

Exemple d'analyse des journaux nginx avec python+pandas

Exemple d'analyse des journaux nginx avec python+pandas

Exemple d'analyse des journaux nginx avec python+pandas

Ce qui suit est un exemple d'analyse des journaux nginx à l'aide de python+pandas. Il a une bonne valeur de référence et j'espère qu'il sera utile à tout le monde. Jetons un coup d'oeil ensemble

Exigences

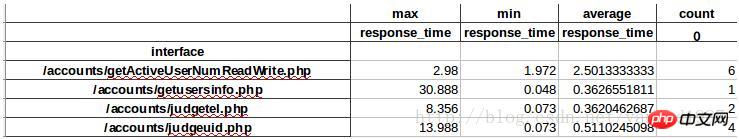

En analysant les logs d'accès nginx, obtenez le temps de réponse maximum, minimum et moyen de chaque interface et visite .

Principe de mise en œuvre

Stockez le champ uriuriupstream_response_time du journal nginx dans la trame de données pandas, puis implémentez-le via des fonctions de regroupement et de statistiques de données.

Mise en œuvre

1.Préparation

#创建日志目录,用于存放日志 mkdir /home/test/python/log/log #创建文件,用于存放从nginx日志中提取的$uri $upstream_response_time字段 touch /home/test/python/log/log.txt #安装相关模块 conda create -n science numpy scipy matplotlib pandas #安装生成execl表格的相关模块 pip install xlwt

2. Implémentation du code

#!/usr/local/miniconda2/envs/science/bin/python

#-*- coding: utf-8 -*-

#统计每个接口的响应时间

#请提前创建log.txt并设置logdir

import sys

import os

import pandas as pd

mulu=os.path.dirname(__file__)

#日志文件存放路径

logdir="/home/test/python/log/log"

#存放统计所需的日志相关字段

logfile_format=os.path.join(mulu,"log.txt")

print "read from logfile \n"

for eachfile in os.listdir(logdir):

logfile=os.path.join(logdir,eachfile)

with open(logfile, 'r') as fo:

for line in fo:

spline=line.split()

#过滤字段中异常部分

if spline[6]=="-":

pass

elif spline[6]=="GET":

pass

elif spline[-1]=="-":

pass

else:

with open(logfile_format, 'a') as fw:

fw.write(spline[6])

fw.write('\t')

fw.write(spline[-1])

fw.write('\n')

print "output panda"

#将统计的字段读入到dataframe中

reader=pd.read_table(logfile_format,sep='\t',engine='python',names=["interface","reponse_time"] ,header=None,iterator=True)

loop=True

chunksize=10000000

chunks=[]

while loop:

try:

chunk=reader.get_chunk(chunksize)

chunks.append(chunk)

except StopIteration:

loop=False

print "Iteration is stopped."

df=pd.concat(chunks)

#df=df.set_index("interface")

#df=df.drop(["GET","-"])

df_groupd=df.groupby('interface')

df_groupd_max=df_groupd.max()

df_groupd_min= df_groupd.min()

df_groupd_mean= df_groupd.mean()

df_groupd_size= df_groupd.size()

#print df_groupd_max

#print df_groupd_min

#print df_groupd_mean

df_ana=pd.concat([df_groupd_max,df_groupd_min,df_groupd_mean,df_groupd_size],axis=1,keys=["max","min","average","count"])

print "output excel"

df_ana.to_excel("test.xls")3. Le formulaire imprimé est le suivant :

Points clés

1. Fichier journal N'utilisez pas readlines() ou readline() lors de la lecture d'un fichier relativement volumineux. Tous les journaux seront lus dans la mémoire, ce qui entraînera une saturation de la mémoire. Par conséquent, la méthode d'itération for line in fo est utilisée ici, qui n'occupe fondamentalement pas de mémoire.

2. Pour lire les journaux nginx, vous pouvez utiliser pd.read_table(log_file, sep=' ', iterator=True), mais le sep que nous définissons ici ne peut pas correspondre normalement à la division, donc divisez d'abord nginx avec split , puis enregistrez-le sur pandas.

3. Pandas fournit des outils IO pour lire des fichiers volumineux en morceaux, utiliser différentes tailles de morceaux pour lire, puis appeler pandas.concat pour se connecter à DataFrame

Recommandations associées :

python3 pandas lit les données MySQL et les insère

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment configurer le nom de domaine du serveur cloud dans nginx

Apr 14, 2025 pm 12:18 PM

Comment configurer le nom de domaine du serveur cloud dans nginx

Apr 14, 2025 pm 12:18 PM

Comment configurer un nom de domaine NGINX sur un serveur cloud: Créez un enregistrement A pointant vers l'adresse IP publique du serveur cloud. Ajoutez des blocs d'hôtes virtuels dans le fichier de configuration Nginx, en spécifiant le port d'écoute, le nom de domaine et le répertoire racine du site Web. Redémarrez Nginx pour appliquer les modifications. Accéder à la configuration du test de nom de domaine. Autres notes: Installez le certificat SSL pour activer HTTPS, assurez-vous que le pare-feu autorise le trafic Port 80 et attendez que la résolution DNS prenne effet.

Comment vérifier la version nginx

Apr 14, 2025 am 11:57 AM

Comment vérifier la version nginx

Apr 14, 2025 am 11:57 AM

Les méthodes qui peuvent interroger la version Nginx sont: utilisez la commande nginx -v; Afficher la directive de version dans le fichier nginx.conf; Ouvrez la page d'erreur Nginx et affichez le titre de la page.

Comment vérifier si Nginx est démarré

Apr 14, 2025 pm 01:03 PM

Comment vérifier si Nginx est démarré

Apr 14, 2025 pm 01:03 PM

Comment confirmer si Nginx est démarré: 1. Utilisez la ligne de commande: SystemCTl Status Nginx (Linux / Unix), netStat -ano | Findstr 80 (Windows); 2. Vérifiez si le port 80 est ouvert; 3. Vérifiez le message de démarrage NGINX dans le journal système; 4. Utilisez des outils tiers, tels que Nagios, Zabbix et Icinga.

Comment configurer Nginx dans Windows

Apr 14, 2025 pm 12:57 PM

Comment configurer Nginx dans Windows

Apr 14, 2025 pm 12:57 PM

Comment configurer Nginx dans Windows? Installez Nginx et créez une configuration d'hôte virtuelle. Modifiez le fichier de configuration principale et incluez la configuration de l'hôte virtuel. Démarrer ou recharger nginx. Testez la configuration et affichez le site Web. Activer sélectivement SSL et configurer les certificats SSL. Définissez sélectivement le pare-feu pour permettre le trafic Port 80 et 443.

Comment vérifier le nom du conteneur Docker

Apr 15, 2025 pm 12:21 PM

Comment vérifier le nom du conteneur Docker

Apr 15, 2025 pm 12:21 PM

Vous pouvez interroger le nom du conteneur Docker en suivant les étapes: répertorier tous les conteneurs (Docker PS). Filtrez la liste des conteneurs (à l'aide de la commande grep). Obtient le nom du conteneur (situé dans la colonne "Noms").

Comment démarrer le serveur Nginx

Apr 14, 2025 pm 12:27 PM

Comment démarrer le serveur Nginx

Apr 14, 2025 pm 12:27 PM

Le démarrage d'un serveur Nginx nécessite différentes étapes en fonction des différents systèmes d'exploitation: Système Linux / Unix: Installez le package NGINX (par exemple, en utilisant Apt-Get ou Yum). Utilisez SystemCTL pour démarrer un service NGINX (par exemple, sudo systemctl start nginx). Système Windows: téléchargez et installez les fichiers binaires Windows. Démarrer Nginx à l'aide de l'exécutable Nginx.exe (par exemple, nginx.exe -c conf \ nginx.conf). Peu importe le système d'exploitation que vous utilisez, vous pouvez accéder au serveur IP

Comment démarrer un conteneur par Docker

Apr 15, 2025 pm 12:27 PM

Comment démarrer un conteneur par Docker

Apr 15, 2025 pm 12:27 PM

Étapes de démarrage du conteneur Docker: Tirez l'image du conteneur: Exécutez "Docker Pull [Mirror Name]". Créer un conteneur: utilisez "Docker Create [Options] [Mirror Name] [Commandes et paramètres]". Démarrez le conteneur: exécutez "docker start [nom de conteneur ou id]". Vérifiez l'état du conteneur: vérifiez que le conteneur s'exécute avec "Docker PS".

Comment exécuter nginx apache

Apr 14, 2025 pm 12:33 PM

Comment exécuter nginx apache

Apr 14, 2025 pm 12:33 PM

Pour faire en sorte que Nginx exécute Apache, vous devez: 1. Installez Nginx et Apache; 2. Configurer l'agent Nginx; 3. Démarrer Nginx et Apache; 4. Testez la configuration pour vous assurer que vous pouvez voir le contenu Apache après avoir accédé au nom de domaine. De plus, vous devez faire attention à d'autres questions telles que la correspondance du numéro de port, la configuration de l'hôte virtuel et les paramètres SSL / TLS.