développement back-end

développement back-end

Tutoriel Python

Tutoriel Python

python2.7 implémente les données de la page Web du robot

python2.7 implémente les données de la page Web du robot

python2.7 implémente les données de la page Web du robot

Cet article présente principalement en détail l'implémentation de l'exploration des données de page Web dans python2.7. Il a une certaine valeur de référence. Les amis intéressés peuvent s'y référer

Je viens d'apprendre Python récemment et j'ai créé un simple Le robot d'exploration. , sous forme de simple démo, espère aider les débutants comme moi.

Le code utilise un robot réalisé avec python2.7 pour capturer le titre du poste, le nom de l'entreprise, le salaire, l'heure de sortie, etc. sur 51job.

Accédez directement au code. Les commentaires dans le code sont relativement clairs. Si MySQL n'est pas installé, vous devez bloquer le code concerné :

#!/usr/bin/python

# -*- coding: UTF-8 -*-

from bs4 import BeautifulSoup

import urllib

import urllib2

import codecs

import re

import time

import logging

import MySQLdb

class Jobs(object):

# 初始化

"""docstring for Jobs"""

def __init__(self):

super(Jobs, self).__init__()

logging.basicConfig(level=logging.DEBUG,

format='%(asctime)s %(filename)s[line:%(lineno)d] %(levelname)s %(message)s')

#数据库的操作,没有mysql可以做屏蔽

self.db = MySQLdb.connect('127.0.0.1','root','rootroot','MySQL_Test',charset='utf8')

self.cursor = self.db.cursor()

#log日志的显示

self.logger = logging.getLogger("sjk")

self.logger.setLevel(level=logging.DEBUG)

formatter = logging.Formatter(

'%(asctime)s - %(name)s - %(levelname)s - %(message)s')

handler = logging.FileHandler('log.txt')

handler.setFormatter(formatter)

handler.setLevel(logging.DEBUG)

self.logger.addHandler(handler)

self.logger.info('初始化完成')

# 模拟请求数据

def jobshtml(self, key, page='1'):

try:

self.logger.info('开始请求第' + page + '页')

#网页url

searchurl = "https://search.51job.com/list/040000,000000,0000,00,9,99,{key},2,{page}.html?lang=c&stype=&postchannel=0000&workyear=99&cotype=99°reefrom=99&jobterm=99&companysize=99&providesalary=99&lonlat=0%2C0&radius=-1&ord_field=0&confirmdate=9&fromType=&dibiaoid=0&address=&line=&specialarea=00&from=&welfare="

user_agent = 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10.13; rv:59.0) Gecko/20100101 Firefox/59.0'

#设置请求头

header = {'User-Agent': user_agent, 'Host': 'search.51job.com',

'Referer': 'https://www.51job.com/'}

#拼接url

finalUrl = searchurl.format(key=key, page=page)

request = urllib2.Request(finalUrl, headers=header)

response = urllib2.urlopen(request)

#等待网页加载完成

time.sleep(3)

#gbk格式解码

info = response.read().decode('gbk')

self.logger.info('请求网页网页')

self.decodeHtml(info=info, key=key, page=page)

except urllib2.HTTPError as e:

print e.reason

# 解析网页数据

def decodeHtml(self, info, key, page):

self.logger.info('开始解析网页数据')

#BeautifulSoup 解析网页

soup = BeautifulSoup(info, 'html.parser')

#找到class = t1 t2 t3 t4 t5 的标签数据

ps = soup.find_all(attrs={"class": re.compile(r'^t[1-5].*')})

#打开txt文件 a+ 代表追加

f = codecs.open(key + '.txt', 'a+', 'UTF-8')

#清除之前的数据信息

f.truncate()

f.write('\n------------' + page + '--------------\n')

count = 1

arr = []

#做一些字符串的处理,形成数据格式 iOS开发工程师 有限公司 深圳-南山区 0.9-1.6万/月 05-16

for pi in ps:

spe = " "

finalstr = pi.getText().strip()

arr.append(finalstr)

if count % 5 == 0:

#每一条数据插入数据库,如果没有安装mysql 可以将当前行注释掉

self.connectMySQL(arr=arr)

arr = []

spe = "\n"

writestr = finalstr + spe

count += 1

f.write(writestr)

f.close()

self.logger.info('解析完成')

#数据库操作 没有安装mysql 可以屏蔽掉

def connectMySQL(self,arr):

work=arr[0]

company=arr[1]

place=arr[2]

salary=arr[3]

time=arr[4]

query = "select * from Jobs_tab where \

company_name='%s' and work_name='%s' and work_place='%s' \

and salary='%s' and time='%s'" %(company,work,place,salary,time)

self.cursor.execute(query)

queryresult = self.cursor.fetchall()

#数据库中不存在就插入数据 存在就可以更新数据 不过我这边没有写

if len(queryresult) > 0:

sql = "insert into Jobs_tab(work_name,company_name,work_place,salary\

,time) values('%s','%s','%s','%s','%s')" %(work,company,place,salary,time)

try:

self.cursor.execute(sql)

self.db.commit()

except Exception as e:

self.logger.info('写入数据库失败')

#模拟登陆

# def login(self):

# data = {'action':'save','isread':'on','loginname':'18086514327','password':'kui4131sjk'}

# 开始抓取 主函数

def run(self, key):

# 只要前5页的数据 key代表搜索工做类型 这边我是用的ios page是页数

for x in xrange(1, 6):

self.jobshtml(key=key, page=str(x))

self.logger.info('写入数据库完成')

self.db.close()

if __name__ == '__main__':

Jobs().run(key='iOS')

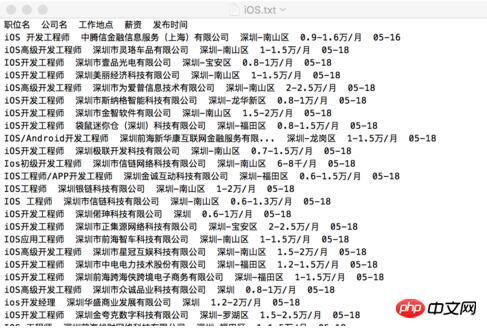

Attrapez-le comme ça Le format d'obtention des données de page Web est le suivant :

Recommandations associées :

Python implémente le téléchargement d'images de beauté par un robot

Exemple d'implémentation Python de bandes dessinées téléchargées par un robot

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment envoyer des pages Web sur le bureau comme raccourci dans le navigateur Edge ?

Mar 14, 2024 pm 05:22 PM

Comment envoyer des pages Web sur le bureau comme raccourci dans le navigateur Edge ?

Mar 14, 2024 pm 05:22 PM

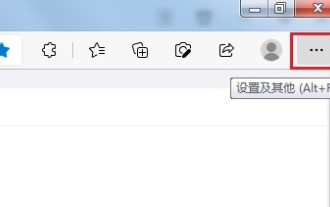

Comment envoyer des pages Web sur le bureau sous forme de raccourci dans le navigateur Edge ? Beaucoup de nos utilisateurs souhaitent afficher les pages Web fréquemment utilisées sur le bureau sous forme de raccourcis pour faciliter l'ouverture directe des pages d'accès, mais ils ne savent pas comment procéder. En réponse à ce problème, l'éditeur de ce numéro partagera le. solution avec la majorité des utilisateurs, jetons un coup d’œil au contenu partagé dans le didacticiel du logiciel d’aujourd’hui. La méthode de raccourci pour envoyer des pages Web au bureau dans le navigateur Edge : 1. Ouvrez le logiciel et cliquez sur le bouton "..." sur la page. 2. Sélectionnez « Installer ce site en tant qu'application » dans « Application » dans l'option du menu déroulant. 3. Enfin, cliquez dessus dans la fenêtre pop-up

Utilisez ddrescue pour récupérer des données sous Linux

Mar 20, 2024 pm 01:37 PM

Utilisez ddrescue pour récupérer des données sous Linux

Mar 20, 2024 pm 01:37 PM

DDREASE est un outil permettant de récupérer des données à partir de périphériques de fichiers ou de blocs tels que des disques durs, des SSD, des disques RAM, des CD, des DVD et des périphériques de stockage USB. Il copie les données d'un périphérique bloc à un autre, laissant derrière lui les blocs corrompus et ne déplaçant que les bons blocs. ddreasue est un puissant outil de récupération entièrement automatisé car il ne nécessite aucune interruption pendant les opérations de récupération. De plus, grâce au fichier map ddasue, il peut être arrêté et repris à tout moment. Les autres fonctionnalités clés de DDREASE sont les suivantes : Il n'écrase pas les données récupérées mais comble les lacunes en cas de récupération itérative. Cependant, il peut être tronqué si l'outil est invité à le faire explicitement. Récupérer les données de plusieurs fichiers ou blocs en un seul

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

0. À quoi sert cet article ? Nous proposons DepthFM : un modèle d'estimation de profondeur monoculaire génératif de pointe, polyvalent et rapide. En plus des tâches traditionnelles d'estimation de la profondeur, DepthFM démontre également des capacités de pointe dans les tâches en aval telles que l'inpainting en profondeur. DepthFM est efficace et peut synthétiser des cartes de profondeur en quelques étapes d'inférence. Lisons ce travail ensemble ~ 1. Titre des informations sur l'article : DepthFM : FastMonocularDepthEstimationwithFlowMatching Auteur : MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Comment utiliser la fonction de filtre Excel avec plusieurs conditions

Feb 26, 2024 am 10:19 AM

Comment utiliser la fonction de filtre Excel avec plusieurs conditions

Feb 26, 2024 am 10:19 AM

Si vous avez besoin de savoir comment utiliser le filtrage avec plusieurs critères dans Excel, le didacticiel suivant vous guidera à travers les étapes pour vous assurer que vous pouvez filtrer et trier efficacement vos données. La fonction de filtrage d'Excel est très puissante et peut vous aider à extraire les informations dont vous avez besoin à partir de grandes quantités de données. Cette fonction peut filtrer les données en fonction des conditions que vous définissez et afficher uniquement les pièces qui remplissent les conditions, rendant la gestion des données plus efficace. En utilisant la fonction de filtre, vous pouvez trouver rapidement des données cibles, ce qui vous fait gagner du temps dans la recherche et l'organisation des données. Cette fonction peut non seulement être appliquée à de simples listes de données, mais peut également être filtrée en fonction de plusieurs conditions pour vous aider à localiser plus précisément les informations dont vous avez besoin. Dans l’ensemble, la fonction de filtrage d’Excel est très utile

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

Vitesse Internet lente des données cellulaires sur iPhone : correctifs

May 03, 2024 pm 09:01 PM

Vitesse Internet lente des données cellulaires sur iPhone : correctifs

May 03, 2024 pm 09:01 PM

Vous êtes confronté à un décalage et à une connexion de données mobile lente sur iPhone ? En règle générale, la puissance de l'Internet cellulaire sur votre téléphone dépend de plusieurs facteurs tels que la région, le type de réseau cellulaire, le type d'itinérance, etc. Vous pouvez prendre certaines mesures pour obtenir une connexion Internet cellulaire plus rapide et plus fiable. Correctif 1 – Forcer le redémarrage de l'iPhone Parfois, le redémarrage forcé de votre appareil réinitialise simplement beaucoup de choses, y compris la connexion cellulaire. Étape 1 – Appuyez simplement une fois sur la touche d’augmentation du volume et relâchez-la. Ensuite, appuyez sur la touche de réduction du volume et relâchez-la à nouveau. Étape 2 – La partie suivante du processus consiste à maintenir le bouton sur le côté droit. Laissez l'iPhone finir de redémarrer. Activez les données cellulaires et vérifiez la vitesse du réseau. Vérifiez à nouveau Correctif 2 – Changer le mode de données Bien que la 5G offre de meilleures vitesses de réseau, elle fonctionne mieux lorsque le signal est plus faible

Que dois-je faire si les images de la page Web ne peuvent pas être chargées ? 6 solutions

Mar 15, 2024 am 10:30 AM

Que dois-je faire si les images de la page Web ne peuvent pas être chargées ? 6 solutions

Mar 15, 2024 am 10:30 AM

Certains internautes ont constaté que lorsqu'ils ouvraient la page Web du navigateur, les images de la page Web ne pouvaient pas être chargées pendant une longue période. Que s'est-il passé ? J'ai vérifié que le réseau est normal, alors quel est le problème ? L'éditeur ci-dessous vous présentera six solutions au problème de l'impossibilité de charger les images de pages Web. Les images de la page Web ne peuvent pas être chargées : 1. Problème de vitesse Internet La page Web ne peut pas afficher les images. Cela peut être dû au fait que la vitesse Internet de l'ordinateur est relativement lente et qu'il y a davantage de logiciels ouverts sur l'ordinateur et que les images auxquelles nous accédons sont relativement volumineuses. peut être dû à un délai de chargement. Par conséquent, l'image ne peut pas être affichée. Vous pouvez désactiver le logiciel qui utilise la vitesse du réseau et le vérifier dans le gestionnaire de tâches. 2. Trop de visiteurs Si la page Web ne peut pas afficher d'images, c'est peut-être parce que les pages Web que nous avons visitées ont été visitées en même temps.

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

Je pleure à mort. Le monde construit à la folie de grands modèles. Les données sur Internet ne suffisent pas du tout. Le modèle de formation ressemble à « The Hunger Games », et les chercheurs en IA du monde entier se demandent comment nourrir ces personnes avides de données. Ce problème est particulièrement important dans les tâches multimodales. À une époque où rien ne pouvait être fait, une équipe de start-up du département de l'Université Renmin de Chine a utilisé son propre nouveau modèle pour devenir la première en Chine à faire de « l'auto-alimentation des données générées par le modèle » une réalité. De plus, il s’agit d’une approche à deux volets, du côté compréhension et du côté génération, les deux côtés peuvent générer de nouvelles données multimodales de haute qualité et fournir un retour de données au modèle lui-même. Qu'est-ce qu'un modèle ? Awaker 1.0, un grand modèle multimodal qui vient d'apparaître sur le Forum Zhongguancun. Qui est l'équipe ? Moteur Sophon. Fondé par Gao Yizhao, doctorant à la Hillhouse School of Artificial Intelligence de l’Université Renmin.