développement back-end

développement back-end

Tutoriel Python

Tutoriel Python

Crawler Python pour créer un framework de robot Scrapy dans l'environnement Anaconda

Crawler Python pour créer un framework de robot Scrapy dans l'environnement Anaconda

Crawler Python pour créer un framework de robot Scrapy dans l'environnement Anaconda

Comment créer un framework de robot Scrapy dans l'environnement Anaconda ? Cet article vous présentera les étapes à suivre pour créer un projet de framework de robot Scrapy dans l'environnement Anaconda. Il vaut la peine d'être lu.

Tutoriel Python Crawler-31-Créer un projet de framework de robot Scrapy

Tout d'abord, cet article est dans l'environnement Anaconda, donc si Anaconda n'est pas installé, veuillez vous rendre sur le site officiel pour télécharger et installez-le d'abord

Adresse de téléchargement Anaconda : https://www.anaconda.com/download/

Création du projet de framework de robot Scrapy

0.

1. Entrez l'environnement Anaconda que vous souhaitez utiliser

Ici, nous avons créé le projet et analysons le rôle des fichiers générés automatiquement

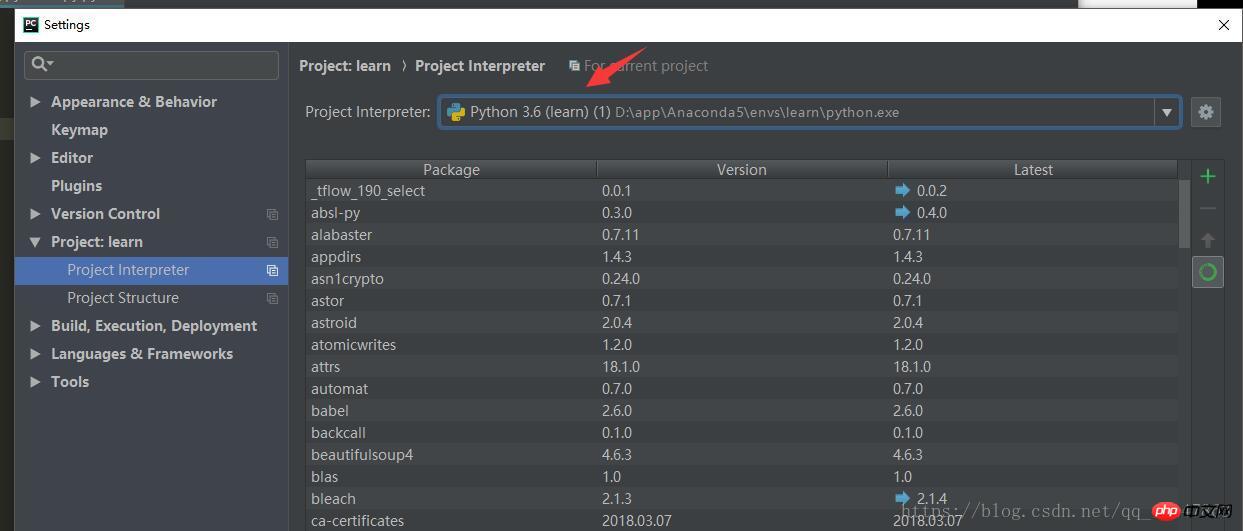

1. trouvé sous [Paramètres] dans [Pycharm] Recherchez

sous [Projet :] 2. Utilisez la commande : activer le nom de l'environnement, par exemple :

activer apprendre

3. Entrez le répertoire souhaité dans lequel le projet scrapy doit être stocké [Note]

4 Nouveau projet : nom du projet scrapy startproject xxx, par exemple :

scrapy startproject new_project5. Capture d'écran de l'opération :

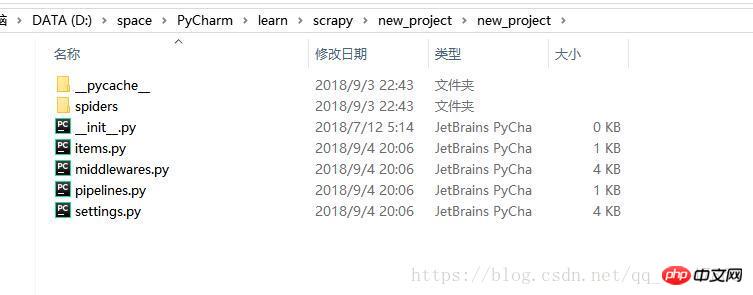

7. Utilisez simplement Pycharm pour ouvrir le répertoire où se trouve le projet

7. Utilisez simplement Pycharm pour ouvrir le répertoire où se trouve le projet

Développement du projet de framework de robot Scrapy

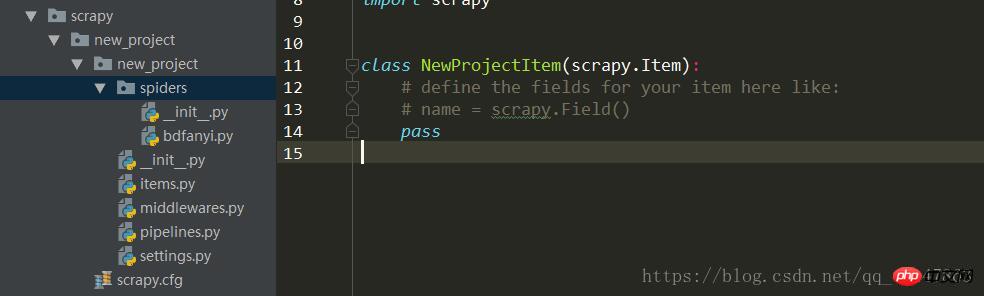

0. pour ouvrir le projet, capture d'écran :

Le processus général de développement du projet :

L'adresse spider/xxspider.py se charge de décomposer et extraire les données téléchargées

1. Clarifiez la cible/le produit qui doit être exploré : écrivez l'élément py

2. Téléchargez et créez un fichier python dans le répertoire spider pour créer un robot :

3. Contenu du magasin : pipelines.py

Fichier Pipeline.py

Lorsque l'objet araignée est fermé, le

L'objet araignée est appelé. Lorsque l'objet araignée est ouvert, le

est appelé pour initialiser certains paramètres nécessaires.

Les éléments extraits par l'araignée sont utilisés comme Les paramètres sont transmis et l'araignée.

est également transmis. Cette méthode doit implémenter

et doit renvoyer un objet Item. L'élément supprimé ne correspondra pas au pipeline suivant

fichier de pipelines

.Une fois que le robot a extrait les données et les a stockées dans l'élément, les données enregistrées dans l'élément nécessitent un traitement ultérieur, tel que le nettoyage, le déparasitage, le stockage, etc.

Le pipeline doit traiter la fonction process_item

process_item

_ init _ : constructeur

open_spider(spider) :

close_spider(spider) :

Répertoire Spider

correspond au fichier sous le dossier spider

_ init _ : initialiser le nom du robot, démarrer la liste _urls

start_requests : générer Demandes d'intersection d'objets Téléchargez et renvoyez la réponse à Scrapy

parse : analysez l'élément correspondant en fonction de la réponse renvoyée, et l'élément entre automatiquement dans le pipeline : si nécessaire, analysez l'URL et l'URL est automatiquement transmise au module de requêtes, et le cycle continue

start_requests : cette méthode peut être appelée une fois, lisez le contenu de start _urls et démarrez le processus de boucle

name : définissez le nom du robot

start_urls : définissez l'URL pour démarrer le premier lot d'exploration

allow_domains : liste des noms de domaine que l'araignée est autorisée à explorer

start_request(self) : appelé une seule fois

analyse : codage de détection

journal : enregistrement du journal

Recommandations associées :

Explication détaillée des exemples scrapy du framework de robot d'exploration PythonTutoriel d'introduction au robot d'exploration Scrapy Four Spider (crawler) Un exemple simple d'écriture d'un robot d'exploration Web à l'aide du framework Scrapy de PythonCe qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1393

1393

52

52

1207

1207

24

24

Comment résoudre le problème des autorisations rencontré lors de la visualisation de la version Python dans le terminal Linux?

Apr 01, 2025 pm 05:09 PM

Comment résoudre le problème des autorisations rencontré lors de la visualisation de la version Python dans le terminal Linux?

Apr 01, 2025 pm 05:09 PM

Solution aux problèmes d'autorisation Lors de la visualisation de la version Python dans Linux Terminal Lorsque vous essayez d'afficher la version Python dans Linux Terminal, entrez Python ...

Comment enseigner les bases de la programmation novice en informatique dans le projet et les méthodes axées sur les problèmes dans les 10 heures?

Apr 02, 2025 am 07:18 AM

Comment enseigner les bases de la programmation novice en informatique dans le projet et les méthodes axées sur les problèmes dans les 10 heures?

Apr 02, 2025 am 07:18 AM

Comment enseigner les bases de la programmation novice en informatique dans les 10 heures? Si vous n'avez que 10 heures pour enseigner à l'informatique novice des connaissances en programmation, que choisissez-vous d'enseigner ...

Comment éviter d'être détecté par le navigateur lors de l'utilisation de Fiddler partout pour la lecture de l'homme au milieu?

Apr 02, 2025 am 07:15 AM

Comment éviter d'être détecté par le navigateur lors de l'utilisation de Fiddler partout pour la lecture de l'homme au milieu?

Apr 02, 2025 am 07:15 AM

Comment éviter d'être détecté lors de l'utilisation de FiddlereVerywhere pour les lectures d'homme dans le milieu lorsque vous utilisez FiddlereVerywhere ...

Comment copier efficacement la colonne entière d'une dataframe dans une autre dataframe avec différentes structures dans Python?

Apr 01, 2025 pm 11:15 PM

Comment copier efficacement la colonne entière d'une dataframe dans une autre dataframe avec différentes structures dans Python?

Apr 01, 2025 pm 11:15 PM

Lorsque vous utilisez la bibliothèque Pandas de Python, comment copier des colonnes entières entre deux frames de données avec différentes structures est un problème courant. Supposons que nous ayons deux dats ...

Comment Uvicorn écoute-t-il en permanence les demandes HTTP sans servir_forever ()?

Apr 01, 2025 pm 10:51 PM

Comment Uvicorn écoute-t-il en permanence les demandes HTTP sans servir_forever ()?

Apr 01, 2025 pm 10:51 PM

Comment Uvicorn écoute-t-il en permanence les demandes HTTP? Uvicorn est un serveur Web léger basé sur ASGI. L'une de ses fonctions principales est d'écouter les demandes HTTP et de procéder ...

Comment créer dynamiquement un objet via une chaîne et appeler ses méthodes dans Python?

Apr 01, 2025 pm 11:18 PM

Comment créer dynamiquement un objet via une chaîne et appeler ses méthodes dans Python?

Apr 01, 2025 pm 11:18 PM

Dans Python, comment créer dynamiquement un objet via une chaîne et appeler ses méthodes? Il s'agit d'une exigence de programmation courante, surtout si elle doit être configurée ou exécutée ...

Comment résoudre les problèmes d'autorisation lors de l'utilisation de la commande python --version dans le terminal Linux?

Apr 02, 2025 am 06:36 AM

Comment résoudre les problèmes d'autorisation lors de l'utilisation de la commande python --version dans le terminal Linux?

Apr 02, 2025 am 06:36 AM

Utilisation de Python dans Linux Terminal ...

Comment gérer les paramètres de requête de liste séparés par les virgules dans FastAPI?

Apr 02, 2025 am 06:51 AM

Comment gérer les paramètres de requête de liste séparés par les virgules dans FastAPI?

Apr 02, 2025 am 06:51 AM

Fastapi ...