Qu'est-ce que l'avalanche Redis

Qu'est-ce que Redis Avalanche ? L'article suivant vous donnera une brève introduction, j'espère qu'il vous sera utile.

Qu'est-ce qu'une avalanche ?

Étant donné que la couche de cache transporte un grand nombre de requêtes, elle protège efficacement la couche de stockage. Cependant, si le cache n'est pas en mesure de fournir des services pour une raison quelconque, toutes les requêtes arriveront. couche, le nombre d'appels à la couche de stockage augmentera considérablement, provoquant également le blocage de la couche de stockage. L'explication anglaise de l'avalanche de cache est "run bison", ce qui signifie qu'après le crash de la couche de cache, le trafic simultané accédera au stockage principal comme un bison au galop.

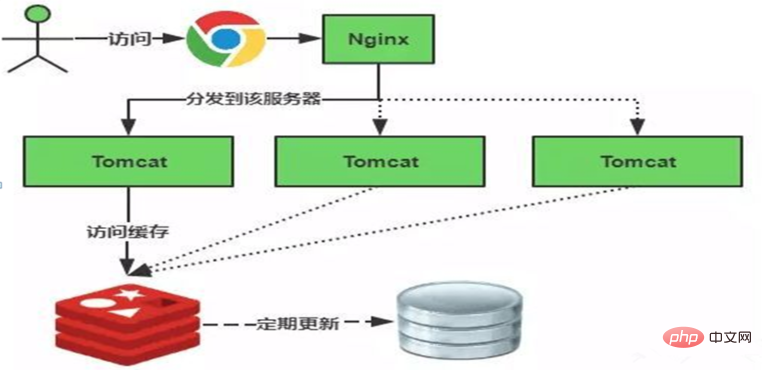

La compréhension simple de l'avalanche de cache est la suivante : en raison de la défaillance du cache d'origine (ou les données ne sont pas chargées dans le cache), pendant la période où le nouveau cache n'est pas arrivé (le cache est normalement obtenu depuis Redis, comme indiqué ci-dessous), tout le cache doit être accessible à l'origine. Toutes les requêtes vont interroger la base de données, ce qui exerce une pression énorme sur le processeur et la mémoire de la base de données. Dans les cas graves, cela peut entraîner un temps d'arrêt de la base de données et un crash du système.

L'échec du cache est le suivant :

Un scénario dans lequel ce problème existe est : lorsque le serveur de cache est redémarré Ou un grand nombre de caches peuvent échouer dans un certain laps de temps, donc lorsqu'ils échouent, une grande quantité de données accédera directement à la base de données, ce qui exerce beaucoup de pression sur la base de données.

L'effet avalanche de l'invalidation du cache a un impact terrible sur le système sous-jacent ! Alors quelles sont les solutions à ce problème ?

Solution

1) Configurer la haute disponibilité du cluster redis et du cluster DB Si redis tombe en panne, il peut être immédiatement remplacé par une autre machine. Cela peut prévenir certains risques.

2) Utilisez des verrous mutex

Après l'expiration du cache, contrôlez le nombre de threads lisant et écrivant dans la base de données via le verrouillage ou la mise en file d'attente. Par exemple : un seul thread est autorisé à interroger les données et à écrire dans le cache pour une certaine clé, tandis que les autres threads attendent. S'il s'agit d'une machine autonome, vous pouvez utiliser synchronisé ou verrouiller pour le résoudre. S'il s'agit d'un environnement distribué, vous pouvez utiliser la commande redis setnx pour le résoudre.

3) Pour différentes clés, vous pouvez définir différents délais d'expiration pour rendre les points temporels d'invalidation du cache incohérents et essayer d'obtenir une distribution uniforme.

4) Ne jamais expirer

Redis est configuré pour ne jamais expirer. Cela garantit qu'il n'y aura pas de problèmes de point d'accès, c'est-à-dire qu'il n'expirera pas physiquement.

5), Protection des ressources

À l'aide de l'hystrix de Netflix, vous pouvez isoler le pool de threads de diverses ressources pour protéger le pool de threads principal.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment construire le mode Cluster Redis

Apr 10, 2025 pm 10:15 PM

Comment construire le mode Cluster Redis

Apr 10, 2025 pm 10:15 PM

Le mode Redis Cluster déploie les instances Redis sur plusieurs serveurs grâce à la rupture, à l'amélioration de l'évolutivité et de la disponibilité. Les étapes de construction sont les suivantes: Créez des instances de redis étranges avec différents ports; Créer 3 instances Sentinel, Moniteur Redis Instances et basculement; Configurer les fichiers de configuration Sentinel, ajouter des informations d'instance Redis de surveillance et des paramètres de basculement; Configurer les fichiers de configuration d'instance Redis, activer le mode de cluster et spécifier le chemin du fichier d'informations de cluster; Créer un fichier nœuds.conf, contenant des informations de chaque instance redis; Démarrez le cluster, exécutez la commande CREATE pour créer un cluster et spécifiez le nombre de répliques; Connectez-vous au cluster pour exécuter la commande d'informations de cluster pour vérifier l'état du cluster; faire

Comment utiliser la commande redis

Apr 10, 2025 pm 08:45 PM

Comment utiliser la commande redis

Apr 10, 2025 pm 08:45 PM

L'utilisation de la directive Redis nécessite les étapes suivantes: Ouvrez le client Redis. Entrez la commande (Verbe Key Value). Fournit les paramètres requis (varie de l'instruction à l'instruction). Appuyez sur Entrée pour exécuter la commande. Redis renvoie une réponse indiquant le résultat de l'opération (généralement OK ou -err).

Comment afficher toutes les clés dans Redis

Apr 10, 2025 pm 07:15 PM

Comment afficher toutes les clés dans Redis

Apr 10, 2025 pm 07:15 PM

Pour afficher toutes les touches dans Redis, il existe trois façons: utilisez la commande Keys pour retourner toutes les clés qui correspondent au modèle spécifié; Utilisez la commande SCAN pour itérer les touches et renvoyez un ensemble de clés; Utilisez la commande info pour obtenir le nombre total de clés.

Comment implémenter le redis sous-jacent

Apr 10, 2025 pm 07:21 PM

Comment implémenter le redis sous-jacent

Apr 10, 2025 pm 07:21 PM

Redis utilise des tables de hachage pour stocker les données et prend en charge les structures de données telles que les chaînes, les listes, les tables de hachage, les collections et les collections ordonnées. Redis persiste les données via des instantanés (RDB) et ajoutez les mécanismes d'écriture uniquement (AOF). Redis utilise la réplication maître-esclave pour améliorer la disponibilité des données. Redis utilise une boucle d'événement unique pour gérer les connexions et les commandes pour assurer l'atomicité et la cohérence des données. Redis définit le temps d'expiration de la clé et utilise le mécanisme de suppression paresseux pour supprimer la clé d'expiration.

Comment implémenter Redis Counter

Apr 10, 2025 pm 10:21 PM

Comment implémenter Redis Counter

Apr 10, 2025 pm 10:21 PM

Redis Counter est un mécanisme qui utilise le stockage de la paire de valeurs de clés Redis pour implémenter les opérations de comptage, y compris les étapes suivantes: création de clés de comptoir, augmentation du nombre, diminution du nombre, réinitialisation du nombre et objet de comptes. Les avantages des compteurs Redis comprennent une vitesse rapide, une concurrence élevée, une durabilité et une simplicité et une facilité d'utilisation. Il peut être utilisé dans des scénarios tels que le comptage d'accès aux utilisateurs, le suivi des métriques en temps réel, les scores de jeu et les classements et le comptage de traitement des commandes.

Comment démarrer le serveur avec redis

Apr 10, 2025 pm 08:12 PM

Comment démarrer le serveur avec redis

Apr 10, 2025 pm 08:12 PM

Les étapes pour démarrer un serveur Redis incluent: Installez Redis en fonction du système d'exploitation. Démarrez le service Redis via Redis-Server (Linux / MacOS) ou Redis-Server.exe (Windows). Utilisez la commande redis-Cli Ping (Linux / MacOS) ou redis-Cli.exe Ping (Windows) pour vérifier l'état du service. Utilisez un client redis, tel que redis-cli, python ou node.js pour accéder au serveur.

Comment lire le code source de Redis

Apr 10, 2025 pm 08:27 PM

Comment lire le code source de Redis

Apr 10, 2025 pm 08:27 PM

La meilleure façon de comprendre le code source redis est d'aller étape par étape: familiarisez-vous avec les bases de Redis. Sélectionnez un module ou une fonction spécifique comme point de départ. Commencez par le point d'entrée du module ou de la fonction et affichez le code ligne par ligne. Affichez le code via la chaîne d'appel de fonction. Familiez les structures de données sous-jacentes utilisées par Redis. Identifiez l'algorithme utilisé par Redis.

Comment utiliser Redis Lock

Apr 10, 2025 pm 08:39 PM

Comment utiliser Redis Lock

Apr 10, 2025 pm 08:39 PM

L'utilisation des opérations Redis pour verrouiller nécessite l'obtention du verrouillage via la commande setnx, puis en utilisant la commande Expire pour définir le temps d'expiration. Les étapes spécifiques sont les suivantes: (1) Utilisez la commande setnx pour essayer de définir une paire de valeurs de clé; (2) Utilisez la commande Expire pour définir le temps d'expiration du verrou; (3) Utilisez la commande del pour supprimer le verrouillage lorsque le verrouillage n'est plus nécessaire.