Que signifie Apache Spark

Apache Spark est un puissant moteur de traitement open source développé à l'origine par Matei Zaharia ? Développé dans le cadre de sa thèse de doctorat à l’Université de Californie à Berkeley. La première version de Spark est sortie en 2012.

Apache Spark est un framework rapide et facile à utiliser qui vous permet de résoudre une variété de problèmes de données complexes, qu'elles soient semi-structurées, structurées, en streaming, ou d'apprentissage automatique ou de science des données. Elle est également devenue l'une des plus grandes communautés open source dans le domaine du Big Data, avec plus de 1 000 contributeurs issus de plus de 250 organisations et plus de 300 000 membres de la communauté Spark Meetup dans plus de 570 sites à travers le monde.

Qu'est-ce qu'Apache Spark ?

Apache Spark est un puissant moteur de requêtes et de traitement distribué open source. Il offre la flexibilité et l'évolutivité de MapReduce mais à des vitesses nettement supérieures : il est 100 fois plus rapide qu'Apache Hadoop lorsque les données sont stockées en mémoire et jusqu'à 10 fois plus rapide lors de l'accès au disque.

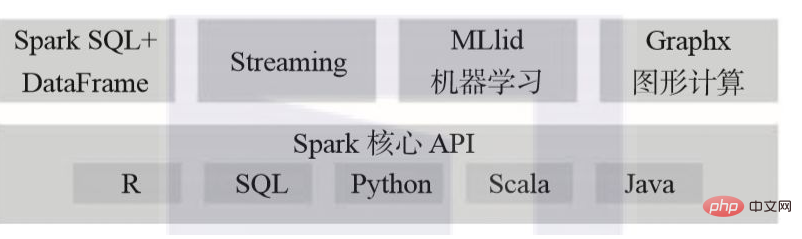

Apache Spark permet aux utilisateurs de lire, transformer, agréger des données, ainsi que de former et déployer facilement des modèles statistiques complexes. Java, Scala, Python, R et SQL ont tous accès à l'API Spark.

Apache Spark peut être utilisé pour créer des applications, soit conditionnées sous forme de bibliothèques à déployer sur un cluster, soit exécutées de manière interactive via des notebooks tels que Jupyter, Spark-Notebook, les notebooks Databricks et l'analyse rapide Apache Zeppelin.

Apache Spark fournit de nombreuses bibliothèques qui seront familières aux analystes de données, aux data scientists ou aux chercheurs ayant utilisé les pandas de Python ou les data.frame ou data.tables du langage R. Il est très important de noter que même si Spark DataFrame semble familier aux utilisateurs de pandas ou data.frame, data.tables, il existe encore quelques différences, alors n'en attendez pas trop. Les utilisateurs ayant plus d’expérience en SQL peuvent également utiliser le langage pour façonner leurs données.

De plus, Apache Spark fournit plusieurs algorithmes, modèles et frameworks statistiques déjà implémentés et réglés : MLlib et ML pour l'apprentissage automatique, GraphX et GraphFrames pour le traitement des graphiques et Spark Streaming (DStream et Structured). Spark permet aux utilisateurs de combiner librement ces bibliothèques dans la même application.

Apache Spark fonctionne facilement sur un ordinateur portable local et peut être facilement déployé en mode autonome sur un cluster local ou dans le cloud via YARN ou Apache Mesos. Il peut lire et écrire à partir de différentes sources de données, notamment (mais sans s'y limiter) HDFS, Apache Cassandra, Apache HBase et S3 :

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Que signifie Apache ?

Que signifie Apache ?

Logiciel de base de données couramment utilisé

Logiciel de base de données couramment utilisé

le démarrage d'Apache a échoué

le démarrage d'Apache a échoué

Logiciel de création de site internet

Logiciel de création de site internet

Comment vendre des pièces LUNA

Comment vendre des pièces LUNA

Processus d'achat et de vente de Bitcoin sur Huobi.com

Processus d'achat et de vente de Bitcoin sur Huobi.com

Le rôle du système d'exploitation Linux

Le rôle du système d'exploitation Linux

ASUS x402c

ASUS x402c

Quelle est la différence entre le blocage et la suppression sur WeChat ?

Quelle est la différence entre le blocage et la suppression sur WeChat ?