qu'est-ce que la collecte de données Apache Kafka

Qu'est-ce que la collecte de données Apache Kafka ?

Apache Kafka - Introduction

Apache Kafka est né sur LinkedIn et est ensuite devenu un projet Apache open source en 2011, puis est devenu un projet de premier ordre dans Apache en 2012. Kafka est écrit en Scala et Java. Apache Kafka est un système de messagerie tolérant aux pannes basé sur la publication et l'abonnement. Il est rapide, évolutif et distribué de par sa conception.

Ce tutoriel explorera les principes, l'installation, le fonctionnement de Kafka, puis présentera le déploiement du cluster Kafka. Enfin, nous conclurons avec les applications temps réel et l'intégration avec les technologies Big Data.

Avant de poursuivre ce tutoriel, vous devez avoir une bonne compréhension de Java, Scala, des systèmes de messagerie distribués et de l'environnement Linux.

Dans le big data, une grande quantité de données est utilisée. Concernant les données, nous sommes confrontés à deux défis principaux. Le premier défi est de savoir comment collecter de grandes quantités de données, et le deuxième défi consiste à analyser les données collectées. Pour surmonter ces défis, vous avez besoin d’un système de messagerie.

Kafka est conçu pour les systèmes distribués à haut débit. Kafka a tendance à bien fonctionner comme alternative aux courtiers de messagerie plus traditionnels. Comparé à d'autres systèmes de messagerie, Kafka offre un meilleur débit, un partitionnement intégré, une réplication et une tolérance aux pannes inhérente, ce qui le rend idéal pour les applications de traitement de messages à grande échelle.

Qu'est-ce qu'un système de messagerie ?

Le système de messagerie s'occupe du transfert des données d'une application à une autre, afin que les applications puissent se concentrer sur les données mais ne pas se soucier de la façon de les partager. La messagerie distribuée est basée sur le concept de files d'attente de messages fiables. Les messages sont mis en file d'attente de manière asynchrone entre l'application client et le système de messagerie. Deux types de modèles de messagerie sont disponibles : l'un est point à point et l'autre est un système de messagerie de publication-abonnement (pub-sub). La plupart des modèles de messagerie suivent le pub-sub.

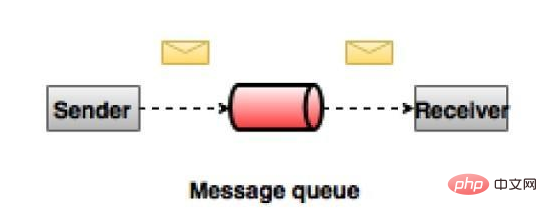

Système de messages peer-to-peer

Dans un système peer-to-peer, les messages resteront dans les files d'attente. Un ou plusieurs consommateurs peuvent consommer les messages de la file d'attente, mais un message spécifique ne peut être consommé que par un seul consommateur au maximum. Une fois qu'un consommateur lit un message dans une file d'attente, il disparaît de la file d'attente. Un exemple typique de ce système est un système de traitement des commandes, dans lequel chaque commande sera traitée par un seul processeur de commandes, mais plusieurs processeurs de commandes peuvent travailler simultanément. Le diagramme ci-dessous représente la structure.

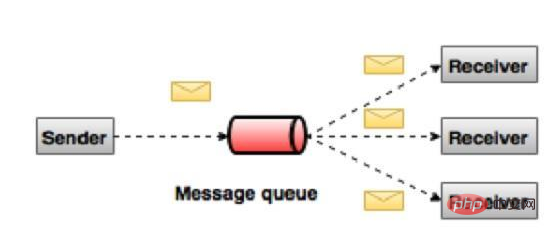

Système de messagerie de publication-abonnement

Dans un système de publication-abonnement, les messages resteront dans des sujets. Contrairement aux systèmes peer-to-peer, un consommateur peut s'abonner à un ou plusieurs sujets et consulter tous les messages de ce sujet. Dans le système de publication-abonnement, le générateur de messages est appelé l'éditeur et le consommateur du message est appelé l'abonné. Un exemple concret est Dish TV, qui publie différentes chaînes comme le sport, les films, la musique, etc. N'importe qui peut s'abonner à ses propres chaînes et obtenir ses chaînes par abonnement.

Qu'est-ce que Kafka ?

Apache Kafka est un système de messagerie de publication-abonnement distribué et une file d'attente puissante qui peut gérer de grandes quantités de données et vous permet de transmettre des messages d'un point de terminaison à un autre. Kafka convient à la consommation de messages hors ligne et en ligne. Les messages Kafka sont conservés sur le disque et répliqués au sein du cluster pour éviter la perte de données. Kafka est construit sur le service de synchronisation ZooKeeper. Il s'intègre parfaitement à Apache Storm et Spark pour diffuser l'analyse des données en temps réel.

Avantages Voici quelques avantages de Kafka -

Fiabilité - Kafka est distribué, partitionné, répliqué et tolérant aux pannes.

Évolutivité – Le système de messagerie Kafka évolue facilement, sans temps d'arrêt.

Durabilité - Kafka utilise un journal de validation distribué, ce qui signifie que les messages restent sur le disque le plus rapidement possible, ce qui le rend durable.

Performances : Kafka offre un débit élevé pour les messages de publication et d'abonnement. Il maintient des performances stables même lorsque plusieurs téraoctets de messages sont stockés.

Kafka est très rapide, garantissant zéro temps d'arrêt et zéro perte de données.

Cas d'utilisation

Kafka peut être utilisé pour de nombreux cas d'utilisation. Certains d'entre eux sont répertoriés ci-dessous -

Métriques - Kafka est souvent utilisé pour exécuter des données de surveillance. Cela implique l'agrégation des statistiques des applications distribuées pour produire un flux centralisé de données opérationnelles.

Solution d'agrégation de journaux : Kafka peut être utilisé dans une organisation pour collecter les journaux de plusieurs services et les transmettre à plusieurs serveurs dans un format standard.

Streaming - Frameworks populaires comme Storm et Spark

Le streaming lit les données d'un sujet, les traite et écrit les données traitées dans un nouveau sujet qui peut être utilisé par les utilisateurs et les applications. La forte durabilité de Kafka est également très utile dans le traitement des flux.

Kafka nécessite

Kafka est une plateforme unifiée pour traiter toutes les sources de données en temps réel. Kafka prend en charge la messagerie à faible latence et garantit la tolérance aux pannes en présence de pannes de machine. Il a la capacité de gérer un grand nombre de consommateurs différents. Kafka est très rapide, effectuant 2 millions d'écritures/seconde. Kafka conserve toutes les données sur le disque, ce qui signifie essentiellement que toutes les écritures sont transférées dans le cache des pages du système d'exploitation (RAM). Cela transfère les données du cache de page vers le socket Web de manière très efficace.

Pour plus de connaissances sur Apache, veuillez visiter la colonne Tutoriel d'utilisation d'Apache !

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment exécuter le projet H5

Apr 06, 2025 pm 12:21 PM

Comment exécuter le projet H5

Apr 06, 2025 pm 12:21 PM

L'exécution du projet H5 nécessite les étapes suivantes: Installation des outils nécessaires tels que le serveur Web, Node.js, les outils de développement, etc. Créez un environnement de développement, créez des dossiers de projet, initialisez les projets et écrivez du code. Démarrez le serveur de développement et exécutez la commande à l'aide de la ligne de commande. Aperçu du projet dans votre navigateur et entrez l'URL du serveur de développement. Publier des projets, optimiser le code, déployer des projets et configurer la configuration du serveur Web.

Comment régler le codage des caractères du côté serveur pour résoudre la table de bootstrap Briked

Apr 07, 2025 pm 12:00 PM

Comment régler le codage des caractères du côté serveur pour résoudre la table de bootstrap Briked

Apr 07, 2025 pm 12:00 PM

Pour définir l'encodage des caractères côté serveur pour résoudre la table de bootstrap brouillé, vous devez suivre les étapes suivantes: Vérifiez le codage des caractères du serveur; modifier le fichier de configuration du serveur; Définissez le codage des caractères sur UTF-8; Enregistrer et redémarrer le serveur; Vérifiez le codage.

Comment définir le répertoire CGI dans Apache

Apr 13, 2025 pm 01:18 PM

Comment définir le répertoire CGI dans Apache

Apr 13, 2025 pm 01:18 PM

Pour configurer un répertoire CGI dans Apache, vous devez effectuer les étapes suivantes: Créez un répertoire CGI tel que "CGI-Bin" et accorder des autorisations d'écriture Apache. Ajoutez le bloc directif "Scriptalias" dans le fichier de configuration Apache pour mapper le répertoire CGI à l'URL "/ cgi-bin". Redémarrez Apache.

Comment démarrer Apache

Apr 13, 2025 pm 01:06 PM

Comment démarrer Apache

Apr 13, 2025 pm 01:06 PM

Les étapes pour démarrer Apache sont les suivantes: Installez Apache (Commande: Sudo apt-get install Apache2 ou téléchargez-le à partir du site officiel) Start Apache (Linux: Sudo SystemCTL Démarrer Apache2; Windows: Cliquez avec le bouton droit sur le service "APACHE2.4" et SELECT ") Vérifiez si elle a été lancée (Linux: SUDO SYSTEMCTL STATURE APACHE2; (Facultatif, Linux: Sudo SystemCTL

Comment vérifier la configuration de Debian OpenSSL

Apr 12, 2025 pm 11:57 PM

Comment vérifier la configuration de Debian OpenSSL

Apr 12, 2025 pm 11:57 PM

Cet article présente plusieurs méthodes pour vérifier la configuration OpenSSL du système Debian pour vous aider à saisir rapidement l'état de sécurité du système. 1. Confirmez d'abord la version OpenSSL, vérifiez si OpenSSL a été installé et des informations de version. Entrez la commande suivante dans le terminal: si OpenSSLVersion n'est pas installée, le système invitera une erreur. 2. Affichez le fichier de configuration. Le fichier de configuration principal d'OpenSSL est généralement situé dans /etc/ssl/opensessl.cnf. Vous pouvez utiliser un éditeur de texte (tel que Nano) pour afficher: Sutonano / etc / ssl / openssl.cnf Ce fichier contient des informations de configuration importantes telles que la clé, le chemin de certificat et l'algorithme de chiffrement. 3. Utiliser OPE

Comment supprimer plus que les noms de serveurs d'Apache

Apr 13, 2025 pm 01:09 PM

Comment supprimer plus que les noms de serveurs d'Apache

Apr 13, 2025 pm 01:09 PM

Pour supprimer une directive de nom de serveur supplémentaire d'Apache, vous pouvez prendre les étapes suivantes: Identifier et supprimer la directive supplémentaire de serveur. Redémarrez Apache pour que les modifications prennent effet. Vérifiez le fichier de configuration pour vérifier les modifications. Testez le serveur pour vous assurer que le problème est résolu.

Comment utiliser les journaux Debian Apache pour améliorer les performances du site Web

Apr 12, 2025 pm 11:36 PM

Comment utiliser les journaux Debian Apache pour améliorer les performances du site Web

Apr 12, 2025 pm 11:36 PM

Cet article expliquera comment améliorer les performances du site Web en analysant les journaux Apache dans le système Debian. 1. Bases de l'analyse du journal APACH LOG enregistre les informations détaillées de toutes les demandes HTTP, y compris l'adresse IP, l'horodatage, l'URL de la demande, la méthode HTTP et le code de réponse. Dans Debian Systems, ces journaux sont généralement situés dans les répertoires /var/log/apache2/access.log et /var/log/apache2/error.log. Comprendre la structure du journal est la première étape d'une analyse efficace. 2.

Comment se connecter à la base de données d'Apache

Apr 13, 2025 pm 01:03 PM

Comment se connecter à la base de données d'Apache

Apr 13, 2025 pm 01:03 PM

Apache se connecte à une base de données nécessite les étapes suivantes: Installez le pilote de base de données. Configurez le fichier web.xml pour créer un pool de connexion. Créez une source de données JDBC et spécifiez les paramètres de connexion. Utilisez l'API JDBC pour accéder à la base de données à partir du code Java, y compris l'obtention de connexions, la création d'instructions, les paramètres de liaison, l'exécution de requêtes ou de mises à jour et de traitement des résultats.