Comment importer la mise en page du modèle CAO

Comment importer la mise en page du modèle CAO : ouvrez d'abord le logiciel et entrez dans l'espace de mise en page, puis dessinez les graphiques dans le modèle ; puis cliquez sur la mise en page en bas, double-cliquez sur l'espace vide dans le modèle ; disposition pour ajuster la taille et la position des graphiques ; enfin, double-cliquez sur la souris. Disposez l'espace vide à l'extérieur, confirmez l'espace et entraînez-vous à plusieurs reprises.

L'environnement d'exploitation de cet article : système Windows 7, version autocad2020, ordinateur Dell G3.

Comment importer la mise en page du modèle CAO :

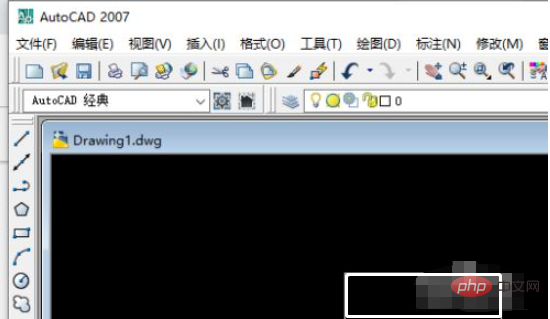

1. Ouvrez le logiciel AutoCAD2007 et entrez dans l'espace de mise en page du modèle.

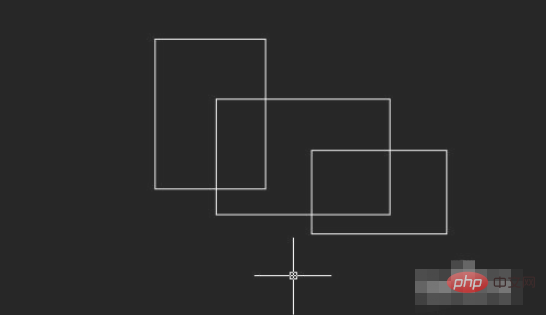

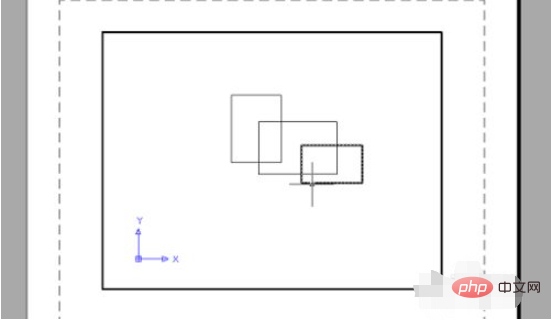

2. Dessinez ensuite les graphiques dans le modèle.

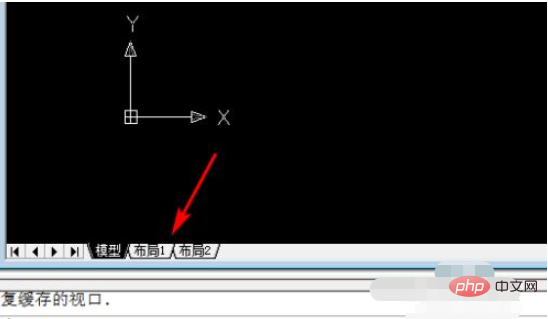

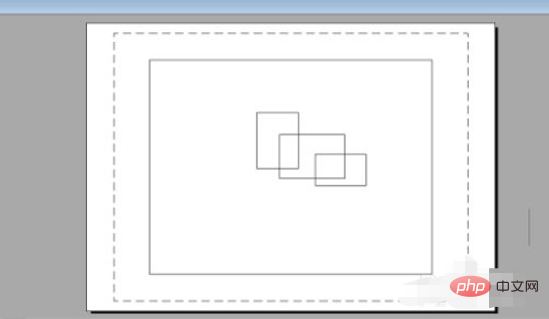

3. Cliquez sur la mise en page en bas et le système amènera les graphiques dans l'interface de mise en page.

4. Double-cliquez sur l'espace vide dans la mise en page pour ajuster la taille et la position du graphique.

5. Double-cliquez sur l'espace vide à l'extérieur de la mise en page, confirmez l'espace et répétez l'opération.

Recommandations vidéo associées : Programmation PHP de l'entrée à la maîtrise

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

À la pointe de la technologie logicielle, le groupe de l'UIUC Zhang Lingming, en collaboration avec des chercheurs de l'organisation BigCode, a récemment annoncé le modèle de grand code StarCoder2-15B-Instruct. Cette réalisation innovante a permis une percée significative dans les tâches de génération de code, dépassant avec succès CodeLlama-70B-Instruct et atteignant le sommet de la liste des performances de génération de code. Le caractère unique de StarCoder2-15B-Instruct réside dans sa stratégie d'auto-alignement pur. L'ensemble du processus de formation est ouvert, transparent et complètement autonome et contrôlable. Le modèle génère des milliers d'instructions via StarCoder2-15B en réponse au réglage fin du modèle de base StarCoder-15B sans recourir à des annotations manuelles coûteuses.

Yolov10 : explication détaillée, déploiement et application en un seul endroit !

Jun 07, 2024 pm 12:05 PM

Yolov10 : explication détaillée, déploiement et application en un seul endroit !

Jun 07, 2024 pm 12:05 PM

1. Introduction Au cours des dernières années, les YOLO sont devenus le paradigme dominant dans le domaine de la détection d'objets en temps réel en raison de leur équilibre efficace entre le coût de calcul et les performances de détection. Les chercheurs ont exploré la conception architecturale de YOLO, les objectifs d'optimisation, les stratégies d'expansion des données, etc., et ont réalisé des progrès significatifs. Dans le même temps, le recours à la suppression non maximale (NMS) pour le post-traitement entrave le déploiement de bout en bout de YOLO et affecte négativement la latence d'inférence. Dans les YOLO, la conception de divers composants manque d’une inspection complète et approfondie, ce qui entraîne une redondance informatique importante et limite les capacités du modèle. Il offre une efficacité sous-optimale et un potentiel d’amélioration des performances relativement important. Dans ce travail, l'objectif est d'améliorer encore les limites d'efficacité des performances de YOLO à la fois en post-traitement et en architecture de modèle. à cette fin

L'Université Tsinghua a pris le relais et YOLOv10 est sorti : les performances ont été grandement améliorées et il figurait sur la hot list de GitHub

Jun 06, 2024 pm 12:20 PM

L'Université Tsinghua a pris le relais et YOLOv10 est sorti : les performances ont été grandement améliorées et il figurait sur la hot list de GitHub

Jun 06, 2024 pm 12:20 PM

La série de référence YOLO de systèmes de détection de cibles a une fois de plus reçu une mise à niveau majeure. Depuis la sortie de YOLOv9 en février de cette année, le relais de la série YOLO (YouOnlyLookOnce) a été passé entre les mains de chercheurs de l'Université Tsinghua. Le week-end dernier, la nouvelle du lancement de YOLOv10 a attiré l'attention de la communauté IA. Il est considéré comme un cadre révolutionnaire dans le domaine de la vision par ordinateur et est connu pour ses capacités de détection d'objets de bout en bout en temps réel, poursuivant l'héritage de la série YOLO en fournissant une solution puissante alliant efficacité et précision. Adresse de l'article : https://arxiv.org/pdf/2405.14458 Adresse du projet : https://github.com/THU-MIG/yo

URL du site officiel de Binance Entrée du site officiel de Binance dernière entrée authentique

Dec 16, 2024 pm 06:15 PM

URL du site officiel de Binance Entrée du site officiel de Binance dernière entrée authentique

Dec 16, 2024 pm 06:15 PM

Cet article se concentre sur les dernières entrées authentiques sur le site officiel de Binance, y compris le site officiel de Binance Global, le site officiel américain et le site officiel de l'Académie. En outre, l'article fournit également des étapes d'accès détaillées, notamment l'utilisation d'un appareil de confiance, la saisie de l'URL correcte, la revérification de l'interface du site Web, la vérification du certificat du site Web, le contact du support client, etc., pour garantir un accès sûr et fiable à Binance. plate-forme.

Rapport technique Google Gemini 1.5 : prouvez facilement les questions de l'Olympiade mathématique, la version Flash est 5 fois plus rapide que GPT-4 Turbo

Jun 13, 2024 pm 01:52 PM

Rapport technique Google Gemini 1.5 : prouvez facilement les questions de l'Olympiade mathématique, la version Flash est 5 fois plus rapide que GPT-4 Turbo

Jun 13, 2024 pm 01:52 PM

En février de cette année, Google a lancé le grand modèle multimodal Gemini 1.5, qui a considérablement amélioré les performances et la vitesse grâce à l'ingénierie et à l'optimisation de l'infrastructure, à l'architecture MoE et à d'autres stratégies. Avec un contexte plus long, des capacités de raisonnement plus fortes et une meilleure gestion du contenu multimodal. Ce vendredi, Google DeepMind a officiellement publié le rapport technique de Gemini 1.5, qui couvre la version Flash et d'autres mises à jour récentes. Le document fait 153 pages. Lien du rapport technique : https://storage.googleapis.com/deepmind-media/gemini/gemini_v1_5_report.pdf Dans ce rapport, Google présente Gemini1

Revoir! Résumer de manière exhaustive le rôle important des modèles de base dans la promotion de la conduite autonome

Jun 11, 2024 pm 05:29 PM

Revoir! Résumer de manière exhaustive le rôle important des modèles de base dans la promotion de la conduite autonome

Jun 11, 2024 pm 05:29 PM

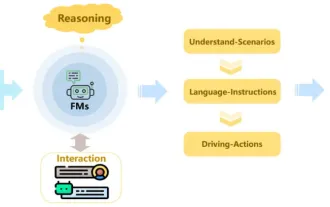

Écrit ci-dessus et compréhension personnelle de l'auteur : Récemment, avec le développement et les percées de la technologie d'apprentissage profond, les modèles de base à grande échelle (Foundation Models) ont obtenu des résultats significatifs dans les domaines du traitement du langage naturel et de la vision par ordinateur. L’application de modèles de base à la conduite autonome présente également de grandes perspectives de développement, susceptibles d’améliorer la compréhension et le raisonnement des scénarios. Grâce à une pré-formation sur un langage riche et des données visuelles, le modèle de base peut comprendre et interpréter divers éléments des scénarios de conduite autonome et effectuer un raisonnement, fournissant ainsi un langage et des commandes d'action pour piloter la prise de décision et la planification. Le modèle de base peut être constitué de données enrichies d'une compréhension du scénario de conduite afin de fournir les rares caractéristiques réalisables dans les distributions à longue traîne qui sont peu susceptibles d'être rencontrées lors d'une conduite de routine et d'une collecte de données.

Les différents ensembles de données ont-ils des lois d'échelle différentes ? Et vous pouvez le prédire avec un algorithme de compression

Jun 07, 2024 pm 05:51 PM

Les différents ensembles de données ont-ils des lois d'échelle différentes ? Et vous pouvez le prédire avec un algorithme de compression

Jun 07, 2024 pm 05:51 PM

De manière générale, plus il faut de calculs pour entraîner un réseau de neurones, meilleures sont ses performances. Lors de la mise à l'échelle d'un calcul, une décision doit être prise : augmenter le nombre de paramètres du modèle ou augmenter la taille de l'ensemble de données : deux facteurs qui doivent être pris en compte dans un budget de calcul fixe. L'avantage de l'augmentation du nombre de paramètres du modèle est que cela peut améliorer la complexité et la capacité d'expression du modèle, permettant ainsi de mieux ajuster les données d'entraînement. Cependant, un trop grand nombre de paramètres peut conduire à un surajustement, ce qui rend le modèle peu performant sur des données invisibles. D’un autre côté, l’augmentation de la taille de l’ensemble de données peut améliorer la capacité de généralisation du modèle et réduire les problèmes de surajustement. Laissez-nous vous le dire : tant que vous allouez les paramètres et les données de manière appropriée, vous pouvez maximiser les performances dans le cadre d'un budget informatique fixe. De nombreuses études antérieures ont exploré la mise à l'échelle des modèles de langage neuronal.

Le scandale des bombardements met en colère le directeur du Stanford AI Lab ! Deux membres de l'équipe de plagiat ont été blâmés et une personne a disparu, et son casier judiciaire a été dévoilé. Net-citoyens : re-comprendre le modèle open source chinois.

Jun 09, 2024 am 09:38 AM

Le scandale des bombardements met en colère le directeur du Stanford AI Lab ! Deux membres de l'équipe de plagiat ont été blâmés et une personne a disparu, et son casier judiciaire a été dévoilé. Net-citoyens : re-comprendre le modèle open source chinois.

Jun 09, 2024 am 09:38 AM

L'incident de l'équipe de Stanford plagiant un grand modèle de l'Université Tsinghua est survenu plus tard - l'équipe Llama3-V a admis le plagiat, et deux des étudiants de premier cycle de Stanford se sont même coupés d'un autre auteur. Les derniers tweets d’excuses ont été envoyés par SiddharthSharma et AkshGarg. Parmi eux, Mustafa Aljadery (Lao Mu en abrégé) de l'Université de Californie du Sud est accusé d'être le principal responsable de la faute et il a disparu depuis hier : Nous espérons que Lao Mu fera la première déclaration, mais nous avons été impossible de le contacter depuis hier. Siddharth, moi-même (Akshi) et Lao Mu avons sorti Llama3-V, et Lao Mu a écrit le code du projet. Siddharth et mon rôle est de l'aider à démarrer sur Medium et T