titres

titres

Jetez un œil aux différents septièmes recensements nationaux sous un angle technique ! !

Jetez un œil aux différents septièmes recensements nationaux sous un angle technique ! !

Jetez un œil aux différents septièmes recensements nationaux sous un angle technique ! !

Après avoir lu le septième bulletin de recensement, vous constaterez que l'ensemble du processus de travail est similaire au processus d'analyse des données dans les entreprises. Cet article examinera d'abord les points communs entre les deux, puis examinera sur quelles informations le « Recensement des sept personnes » devrait se concentrer en tant que praticien d'Internet.

Nous nous référons au « Septième Bulletin national de recensement » pour expliquer

.Innover dans le contenu et les méthodes de recensement. La méthode de collecte de données électronique est entièrement adoptée et les enquêteurs utilisent des équipements électroniques pour collecter et rapporter les données directement en temps réel ; Transformer et rapporter, correspondant à l'entreprise est

enterrer le point et rapporter

Comment comprendre le point enterré ? "Point" est en fait un certain emplacement sur l'application ou le site Web. Une fois que l'utilisateur a effectué une certaine action, les informations actuelles de l'utilisateur sont enregistrées. Une action peut consister à parcourir, cliquer, glisser, etc. Par exemple : dans une application de commerce électronique, lorsqu'un utilisateur clique sur le bouton de commande, l'heure, le montant, l'identifiant du produit, l'état du réseau mobile, le système d'exploitation mobile et d'autres informations sur la commande de l'utilisateur sont enregistrés. Il s'agit d'un point caché. Un lieu de sépulture peut enregistrer n'importe quelle information, mais il existe trois informations essentielles : l'heure, le lieu et la personne. L'heure est l'heure à laquelle le comportement se produit, qui est utilisée pour analyser le timing de l'utilisateur ; l'emplacement spécifique sur la page actuelle où le comportement s'est produit ; le caractère est l'identification de l'utilisateur, qui est généralement générée à l'aide des informations sur l'appareil provenant des téléphones mobiles et des PC. D'autres informations sont collectées de manière sélective en fonction des besoins de l'analyse des données.

Une fois les informations collectées, elles sont généralement signaléesau serveur de l'entreprise via la technologie en temps réel

pour une analyse ultérieure. Sur la base de ces points enfouis, nous pouvons analyser quel contenu l'utilisateur a consulté à quelle heure, sur quel contenu il a cliqué en dernier, combien de temps il a regardé le contenu cliqué, ce qu'il a finalement acheté, combien il a dépensé, etc., et analyser plus en détail le Quel est le contenu préféré de l'utilisateur et quel est son pouvoir d'achat, afin de pouvoir faire des recommandations personnalisées.Exploiter pleinement la technologie cloud Internet, les services cloud et les applications cloud pour compléter le traitement des données

Les frameworks de stockage et de calcul distribués peuvent être open source, comme Hadoop, Hive, Spark, etc., ou ils peuvent être auto-développés par les entreprises, comme MaxCompute d'Alibaba Cloud.En raison de la quantité relativement importante de données enfouies, il est nécessaire de stockage à long terme. Par conséquent, une fois les points enterrés d'une entreprise signalés, ils sont généralement stockés sur des supports de stockage distribués, et le travail d'analyse des données ultérieur est principalement traité à l'aide d'un cadre informatique distribué. Les services de stockage et de calcul distribués prennent actuellement principalement la forme de services cloud. Une entreprise pour laquelle je travaillais a initialement acheté ses propres serveurs pour créer des services distribués. Parce que les coûts d'exploitation et de maintenance étaient trop élevés et insupportables, elle a finalement migré vers Alibaba Cloud, ce qui a permis d'économiser une grande partie des coûts d'exploitation et de maintenance.

Gérer en toute sécurité la collecte, la transmission et le stockage des données du recensement conformément aux normes de protection du niveau trois de sécurité du réseau national pour assurer la sécurité des informations personnelles des citoyens

Dans l'entreprise, les informations confidentielles des utilisateurs, telles que le numéro d'identification, seront désensibilisées, c'est-à-dire que le numéro d'identification sera codé dans un identifiant unique, de sorte qu'il n'affecte ni l'utilisation ni divulgue des informations privées.Cette partie dit

Protection des informations personnelles

En plus de la désensibilisation, il est également nécessaire de classer la confidentialité des données et d'établir un mécanisme d'examen des autorités correspondant. Le niveau de données confidentielles utilisé doit être appliqué pour les autorisations correspondantes et enregistré afin que les fuites d'informations puissent être retracées.

Les agences de recensement à tous les niveaux appliquent strictement les exigences de contrôle de qualité et effectuent soigneusement une inspection de qualité pour garantir la qualité du travail à toutes les étapes du recensement

. Dans une entreprise, le contrôle de la qualité des points enterrés est également un élément clé. Si les points enterrés signalés sont tous erronés et ne peuvent pas être utilisés, cela n'a évidemment aucun sens.Cette partie parle de

suivi de la qualité des données

Les entreprises surveillent généralement la qualité des points enterrés à travers deux aspects. Premièrement, vérifier les points enterrés individuels, vérifier si le format de chaque champ des points enterrés signalés est correct, surveiller le taux de valeur nulle des champs centraux, etc. . Deuxièmement, surveillez le trafic et déterminez s'il existe des anomalies dans l'ampleur des points enterrés signalés grâce à une comparaison d'une année sur l'autre.

Le septième recensement national a étudié de manière approfondie le nombre, la structure, la répartition et d'autres aspects de la population de mon pays, et a saisi les caractéristiques tendancielles des changements démographiques. Il vise à améliorer la stratégie de développement démographique et le système politique de mon pays. et sa formulation fournit un support d'informations statistiques précises pour la planification du développement économique et social et la promotion d'un développement économique de haute qualité.

que nous connaissons bien en entreprise, il s'agit d'analyser le comportement des utilisateurs, d'obtenir des conclusions précieuses et de fournir une aide à la décision pour l'itération de. l'application ou le site Web.Cette partie est l'

analyse des données

L'analyse des données est généralement divisée en deux parties. Une partie est l'analyse numérique, qui peut être de simples statistiques numériques, ou vous pouvez utiliser l'apprentissage automatique Python pour l'ajustement, la classification, etc. Lorsque la quantité de données est importante, les frameworks informatiques distribués Hadoop et Spark seront utilisés. L’autre partie est l’analyse de texte, qui utilise davantage de méthodes d’apprentissage automatique et d’apprentissage profond pour extraire des éléments qui ne peuvent pas être vus par l’analyse numérique.

Permettez-moi également d'ajouter quelque chose. L'âge, le sexe, l'éducation et d'autres informations que nous voyons dans le recensement sont généralement appelés portraits d'utilisateurs dans les entreprises. Ces informations ne peuvent pas être collectées via des points enfouis, mais ce sont des données très importantes pour les entreprises. Elles doivent souvent être combinées avec le comportement des utilisateurs et prédites à l'aide d'algorithmes d'apprentissage automatique et d'apprentissage profond.

C'est la fin de la première partie. Nous avons pris le recensement comme exemple pour présenter le processus d'analyse des données d'entreprise et les technologies impliquées. Parlons brièvement des aspects auxquels nous devrions prêter attention en tant que praticiens d’Internet.

La qualité de la population continue de s'améliorer et de nouveaux avantages liés aux dividendes des talents apparaîtront progressivement. Dans le même temps, la pression sur l'emploi des étudiants augmente et le rythme de la transformation et de la modernisation industrielles doit être accéléré.

La population des cols blancs est excédentaire depuis longtemps et l'involution de 996 continuera d'être intense. Par conséquent, le coût des talents des entreprises de haute technologie a été réduit et le « talent ». l'avantage du dividende est progressivement apparu.

Pour devenir forgeron, vous devez travailler dur et améliorer continuellement vos véritables compétences et votre apprentissage.

L'agglomération accélérée de la population reflète non seulement les changements de tendance dans l'urbanisation et l'agglomération économique, mais met également en avant de nouvelles exigences pour améliorer la qualité de l'urbanisation et promouvoir un développement régional coordonné.

L'afflux de population vers les grandes villes s'accélère, et la perte de population dans les zones rurales s'accélère.

Le processus d’urbanisation de la Chine n’est pas encore terminé. Pour les étudiants qui n’ont pas encore obtenu leur diplôme, choisir des villes de premier rang et de nouvelles villes de premier rang est un choix judicieux. Pour les travailleurs migrants qui vivent déjà dans les grandes villes, acheter une maison dans un emplacement central est un choix judicieux.

La proportion de personnes âgées augmente rapidement et le vieillissement est devenu la condition nationale fondamentale de notre pays à l'avenir. Dans le même temps, l'augmentation de la population âgée apportera également de la sagesse, de l'héritage, de la performance et une expansion de la demande.

Soyez prêt à retarder la retraite. Il semble que vous deviez considérer non seulement la crise de la quarantaine, mais aussi la crise de la vieillesse.

Aucune entreprise ne restera inactive et analysera un tas de données inutiles à longueur de journée. Il en va de même pour le recensement. Trouver les informations qui vous sont utiles et découvrir comment aborder l'avenir est ce que chacun devrait faire le plus.

Recommandations associées :

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Lisez des fichiers CSV et effectuez une analyse de données à l'aide de pandas

Jan 09, 2024 am 09:26 AM

Lisez des fichiers CSV et effectuez une analyse de données à l'aide de pandas

Jan 09, 2024 am 09:26 AM

Pandas est un puissant outil d'analyse de données qui peut facilement lire et traiter différents types de fichiers de données. Parmi eux, les fichiers CSV sont l’un des formats de fichiers de données les plus courants et les plus utilisés. Cet article expliquera comment utiliser Pandas pour lire des fichiers CSV et effectuer une analyse de données, et fournira des exemples de code spécifiques. 1. Importez les bibliothèques nécessaires Tout d'abord, nous devons importer la bibliothèque Pandas et les autres bibliothèques associées qui peuvent être nécessaires, comme indiqué ci-dessous : importpandasaspd 2. Lisez le fichier CSV à l'aide de Pan

Introduction aux méthodes d'analyse des données

Jan 08, 2024 am 10:22 AM

Introduction aux méthodes d'analyse des données

Jan 08, 2024 am 10:22 AM

Méthodes courantes d'analyse des données : 1. Méthode d'analyse comparative ; 2. Méthode d'analyse structurelle ; 3. Méthode d'analyse croisée ; 5. Méthode d'analyse des causes et des effets ; , Méthode d'analyse en composantes principales ; 9. Méthode d'analyse de dispersion ; 10. Méthode d'analyse matricielle. Introduction détaillée : 1. Méthode d'analyse comparative : Analyse comparative de deux ou plusieurs données pour trouver les différences et les modèles ; 2. Méthode d'analyse structurelle : Une méthode d'analyse comparative entre chaque partie de l'ensemble et l'ensemble. , etc.

Comment créer une application d'analyse de données rapide à l'aide de React et Google BigQuery

Sep 26, 2023 pm 06:12 PM

Comment créer une application d'analyse de données rapide à l'aide de React et Google BigQuery

Sep 26, 2023 pm 06:12 PM

Comment utiliser React et Google BigQuery pour créer des applications d'analyse de données rapides Introduction : À l'ère actuelle d'explosion de l'information, l'analyse des données est devenue un maillon indispensable dans diverses industries. Parmi eux, créer des applications d’analyse de données rapides et efficaces est devenu l’objectif poursuivi par de nombreuses entreprises et particuliers. Cet article explique comment utiliser React et Google BigQuery pour créer une application d'analyse rapide des données et fournit des exemples de code détaillés. 1. Présentation React est un outil pour créer

11 distributions de base que les data scientists utilisent 95 % du temps

Dec 15, 2023 am 08:21 AM

11 distributions de base que les data scientists utilisent 95 % du temps

Dec 15, 2023 am 08:21 AM

Suite au dernier inventaire des « 11 graphiques de base que les data scientists utilisent 95 % du temps », nous vous présenterons aujourd'hui 11 distributions de base que les data scientists utilisent 95 % du temps. La maîtrise de ces distributions nous aide à comprendre plus profondément la nature des données et à faire des inférences et des prédictions plus précises lors de l'analyse des données et de la prise de décision. 1. Distribution normale La distribution normale, également connue sous le nom de distribution gaussienne, est une distribution de probabilité continue. Il présente une courbe symétrique en forme de cloche avec la moyenne (μ) comme centre et l'écart type (σ) comme largeur. La distribution normale a une valeur d'application importante dans de nombreux domaines tels que les statistiques, la théorie des probabilités et l'ingénierie.

Apprentissage automatique et analyse de données à l'aide du langage Go

Nov 30, 2023 am 08:44 AM

Apprentissage automatique et analyse de données à l'aide du langage Go

Nov 30, 2023 am 08:44 AM

Dans la société intelligente d’aujourd’hui, l’apprentissage automatique et l’analyse des données sont des outils indispensables qui peuvent aider les individus à mieux comprendre et utiliser de grandes quantités de données. Dans ces domaines, le langage Go est également devenu un langage de programmation qui a beaucoup retenu l'attention. Sa rapidité et son efficacité en font le choix de nombreux programmeurs. Cet article explique comment utiliser le langage Go pour l'apprentissage automatique et l'analyse de données. 1. L'écosystème du langage Go d'apprentissage automatique n'est pas aussi riche que Python et R. Cependant, à mesure que de plus en plus de personnes commencent à l'utiliser, certaines bibliothèques et frameworks d'apprentissage automatique

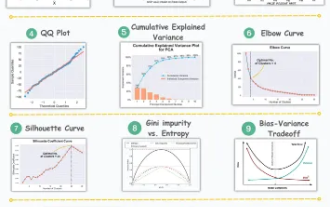

11 visualisations avancées pour l'analyse des données et l'apprentissage automatique

Oct 25, 2023 am 08:13 AM

11 visualisations avancées pour l'analyse des données et l'apprentissage automatique

Oct 25, 2023 am 08:13 AM

La visualisation est un outil puissant pour communiquer des modèles et des relations de données complexes de manière intuitive et compréhensible. Ils jouent un rôle essentiel dans l’analyse des données, fournissant des informations souvent difficiles à discerner à partir de données brutes ou de représentations numériques traditionnelles. La visualisation est cruciale pour comprendre les modèles et les relations de données complexes, et nous présenterons les 11 graphiques les plus importants et incontournables qui aident à révéler les informations contenues dans les données et à rendre les données complexes plus compréhensibles et significatives. 1. KSPlotKSPlot est utilisé pour évaluer les différences de distribution. L'idée principale est de mesurer la distance maximale entre les fonctions de distribution cumulatives (CDF) de deux distributions. Plus la distance maximale est petite, plus ils appartiennent probablement à la même distribution. Par conséquent, il est principalement interprété comme un « système » permettant de déterminer les différences de distribution.

Comment utiliser les interfaces ECharts et PHP pour mettre en œuvre l'analyse des données et la prédiction de graphiques statistiques

Dec 17, 2023 am 10:26 AM

Comment utiliser les interfaces ECharts et PHP pour mettre en œuvre l'analyse des données et la prédiction de graphiques statistiques

Dec 17, 2023 am 10:26 AM

Comment utiliser les interfaces ECharts et PHP pour mettre en œuvre l'analyse des données et la prédiction des graphiques statistiques. L'analyse et la prédiction des données jouent un rôle important dans divers domaines. Elles peuvent nous aider à comprendre les tendances et les modèles de données et fournir des références pour les décisions futures. ECharts est une bibliothèque de visualisation de données open source qui fournit des composants graphiques riches et flexibles capables de charger et de traiter dynamiquement des données à l'aide de l'interface PHP. Cet article présentera la méthode de mise en œuvre de l'analyse et de la prédiction des données de graphiques statistiques basée sur ECharts et l'interface PHP, et fournira

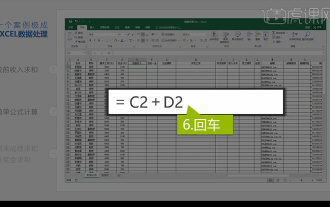

Analyse de données Excel intégrée

Mar 21, 2024 am 08:21 AM

Analyse de données Excel intégrée

Mar 21, 2024 am 08:21 AM

1. Dans cette leçon, nous expliquerons l'analyse intégrée des données Excel. Nous la compléterons à travers un cas. Ouvrez le support de cours et cliquez sur la cellule E2 pour saisir la formule. 2. Nous sélectionnons ensuite la cellule E53 pour calculer toutes les données suivantes. 3. Ensuite, nous cliquons sur la cellule F2, puis nous entrons la formule pour la calculer. De même, en faisant glisser vers le bas, nous pouvons calculer la valeur souhaitée. 4. Nous sélectionnons la cellule G2, cliquons sur l'onglet Données, cliquez sur Validation des données, sélectionnons et confirmons. 5. Utilisons la même méthode pour remplir automatiquement les cellules ci-dessous qui doivent être calculées. 6. Ensuite, nous calculons le salaire réel et sélectionnons la cellule H2 pour saisir la formule. 7. Ensuite, nous cliquons sur le menu déroulant des valeurs pour cliquer sur d'autres nombres.