Présenter comment installer Kafka et Zookeeper

Cet article est écrit par la rubrique tutoriel go Language pour présenter comment installer Kafka et Zookeeper. J'espère qu'il sera utile aux amis dans le besoin !

Installation de Kafka et Zookeeper

Ecrire compose

zookeeper:

image: wurstmeister/zookeeper

ports:

- "2181:2181"

kafka:

image: wurstmeister/kafka

volumes:

- ./data/etc/localtime:/etc/localtime

- ./data/var/run/docker.sock:/var/run/docker.sock

ports:

- "9092:9092"

environment:

KAFKA_ADVERTISED_HOST_NAME: 192.168.110.147 ## 宿主机IP

KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181

KAFKA_ADVERTISED_PORT: 9092

kafka-manager:

image: sheepkiller/kafka-manager

environment:

ZK_HOSTS: 192.168.110.147 ## zookeeper地址

ports:

- "9091:9000" # 宿主机port:container_portDémarrer l'installation

luwei@luweideMacBook-Pro-2 lnmp % docker-compose up -d zookeeper Pulling zookeeper (wurstmeister/zookeeper:)... latest: Pulling from wurstmeister/zookeeper a3ed95caeb02: Pull complete ef38b711a50f: Pull complete e057c74597c7: Pull complete 666c214f6385: Pull complete c3d6a96f1ffc: Pull complete 3fe26a83e0ca: Pull complete 3d3a7dd3a3b1: Pull complete f8cc938abe5f: Pull complete 9978b75f7a58: Pull complete 4d4dbcc8f8cc: Pull complete 8b130a9baa49: Pull complete 6b9611650a73: Pull complete 5df5aac51927: Pull complete 76eea4448d9b: Pull complete 8b66990876c6: Pull complete f0dd38204b6f: Pull complete Digest: sha256:7a7fd44a72104bfbd24a77844bad5fabc86485b036f988ea927d1780782a6680 Status: Downloaded newer image for wurstmeister/zookeeper:latest Creating lnmp_zookeeper_1 ... done luwei@luweideMacBook-Pro-2 lnmp % docker-compose up -d kafka lnmp_kafka_1 is up-to-date luwei@luweideMacBook-Pro-2 lnmp % docker-compose up -d kafka Starting lnmp_kafka_1 ... done

Voir les résultats de l'installation

luwei@luweideMacBook-Pro-2 ~ % docker ps CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 28a2a3b33856 sheepkiller/kafka-manager "./start-kafka-manag…" 3 minutes ago Up 3 minutes 0.0.0.0:9091->9000/tcp lnmp_kafka-manager_1 d6ae300116f3 wurstmeister/zookeeper "/bin/sh -c '/usr/sb…" 9 minutes ago Up 8 minutes 22/tcp, 2888/tcp, 3888/tcp, 0.0.0.0:2181->2181/tcp lnmp_zookeeper_1 c9de041d5ace wurstmeister/kafka "start-kafka.sh" 15 minutes ago Up 4 seconds 0.0.0.0:9092->9092/tcp lnmp_kafka_1 92b5e1563062 mysql:5.7.16 "docker-entrypoint.s…" 2 weeks ago Up 6 hours 0.0.0.0:3307->3306/tcp my_mysql57 29f0b85f1284 registry.cn-hangzhou.aliyuncs.com/helowin/oracle_11g "/bin/sh -c '/home/o…" 3 weeks ago Up 6 hours 0.0.0.0:1521->1521/tcp oracle 89c169b8bd14 nginx:alpine "/docker-entrypoint.…" 4 weeks ago Up 6 hours (healthy) 0.0.0.0:81->80/tcp, 0.0.0.0:444->443/tcp nginx e0e4fa4bf177 lnmp_php72 "entrypoint php-fpm" 4 weeks ago Up 6 hours (healthy) 9000-9001/tcp php72 a1ddf67627cd lnmp_php56 "entrypoint php-fpm" 4 weeks ago Up 6 hours (healthy) 9000/tcp php56 324aa6c8b071 lnmp_php71 "entrypoint php-fpm" 4 weeks ago Up 6 hours (healthy) 9000/tcp php71 4fd5d2ce7612 mongo:4.4.0 "docker-entrypoint.s…" 4 weeks ago Up 6 hours 0.0.0.0:27018->27017/tcp mongo4.4 f212f81e0546 redis:4-alpine "docker-entrypoint.s…" 4 weeks ago Up 6 hours (healthy) 0.0.0.0:6379->6379/tcp redis e42962aa16c8 mysql:5.6 "docker-entrypoint.s…" 4 weeks ago Restarting (137) 50 seconds ago mysql luwei@luweideMacBook-Pro-2 ~ %

Connecter le conteneur kafka

luwei@luweideMacBook-Pro-2 ~ % docker exec -it lnmp_kafka_1 /bin/bash bash-5.1#

Créer un sujet

bash-5.1# find / -name kafka-topics.sh /opt/kafka_2.13-2.7.1/bin/kafka-topics.sh bash-5.1# /opt/kafka_2.13-2.7.1/bin/kafka-topics.sh --create --zookeeper 192.168.110.147:2181 --replication-factor 1 --partitions 1 --topic test Created topic test. bash-5.1#

Voir le sujet créé

bash-5.1# /opt/kafka_2.13-2.7.1/bin/kafka-topics.sh --list --zookeeper 192.168.110.147:2181 test bash-5.1#

Démarrez le producteur

bash-5.1# find / -name kafka-console-producer.sh

/opt/kafka_2.13-2.7.1/bin/kafka-console-producer.sh

bash-5.1# /opt/kafka_2.13-2.7.1/bin/kafka-console-producer.sh --broker-list 192.168.110.147:9092 --topic mykafka

>hello donglei

[2021-11-22 08:05:19,506] WARN [Producer clientId=console-producer] Error while fetching metadata with correlation id 3 : {mykafka=LEADER_NOT_AVAILABLE} (org.apache.kafka.clients.NetworkClient)

>Démarrer le consommateur

bash-5.1# /opt/kafka_2.13-2.7.1/bin/kafka-console-consumer.sh --bootstrap-server 192.168.110.147:9092 --topic mykafka --from-beginning hello donglei

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment mettre en œuvre une analyse boursière en temps réel à l'aide de PHP et Kafka

Jun 28, 2023 am 10:04 AM

Comment mettre en œuvre une analyse boursière en temps réel à l'aide de PHP et Kafka

Jun 28, 2023 am 10:04 AM

Avec le développement d’Internet et de la technologie, l’investissement numérique est devenu un sujet de préoccupation croissant. De nombreux investisseurs continuent d’explorer et d’étudier des stratégies d’investissement, dans l’espoir d’obtenir un retour sur investissement plus élevé. Dans le domaine du trading d'actions, l'analyse boursière en temps réel est très importante pour la prise de décision, et l'utilisation de la file d'attente de messages en temps réel Kafka et de la technologie PHP constitue un moyen efficace et pratique. 1. Introduction à Kafka Kafka est un système de messagerie distribué de publication et d'abonnement à haut débit développé par LinkedIn. Les principales fonctionnalités de Kafka sont

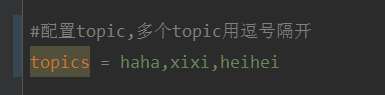

Comment spécifier dynamiquement plusieurs sujets à l'aide de @KafkaListener dans springboot+kafka

May 20, 2023 pm 08:58 PM

Comment spécifier dynamiquement plusieurs sujets à l'aide de @KafkaListener dans springboot+kafka

May 20, 2023 pm 08:58 PM

Expliquez que ce projet est un projet d'intégration springboot+kafak, il utilise donc l'annotation de consommation kafak @KafkaListener dans springboot. Tout d'abord, configurez plusieurs sujets séparés par des virgules dans application.properties. Méthode : utilisez l'expression SpEl de Spring pour configurer les sujets comme : @KafkaListener(topics="#{’${topics}’.split(’,’)}") pour exécuter le programme. L'effet d'impression de la console est le suivant.

Utilisation de ZooKeeper pour le traitement des verrous distribués dans le développement d'API Java

Jun 17, 2023 pm 10:36 PM

Utilisation de ZooKeeper pour le traitement des verrous distribués dans le développement d'API Java

Jun 17, 2023 pm 10:36 PM

À mesure que les applications modernes continuent d’évoluer et que le besoin de haute disponibilité et de simultanéité augmente, les architectures de systèmes distribués deviennent de plus en plus courantes. Dans un système distribué, plusieurs processus ou nœuds s'exécutent en même temps et accomplissent des tâches ensemble, et la synchronisation entre les processus devient particulièrement importante. Étant donné que de nombreux nœuds d'un environnement distribué peuvent accéder simultanément à des ressources partagées, la manière de gérer les problèmes de concurrence et de synchronisation est devenue une tâche importante dans un système distribué. À cet égard, ZooKeeper est devenu une solution très populaire. ZooKee

Comment créer des applications de traitement de données en temps réel à l'aide de React et Apache Kafka

Sep 27, 2023 pm 02:25 PM

Comment créer des applications de traitement de données en temps réel à l'aide de React et Apache Kafka

Sep 27, 2023 pm 02:25 PM

Comment utiliser React et Apache Kafka pour créer des applications de traitement de données en temps réel Introduction : Avec l'essor du Big Data et du traitement de données en temps réel, la création d'applications de traitement de données en temps réel est devenue la priorité de nombreux développeurs. La combinaison de React, un framework front-end populaire, et d'Apache Kafka, un système de messagerie distribué hautes performances, peut nous aider à créer des applications de traitement de données en temps réel. Cet article expliquera comment utiliser React et Apache Kafka pour créer des applications de traitement de données en temps réel, et

Cinq sélections d'outils de visualisation pour explorer Kafka

Feb 01, 2024 am 08:03 AM

Cinq sélections d'outils de visualisation pour explorer Kafka

Feb 01, 2024 am 08:03 AM

Cinq options pour les outils de visualisation Kafka ApacheKafka est une plateforme de traitement de flux distribué capable de traiter de grandes quantités de données en temps réel. Il est largement utilisé pour créer des pipelines de données en temps réel, des files d'attente de messages et des applications basées sur des événements. Les outils de visualisation de Kafka peuvent aider les utilisateurs à surveiller et gérer les clusters Kafka et à mieux comprendre les flux de données Kafka. Ce qui suit est une introduction à cinq outils de visualisation Kafka populaires : ConfluentControlCenterConfluent

Analyse comparative des outils de visualisation kafka : Comment choisir l'outil le plus approprié ?

Jan 05, 2024 pm 12:15 PM

Analyse comparative des outils de visualisation kafka : Comment choisir l'outil le plus approprié ?

Jan 05, 2024 pm 12:15 PM

Comment choisir le bon outil de visualisation Kafka ? Analyse comparative de cinq outils Introduction : Kafka est un système de file d'attente de messages distribué à haute performance et à haut débit, largement utilisé dans le domaine du Big Data. Avec la popularité de Kafka, de plus en plus d'entreprises et de développeurs ont besoin d'un outil visuel pour surveiller et gérer facilement les clusters Kafka. Cet article présentera cinq outils de visualisation Kafka couramment utilisés et comparera leurs caractéristiques et fonctions pour aider les lecteurs à choisir l'outil qui répond à leurs besoins. 1. KafkaManager

Utilisation de ZooKeeper et Curator pour la coordination et la gestion distribuées dans Beego

Jun 22, 2023 pm 09:27 PM

Utilisation de ZooKeeper et Curator pour la coordination et la gestion distribuées dans Beego

Jun 22, 2023 pm 09:27 PM

Avec le développement rapide d'Internet, les systèmes distribués sont devenus l'une des infrastructures de nombreuses entreprises et organisations. Pour qu’un système distribué fonctionne correctement, il doit être coordonné et géré. À cet égard, ZooKeeper et Curator sont deux outils qui valent la peine d'être utilisés. ZooKeeper est un service de coordination distribué très populaire qui peut nous aider à coordonner l'état et les données entre les nœuds d'un cluster. Curator est une encapsulation de ZooKeeper

La pratique du go-zero et Kafka+Avro : construire un système de traitement de données interactif performant

Jun 23, 2023 am 09:04 AM

La pratique du go-zero et Kafka+Avro : construire un système de traitement de données interactif performant

Jun 23, 2023 am 09:04 AM

Ces dernières années, avec l'essor du Big Data et des communautés open source actives, de plus en plus d'entreprises ont commencé à rechercher des systèmes de traitement de données interactifs hautes performances pour répondre aux besoins croissants en matière de données. Dans cette vague de mises à niveau technologiques, le go-zero et Kafka+Avro suscitent l’attention et sont adoptés par de plus en plus d’entreprises. go-zero est un framework de microservices développé sur la base du langage Golang. Il présente les caractéristiques de hautes performances, de facilité d'utilisation, d'extension facile et de maintenance facile. Il est conçu pour aider les entreprises à créer rapidement des systèmes d'applications de microservices efficaces. sa croissance rapide