Opération et maintenance

Opération et maintenance

Apache

Apache

Parlons de la façon d'analyser les données Apache Avro (explication avec exemples)

Parlons de la façon d'analyser les données Apache Avro (explication avec exemples)

Parlons de la façon d'analyser les données Apache Avro (explication avec exemples)

Comment analyser les données Apache Avro ? Cet article vous présentera les méthodes de sérialisation pour générer des données Avro, de désérialisation pour analyser les données Avro et d'utilisation de FlinkSQL pour analyser les données Avro. J'espère que cela vous sera utile !

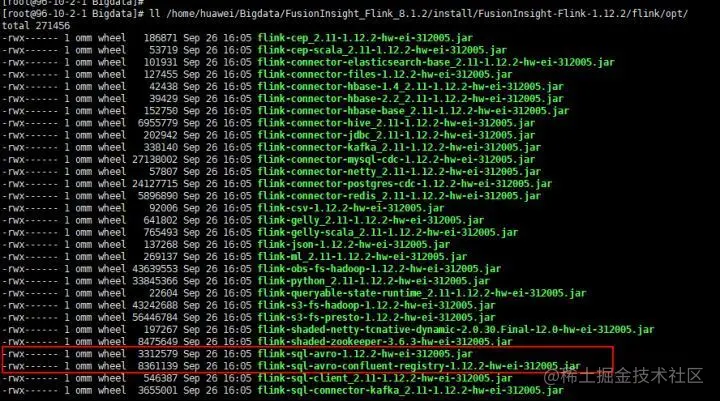

Avec le développement rapide d'Internet, les technologies de pointe telles que le cloud computing, le big data, l'intelligence artificielle et l'Internet des objets sont devenues des technologies de haute technologie courantes à l'ère d'aujourd'hui, comme les sites Web de commerce électronique. , la reconnaissance faciale, les voitures sans conducteur et les téléphones intelligents. Les maisons, les villes intelligentes, etc. facilitent non seulement l'alimentation, l'habillement, le logement et le transport des gens, mais derrière eux se trouve une grande quantité de données qui sont collectées, effacées et analysées par diverses plates-formes système à tout moment, garantissant une faible latence et une qualité de données élevée. Le débit et la sécurité sont particulièrement importants. Apache Avro lui-même est sérialisé via Schema pour la transmission binaire, d'une part, et d'autre part. d'autre part, il garantit la sécurité des données. Avro est actuellement de plus en plus utilisé dans diverses industries, plus il est étendu, plus il est important de traiter et d'analyser les données avro. Cet article montrera comment générer des données avro via la sérialisation et. utilisez FlinkSQL pour l'analyse.

Cet article est une démonstration de l'analyse avro. Actuellement, FlinkSQL ne convient qu'à l'analyse de données avro simples. Les données avro imbriquées complexes ne sont pas prises en charge pour le moment.

Introduction à la scène

Cet article présente principalement les trois contenus clés suivants :

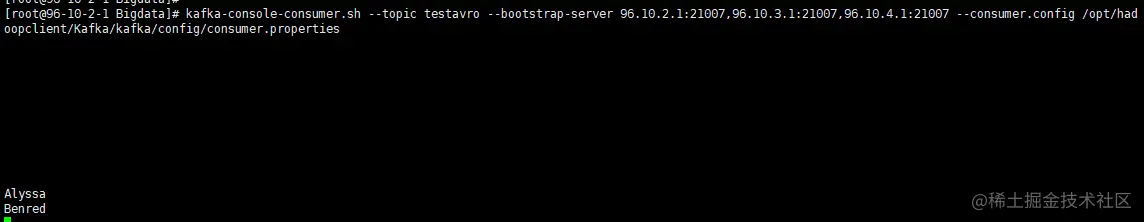

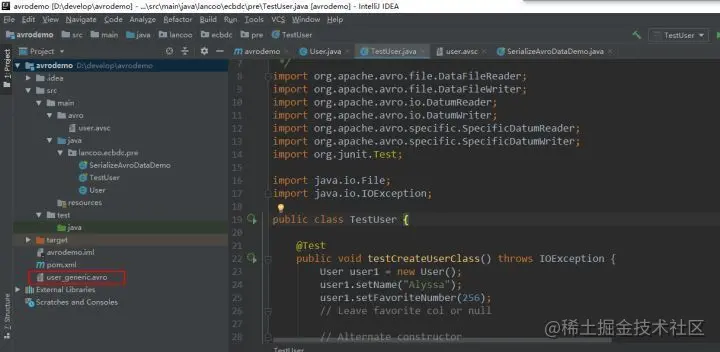

Comment sérialiser et générer des données Avro

Comment désérialiser et analyser les données Avro

Comment utiliser FlinkSQL pour analyser les données Avro

Prérequis

Pour comprendre ce qu'est avro, vous pouvez vous référer au guide de démarrage rapide du site officiel d'Apache avro

Comprendre les scénarios d'application avro

Étapes de fonctionnement

1. Créer un nouveau maven avro. projetez et configurez les dépendances pom

Le contenu du fichier pom est le suivant :

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>com.huawei.bigdata</groupId>

<artifactId>avrodemo</artifactId>

<version>1.0-SNAPSHOT</version>

<dependencies>

<dependency>

<groupId>org.apache.avro</groupId>

<artifactId>avro</artifactId>

<version>1.8.1</version>

</dependency>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.12</version>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<groupId>org.apache.avro</groupId>

<artifactId>avro-maven-plugin</artifactId>

<version>1.8.1</version>

<executions>

<execution>

<phase>generate-sources</phase>

<goals>

<goal>schema</goal>

</goals>

<configuration>

<sourceDirectory>${project.basedir}/src/main/avro/</sourceDirectory>

<outputDirectory>${project.basedir}/src/main/java/</outputDirectory>

</configuration>

</execution>

</executions>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<configuration>

<source>1.6</source>

<target>1.6</target>

</configuration>

</plugin>

</plugins>

</build>

</project>Remarque : Le fichier pom ci-dessus est configuré avec le chemin d'accès à la classe générée automatiquement, c'est-à-dire b

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Comment définir le répertoire CGI dans Apache

Apr 13, 2025 pm 01:18 PM

Comment définir le répertoire CGI dans Apache

Apr 13, 2025 pm 01:18 PM

Pour configurer un répertoire CGI dans Apache, vous devez effectuer les étapes suivantes: Créez un répertoire CGI tel que "CGI-Bin" et accorder des autorisations d'écriture Apache. Ajoutez le bloc directif "Scriptalias" dans le fichier de configuration Apache pour mapper le répertoire CGI à l'URL "/ cgi-bin". Redémarrez Apache.

Comment se connecter à la base de données d'Apache

Apr 13, 2025 pm 01:03 PM

Comment se connecter à la base de données d'Apache

Apr 13, 2025 pm 01:03 PM

Apache se connecte à une base de données nécessite les étapes suivantes: Installez le pilote de base de données. Configurez le fichier web.xml pour créer un pool de connexion. Créez une source de données JDBC et spécifiez les paramètres de connexion. Utilisez l'API JDBC pour accéder à la base de données à partir du code Java, y compris l'obtention de connexions, la création d'instructions, les paramètres de liaison, l'exécution de requêtes ou de mises à jour et de traitement des résultats.

Comment démarrer Apache

Apr 13, 2025 pm 01:06 PM

Comment démarrer Apache

Apr 13, 2025 pm 01:06 PM

Les étapes pour démarrer Apache sont les suivantes: Installez Apache (Commande: Sudo apt-get install Apache2 ou téléchargez-le à partir du site officiel) Start Apache (Linux: Sudo SystemCTL Démarrer Apache2; Windows: Cliquez avec le bouton droit sur le service "APACHE2.4" et SELECT ") Vérifiez si elle a été lancée (Linux: SUDO SYSTEMCTL STATURE APACHE2; (Facultatif, Linux: Sudo SystemCTL

Que faire si le port Apache80 est occupé

Apr 13, 2025 pm 01:24 PM

Que faire si le port Apache80 est occupé

Apr 13, 2025 pm 01:24 PM

Lorsque le port Apache 80 est occupé, la solution est la suivante: découvrez le processus qui occupe le port et fermez-le. Vérifiez les paramètres du pare-feu pour vous assurer qu'Apache n'est pas bloqué. Si la méthode ci-dessus ne fonctionne pas, veuillez reconfigurer Apache pour utiliser un port différent. Redémarrez le service Apache.

Comment supprimer plus que les noms de serveurs d'Apache

Apr 13, 2025 pm 01:09 PM

Comment supprimer plus que les noms de serveurs d'Apache

Apr 13, 2025 pm 01:09 PM

Pour supprimer une directive de nom de serveur supplémentaire d'Apache, vous pouvez prendre les étapes suivantes: Identifier et supprimer la directive supplémentaire de serveur. Redémarrez Apache pour que les modifications prennent effet. Vérifiez le fichier de configuration pour vérifier les modifications. Testez le serveur pour vous assurer que le problème est résolu.

Comment afficher votre version Apache

Apr 13, 2025 pm 01:15 PM

Comment afficher votre version Apache

Apr 13, 2025 pm 01:15 PM

Il existe 3 façons d'afficher la version sur le serveur Apache: via la ligne de commande (apachectl -v ou apache2ctl -v), cochez la page d'état du serveur (http: // & lt; serveur ip ou nom de domaine & gt; / server-status), ou afficher le fichier de configuration Apache (serverVeelion: apache / & lt; version & gt;).

Comment Debian améliore la vitesse de traitement des données Hadoop

Apr 13, 2025 am 11:54 AM

Comment Debian améliore la vitesse de traitement des données Hadoop

Apr 13, 2025 am 11:54 AM

Cet article examine comment améliorer l'efficacité du traitement des données Hadoop sur les systèmes Debian. Les stratégies d'optimisation couvrent les mises à niveau matérielle, les ajustements des paramètres du système d'exploitation, les modifications de configuration de Hadoop et l'utilisation d'algorithmes et d'outils efficaces. 1. Le renforcement des ressources matérielles garantit que tous les nœuds ont des configurations matérielles cohérentes, en particulier en faisant attention aux performances du CPU, de la mémoire et de l'équipement réseau. Le choix des composants matériels de haute performance est essentiel pour améliorer la vitesse de traitement globale. 2. Réglage des paramètres JVM: Ajustez dans le fichier hadoop-env.sh

Comment résoudre le problème qu'Apache ne peut pas être démarré

Apr 13, 2025 pm 01:21 PM

Comment résoudre le problème qu'Apache ne peut pas être démarré

Apr 13, 2025 pm 01:21 PM

Apache ne peut pas démarrer car les raisons suivantes peuvent être: Erreur de syntaxe du fichier de configuration. Conflit avec d'autres ports de demande. Problème d'autorisations. Hors de la mémoire. Traitement dans l'impasse. Échec du démon. Problèmes d'autorisations de Selinux. Problème de pare-feu. Conflit logiciel.