Opération et maintenance

Opération et maintenance

Docker

Docker

Quelle est la différence entre le volume du docker et le montage

Quelle est la différence entre le volume du docker et le montage

Quelle est la différence entre le volume du docker et le montage

La différence entre "docker volume" et mount est la suivante : "docker volume" est déclaratif, "Docker Engine" lui-même occupera un certain répertoire dans le système et Docker attribuera par défaut un chemin au volume sous le chemin occupé ; et le montage n'occupe pas de chemin en tant que point de montage.

L'environnement d'exploitation de ce tutoriel : système linux7.3, version docker-1.13.1, ordinateur Dell G3.

Quelle est la différence entre le volume Docker et le montage ?

Pendant longtemps, lorsque plusieurs conteneurs doivent partager l'accès au même répertoire de données, ou lorsque les données du conteneur doivent être conservées (comme une base de données), nous J'ai toujours utilisé le formulaire de répertoire de montage ( bind mounts), montez un répertoire sur l'hôte dans un répertoire spécifié dans le conteneur. Cette méthode peut résoudre le problème, mais cette méthode a toujours quelques défauts :

- Le déploiement de conteneurs sur. différents serveurs doivent être basés sur des conditions réelles. Modifier le chemin du répertoire de montage du disque

- Les autorisations de fichiers et de répertoires des différents systèmes d'exploitation vous rendront confus et en colère ?

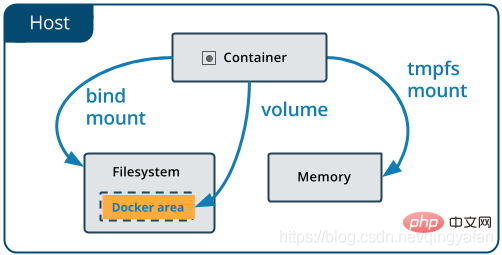

Et ces problèmes peuvent être résolus en utilisant Volume. Comparons d'abord les montages de liaison et le volume Docker, puis voyons comment le volume résout le problème des montages de liaison. Jetons d'abord un coup d'œil à une image :

Cette image montre que le montage et le volume de liaison utilisent réellement le système de fichiers de l'hôte. La différence est que le volume se trouve dans le répertoire géré par Docker. lui-même, il n'y a donc aucun problème de montage causé par les autorisations, et le chemin du répertoire est géré par docker lui-même, il n'est donc pas nécessaire de spécifier différents chemins sur différents serveurs. Vous n'avez pas besoin de vous soucier du chemin (en fait. , pas tous, comme cela sera expliqué ci-dessous) s'en soucier ?). Examinons ensuite les différentes utilisations du montage et du volume de liaison.

1. Lorsque le conteneur est déployé sur différents serveurs, le chemin doit être modifié en fonction du répertoire de montage réel du disque

Par exemple :

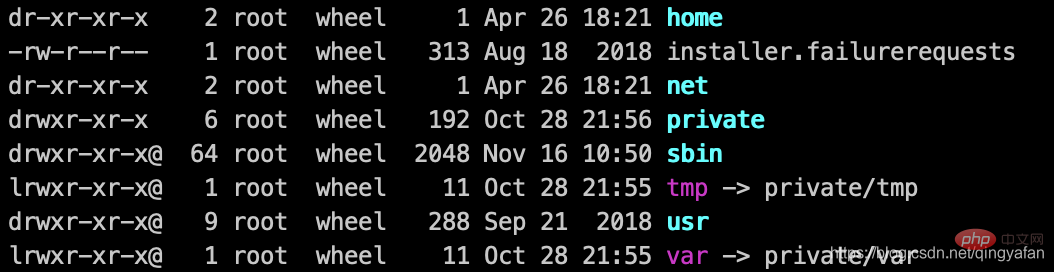

Dans les systèmes Linux, nous utilisons souvent "/var/someDir" comme paramètre. répertoire de montage ;

Cependant, voici sur Mac, /var/ n'est pas un vrai répertoire. Les utilisateurs de Mac vous diront que nous sommes plus avancés que Linux. Nous n'utilisons pas /var/ et les utilisateurs n'en ont pas besoin ; Dans les systèmes Windows, les utilisateurs Windows vous demanderont : /var / Qu'est-ce que c'est ? Le lecteur C et le lecteur D sont la division la plus raisonnable ~~

À l'origine, le test dans le système Linux était très bon, mais en conséquence, il y a eu divers problèmes avec le chemin de montage sous Windows. Je n'entrerai pas dans les détails ici. Non Si vous rencontrez ces problèmes, vous pouvez l'essayer et en faire l'expérience. Mais c'est mieux sous Mac, après tout, c'est la même chose que sous Linux.

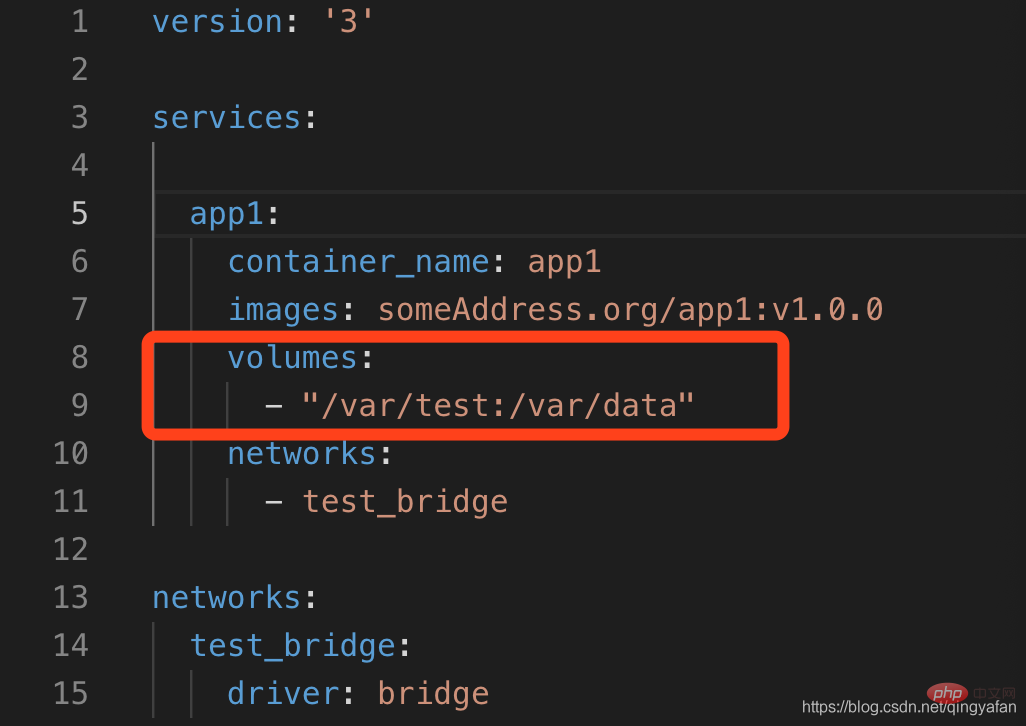

En plus de la méthode de montage dans Docker, il existe également un volume qui peut conserver les données. C'est un peu gênant de le mentionner. Après avoir utilisé Docker pendant si longtemps, j'ai toujours considéré le montage comme un volume, mais ce n'est pas de ma faute. . Le fichier Docker-compose se trouve dans la section volume. Il n'y a aucun problème pour écrire la relation de mappage entre le conteneur et le chemin de montage de l'hôte, mais cela a toujours été un malentendu. . (Blâme de fantaisie ?)

En fait, "montage" et "Docker Volume" ne sont pas la même chose. Il y a une certaine différence est déclaratif, et Docker Engine lui-même occupera un certain répertoire dans le système. , Linux est généralement "/var/lib/docker", et il peut être ajusté sous Mac et Windows. Lorsque nous déclarons un volume, Docker attribuera par défaut un chemin au volume sous le chemin occupé, par exemple :

En fait, "montage" et "Docker Volume" ne sont pas la même chose. Il y a une certaine différence est déclaratif, et Docker Engine lui-même occupera un certain répertoire dans le système. , Linux est généralement "/var/lib/docker", et il peut être ajusté sous Mac et Windows. Lorsque nous déclarons un volume, Docker attribuera par défaut un chemin au volume sous le chemin occupé, par exemple :

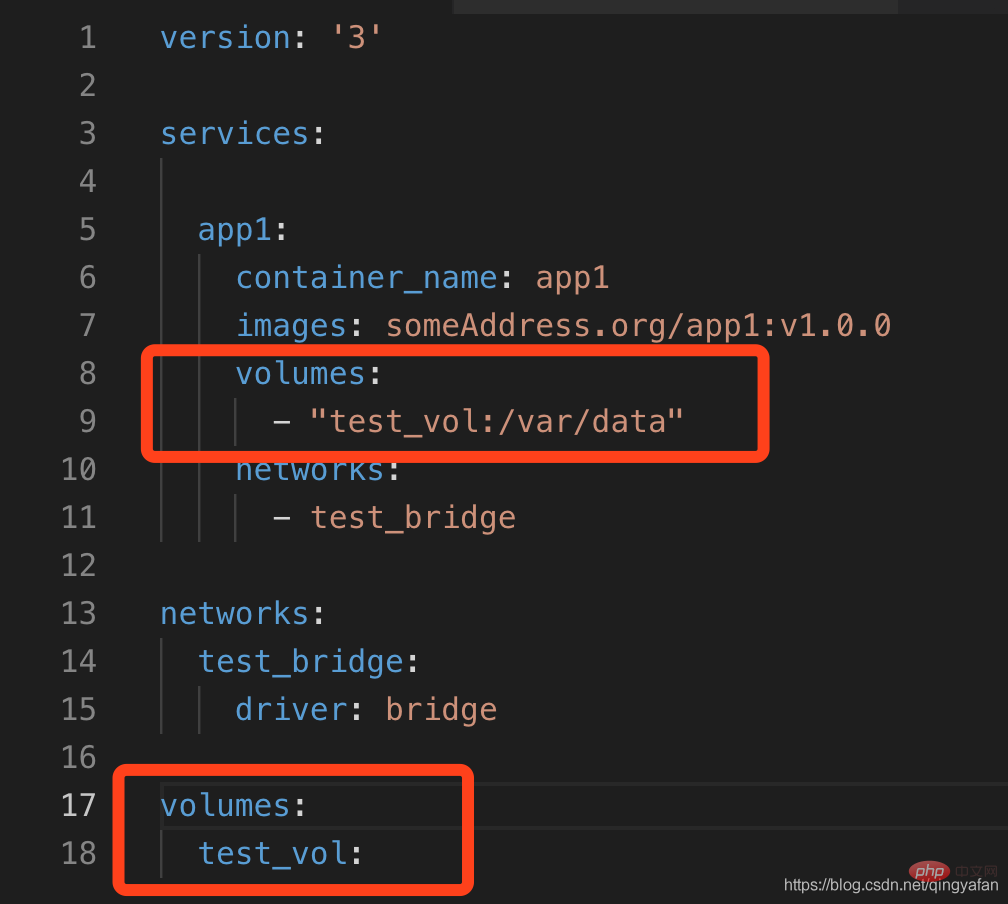

Lors de son utilisation, utilisez simplement le nom du volume au lieu du nom du chemin de l'hôte. Supposons que nous ayons créé un volume nommé "test_vol" ci-dessus :

- docker run -d -v "test_vol:/var/data" some_image, de sorte que le répertoire /var/data du conteneur soit monté sur le point de montage de "test_vol" ; Déclarons le volume dans le fichier docker-compose.yaml Modifions l'exemple ci-dessus :

Il est à noter que le volume entraînera l'expansion du répertoire docker, car il doit stocker. images et Pour enregistrer le volume, il est préférable de ne pas le placer sur le disque système, mais de configurer le répertoire d'installation de Docker sur un autre disque de montage plus grand.

- Les deux ont un comportement différent : lorsque le répertoire correspondant à l'extérieur du conteneur est vide, volume copiera d'abord le contenu du conteneur dans le répertoire à l'extérieur du conteneur, tandis que mount écrasera le répertoire interne du conteneur par le répertoire externe ! !

- volume Un autre inconvénient de bind mount est qu'il ne peut pas monter directement des fichiers, comme le montage du fichier de configuration du conteneur nginx : nginx.conf.

- Il doit être expliqué ici qu'une méthode de fichier unique telle qu'un fichier de configuration ne convient pas à l'utilisation du volume. Bien que le montage de liaison puisse également être résolu, puisque le fichier de configuration contient des informations sensibles telles que les mots de passe de la base de données, la meilleure méthode. utilise tmpfs.

Le volume de Kubernetes reflète également une conception similaire. Bien que subPath puisse résoudre le problème du montage du fichier de configuration, le meilleur moyen est d'utiliser configMap.

Apprentissage recommandé : "

Tutoriel vidéo DockerCe qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment empaqueter un projet avec pycharm

Apr 25, 2024 am 03:54 AM

Comment empaqueter un projet avec pycharm

Apr 25, 2024 am 03:54 AM

Il existe quatre façons de regrouper un projet dans PyCharm : Emballer sous forme de fichier exécutable distinct : Exporter au format de fichier unique EXE. Emballé sous forme de programme d'installation : générez le Makefile et compilez les outils de configuration. Packagez en tant qu'image Docker : spécifiez un nom d'image, ajustez les options de construction et construisez. Package en tant que conteneur : spécifiez l'image à créer, ajustez les options d'exécution et démarrez le conteneur.

Architecture et pratique du système distribué PHP

May 04, 2024 am 10:33 AM

Architecture et pratique du système distribué PHP

May 04, 2024 am 10:33 AM

L'architecture système distribuée PHP atteint l'évolutivité, les performances et la tolérance aux pannes en distribuant différents composants sur les machines connectées au réseau. L'architecture comprend des serveurs d'applications, des files d'attente de messages, des bases de données, des caches et des équilibreurs de charge. Les étapes de migration des applications PHP vers une architecture distribuée comprennent : Identifier les limites des services Sélectionner un système de file d'attente de messages Adopter un cadre de microservices Déploiement vers la gestion de conteneurs Découverte de services

Docker achève le déploiement local du grand modèle open source LLama3 en trois minutes

Apr 26, 2024 am 10:19 AM

Docker achève le déploiement local du grand modèle open source LLama3 en trois minutes

Apr 26, 2024 am 10:19 AM

LLaMA-3 (LargeLanguageModelMetaAI3) est un modèle d'intelligence artificielle générative open source à grande échelle développé par Meta Company. Il ne présente aucun changement majeur dans la structure du modèle par rapport à la génération précédente LLaMA-2. Le modèle LLaMA-3 est divisé en différentes versions, notamment petite, moyenne et grande, pour répondre aux différents besoins d'application et ressources informatiques. La taille des paramètres des petits modèles est de 8B, la taille des paramètres des modèles moyens est de 70B et la taille des paramètres des grands modèles atteint 400B. Cependant, lors de la formation, l'objectif est d'atteindre une fonctionnalité multimodale et multilingue, et les résultats devraient être comparables à GPT4/GPT4V. Installer OllamaOllama est un grand modèle de langage open source (LL

Développement et exploitation agiles de la conteneurisation de microservices PHP

May 08, 2024 pm 02:21 PM

Développement et exploitation agiles de la conteneurisation de microservices PHP

May 08, 2024 pm 02:21 PM

Réponse : Les microservices PHP sont déployés avec HelmCharts pour un développement agile et conteneurisés avec DockerContainer pour l'isolation et l'évolutivité. Description détaillée : utilisez HelmCharts pour déployer automatiquement des microservices PHP afin de réaliser un développement agile. Les images Docker permettent une itération rapide et un contrôle de version des microservices. Le standard DockerContainer isole les microservices et Kubernetes gère la disponibilité et l'évolutivité des conteneurs. Utilisez Prometheus et Grafana pour surveiller les performances et l'état des microservices, et créer des alarmes et des mécanismes de réparation automatiques.

Enseignement du nœud PI: Qu'est-ce qu'un nœud PI? Comment installer et configurer le nœud PI?

Mar 05, 2025 pm 05:57 PM

Enseignement du nœud PI: Qu'est-ce qu'un nœud PI? Comment installer et configurer le nœud PI?

Mar 05, 2025 pm 05:57 PM

Explication détaillée et guide d'installation pour les nœuds de pignon Cet article introduira l'écosystème de pignon en détail - nœuds PI, un rôle clé dans l'écosystème de pignon et fournir des étapes complètes pour l'installation et la configuration. Après le lancement du réseau de test de la blockchain pèse, les nœuds PI sont devenus une partie importante de nombreux pionniers participant activement aux tests, se préparant à la prochaine version du réseau principal. Si vous ne connaissez pas encore Pinetwork, veuillez vous référer à ce qu'est Picoin? Quel est le prix de l'inscription? PI Utilisation, exploitation minière et sécurité. Qu'est-ce que Pinetwork? Le projet Pinetwork a commencé en 2019 et possède sa pièce exclusive de crypto-monnaie PI. Le projet vise à en créer un que tout le monde peut participer

Comment installer Deepseek

Feb 19, 2025 pm 05:48 PM

Comment installer Deepseek

Feb 19, 2025 pm 05:48 PM

Il existe de nombreuses façons d'installer Deepseek, notamment: Compiler à partir de Source (pour les développeurs expérimentés) en utilisant des packages précompilés (pour les utilisateurs de Windows) à l'aide de conteneurs Docker (pour le plus pratique, pas besoin de s'inquiéter de la compatibilité), quelle que soit la méthode que vous choisissez, veuillez lire Les documents officiels documentent soigneusement et les préparent pleinement à éviter des problèmes inutiles.

Comment optimiser les performances des fonctions Java grâce à la conteneurisation ?

Apr 29, 2024 pm 03:09 PM

Comment optimiser les performances des fonctions Java grâce à la conteneurisation ?

Apr 29, 2024 pm 03:09 PM

La conteneurisation améliore les performances des fonctions Java des manières suivantes : Isolation des ressources : garantit un environnement informatique isolé et évite les conflits de ressources. Léger - consomme moins de ressources système et améliore les performances d'exécution. Démarrage rapide - réduit les délais d'exécution des fonctions. Cohérence : dissociez les applications et l'infrastructure pour garantir un comportement cohérent dans tous les environnements.

Déployer des applications JavaEE à l'aide de conteneurs Docker

Jun 05, 2024 pm 08:29 PM

Déployer des applications JavaEE à l'aide de conteneurs Docker

Jun 05, 2024 pm 08:29 PM

Déployez des applications Java EE à l'aide de conteneurs Docker : créez un fichier Docker pour définir l'image, créez l'image, exécutez le conteneur et mappez le port, puis accédez à l'application dans le navigateur. Exemple d'application JavaEE : l'API REST interagit avec la base de données, accessible sur localhost après déploiement via Docker.