Comment l’intelligence inexplicable va-t-elle se développer à l’avenir ?

Depuis 2023, ChatGPT et GPT-4 ont toujours été sur la liste des recherches les plus recherchées. D'un côté, les profanes se demandent à quel point l'IA est soudainement si puissante et, de l'autre, si elle va révolutionner la vie des « travailleurs » ; , en fait, même les initiés ne comprennent pas pourquoi une intelligence étonnante « émerge » soudainement après que l'échelle du modèle dépasse une certaine limite.

L'émergence de l'intelligence est une bonne chose, mais le comportement incontrôlable, imprévisible et inexplicable du modèle a plongé l'ensemble de la communauté universitaire dans la confusion et la réflexion profonde.

Une question simple d'abord. Quel film représentent les emojs suivants ?

Le modèle de langage le plus simple ne peut souvent continuer qu'à écrire « Le film est un film sur un homme qui est un homme qui est un homme » ; la réponse du modèle de complexité moyenne est plus proche, et la réponse donnée est « Le film Emoji » ; "; mais le modèle de langage le plus complexe ne donnera qu'une seule réponse : "Le Monde de Nemo"

En fait, cette invite est également l'une des 204 tâches conçues pour tester les capacités de divers modèles de langage à grande échelle.

Ethan Dyer, informaticien chez Google Research, a participé à l'organisation de ce test. Il a déclaré que même si j'étais prêt à des surprises lors de la construction de l'ensemble de données BIG-Bench, lorsque j'ai réellement été témoin de ce que ces modèles peuvent faire, j'ai quand même ressenti. .. Très surpris.

Ce qui est étonnant, c'est que ces modèles ne nécessitent qu'une invite : ils acceptent une chaîne de texte en entrée et prédisent encore et encore ce qui va suivre uniquement sur la base de statistiques.

Les informaticiens s'attendaient à ce que la mise à l'échelle améliore les performances sur les tâches connues, mais ils ne prévoyaient pas que les modèles seraient soudainement capables de gérer autant de tâches nouvelles et imprévisibles.

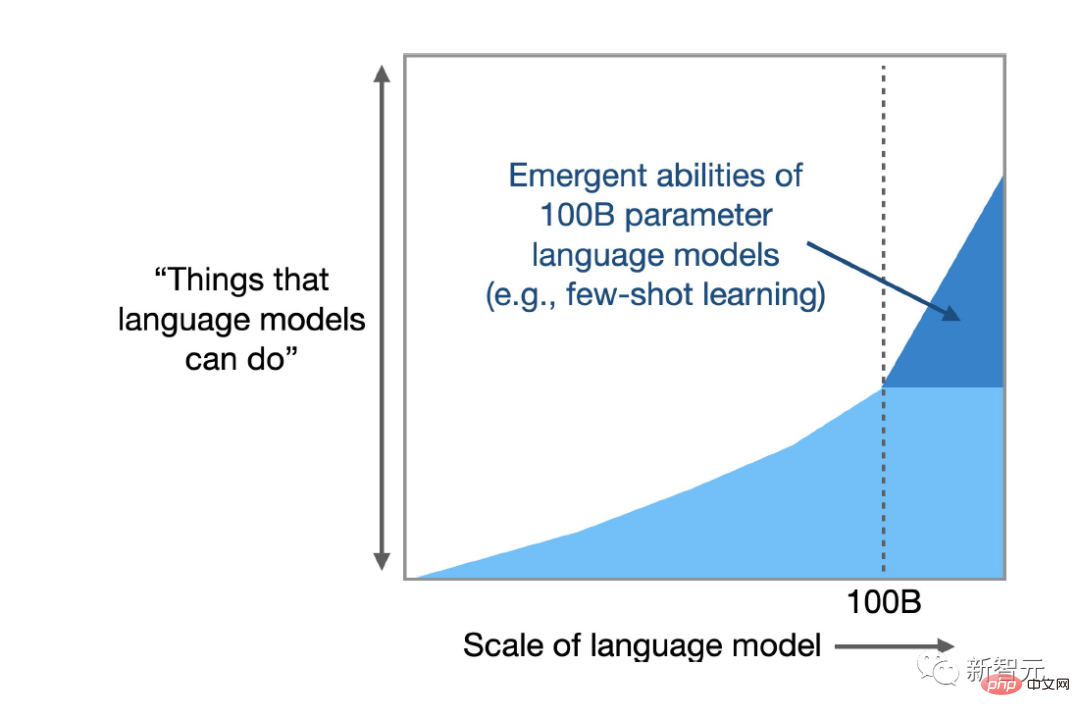

Une enquête récente à laquelle Dyer a participé a montré que le LLM peut produire des centaines de capacités « émergentes », c'est-à-dire des tâches que les grands modèles peuvent accomplir mais ne peuvent pas être accomplies par de petits modèles. Beaucoup de ces tâches semblent n'avoir rien à voir avec l'analyse. du texte, comme des calculs de multiplication à la génération de code informatique exécutable, il comprend également le décodage de films basé sur les symboles Emoji, etc.

Une nouvelle analyse montre que pour certaines tâches et certains modèles, il existe un seuil de complexité au-delà duquel les capacités du modèle augmentent à pas de géant.

Les chercheurs ont également suggéré un autre effet secondaire négatif de l'émergence : à mesure que la complexité augmente, certains modèles affichent de nouveaux biais et inexactitudes dans leurs réponses.

Rishi Bommasani, informaticien à l'Université de Stanford, a déclaré qu'à ma connaissance, il n'y a aucune discussion dans aucune littérature selon laquelle les modèles de langage peuvent faire ces choses.

L’année dernière, Bommasani a aidé à dresser une liste de dizaines de comportements émergents, dont plusieurs trouvés dans les projets de Dyer, et la liste continue de s’allonger.

Lien papier : https://openreview.net/pdf?id=yzkSU5zdwD

Actuellement, les chercheurs ne se précipitent pas seulement pour découvrir davantage de capacités émergentes, mais tentent également de comprendre pourquoi et comment elles se produisent, essentiellement ce qui précède. est une tentative de prédire l’imprévisibilité.

Comprendre l'émergence peut révéler des réponses à des questions profondes concernant l'intelligence artificielle et l'apprentissage automatique en général, par exemple si les modèles complexes font réellement quelque chose de nouveau ou s'ils deviennent simplement très bons en statistiques. Cela peut également aider les chercheurs à exploiter les avantages potentiels et à réduire les risques d'émergence. .

Deep Ganguli, informaticien à la startup d’intelligence artificielle Anthroic, a déclaré que nous ne savons pas comment juger quelle application les capacités nuisibles apparaîtront, si elles sont normales ou imprévisibles.

Les biologistes, physiciens, écologistes et autres scientifiques utilisent le mot « émergence » pour décrire le comportement collectif auto-organisé qui se produit lorsqu'un grand groupe de choses agit comme un tout.

Par exemple, les atomes inanimés se combinent pour créer des cellules vivantes ; les molécules d'eau créent des vagues ; des murmures d'étourneaux volent dans le ciel selon des motifs variés mais reconnaissables ; les cellules font bouger les muscles et les cœurs battent.

Il est important de noter que des capacités émergentes sont présentes dans les systèmes impliquant un grand nombre de pièces indépendantes, mais les chercheurs n'ont pu découvrir ces capacités que récemment dans les LLM, peut-être parce que ces modèles ont atteint une échelle suffisamment grande.

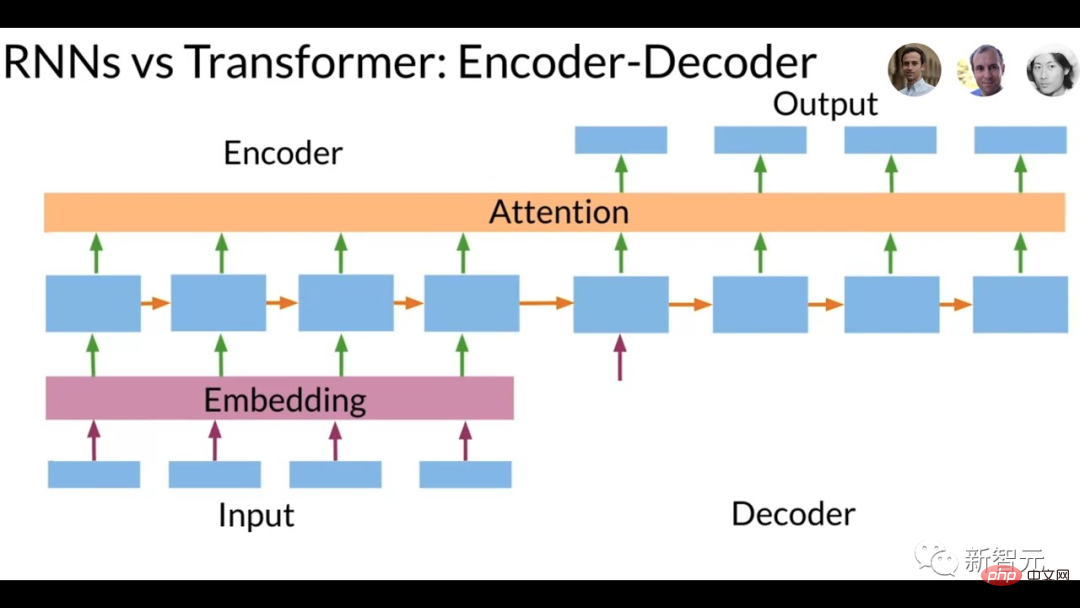

Les modèles linguistiques existent depuis des décennies, mais jusqu'à il y a cinq ans, l'arme la plus puissante était basée sur les réseaux de neurones récurrents (RNN). La méthode d'entraînement consistait à saisir une chaîne de texte et à prédire quel serait le mot suivant. c'est ce qu'on appelle récurrent), car le modèle apprend de ses propres résultats, c'est-à-dire que les prédictions du modèle sont réinjectées dans le réseau pour améliorer les performances.

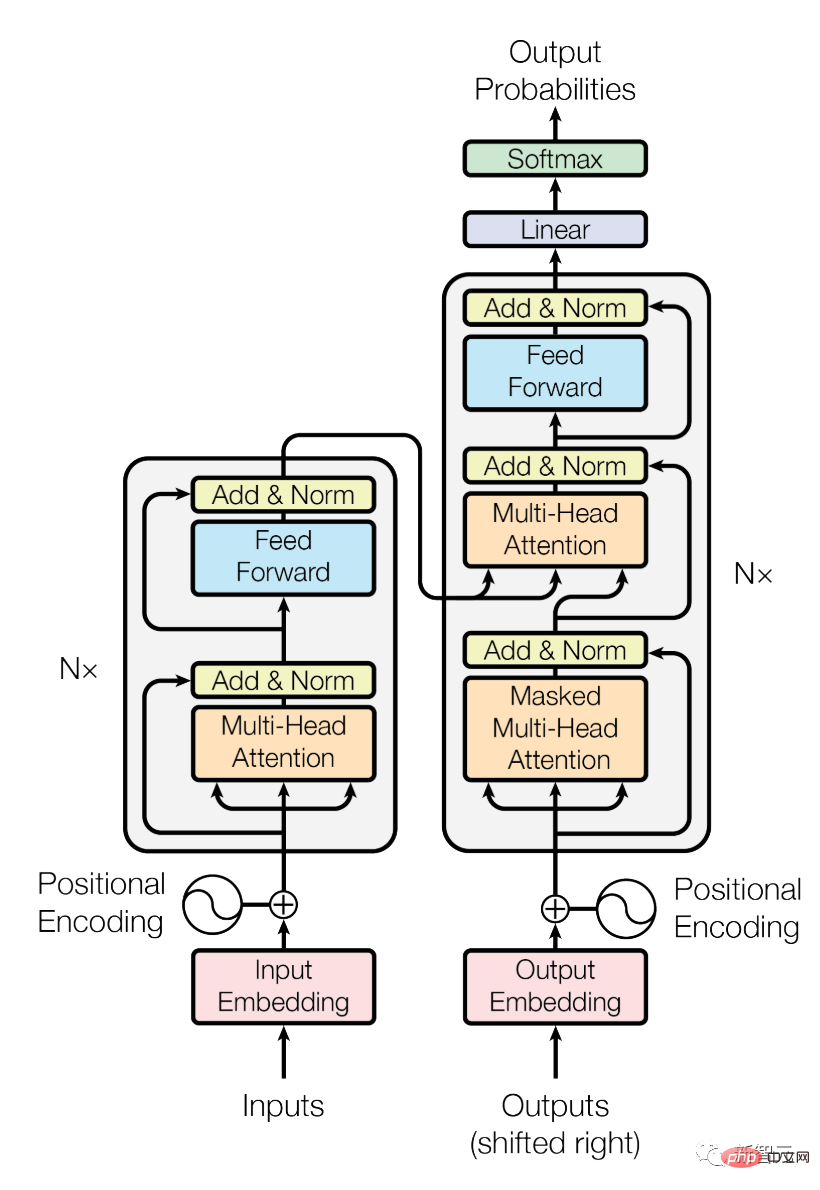

En 2017, les chercheurs de Google Brain ont introduit une nouvelle architecture appelée Transformer. Comparé à un réseau récurrent qui analyse une phrase mot par mot, Transformer peut traiter tous les mots en même temps, ce qui signifie que Transformer peut traiter de grandes quantités de texte. parallèle.

Transformer permet de faire évoluer rapidement la complexité des modèles de langage en augmentant le nombre de paramètres dans le modèle, entre autres facteurs. Les paramètres peuvent être considérés comme des connexions entre les mots, et le modèle ajuste les poids de ceux-ci. connexions pendant la formation. Améliorer les résultats de prévision.

Plus il y a de paramètres dans le modèle, plus la capacité à établir des connexions et plus la capacité à simuler le langage humain est forte.

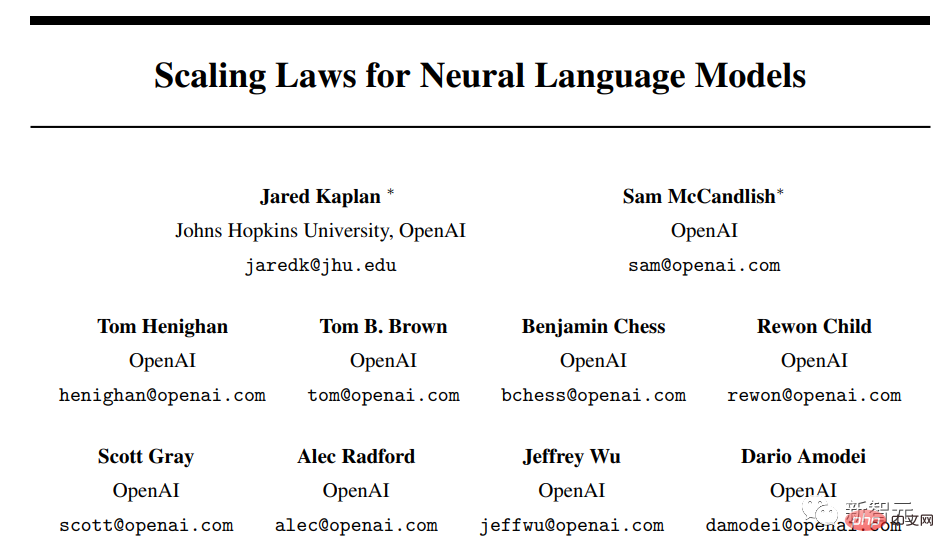

Comme prévu, une analyse réalisée en 2020 par des chercheurs d'OpenAI a révélé qu'à mesure que la taille des modèles augmente, leur précision et leurs capacités s'améliorent.

Lien papier : https://arxiv.org/pdf/2001.08361.pdf

Avec la sortie de modèles tels que GPT-3 (avec 175 milliards de paramètres) et PaLM de Google (évolutif jusqu'à 540 milliards de paramètres), les utilisateurs découvrent de plus en plus de fonctionnalités émergentes.

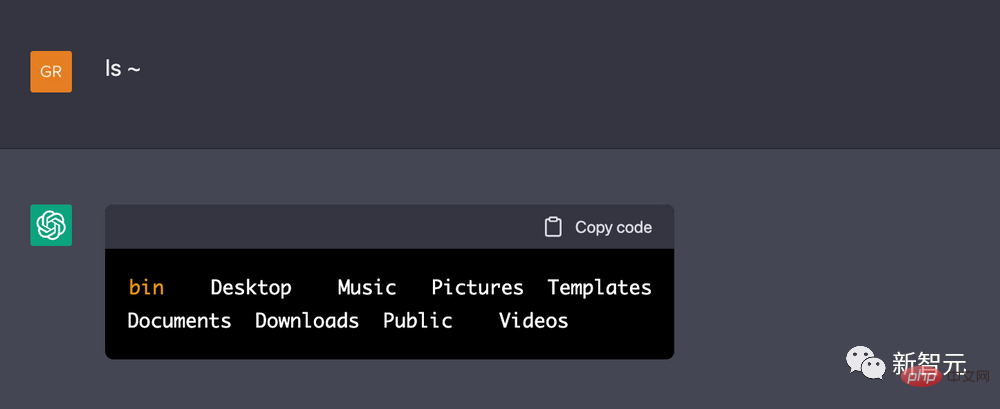

Un ingénieur de DeepMind a même signalé qu'il pouvait faire croire à ChatGPT qu'il s'agissait d'un terminal Linux et exécuter un code mathématique simple pour calculer les 10 premiers nombres premiers. Il convient de noter que ChatGPT peut terminer la tâche plus rapidement que d'exécuter le même code sur une vraie machine Linux.

Comme pour la tâche de symbole Emoji du film, les chercheurs n'ont aucune raison de penser qu'un modèle de langage pour prédire du texte peut imiter un terminal informatique. De nombreux comportements émergents démontrent les capacités d'apprentissage en un ou plusieurs coups des modèles de langage, c'est-à-dire que le LLM offre la possibilité de résoudre des problèmes qui n'ont jamais ou rarement été rencontrés auparavant.

Un grand nombre de chercheurs ont trouvé des signes indiquant que le LLM peut transcender les contraintes des données de formation, et ils s'efforcent de mieux comprendre à quoi ressemble l'émergence et comment elle se produit, et la première étape consiste à la documenter pleinement.

En 2020, Dyer et d'autres de Google Research ont prédit que le LLM aurait des impacts transformateurs, mais quels seraient exactement ces impacts reste une question ouverte.

Par conséquent, ils ont demandé à diverses équipes de recherche de fournir des exemples de tâches difficiles et diverses pour trouver les limites de capacités des modèles de langage. Ce travail est également appelé « Beyond the Imitation Game Benchmark » (BIG-bench, Beyond the Imitation Game Benchmark). Le nom du projet vient du "jeu d'imitation" proposé par Alan Turing, qui teste si l'ordinateur peut répondre aux questions de manière convaincante et humaine, également appelé test de Turing.

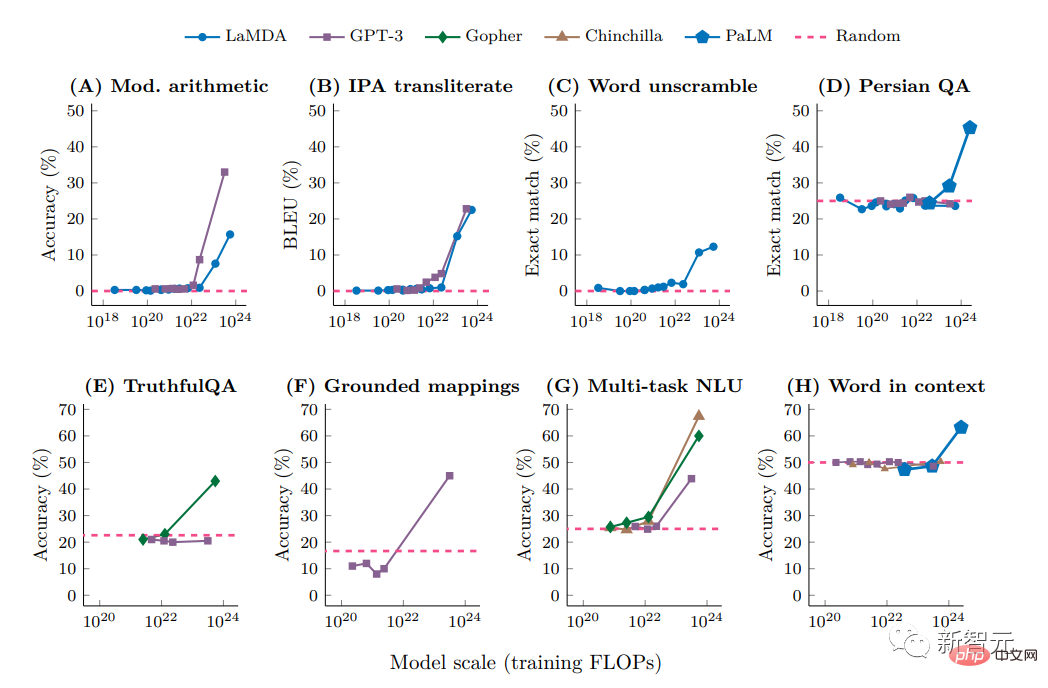

Comme prévu, sur certaines tâches, les performances du modèle se sont améliorées de manière fluide et prévisible à mesure que la complexité augmentait ; sur d'autres tâches, l'augmentation du nombre de paramètres n'a apporté aucune amélioration.

Cependant, dans environ 5 % des tâches, les chercheurs ont découvert ce qu'on appelle des « percées », c'est-à-dire des sauts rapides et spectaculaires de performances dans une certaine plage de seuil, qui varie en fonction de la tâche et du changement de modèle.

Par exemple, un modèle avec relativement peu de paramètres (seulement quelques millions) ne peut pas résoudre avec succès un problème d'addition à trois chiffres ou de multiplication à deux chiffres, mais pour des dizaines de milliards de paramètres, la précision de certains modèles s'améliore considérablement.

Des sauts similaires ont été observés dans d'autres tâches, notamment le décodage de l'alphabet phonétique international, le déchiffrement des lettres d'un mot, l'identification du contenu offensant dans les passages en hinglish (une combinaison d'hindi et d'anglais) et la génération de mots similaires à l'équivalent anglais des proverbes swahili.

Mais les chercheurs se sont vite rendu compte que la complexité du modèle n'était pas le seul facteur déterminant. Si la qualité des données était suffisamment élevée, des capacités inattendues pourraient être obtenues à partir de modèles plus petits avec moins de paramètres, ou dans des ensembles de données plus petits, en plus du libellé. la requête affectera également la précision de la réponse du modèle.

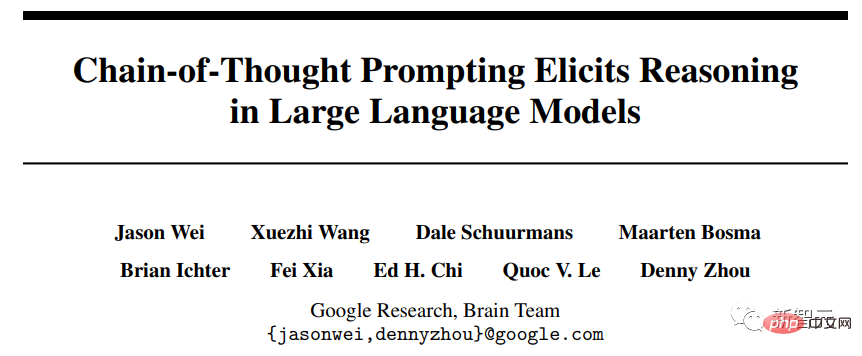

L'année dernière, dans un article publié à NeurIPS, la conférence phare dans le domaine, les chercheurs de Google Brain ont montré comment laisser le modèle s'expliquer à l'aide d'indices (raisonnement en chaîne de la pensée), comme comment résoudre correctement des problèmes de mots mathématiques, et le le même modèle ne peut pas être résolu correctement sans indices.

Lien papier : https://neurips.cc/Conferences/2022/ScheduleMultitrack?event=54087

Yi Tay, un scientifique de Google Brain qui s'engage dans la recherche systématique sur les percées, a souligné que des recherches récentes montrent que les invites de la chaîne de pensée Changer la courbe d'échelle du modèle modifie également le point d'émergence. L'utilisation des invites de la chaîne de pensée peut déclencher des comportements émergents que l'on ne trouve pas dans l'expérience BIG.

Ellie Pavlick, informaticienne à l'Université Brown qui étudie les modèles informatiques du langage, estime que ces découvertes récentes soulèvent au moins deux possibilités :

La première est que, comme le montrent les comparaisons avec les systèmes biologiques, le modèle acquiert une plus grande taille. de nouvelles capacités spontanément, probablement parce que le modèle apprend fondamentalement quelque chose de nouveau et de différent qui n'est pas présent dans le modèle plus petit, ce qui est exactement ce que nous voulons que ce soit le cas. Lorsque le modèle évolue, des changements fondamentaux se produisent.

Une autre possibilité, moins sensationnelle, est que ce qui semble être un événement révolutionnaire pourrait être un processus interne, basé sur des statistiques, fonctionnant par le biais d'un raisonnement en chaîne de pensée, et que les grands LLM pourraient simplement apprendre des heuristiques, pour les paramètres avec moins de paramètres ou une qualité de données inférieure, les algorithmes heuristiques ne peuvent pas être mis en œuvre.

Mais elle pense que pour déterminer laquelle de ces explications est la plus probable, il faut être capable de comprendre comment fonctionnent les LLM, et comme nous ne savons pas comment ils fonctionnent sous le capot, nous ne pouvons pas dire laquelle de ces suppositions est la plus probable. raisonnable .

Google a lancé Bard, un produit de type ChatGPT, en février, mais une erreur factuelle a été révélée dans la démonstration, qui a également apporté une révélation, bien que de plus en plus de recherches. Les gens ont commencé à s'appuyer sur ces modèles de langage pour effectuer un travail de base, mais ils ne pouvaient pas faire confiance aux résultats de ces modèles et avaient besoin de personnes pour vérifier davantage leur travail.

L'émergence crée de l'imprévisibilité, et l'imprévisibilité augmente avec l'échelle, ce qui rend difficile pour les chercheurs de prédire les conséquences d'une utilisation généralisée.

Si vous souhaitez étudier les phénomènes d'émergence, vous devez d'abord avoir un cas en tête. Avant d'étudier l'impact de l'échelle, vous ne pouvez pas savoir quelles capacités ou limitations peuvent survenir.

Certains comportements néfastes émergeront également dans certains modèles. Les résultats d'analyses récentes du LLM montrent que l'émergence de préjugés sociaux s'accompagne souvent d'un grand nombre de paramètres, ce qui signifie que les grands modèles deviendront soudainement plus biaisés s'ils ne peuvent pas être résolus. Ce risque peut mettre en danger les objets de recherche de ces modèles.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment flasher le téléphone Xiaomi

Comment flasher le téléphone Xiaomi

Comment centrer un div en CSS

Comment centrer un div en CSS

Comment ouvrir un fichier rar

Comment ouvrir un fichier rar

Méthodes de lecture et d'écriture de fichiers Java DBF

Méthodes de lecture et d'écriture de fichiers Java DBF

Comment résoudre le problème de l'absence du fichier msxml6.dll

Comment résoudre le problème de l'absence du fichier msxml6.dll

Formules de permutation et de combinaison couramment utilisées

Formules de permutation et de combinaison couramment utilisées

Numéro de téléphone mobile virtuel pour recevoir le code de vérification

Numéro de téléphone mobile virtuel pour recevoir le code de vérification

album photo dynamique

album photo dynamique