Périphériques technologiques

Périphériques technologiques

IA

IA

La vitesse est multipliée par 24 et le rendu inverse de grandes scènes d'intérieur peut être réalisé en 30 minutes. Les résultats des recherches de Rushi ont été sélectionnés pour le CVPR 2023.

La vitesse est multipliée par 24 et le rendu inverse de grandes scènes d'intérieur peut être réalisé en 30 minutes. Les résultats des recherches de Rushi ont été sélectionnés pour le CVPR 2023.

La vitesse est multipliée par 24 et le rendu inverse de grandes scènes d'intérieur peut être réalisé en 30 minutes. Les résultats des recherches de Rushi ont été sélectionnés pour le CVPR 2023.

Les résultats de la recherche sur la technologie de rendu inverse ont été sélectionnés pour la meilleure conférence de vision par ordinateur CVPR pendant deux années consécutives, et du traitement d'une seule image à la couverture de l'intégralité de la scène intérieure, la base technologique d'algorithme visuel de RuShi dans le domaine de la reconstruction tridimensionnelle a été clairement démontré.

La reconstruction tridimensionnelle est l'un des sujets brûlants en vision par ordinateur (CV) et en infographie (CG). Elle utilise la technologie CV pour traiter des images bidimensionnelles d'objets réels et de scènes capturées par des capteurs tels que des caméras pour obtenir leurs trois dimensions. -modèles dimensionnels. À mesure que les technologies connexes continuent de mûrir, la reconstruction 3D est de plus en plus utilisée dans de nombreux domaines tels que les maisons intelligentes, le tourisme AR, la conduite autonome et les cartes de haute précision, les robots, l'urbanisme, la reconstruction de reliques culturelles et le divertissement cinématographique.

Reconstruction de visage 3D typique basée sur des images 2D. Source de l'image : 10.1049/iet-cvi.2013.0220

La reconstruction tridimensionnelle traditionnelle peut être grossièrement divisée en méthodes photométriques et géométriques. La première analyse les changements de luminosité des pixels, et la seconde s'appuie sur la parallaxe pour terminer la reconstruction. Ces dernières années, l'apprentissage automatique, en particulier la technologie d'apprentissage profond, a commencé à être utilisé, obtenant de bons résultats en matière de détection de caractéristiques, d'estimation de profondeur, etc. Bien que certaines méthodes actuelles utilisent des modèles géométriques spatiaux et des cartes de texture, l’apparence de la scène est presque identique à celle du monde réel.

Cependant, il convient de noter que ces méthodes ont encore certaines limites. Elles ne peuvent que restaurer les caractéristiques d'apparence de la scène et ne peuvent pas numériser des attributs plus profonds tels que l'éclairage, la réflectivité et la rugosité de la scène, et encore moins interroger et modifier ces attributs profonds. informations. Je me suis levé. Cela entraîne également l'impossibilité de les convertir en ressources de rendu PBR pouvant être utilisées par le moteur de rendu et ne pouvant donc pas produire des effets de rendu réalistes. Comment résoudre ces problèmes ? La technologie de rendu inverse est progressivement entrée dans le champ de vision des gens.

La tâche de rendu inverse a été proposée pour la première fois par l'ancienne génération d'informaticiens Barrow et Tenenbaum en 1978. Basée sur la reconstruction tridimensionnelle, elle restaure en outre les attributs intrinsèques de la scène tels que l'éclairage, la réflectivité, la rugosité et la métallicité pour obtenir un rendu plus réaliste. Cependant, la décomposition de ces attributs à partir d’images est extrêmement instable, et différentes configurations d’attributs conduisent souvent à des apparences similaires. Avec les progrès du rendu différenciable et de la représentation neuronale implicite, certaines méthodes ont obtenu de bons résultats dans de petites scènes centrées sur les objets avec des priorités explicites ou implicites.

Cependant, le rendu inverse des scènes d'intérieur à grande échelle n'a pas été bien résolu. Non seulement il est difficile de restaurer des matériaux physiquement raisonnables dans des scènes réelles, mais il est également difficile d'assurer la cohérence de plusieurs perspectives au sein de la scène. Il existe une telle entreprise technologique nationale qui est profondément engagée dans la recherche et le développement indépendants d'algorithmes de base et se concentre sur les applications industrielles à grande échelle dans le domaine de la reconstruction 3D - Realsee. Elle a été pionnière sur le sujet difficile du rendu inverse à grande échelle. scènes d'intérieur. Un cadre de rendu inverse multi-vues efficace. L'article a été accepté pour la conférence CVPR 2023.

- Adresse du projet : http://yoodlee.top/TexIR/

- Adresse papier : https://arxiv.org/pdf/2211.10206.pdf

Plus précisément, Rushixin Basé sur des données spatiales précises données, ce procédé peut spéculer à l'envers pour obtenir les attributs intrinsèques de la scène tels que l'éclairage, la réflectivité, la rugosité, etc., et restaurer les performances d'éclairage et de matériau proches de la scène réelle sur la base de la reconstruction tridimensionnelle, ce qui améliore la reconstruction L'effet, la rentabilité et l'application ont été considérablement améliorés.

Cet article comprendre en détail la technologie de rendu inverse multi-vues de Rushi pour les scènes d'intérieur à grande échelle et fournira une analyse approfondie de ses avantages.

Pour les scènes d'intérieur à grande échelle

La nouvelle technologie de rendu inverse de Rushi permet d'obtenir un rendu « précis, détaillé et rapide »

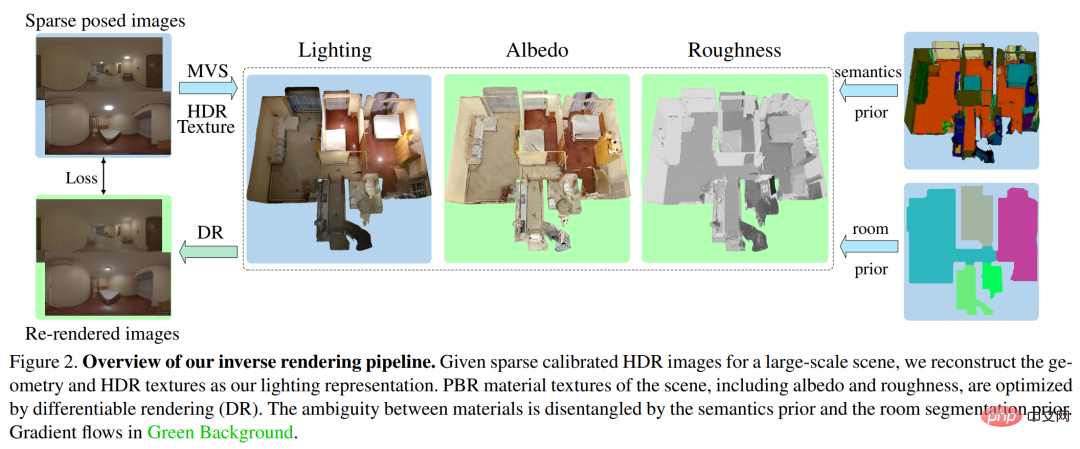

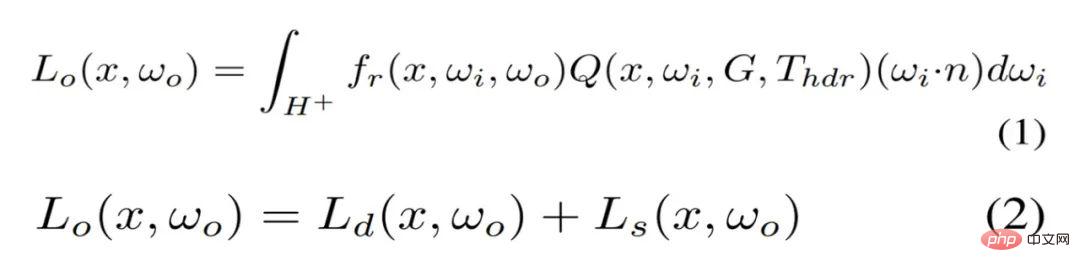

La figure 2 ci-dessous montre le processus global de la nouvelle méthode de rendu inverse de Rushi. Étant donné un ensemble calibré d’images HDR d’une scène intérieure à grande échelle, la méthode vise à récupérer avec précision un éclairage globalement cohérent et des SVBRDF (fonctions de distribution de réflectance bidirectionnelle), permettant une intégration facile dans les pipelines d’images et les applications en aval.

Afin d'atteindre ces objectifs, Rushi a d'abord proposé une représentation d'éclairage compacte appelée TBL (Texture-based Lighting), qui se compose de maillages 3D et de textures HDR, et modélise efficacement n'importe quelle position de l'ensemble de la grande scène intérieure. éclairage pour un éclairage indirect direct et à rebond infini. Sur la base de TBL, Rushi a en outre proposé une Représentation d'éclairage mixte avec irradiance pré-calculée, qui a considérablement amélioré l'efficacité et réduit le bruit de rendu dans l'optimisation des matériaux. Enfin, Rushi a introduit une stratégie d'optimisation des matériaux en trois étapes basée sur la segmentation, qui peut bien gérer l'ambiguïté physique des matériaux dans des scènes d'intérieur complexes à grande échelle.

Éclairage basé sur la texture (TBL)

Dans la représentation de l'éclairage de scènes intérieures à grande échelle, les avantages du TBL se manifestent dans la compacité de la représentation neuronale, l'interprétabilité et la cohérence spatiale de l'éclairage global IBL et de la lumière paramétrique. Le TBL est une représentation globale de la scène entière, définissant l'irradiance émise de tous les points de la surface. L'irradiance émise d'un point de surface est généralement égale à la valeur de la texture HDR, c'est-à-dire l'irradiance HDR observée du pixel correspondant dans l'image HDR d'entrée.

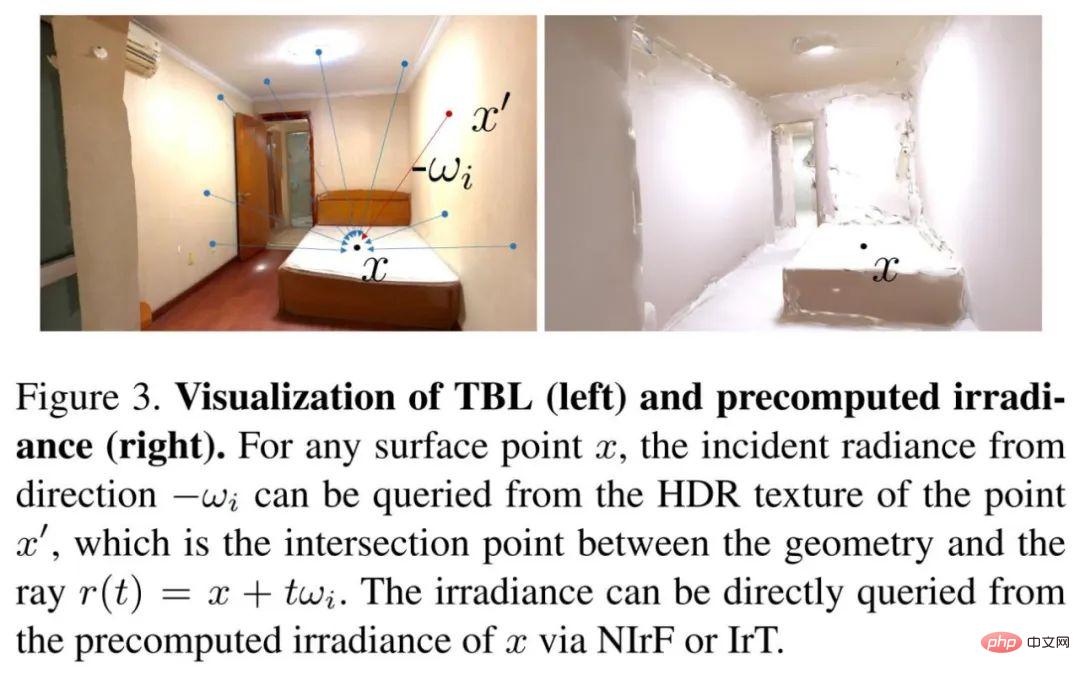

Rushi utilise une technologie de reconstruction 3D de haute qualité développée par lui-même pour reconstruire le modèle de maillage de l'ensemble de la grande scène. Enfin, la texture HDR est reconstruite sur la base de l'image HDR d'entrée, et l'éclairage global est interrogé depuis n'importe quelle position et n'importe quelle direction via la texture HDR. La figure 3 ci-dessous (à gauche) montre une visualisation de TBL.

Représentation d'éclairage mixte

En pratique, l'utilisation directe de TBL pour optimiser les matériaux présente des inconvénients. Le nombre élevé d'échantillons de Monte Carlo entraînera des coûts de calcul et de mémoire élevés. Étant donné que la plupart du bruit existe dans la composante diffuse, l'irradiance des points de surface pour la composante diffuse est précalculée. L'irradiance peut donc être interrogée efficacement, remplaçant ainsi les calculs en ligne coûteux, comme le montre la figure 3 (à droite). L'équation de rendu basée sur TBL est réécrite de l'équation (1) à l'équation (2).

Rushi propose deux représentations pour modéliser l'irradiance précalculée. L'un est le Neural Irradiance Field (NIrF), qui est un perceptron multicouche peu profond (MLP) qui prend des points de surface en entrée et produit l'irradiance p. L'autre est Irradiance Texture (IrT), qui est similaire à la carte de lumière couramment utilisée en infographie.

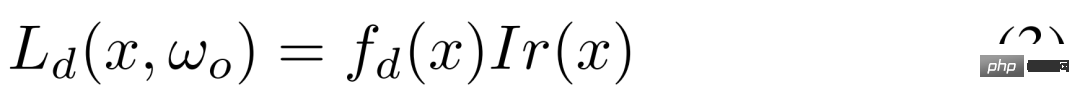

Comme vous pouvez le voir, cette représentation d'éclairage hybride comprend une irradiance précalculée pour la composante diffuse et une source TBL pour la composante spéculaire, ce qui réduit considérablement le bruit de rendu et permet une optimisation efficace des matériaux. La composante diffuse dans l'équation (2) est modélisée comme indiqué dans l'équation (3).

Estimation des matériaux en trois étapes basée sur la segmentation

Pour les matériaux neuronaux, il est difficile de modéliser des scènes à grande échelle avec des matériaux extrêmement complexes, et cela ne convient pas aux moteurs graphiques traditionnels. Au lieu d'opter pour une texture matérielle explicite qui optimise directement la géométrie, une version simplifiée du modèle Disney BRDF a été utilisée avec l'albédo SV et la rugosité SV comme paramètres. Cependant, en raison de la rareté des observations, l’optimisation directe des textures explicites des matériaux entraîne une rugosité incohérente et non convergente.

À cet égard, Rushi utilise des priorités sémantiques et de segmentation des pièces pour résoudre ce problème, où les images sémantiques sont prédites par un modèle basé sur l'apprentissage et la segmentation des pièces est calculée par une grille d'occupation. Dans le processus de mise en œuvre, Rushi adopte une stratégie en trois étapes.

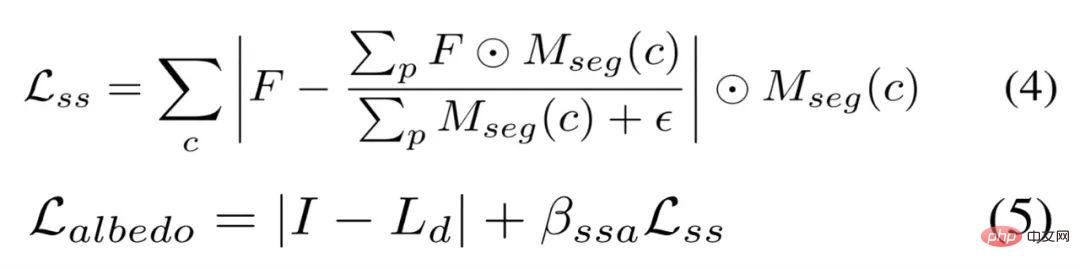

La première étape optimise l'albédo clairsemé sur la base de l'hypothèse lambertienne, au lieu d'initialiser l'albédo à une constante comme dans les petites scènes centrées sur les objets. Bien que l'albédo diffus puisse être calculé directement par la formule (3), cela rendra l'albédo trop brillant dans la zone de surbrillance, ce qui entraînera une rugosité excessive à l'étape suivante. Par conséquent, comme le montre l’équation (4) ci-dessous, nous utilisons des contraintes de lissage sémantique pour induire un albédo similaire sur la même segmentation sémantique. L'albédo clairsemé est optimisé par l'équation (5).

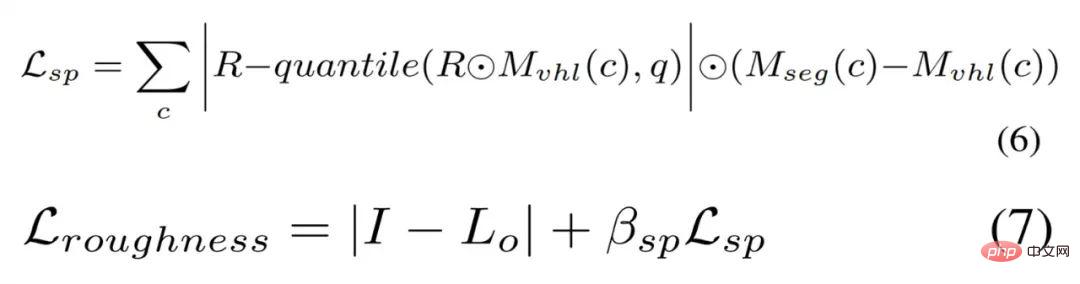

Échantillonnage basé sur les surbrillance virtuelles (VHL) de deuxième étape et propagation basée sur la sémantique. Dans les images multi-vues, seuls des signaux spéculaires clairsemés peuvent être observés, conduisant à une rugosité globalement incohérente, en particulier dans les scènes à grande échelle. Cependant, grâce à une segmentation sémantique préalable, une rugosité raisonnable dans les zones en surbrillance peut être propagée aux zones ayant la même sémantique.

Rushi restitue d'abord l'image en fonction de la pose d'entrée avec une rugosité de 0,01 pour trouver les régions VHL pour chaque classe sémantique, puis optimise la rugosité de ces VHL en fonction de l'albédo clairsemé et de l'éclairage gelés. Une rugosité raisonnable peut être propagée dans la même segmentation sémantique via l'équation (6), et cette rugosité peut être optimisée via l'équation (7).

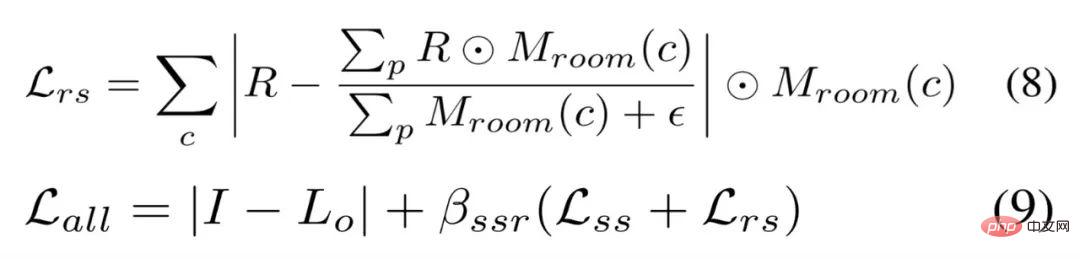

La troisième étape du réglage fin basé sur la segmentation. RuShi affine toutes les textures matérielles en fonction des priorités de segmentation sémantique et de segmentation de pièce. Plus précisément, Rushi utilise une contrainte de lissage similaire à l'équation (4) et une contrainte de lissage de pièce pour la rugosité afin de rendre la rugosité des différentes pièces plus douce et plus lisse. La contrainte de lissage de la pièce est définie par l'équation (8), même si n'utilisant aucune contrainte de lissage sur l'albédo, la perte totale est définie par l'équation (9).

Paramètres expérimentaux et comparaison des effets

Concernant le ensemble de données, Rushi a utilisé deux ensembles de données : ensemble de données synthétiques et ensemble de données réelles. Pour le premier, Rushi a utilisé un traceur de chemin pour créer une scène composite avec différents matériaux et lumières, rendant 24 vues pour l'optimisation et 14 nouvelles vues, rendant des images matérielles Ground Truth pour chaque vue. Pour ces derniers, en raison du manque d'images Full HDR dans les ensembles de données réelles de scènes à grande échelle couramment utilisées telles que Scannet, Matterport3D et Replica, Rushi a collecté 10 ensembles de données réelles Full HDR et en a capturé 10 à 20 en fusionnant 7 expositions bracketées. Une image panoramique full HDR.

À propos de la Méthode de base. Pour récupérer des SVBRDF à partir d'images multi-vues de scènes à grande échelle, les méthodes de rendu inverse actuelles incluent la méthode SOTA basée sur l'apprentissage d'une image unique PhyIR, la méthode de rendu neuronal SOTA centrée sur l'objet multi-vues InvRender, NVDIFFREC et NeILF. Concernant les métriques d'évaluation, nous utilisons PSNR, SSIM et MSE pour évaluer les prédictions matérielles et les images restituées à des fins de comparaison quantitative, et utilisons MAE et SSIM pour évaluer les images ré-éclairées rendues par différentes représentations d'éclairage.

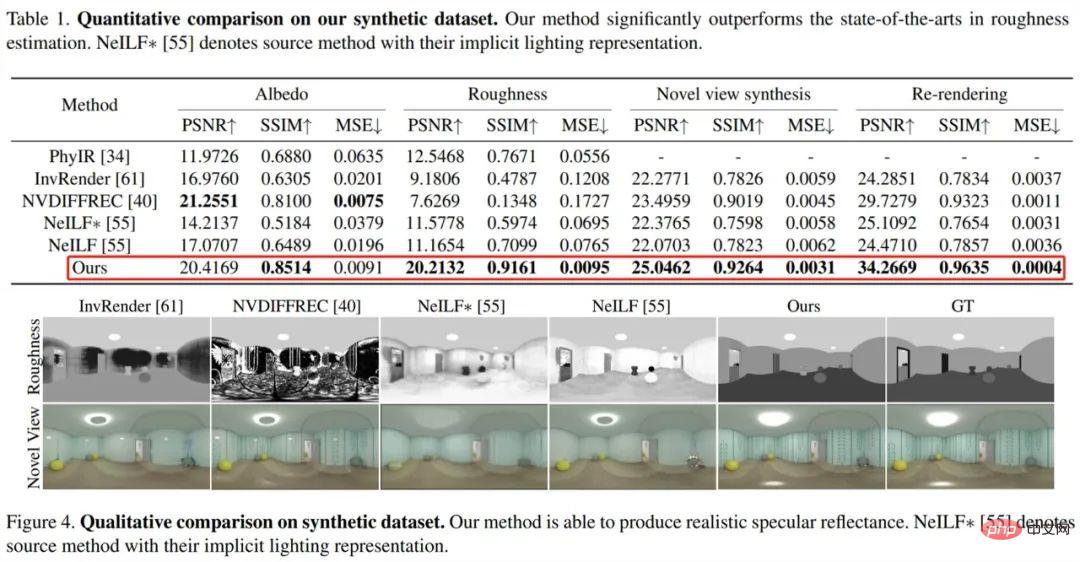

Premièrement regardez l'évaluation sur l'ensemble de données synthétiques, comme le montrent le tableau 1 et la figure 4 ci-dessous, La méthode telle que vue surpasse considérablement la méthode SOTA dans l'estimation de la rugosité, et la rugosité peut produire une réflectance spéculaire physiquement raisonnable. De plus, par rapport à la représentation implicite originale, NeILF avec représentation visuelle d'éclairage hybride réduit l'ambiguïté entre les matériaux et l'éclairage.

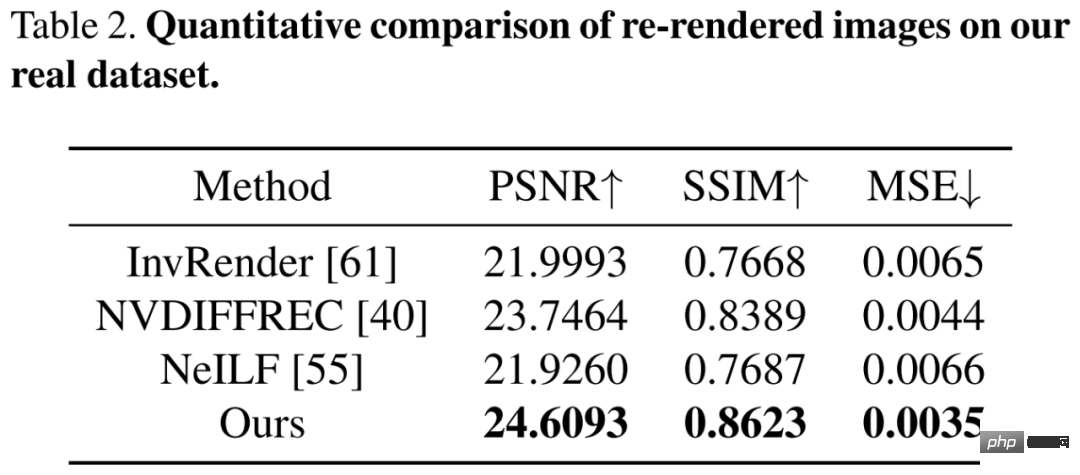

Puis évalué sur un ensemble de données difficiles du monde réel contenant des matériaux et un éclairage complexes. Les résultats de comparaison quantitative dans le tableau 2 ci-dessous montrent que la méthode RuShi est supérieure aux méthodes précédentes. Bien que ces méthodes comportent des erreurs de rendu approximatives, seule la méthode visuelle découple les matériaux globalement cohérents et physiquement sains.

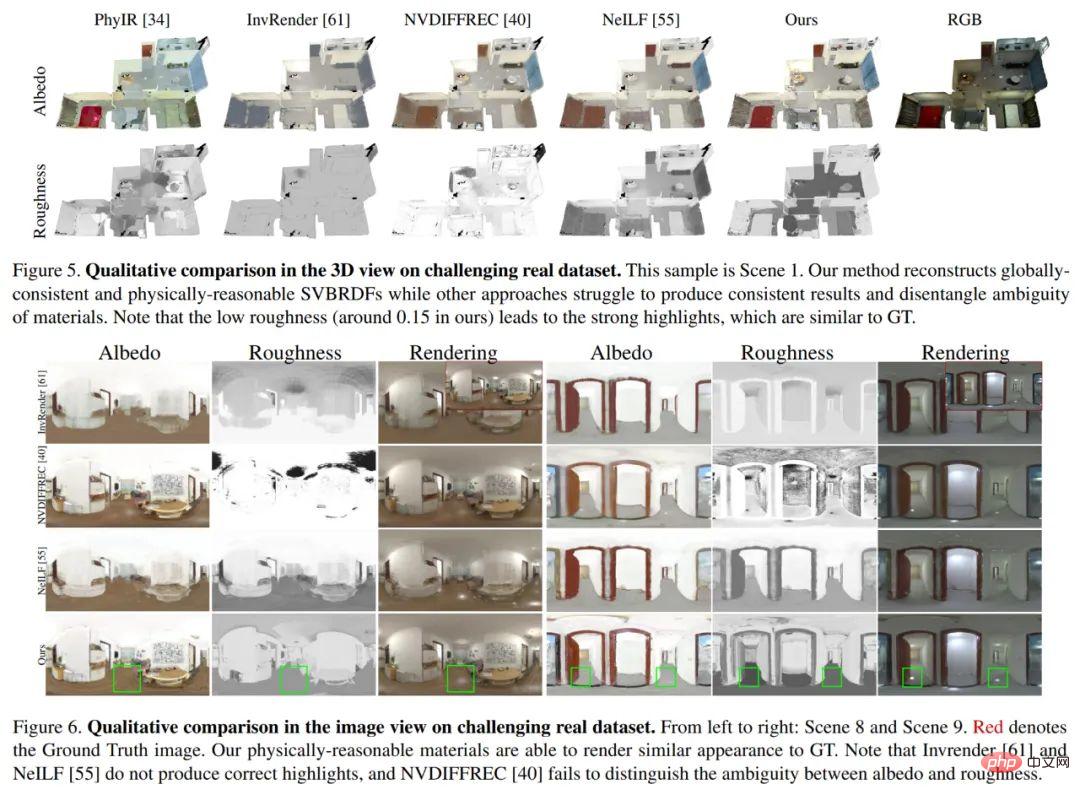

La figure 5 et la figure 6 ci-dessous montrent respectivement une comparaison qualitative de la vue 3D et de la vue image 2D. PhyIR a de mauvaises performances de généralisation en raison de grandes lacunes dans les domaines et ne peut pas atteindre une prédiction de cohérence globale. InvRender, NVDIFFREC et NeILF ont produit des prédictions floues avec des artefacts qui rendaient difficile le découplage du bon matériau. Bien que NVDIFFREC puisse atteindre des performances similaires à celles de la méthode RuSight, il ne peut pas dissocier l'ambiguïté entre l'albédo et la rugosité, de sorte que les reflets de la composante spéculaire sont incorrectement restaurés en albédo diffus.

Expériences d'ablation

Pour démontrer l'efficacité de ses stratégies de représentation de l'éclairage et d'optimisation des matériaux, telles que TBL, représentation d'éclairage mixte, initialisation de l'albédo dans la première étape et estimation de la rugosité dans la deuxième étape L'échantillonnage VHL et la propagation sémantique et la troisième étape de réglage fin basé sur la segmentation ont été réalisées pour les expériences d'ablation.

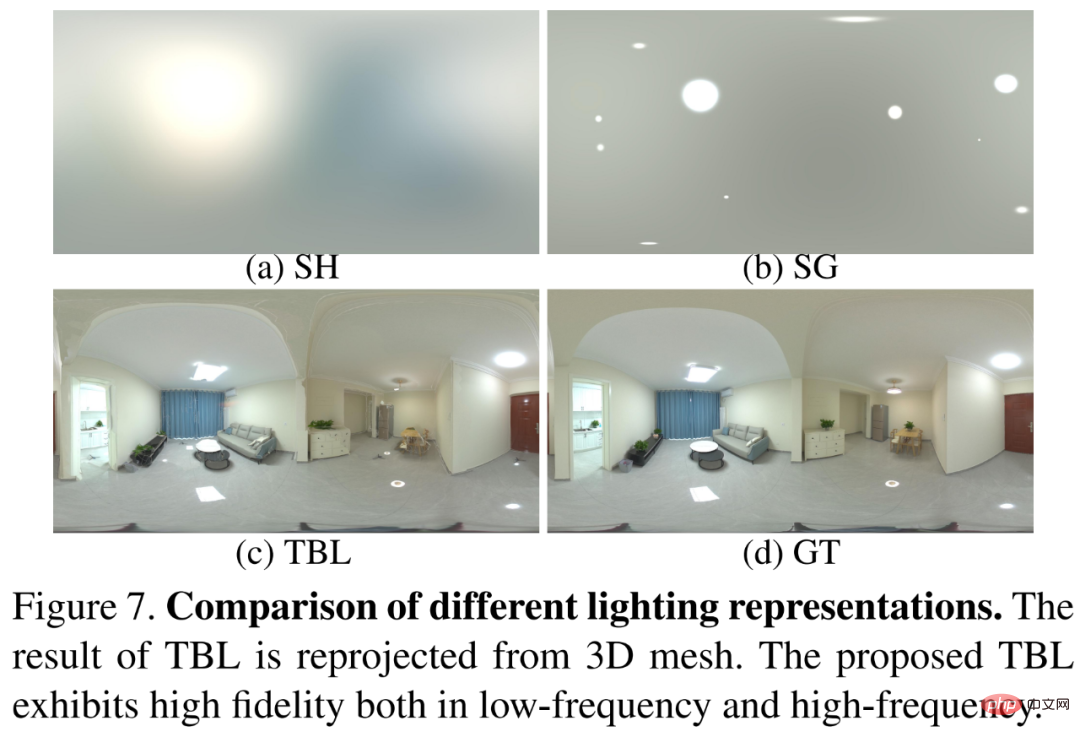

Premièrementa comparé le TBL avec les méthodes d'éclairage SH et SG qui sont largement utilisées dans les méthodes précédentes Les résultats sont présentés dans la figure 7 ci-dessous. Comme le montre la figure 7, le TBL montre une haute fidélité à la fois en basse fréquence et en haute fréquence. caractéristiques de fréquence.

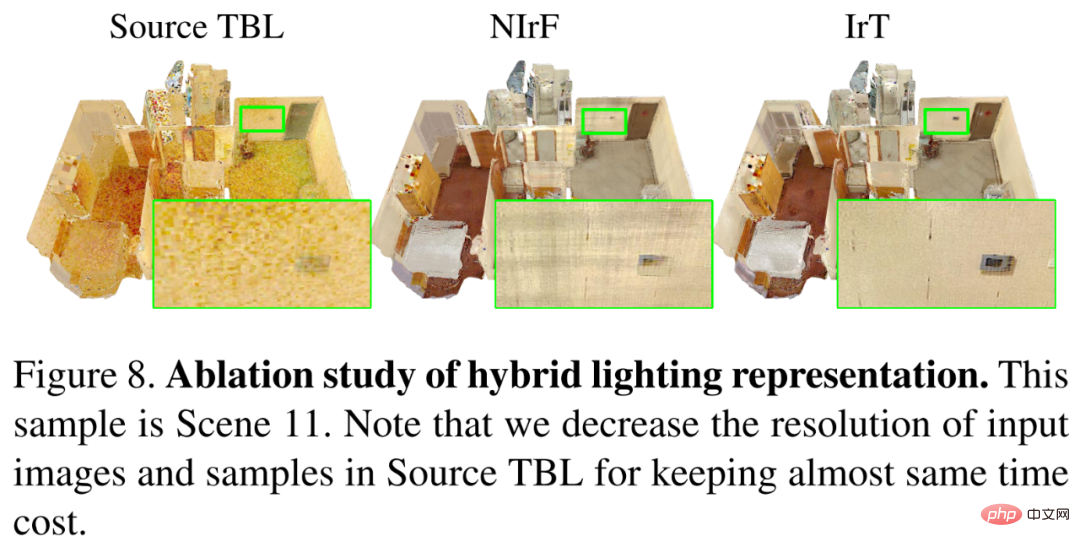

comparez la représentation d'éclairage mixte avec le TBL original, et les résultats sont présentés dans la figure 8 ci-dessous. Sans représentation d'éclairage mixte, l'albédo peut provoquer du bruit et converger lentement. L'introduction de l'irradiance précalculée permet d'utiliser des entrées haute résolution pour récupérer des matériaux fins et accélère considérablement le processus d'optimisation. Dans le même temps, IrT produit un albédo plus fin et sans artefacts par rapport au NIrF.

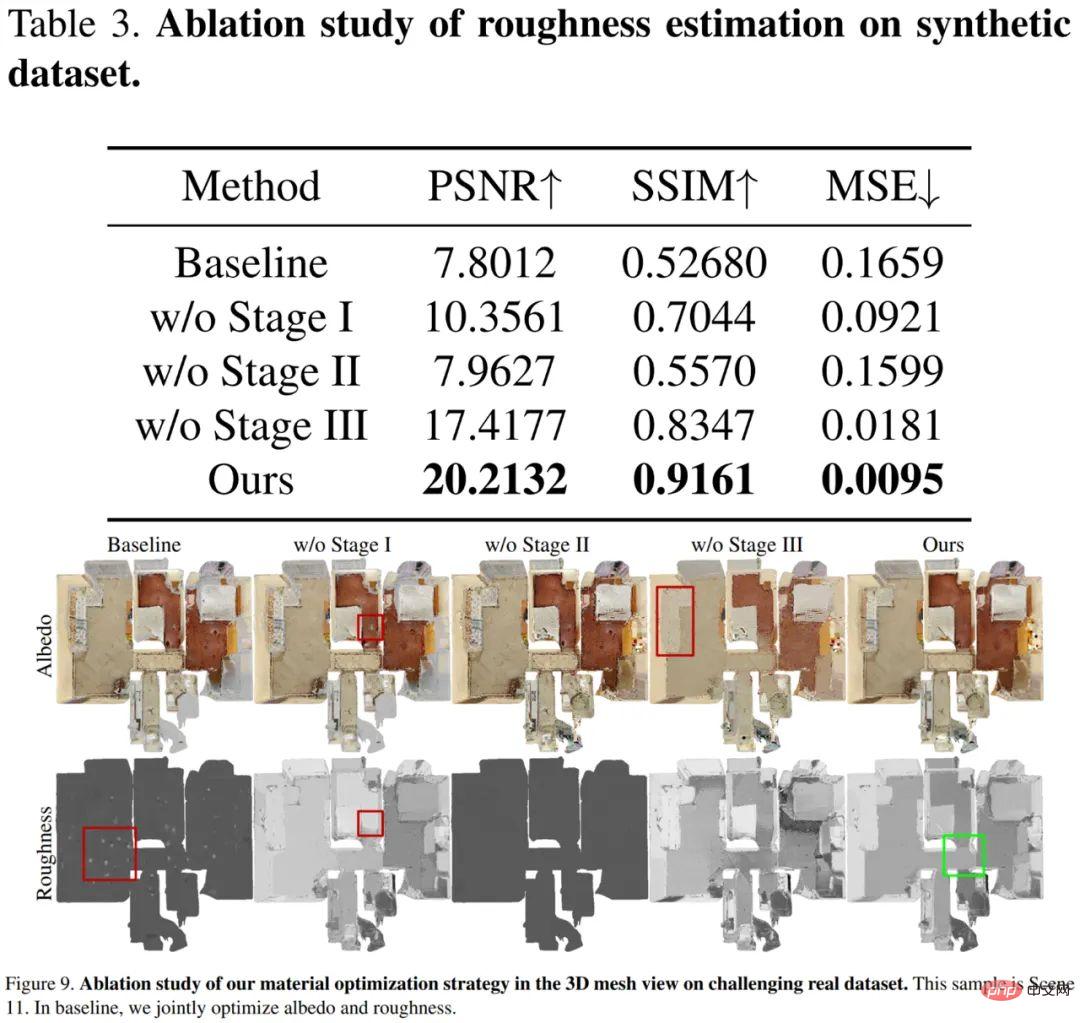

l'efficacité de la stratégie en trois étapes a été vérifiée, et les résultats sont présentés dans le tableau 3 et la figure 9 ci-dessous. La rugosité de base ne parvient pas à converger et seules les zones en surbrillance sont mises à jour. Sans initialisation de l'albédo dans la première étape, les zones claires seront trop lumineuses et entraîneront une rugosité incorrecte. La deuxième étape de l'échantillonnage basé sur VHL et de la propagation sémantique est cruciale pour récupérer une rugosité raisonnable dans les zones où les reflets spéculaires ne sont pas observés. La troisième étape du réglage fin basé sur la segmentation produit un albédo fin, rendant la rugosité finale plus lisse et empêchant la propagation des erreurs de rugosité entre différents matériaux.

La nouvelle technologie de rendu inverse de Rushi, quel est l'avantage ?

En fait, Rushi a obtenu des résultats SOTA sur la tâche de rendu inverse d'une seule image en proposant une méthode de formation de réseau neuronal dans son article CVPR 2022 « PhyIR : Rendu inverse basé sur la physique pour les images panoramiques en intérieur ». Désormais, le nouveau cadre de rendu inverse permet non seulement d'obtenir des perspectives multiples, la maison entière, l'espace et la scène, mais résout également de nombreux défauts clés des méthodes de rendu inverse précédentes.

Tout d'abordLes méthodes précédentes basées sur la formation de données synthétiques ne fonctionnaient pas bien dans des scénarios réels. Le nouveau cadre de rendu inverse en profondeur de Rushi introduit pour la première fois une « scène hiérarchique préalable » grâce à une optimisation des matériaux en plusieurs étapes et en combinaison avec la plus grande base de données spatiales tridimensionnelles au monde dans l'espace numérique de Rushi, l'éclairage, la réflectivité et la lumière dans l'espace de vie. l'espace sont analysés. Les propriétés physiques telles que la rugosité permettent des prédictions hiérarchiques et précises.

Les résultats de la prédictionLe résultat final est une carte de matériaux multi-types physiquement raisonnable et globalement cohérente, qui convertit de manière transparente les données de scène intérieure réellement capturées par l'équipement Rushi en ressources de rendu numérique, s'adaptant à tous les moteurs de rendu grand public actuels tels que Unity et Blender, cela permet la génération automatique d'actifs de scène et d'applications MR basées sur la physique, telles que l'édition de matériaux, la synthèse de nouvelles vues, le rééclairage, l'insertion d'objets virtuels, etc. Cet actif numérique très polyvalent est propice à la prise en charge d’un plus grand nombre d’applications et de produits différents à l’avenir.

Édition de matériaux

Relighting

DeuxièmementLes méthodes de rendu différenciables précédentes basées sur l'optimisation sont extrêmement coûteuses en calcul et extrêmement inefficaces. Ces dernières années, afin de mieux résoudre le problème du rendu inverse et de réduire la dépendance aux données d'entraînement, la méthode de rendu différentiable a été proposée, c'est-à-dire via la méthode de « dérivation différentielle » pour rendre le rendu différenciable vers l'avant, puis vers l'arrière. propager le dégradé aux paramètres de rendu, et enfin les paramètres à résoudre en fonction de la physique sont obtenus par optimisation. De telles méthodes incluent l'éclairage sphérique-harmonique (SH) [1] et l'éclairage sphérique gaussien tridimensionnel (VSG).

Cependant, les scènes d'intérieur à grande échelle présentent un grand nombre d'effets optiques complexes tels que l'occlusion et l'ombre. La modélisation de l'éclairage global dans un rendu différenciable entraînera des coûts de calcul élevés. Par exemple, le TBL proposé cette fois peut représenter efficacement et précisément l'éclairage global des scènes intérieures et ne nécessite qu'environ 20 Mo de mémoire, tandis que l'éclairage VSG basé sur une grille dense [2] nécessite environ 1 Go de mémoire, et l'éclairage VSG basé sur une grille clairsemée [2] nécessite environ 1 Go de mémoire. Méthode d'éclairage SH Plenoxels [3] Environ 750 Mo de mémoire sont nécessaires et la capacité de la mémoire des données a été réduite des dizaines de fois.

De plus, la nouvelle méthode de Rushi peut réaliser le rendu inverse de toute la scène intérieure en30 minutes, tandis que la méthode traditionnelle [4] peut prendre environ 12 heures, ce qui représente une amélioration totale de 24 fois. L'augmentation substantielle de la vitesse de calcul signifie une réduction des coûts et un avantage coût-performance plus significatif, ce qui nous rapproche des applications pratiques à grande échelle.

Enfin, les précédentes méthodes de rendu inverse neuronal de type NeRF (telles que PS-NeRF [5], NeRFactor [6], etc.) sont principalement orientées vers des scènes à petite échelle centrées sur des objets, et elles semblent incapables de modéliser des scènes à grande échelle. scènes intérieures à grande échelle. Basé sur le modèle spatial numérique précis de Rushi et sur une représentation d'éclairage mixte efficace et précise, le nouveau cadre de rendu inverse résout ce problème en introduisant des priorités de segmentation sémantique et de segmentation de pièce. Concernant ce nouveau cadre de rendu inverse en profondeur, Pan Cihui, scientifique en chef de Rushi, a déclaré : « Il permet véritablement une numérisation plus profonde du monde réel et résout le problème des méthodes de rendu inverse précédentes qui étaient difficiles à restaurer des matériaux et des textures physiquement raisonnables dans des scènes réelles. Les problèmes d'éclairage et de cohérence multi-vues ont apporté une plus grande imagination à l'application de la reconstruction 3D et de la MR "Saisissez les avantages de la technologie de rendu inverseInnovez dans l'intégration de l'industrie VR + dans l'espace numériqueToujours, comme Vision. a accumulé beaucoup de technologie dans le domaine de la reconstruction 3D et a investi beaucoup d'énergie dans le peaufinage et le travail sur la mise en œuvre d'algorithmes associés. Dans le même temps, il soutient grandement la recherche et le développement de technologies de pointe et attache une grande importance à la conquête des technologies de pointe du secteur. Ceux-ci sont devenus une base importante pour la reconstruction de modèles 3D réels et la recherche en IRM de RuShi, y compris cette nouvelle technologie de rendu inverse, pour gagner la reconnaissance de la communauté universitaire internationale, et ont aidé les capacités algorithmiques de RuShi à atteindre le premier niveau mondial en matière de recherche théorique et technique. candidatures.Ces algorithmes et avantages techniques permettront une numérisation plus profonde du monde réel et accéléreront encore la construction de l'espace numérique. À l'heure actuelle, Rushi Digital Space a accumulé plus de 27 millions d'ensembles de collections dans différents pays et différents scénarios d'application grâce à des équipements de collecte auto-développés, couvrant une superficie de 2,274 milliards de mètres carrés. Rushi Digital Space soutiendra également son orientation vers le développement de l'intégration de l'industrie VR +, apportant de nouvelles opportunités de développement pour la mise à niveau des applications numériques dans le commerce de détail, les installations industrielles, les expositions culturelles, les affaires publiques, la décoration intérieure, les transactions immobilières et d'autres secteurs, tels que la visualisation de maisons en réalité virtuelle. , musée VR et plus encore.

L'assistant marketing IA créé par Rushi

Pour l'intégration de l'industrie VR +, Le plus grand avantage de Rushi réside dans l'algorithme de reconstruction numérique en constante évolution et l'accumulation de données réelles massives, ce qui lui confère une haute technicité barrières et grandes barrières de données. Ces algorithmes et ces données peuvent également circuler entre eux dans une certaine mesure, élargissant ainsi constamment leurs avantages. Dans le même temps, les barrières des données et des algorithmes permettent à Rushi de résoudre plus facilement les problèmes de diverses industries, d'apporter des solutions techniques et d'innover de nouveaux modèles de développement industriel.

Les réalisations de la technologie de rendu inverse ont été sélectionnées dans CVPR pendant deux années consécutives, principalement parce que Rushi souhaite faire une différence dans la direction MR et réaliser une certaine mise en œuvre dans l'industrie. À l'avenir, Rushi espère combler le fossé entre la réalité virtuelle et la simulation virtuelle pure, parvenir véritablement à l'intégration du virtuel et du réel et créer davantage d'applications industrielles.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

L'article de StableDiffusion3 est enfin là ! Ce modèle est sorti il y a deux semaines et utilise la même architecture DiT (DiffusionTransformer) que Sora. Il a fait beaucoup de bruit dès sa sortie. Par rapport à la version précédente, la qualité des images générées par StableDiffusion3 a été considérablement améliorée. Il prend désormais en charge les invites multithèmes, et l'effet d'écriture de texte a également été amélioré et les caractères tronqués n'apparaissent plus. StabilityAI a souligné que StableDiffusion3 est une série de modèles avec des tailles de paramètres allant de 800M à 8B. Cette plage de paramètres signifie que le modèle peut être exécuté directement sur de nombreux appareils portables, réduisant ainsi considérablement l'utilisation de l'IA.

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

La prédiction de trajectoire joue un rôle important dans la conduite autonome. La prédiction de trajectoire de conduite autonome fait référence à la prédiction de la trajectoire de conduite future du véhicule en analysant diverses données pendant le processus de conduite du véhicule. En tant que module central de la conduite autonome, la qualité de la prédiction de trajectoire est cruciale pour le contrôle de la planification en aval. La tâche de prédiction de trajectoire dispose d'une riche pile technologique et nécessite une connaissance de la perception dynamique/statique de la conduite autonome, des cartes de haute précision, des lignes de voie, des compétences en architecture de réseau neuronal (CNN&GNN&Transformer), etc. Il est très difficile de démarrer ! De nombreux fans espèrent se lancer dans la prédiction de trajectoire le plus tôt possible et éviter les pièges. Aujourd'hui, je vais faire le point sur quelques problèmes courants et des méthodes d'apprentissage introductives pour la prédiction de trajectoire ! Connaissances introductives 1. Existe-t-il un ordre d'entrée pour les épreuves de prévisualisation ? R : Regardez d’abord l’enquête, p

DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

Mar 21, 2024 pm 05:21 PM

DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

Mar 21, 2024 pm 05:21 PM

Cet article explore le problème de la détection précise d'objets sous différents angles de vue (tels que la perspective et la vue à vol d'oiseau) dans la conduite autonome, en particulier comment transformer efficacement les caractéristiques de l'espace en perspective (PV) en vue à vol d'oiseau (BEV). implémenté via le module Visual Transformation (VT). Les méthodes existantes sont globalement divisées en deux stratégies : la conversion 2D en 3D et la conversion 3D en 2D. Les méthodes 2D vers 3D améliorent les caractéristiques 2D denses en prédisant les probabilités de profondeur, mais l'incertitude inhérente aux prévisions de profondeur, en particulier dans les régions éloignées, peut introduire des inexactitudes. Alors que les méthodes 3D vers 2D utilisent généralement des requêtes 3D pour échantillonner des fonctionnalités 2D et apprendre les poids d'attention de la correspondance entre les fonctionnalités 3D et 2D via un transformateur, ce qui augmente le temps de calcul et de déploiement.

Le premier modèle mondial de génération de vidéos de scènes de conduite autonomes multi-vues DrivingDiffusion : nouvelles idées pour les données et la simulation BEV

Oct 23, 2023 am 11:13 AM

Le premier modèle mondial de génération de vidéos de scènes de conduite autonomes multi-vues DrivingDiffusion : nouvelles idées pour les données et la simulation BEV

Oct 23, 2023 am 11:13 AM

Quelques réflexions personnelles de l'auteur Dans le domaine de la conduite autonome, avec le développement de sous-tâches/solutions de bout en bout basées sur BEV, les données d'entraînement multi-vues de haute qualité et la construction de scènes de simulation correspondantes sont devenues de plus en plus importantes. En réponse aux problèmes des tâches actuelles, la « haute qualité » peut être divisée en trois aspects : des scénarios à longue traîne dans différentes dimensions : comme les véhicules à courte portée dans les données sur les obstacles et les angles de cap précis lors du découpage des voitures, et les données sur les lignes de voie. . Scènes telles que des courbes avec des courbures différentes ou des rampes/fusions/fusions difficiles à capturer. Celles-ci reposent souvent sur de grandes quantités de données collectées et sur des stratégies complexes d’exploration de données, qui sont coûteuses. Valeur réelle 3D - image hautement cohérente : l'acquisition actuelle des données BEV est souvent affectée par des erreurs d'installation/calibrage du capteur, des cartes de haute précision et l'algorithme de reconstruction lui-même. cela m'a amené à

'Minecraft' se transforme en une ville IA et les habitants des PNJ jouent comme de vraies personnes

Jan 02, 2024 pm 06:25 PM

'Minecraft' se transforme en une ville IA et les habitants des PNJ jouent comme de vraies personnes

Jan 02, 2024 pm 06:25 PM

Veuillez noter que cet homme carré fronça les sourcils, pensant à l'identité des « invités non invités » devant lui. Il s’est avéré qu’elle se trouvait dans une situation dangereuse, et une fois qu’elle s’en est rendu compte, elle a rapidement commencé une recherche mentale pour trouver une stratégie pour résoudre le problème. Finalement, elle a décidé de fuir les lieux, de demander de l'aide le plus rapidement possible et d'agir immédiatement. En même temps, la personne de l'autre côté pensait la même chose qu'elle... Il y avait une telle scène dans "Minecraft" où tous les personnages étaient contrôlés par l'intelligence artificielle. Chacun d’eux a un cadre identitaire unique. Par exemple, la jeune fille mentionnée précédemment est une coursière de 17 ans mais intelligente et courageuse. Ils ont la capacité de se souvenir, de penser et de vivre comme des humains dans cette petite ville de Minecraft. Ce qui les anime est une toute nouvelle,

Comment éditer des photos sur iPhone avec iOS 17

Nov 30, 2023 pm 11:39 PM

Comment éditer des photos sur iPhone avec iOS 17

Nov 30, 2023 pm 11:39 PM

La photographie mobile a fondamentalement changé la façon dont nous capturons et partageons les moments de la vie. L’avènement des smartphones, notamment de l’iPhone, a joué un rôle clé dans cette évolution. Connu pour sa technologie d'appareil photo avancée et ses fonctionnalités d'édition conviviales, l'iPhone est devenu le premier choix des photographes amateurs et expérimentés. Le lancement d’iOS 17 marque une étape importante dans ce voyage. La dernière mise à jour d'Apple apporte un ensemble amélioré de fonctionnalités de retouche photo, offrant aux utilisateurs une boîte à outils plus puissante pour transformer leurs instantanés quotidiens en images visuellement attrayantes et artistiquement riches. Ce développement technologique simplifie non seulement le processus photographique, mais ouvre également de nouvelles voies d'expression créative, permettant aux utilisateurs d'injecter sans effort une touche professionnelle à leurs photos.

Revoir! Fusion profonde de modèles (LLM/modèle de base/apprentissage fédéré/mise au point, etc.)

Apr 18, 2024 pm 09:43 PM

Revoir! Fusion profonde de modèles (LLM/modèle de base/apprentissage fédéré/mise au point, etc.)

Apr 18, 2024 pm 09:43 PM

Le 23 septembre, l'article « DeepModelFusion:ASurvey » a été publié par l'Université nationale de technologie de la défense, JD.com et l'Institut de technologie de Pékin. La fusion/fusion de modèles profonds est une technologie émergente qui combine les paramètres ou les prédictions de plusieurs modèles d'apprentissage profond en un seul modèle. Il combine les capacités de différents modèles pour compenser les biais et les erreurs des modèles individuels pour de meilleures performances. La fusion profonde de modèles sur des modèles d'apprentissage profond à grande échelle (tels que le LLM et les modèles de base) est confrontée à certains défis, notamment un coût de calcul élevé, un espace de paramètres de grande dimension, l'interférence entre différents modèles hétérogènes, etc. Cet article divise les méthodes de fusion de modèles profonds existantes en quatre catégories : (1) « Connexion de modèles », qui relie les solutions dans l'espace de poids via un chemin de réduction des pertes pour obtenir une meilleure fusion de modèles initiale.

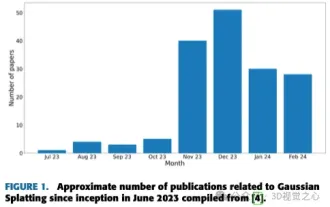

Plus qu'une simple gaussienne 3D ! Dernier aperçu des techniques de reconstruction 3D de pointe

Jun 02, 2024 pm 06:57 PM

Plus qu'une simple gaussienne 3D ! Dernier aperçu des techniques de reconstruction 3D de pointe

Jun 02, 2024 pm 06:57 PM

Écrit ci-dessus & La compréhension personnelle de l'auteur est que la reconstruction 3D basée sur l'image est une tâche difficile qui implique de déduire la forme 3D d'un objet ou d'une scène à partir d'un ensemble d'images d'entrée. Les méthodes basées sur l’apprentissage ont attiré l’attention pour leur capacité à estimer directement des formes 3D. Cet article de synthèse se concentre sur les techniques de reconstruction 3D de pointe, notamment la génération de nouvelles vues inédites. Un aperçu des développements récents dans les méthodes d'éclaboussure gaussienne est fourni, y compris les types d'entrée, les structures de modèle, les représentations de sortie et les stratégies de formation. Les défis non résolus et les orientations futures sont également discutés. Compte tenu des progrès rapides dans ce domaine et des nombreuses opportunités d’améliorer les méthodes de reconstruction 3D, un examen approfondi de l’algorithme semble crucial. Par conséquent, cette étude fournit un aperçu complet des progrès récents en matière de diffusion gaussienne. (Faites glisser votre pouce vers le haut