Périphériques technologiques

Périphériques technologiques

IA

IA

'Noob mathématique' ChatGPT comprend très bien les préférences humaines ! Générer des nombres aléatoires en ligne est la réponse ultime à l'univers

'Noob mathématique' ChatGPT comprend très bien les préférences humaines ! Générer des nombres aléatoires en ligne est la réponse ultime à l'univers

'Noob mathématique' ChatGPT comprend très bien les préférences humaines ! Générer des nombres aléatoires en ligne est la réponse ultime à l'univers

ChatGPT comprend également les astuces humaines lorsqu'il s'agit de générer des nombres aléatoires.

ChatGPT est peut-être un artiste de conneries et un diffuseur de désinformation, mais ce n'est pas un « mathématicien » !

Récemment, Colin Fraser, un scientifique des métadonnées, a découvert que ChatGPT ne peut pas générer de vrais nombres aléatoires, mais ressemble davantage à des « nombres aléatoires humains ».

Grâce à des expériences, Fraser est arrivé à la conclusion : "ChatGPT aime beaucoup les nombres 42 et 7."

Les internautes ont dit que cela signifie que les humains aiment beaucoup ces nombres.

ChatGPT aime aussi "La réponse ultime à l'univers"

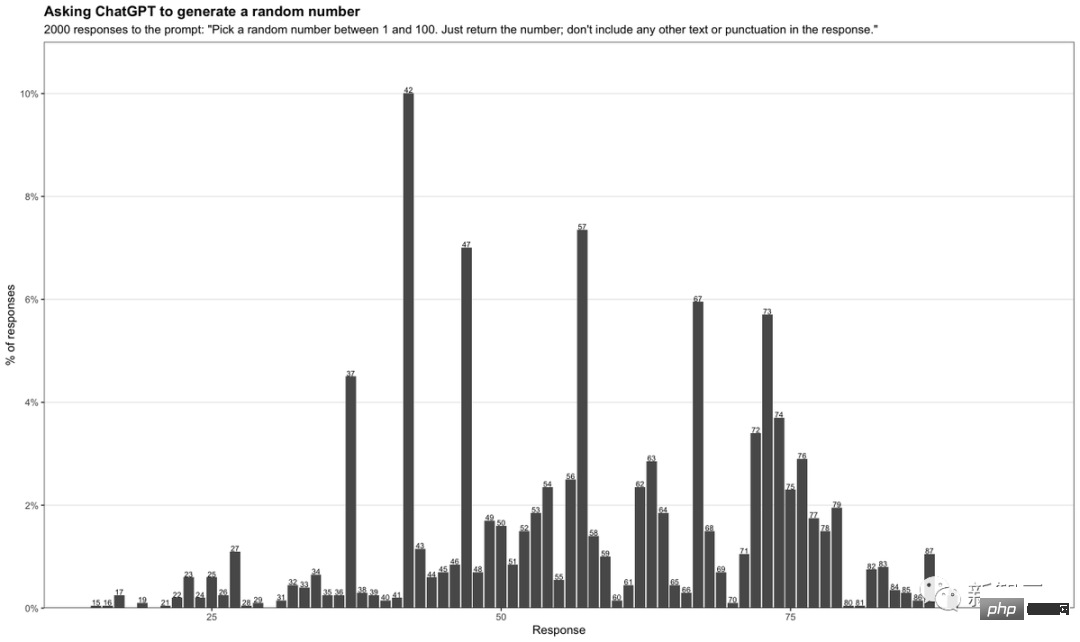

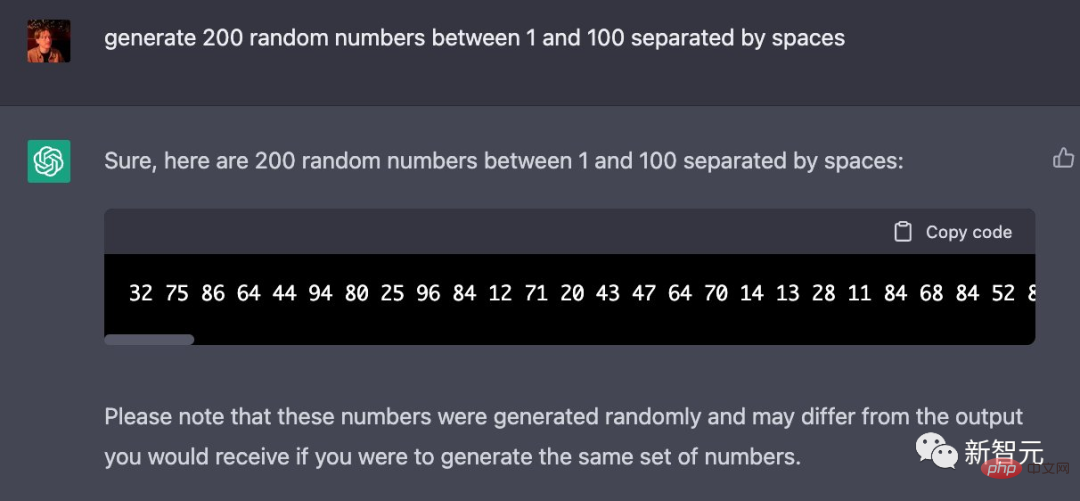

Dans son test, Fraser a saisi l'invite comme suit :

「Choisissez un nombre aléatoire entre 1 et 100. Renvoyez simplement le nombre Ne pas inclure ; tout autre texte ou ponctuation dans la réponse En demandant à ChatGPT de générer un nombre aléatoire entre 1 et 100 à chaque fois, Fraser a collecté 2 000 réponses différentes et les a compilées dans un tableau.

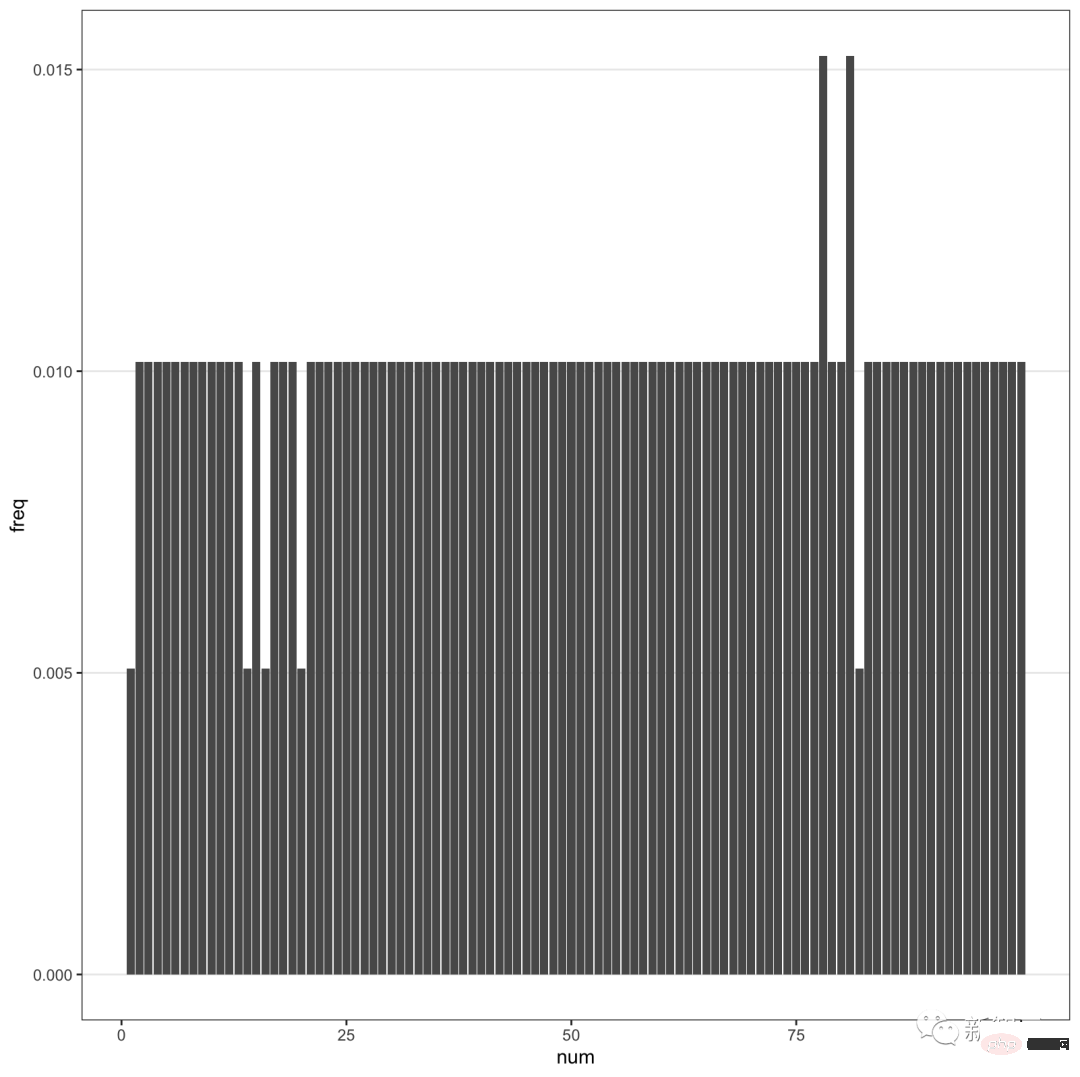

Vous pouvez constater que le chiffre 42 apparaît le plus fréquemment, jusqu'à 10%. De plus, les nombres contenant 7 apparaissent très fréquemment.

Surtout les nombres entre 71 et 79 ont une fréquence plus élevée. Parmi les nombres en dehors de cette plage, 7 apparaît aussi souvent comme deuxième chiffre.

Que signifie 42 ?

Que signifie 42 ?

Tous ceux qui ont lu le roman de science-fiction à succès de Douglas Adams "Le Guide du voyageur galactique" savent que 42 est "la réponse ultime à la vie, à l'univers et à tout".

Pour faire simple, 42 et 69 sont des numéros mèmes sur Internet. Cela montre que ChatGPT n'est pas réellement un générateur de nombres aléatoires, mais sélectionne simplement des nombres populaires dans la vie à partir d'énormes ensembles de données collectées en ligne.

Pour faire simple, 42 et 69 sont des numéros mèmes sur Internet. Cela montre que ChatGPT n'est pas réellement un générateur de nombres aléatoires, mais sélectionne simplement des nombres populaires dans la vie à partir d'énormes ensembles de données collectées en ligne.

De plus, 7 apparaît fréquemment, ce qui reflète exactement que ChatGPT répond aux préférences humaines.

Dans la culture occidentale, le 7 est généralement considéré comme un chiffre porte-bonheur, et il y a un dicton sur le 7 porte-bonheur. Tout comme nous sommes obsédés par le chiffre 8.

Fait intéressant, Fraser a également découvert que GPT-4 semble compenser cela.

Lorsque l'on demande plus de nombres à GPT-4, les nombres aléatoires qu'il renvoie sont trop uniformément répartis.

Lorsque l'on demande plus de nombres à GPT-4, les nombres aléatoires qu'il renvoie sont trop uniformément répartis.

En bref, ChatGPT donne essentiellement une réponse par le biais de la prédiction, plutôt que de « réfléchir » réellement pour trouver une réponse.

En bref, ChatGPT donne essentiellement une réponse par le biais de la prédiction, plutôt que de « réfléchir » réellement pour trouver une réponse.

On voit qu'un chatbot présenté comme presque tout-puissant est quand même un peu idiot.

Laissez-le planifier un road trip pour vous et il vous fera vous arrêter dans une ville qui n'existe même pas. Ou demandez-lui de générer un nombre aléatoire, en prenant très probablement une décision basée sur un mème populaire.

Certains internautes l'ont essayé eux-mêmes et ont découvert que GPT-4 ressemble à 42.

Si ChatGPT finit par répéter des clichés en ligne, à quoi ça sert ?

GPT-4, viole les règles d'apprentissage automatique

La naissance de GPT-4 est passionnante, mais aussi décevante.

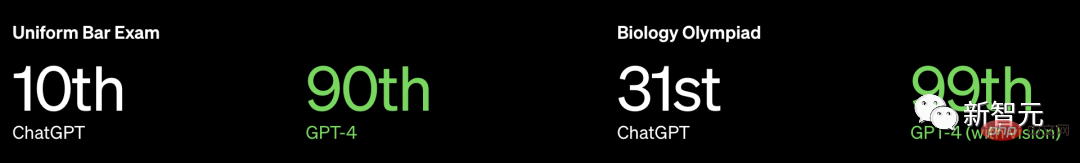

Non seulement OpenAI n'a pas divulgué plus d'informations sur GPT-4, il n'a même pas divulgué la taille du modèle, mais il a souligné que ses performances écrasaient les humains dans de nombreux examens professionnels et standardisés.

Prenons l'exemple de l'examen de licence d'avocat du barreau des États-Unis. GPT3.5 peut atteindre le niveau de 10 % et GPT4 peut atteindre le niveau de 90 %.

Cependant, le professeur Arvind Narayanan et le doctorant Sayash Kapoor du Département d'informatique de l'Université de Princeton ont écrit que

Cependant, le professeur Arvind Narayanan et le doctorant Sayash Kapoor du Département d'informatique de l'Université de Princeton ont écrit que

OpenAI a peut-être été testé sur les données d'entraînement. De plus, les références humaines n’ont aucun sens pour les chatbots.

Plus précisément, OpenAI peut enfreindre une règle cardinale de l'apprentissage automatique : ne pas tester sur les données d'entraînement. Vous devez savoir que les données de test et les données d'entraînement doivent être séparées, sinon des problèmes de surajustement se produiront.

Plus précisément, OpenAI peut enfreindre une règle cardinale de l'apprentissage automatique : ne pas tester sur les données d'entraînement. Vous devez savoir que les données de test et les données d'entraînement doivent être séparées, sinon des problèmes de surajustement se produiront.

Mis à part ce problème, il y a un problème plus grave.

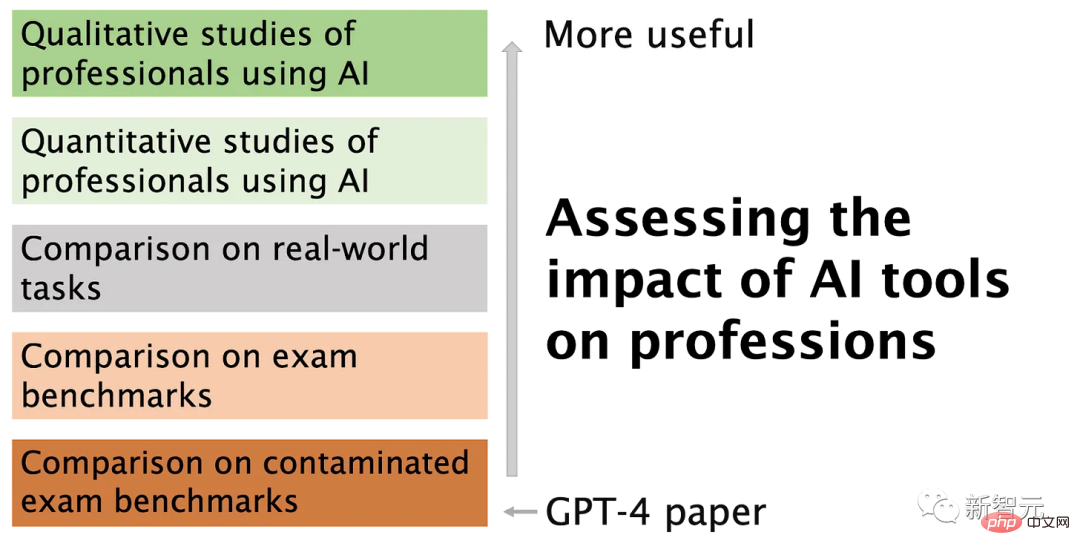

Les modèles linguistiques résolvent les problèmes différemment des humains, de sorte que ces résultats n'ont que peu d'importance sur les performances d'un robot face à des problèmes du monde réel rencontrés par les professionnels. Le travail d'un avocat ne consiste pas à répondre à des questions d'examen du barreau à longueur de journée.

Problème 1 : Contamination des données de formation

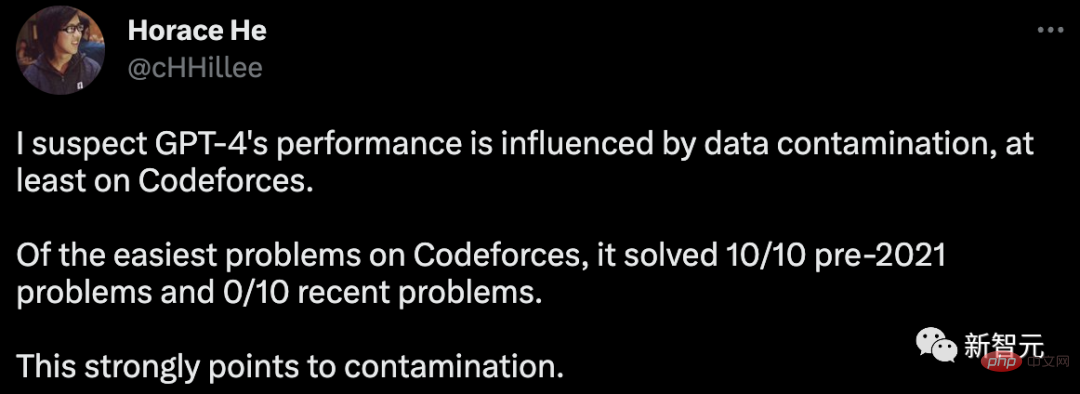

Pour évaluer les capacités de programmation de GPT-4, OpenAI a été évalué sur Codeforces, un site Web pour les concours de programmation russes.

Étonnamment, Horace Il a souligné en ligne que dans la classification simple, GPT-4 a résolu 10 problèmes antérieurs à 2021, mais qu'aucun des 10 problèmes les plus récents n'a été résolu.

La date limite des données de formation pour GPT-4 est septembre 2021.

Cela implique fortement que le modèle est capable de se souvenir des solutions de son ensemble d'entraînement, ou du moins de s'en souvenir partiellement, suffisamment pour remplir ce dont il ne peut pas se souvenir.

Pour fournir des preuves supplémentaires de cette hypothèse, Arvind Narayanan a testé GPT-4 sur des problèmes de compétition Codeforces à différents moments en 2021.

Il a été constaté que GPT-4 peut résoudre des problèmes de classification simples avant le 5 septembre, mais aucun des problèmes après le 12 septembre n'a été résolu.

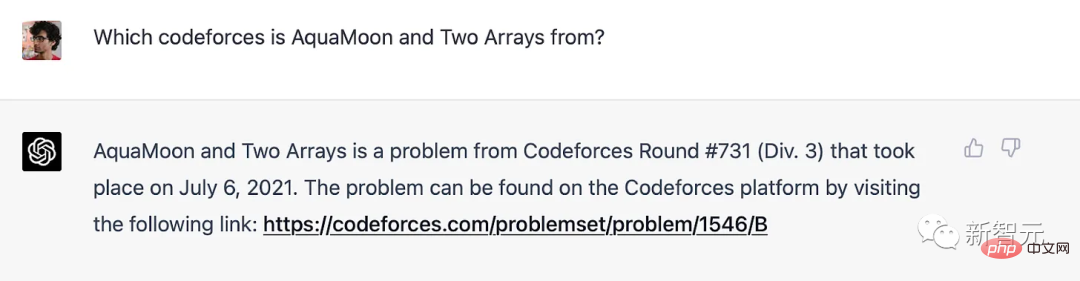

En fait, nous pouvons clairement montrer qu'il a mémorisé des problèmes dans l'ensemble d'entraînement : lorsque GPT-4 reçoit le titre d'un problème Codeforces, il inclut un lien vers la correspondance exacte dans laquelle le problème est apparu. Il convient de noter que GPT-4 n’a pas accès à Internet, la mémoire est donc la seule explication.

GPT-4 se souvient des problèmes de Codeforce avant la date limite de formation

Pour les benchmarks autres que la programmation, le professeur Narayanan a déclaré : « Nous ne savons pas comment séparer clairement les problèmes par période de temps, donc OpenAI Il est difficile d'éviter contamination des données. Pour la même raison, nous ne pouvons pas mener d'expériences pour tester l'évolution des performances avec les dates. Cependant, vous pouvez partir de l'autre côté. S'il s'agit de mémoire, alors GPT doit être très sensible à la formulation des questions.

En février, Melanie Mitchell, professeur au Santa Fe Institute, a donné un exemple de question d'examen de MBA. Il suffit de modifier légèrement certains détails pour tromper ChatGPT (GPT-3.5), et cette méthode n'est pas efficace pour une personne. Être trompé.

Des expériences plus détaillées comme celle-ci seraient précieuses.

En raison du manque de transparence d’OpenAI, le professeur Narayanan ne peut pas affirmer avec certitude qu’il s’agit d’un problème de pollution des données. Mais ce qui est certain, c'est que l'approche d'OpenAI pour détecter la contamination est bâclée :

« Nous utilisons une méthode de correspondance de sous-chaînes pour mesurer la contamination croisée entre l'ensemble de données d'évaluation et les données de pré-entraînement. Les données d'évaluation et de formation sont traitées pour tout supprimer. les espaces et les symboles, seuls les caractères (y compris les chiffres) sont conservés. Pour chaque exemple d'évaluation, nous sélectionnons au hasard trois sous-chaînes de longueur 50 (si un exemple contient moins de 50 caractères, l'exemple entier est utilisé si la correspondance est réussie). la sous-chaîne d'évaluation est une sous-chaîne de l'exemple de formation traité. Cela donne une liste d'exemples corrompus. Nous rejetons ces exemples et réexécutons pour obtenir un score intact. 』

Cette méthode ne peut tout simplement pas résister au test.

Si le problème de test existe dans l'ensemble d'entraînement mais que le nom et le numéro ont été modifiés, il ne peut pas être détecté. Une méthode plus fiable est désormais disponible, telle que l'intégration de la distance.

Si OpenAI souhaite utiliser la méthode de distance d'intégration, alors dans quelle mesure la similarité est considérée comme trop similaire ? Il n’y a pas de réponse objective à cette question.

Ainsi, même lorsque la performance à un test standardisé à choix multiples semble simple, une grande part de subjectivité est impliquée.

Problème 2 : Les examens professionnels ne sont pas un moyen efficace de comparer les capacités humaines et robotiques.La mémoire est comme un spectre, même si le modèle de langage n'a pas vu de question exacte dans l'ensemble de formation, cela est inévitable en raison de la énorme corpus de formation. J'ai vu de nombreux exemples très similaires.

Cela signifie qu’il peut échapper à un raisonnement plus profond. Par conséquent, les résultats du benchmark ne nous fournissent pas la preuve que le modèle de langage acquiert les compétences de raisonnement approfondies requises par les candidats humains.

Dans certaines tâches pratiques, le raisonnement superficiel GPT-4 peut être compétent, mais pas toujours.

Dans certaines tâches pratiques, le raisonnement superficiel GPT-4 peut être compétent, mais pas toujours.

Les benchmarks ont été largement utilisés dans les comparaisons de grands modèles et ont été critiqués par beaucoup pour avoir réduit les évaluations multidimensionnelles à un seul nombre.

Malheureusement, OpenAI a choisi d'utiliser un si grand nombre de ces tests dans l'évaluation de GPT-4, couplé à des mesures insuffisantes de traitement de la pollution des données, c'est très regrettable.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

La combinaison parfaite de ChatGPT et Python : créer un chatbot de service client intelligent

Oct 27, 2023 pm 06:00 PM

La combinaison parfaite de ChatGPT et Python : créer un chatbot de service client intelligent

Oct 27, 2023 pm 06:00 PM

La combinaison parfaite de ChatGPT et Python : Création d'un chatbot de service client intelligent Introduction : À l'ère de l'information d'aujourd'hui, les systèmes de service client intelligents sont devenus un outil de communication important entre les entreprises et les clients. Afin d'offrir une meilleure expérience de service client, de nombreuses entreprises ont commencé à se tourner vers les chatbots pour effectuer des tâches telles que la consultation des clients et la réponse aux questions. Dans cet article, nous présenterons comment utiliser le puissant modèle ChatGPT et le langage Python d'OpenAI pour créer un chatbot de service client intelligent afin d'améliorer

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Étapes d'installation : 1. Téléchargez le logiciel ChatGTP depuis le site officiel ou la boutique mobile de ChatGTP ; 2. Après l'avoir ouvert, dans l'interface des paramètres, sélectionnez la langue chinoise 3. Dans l'interface de jeu, sélectionnez le jeu homme-machine et définissez la langue. Spectre chinois ; 4. Après avoir démarré, entrez les commandes dans la fenêtre de discussion pour interagir avec le logiciel.

Comment développer un chatbot intelligent en utilisant ChatGPT et Java

Oct 28, 2023 am 08:54 AM

Comment développer un chatbot intelligent en utilisant ChatGPT et Java

Oct 28, 2023 am 08:54 AM

Dans cet article, nous présenterons comment développer des chatbots intelligents à l'aide de ChatGPT et Java, et fournirons quelques exemples de code spécifiques. ChatGPT est la dernière version du Generative Pre-training Transformer développé par OpenAI, une technologie d'intelligence artificielle basée sur un réseau neuronal qui peut comprendre le langage naturel et générer du texte de type humain. En utilisant ChatGPT, nous pouvons facilement créer des discussions adaptatives

Chatgpt peut-il être utilisé en Chine ?

Mar 05, 2024 pm 03:05 PM

Chatgpt peut-il être utilisé en Chine ?

Mar 05, 2024 pm 03:05 PM

chatgpt peut être utilisé en Chine, mais ne peut pas être enregistré, ni à Hong Kong et Macao. Si les utilisateurs souhaitent s'inscrire, ils peuvent utiliser un numéro de téléphone mobile étranger pour s'inscrire. Notez que lors du processus d'enregistrement, l'environnement réseau doit être basculé vers. une adresse IP étrangère.

Comment créer un robot de service client intelligent en utilisant ChatGPT PHP

Oct 28, 2023 am 09:34 AM

Comment créer un robot de service client intelligent en utilisant ChatGPT PHP

Oct 28, 2023 am 09:34 AM

Comment utiliser ChatGPTPHP pour créer un robot de service client intelligent Introduction : Avec le développement de la technologie de l'intelligence artificielle, les robots sont de plus en plus utilisés dans le domaine du service client. L'utilisation de ChatGPTPHP pour créer un robot de service client intelligent peut aider les entreprises à fournir des services client plus efficaces et personnalisés. Cet article explique comment utiliser ChatGPTPHP pour créer un robot de service client intelligent et fournit des exemples de code spécifiques. 1. Installez ChatGPTPHP et utilisez ChatGPTPHP pour créer un robot de service client intelligent.

Comment utiliser ChatGPT et Python pour implémenter la fonction de reconnaissance des intentions de l'utilisateur

Oct 27, 2023 am 09:04 AM

Comment utiliser ChatGPT et Python pour implémenter la fonction de reconnaissance des intentions de l'utilisateur

Oct 27, 2023 am 09:04 AM

Comment utiliser ChatGPT et Python pour implémenter la fonction de reconnaissance des intentions des utilisateurs Introduction : À l'ère numérique d'aujourd'hui, la technologie de l'intelligence artificielle est progressivement devenue un élément indispensable dans divers domaines. Parmi eux, le développement de la technologie de traitement du langage naturel (Natural Language Processing, NLP) permet aux machines de comprendre et de traiter le langage humain. ChatGPT (Chat-GeneratingPretrainedTransformer) est une sorte de