Périphériques technologiques

Périphériques technologiques

IA

IA

Guide d'utilisation du plug-in ChatGPT pour débloquer une nouvelle expérience Internet

Guide d'utilisation du plug-in ChatGPT pour débloquer une nouvelle expérience Internet

Guide d'utilisation du plug-in ChatGPT pour débloquer une nouvelle expérience Internet

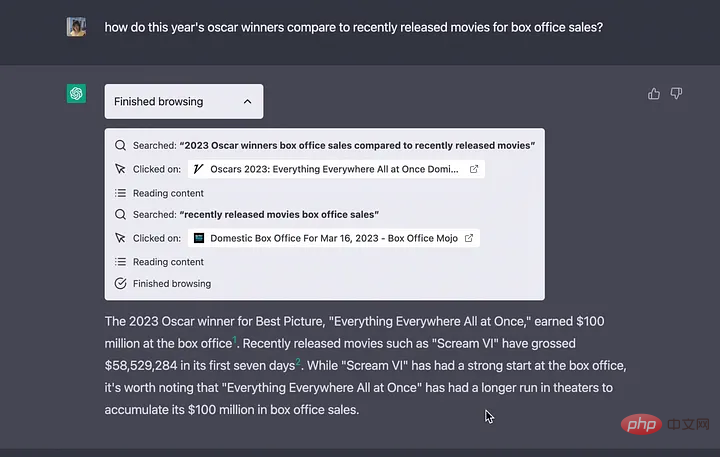

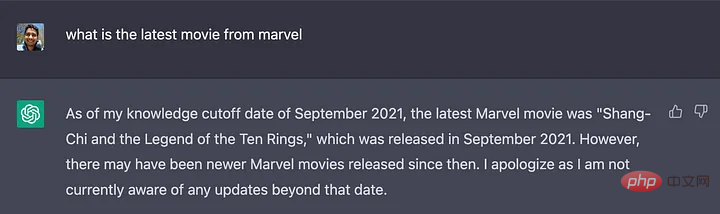

La base de connaissances de ChatGPT a été formée avec des données datant de septembre 2021, mais en utilisant ces plugins, ChatGPT est désormais capable de rechercher sur le Web les dernières réponses, supprimant ainsi les limites de s'appuyer uniquement sur sa base de connaissances.

Récemment, OpenAI a publié une nouvelle fonctionnalité de ChatGPT : le système de plug-in. ChatGPT peut désormais être étendu avec des fonctionnalités et effectuer de nouvelles tâches, telles que :

- Récupérer des informations en temps réel : par exemple, les résultats sportifs, les cours des actions, les dernières actualités, etc.

- Récupérer les informations de la base de connaissances : par exemple, des documents d'entreprise, des notes personnelles, etc.

- Effectuer des actions au nom de l'utilisateur : par exemple, réserver un vol, commander de la nourriture, etc. La base de connaissances de

La base de connaissances de ChatGPT a été formée avec des données à partir de septembre 2021, mais en utilisant ces plugins, ChatGPT est désormais capable de rechercher sur le Web les dernières réponses, supprimant ainsi les limites de s'appuyer uniquement sur sa base de connaissances.

Créer des plugins personnalisés

OpenAI permet également à tout développeur de créer ses propres plugins. Bien que les développeurs doivent actuellement s'inscrire sur une liste d'attente (https://openai.com/waitlist/plugins), les fichiers pour créer des plugins sont déjà disponibles.

Plus d'informations sur le processus de plug-in peuvent être trouvées sur cette page (https://platform.openai.com/docs/plugins/introduction).

Un exemple de code peut être trouvé sur cette page (https://platform.openai.com/docs/plugins/examples).

La documentation montre uniquement comment fonctionne l'intégration entre l'API tierce et ChatGPT. L'article suivant explorera le fonctionnement interne de cette intégration :

LangChain est un outil développé par Harrison Chase (hwchase17) en 2022 pour aider les développeurs à intégrer des applications tierces dans des modèles de langage étendus (LLM). Empruntez l'exemple ci-dessous pour expliquer son mode de fonctionnement :"Comment les grands modèles de langage effectuent-ils des opérations sans formation pertinente ?" réponse, résumé et plus encore

import os

import os

os.environ["OPENAI_API_KEY"] = "

from langchain.agents import load_tools

from langchain.agents import initialize_agentfrom langchain.llms import OpenAI

# Tout d'abord, chargez le modèle de langage à utiliser pour contrôler l'agent

llm = OpenAI(temperature=0)

# Continuer Venez et chargez quelques outils à utiliser. Veuillez noter que l'outil llm-math utilise LLM, vous devez donc le passer dans

tools = load_tools(["serpapi", "llm-math"], llm=llm)

# Enfin, utilisez les outils, le modèle de langage et que vous souhaitez utiliser le type d'agent pour initialiser l'agent

agent = initialize_agent(tools, llm, agent="zero-shot-react-description", verbose=True)

# Maintenant, testons

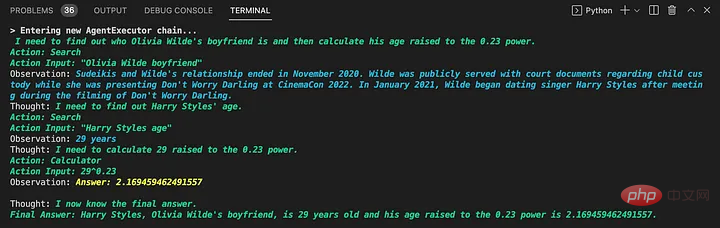

agent.run("Qui est Le petit ami d'Olivia Wilde ? Quel est son âge actuel à la puissance 0,23 ?")

Trois parties principales peuvent être vues à partir de cet exemple :

LLM : LLM est un composant essentiel de LangChain, qui aide l'agent à comprendre le langage naturel. Dans cet exemple, le modèle par défaut d’OpenAI est utilisé. Selon le code source (https://github.com/hwchase17/langchain/blob/master/langchain/llms/openai.py#L133), le modèle par défaut est text-davinci-003.

Agent : L'agent utilise LLM pour décider quelles actions entreprendre et dans quel ordre. Une action peut consister à utiliser un outil et à observer son résultat, ou à renvoyer une réponse à l'utilisateur.

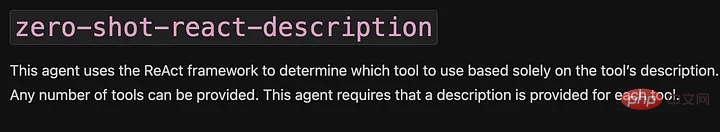

La description 0-shot-react est utilisée ici. Dans sa documentation, on peut lire que « cet agent utilise le framework ReAct et décide quel outil utiliser en fonction entièrement de la description de l'outil ». Ces informations seront utilisées ultérieurement.

- Outils : fonctions que les agents peuvent utiliser pour interagir avec le monde. Dans cet exemple, deux outils sont utilisés :

- serpapi : un wrapper autour de l'API https://serpapi.com/. Il est utilisé pour naviguer sur le Web.

- llm-math : permet à l'agent de répondre à des questions liées aux mathématiques dans des invites, telles que "Quel est son âge actuel élevé à la puissance 0,23 ?".

Lorsque le script est exécuté, l'agent fait plusieurs choses comme rechercher qui est le petit ami d'Olivia Wilde, extraire son nom, demander l'âge de Harry Style, effectuer une recherche et calculer 29 ^ 0,23 à l'aide de l'outil llm-math, soit 2,16.

Le plus gros avantage de LangChain est qu'il ne s'appuie pas sur un seul fournisseur, comme décrit dans la documentation (https://python.langchain.com/en/latest/modules/llms/integrations.html).

Pourquoi LangChain peut-il fournir des fonctions puissantes pour le système de plug-in ChatGPT ?

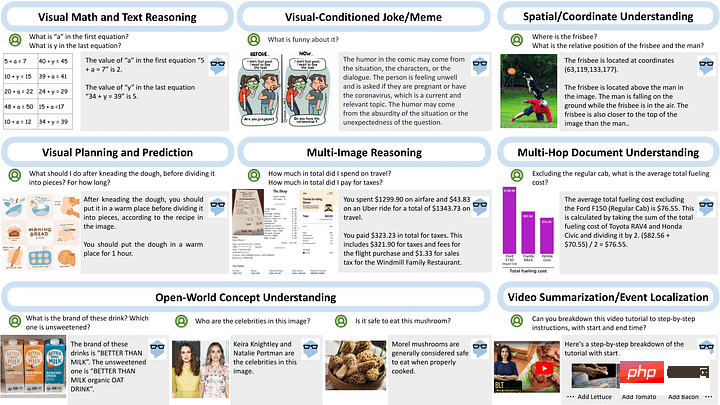

Le 21 mars, Microsoft, le partenaire le plus important d'OpenAI, a publié MM-REACT, révélant le raisonnement et les actions multimodaux de ChatGPT (https://github.com/microsoft/MM-REACT).

En examinant les capacités de ce « paradigme système », vous pouvez voir que chaque exemple implique une interaction entre un modèle de langage et une application externe.

En regardant l'exemple de code fourni (https://github.com/microsoft/MM-REACT/blob/main/sample.py), nous pouvons voir que l'implémentation de l'interaction modèle+outils utilise Fabriqué par LangChain. Le fichier README.md (https://github.com/microsoft/MM-REACT/blob/main/README.md) indique également que « le code de MM-REACT est basé sur langchain ».

En combinant ces preuves, ainsi que le fait que la documentation du plugin ChatGPT mentionne que « les descriptions des plugins, les demandes d'API et les réponses de l'API sont toutes insérées dans les conversations avec ChatGPT. » On peut supposer que le système de plugins ajoute différents plugins en tant qu'outils proxy. dans Dans ce cas, il s'agit de ChatGPT.

Il est également possible qu'OpenAI ait transformé ChatGPT en un proxy de type zero-shot-react-description pour prendre en charge ces plug-ins (le type que nous avons vu dans l'exemple précédent). La description de l’API étant insérée dans la conversation, elle correspond aux attentes de l’agent, comme on peut le voir dans l’extrait de documentation ci-dessous.

LangChain

Conclusion

Bien que le système de plug-in ne soit pas encore ouvert aux utilisateurs, vous pouvez utiliser les documents publiés et MM-REACT pour découvrir les puissantes fonctions du système de plug-in ChatGPT.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

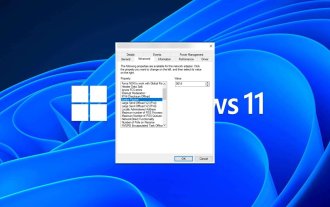

Comment ajuster la taille du MTU sur Windows 11

Aug 25, 2023 am 11:21 AM

Comment ajuster la taille du MTU sur Windows 11

Aug 25, 2023 am 11:21 AM

Si vous rencontrez soudainement une connexion Internet lente sous Windows 11 et que vous avez essayé toutes les astuces du livre, cela n'a peut-être rien à voir avec votre réseau et tout à voir avec votre unité de transmission maximale (MTU). Des problèmes peuvent survenir si votre système envoie ou reçoit des données avec une taille MTU incorrecte. Dans cet article, nous apprendrons comment modifier la taille du MTU sous Windows 11 pour une connexion Internet fluide et ininterrompue. Quelle est la taille MTU par défaut dans Windows 11 ? La taille MTU par défaut dans Windows 11 est de 1 500, ce qui correspond au maximum autorisé. MTU signifie unité de transmission maximale. Il s'agit de la taille maximale des paquets pouvant être envoyés ou reçus sur le réseau. chaque réseau de soutien

![Le module d'extension WLAN s'est arrêté [correctif]](https://img.php.cn/upload/article/000/465/014/170832352052603.gif?x-oss-process=image/resize,m_fill,h_207,w_330) Le module d'extension WLAN s'est arrêté [correctif]

Feb 19, 2024 pm 02:18 PM

Le module d'extension WLAN s'est arrêté [correctif]

Feb 19, 2024 pm 02:18 PM

S'il y a un problème avec le module d'extension WLAN sur votre ordinateur Windows, cela peut entraîner une déconnexion d'Internet. Cette situation est souvent frustrante, mais heureusement, cet article propose quelques suggestions simples qui peuvent vous aider à résoudre ce problème et à rétablir le bon fonctionnement de votre connexion sans fil. Réparer le module d'extensibilité WLAN s'est arrêté Si le module d'extensibilité WLAN a cessé de fonctionner sur votre ordinateur Windows, suivez ces suggestions pour le réparer : Exécutez l'utilitaire de résolution des problèmes réseau et Internet pour désactiver et réactiver les connexions réseau sans fil Redémarrez le service de configuration automatique WLAN Modifier les options d'alimentation Modifier Paramètres d'alimentation avancés Réinstaller le pilote de la carte réseau Exécuter certaines commandes réseau Examinons-le maintenant en détail

Comment résoudre l'erreur du serveur DNS Win11

Jan 10, 2024 pm 09:02 PM

Comment résoudre l'erreur du serveur DNS Win11

Jan 10, 2024 pm 09:02 PM

Nous devons utiliser le DNS correct lors de la connexion à Internet pour accéder à Internet. De la même manière, si nous utilisons des paramètres DNS incorrects, cela entraînera une erreur du serveur DNS. À ce stade, nous pouvons essayer de résoudre le problème en sélectionnant d'obtenir automatiquement le DNS dans les paramètres réseau. solutions. Comment résoudre l'erreur du serveur DNS du réseau Win11. Méthode 1 : Réinitialiser le DNS 1. Tout d'abord, cliquez sur Démarrer dans la barre des tâches pour entrer, recherchez et cliquez sur le bouton icône « Paramètres ». 2. Cliquez ensuite sur la commande d'option "Réseau et Internet" dans la colonne de gauche. 3. Recherchez ensuite l'option « Ethernet » sur la droite et cliquez pour entrer. 4. Après cela, cliquez sur "Modifier" dans l'attribution du serveur DNS et définissez enfin DNS sur "Automatique (D

Corrigez les téléchargements « Échec de l'erreur réseau » sur Chrome, Google Drive et Photos !

Oct 27, 2023 pm 11:13 PM

Corrigez les téléchargements « Échec de l'erreur réseau » sur Chrome, Google Drive et Photos !

Oct 27, 2023 pm 11:13 PM

Qu'est-ce que le problème « Échec du téléchargement de l'erreur réseau » ? Avant d’aborder les solutions, comprenons d’abord ce que signifie le problème « Échec du téléchargement de l’erreur réseau ». Cette erreur se produit généralement lorsque la connexion réseau est interrompue pendant le téléchargement. Cela peut se produire pour diverses raisons telles qu'une faible connexion Internet, une congestion du réseau ou des problèmes de serveur. Lorsque cette erreur se produit, le téléchargement s'arrêtera et un message d'erreur s'affichera. Comment réparer l’échec du téléchargement avec une erreur réseau ? Faire face à « Échec du téléchargement d'une erreur réseau » peut devenir un obstacle lors de l'accès ou du téléchargement des fichiers nécessaires. Que vous utilisiez des navigateurs comme Chrome ou des plateformes comme Google Drive et Google Photos, cette erreur apparaîtra, provoquant des désagréments. Vous trouverez ci-dessous des points pour vous aider à naviguer et à résoudre ce problème.

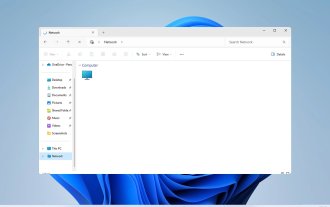

Correctif : WD My Cloud n'apparaît pas sur le réseau sous Windows 11

Oct 02, 2023 pm 11:21 PM

Correctif : WD My Cloud n'apparaît pas sur le réseau sous Windows 11

Oct 02, 2023 pm 11:21 PM

Si WDMyCloud n'apparaît pas sur le réseau sous Windows 11, cela peut être un gros problème, surtout si vous y stockez des sauvegardes ou d'autres fichiers importants. Cela peut constituer un gros problème pour les utilisateurs qui ont fréquemment besoin d'accéder au stockage réseau. Dans le guide d'aujourd'hui, nous allons donc vous montrer comment résoudre ce problème de manière permanente. Pourquoi WDMyCloud n'apparaît-il pas sur le réseau Windows 11 ? Votre appareil MyCloud, votre adaptateur réseau ou votre connexion Internet n'est pas configuré correctement. La fonction SMB n'est pas installée sur l'ordinateur. Un problème temporaire dans Winsock peut parfois être à l'origine de ce problème. Que dois-je faire si mon cloud n'apparaît pas sur le réseau ? Avant de commencer à résoudre le problème, vous pouvez effectuer quelques vérifications préliminaires :

Que dois-je faire si la Terre s'affiche dans le coin inférieur droit de Windows 10 alors que je ne peux pas accéder à Internet Diverses solutions au problème selon lequel la Terre ne peut pas accéder à Internet dans Win10 ?

Feb 29, 2024 am 09:52 AM

Que dois-je faire si la Terre s'affiche dans le coin inférieur droit de Windows 10 alors que je ne peux pas accéder à Internet Diverses solutions au problème selon lequel la Terre ne peut pas accéder à Internet dans Win10 ?

Feb 29, 2024 am 09:52 AM

Cet article présentera la solution au problème selon lequel le symbole du globe s'affiche sur le réseau du système Win10 mais ne peut pas accéder à Internet. L'article fournira des étapes détaillées pour aider les lecteurs à résoudre le problème du réseau Win10 montrant que la Terre ne peut pas accéder à Internet. Méthode 1 : Redémarrez directement. Vérifiez d'abord si le câble réseau n'est pas correctement branché et si le haut débit est en retard. Dans ce cas, vous devez redémarrer le routeur ou le modem optique. Si aucune action importante n'est effectuée sur l'ordinateur, vous pouvez redémarrer l'ordinateur directement. La plupart des problèmes mineurs peuvent être rapidement résolus en redémarrant l'ordinateur. S’il est déterminé que le haut débit n’est pas en retard et que le réseau est normal, c’est une autre affaire. Méthode 2 : 1. Appuyez sur la touche [Win] ou cliquez sur [Menu Démarrer] dans le coin inférieur gauche. Dans l'élément de menu qui s'ouvre, cliquez sur l'icône d'engrenage au-dessus du bouton d'alimentation. Il s'agit de [Paramètres].

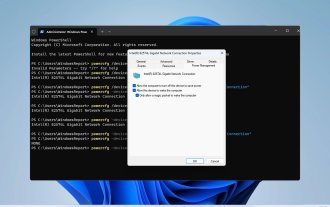

Comment activer/désactiver Wake on LAN dans Windows 11

Sep 06, 2023 pm 02:49 PM

Comment activer/désactiver Wake on LAN dans Windows 11

Sep 06, 2023 pm 02:49 PM

Wake on LAN est une fonctionnalité réseau sur Windows 11 qui vous permet de sortir votre ordinateur à distance de la veille prolongée ou du mode veille. Bien que les utilisateurs occasionnels ne l'utilisent pas souvent, cette fonctionnalité est utile pour les administrateurs réseau et les utilisateurs expérimentés utilisant des réseaux filaires, et aujourd'hui nous allons vous montrer comment la configurer. Comment savoir si mon ordinateur prend en charge Wake on LAN ? Pour utiliser cette fonctionnalité, votre ordinateur a besoin des éléments suivants : Le PC doit être connecté à une alimentation ATX afin que vous puissiez le sortir du mode veille à distance. Des listes de contrôle d'accès doivent être créées et ajoutées à tous les routeurs du réseau. La carte réseau doit prendre en charge la fonction Wake-up-on-LAN. Pour que cette fonctionnalité fonctionne, les deux ordinateurs doivent être sur le même réseau. Bien que la plupart des adaptateurs Ethernet utilisent

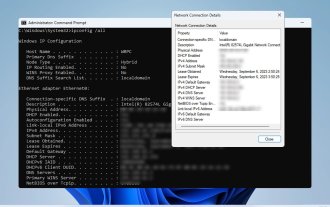

Comment vérifier les détails et l'état de la connexion réseau sous Windows 11

Sep 11, 2023 pm 02:17 PM

Comment vérifier les détails et l'état de la connexion réseau sous Windows 11

Sep 11, 2023 pm 02:17 PM

Afin de vous assurer que votre connexion réseau fonctionne correctement ou de résoudre le problème, vous devez parfois vérifier les détails de la connexion réseau sous Windows 11. En faisant cela, vous pouvez afficher diverses informations, notamment votre adresse IP, votre adresse MAC, la vitesse de la liaison, la version du pilote, etc., et dans ce guide, nous vous montrerons comment procéder. Comment trouver les détails de la connexion réseau sur Windows 11 ? 1. Utilisez l'application « Paramètres » et appuyez sur la touche + pour ouvrir les paramètres Windows. WindowsI Ensuite, accédez à Réseau et Internet dans le volet de gauche et sélectionnez votre type de réseau. Dans notre cas, il s'agit d'Ethernet. Si vous utilisez un réseau sans fil, sélectionnez plutôt un réseau Wi-Fi. Au bas de l'écran, vous devriez voir