Périphériques technologiques

Périphériques technologiques

IA

IA

En réexaminant le problème d'optimisation de Prompt, le biais de prédiction renforce l'apprentissage du contexte du modèle de langage

En réexaminant le problème d'optimisation de Prompt, le biais de prédiction renforce l'apprentissage du contexte du modèle de langage

En réexaminant le problème d'optimisation de Prompt, le biais de prédiction renforce l'apprentissage du contexte du modèle de langage

Les LLM ont obtenu de bonnes performances dans le cadre de l'apprentissage en contexte, mais choisir des exemples différents conduira à des performances complètement différentes. Un travail de recherche récent propose une stratégie de recherche rapide du point de vue du biais prédictif, et trouve approximativement la combinaison optimale d'exemples.

- Lien papier : https://arxiv.org/abs/2303.13217

- Lien code : https://github.com/MaHuanAAA/g_fair_searching

Introduction à la recherche

Grand modèle de langage dans l'apprentissage en contexte Démonstration Grâce à leur incroyable capacité, ces modèles peuvent apprendre à partir d'un contexte construit à partir de quelques exemples d'entrées et de sorties et être directement appliqués à de nombreuses tâches en aval sans optimisation fine. Cependant, des recherches antérieures ont montré que l'apprentissage contextuel peut présenter un degré élevé d'instabilité en raison de changements dans les exemples de formation, l'ordre des exemples et les formats d'invite. Par conséquent, la construction d’invites appropriées est cruciale pour améliorer les performances de l’apprentissage contextuel.

Les recherches précédentes étudient généralement cette question sous deux angles : (1) réglage rapide dans l'espace de codage (réglage rapide), (2) recherche dans l'espace d'origine (recherche rapide).

L'idée clé du réglage Prompt est d'injecter des intégrations spécifiques à une tâche dans des calques cachés, puis d'utiliser une optimisation basée sur le dégradé pour ajuster ces intégrations. Cependant, ces méthodes nécessitent de modifier le processus d'inférence original du modèle et d'obtenir le gradient du modèle, ce qui n'est pas pratique dans les services LLM boîte noire comme GPT-3 et ChatGPT. De plus, le réglage des indices introduit des coûts de calcul et de stockage supplémentaires, qui sont généralement coûteux pour le LLM.

Une approche plus réalisable et plus efficace consiste à optimiser les invites en recherchant dans l'espace de texte d'origine des échantillons et des séquences de démonstration approximatifs. Certains travaux génèrent des invites à partir de la « Vue globale » ou de la « Vue locale ». Les méthodes basées sur une vue globale optimisent généralement les différents éléments de l'invite dans son ensemble pour obtenir de meilleures performances. Par exemple, les approches guidées par la diversité [1] exploitent la diversité globale des démonstrations pour la recherche, ou tentent d'optimiser l'ensemble de l'ordre de combinaison d'échantillons [2] pour obtenir de meilleures performances. Contrairement à la vue globale, les méthodes basées sur la vue locale fonctionnent en concevant différents critères de sélection heuristiques, tels que KATE [3].

Mais ces méthodes ont leurs propres limites : (1) La plupart des recherches actuelles se concentrent principalement sur la recherche d'indices en fonction d'un seul facteur, tel que la sélection ou l'ordre des exemples. Cependant, l’impact global de chaque facteur sur la performance n’est pas clair. (2) Ces méthodes sont généralement basées sur des critères heuristiques et nécessitent une perspective unifiée pour expliquer leur fonctionnement. (3) Plus important encore, les méthodes existantes optimisent les indices globalement ou localement, ce qui peut conduire à des performances insatisfaisantes.

Cet article réexamine le problème de l'optimisation des invites dans le domaine de la PNL du point de vue du « biais de prédiction » et découvre un phénomène clé : la qualité d'une invite donnée dépend de son biais inhérent. Sur la base de ce phénomène, l'article propose un critère alternatif pour évaluer la qualité des invites basé sur le biais de prédiction. Cette métrique peut évaluer les invites via un seul processus direct sans avoir besoin d'un ensemble de développement supplémentaire.

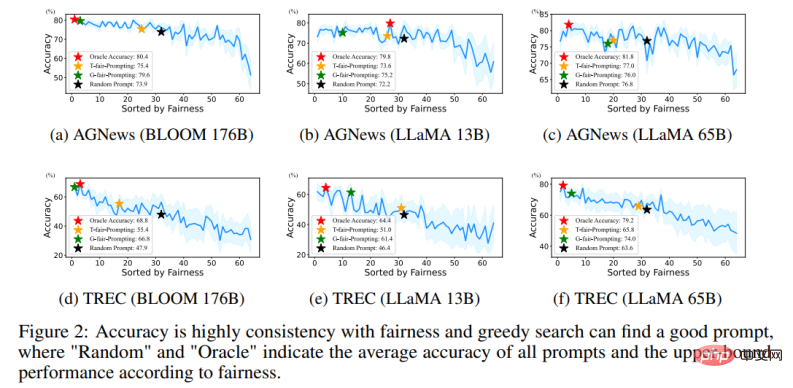

Plus précisément, en saisissant un test « sans contenu » à une invite donnée, le modèle est censé générer une distribution de prédiction uniforme (une entrée « sans contenu » ne contient aucune information utile). Par conséquent, l’uniformité de la distribution de prédiction est utilisée dans cet article pour représenter l’écart de prédiction d’une invite donnée. Ceci est similaire à la métrique utilisée par la méthode de post-étalonnage précédente [4], mais contrairement au post-étalonnage qui utilise cette métrique pour un post-étalonnage probabiliste sous une invite fixe, l'article explore plus en détail son application dans la recherche automatique d'invites approximatives. Et grâce à des expériences approfondies, nous avons confirmé la corrélation entre le biais inhérent à une invite donnée et sa performance moyenne à une tâche sur un ensemble de tests donné.

De plus, cette métrique basée sur les biais permet à la méthode de rechercher des invites appropriées d'une manière « locale à globale ». Cependant, un problème réaliste est qu’il n’est pas possible de rechercher la solution optimale en parcourant toutes les combinaisons car sa complexité dépasserait O (N !).

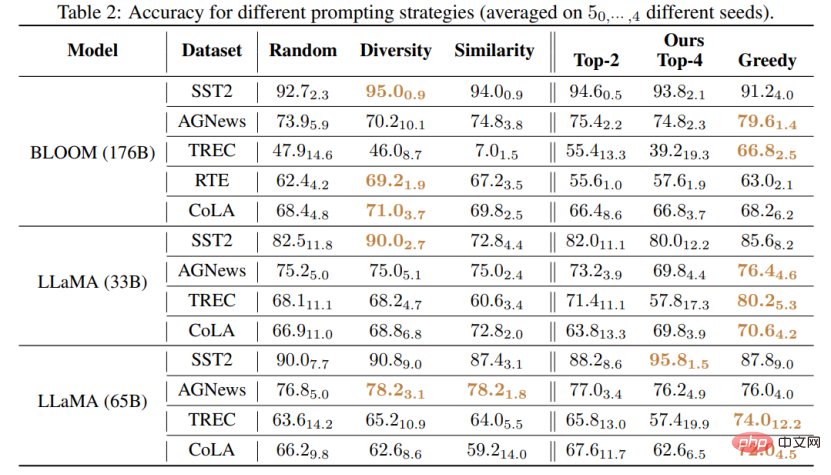

Ce travail propose deux nouvelles stratégies pour rechercher des invites de haute qualité de manière efficace : (1) T-fair-Prompting (2) G-fair-Prompting. T-fair-Prompting utilise une approche intuitive, calculant d'abord l'écart de chaque exemple individuellement pour former une invite, puis sélectionnant les exemples Top-k les plus justes à combiner dans l'invite finale. Cette stratégie est assez efficace, de complexité O (N). Mais il convient de noter que T-fair-Prompting repose sur l’hypothèse que l’invite optimale est généralement construite à partir des exemples les moins biaisés. Cependant, cela peut ne pas être vrai dans des situations pratiques et conduit souvent à des solutions locales optimales. Par conséquent, G-fair-Prompting est présenté davantage dans l'article pour améliorer la qualité de la recherche. G-fair-Prompting suit le processus régulier de recherche gourmande pour trouver la solution optimale en faisant des choix optimaux locaux à chaque étape. À chaque étape de l'algorithme, des exemples sont sélectionnés de telle sorte que l'invite mise à jour atteigne une équité optimale avec une complexité temporelle dans le pire des cas de O (N^2), améliorant considérablement la qualité de la recherche. G-fair-Prompting fonctionne dans une perspective locale vers globale, où le biais des échantillons individuels est pris en compte dès les premières étapes, tandis que les étapes ultérieures se concentrent sur la réduction du biais de prédiction global.

Résultats expérimentaux

Cette étude propose une méthode efficace et interprétable pour améliorer les performances d'apprentissage contextuel des modèles de langage, qui peut être appliquée à diverses tâches en aval. L'article vérifie l'efficacité de ces deux stratégies sur divers LLM (y compris la série de modèles GPT et la série LMaMA récemment publiée). Par rapport à la méthode SOTA, G-fair-Prompting a obtenu plus de 10 % d'amélioration relative sur différentes tâches en aval. .

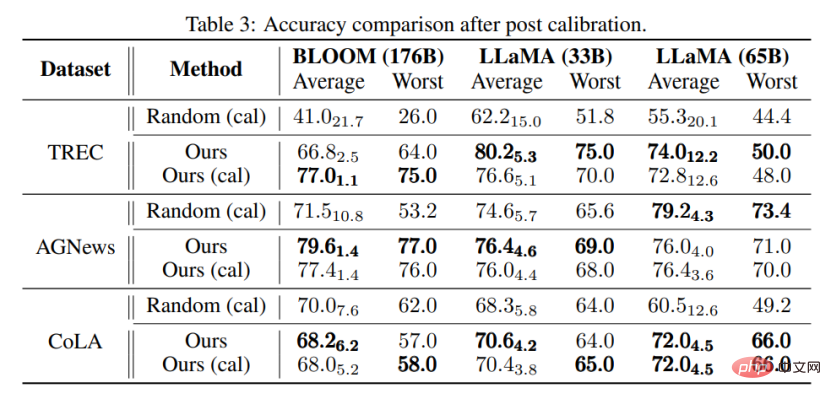

Ce qui se rapproche le plus de cette recherche est la méthode Calibration-before-use [4], qui utilisent toutes deux une entrée « sans contenu » pour améliorer les performances du modèle. Cependant, la méthode d'étalonnage avant utilisation est conçue pour utiliser cette norme pour calibrer la sortie, ce qui reste sensible à la qualité des exemples utilisés. En revanche, cet article vise à parcourir l'espace d'origine pour trouver une invite presque optimale pour améliorer les performances du modèle sans aucun post-traitement de la sortie du modèle. De plus, cet article est le premier à démontrer, par des expériences approfondies, le lien entre le biais de prédiction et la performance finale de la tâche, qui n'a pas encore été étudié dans les méthodes d'étalonnage avant utilisation.

On peut également constater grâce à des expériences que même sans calibrage, l'invite sélectionnée par la méthode proposée dans cet article peut être meilleure que l'invite calibrée sélectionnée au hasard. Cela montre que la méthode peut être pratique et efficace dans des applications pratiques et peut servir d’inspiration pour de futures recherches sur le traitement du langage naturel.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Une plongée approfondie dans les modèles, les données et les frameworks : une revue exhaustive de 54 pages de grands modèles de langage efficaces

Jan 14, 2024 pm 07:48 PM

Une plongée approfondie dans les modèles, les données et les frameworks : une revue exhaustive de 54 pages de grands modèles de langage efficaces

Jan 14, 2024 pm 07:48 PM

Les modèles linguistiques à grande échelle (LLM) ont démontré des capacités convaincantes dans de nombreuses tâches importantes, notamment la compréhension du langage naturel, la génération de langages et le raisonnement complexe, et ont eu un impact profond sur la société. Cependant, ces capacités exceptionnelles nécessitent des ressources de formation importantes (illustrées dans l’image de gauche) et de longs temps d’inférence (illustrés dans l’image de droite). Les chercheurs doivent donc développer des moyens techniques efficaces pour résoudre leurs problèmes d’efficacité. De plus, comme on peut le voir sur le côté droit de la figure, certains LLM (LanguageModels) efficaces tels que Mistral-7B ont été utilisés avec succès dans la conception et le déploiement de LLM. Ces LLM efficaces peuvent réduire considérablement la mémoire d'inférence tout en conservant une précision similaire à celle du LLaMA1-33B

La puissante combinaison de modèles de diffusion + super-résolution, la technologie derrière le générateur d'images de Google Imagen

Apr 10, 2023 am 10:21 AM

La puissante combinaison de modèles de diffusion + super-résolution, la technologie derrière le générateur d'images de Google Imagen

Apr 10, 2023 am 10:21 AM

Ces dernières années, l’apprentissage multimodal a reçu beaucoup d’attention, en particulier dans les deux directions de la synthèse texte-image et de l’apprentissage contrastif image-texte. Certains modèles d'IA ont attiré l'attention du grand public en raison de leur application dans la génération et l'édition d'images créatives, tels que les modèles d'images texte DALL・E et DALL-E 2 lancés par OpenAI, ainsi que GauGAN et GauGAN2 de NVIDIA. Pour ne pas être en reste, Google a publié fin mai son propre modèle de conversion texte-image, Imagen, qui semble repousser encore les limites de la génération d'images conditionnelles aux légendes. À partir d'une simple description d'une scène, Imagen peut générer des images de haute qualité et haute résolution.

Crushing H100, le GPU nouvelle génération de Nvidia se dévoile ! La première conception de module multipuce 3 nm, dévoilée en 2024

Sep 30, 2023 pm 12:49 PM

Crushing H100, le GPU nouvelle génération de Nvidia se dévoile ! La première conception de module multipuce 3 nm, dévoilée en 2024

Sep 30, 2023 pm 12:49 PM

Processus 3 nm, les performances dépassent le H100 ! Récemment, le média étranger DigiTimes a annoncé que Nvidia développait le GPU de nouvelle génération, le B100, dont le nom de code est "Blackwell". Il s'agirait d'un produit destiné aux applications d'intelligence artificielle (IA) et de calcul haute performance (HPC). , le B100 utilisera le processus de traitement 3 nm de TSMC, ainsi qu'une conception de module multi-puces (MCM) plus complexe, et apparaîtra au quatrième trimestre 2024. Pour Nvidia, qui monopolise plus de 80 % du marché des GPU d’intelligence artificielle, il peut utiliser le B100 pour frapper pendant que le fer est chaud et attaquer davantage des challengers comme AMD et Intel dans cette vague de déploiement d’IA. Selon les estimations de NVIDIA, d'ici 2027, la valeur de production de ce domaine devrait atteindre environ

La revue la plus complète des grands modèles multimodaux est ici ! 7 chercheurs Microsoft ont coopéré vigoureusement, 5 thèmes majeurs, 119 pages de document

Sep 25, 2023 pm 04:49 PM

La revue la plus complète des grands modèles multimodaux est ici ! 7 chercheurs Microsoft ont coopéré vigoureusement, 5 thèmes majeurs, 119 pages de document

Sep 25, 2023 pm 04:49 PM

La revue la plus complète des grands modèles multimodaux est ici ! Écrit par 7 chercheurs chinois de Microsoft, il compte 119 pages - il part de deux types d'orientations de recherche multimodales sur grands modèles qui ont été complétées et sont toujours à l'avant-garde, et résume de manière exhaustive cinq sujets de recherche spécifiques : la compréhension visuelle et la génération visuelle. L'agent multimodal grand modèle multimodal supporté par le modèle visuel unifié LLM se concentre sur un phénomène : le modèle de base multimodal est passé de spécialisé à universel. Ps. C'est pourquoi l'auteur a directement dessiné une image de Doraemon au début de l'article. Qui devrait lire cette critique (rapport) ? Dans les mots originaux de Microsoft : tant que vous souhaitez apprendre les connaissances de base et les derniers progrès des modèles de base multimodaux, que vous soyez un chercheur professionnel ou un étudiant, ce contenu est très approprié pour vous réunir.

Adaptateur I2V de la communauté SD : aucune configuration requise, plug and play, parfaitement compatible avec le plug-in vidéo Tusheng

Jan 15, 2024 pm 07:48 PM

Adaptateur I2V de la communauté SD : aucune configuration requise, plug and play, parfaitement compatible avec le plug-in vidéo Tusheng

Jan 15, 2024 pm 07:48 PM

La tâche de génération d'image en vidéo (I2V) est un défi dans le domaine de la vision par ordinateur qui vise à convertir des images statiques en vidéos dynamiques. La difficulté de cette tâche est d'extraire et de générer des informations dynamiques dans la dimension temporelle à partir d'une seule image tout en conservant l'authenticité et la cohérence visuelle du contenu de l'image. Les méthodes I2V existantes nécessitent souvent des architectures de modèles complexes et de grandes quantités de données de formation pour atteindre cet objectif. Récemment, un nouveau résultat de recherche « I2V-Adapter : AGeneralImage-to-VideoAdapter for VideoDiffusionModels » dirigé par Kuaishou a été publié. Cette recherche introduit une méthode innovante de conversion image-vidéo et propose un module adaptateur léger, c'est-à-dire

Papier de score parfait VPR 2024 ! Meta propose EfficientSAM : divisez tout rapidement !

Mar 02, 2024 am 10:10 AM

Papier de score parfait VPR 2024 ! Meta propose EfficientSAM : divisez tout rapidement !

Mar 02, 2024 am 10:10 AM

Ce travail d'EfficientSAM a été inclus dans le CVPR2024 avec une note parfaite de 5/5/5 ! L'auteur a partagé le résultat sur les réseaux sociaux, comme le montre l'image ci-dessous : Le lauréat du prix LeCun Turing a également fortement recommandé ce travail ! Dans des recherches récentes, les chercheurs de Meta ont proposé une nouvelle méthode améliorée, à savoir le pré-entraînement d'image de masque (SAMI) utilisant SAM. Cette méthode combine la technologie de pré-entraînement MAE et les modèles SAM pour obtenir des encodeurs ViT pré-entraînés de haute qualité. Grâce à SAMI, les chercheurs tentent d'améliorer les performances et l'efficacité du modèle et de proposer de meilleures solutions pour les tâches de vision. La proposition de cette méthode apporte de nouvelles idées et opportunités pour explorer et développer davantage les domaines de la vision par ordinateur et de l’apprentissage profond. en combinant différents

Annonce du prix Boltzmann 2022 : le fondateur de Hopfield Network remporte le prix

Aug 13, 2023 pm 08:49 PM

Annonce du prix Boltzmann 2022 : le fondateur de Hopfield Network remporte le prix

Aug 13, 2023 pm 08:49 PM

Les deux scientifiques qui ont remporté le prix Boltzmann 2022 ont été annoncés. Ce prix a été créé par le comité de physique statistique (C3) de l'IUPAP pour récompenser les chercheurs qui ont réalisé des réalisations exceptionnelles dans le domaine de la physique statistique. Le gagnant doit être un scientifique qui n’a jamais remporté de prix Boltzmann ou de prix Nobel. Ce prix a débuté en 1975 et est décerné tous les trois ans pour commémorer Ludwig Boltzmann, le fondateur de la physique statistique, Deepak Dharistheoriginalstatement. Raison de l'attribution : en reconnaissance des contributions pionnières de Deepak Dharistheoriginalstatement au domaine de la physique statistique, y compris la solution exacte de l'auto-organisation. modèle critique, croissance d'interface, désordre

L'étoile montante de Google AI passe à Pika : la génération vidéo Lumiere est un scientifique fondateur

Feb 26, 2024 am 09:37 AM

L'étoile montante de Google AI passe à Pika : la génération vidéo Lumiere est un scientifique fondateur

Feb 26, 2024 am 09:37 AM

La génération vidéo progresse à plein régime et Pika a accueilli un grand général : le chercheur de Google, Omer Bar-Tal, qui est le scientifique fondateur de Pika. Il y a un mois, Google a publié le modèle de génération vidéo Lumiere en tant que co-auteur, et l'effet a été incroyable. À cette époque, les internautes disaient : Google rejoint la bataille de la génération vidéo, et il y a une autre bonne émission à regarder. Certaines personnes du secteur, notamment le PDG de StabilityAI et d'anciens collègues de Google, ont envoyé leurs bénédictions. Le premier ouvrage de Lumière, Omer Bar-Tal, qui vient d'obtenir une maîtrise, est diplômé du Département de mathématiques et d'informatique de l'Université de Tel Aviv en 2021, puis est allé à l'Institut des sciences Weizmann pour étudier une maîtrise en informatique science, principalement axée sur la recherche dans le domaine de la synthèse d’images et de vidéos. Ses résultats de thèse ont été publiés à plusieurs reprises