Périphériques technologiques

Périphériques technologiques

IA

IA

Papier de 30 pages ! Nouveau travail de l'équipe de Yu Shilun : enquête complète de l'AIGC, historique du développement du GAN à ChatGPT

Papier de 30 pages ! Nouveau travail de l'équipe de Yu Shilun : enquête complète de l'AIGC, historique du développement du GAN à ChatGPT

Papier de 30 pages ! Nouveau travail de l'équipe de Yu Shilun : enquête complète de l'AIGC, historique du développement du GAN à ChatGPT

2022 peut être considérée comme la première année de l’IA générative. Récemment, l'équipe de Yu Shilun a publié une enquête complète sur AIGC, présentant l'historique du développement du GAN à ChatGPT.

L'année 2022, qui vient de s'écouler, est sans doute le point singulier de l'explosion de l'IA générative.

Depuis 2021, l'IA générative a été sélectionnée dans le « Cycle de battage médiatique de la technologie de l'intelligence artificielle » de Gartner pendant deux années consécutives et est considérée comme une tendance technologique importante de l'IA à l'avenir.

Récemment, l'équipe de Yu Shilun a publié une enquête complète sur AIGC, présentant l'historique du développement du GAN à ChatGPT.

Adresse du papier : https://arxiv.org/pdf/2303.04226.pdf

Cet article extrait une partie du document pour l'introduction.

La singularité est arrivée ?

Ces dernières années, le contenu généré par l'intelligence artificielle (AIGC, également connu sous le nom d'IA générative) a attiré une large attention en dehors de la communauté informatique.

La société dans son ensemble a commencé à s'intéresser beaucoup à divers produits de génération de contenu développés par de grandes entreprises technologiques, telles que ChatGPT et DALL-E-2.

AIGC fait référence à l'utilisation de la technologie d'intelligence artificielle générative (GAI) pour générer du contenu et peut créer automatiquement une grande quantité de contenu en peu de temps.

ChatGPT est un système d'IA développé par OpenAI pour créer des conversations. Le système est capable de comprendre efficacement le langage humain et de répondre de manière significative.

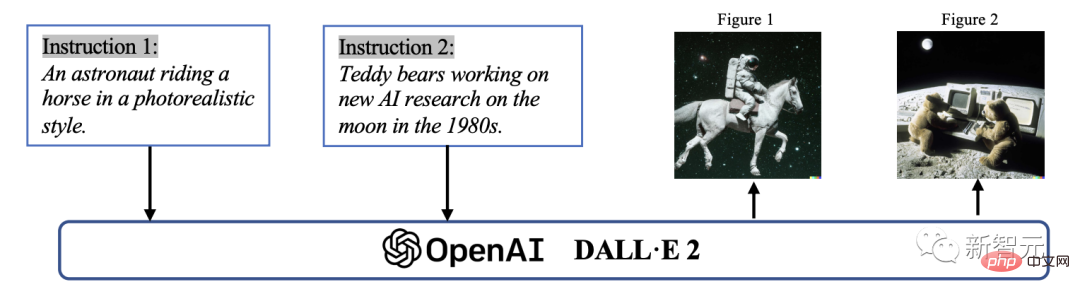

De plus, DALL-E-2 est un autre modèle GAI de pointe développé par OpenAI, capable de créer des images uniques de haute qualité à partir de descriptions textuelles en quelques minutes.

Exemple d'AIGC dans la génération d'images

Techniquement parlant, AIGC fait référence à des instructions données qui peuvent guider le modèle pour accomplir la tâche, en utilisant GAI pour générer du contenu qui satisfait aux instructions. Ce processus de génération comprend généralement deux étapes : extraire les informations d'intention à partir des instructions et générer du contenu basé sur l'intention extraite.

Cependant, comme l'ont prouvé des études antérieures, le paradigme du modèle GAI contenant les deux étapes ci-dessus n'est pas complètement nouveau.

Par rapport aux travaux antérieurs, le point central des progrès récents de l'AIGC est de former des modèles génératifs plus complexes sur des ensembles de données plus vastes, d'utiliser des cadres de modèles de base plus larges et d'avoir accès à un large éventail de ressources informatiques.

Par exemple, le framework principal de GPT-3 est le même que celui de GPT-2, mais la taille des données de pré-formation passe de WebText (38 Go) à CommonCrawl (570 Go après filtrage), et la taille du modèle de base passe de 1,5 Go. à 175B.

Par conséquent, GPT-3 a une meilleure capacité de généralisation que GPT-2 sur diverses tâches.

En plus des avantages apportés par l’augmentation des volumes de données et de la puissance de calcul, les chercheurs explorent également les moyens de combiner les nouvelles technologies avec les algorithmes GAI.

Par exemple, ChatGPT utilise l'apprentissage par renforcement avec retour humain (RLHF) pour déterminer la réponse la plus appropriée à une instruction donnée, améliorant ainsi la fiabilité et la précision du modèle au fil du temps. Cette approche permet à ChatGPT de mieux comprendre les préférences humaines dans les longues conversations.

En parallèle, en CV, Stable Diffusion proposée par Stability AI en 2022 a également connu un grand succès en génération d'images.

Contrairement aux méthodes précédentes, les modèles de diffusion générative peuvent aider à générer des images haute résolution en contrôlant l'équilibre entre exploration et exploitation, obtenant ainsi une combinaison harmonieuse de diversité dans les images générées et de similitudes avec les données d'entraînement.

En combinant ces avancées, le modèle a fait des progrès significatifs dans la mission de l’AIGC et a été adopté par des secteurs aussi divers que l’art, la publicité et l’éducation.

Dans un avenir proche, l'AIGC continuera de devenir un domaine important de recherche sur l'apprentissage automatique.

D'une manière générale, les modèles GAI peuvent être divisés en deux types : les modèles monomodaux et les modèles multimodaux

Par conséquent, il est crucial de procéder à un examen complet des recherches antérieures et d'identifier les problèmes existants dans ce domaine. Il s'agit de la première enquête axée sur les technologies et applications de base dans le domaine de l'AIGC.

C'est la première fois que l'AIGC résume une enquête complète sur GAI en termes de technologie et d'applications.

Les enquêtes précédentes ont principalement présenté le GAI sous différents angles, notamment la génération de langage naturel, la génération d'images et la génération d'apprentissage automatique multimodal. Cependant, ces travaux antérieurs se sont uniquement concentrés sur des parties spécifiques de l’AIGC.

Dans cette enquête, nous avons d'abord passé en revue les technologies de base couramment utilisées dans l'AIGC. Ensuite, un résumé complet des algorithmes GAI avancés est fourni, y compris la génération unimodale et multimodale. De plus, l'article examine les applications et les défis potentiels de l'AIGC.

Enfin, l'orientation future de ce domaine est soulignée. En résumé, les principales contributions de cet article sont les suivantes :

- Au meilleur de nos connaissances, nous sommes les premiers à fournir une définition formelle et une étude complète des processus génératifs AIGC et augmentés par l'IA.

-Nous avons examiné l'histoire et la technologie de base de l'AIGC et mené une analyse complète des derniers progrès des tâches et des modèles GAI du point de vue de la génération unimodale et de la génération multimodale.

-Cet article aborde les principaux défis auxquels est confronté l'AIGC et les futures tendances de la recherche.

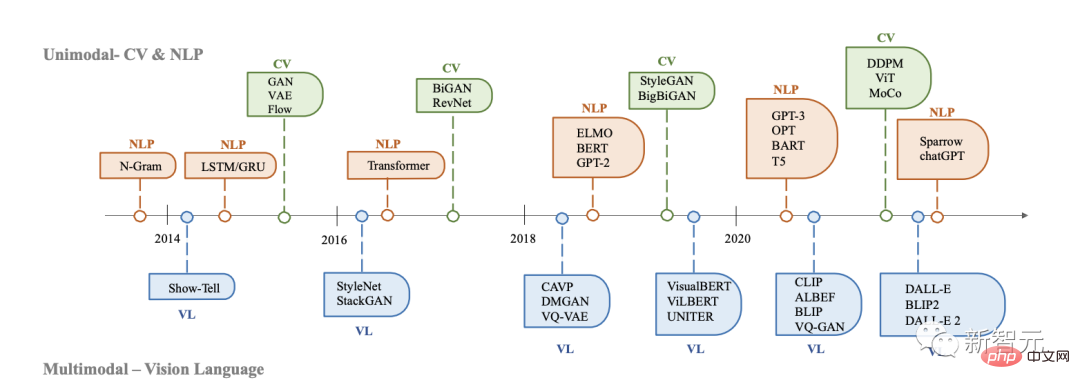

Histoire de l'IA générative

Les modèles génératifs ont une longue histoire dans l'intelligence artificielle, remontant au développement des modèles de Markov cachés (HMM) et des modèles de mélange gaussien (GMM) dans les années 1950.

Ces modèles génèrent des données continues telles que la parole et des séries chronologiques. Cependant, il a fallu attendre l’avènement du deep learning pour que les performances des modèles génératifs se soient améliorées de manière significative.

Dans les premiers modèles génératifs profonds, les différents domaines ne se chevauchaient généralement pas beaucoup.

Historique du développement de l'IA générative en CV, PNL et VL

En PNL, la méthode traditionnelle de génération de phrases consiste à utiliser un modèle de langage N-gram pour apprendre la distribution des mots puis rechercher le meilleur séquence. Cependant, cette méthode ne peut pas s’adapter efficacement aux peines longues.

Pour résoudre ce problème, les réseaux de neurones récurrents (RNN) ont ensuite été introduits dans les tâches de modélisation du langage, permettant de modéliser des dépendances relativement longues.

Le deuxième est le développement de la mémoire à long terme (LSTM) et des unités récurrentes fermées (GRU), qui utilisent des mécanismes de déclenchement pour contrôler la mémoire pendant l'entraînement. Ces méthodes sont capables de gérer environ 200 jetons dans un échantillon, ce qui marque une amélioration significative par rapport aux modèles de langage N-gram.

Pendant ce temps, en CV, avant l'émergence des méthodes basées sur l'apprentissage profond, les algorithmes traditionnels de génération d'images utilisaient des techniques telles que la synthèse de texture (PTS) et le mappage de texture.

Ces algorithmes sont basés sur des fonctionnalités conçues à la main et ont des capacités limitées à générer des images complexes et diverses.

En 2014, les réseaux contradictoires génératifs (GAN) ont été proposés pour la première fois et sont devenus une étape importante dans le domaine de l'intelligence artificielle en raison de leurs résultats impressionnants dans diverses applications.

Des auto-encodeurs variables (VAE) et d'autres méthodes, telles que des modèles de diffusion génératifs, ont également été développés pour fournir un contrôle plus fin sur le processus de génération d'images et permettre la génération d'images de haute qualité.

Le développement de modèles génératifs dans différents domaines suit des chemins différents, mais au final il y a une intersection : l'architecture du transformateur.

En 2017, Transformer a été introduit dans les tâches PNL par Vaswani et al., puis appliqué au CV, puis est devenu l'architecture dominante pour de nombreux modèles génératifs dans divers domaines.

Dans le domaine du NLP, de nombreux modèles de langage célèbres à grande échelle, tels que BERT et GPT, adoptent l'architecture Transformer comme élément de base principal. Avantages par rapport aux blocs de construction précédents, à savoir LSTM et GRU.

Dans CV, Vision Transformer (ViT) et Swin Transformer ont ensuite développé ce concept, combinant l'architecture Transformer avec un composant de vision, lui permettant d'être appliqué aux systèmes de liaison descendante basés sur l'image.

En plus des améliorations apportées par Transformer à une modalité unique, ce crossover permet également de fusionner des modèles de différents domaines pour effectuer des tâches multimodales.

Un exemple de modèle multimodal est CLIP. CLIP est un modèle de langage visuel commun. Il combine l'architecture Transformer avec un composant visuel, permettant une formation sur de grandes quantités de données texte et image.

En combinant les connaissances visuelles et linguistiques en pré-formation, CLIP peut également être utilisé comme encodeur d'image dans la génération de signaux multimodaux. En bref, l’émergence de modèles basés sur Transformer a révolutionné la génération d’intelligence artificielle et a ouvert la possibilité d’une formation à grande échelle.

Ces dernières années, les chercheurs ont également commencé à introduire de nouvelles technologies basées sur ces modèles.

Par exemple, en PNL, afin d'aider le modèle à mieux comprendre les exigences de la tâche, les gens préfèrent parfois les indices en quelques coups. Il s'agit d'inclure dans l'invite quelques exemples sélectionnés dans l'ensemble de données.

Dans les langages visuels, les chercheurs combinent des modèles spécifiques à des modèles avec des objectifs d'apprentissage contrastifs auto-supervisés pour fournir des représentations plus puissantes.

À l'avenir, à mesure que l'AIGC deviendra de plus en plus important, de plus en plus de technologies seront introduites, ce qui donnera à ce domaine une grande vitalité.

Bases de l'AIGC

Dans cette section, les modèles de base couramment utilisés de l'AIGC sont présentés.

Basic Model

Transformer

Transformer est l'architecture de base de nombreux modèles de pointe, tels que GPT-3, DALL-E-2, Codex et Gopher.

Il a été proposé pour la première fois de résoudre les limites des modèles traditionnels, tels que les RNN, dans le traitement de séquences de longueur variable et la conscience du contexte.

L'architecture de Transformer est principalement basée sur un mécanisme d'auto-attention, qui permet au modèle de prêter attention aux différentes parties de la séquence d'entrée.

Transformer se compose d'un encodeur et d'un décodeur. Le codeur reçoit une séquence d'entrée et génère une représentation cachée, tandis que le décodeur reçoit une représentation cachée et génère une séquence de sortie.

Chaque couche de l'encodeur et du décodeur se compose d'une attention multi-têtes et d'un réseau neuronal à action directe. L'attention multi-têtes est le composant principal de Transformer, qui apprend à attribuer différents poids en fonction de la pertinence des balises.

Cette approche de routage des informations permet au modèle de mieux gérer les dépendances à long terme et, par conséquent, améliore les performances dans un large éventail de tâches PNL.

Un autre avantage du Transformer est que son architecture le rend hautement parallèle et permet aux données de surmonter les biais inductifs. Cette fonctionnalité rend Transformer très adapté à la pré-formation à grande échelle, permettant aux modèles basés sur Transformer de s'adapter à différentes tâches en aval.

Modèle de langage pré-entraîné

Depuis l'introduction de l'architecture Transformer, elle est devenue un choix courant pour le traitement du langage naturel en raison de son parallélisme et de ses capacités d'apprentissage.

D'une manière générale, ces modèles de langage pré-entraînés basés sur Transformer peuvent généralement être divisés en deux catégories en fonction de leurs tâches de formation : les modèles de langage autorégressifs et les modèles de langage de masque.

Étant donné une phrase composée de plusieurs jetons, l'objectif de la modélisation de langage masqué, telle que BERT et RoBERTa, est de prédire la probabilité du jeton masqué à partir d'informations contextuelles.

L'exemple le plus notable de modèle de langage masqué est BERT, qui comprend des tâches de modélisation de langage masqué et de prédiction de la phrase suivante. RoBERTa utilise la même architecture que BERT, améliorant ses performances en augmentant la quantité de données de pré-entraînement et en intégrant des objectifs de pré-entraînement plus ambitieux.

XL-Net est également basé sur BERT, qui intègre des opérations de permutation pour modifier l'ordre des prédictions pour chaque itération de formation, permettant au modèle d'apprendre davantage d'informations croisées.

Et les modèles de langage autorégressifs, tels que GPT-3 et OPT, modélisent la probabilité étant donné le jeton précédent, et sont donc des modèles de langage de gauche à droite. Contrairement aux modèles de langage masqués, les modèles de langage autorégressifs sont plus adaptés aux tâches génératives.

Apprentissage par renforcement à partir des commentaires humains

Bien que formé sur des données à grande échelle, l'AIGC peut ne pas toujours produire un contenu cohérent avec l'intention de l'utilisateur.

Pour que la sortie AIGC corresponde mieux aux préférences humaines, l'apprentissage par renforcement à partir de la rétroaction humaine (RLHF) a été appliqué pour affiner le modèle dans diverses applications, telles que Sparrow, InstructGPT et ChatGPT.

Normalement, l'ensemble du processus du RLHF comprend les trois étapes suivantes : pré-formation, apprentissage par récompense et mise au point de l'apprentissage par renforcement.

Informatique

Matériel

Ces dernières années, la technologie matérielle a fait des progrès significatifs, facilitant la formation de grands modèles.

Dans le passé, la formation d'un grand réseau neuronal à l'aide d'un processeur pouvait prendre des jours, voire des semaines. Cependant, avec l’augmentation de la puissance de calcul, ce processus s’est accéléré de plusieurs ordres de grandeur.

Par exemple, le GPU NVIDIA A100 de NVIDIA est 7 fois plus rapide que le V100 et 11 fois plus rapide que le T4 dans le processus d'inférence à grande échelle BERT.

De plus, l'unité de traitement tensoriel (TPU) de Google est spécialement conçue pour l'apprentissage en profondeur, offrant des performances de calcul supérieures à celles du GPU A100.

Les progrès accélérés de la puissance de calcul ont considérablement amélioré l'efficacité de la formation des modèles d'intelligence artificielle, offrant de nouvelles possibilités pour le développement de modèles vastes et complexes.

Formation distribuée

Une autre amélioration majeure est la formation distribuée.

Dans le machine learning traditionnel, la formation est généralement effectuée sur une machine utilisant un seul processeur. Cette approche fonctionne bien pour les petits ensembles de données et les modèles, mais devient peu pratique lorsqu'il s'agit de grands ensembles de données et de modèles complexes.

Dans la formation distribuée, les tâches de formation sont réparties sur plusieurs processeurs ou machines, ce qui améliore considérablement la vitesse de formation du modèle.

Certaines entreprises ont également publié des frameworks qui simplifient le processus de formation distribuée des piles d'apprentissage profond. Ces frameworks fournissent des outils et des API qui permettent aux développeurs de répartir facilement les tâches de formation sur plusieurs processeurs ou machines sans avoir à gérer l'infrastructure sous-jacente.

Cloud Computing

Le cloud computing joue également un rôle essentiel dans la formation de grands modèles. Auparavant, les modèles étaient souvent formés localement. Désormais, avec les services de cloud computing tels qu'AWS et Azure donnant accès à de puissantes ressources informatiques, les chercheurs et les praticiens du deep learning peuvent créer de grands clusters GPU ou TPU nécessaires à la formation de grands modèles à la demande.

Collectivement, ces avancées permettent de développer des modèles plus complexes et plus précis, ouvrant de nouvelles possibilités dans divers domaines de la recherche et des applications de l'intelligence artificielle.

Présentation de l'auteur

Philip S. Yu est un chercheur dans le domaine de l'informatique, un boursier ACM/IEEE et un professeur distingué au Département d'informatique de l'Université de l'Illinois à Chicago (UIC).

Il a réalisé des réalisations de renommée mondiale dans la théorie et la technologie de l'exploration et de la gestion du Big Data. En réponse aux défis du big data en termes d'échelle, de vitesse et de diversité, il a proposé des solutions efficaces et de pointe en matière de méthodes et technologies d'exploration de données et de gestion, notamment dans l'intégration de données diverses, l'exploration de flux de données, de modèles fréquents et de sous-espaces. . Il a apporté des contributions révolutionnaires aux graphiques.

Il a également apporté des contributions pionnières dans le domaine de la technologie de traitement de bases de données parallèles et distribuées, et l'a appliquée au système IBM S/390 Parallel Sysplex, transformant avec succès l'ordinateur central IBM traditionnel en une architecture de microprocesseur parallèle.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Que signifie la transaction transversale? Quelles sont les transactions transversales?

Apr 21, 2025 pm 11:39 PM

Que signifie la transaction transversale? Quelles sont les transactions transversales?

Apr 21, 2025 pm 11:39 PM

Échanges qui prennent en charge les transactions transversales: 1. Binance, 2. UniSwap, 3. Sushiswap, 4. Curve Finance, 5. Thorchain, 6. 1inch Exchange, 7. DLN Trade, ces plateformes prennent en charge les transactions d'actifs multi-chaînes via diverses technologies.

WEB3 Trading Platform Ranking_Web3 Global Exchanges Top Ten Résumé

Apr 21, 2025 am 10:45 AM

WEB3 Trading Platform Ranking_Web3 Global Exchanges Top Ten Résumé

Apr 21, 2025 am 10:45 AM

Binance est le suzerain de l'écosystème mondial de trading d'actifs numériques, et ses caractéristiques comprennent: 1. Le volume de négociation quotidien moyen dépasse 150 milliards de dollars, prend en charge 500 paires de négociation, couvrant 98% des monnaies grand public; 2. La matrice d'innovation couvre le marché des dérivés, la mise en page Web3 et le système éducatif; 3. Les avantages techniques sont des moteurs de correspondance d'une milliseconde, avec des volumes de traitement de pointe de 1,4 million de transactions par seconde; 4. Conformité Progress détient des licences de 15 pays et établit des entités conformes en Europe et aux États-Unis.

Prévisions des prix WorldCoin (WLD) 2025-2031: WLD atteindra-t-il 4 $ d'ici 2031?

Apr 21, 2025 pm 02:42 PM

Prévisions des prix WorldCoin (WLD) 2025-2031: WLD atteindra-t-il 4 $ d'ici 2031?

Apr 21, 2025 pm 02:42 PM

WorldCoin (WLD) se démarque sur le marché des crypto-monnaies avec ses mécanismes uniques de vérification biométrique et de protection de la vie privée, attirant l'attention de nombreux investisseurs. WLD a permis de se produire avec remarquablement parmi les Altcoins avec ses technologies innovantes, en particulier en combinaison avec la technologie d'Intelligence artificielle OpenAI. Mais comment les actifs numériques se comporteront-ils au cours des prochaines années? Prédons ensemble le prix futur de WLD. Les prévisions de prix de 2025 WLD devraient atteindre une croissance significative de la WLD en 2025. L'analyse du marché montre que le prix moyen du WLD peut atteindre 1,31 $, avec un maximum de 1,36 $. Cependant, sur un marché baissier, le prix peut tomber à environ 0,55 $. Cette attente de croissance est principalement due à WorldCoin2.

Classement des échanges à effet de levier dans le cercle des devises Les dernières recommandations des dix premiers échanges à effet de levier dans le cercle des devises

Apr 21, 2025 pm 11:24 PM

Classement des échanges à effet de levier dans le cercle des devises Les dernières recommandations des dix premiers échanges à effet de levier dans le cercle des devises

Apr 21, 2025 pm 11:24 PM

Les plates-formes qui ont des performances exceptionnelles dans le commerce, la sécurité et l'expérience utilisateur en effet de levier en 2025 sont: 1. OKX, adaptés aux traders à haute fréquence, fournissant jusqu'à 100 fois l'effet de levier; 2. Binance, adaptée aux commerçants multi-monnaies du monde entier, offrant un effet de levier 125 fois élevé; 3. Gate.io, adapté aux joueurs de dérivés professionnels, fournissant 100 fois l'effet de levier; 4. Bitget, adapté aux novices et aux commerçants sociaux, fournissant jusqu'à 100 fois l'effet de levier; 5. Kraken, adapté aux investisseurs stables, fournissant 5 fois l'effet de levier; 6. BUTBIT, adapté aux explorateurs Altcoin, fournissant 20 fois l'effet de levier; 7. Kucoin, adapté aux commerçants à faible coût, fournissant 10 fois l'effet de levier; 8. Bitfinex, adapté au jeu senior

'Black Monday Sell' est une journée difficile pour l'industrie de la crypto-monnaie

Apr 21, 2025 pm 02:48 PM

'Black Monday Sell' est une journée difficile pour l'industrie de la crypto-monnaie

Apr 21, 2025 pm 02:48 PM

Le plongeon sur le marché des crypto-monnaies a provoqué la panique parmi les investisseurs, et Dogecoin (Doge) est devenu l'une des zones les plus difficiles. Son prix a fortement chuté et le verrouillage de la valeur totale de la finance décentralisée (DEFI) (TVL) a également connu une baisse significative. La vague de vente de "Black Monday" a balayé le marché des crypto-monnaies, et Dogecoin a été le premier à être touché. Son Defitvl a chuté aux niveaux de 2023 et le prix de la devise a chuté de 23,78% au cours du dernier mois. Le Defitvl de Dogecoin est tombé à un minimum de 2,72 millions de dollars, principalement en raison d'une baisse de 26,37% de l'indice de valeur SOSO. D'autres plates-formes de Defi majeures, telles que le Dao et Thorchain ennuyeux, TVL ont également chuté de 24,04% et 20, respectivement.

Comment gagner des récompenses de plateaux aériens du noyau sur la stratégie de processus complète de la binance

Apr 21, 2025 pm 01:03 PM

Comment gagner des récompenses de plateaux aériens du noyau sur la stratégie de processus complète de la binance

Apr 21, 2025 pm 01:03 PM

Dans le monde animé des crypto-monnaies, de nouvelles opportunités émergent toujours. À l'heure actuelle, l'activité aérienne de Kerneldao (noyau) attire beaucoup l'attention et attire l'attention de nombreux investisseurs. Alors, quelle est l'origine de ce projet? Quels avantages le support BNB peut-il en tirer? Ne vous inquiétez pas, ce qui suit le révélera un par un pour vous.

Pourquoi la hausse ou la baisse des prix de monnaie virtuelle? Pourquoi la hausse ou la baisse des prix de monnaie virtuelle?

Apr 21, 2025 am 08:57 AM

Pourquoi la hausse ou la baisse des prix de monnaie virtuelle? Pourquoi la hausse ou la baisse des prix de monnaie virtuelle?

Apr 21, 2025 am 08:57 AM

Les facteurs de la hausse des prix des devises virtuels comprennent: 1. Une augmentation de la demande du marché, 2. Daisser l'offre, 3. Stimulé de nouvelles positives, 4. Sentiment du marché optimiste, 5. Environnement macroéconomique; Les facteurs de déclin comprennent: 1. Daissement de la demande du marché, 2. AUGMENT DE L'OFFICATION, 3. Strike of Negative News, 4. Pespimiste Market Sentiment, 5. Environnement macroéconomique.

Aavenomics est une recommandation pour modifier le jeton Aave Protocol et introduire le rachat de jetons, qui a atteint le nombre de personnes quorum.

Apr 21, 2025 pm 06:24 PM

Aavenomics est une recommandation pour modifier le jeton Aave Protocol et introduire le rachat de jetons, qui a atteint le nombre de personnes quorum.

Apr 21, 2025 pm 06:24 PM

Aavenomics est une proposition de modification du jeton de protocole Aave et d'introduire des dépens de jetons, qui a mis en œuvre un quorum pour Aavedao. Marc Zeller, fondateur de l'Aave Project Chain (ACI), l'a annoncé sur X, notant qu'il marque une nouvelle ère pour l'accord. Marc Zeller, fondateur de l'Aave Chain Initiative (ACI), a annoncé sur X que la proposition d'Aavenomics comprend la modification du jeton Aave Protocol et l'introduction de dépens de jetons, a obtenu un quorum pour Aavedao. Selon Zeller, cela marque une nouvelle ère pour l'accord. Les membres d'Aavedao ont voté massivement pour soutenir la proposition, qui était de 100 par semaine mercredi