Périphériques technologiques

Périphériques technologiques

IA

IA

Cela ne coûte que 0,003 $ la fois, soit 20 fois moins cher que les humains ! ChatGPT met les annotateurs de données en danger

Cela ne coûte que 0,003 $ la fois, soit 20 fois moins cher que les humains ! ChatGPT met les annotateurs de données en danger

Cela ne coûte que 0,003 $ la fois, soit 20 fois moins cher que les humains ! ChatGPT met les annotateurs de données en danger

Récemment, une équipe de recherche de l'Université de Zurich a découvert que ChatGPT surpassait les travailleurs du crowdsourcing sur plusieurs tâches d'annotation PNL, avec une grande cohérence, et ne coûtait qu'environ 0,003 $ par annotation, soit 20 fois moins cher que MTurk.

Actuellement, de nombreuses applications de traitement du langage naturel (NLP) nécessitent la prise en charge de données annotées de haute qualité, en particulier lorsque ces données sont utilisées pour des tâches telles que la formation de classificateurs ou l'évaluation des performances de modèles non supervisés.

Par exemple, les chercheurs en IA souhaitent souvent filtrer les données bruyantes des médias sociaux pour rechercher des corrélations, attribuer du texte à différents sujets ou catégories conceptuelles, ou mesurer son sentiment ou sa position.

Et, quelle que soit la méthode spécifique utilisée pour ces tâches (supervisées, semi-supervisées ou non supervisées), des données étiquetées sont nécessaires pour établir un ensemble de formation ou un étalon-or.

Cependant, dans la plupart des cas, pour réaliser un travail d'annotation de données de haute qualité, il est toujours indissociable du crowdsourcing de travailleurs sur la plateforme d'annotation de données ou d'annotateurs formés tels que des assistants de recherche pour le faire manuellement.

En règle générale, les annotateurs formés créent d'abord un ensemble de données de référence relativement petit, puis embauchent des travailleurs participatifs pour augmenter la quantité de données annotées et effectuer un travail répétitif. En fonction de leur taille et de leur complexité, les tâches d'annotation de données peuvent parfois être très longues et laborieuses. Non seulement elles nécessitent un certain coût de main d'œuvre, mais la qualité de l'annotation des données ne peut pas être garantie.

Alors, les machines peuvent-elles aider les humains à accomplir cette tâche fondamentale ?

Dans le passé, les machines n'étaient pas douées pour ce genre de tâches de « travail lent et minutieux », mais contre toute attente, la tâche « annotation des données » a été complétée par ChatGPT, et c'est encore mieux que la plupart des gens.

Dans une nouvelle étude publiée aujourd'hui, une équipe de recherche de l'Université de Zurich a utilisé un échantillon de 2 382 tweets pour démontrer que ChatGPT excelle dans les tâches multi-annotations telles que la détection de pertinence, de sujet et de cadre pour les travailleurs du crowdsourcing.

Le document de recherche pertinent s'intitule « ChatGPT surpasse les Crowd-Workers pour les tâches d'annotation de texte » et a été publié sur le site Web de préimpression arXiv.

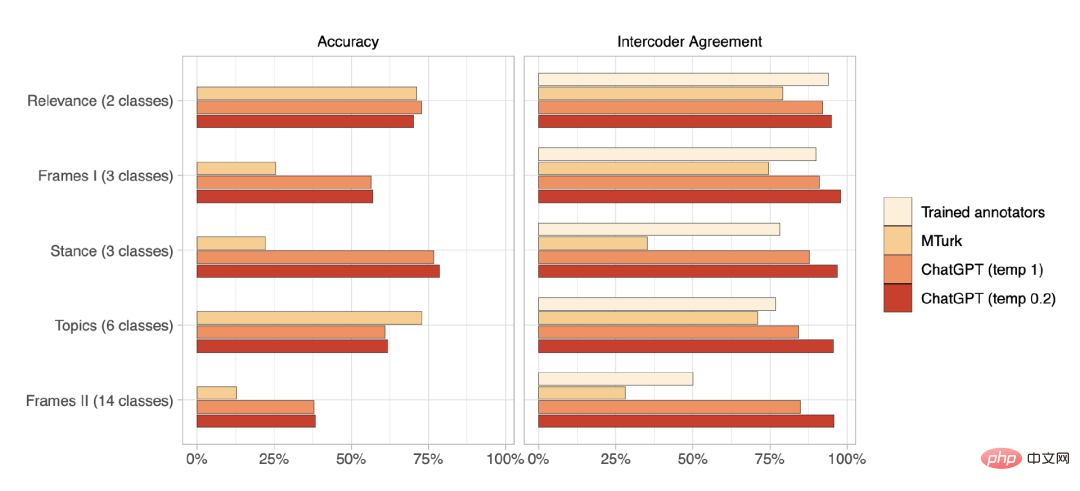

Plus précisément, ChatGPT a surpassé les travailleurs du crowdsourcing en termes de précision zéro dans quatre des cinq tâches ; en termes d'accord intercodeur pour toutes les tâches, ChatGPT surpasse non seulement les travailleurs du crowdsourcing, mais également les annotateurs formés.

Performances d'annotation de données de texte à échantillon nul de ChatGPT

Il convient de mentionner que le coût de chaque annotation de ChatGPT est inférieur à 0,003 $, soit environ 20 fois moins cher que les plateformes d'annotation de données.

L'équipe de recherche estime que même si des recherches supplémentaires sont nécessaires pour mieux comprendre les performances de ChatGPT et d'autres LLM dans un contexte plus large, les résultats suggèrent qu'ils ont le potentiel de changer la façon dont les chercheurs annotent les données, améliorant considérablement l'efficacité de la classification des textes et détruire certains modèles économiques des plateformes d’annotation de données.

Au moins pour l'instant, ces résultats démontrent l'importance d'approfondir les propriétés et les capacités d'annotation de texte des LLM.

À l'avenir, l'équipe de recherche étudiera les performances de ChatGPT dans plusieurs langues, les performances de ChatGPT dans plusieurs types de textes (médias sociaux, médias d'information, législation, discours, etc.), en utilisant la chaîne de pensée (CoT) invites et autres stratégies Nous continuerons à travailler dur pour améliorer les performances de l'inférence à échantillon nul.

Il convient de mentionner que lorsque l'équipe de recherche menait ce travail, OpenAI n'avait pas encore publié GPT-4. Quel serait le résultat si GPT-4 était utilisé pour effectuer la tâche d'annotation des données ?

Référence :https://arxiv.org/abs/2303.15056

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

La combinaison parfaite de ChatGPT et Python : créer un chatbot de service client intelligent

Oct 27, 2023 pm 06:00 PM

La combinaison parfaite de ChatGPT et Python : créer un chatbot de service client intelligent

Oct 27, 2023 pm 06:00 PM

La combinaison parfaite de ChatGPT et Python : Création d'un chatbot de service client intelligent Introduction : À l'ère de l'information d'aujourd'hui, les systèmes de service client intelligents sont devenus un outil de communication important entre les entreprises et les clients. Afin d'offrir une meilleure expérience de service client, de nombreuses entreprises ont commencé à se tourner vers les chatbots pour effectuer des tâches telles que la consultation des clients et la réponse aux questions. Dans cet article, nous présenterons comment utiliser le puissant modèle ChatGPT et le langage Python d'OpenAI pour créer un chatbot de service client intelligent afin d'améliorer

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Étapes d'installation : 1. Téléchargez le logiciel ChatGTP depuis le site officiel ou la boutique mobile de ChatGTP ; 2. Après l'avoir ouvert, dans l'interface des paramètres, sélectionnez la langue chinoise 3. Dans l'interface de jeu, sélectionnez le jeu homme-machine et définissez la langue. Spectre chinois ; 4. Après avoir démarré, entrez les commandes dans la fenêtre de discussion pour interagir avec le logiciel.

Comment développer un chatbot intelligent en utilisant ChatGPT et Java

Oct 28, 2023 am 08:54 AM

Comment développer un chatbot intelligent en utilisant ChatGPT et Java

Oct 28, 2023 am 08:54 AM

Dans cet article, nous présenterons comment développer des chatbots intelligents à l'aide de ChatGPT et Java, et fournirons quelques exemples de code spécifiques. ChatGPT est la dernière version du Generative Pre-training Transformer développé par OpenAI, une technologie d'intelligence artificielle basée sur un réseau neuronal qui peut comprendre le langage naturel et générer du texte de type humain. En utilisant ChatGPT, nous pouvons facilement créer des discussions adaptatives

Comment créer un robot de service client intelligent en utilisant ChatGPT PHP

Oct 28, 2023 am 09:34 AM

Comment créer un robot de service client intelligent en utilisant ChatGPT PHP

Oct 28, 2023 am 09:34 AM

Comment utiliser ChatGPTPHP pour créer un robot de service client intelligent Introduction : Avec le développement de la technologie de l'intelligence artificielle, les robots sont de plus en plus utilisés dans le domaine du service client. L'utilisation de ChatGPTPHP pour créer un robot de service client intelligent peut aider les entreprises à fournir des services client plus efficaces et personnalisés. Cet article explique comment utiliser ChatGPTPHP pour créer un robot de service client intelligent et fournit des exemples de code spécifiques. 1. Installez ChatGPTPHP et utilisez ChatGPTPHP pour créer un robot de service client intelligent.

Chatgpt peut-il être utilisé en Chine ?

Mar 05, 2024 pm 03:05 PM

Chatgpt peut-il être utilisé en Chine ?

Mar 05, 2024 pm 03:05 PM

chatgpt peut être utilisé en Chine, mais ne peut pas être enregistré, ni à Hong Kong et Macao. Si les utilisateurs souhaitent s'inscrire, ils peuvent utiliser un numéro de téléphone mobile étranger pour s'inscrire. Notez que lors du processus d'enregistrement, l'environnement réseau doit être basculé vers. une adresse IP étrangère.

La combinaison parfaite de ChatGPT et Python : créer un chatbot en temps réel

Oct 28, 2023 am 08:37 AM

La combinaison parfaite de ChatGPT et Python : créer un chatbot en temps réel

Oct 28, 2023 am 08:37 AM

La combinaison parfaite de ChatGPT et Python : Créer un chatbot en temps réel Introduction : Avec le développement rapide de la technologie de l'intelligence artificielle, les chatbots jouent un rôle de plus en plus important dans divers domaines. Les chatbots peuvent aider les utilisateurs à fournir une assistance immédiate et personnalisée tout en offrant aux entreprises un service client efficace. Cet article explique comment utiliser le modèle ChatGPT et le langage Python d'OpenAI pour créer un robot de discussion en temps réel et fournit des exemples de code spécifiques. 1. ChatGPT

Comment utiliser ChatGPT et Python pour implémenter la fonction de reconnaissance des intentions de l'utilisateur

Oct 27, 2023 am 09:04 AM

Comment utiliser ChatGPT et Python pour implémenter la fonction de reconnaissance des intentions de l'utilisateur

Oct 27, 2023 am 09:04 AM

Comment utiliser ChatGPT et Python pour implémenter la fonction de reconnaissance des intentions des utilisateurs Introduction : À l'ère numérique d'aujourd'hui, la technologie de l'intelligence artificielle est progressivement devenue un élément indispensable dans divers domaines. Parmi eux, le développement de la technologie de traitement du langage naturel (Natural Language Processing, NLP) permet aux machines de comprendre et de traiter le langage humain. ChatGPT (Chat-GeneratingPretrainedTransformer) est une sorte de