Périphériques technologiques

Périphériques technologiques

IA

IA

L'humanité a atteint la limite supérieure de l'architecture informatique en silicium ! L'IA devrait consommer 50 % de l'approvisionnement mondial en électricité d'ici 2030

L'humanité a atteint la limite supérieure de l'architecture informatique en silicium ! L'IA devrait consommer 50 % de l'approvisionnement mondial en électricité d'ici 2030

L'humanité a atteint la limite supérieure de l'architecture informatique en silicium ! L'IA devrait consommer 50 % de l'approvisionnement mondial en électricité d'ici 2030

Nous avons commencé à ressentir le sentiment d'atteindre la limite supérieure de l'expérience informatique sur silicium. Au cours des 10 prochaines années, il y aura un grave déficit de puissance de calcul, et ni les entreprises technologiques existantes ni les gouvernements n'ont été en mesure de résoudre ce problème.

De nos jours, nous sommes tellement habitués à ce que l'informatique devienne de moins en moins chère que nous ne doutons jamais qu'un jour nous ne pourrons peut-être plus nous le permettre.

Maintenant, Rodolfo Rosini, PDG d'une startup, pose une question qui nous choque tous : et si nous atteignions les limites physiques fondamentales des modèles informatiques classiques, tout comme notre économie repose sur une informatique bon marché ?

La stagnation de l'informatique à grande échelle

Maintenant, les États-Unis ont atteint un plateau en raison d'un manque d'innovation technologique.

La loi de Wright s'applique dans de nombreuses industries : chaque fois que le processus de fabrication est amélioré d'environ 20 %, la productivité double.

En technologie, cela se manifeste par la loi de Moore.

Dans les années 1960, Gordon Moore, cofondateur d'Intel, a remarqué que le nombre de transistors dans les circuits intégrés semblait avoir doublé d'année en année et a proposé la loi de Moore.

Depuis lors, cette loi est devenue la base du contrat entre le marketing et l'ingénierie, tirant parti de la puissance de calcul excédentaire et de la diminution de la taille pour piloter la construction de produits dans la pile informatique.

On s’attendait alors à ce que la puissance de calcul s’améliore de façon exponentielle au fil du temps grâce à des processeurs plus rapides et moins chers.

Cependant, les différentes forces qui composent la loi de Moore ont changé.

Pendant des décennies, la force motrice derrière la loi de Moore a été la loi d’échelle de Dennard. La taille du transistor et la consommation d'énergie sont simultanément réduites de moitié, doublant la quantité de calcul par unité d'énergie (cette dernière est également connue sous le nom de loi de Koomey).

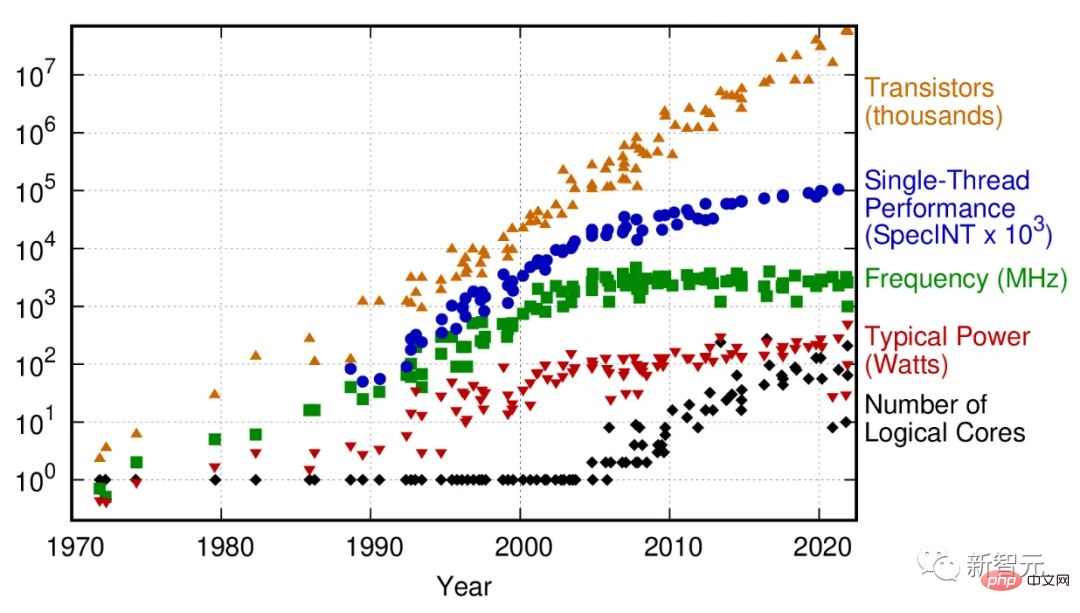

50 ans de données sur les tendances des microprocesseurs

En 2005, cette mise à l'échelle a commencé à s'effondrer car une fuite de courant provoquait un échauffement de la puce, et avec elle les performances des puces dotées d'un seul cœur de traitement stagnaient.

Pour maintenir la trajectoire de croissance de l'informatique, l'industrie des puces s'est tournée vers des architectures multicœurs : plusieurs microprocesseurs « collés » ensemble. Bien que cela puisse étendre la loi de Moore en termes de densité de transistors, cela augmente la complexité de l'ensemble de la pile informatique.

Pour certains types de tâches informatiques, comme l'apprentissage automatique ou l'infographie, cela apporte des améliorations de performances. Mais pour de nombreuses tâches informatiques générales qui ne sont pas bien parallélisées, les architectures multicœurs sont impuissantes.

En bref, la puissance de calcul pour de nombreuses tâches n'augmente plus de façon exponentielle.

Même en termes de performances des supercalculateurs multicœurs, à en juger par le TOP500 (classement des supercalculateurs les plus rapides au monde), il y a eu un net point d'inflexion vers 2010.

Quels sont les effets de ce ralentissement ? Le rôle croissant que joue l'informatique dans différentes industries montre que l'impact est immédiat et ne fera que s'accentuer à mesure que la loi de Moore s'affaiblira.

Prenons deux exemples extrêmes : l'amélioration de la puissance de calcul et la réduction des coûts ont conduit à une augmentation de 49 % de la productivité de l'exploration pétrolière dans le secteur de l'énergie et à une augmentation de 94 % des prévisions de repliement des protéines dans l'industrie de la biotechnologie.

Cela signifie que l'impact de la vitesse de calcul ne se limite pas à l'industrie technologique : la majeure partie de la croissance économique des 50 dernières années a été des effets de second ordre entraînés par la loi de Moore, et sans elle, l'économie mondiale pourrait cesser de croître.

Une autre raison importante expliquant le besoin de plus de puissance de calcul est la montée en puissance de l’intelligence artificielle. Aujourd’hui, la formation d’un grand modèle linguistique (LLM) peut coûter des millions de dollars et prendre des semaines.

L'avenir promis par l'apprentissage automatique ne peut être réalisé sans une augmentation continue du traitement des nombres et de la mise à l'échelle des données.

À mesure que les modèles d'apprentissage automatique deviennent de plus en plus répandus dans les technologies grand public, annonçant des demandes informatiques énormes, voire hyperboliques, dans d'autres secteurs, un traitement bon marché devient la pierre angulaire de la productivité.

La mort de la loi de Moore pourrait entraîner une grande stagnation de l’informatique. Comparés aux réseaux neuronaux multimodaux qui peuvent être nécessaires pour réaliser l'AGI, les LLM actuels sont encore relativement petits et faciles à former. Les futurs GPT et leurs concurrents auront besoin d’ordinateurs hautes performances particulièrement puissants pour s’améliorer, voire optimiser.

Peut-être que beaucoup de gens auront des doutes. Après tout, la fin de la loi de Moore a été prédite à plusieurs reprises. Pourquoi devrait-il l'être maintenant ?

Historiquement, bon nombre de ces prédictions découlent de défis techniques. L’ingéniosité humaine a surmonté ces obstacles à maintes reprises auparavant.

La différence est désormais que nous ne sommes plus confrontés à des défis d’ingénierie et d’intelligence, mais plutôt à des limitations imposées par la physique.

MIT Technology Review a publié un article le 24 février disant que nous ne sommes pas préparés à la fin de la loi de Moore

Surchauffe entraînant une incapacité à traiter

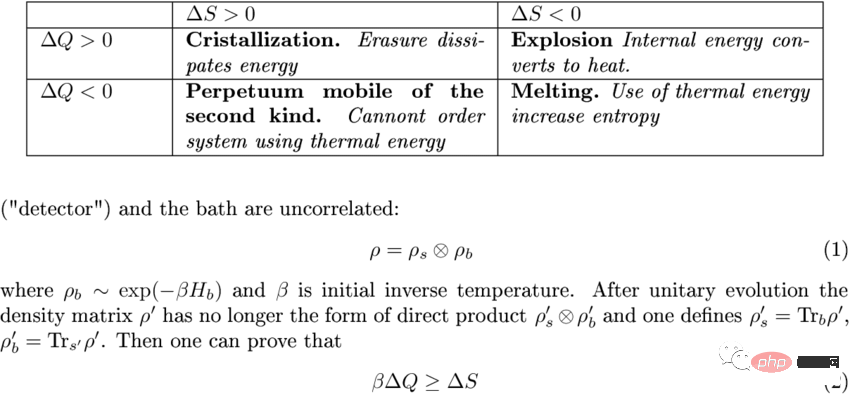

Les ordinateurs fonctionnent en traitant les informations.

Lorsqu'ils traitent les informations, une partie de celles-ci est supprimée lorsque le microprocesseur fusionne les branches informatiques ou écrase le registre. Ce n'est pas gratuit.

Les lois de la thermodynamique imposent des limites strictes à l'efficacité de certains processus, et elles s'appliquent aux calculs comme aux machines à vapeur. Ce coût est appelé limite de Landauer.

C'est une infime quantité de chaleur émise lors de chaque opération de calcul : environ 10^-21 joules par bit.

Étant donné que cette chaleur est si faible, la limite de Landauer a longtemps été considérée comme négligeable.

Cependant, les capacités d'ingénierie ont désormais progressé au point où cette échelle d'énergie peut être atteinte, car la limite réelle est estimée à 10 à 100 fois supérieure à la limite de Landauer en raison d'autres frais généraux tels que les fuites de courant. Les puces contiennent des centaines de milliards de transistors qui fonctionnent des milliards de fois par seconde.

Ajoutez ces chiffres ensemble, et peut-être que la loi de Moore a encore un ordre de grandeur à croître avant d'atteindre la barrière thermique.

À ce stade, les architectures de transistors existantes ne seront pas en mesure d’améliorer davantage l’efficacité énergétique et la chaleur générée empêchera les transistors d’être plus étroitement emballés.

Si nous ne comprenons pas cela, nous ne pourrons pas voir clairement comment les valeurs de l’industrie vont changer.

Les microprocesseurs seront limités et l’industrie sera en compétition pour obtenir des récompenses moindres en cas d’efficacité énergétique marginale.

La taille des puces augmentera. Regardez la carte GPU de la série 4000 de Nvidia : malgré l'utilisation d'un processus à plus haute densité, elle a à peu près la taille d'un petit chien et contient une énorme puissance de 650 W.

Cela a incité le PDG de NVIDIA, Jensen Huang, à déclarer fin 2022 que « la loi de Moore est morte » – une déclaration qui, bien que généralement vraie, a été démentie par d'autres sociétés de semi-conducteurs.

L'IEEE publie chaque année une feuille de route pour les semi-conducteurs. La dernière évaluation indique que la mise à l'échelle 2D sera achevée en 2028 et que la mise à l'échelle 3D devrait être entièrement lancée en 2031.

La mise à l'échelle 3D (où les puces sont empilées les unes sur les autres) est déjà courante, mais dans la mémoire des ordinateurs, pas dans les microprocesseurs.

Cela est dû au fait que la dissipation thermique de la mémoire est beaucoup plus faible ; cependant, la dissipation thermique est complexe dans l'architecture 3D, le refroidissement actif de la mémoire devient donc important.

Une mémoire avec 256 couches arrive et devrait atteindre la barre des 1 000 couches d'ici 2030.

De retour aux microprocesseurs, les architectures de dispositifs multi-portes qui deviennent des standards commerciaux (comme les FinFET et les Gates-all-round) continueront de suivre la loi de Moore dans les années à venir.

Cependant, en raison de problèmes thermiques inhérents, une véritable mise à l'échelle verticale était impossible après les années 1930.

En fait, les chipsets actuels surveillent attentivement quelles parties du processeur sont actives à tout moment pour éviter une surchauffe même sur un seul plan.

Crise 2030 ?

Il y a un siècle, le poète américain Robert Frost demandait un jour : le monde finira-t-il par le gel ou par le feu

Si la réponse est le feu, cela annonce presque la fin de l'informatique ?

Ou, acceptez simplement le fait que la consommation d’énergie augmentera et intensifiera la fabrication de microprocesseurs.

Pour cela, les humains ont consommé une grande partie de l’énergie terrestre.

Une autre option consiste peut-être simplement à accepter l’augmentation de la consommation d’énergie et à augmenter la fabrication des microprocesseurs. Nous utilisons déjà une grande partie de l’énergie disponible sur Terre à cette fin.

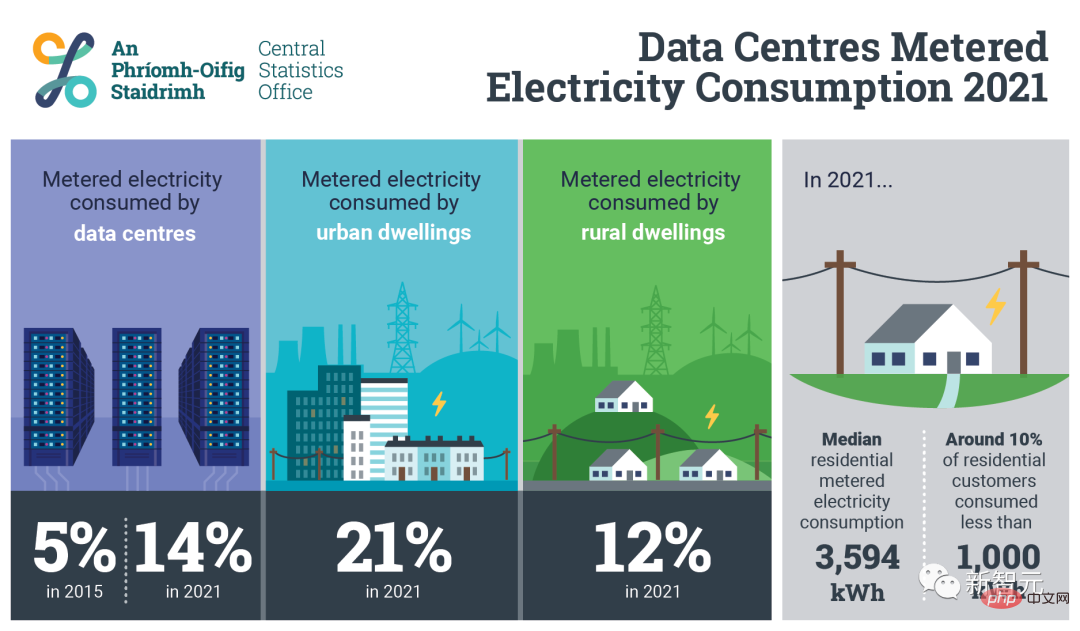

En Irlande, seuls 70 centres de données consomment 14 % de l’énergie du pays. D’ici 2030, on estime que 30 à 50 % de l’électricité produite dans le monde sera utilisée pour l’informatique et le refroidissement.

(Fait intéressant, après la publication du billet de blog le 19 mars, l'auteur a supprimé cette prédiction. Son explication est qu'elle est basée sur la pire inférence de l'article de Nature, par souci de clarté et d'exactitude de argument , qui a maintenant été supprimé)

Le rythme actuel de mise à l'échelle de la production d'énergie entraînera une légère augmentation du coût de la mise à l'échelle de la loi de Moore.

Une série de mesures ponctuelles d’optimisation au niveau de la conception (efficacité énergétique) et de la mise en œuvre (remplacement des anciennes conceptions encore utilisées par les dernières technologies) permettra aux économies en développement comme l’Inde de rattraper la productivité globale du monde.

Après la fin de la loi de Moore, l'humanité sera à court d'énergie avant que la fabrication de puces à microprocesseur n'atteigne ses limites, et le rythme de baisse des coûts informatiques stagnera.

Bien que l'informatique quantique soit présentée comme un moyen efficace de surpasser la loi de Moore, il y a trop d'inconnues à son sujet, et il reste encore des décennies avant qu'elle ne soit utilisée commercialement. Au moins dans les 20 à 30 prochaines années, elle ne sera pas utile.

De toute évidence, il y aura un grave déficit de puissance de calcul au cours des 10 prochaines années, et aucune entreprise technologique, investisseur ou agence gouvernementale existante ne sera en mesure de le résoudre.

La collision entre la loi de Moore et la limite de Landauer dure depuis des décennies et peut être considérée comme l'un des événements les plus importants et les plus critiques des années 2030.

Mais maintenant, il semble que peu de gens soient au courant.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

La multiplication matricielle universelle de CUDA : de l'entrée à la maîtrise !

Mar 25, 2024 pm 12:30 PM

La multiplication matricielle universelle de CUDA : de l'entrée à la maîtrise !

Mar 25, 2024 pm 12:30 PM

La multiplication matricielle générale (GEMM) est un élément essentiel de nombreuses applications et algorithmes, et constitue également l'un des indicateurs importants pour évaluer les performances du matériel informatique. Une recherche approfondie et l'optimisation de la mise en œuvre de GEMM peuvent nous aider à mieux comprendre le calcul haute performance et la relation entre les systèmes logiciels et matériels. En informatique, une optimisation efficace de GEMM peut augmenter la vitesse de calcul et économiser des ressources, ce qui est crucial pour améliorer les performances globales d’un système informatique. Une compréhension approfondie du principe de fonctionnement et de la méthode d'optimisation de GEMM nous aidera à mieux utiliser le potentiel du matériel informatique moderne et à fournir des solutions plus efficaces pour diverses tâches informatiques complexes. En optimisant les performances de GEMM

Comment calculer l'addition, la soustraction, la multiplication et la division dans un document Word

Mar 19, 2024 pm 08:13 PM

Comment calculer l'addition, la soustraction, la multiplication et la division dans un document Word

Mar 19, 2024 pm 08:13 PM

WORD est un traitement de texte puissant. Nous pouvons utiliser Word pour éditer divers textes. Dans les tableaux Excel, nous maîtrisons les méthodes de calcul d'addition, de soustraction et de multiplicateurs. Ainsi, si nous avons besoin de calculer l'addition de valeurs numériques dans les tableaux Word, Comment soustraire le multiplicateur ? Puis-je utiliser uniquement une calculatrice pour le calculer ? La réponse est bien sûr non, WORD peut aussi le faire. Aujourd'hui, je vais vous apprendre à utiliser des formules pour calculer des opérations de base telles que l'addition, la soustraction, la multiplication et la division dans des tableaux dans des documents Word. Apprenons ensemble. Alors, aujourd'hui, permettez-moi de vous montrer en détail comment calculer l'addition, la soustraction, la multiplication et la division dans un document WORD ? Étape 1 : ouvrez un WORD, cliquez sur [Tableau] sous [Insérer] dans la barre d'outils et insérez un tableau dans le menu déroulant.

Comment compter le nombre d'éléments dans une liste à l'aide de la fonction count() de Python

Nov 18, 2023 pm 02:53 PM

Comment compter le nombre d'éléments dans une liste à l'aide de la fonction count() de Python

Nov 18, 2023 pm 02:53 PM

Comment utiliser la fonction count() de Python pour compter le nombre d'éléments dans une liste nécessite des exemples de code spécifiques. En tant que langage de programmation puissant et facile à apprendre, Python fournit de nombreuses fonctions intégrées pour gérer différentes structures de données. L'une d'elles est la fonction count(), qui peut être utilisée pour compter le nombre d'éléments dans une liste. Dans cet article, nous expliquerons en détail comment utiliser la fonction count() et fournirons des exemples de code spécifiques. La fonction count() est une fonction intégrée de Python, utilisée pour calculer un certain

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

L'article de StableDiffusion3 est enfin là ! Ce modèle est sorti il y a deux semaines et utilise la même architecture DiT (DiffusionTransformer) que Sora. Il a fait beaucoup de bruit dès sa sortie. Par rapport à la version précédente, la qualité des images générées par StableDiffusion3 a été considérablement améliorée. Il prend désormais en charge les invites multithèmes, et l'effet d'écriture de texte a également été amélioré et les caractères tronqués n'apparaissent plus. StabilityAI a souligné que StableDiffusion3 est une série de modèles avec des tailles de paramètres allant de 800M à 8B. Cette plage de paramètres signifie que le modèle peut être exécuté directement sur de nombreux appareils portables, réduisant ainsi considérablement l'utilisation de l'IA.

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

La prédiction de trajectoire joue un rôle important dans la conduite autonome. La prédiction de trajectoire de conduite autonome fait référence à la prédiction de la trajectoire de conduite future du véhicule en analysant diverses données pendant le processus de conduite du véhicule. En tant que module central de la conduite autonome, la qualité de la prédiction de trajectoire est cruciale pour le contrôle de la planification en aval. La tâche de prédiction de trajectoire dispose d'une riche pile technologique et nécessite une connaissance de la perception dynamique/statique de la conduite autonome, des cartes de haute précision, des lignes de voie, des compétences en architecture de réseau neuronal (CNN&GNN&Transformer), etc. Il est très difficile de démarrer ! De nombreux fans espèrent se lancer dans la prédiction de trajectoire le plus tôt possible et éviter les pièges. Aujourd'hui, je vais faire le point sur quelques problèmes courants et des méthodes d'apprentissage introductives pour la prédiction de trajectoire ! Connaissances introductives 1. Existe-t-il un ordre d'entrée pour les épreuves de prévisualisation ? R : Regardez d’abord l’enquête, p

DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

Mar 21, 2024 pm 05:21 PM

DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

Mar 21, 2024 pm 05:21 PM

Cet article explore le problème de la détection précise d'objets sous différents angles de vue (tels que la perspective et la vue à vol d'oiseau) dans la conduite autonome, en particulier comment transformer efficacement les caractéristiques de l'espace en perspective (PV) en vue à vol d'oiseau (BEV). implémenté via le module Visual Transformation (VT). Les méthodes existantes sont globalement divisées en deux stratégies : la conversion 2D en 3D et la conversion 3D en 2D. Les méthodes 2D vers 3D améliorent les caractéristiques 2D denses en prédisant les probabilités de profondeur, mais l'incertitude inhérente aux prévisions de profondeur, en particulier dans les régions éloignées, peut introduire des inexactitudes. Alors que les méthodes 3D vers 2D utilisent généralement des requêtes 3D pour échantillonner des fonctionnalités 2D et apprendre les poids d'attention de la correspondance entre les fonctionnalités 3D et 2D via un transformateur, ce qui augmente le temps de calcul et de déploiement.

Comment utiliser la fonction Math.Pow en C# pour calculer la puissance d'un nombre spécifié

Nov 18, 2023 am 11:32 AM

Comment utiliser la fonction Math.Pow en C# pour calculer la puissance d'un nombre spécifié

Nov 18, 2023 am 11:32 AM

En C#, il existe une bibliothèque de classes Math, qui contient de nombreuses fonctions mathématiques. Il s'agit notamment de la fonction Math.Pow, qui calcule les puissances, ce qui peut nous aider à calculer la puissance d'un nombre spécifié. L'utilisation de la fonction Math.Pow est très simple, il suffit de spécifier la base et l'exposant. La syntaxe est la suivante : Math.Pow(base,exponent) ; où base représente la base et exponent représente l'exposant. Cette fonction renvoie un résultat de type double, c'est-à-dire le résultat du calcul de puissance. Allons

'Minecraft' se transforme en une ville IA et les habitants des PNJ jouent comme de vraies personnes

Jan 02, 2024 pm 06:25 PM

'Minecraft' se transforme en une ville IA et les habitants des PNJ jouent comme de vraies personnes

Jan 02, 2024 pm 06:25 PM

Veuillez noter que cet homme carré fronça les sourcils, pensant à l'identité des « invités non invités » devant lui. Il s’est avéré qu’elle se trouvait dans une situation dangereuse, et une fois qu’elle s’en est rendu compte, elle a rapidement commencé une recherche mentale pour trouver une stratégie pour résoudre le problème. Finalement, elle a décidé de fuir les lieux, de demander de l'aide le plus rapidement possible et d'agir immédiatement. En même temps, la personne de l'autre côté pensait la même chose qu'elle... Il y avait une telle scène dans "Minecraft" où tous les personnages étaient contrôlés par l'intelligence artificielle. Chacun d’eux a un cadre identitaire unique. Par exemple, la jeune fille mentionnée précédemment est une coursière de 17 ans mais intelligente et courageuse. Ils ont la capacité de se souvenir, de penser et de vivre comme des humains dans cette petite ville de Minecraft. Ce qui les anime est une toute nouvelle,