Périphériques technologiques

Périphériques technologiques

IA

IA

Microsoft propose OTO, un cadre d'élagage automatisé de réseau neuronal, pour obtenir des modèles légers hautes performances en un seul arrêt

Microsoft propose OTO, un cadre d'élagage automatisé de réseau neuronal, pour obtenir des modèles légers hautes performances en un seul arrêt

Microsoft propose OTO, un cadre d'élagage automatisé de réseau neuronal, pour obtenir des modèles légers hautes performances en un seul arrêt

OTO est le premier cadre de formation et de compression de structure de réseaux neuronaux automatisé, unique, convivial et polyvalent du secteur.

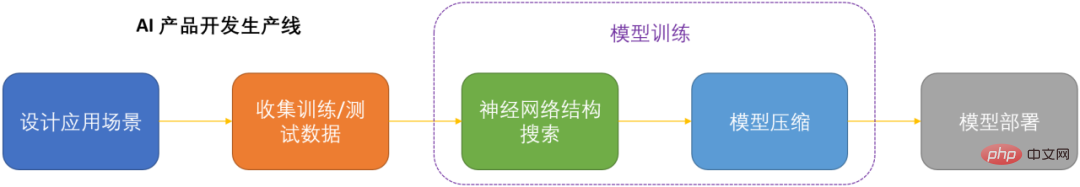

À l'ère de l'intelligence artificielle, la manière de déployer et de maintenir les réseaux de neurones est une question clé pour la production. Compte tenu de la réduction des coûts de calcul tout en minimisant la perte de performances des modèles, la compression des réseaux de neurones est devenue l'une des clés de la production des DNN.

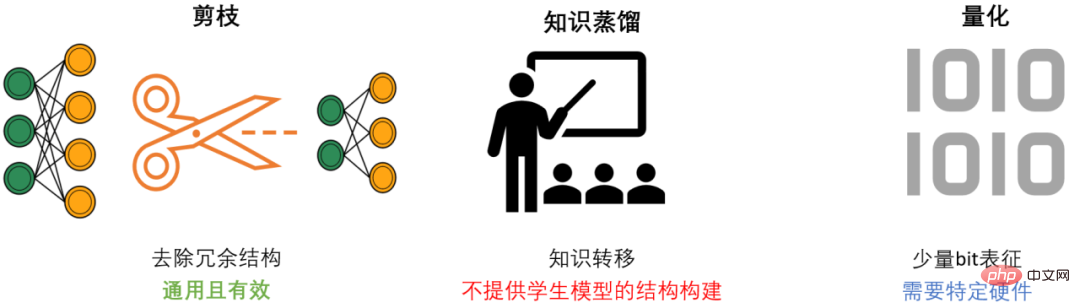

La compression DNN comporte généralement trois méthodes : l'élagage, la distillation des connaissances et la quantification. L'élagage vise à identifier et supprimer les structures redondantes, à affiner le DNN tout en conservant autant que possible les performances du modèle. Il s'agit de la méthode de compression la plus polyvalente et la plus efficace. De manière générale, les trois méthodes peuvent se compléter et fonctionner ensemble pour obtenir le meilleur effet de compression.

Cependant, la plupart des méthodes d'élagage existantes ne ciblent que des modèles et des tâches spécifiques, et nécessitent de solides connaissances professionnelles dans le domaine. Par conséquent, les développeurs d'IA doivent généralement consacrer beaucoup d'efforts pour appliquer ces méthodes à leurs propres scénarios. Cela consomme beaucoup de coûts humains et matériels.

Présentation de l'OTO

Afin de résoudre les problèmes des méthodes d'élagage existantes et de faciliter la tâche des développeurs d'IA, l'équipe Microsoft a proposé le framework OTO Only-Train-Once. OTO est le premier cadre de formation et de compression de structure de réseaux neuronaux automatisé, unique, convivial et universel du secteur. Une série de travaux a été publiée dans ICLR2023 et NeurIPS2021.

En utilisant OTO, les ingénieurs en IA peuvent facilement entraîner des réseaux neuronaux cibles et obtenir des modèles légers et performants en un seul arrêt. OTO minimise l'investissement du développeur en temps et en efforts d'ingénierie, et ne nécessite pas de pré-formation fastidieuse ni de réglage supplémentaire du modèle que nécessitent généralement les méthodes existantes.

- Lien papier :

- OTOv2 ICLR 2023 : https://openreview.net/pdf?id=7ynoX1ojPMt

- OTOv1 NeurIPS 2021 : https://proceedings.neurips.cc/paper_files/paper/2021/file/a376033f78e144 f49 4bfc743c0be3330 -Paper.pdf

- Lien de code :

https://github.com/tianyic/only_train_once

Algorithme de base du cadre

L'algorithme d'élagage structurel idéalisé devrait être : une solution automatisée unique pour les réseaux de neurones généraux. Facilement s'entraîner à partir de zéro tout en obtenant un modèle performant et léger sans avoir besoin de réglages ultérieurs. Mais en raison de la complexité des réseaux neuronaux, atteindre cet objectif est extrêmement difficile. Afin d'atteindre cet objectif ultime, les trois questions fondamentales suivantes doivent être systématiquement résolues :

- Comment savoir quelles structures de réseau peuvent être supprimées ?

- Comment supprimer la structure du réseau sans perdre autant que possible les performances du modèle ?

- Comment pouvons-nous accomplir automatiquement les deux points ci-dessus ?

L'équipe Microsoft a conçu et mis en œuvre trois ensembles d'algorithmes de base, résolvant systématiquement et complètement ces trois problèmes fondamentaux pour la première fois.

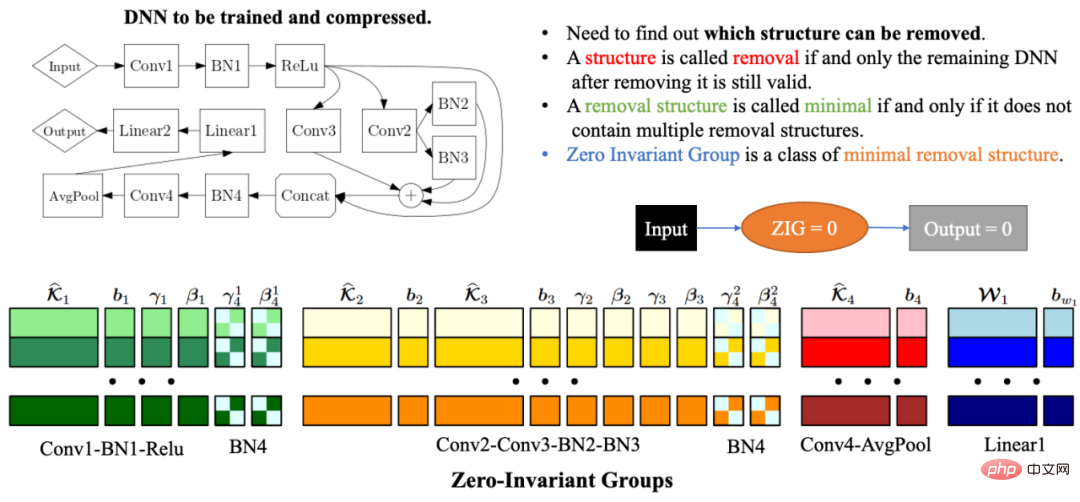

Groupes automatisés à zéro invariant

En raison de la complexité et de la corrélation de la structure du réseau, la suppression de toute structure de réseau peut rendre la structure de réseau restante invalide. Par conséquent, l’un des plus gros problèmes de la compression automatisée de la structure du réseau est de savoir comment trouver les paramètres du modèle qui doivent être élagués ensemble pour que le réseau restant soit toujours valide. Pour résoudre ce problème, l'équipe Microsoft a proposé des groupes zéro-invariant (ZIG) dans OTOv1. Le groupe invariant zéro peut être compris comme un type de plus petite unité amovible, de sorte que le réseau restant est toujours valide après la suppression de la structure de réseau correspondante du groupe. Une autre grande propriété d'un groupe invariant zéro est que si un groupe invariant zéro est égal à zéro, alors quelle que soit la valeur d'entrée, la valeur de sortie est toujours nulle. Dans OTOv2, les chercheurs ont en outre proposé et mis en œuvre un ensemble d’algorithmes automatisés pour résoudre le problème de regroupement de groupes invariants nuls dans les réseaux généraux. L'algorithme de regroupement automatisé est une combinaison soigneusement conçue d'une série d'algorithmes graphiques. L'ensemble de l'algorithme est très efficace et présente une complexité temporelle et spatiale linéaire.

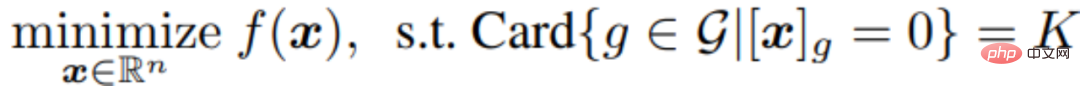

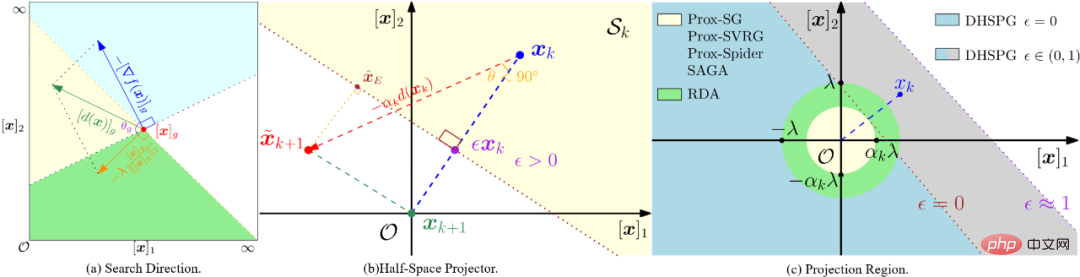

Algorithme d'optimisation de gradient projeté à double demi-plan (DHSPG)

Après avoir divisé tous les groupes zéro-invariants du réseau cible, les prochaines tâches de formation et d'élagage du modèle doivent déterminer quels groupes zéro-invariants sont redondants .Le reste, lesquels sont importants. La structure de réseau correspondant aux groupes redondants invariants zéro doit être supprimée et les groupes importants invariants zéro doivent être conservés pour garantir les performances du modèle de compression. Les chercheurs ont formulé ce problème comme un problème de sparsification structurelle et ont proposé un nouvel algorithme d’optimisation DHSPG (Dual Half-Space Projected Gradient) pour le résoudre.

DHSPG peut très efficacement trouver des groupes redondants invariants zéro et les projeter à zéro, et former en continu d'importants groupes invariants zéro pour obtenir des performances comparables au modèle d'origine.

Par rapport aux algorithmes d'optimisation clairsemés traditionnels, DHSPG dispose de capacités d'exploration de structures clairsemées plus fortes et plus stables, et étend l'espace de recherche de formation, de sorte qu'il obtient généralement des résultats de performances réelles plus élevés.

Construire automatiquement un modèle de compression léger

En utilisant DHSPG pour entraîner le modèle, nous obtiendrons une solution qui obéit à la grande parcimonie structurelle du groupe zéro invariant, c'est-à-dire qu'il y en a beaucoup dans la solution qui sont projetés dans un ensemble de zéros invariants par zéro, et cette solution aura également des performances de modèle élevées. Ensuite, les chercheurs ont supprimé toutes les structures correspondant aux groupes redondants invariants de zéro pour construire automatiquement un réseau de compression. En raison des caractéristiques des groupes invariants zéro, c'est-à-dire que si un groupe invariant zéro est égal à zéro, alors quelle que soit la valeur d'entrée, la valeur de sortie sera toujours nulle, donc la suppression des groupes redondants invariants zéro ne sera pas avoir un impact sur le réseau. Par conséquent, le réseau compressé obtenu via OTO aura le même résultat que le réseau complet, sans qu’il soit nécessaire d’affiner davantage le modèle requis par les méthodes traditionnelles.

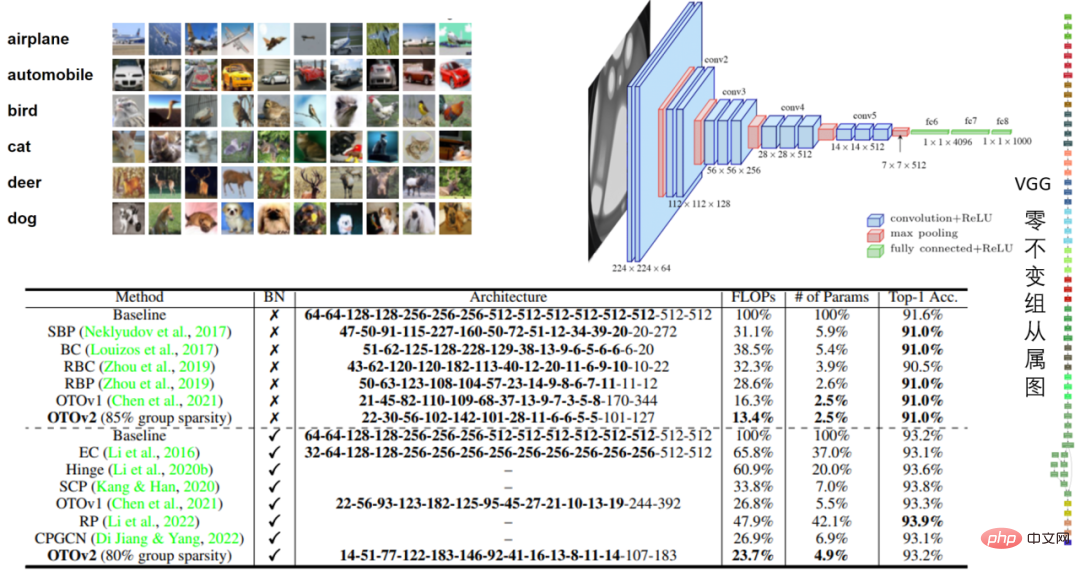

De nombreuses expériences 任 Modèles VGG16 et VGG16-BN dans CIFAR10 et modèles VGG16-BN dans CIFAR10 Dans l'expérience VGG16 de CIFAR10, le volume a été réduit de 97,5% et les performances étaient impressionnantes.

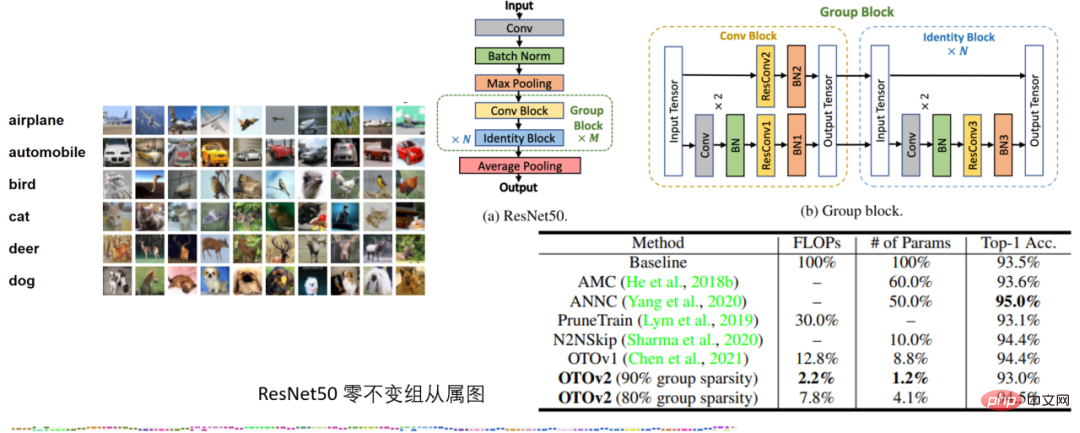

Tableau 2 : Expérience ResNet50 sur CIFAR10

Tableau 2 : Expérience ResNet50 sur CIFAR10

Dans l'expérience ResNet50 sur CIFAR10, OTO surpasse les frameworks de compression de réseau neuronal SOTA AMC et ANNC sans quantification, en utilisant seulement 7,8 % des FLOP et 4,1 % des paramètres.

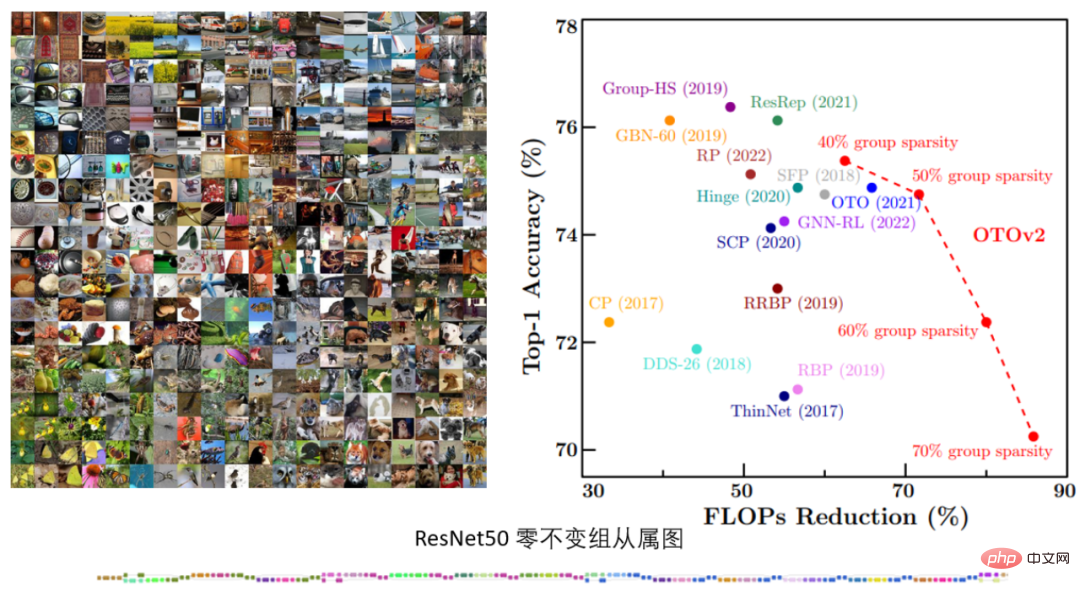

Tableau 3. Expérience ResNet50 d'ImageNet

Tableau 3. Expérience ResNet50 d'ImageNet

Dans l'expérience ResNet50 d'ImageNet, OTOv2 a montré des performances comparables, voire meilleures, que la méthode SOTA existante sous différentes cibles de sparsification structurelle.

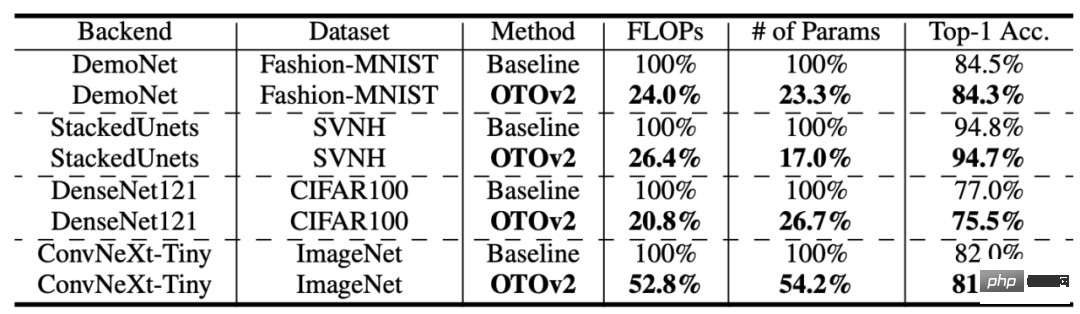

Tableau 4 : Plus de structures et d'ensembles de données

Tableau 4 : Plus de structures et d'ensembles de données

OTO obtient également de bonnes performances sur davantage d'ensembles de données et de structures de modèles.

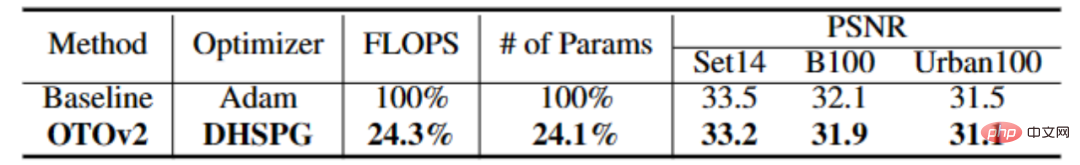

Tâche de vision de bas niveau

Tableau 4 : Expérience CARNx2

Dans la tâche de super-résolution, la formation à guichet unique OTO a compressé le réseau CARNx2 et a obtenu un résultat compétitif par rapport au modèle original performances et compressé la charge de travail de calcul et la taille du modèle de plus de 75 %.Tâche de modèle de langage

De plus, les chercheurs ont également mené des expériences comparatives sur Bert sur l'un des algorithmes de base, l'algorithme d'optimisation DHSPG, et ont vérifié ses hautes performances par rapport à d'autres algorithmes d'optimisation clairsemés. On peut constater que sur Squad, la réduction des paramètres et les performances du modèle obtenues en utilisant DHSPG pour la formation sont de loin supérieures à d'autres algorithmes d'optimisation clairsemés.

ConclusionL'équipe Microsoft a proposé un cadre automatisé d'élagage de structure de formation de réseau neuronal à guichet unique appelé OTO (Only-Train-Once). Il peut automatiquement compresser un réseau neuronal complet en un réseau léger tout en conservant des performances élevées. OTO simplifie considérablement le processus complexe en plusieurs étapes des méthodes d'élagage structurel existantes, convient à diverses architectures et applications de réseau et minimise l'investissement d'ingénierie supplémentaire des utilisateurs. Il est polyvalent, efficace et facile à utiliser.Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Mise à niveau de Microsoft Edge : la fonction de sauvegarde automatique du mot de passe interdite ? ! Les utilisateurs ont été choqués !

Apr 19, 2024 am 08:13 AM

Mise à niveau de Microsoft Edge : la fonction de sauvegarde automatique du mot de passe interdite ? ! Les utilisateurs ont été choqués !

Apr 19, 2024 am 08:13 AM

Actualités du 18 avril : Récemment, certains utilisateurs du navigateur Microsoft Edge utilisant le canal Canary ont signalé qu'après la mise à niveau vers la dernière version, ils avaient constaté que l'option d'enregistrement automatique des mots de passe était désactivée. Après enquête, il a été constaté qu'il s'agissait d'un ajustement mineur après la mise à niveau du navigateur, plutôt que d'une suppression de fonctionnalités. Avant d'utiliser le navigateur Edge pour accéder à un site Web, les utilisateurs ont signalé que le navigateur ouvrait une fenêtre leur demandant s'ils souhaitaient enregistrer le mot de passe de connexion au site Web. Après avoir choisi d'enregistrer, Edge remplira automatiquement le numéro de compte et le mot de passe enregistrés lors de votre prochaine connexion, offrant ainsi aux utilisateurs une grande commodité. Mais la dernière mise à jour ressemble à un ajustement, modifiant les paramètres par défaut. Les utilisateurs doivent choisir d'enregistrer le mot de passe, puis activer manuellement le remplissage automatique du compte et du mot de passe enregistrés dans les paramètres.

Microsoft publie la mise à jour cumulative Win11 août : amélioration de la sécurité, optimisation de l'écran de verrouillage, etc.

Aug 14, 2024 am 10:39 AM

Microsoft publie la mise à jour cumulative Win11 août : amélioration de la sécurité, optimisation de l'écran de verrouillage, etc.

Aug 14, 2024 am 10:39 AM

Selon les informations de ce site du 14 août, lors de la journée d'événement Patch Tuesday d'aujourd'hui, Microsoft a publié des mises à jour cumulatives pour les systèmes Windows 11, notamment la mise à jour KB5041585 pour 22H2 et 23H2 et la mise à jour KB5041592 pour 21H2. Après l'installation de l'équipement mentionné ci-dessus avec la mise à jour cumulative d'août, les changements de numéro de version attachés à ce site sont les suivants : Après l'installation de l'équipement 21H2, le numéro de version est passé à Build22000.314722H2. le numéro de version est passé à Build22621.403723H2. Après l'installation de l'équipement, le numéro de version est passé à Build22631.4037. Le contenu principal de la mise à jour KB5041585 pour Windows 1121H2 est le suivant : Amélioration : Amélioré.

La fenêtre contextuelle plein écran de Microsoft exhorte les utilisateurs de Windows 10 à se dépêcher et à passer à Windows 11

Jun 06, 2024 am 11:35 AM

La fenêtre contextuelle plein écran de Microsoft exhorte les utilisateurs de Windows 10 à se dépêcher et à passer à Windows 11

Jun 06, 2024 am 11:35 AM

Selon l'actualité du 3 juin, Microsoft envoie activement des notifications en plein écran à tous les utilisateurs de Windows 10 pour les encourager à passer au système d'exploitation Windows 11. Ce déplacement concerne les appareils dont les configurations matérielles ne prennent pas en charge le nouveau système. Depuis 2015, Windows 10 occupe près de 70 % des parts de marché, établissant ainsi sa domination en tant que système d'exploitation Windows. Cependant, la part de marché dépasse largement la part de marché de 82 %, et la part de marché dépasse largement celle de Windows 11, qui sortira en 2021. Même si Windows 11 est lancé depuis près de trois ans, sa pénétration sur le marché est encore lente. Microsoft a annoncé qu'il mettrait fin au support technique de Windows 10 après le 14 octobre 2025 afin de se concentrer davantage sur

La fonction de compression des fichiers 7z et TAR de Microsoft Win11 a été rétrogradée des versions 24H2 aux versions 23H2/22H2

Apr 28, 2024 am 09:19 AM

La fonction de compression des fichiers 7z et TAR de Microsoft Win11 a été rétrogradée des versions 24H2 aux versions 23H2/22H2

Apr 28, 2024 am 09:19 AM

Selon les informations de ce site le 27 avril, Microsoft a publié la mise à jour de la version préliminaire de Windows 11 Build 26100 sur les canaux Canary et Dev plus tôt ce mois-ci, qui devrait devenir une version RTM candidate de la mise à jour Windows 1124H2. Les principaux changements de la nouvelle version sont l'explorateur de fichiers, l'intégration de Copilot, l'édition des métadonnées des fichiers PNG, la création de fichiers compressés TAR et 7z, etc. @PhantomOfEarth a découvert que Microsoft a délégué certaines fonctions de la version 24H2 (Germanium) à la version 23H2/22H2 (Nickel), comme la création de fichiers compressés TAR et 7z. Comme le montre le schéma, Windows 11 prendra en charge la création native de TAR

Mise à jour du navigateur Microsoft Edge : ajout de la fonction 'zoomer sur l'image' pour améliorer l'expérience utilisateur

Mar 21, 2024 pm 01:40 PM

Mise à jour du navigateur Microsoft Edge : ajout de la fonction 'zoomer sur l'image' pour améliorer l'expérience utilisateur

Mar 21, 2024 pm 01:40 PM

Selon l'actualité du 21 mars, Microsoft a récemment mis à jour son navigateur Microsoft Edge et ajouté une fonction pratique « agrandir l'image ». Désormais, lorsqu'ils utilisent le navigateur Edge, les utilisateurs peuvent facilement trouver cette nouvelle fonctionnalité dans le menu contextuel en cliquant simplement avec le bouton droit sur l'image. Ce qui est plus pratique, c'est que les utilisateurs peuvent également passer le curseur sur l'image, puis double-cliquer sur la touche Ctrl pour appeler rapidement la fonction de zoom avant sur l'image. Selon la compréhension de l'éditeur, le nouveau navigateur Microsoft Edge a été testé pour les nouvelles fonctionnalités du canal Canary. La version stable du navigateur a également officiellement lancé la fonction pratique « agrandir l'image », offrant aux utilisateurs une expérience de navigation d'images plus pratique. Les médias scientifiques et technologiques étrangers y ont également prêté attention.

Exploration des réseaux siamois en utilisant la perte contrastive pour la comparaison de similarité d'images

Apr 02, 2024 am 11:37 AM

Exploration des réseaux siamois en utilisant la perte contrastive pour la comparaison de similarité d'images

Apr 02, 2024 am 11:37 AM

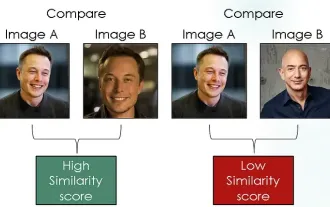

Introduction Dans le domaine de la vision par ordinateur, mesurer avec précision la similarité des images est une tâche critique avec un large éventail d'applications pratiques. Des moteurs de recherche d’images aux systèmes de reconnaissance faciale en passant par les systèmes de recommandation basés sur le contenu, la capacité de comparer et de trouver efficacement des images similaires est importante. Le réseau siamois combiné à la perte contrastive fournit un cadre puissant pour apprendre la similarité des images de manière basée sur les données. Dans cet article de blog, nous plongerons dans les détails des réseaux siamois, explorerons le concept de perte contrastive et explorerons comment ces deux composants fonctionnent ensemble pour créer un modèle de similarité d'image efficace. Premièrement, le réseau siamois se compose de deux sous-réseaux identiques partageant les mêmes poids et paramètres. Chaque sous-réseau code l'image d'entrée dans un vecteur de caractéristiques, qui

Microsoft prévoit de supprimer progressivement NTLM dans Windows 11 au second semestre 2024 et de passer entièrement à l'authentification Kerberos

Jun 09, 2024 pm 04:17 PM

Microsoft prévoit de supprimer progressivement NTLM dans Windows 11 au second semestre 2024 et de passer entièrement à l'authentification Kerberos

Jun 09, 2024 pm 04:17 PM

Au second semestre 2024, le blog officiel de sécurité Microsoft a publié un message en réponse à l'appel de la communauté de la sécurité. La société prévoit d'éliminer le protocole d'authentification NTLAN Manager (NTLM) dans Windows 11, publié au second semestre 2024, pour améliorer la sécurité. Selon des explications précédentes, Microsoft a déjà pris des mesures similaires auparavant. Le 12 octobre dernier, Microsoft a proposé un plan de transition dans un communiqué de presse officiel visant à supprimer progressivement les méthodes d'authentification NTLM et à inciter davantage d'entreprises et d'utilisateurs à passer à Kerberos. Pour aider les entreprises susceptibles de rencontrer des problèmes avec les applications et services câblés après avoir désactivé l'authentification NTLM, Microsoft fournit IAKerb et

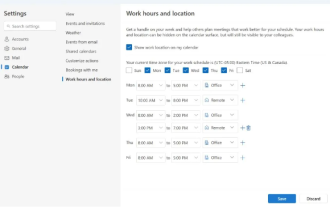

Microsoft lance une nouvelle version d'Outlook pour Windows : mise à niveau complète des fonctions de calendrier

Apr 27, 2024 pm 03:44 PM

Microsoft lance une nouvelle version d'Outlook pour Windows : mise à niveau complète des fonctions de calendrier

Apr 27, 2024 pm 03:44 PM

Dans l'actualité du 27 avril, Microsoft a annoncé qu'il publierait bientôt un test d'une nouvelle version du client Outlook pour Windows. Cette mise à jour se concentre principalement sur l’optimisation de la fonction de calendrier, dans le but d’améliorer l’efficacité du travail des utilisateurs et de simplifier davantage le flux de travail quotidien. L'amélioration de la nouvelle version du client Outlook pour Windows réside dans sa fonction de gestion de calendrier plus puissante. Désormais, les utilisateurs peuvent partager plus facilement leurs horaires de travail personnels et leurs informations de localisation, ce qui rend la planification des réunions plus efficace. En outre, Outlook a également ajouté des paramètres conviviaux, permettant aux utilisateurs de configurer les réunions pour qu'elles se terminent automatiquement plus tôt ou commencent plus tard, offrant ainsi aux utilisateurs plus de flexibilité, qu'ils souhaitent changer de salle de réunion, faire une pause ou prendre une tasse de café. . selon