Périphériques technologiques

Périphériques technologiques

IA

IA

ChatGPT Waterloo : interdiction généralisée de compte par l'Italie ;

ChatGPT Waterloo : interdiction généralisée de compte par l'Italie ;

ChatGPT Waterloo : interdiction généralisée de compte par l'Italie ;

ChatGPT semble connaître un Waterloo.

Le 31 mars, un grand nombre d'utilisateurs se sont plaints sur les plateformes sociales de ne plus pouvoir se connecter au compte ChatGPT qu'ils avaient ouvert avec leur propre argent. Ce qui était encore plus embarrassant, c'est qu'ils ne pouvaient pas créer un nouveau compte. Comme de plus en plus d'utilisateurs l'ont révélé, il a été découvert que l'incident d'interdiction de compte avait commencé le 30 mars et se propageait rapidement.

Le 1er avril, de plus en plus de personnes ont déclaré que leurs comptes étaient bloqués, et les utilisateurs des principales plateformes et des discussions de groupe se sont précipités pour se dire des « notes » pour éviter d'être bloqués. A cette époque, les comptes Plus initialement utilisables n'ont pas été épargnés et sont devenus invalides les uns après les autres, et certains enregistrements n'ont pas pu être vérifiés dans la facture.

Bizarrement, depuis le 3 avril, les interdictions de comptes à grande échelle ne semblent pas s'être arrêtées. De nombreux internautes ont également posté sur les plateformes sociales en disant : « ChatGPT interdit les comptes à grande échelle ». Un grand nombre d'utilisateurs ont signalé que les interdictions silencieuses de comptes étaient cette fois principalement concentrées en Asie. Dans le même temps, OpenAI n'a émis aucun avertissement ni réponse à ce sujet.

En termes de conformité, ChatGPT a également fait l'objet d'un nouveau contrôle. Le site Web Record a révélé que l'agence italienne de protection des données a officiellement annoncé une interdiction temporaire de l'utilisation de ChatGPT et a strictement demandé à sa société mère OpenAI de cesser de traiter les informations des utilisateurs italiens. L'Italie a "tiré" le premier coup pour interdire ChatGPT !

Quant aux raisons de l'interdiction de ChatGPT, l'agence italienne de protection des données a déclaré qu'OpenAI a non seulement collecté illégalement une grande quantité de données personnelles d'utilisateurs italiens, mais ce qui est encore pire, c'est qu'OpenAI n'a pas mis en place de mécanisme pour vérifier l'âge. des utilisateurs de ChatGPT pour empêcher les mineurs d'accéder à du matériel illégal.

L'Agence italienne de protection des données a en outre souligné qu'OpenAI disposait de 20 jours pour défendre son vol d'informations, faute de quoi elle pourrait être condamnée à une amende pouvant aller jusqu'à 20 millions d'euros ou 4 % du chiffre d'affaires annuel de l'entreprise pour violation du règlement général sur la protection des données de l'UE. Non seulement en termes d'amendes, une fois qu'OpenAI ne peut pas expliquer en détail si elle a pris des mesures pour protéger les données des utilisateurs, cela augmentera inévitablement la probabilité que les pays de l'UE interdisent ChatGPT.

Après que l'Italie ait interdit ChatGPT, OpenAI a immédiatement mis ChatGPT hors ligne en Italie. Son PDG, Sam Altman, a immédiatement tweeté pour expliquer que le travail effectué par l'entreprise consistait à réduire les données personnelles lors de la formation de systèmes d'intelligence artificielle tels que ChatGPT. comprendra le monde plutôt que les individus. L'entreprise n'a enfreint aucune réglementation et attend avec impatience de coopérer avec l'autorité italienne de protection des données personnelles.

ChatGPT est sans aucun doute une arme à double tranchant

Il est indéniable que l'émergence de ChatGPT déclenchera un nouveau cycle de révolution de l'information et profitera davantage à l'humanité, mais tout a deux faces, et la société attend avec impatience le avantages que ChatGPT apportera à l’humanité Lorsqu’une opportunité sans précédent se présente, vous devez également réfléchir aux risques de sécurité que son émergence entraînera. Après tout, en seulement deux ou trois mois, les risques de sécurité liés à l’utilisation de ChatGPT se sont succédés.

Les utilisateurs peuvent consulter les enregistrements de discussion des autres utilisateurs

ChatGPT montre une image « parfaite » depuis son lancement, mais à mesure que le nombre d'utilisateurs augmentait progressivement, certains risques de sécurité ont progressivement commencé à être exposés.

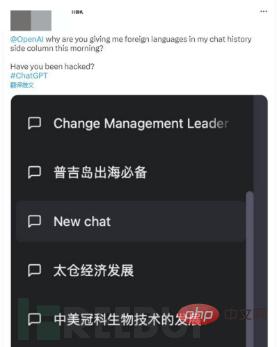

Début mars 2023, certains utilisateurs ont révélé que les enregistrements de discussion d'autres personnes étaient affichés dans leurs listes de discussion. Pendant un certain temps, ChatGPT a divulgué les données des utilisateurs et a finalement occupé les principales listes de médias sociaux. de publier en urgence un tweet pour expliquer aux utilisateurs que le BUG qui a provoqué la fuite de l'historique de discussion ChatGPT de l'utilisateur n'était qu'un bug dans la base de code open source.

Après la fuite des enregistrements de discussion des utilisateurs, bien qu'OpenAI ait facilement admis aux médias qu'il y avait une vulnérabilité de sécurité dans ChatGPT et immédiatement déconnecté la fonction d'historique de discussion, il a toujours souligné que seul le titre de l'historique de discussion était fuite. Les utilisateurs ne peuvent pas voir les discussions réelles des autres.

À en juger par les informations divulguées par OpenAI, le contenu des conversations des utilisateurs sera automatiquement enregistré dans le cloud et il existe une possibilité de vol par un tiers. Combiné à cette fuite d'enregistrements de discussion historiques, de plus en plus de chercheurs en sécurité ont commencé à le faire. Considérez sérieusement l'émergence de ChatGPT. Si les problèmes de sécurité des informations sont accidentels.

L'utilisation de ChatGPT par Samsung a entraîné une fuite de données confidentielles

Une vague après l'autre. La semaine dernière, les médias sud-coréens ont révélé que le géant de la technologie Samsung Electronics avait été exposé à trois fuites de données internes confidentielles moins de 20 jours après l'introduction de ChatGPT. (2 cas étaient liés à des équipements semi-conducteurs et 1 cas était lié au contenu de réunions internes).

Il est rapporté que ces informations confidentielles de Samsung Electronics peuvent avoir été importées dans la base de données ChatGPT et risquent de fuir à tout moment.

Description détaillée des trois incidents :

- Les employés du département des solutions d'équipement de Samsung DS ont rencontré des problèmes de copie lors de l'utilisation d'équipements de test de semi-conducteurs pour télécharger des logiciels. Ils ont donc collé le code problématique dans ChatGPT et ont essayé de le faire. Cependant, cette décision peut permettre à ChatGPT d'utiliser les informations confidentielles de Samsung comme matériel de formation

- Un autre employé du département DS Device Solutions a essayé d'utiliser ChatGPT pour l'aider à optimiser un morceau de code, il a donc directement lié le résultat et la qualité à un morceau de code lié à le dispositif d'enregistrement des tarifs y a été saisi

- Après qu'un initié de Samsung ait utilisé l'assistant vocal AI Naver Clova pour convertir l'enregistrement de la réunion en texte, il a souhaité utiliser ChatGPT pour résumer et affiner le contenu de la réunion, mais cela peut conduire à la fuite de comptes rendus confidentiels de réunions.

Après la fuite de Samsung Electronics, ils ont immédiatement organisé le personnel de sécurité en interne pour formuler des mesures de protection pertinentes, et ont déclaré que si des incidents similaires se reproduisaient à l'avenir, Samsung pourrait couper le service ChatGPT en interne. En outre, les médias ont révélé que Samsung envisageait actuellement de développer des services d'IA spécifiques à Samsung via le DS Department Innovation Center.

Le 11 mars de cette année, Samsung Electronics a adopté une résolution autorisant les employés du département DS à utiliser ChatGPT, mais ChatGPT est toujours désactivé pour les employés du département Expérience des appareils DX. En conséquence, nous avons rencontré trois incidents de sécurité inattendus en seulement vingt jours. Cela montre que la sécurité de ChatGPT mérite effectivement d'être prise en considération.

Samsung n'est pas la seule entreprise où les employés téléchargent des données confidentielles d'entreprise sur ChatGPT. À en juger par les statistiques de Cyberhaven sur l'utilisation de ChatGPT par 1,6 million d'employés, environ 3,1 % des employés téléchargent directement des données internes de l'entreprise sur ChatGPT pour analyse afin d'améliorer l'efficacité du travail.

Un certain nombre de personnalités scientifiques ont appelé conjointement à un moratoire sur la recherche sur le développement d'une IA plus puissante.

Comme le montre le contenu mentionné ci-dessus, ChatGPT est largement utilisé et comporte de sérieux risques de sécurité, donc en ce qui concerne l'avenir de ChatGPT. et l'intelligence artificielle , ont suscité des inquiétudes du public concernant la technologie de l'IA, et de nombreuses personnalités scientifiques bien connues ont déclaré conjointement qu'elles suspendraient le développement de systèmes d'IA plus puissants.

Le 29 mars, heure des États-Unis, parmi les participants, dont le père de l'intelligence artificielle, Jeffrey Hinton, le PDG de Tesla et Twitter, Elon Musk, le lauréat du Turing Award Joshua Bengio, etc. Des milliers d'experts en intelligence artificielle et de dirigeants de l'industrie ont signé une lettre ouverte intitulée " Pause Large Model Experiments in AI" publié par le Future of Life Institute, une organisation américaine à but non lucratif.

Dans la lettre, ces experts de haut niveau ont appelé tous les laboratoires d'intelligence artificielle à suspendre le développement et la formation de systèmes d'intelligence artificielle plus puissants pendant au moins six mois. Dans des circonstances particulières, les gouvernements devraient intervenir rapidement et suspendre immédiatement le système d'IA. recherche.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1393

1393

52

52

1207

1207

24

24

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Étapes d'installation : 1. Téléchargez le logiciel ChatGTP depuis le site officiel ou la boutique mobile de ChatGTP ; 2. Après l'avoir ouvert, dans l'interface des paramètres, sélectionnez la langue chinoise 3. Dans l'interface de jeu, sélectionnez le jeu homme-machine et définissez la langue. Spectre chinois ; 4. Après avoir démarré, entrez les commandes dans la fenêtre de discussion pour interagir avec le logiciel.

Chatgpt peut-il être utilisé en Chine ?

Mar 05, 2024 pm 03:05 PM

Chatgpt peut-il être utilisé en Chine ?

Mar 05, 2024 pm 03:05 PM

chatgpt peut être utilisé en Chine, mais ne peut pas être enregistré, ni à Hong Kong et Macao. Si les utilisateurs souhaitent s'inscrire, ils peuvent utiliser un numéro de téléphone mobile étranger pour s'inscrire. Notez que lors du processus d'enregistrement, l'environnement réseau doit être basculé vers. une adresse IP étrangère.

Maîtrisez la sécurité des réseaux et les tests d'intrusion dans Go

Nov 30, 2023 am 10:16 AM

Maîtrisez la sécurité des réseaux et les tests d'intrusion dans Go

Nov 30, 2023 am 10:16 AM

Avec le développement d’Internet, la sécurité des réseaux est devenue un enjeu urgent. Pour le personnel technique engagé dans des travaux de sécurité des réseaux, il est sans aucun doute nécessaire de maîtriser un langage de programmation efficace, stable et sécurisé. Parmi eux, le langage Go est devenu le premier choix pour de nombreux praticiens de la sécurité des réseaux. Le langage Go, appelé Golang, est un langage de programmation open source créé par Google. Le langage possède des fonctionnalités exceptionnelles telles qu'une efficacité élevée, une simultanéité élevée, une fiabilité élevée et une sécurité élevée, il est donc largement utilisé dans la sécurité des réseaux et les tests d'intrusion.

L'intelligence artificielle et la cybersécurité : enjeux actuels et orientations futures

Mar 01, 2024 pm 08:19 PM

L'intelligence artificielle et la cybersécurité : enjeux actuels et orientations futures

Mar 01, 2024 pm 08:19 PM

L’intelligence artificielle (IA) a révolutionné tous les domaines, et la cybersécurité ne fait pas exception. À mesure que notre dépendance à l’égard de la technologie continue de croître, les menaces qui pèsent sur notre infrastructure numérique augmentent également. L'intelligence artificielle (IA) a révolutionné le domaine de la cybersécurité, offrant des capacités avancées de détection des menaces, de réponse aux incidents et d'évaluation des risques. Cependant, l’utilisation de l’intelligence artificielle en cybersécurité pose certaines difficultés. Cet article examinera l’état actuel de l’intelligence artificielle en matière de cybersécurité et explorera les orientations futures. Le rôle de l'intelligence artificielle dans la cybersécurité Les gouvernements, les entreprises et les particuliers sont confrontés à des défis de plus en plus graves en matière de cybersécurité. À mesure que les cybermenaces deviennent plus sophistiquées, le besoin de mesures de protection de sécurité avancées continue d’augmenter. L'intelligence artificielle (IA) s'appuie sur sa méthode unique pour identifier, prévenir

SearchGPT : Open AI affronte Google avec son propre moteur de recherche IA

Jul 30, 2024 am 09:58 AM

SearchGPT : Open AI affronte Google avec son propre moteur de recherche IA

Jul 30, 2024 am 09:58 AM

L’Open AI fait enfin son incursion dans la recherche. La société de San Francisco a récemment annoncé un nouvel outil d'IA doté de capacités de recherche. Rapporté pour la première fois par The Information en février de cette année, le nouvel outil s'appelle à juste titre SearchGPT et propose un c

Comment les fonctions C++ implémentent-elles la sécurité réseau dans la programmation réseau ?

Apr 28, 2024 am 09:06 AM

Comment les fonctions C++ implémentent-elles la sécurité réseau dans la programmation réseau ?

Apr 28, 2024 am 09:06 AM

Les fonctions C++ peuvent assurer la sécurité du réseau dans la programmation réseau. Les méthodes incluent : 1. L'utilisation d'algorithmes de cryptage (openssl) pour crypter la communication ; 2. L'utilisation de signatures numériques (cryptopp) pour vérifier l'intégrité des données et l'identité de l'expéditeur ; 3. La défense contre les attaques de scripts inter-sites ; ( htmlcxx) pour filtrer et nettoyer les entrées de l'utilisateur.

ChatGPT est désormais disponible pour macOS avec la sortie d'une application dédiée

Jun 27, 2024 am 10:05 AM

ChatGPT est désormais disponible pour macOS avec la sortie d'une application dédiée

Jun 27, 2024 am 10:05 AM

L'application ChatGPT Mac d'Open AI est désormais accessible à tous, après avoir été limitée aux seuls utilisateurs disposant d'un abonnement ChatGPT Plus au cours des derniers mois. L'application s'installe comme n'importe quelle autre application Mac native, à condition que vous disposiez d'un Apple S à jour.