Périphériques technologiques

Périphériques technologiques

IA

IA

Pour résoudre le problème de l'apprentissage des représentations VAE, l'Université d'Hokkaido a proposé un nouveau modèle génératif GWAE

Pour résoudre le problème de l'apprentissage des représentations VAE, l'Université d'Hokkaido a proposé un nouveau modèle génératif GWAE

Pour résoudre le problème de l'apprentissage des représentations VAE, l'Université d'Hokkaido a proposé un nouveau modèle génératif GWAE

L'apprentissage de représentations de faible dimension de données de grande dimension est une tâche fondamentale dans l'apprentissage non supervisé, car de telles représentations capturent succinctement l'essence des données et permettent d'effectuer des tâches en aval basées sur des entrées de faible dimension. L'auto-encodeur variationnel (VAE) est une méthode d'apprentissage de représentation importante, mais en raison de son contrôle objectif, l'apprentissage de la représentation reste une tâche difficile. Bien que l'objectif de limite inférieure de preuve (ELBO) de la VAE soit modélisé de manière générative, l'apprentissage des représentations n'est pas directement ciblé sur cet objectif, ce qui nécessite des modifications spécifiques à la tâche d'apprentissage des représentations, telles que le démêlage. Ces modifications conduisent parfois à des changements implicites et indésirables dans le modèle, ce qui rend l'apprentissage de la représentation contrôlée une tâche difficile.

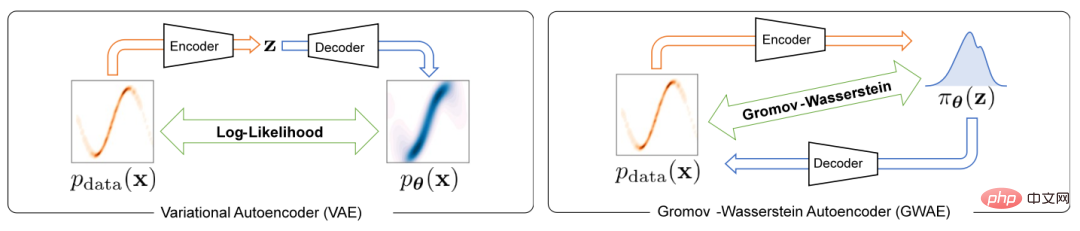

Pour résoudre le problème d'apprentissage des représentations dans les auto-encodeurs variationnels, cet article propose un nouveau modèle génératif appelé Gromov-Wasserstein Autoencoders (GWAE). GWAE fournit un nouveau cadre pour l'apprentissage des représentations basé sur l'architecture du modèle d'encodeur automatique variationnel (VAE). Contrairement aux méthodes traditionnelles d'apprentissage des représentations basées sur la VAE pour la modélisation générative des variables de données, GWAE obtient des représentations bénéfiques grâce à un transfert optimal entre les données et les variables latentes. La métrique de Gromov-Wasserstein (GW) rend possible ce transfert optimal entre variables non comparables (par exemple des variables de dimensions différentes), qui se concentre sur la structure de distance des variables considérées. En remplaçant l'objectif ELBO par la métrique GW, GWAE effectue une comparaison entre les données et l'espace latent, ciblant directement l'apprentissage des représentations dans les auto-encodeurs variationnels (Figure 1). Cette formulation de l'apprentissage des représentations permet aux représentations apprises d'avoir des propriétés spécifiques considérées comme bénéfiques (par exemple, la décomposabilité), appelées méta-priorités.

Figure 1 La différence entre VAE et GWAE

Cette recherche a été acceptée par l'ICLR 2023.

- Lien papier : https://arxiv.org/abs/2209.07007

- Lien code : https://github.com/ganmodokix/gwae

Introduction à la méthode

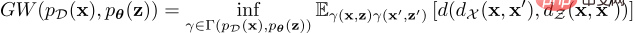

La cible GW entre la distribution des données et la distribution a priori potentielle est définie comme suit :

Cette formule de coût de transmission optimal peut mesurer l'incohérence des distributions dans des espaces incomparables cependant, pour des distributions continues, en raison de la ; nécessité Tous les couplages ont une limite inférieure et il n'est pas pratique de calculer les valeurs exactes de GW. Pour résoudre ce problème, GWAE résout un problème d'optimisation détendu pour estimer et minimiser l'estimateur GW, dont le gradient peut être calculé par différenciation automatique. L'objectif de relaxation est la somme de la métrique GW estimée et de trois pertes de régularisation, qui peuvent toutes être implémentées dans un cadre de programmation différenciable tel que PyTorch. Cet objectif de relaxation se compose d'une perte principale et de trois pertes de régularisation, à savoir la perte principale estimée de GW, la perte de reconstruction basée sur WAE, la perte de condition suffisante fusionnée et la perte de régularisation d'entropie.

Ce schéma peut également personnaliser de manière flexible la distribution antérieure pour introduire des fonctionnalités bénéfiques dans la représentation de faible dimension. Plus précisément, cet article présente trois populations antérieures, à savoir :

Neural Prior (NP) Dans les GWAE avec NP, un réseau neuronal entièrement connecté est utilisé pour construire un dispositif d'échantillonnage préalable. Cette famille de distributions a priori fait moins d'hypothèses sur les variables sous-jacentes et convient aux situations générales.

Factorized Neural Prior (FNP) Dans les GWAE avec FNP, un échantillonneur est construit à l'aide d'un réseau neuronal connecté localement, où les entrées pour chaque variable latente sont générées indépendamment. Cet échantillonneur produit une représentation factorisée a priori et une représentation indépendante par terme, ce qui constitue une méthode importante pour le démêlage méta-a priori représentatif.

Gaussian Mixture Prior (GMP) Dans GMP, il est défini comme un mélange de plusieurs distributions gaussiennes, et son échantillonneur peut être implémenté à l'aide de techniques de paramétrage lourdes et de techniques Gumbel-Max. GMP permet de faire l'hypothèse de clusters dans la représentation, où chaque composante gaussienne du prior est censée capturer un cluster.

Expériences et résultats

Cette étude évalue empiriquement GWAE avec deux méta-prieurs principaux : désentremêlement et clustering.

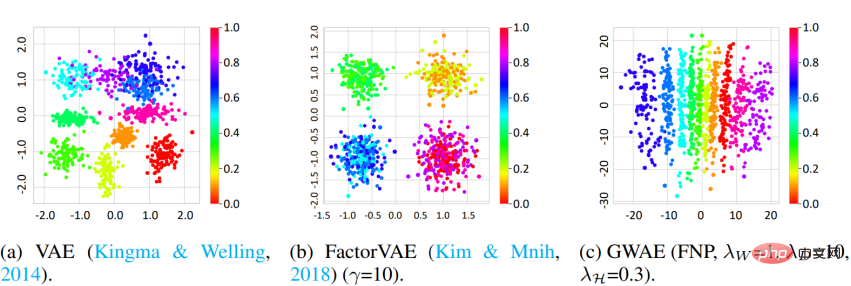

Démêlement L'étude a utilisé l'ensemble de données 3D Shapes et la métrique DCI pour mesurer la capacité de démêlage de GWAE. Les résultats montrent que GWAE utilisant FNP est capable d'apprendre les facteurs de teinte des objets sur un seul axe, ce qui démontre la capacité de démêlage de GWAE. L'évaluation quantitative démontre également les performances de démêlage du GWAE.

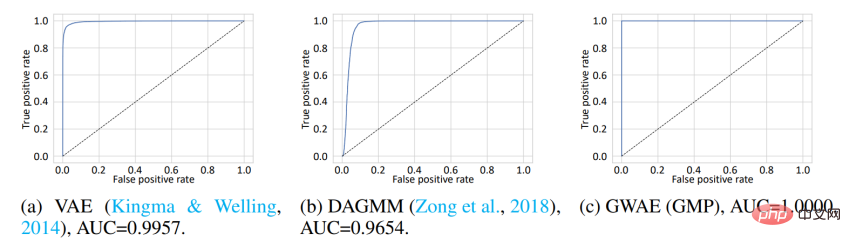

Clustering Pour évaluer les représentations obtenues sur la base des méta-priorités de clustering, cette étude a mené une détection hors distribution (OoD). L'ensemble de données MNIST est utilisé comme données In-Distribution (ID) et l'ensemble de données Omniglot est utilisé comme données OoD. Alors que MNIST contient des chiffres manuscrits, Omniglot contient des lettres manuscrites avec des lettres différentes. Dans cette expérience, les ensembles de données ID et OoD partagent le domaine des images manuscrites, mais ils contiennent des caractères différents. Les modèles sont formés sur les données d'identification, puis utilisent leurs représentations apprises pour détecter les données d'identification ou OoD. Dans VAE et DAGMM, la variable utilisée pour la détection OoD est le log-vraisemblance a priori, tandis que dans GWAE, c'est le potentiel de Kantorovich. Le prior pour GWAE a été construit en utilisant GMP pour capturer les clusters de MNIST. La courbe ROC montre les performances de détection OoD des modèles, les trois modèles atteignant des performances presque parfaites. Cependant, le GWAE construit à l'aide de GMP a obtenu les meilleurs résultats en termes d'aire sous la courbe (AUC).

De plus, cette étude a évalué la capacité générative du GWAE.

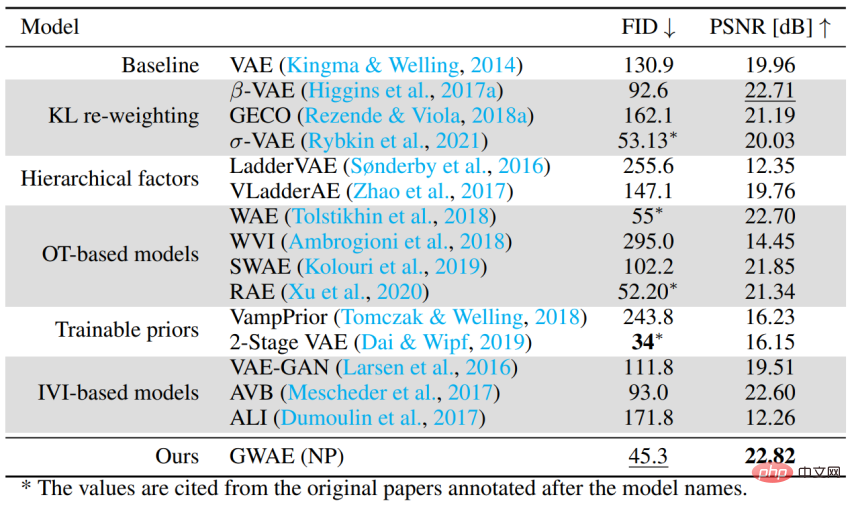

Performances en tant que modèle génératif basé sur un auto-encodeur Pour évaluer la capacité de GWAE à gérer le cas général sans méta-prieurs spécifiques, les performances génératives ont été évaluées à l'aide de l'ensemble de données CelebA. L'expérience utilise FID pour évaluer les performances génératives du modèle et PSNR pour évaluer les performances d'auto-encodage. GWAE a obtenu la deuxième meilleure performance générative et la meilleure performance d'auto-encodage en utilisant NP, démontrant sa capacité à capturer la distribution des données dans son modèle et à capturer les informations sur les données dans sa représentation.

Résumé

- GWAE est un modèle génératif d'auto-encodeur variationnel construit sur la base de la métrique de Gromov-Wasserstein et est conçu pour effectuer directement un apprentissage de représentation.

- Étant donné que l'a priori ne nécessite que des échantillons différenciables, divers paramètres de distribution a priori peuvent être construits pour supposer des méta-a priori (propriétés idéales de la représentation).

- Des expériences sur les méta-prieurs primaires et l'évaluation des performances en tant qu'auto-encodeur variationnel démontrent la flexibilité de la formulation GWAE et les capacités d'apprentissage des représentations de GWAE.

- Page d'accueil personnelle du premier auteur Nao Nakagawa : https://ganmodokix.com/note/cv

- Page d'accueil du Laboratoire multimédia de l'Université d'Hokkaido : https://www-lmd.ist.hokudai ac.jp. /

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Les startups d'IA ont collectivement transféré leurs emplois vers OpenAI, et l'équipe de sécurité s'est regroupée après le départ d'Ilya !

Jun 08, 2024 pm 01:00 PM

Les startups d'IA ont collectivement transféré leurs emplois vers OpenAI, et l'équipe de sécurité s'est regroupée après le départ d'Ilya !

Jun 08, 2024 pm 01:00 PM

" sept péchés capitaux" » Dissiper les rumeurs : selon des informations divulguées et des documents obtenus par Vox, la haute direction d'OpenAI, y compris Altman, était bien au courant de ces dispositions de récupération de capitaux propres et les a approuvées. De plus, OpenAI est confronté à un problème grave et urgent : la sécurité de l’IA. Les récents départs de cinq employés liés à la sécurité, dont deux de ses employés les plus en vue, et la dissolution de l'équipe « Super Alignment » ont une nouvelle fois mis les enjeux de sécurité d'OpenAI sur le devant de la scène. Le magazine Fortune a rapporté qu'OpenA

Comment évaluer la rentabilité du support commercial des frameworks Java

Jun 05, 2024 pm 05:25 PM

Comment évaluer la rentabilité du support commercial des frameworks Java

Jun 05, 2024 pm 05:25 PM

L'évaluation du rapport coût/performance du support commercial pour un framework Java implique les étapes suivantes : Déterminer le niveau d'assurance requis et les garanties de l'accord de niveau de service (SLA). L’expérience et l’expertise de l’équipe d’appui à la recherche. Envisagez des services supplémentaires tels que les mises à niveau, le dépannage et l'optimisation des performances. Évaluez les coûts de support commercial par rapport à l’atténuation des risques et à une efficacité accrue.

Le modèle 70B génère 1 000 jetons en quelques secondes, la réécriture du code dépasse GPT-4o, de l'équipe Cursor, un artefact de code investi par OpenAI

Jun 13, 2024 pm 03:47 PM

Le modèle 70B génère 1 000 jetons en quelques secondes, la réécriture du code dépasse GPT-4o, de l'équipe Cursor, un artefact de code investi par OpenAI

Jun 13, 2024 pm 03:47 PM

Modèle 70B, 1000 tokens peuvent être générés en quelques secondes, ce qui se traduit par près de 4000 caractères ! Les chercheurs ont affiné Llama3 et introduit un algorithme d'accélération. Par rapport à la version native, la vitesse est 13 fois plus rapide ! Non seulement il est rapide, mais ses performances sur les tâches de réécriture de code dépassent même GPT-4o. Cette réalisation vient d'anysphere, l'équipe derrière le populaire artefact de programmation d'IA Cursor, et OpenAI a également participé à l'investissement. Il faut savoir que sur Groq, un framework d'accélération d'inférence rapide bien connu, la vitesse d'inférence de 70BLlama3 n'est que de plus de 300 jetons par seconde. Avec la vitesse de Cursor, on peut dire qu'il permet une édition complète et quasi instantanée des fichiers de code. Certaines personnes l'appellent un bon gars, si tu mets Curs

Comment la courbe d'apprentissage des frameworks PHP se compare-t-elle à celle d'autres frameworks de langage ?

Jun 06, 2024 pm 12:41 PM

Comment la courbe d'apprentissage des frameworks PHP se compare-t-elle à celle d'autres frameworks de langage ?

Jun 06, 2024 pm 12:41 PM

La courbe d'apprentissage d'un framework PHP dépend de la maîtrise du langage, de la complexité du framework, de la qualité de la documentation et du support de la communauté. La courbe d'apprentissage des frameworks PHP est plus élevée par rapport aux frameworks Python et inférieure par rapport aux frameworks Ruby. Par rapport aux frameworks Java, les frameworks PHP ont une courbe d'apprentissage modérée mais un temps de démarrage plus court.

Comment les options légères des frameworks PHP affectent-elles les performances des applications ?

Jun 06, 2024 am 10:53 AM

Comment les options légères des frameworks PHP affectent-elles les performances des applications ?

Jun 06, 2024 am 10:53 AM

Le framework PHP léger améliore les performances des applications grâce à une petite taille et une faible consommation de ressources. Ses fonctionnalités incluent : une petite taille, un démarrage rapide, une faible utilisation de la mémoire, une vitesse de réponse et un débit améliorés et une consommation de ressources réduite. Cas pratique : SlimFramework crée une API REST, seulement 500 Ko, une réactivité élevée et un débit élevé.

China Mobile : l'humanité entre dans la quatrième révolution industrielle et a officiellement annoncé « trois plans »

Jun 27, 2024 am 10:29 AM

China Mobile : l'humanité entre dans la quatrième révolution industrielle et a officiellement annoncé « trois plans »

Jun 27, 2024 am 10:29 AM

Selon les informations du 26 juin, lors de la cérémonie d'ouverture de la Conférence mondiale des communications mobiles 2024 de Shanghai (MWC Shanghai), le président de China Mobile, Yang Jie, a prononcé un discours. Il a déclaré qu'actuellement, la société humaine entre dans la quatrième révolution industrielle, dominée par l'information et profondément intégrée à l'information et à l'énergie, c'est-à-dire la « révolution de l'intelligence numérique », et la formation de nouvelles forces productives s'accélère. Yang Jie estime que de la « révolution de la mécanisation » entraînée par les machines à vapeur, à la « révolution de l'électrification » entraînée par l'électricité et les moteurs à combustion interne, en passant par la « révolution de l'information » entraînée par les ordinateurs et Internet, chaque cycle de révolution industrielle est basé sur « L'information et « l'énergie » constituent l'axe principal, apportant le développement de la productivité

Comment choisir le meilleur framework Golang pour différents scénarios d'application

Jun 05, 2024 pm 04:05 PM

Comment choisir le meilleur framework Golang pour différents scénarios d'application

Jun 05, 2024 pm 04:05 PM

Choisissez le meilleur framework Go en fonction des scénarios d'application : tenez compte du type d'application, des fonctionnalités du langage, des exigences de performances et de l'écosystème. Frameworks Go courants : Gin (application Web), Echo (service Web), Fibre (haut débit), gorm (ORM), fasthttp (vitesse). Cas pratique : construction de l'API REST (Fiber) et interaction avec la base de données (gorm). Choisissez un framework : choisissez fasthttp pour les performances clés, Gin/Echo pour les applications Web flexibles et gorm pour l'interaction avec la base de données.

L'histoire intérieure de l'algorithme de recherche de Google a été révélée et 2 500 pages de documents avec de vrais noms ont été divulgués ! Les mensonges du classement de recherche dévoilés

Jun 11, 2024 am 09:14 AM

L'histoire intérieure de l'algorithme de recherche de Google a été révélée et 2 500 pages de documents avec de vrais noms ont été divulgués ! Les mensonges du classement de recherche dévoilés

Jun 11, 2024 am 09:14 AM

Récemment, 2 500 pages de documents internes de Google ont été divulguées, révélant le fonctionnement de la recherche, « l’arbitre le plus puissant d’Internet ». Le co-fondateur et PDG de SparkToro est une personne anonyme. Il a publié un article de blog sur son site Web personnel, affirmant qu'« une personne anonyme a partagé avec moi des milliers de pages de documentation divulguée sur l'API de recherche Google que tout le monde dans le domaine du référencement devrait lire ». ! "Depuis de nombreuses années, RandFishkin est le principal porte-parole dans le domaine du SEO (Search Engine Optimization, optimisation des moteurs de recherche), et il a proposé le concept d'« autorité de site Web » (DomainRating). Puisqu'il est très respecté dans ce domaine, RandFishkin