Périphériques technologiques

Périphériques technologiques

IA

IA

Google a perdu la bataille du LLM ! De plus en plus de chercheurs de haut niveau changent d'emploi chez OpenAI

Google a perdu la bataille du LLM ! De plus en plus de chercheurs de haut niveau changent d'emploi chez OpenAI

Google a perdu la bataille du LLM ! De plus en plus de chercheurs de haut niveau changent d'emploi chez OpenAI

Il y a quelques jours, Google a failli être confronté à une crise de relations publiques. Jacob Devlin, un ancien employé de Bert qui avait quitté OpenAI, a révélé que Bard avait en fait été formé à l'aide des données ChatGPT.

Par la suite, Google a rapidement démenti.

Et cette controverse a également donné lieu à un grand débat : pourquoi de plus en plus de chercheurs de haut niveau de Google changent d'emploi pour OpenAI ? Peut-il encore gagner cette bataille du LLM ?

Réponse d'un ami

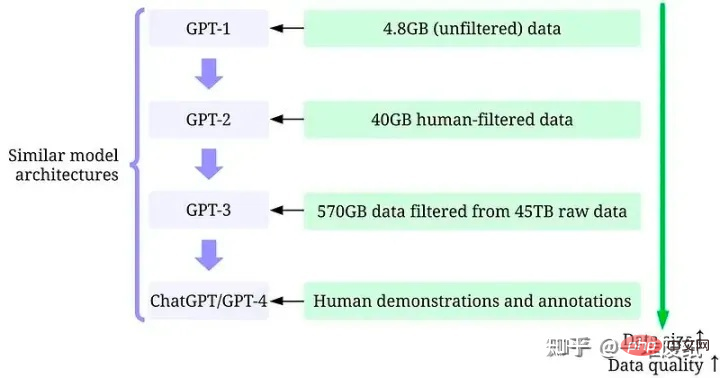

Un médecin de l'Université Rice et un ami proche ont déclaré que l'écart entre Google et OpenAI est en fait un écart de données.

"OpenAI a une forte obsession pour le LLM, qui est totalement inégalée par des entreprises comme Google. Bien sûr, l'écart entre les personnes n'est qu'un aspect, l'écart entre les données et l'attitude envers les données sont la clé de son succès. Les gens peuvent être capable de dépenser de l'argent pour le récupérer, la technologie pourra peut-être compenser, mais le manque de données ne sera pas rattrapé par Google dans peu de temps. "

https://arxiv.org /abs/2303.10158

De toute évidence, le succès de ChatGPT réside dans des données annotées de haute qualité.

"Un tas de vieux papiers" introduit qu'OpenAI attache une grande importance à la qualité des données et des étiquettes. Elle est extrêmement stricte dans la sélection des annotateurs (il y a des examens), et ils finiront même par émettre des questionnaires. C’est cette obsession qui a fait le succès du modèle GPT, que Google ne peut pas du tout égaler.

Et à mesure que des centaines de millions d'utilisateurs continuent de fournir de nouvelles données à OpenAI, l'écart entre Google et OpenAI ne fera que se creuser.

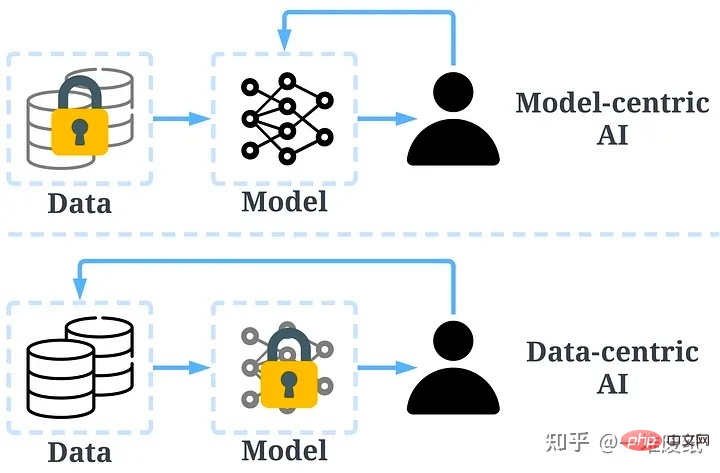

Le concept d’IA centrée sur les données a jeté les bases du succès d’OpenAI.

"Zhang Junlin", un excellent répondeur sur des sujets liés au traitement du langage naturel et à l'apprentissage profond, a déclaré qu'OpenAI avait laissé tout le monde derrière lui.

En incluant Google, en fait, la compréhension du concept de développement LLM est évidemment un pas en retard sur OpenAI. La réalité est qu’OpenAI a trop bien performé et a laissé tout le monde derrière lui, pas seulement au niveau national. Je pense qu'OpenAI est en avance d'environ six mois à un an sur Google et DeepMind à l'étranger en termes de concepts et de technologies associées pour le LLM, et il a environ deux ans d'avance sur la Chine.

"Zhou Daodao", interrogé par Zhihu, a déclaré que comparer le récent renversement de Google avec OpenAI a dû donner un choc énorme à ces chercheurs de haut niveau.

De plus, on dit qu'OpenAI donnera aux chercheurs plus de ressources et d'exigences plus larges que Google. Après tout, OpenAI ressemble plus à une institution de recherche, tandis que Google ressemble plus à un département qui traite l'IA comme un produit.

La réponse donnée par l'intimé "Chen Dabao" est très déchirante.

L'histoire future des affaires enregistrera deux cas classiques et ironiques :

1 Kodak a inventé l'appareil photo numérique

2 Google a inventé le transformateur

Source photo : "Chen Dabao"

Personnes anonymes. les intérêts sont également apparus dans la zone de commentaires.

Une autre personne anonyme a fait mouche.

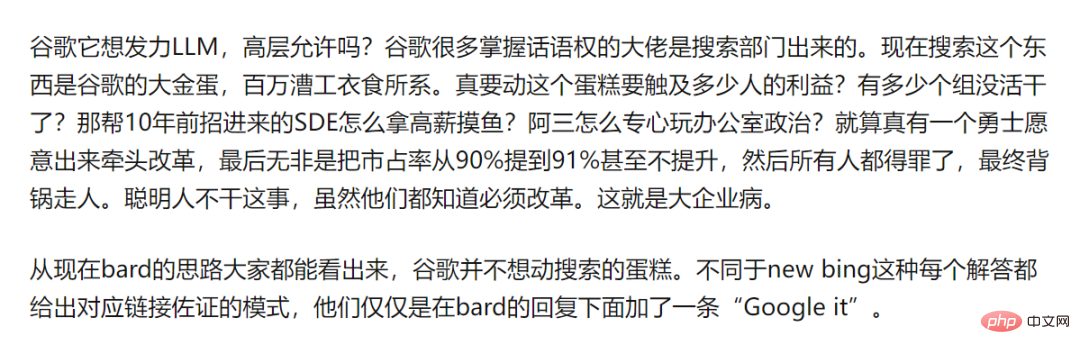

Un ami a souligné le « dilemme de l'innovateur » de Google en tant que grande entreprise.

Une autre personne anonyme intéressée apparaît.

L'ami "Xingnan Zhou (Bill)" a conclu que les grandes entreprises comme Google vont humaniser. Sur la base de la politique, tout le monde est une vis.

Et Insider nous a résumé un long article, faisant le point sur les meilleurs talents qui ont été perdus au sein de l’équipe d’intelligence artificielle de Google au fil des ans.

Où sont passés tous les talents ?

Google a contribué à des recherches très importantes dans le domaine de l'intelligence artificielle. Cependant, l’entreprise a mis du temps à transformer ses innovations en produits.

En conséquence, les meilleurs chercheurs en IA partent vers des startups qui peuvent générer plus de valeur et d'impact, comme OpenAI, Character.AI, DeepMind, Cohere, Inceptive.

Google est déjà dans une position défensive et perdra à tout moment sa position de leader dans le domaine de l'intelligence artificielle. Le départ des meilleurs chercheurs a exacerbé le problème.

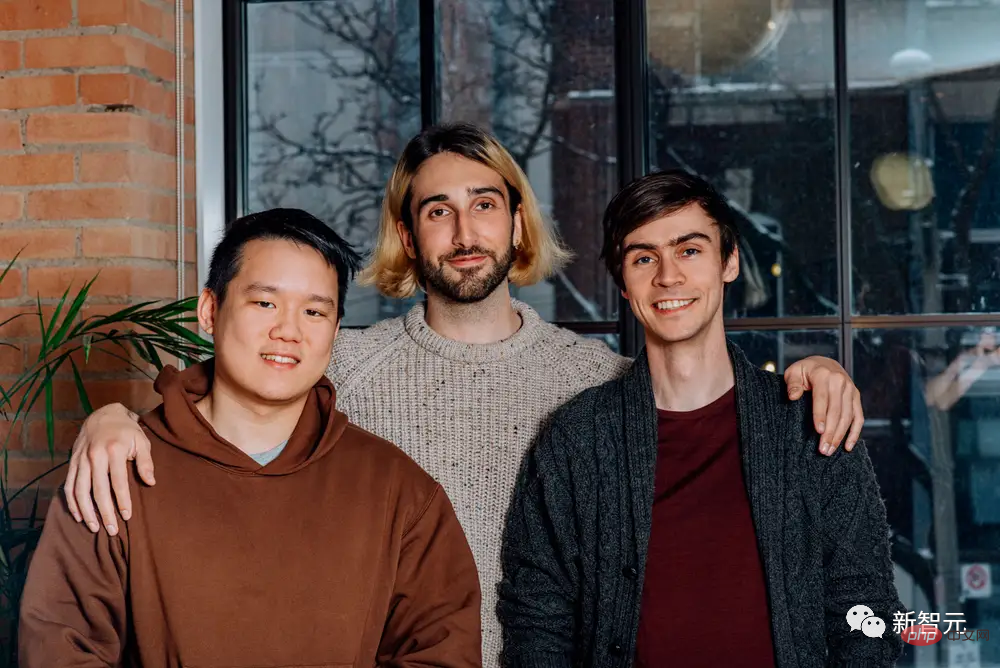

L'équipe co-fondatrice de Cohere, Ivan Zhang, Aidan Gomez et Nick Frosst

Bien que Google soit en mode défensif, ce n'est pas obligatoire. La société a créé elle-même une grande partie de la technologie sous-jacente, alimentant des produits comme ChatGPT. Il rend également ses recherches disponibles en open source, ce qui ironise quelque peu sur l'ascension fulgurante d'OpenAI.

Google a longtemps hésité à lancer des chatbots similaires à ChatGPT, craignant que cette technologie ne nuise à la réputation de son entreprise.

Daniel De Freitas et Noam Shazeer, les deux chercheurs à l'origine du modèle linguistique à grande échelle de Google LaMDA, ont quitté l'entreprise, frustrés par le retard de l'entreprise à lancer un chatbot similaire à ChatGPT.

D'autres anciens chercheurs de Google pensent également que dans une ère aussi passionnante de l'intelligence artificielle, les startups permettront aux chercheurs de s'approprier leurs résultats et d'exercer eux-mêmes plus de valeur et d'impact.

Voici quelques-uns des articles les plus médiatisés dans le domaine de l'intelligence artificielle rédigés par des chercheurs qui ont quitté Google pour d'autres entreprises.

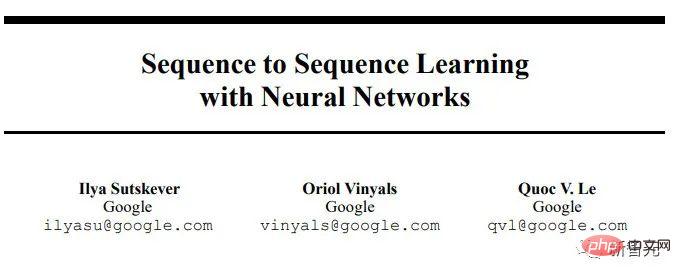

Ilya Sutskever

"Apprentissage séquence à séquence avec les réseaux de neurones" a été publié en 2014. Cet article séquence à séquence explore des modèles de langage d'entraînement pour convertir des séquences de mots dans un domaine en séquences dans un autre domaine. Par exemple, convertissez une phrase anglaise en une phrase française.

Ilya Sutskever a dirigé les recherches sur cet article. Il a quitté Google en 2015 après près de trois ans en tant que chercheur scientifique. Sutskever est co-fondateur d'OpenAI et continue d'y travailler en tant que scientifique en chef.

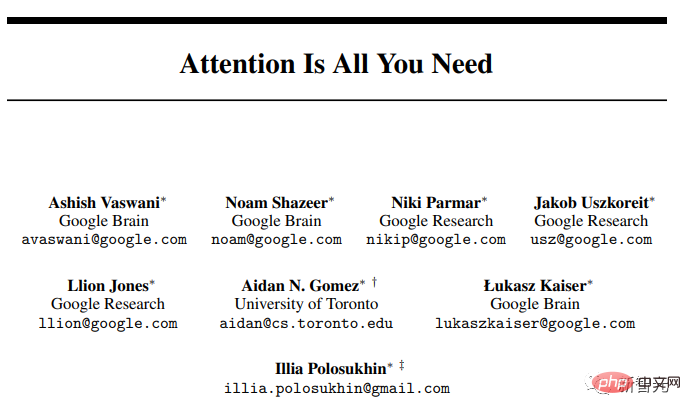

L'attention est tout ce dont vous avez besoin

L'article à succès de Transformer a maintenant été cité plus de 70 000 fois. Transformer est considéré comme une avancée majeure dans le traitement du langage naturel. Il aide l'IA à comprendre le sens en glanant des nuances contextuelles en examinant simultanément chaque mot d'une phrase et en pesant l'importance de chaque mot.

Le « T » dans ChatGPT signifie Transformer, ce qui montre l'importance de cet article.

Cependant, les huit auteurs de cet article, à l'exception de Llion Jones, ont tous quitté Google.

Ashish Vaswani a quitté Google Brain (l'équipe de recherche sur l'IA en apprentissage profond de Google) après cinq ans pour créer Adept, une entreprise qui a récemment levé 350 millions de dollars pour créer des outils d'IA génératifs qui aident les gens à devenir plus intelligents. Utilisez efficacement les logiciels de productivité. Il a récemment quitté Adept pour une startup furtive.

Noam Shazeer est désormais le PDG de Character.AI.

Niki Parmar a quitté Google Brain après cinq ans pour devenir co-fondatrice et CTO d'Adept, mais comme Vaswani, elle est également récemment partie pour une startup secrète.

Jakob Uszkoreit travaille chez Google depuis 13 ans, travaillant sur les réseaux de neurones et l'apprentissage profond. Il est aujourd'hui co-fondateur d'Inceptive, une startup utilisant le deep learning pour concevoir de nouveaux traitements.

Aidan Gomez est le co-fondateur et PDG de Cohere, une entreprise qui a levé environ 160 millions de dollars pour aider les développeurs à intégrer l'intelligence artificielle générative dans leurs applications et sites Web. Il a passé un an et demi en tant que chercheur chez Google Brain. Et son co-fondateur chez Cohere, Nick Frosst, a passé quatre ans en tant que chercheur chez Google Brain.

Lukasz Kaiser a quitté Google Brain après avoir travaillé chez Google Brain pendant plus de 7 ans et a rejoint OpenAI en 2021. Kaiser a récemment été cité dans le livre blanc GPT-4 d'OpenAI comme l'un des principaux contributeurs à ses capacités de contexte long, permettant aux chatbots d'avoir des conversations plus longues avant d'oublier le contexte de la discussion.

Illia Polosukhin travaille depuis trois ans sur l'apprentissage profond et la compréhension du langage naturel chez Google Brain. Il part en 2017 et fonde Pagoda, une plateforme de startup Web3.

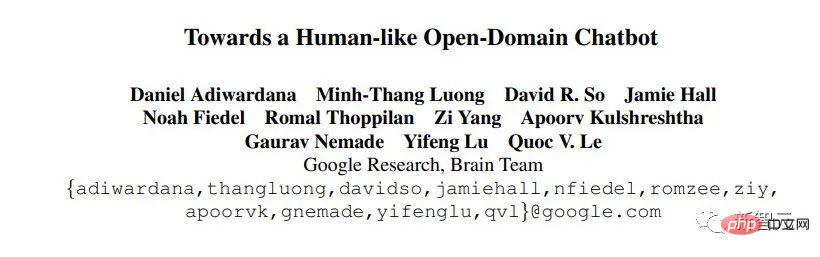

Créer un chatbot de domaine ouvert de type humain

Cet article présente le chatbot original de Google, Meena, et explore comment les chatbots peuvent apprendre à parler de sujets en étudiant les données extraites des conversations publiques sur les réseaux sociaux. Il décrit également un test créé par Google pour évaluer les performances orales des chatbots.

Cet article constitue une autre étape importante dans la modélisation d'un grand langage. Les auteurs pensent qu'ils peuvent créer un grand modèle de langage capable de produire des réponses de type humain aux problèmes sans formation codée en dur.

L'un des auteurs, Daniel De Freitas, a été co-fondateur et président de Character.AI après avoir travaillé comme chercheur chez Google Brain pendant cinq ans.

Le collègue de De Freitas chez Character.AI, Romal Thoppilan, a également contribué à cet article.

À gauche se trouve Romal Thoppilan ; à droite se trouve Daniel De Freitas

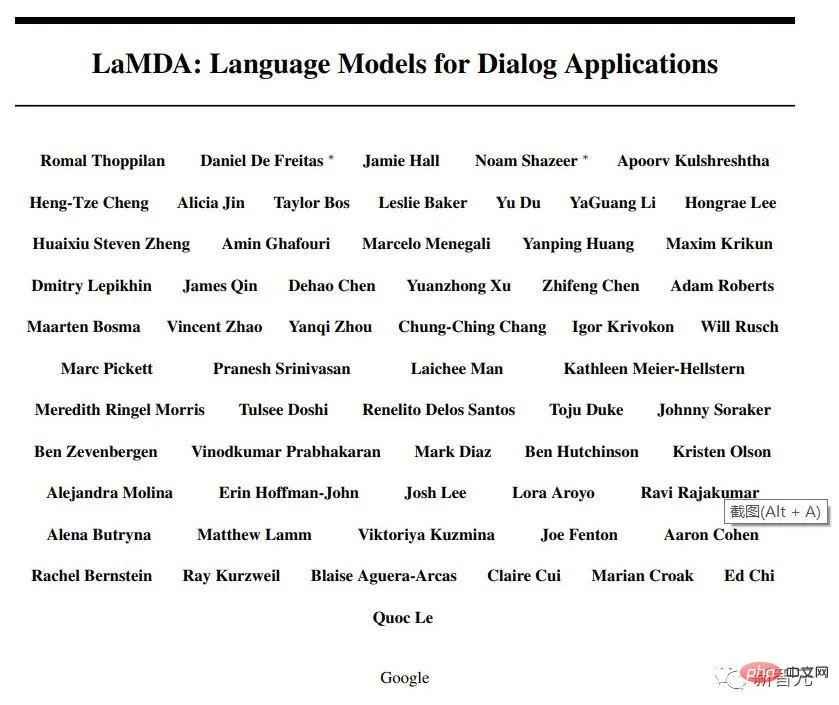

LaMDA : Modèle de langage pour les applications conversationnelles

LaMDA est l'abréviation de modèle de langage pour les applications conversationnelles et est la base du chatbot Bard . Il a été présenté pour la première fois en 2020 sous le nom de Meena, mais Google n'a jamais rendu Meena au public. D'anciens employés du groupe de recherche sur l'intelligence artificielle de Google ont expliqué que cela serait un cauchemar en termes de relations publiques, car Google craignait que les robots ne fassent des commentaires nuisibles.

Plusieurs chercheurs clés derrière LaMDA ont quitté Google Brain.

Character.AI, une société fondée l'année dernière par Daniel De Freitas et Noam Shazeer, a récemment levé environ 200 millions de dollars pour créer des chatbots qui parlent sous une variété de personnages, allant de Musk au thérapeute en passant par le coach de vie.

Romal Thoppilan est le chercheur fondateur de Character.AI après avoir travaillé chez Google Brain pendant 7 ans.

Alicia Jin rejoindra Character.AI vers la fin de 2022 en tant qu'ingénieur de recherche. Elle a travaillé chez Google Brain pendant trois ans.

BERT

BERT (Bidirectionnel Encoder Representations from Transformers) est construit sur le modèle Transformer de traitement du langage naturel. Après une pré-formation, il peut bien accomplir deux tâches : la modélisation du langage masqué et la prédiction de la phrase suivante. En d’autres termes, BERT tente de prédire les mots cachés ou « masqués », obligeant l’algorithme à travailler dur pour en savoir plus sur le texte environnant et mieux prédire les mots cachés.

Si vous tapez « pouvez-vous acheter des médicaments pour la pharmacie de quelqu'un d'autre ? », il comprendra que « d'autres personnes » est une partie importante de la requête.

Google a commencé à intégrer BERT dans son moteur de recherche dès 2019. Il s’agit de l’une des plus grandes améliorations en matière de précision de recherche depuis l’incorporation d’un autre algorithme d’apprentissage automatique, RankBrain, en 2015.

Jacob Devlin est l'auteur principal de cet article et il a rejoint OpenAI peu de temps avant le lancement de ChatGPT.

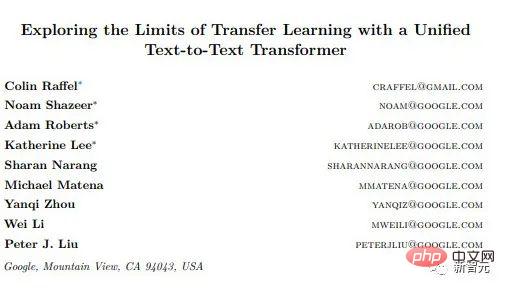

T5

Le nom officiel de l'article T5 est "Explorer les limites de l'apprentissage par transfert avec un transformateur de texte en texte unifié". Il est construit sur la base de BERT et est très adapté aux tâches. comme la traduction et le résumé.

Colin Raffel, qui a dirigé le journal, a travaillé comme chercheur scientifique chez Google Brain pendant environ cinq ans avant de le quitter en 2021. Actuellement professeur adjoint à l'UNC-Chapel Hill, il passe une journée par semaine en tant que chercheur à Hugging Face. Hugging Face a récemment annoncé avoir levé 100 millions de dollars en mai 2022, valorisant l'entreprise à 2 milliards de dollars. Les utilisateurs peuvent partager de grands modèles linguistiques et des ensembles de données sur Hugging Face.

Sharan Narang, une autre collaboratrice du journal T5, a quitté Google Brain en 2022 après y avoir travaillé pendant quatre ans. Il est maintenant chercheur en intelligence artificielle chez Meta Corporation.

Une méthode de placement de motifs pour une conception rapide de puces

Un article dirigé par les scientifiques de Google Azalia Mirhoseini et Anna Goldie a révélé que l'intelligence artificielle peut terminer le processus de conception de puces plus rapidement que les experts humains.

Un autre article dirigé par le duo, "Chip Layout with Deep Reinforcement Learning", propose un moyen d'utiliser l'intelligence artificielle dans la conception des puces pour maximiser les performances tout en minimisant la surface et la consommation d'énergie.

Ces résultats ont aidé Google à concevoir des puces TPU spécifiquement pour les tâches d'apprentissage automatique.

Mirhoseini et Goldie ont tous deux quitté Google en 2022 pour rejoindre Anthropic, un concurrent d'OpenAI qui développe son propre modèle de langage à grande échelle et un chatbot appelé Claude.

DeepMind

Mustafa Suleyman est le co-fondateur de DeepMind et est directeur des produits de l'entreprise. Il s'agit d'un laboratoire d'intelligence artificielle racheté par Google en 2014. Le laboratoire a développé AlphaGo, le programme d'apprentissage automatique qui a battu les champions du monde professionnels au jeu de Go.

Alphabet, la société mère de Google, a récemment annoncé dans son rapport financier du quatrième trimestre que les résultats financiers de DeepMind seraient indépendants des « autres investissements », soulignant l’importance de l’intelligence artificielle dans la stratégie future de Google. En règle générale, « autres investissements » est un terme général désignant les projets naissants de l’entreprise qui n’ont pas encore atteint la rentabilité.

Suleyman est un ardent défenseur de la garantie de la sécurité des nouveaux produits d'intelligence artificielle. Alors qu'il travaillait chez DeepMind, il a créé un département de recherche appelé DeepMind Ethics and Society pour étudier les impacts réels de l'intelligence artificielle. En 2019, il a été mis en congé par DeepMind après avoir été accusé d'intimidation auprès d'employés. Il est revenu chez Google en tant que vice-président pendant que l'enquête était en cours.

Suleyman a été cité dans de nombreux articles de recherche liés à l'apprentissage automatique. En février 2022, il a cofondé la startup d'intelligence artificielle Inflection avec le créateur de LinkedIn Reid Hoffman.

De nombreux contributeurs clés aux articles les plus révolutionnaires de Google sur l’intelligence artificielle sont partis, rejoignant des concurrents tels qu’OpenAI ou créant leur propre entreprise.

Lorsque ChatGPT d'OpenAI est sorti fin 2022, le PDG de Google, Sundar Pichai, a annoncé une « alerte rouge » en interne, sommant l'entreprise de réagir.

À l'époque, Pichai avait déclaré que Google continuerait sans aucun doute à embaucher les meilleurs chercheurs en intelligence artificielle.

Mais après avoir perdu tant de personnes compétentes, Google peut-il encore atteindre la grandeur ?

Références :

https://www.businessinsider.com/google-ai-teams-brain-drain-researchers-leave-2023-3

https://www.zhihu.com/question/592975340/ réponse /2963265672

https://zhuanlan.zhihu.com/p/597586623

https://www.zhihu.com/question/592975340/answer/2964598555

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment commenter Deepseek

Feb 19, 2025 pm 05:42 PM

Comment commenter Deepseek

Feb 19, 2025 pm 05:42 PM

Deepseek est un puissant outil de récupération d'informations. .

Comment rechercher Deepseek

Feb 19, 2025 pm 05:39 PM

Comment rechercher Deepseek

Feb 19, 2025 pm 05:39 PM

Deepseek est un moteur de recherche propriétaire qui ne recherche que dans une base de données ou un système spécifique, plus rapide et plus précis. Lorsque vous l'utilisez, il est conseillé aux utilisateurs de lire le document, d'essayer différentes stratégies de recherche, de demander de l'aide et des commentaires sur l'expérience utilisateur afin de tirer le meilleur parti de leurs avantages.

Sesame Open Door Exchange Page d'enregistrement de page Enregistrement Gate Trading App The Registration Site Web

Feb 28, 2025 am 11:06 AM

Sesame Open Door Exchange Page d'enregistrement de page Enregistrement Gate Trading App The Registration Site Web

Feb 28, 2025 am 11:06 AM

Cet article présente le processus d'enregistrement de la version Web de Sesame Open Exchange (GATE.IO) et l'application Gate Trading en détail. Qu'il s'agisse de l'enregistrement Web ou de l'enregistrement de l'application, vous devez visiter le site Web officiel ou l'App Store pour télécharger l'application authentique, puis remplir le nom d'utilisateur, le mot de passe, l'e-mail, le numéro de téléphone mobile et d'autres informations et terminer la vérification des e-mails ou du téléphone mobile.

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé?

Feb 21, 2025 pm 10:57 PM

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé?

Feb 21, 2025 pm 10:57 PM

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé? Bybit est un échange de crypto-monnaie qui fournit des services de trading aux utilisateurs. Les applications mobiles de l'échange ne peuvent pas être téléchargées directement via AppStore ou GooglePlay pour les raisons suivantes: 1. La politique de l'App Store empêche Apple et Google d'avoir des exigences strictes sur les types d'applications autorisées dans l'App Store. Les demandes d'échange de crypto-monnaie ne répondent souvent pas à ces exigences car elles impliquent des services financiers et nécessitent des réglementations et des normes de sécurité spécifiques. 2. Conformité des lois et réglementations Dans de nombreux pays, les activités liées aux transactions de crypto-monnaie sont réglementées ou restreintes. Pour se conformer à ces réglementations, l'application ByBit ne peut être utilisée que via des sites Web officiels ou d'autres canaux autorisés

Sesame Open Door Trading Platform Download Version mobile Gateio Trading Plateforme de téléchargement Adresse de téléchargement

Feb 28, 2025 am 10:51 AM

Sesame Open Door Trading Platform Download Version mobile Gateio Trading Plateforme de téléchargement Adresse de téléchargement

Feb 28, 2025 am 10:51 AM

Il est crucial de choisir un canal formel pour télécharger l'application et d'assurer la sécurité de votre compte.

portail d'enregistrement officiel de Gate.io Exchange

Feb 20, 2025 pm 04:27 PM

portail d'enregistrement officiel de Gate.io Exchange

Feb 20, 2025 pm 04:27 PM

Gate.io est un échange de crypto-monnaie de premier plan qui offre une large gamme d'actifs cryptographiques et de paires de trading. Enregistrer Gate.io est très simple. Complétez l'inscription. Avec Gate.io, les utilisateurs peuvent profiter d'une expérience de trading de crypto-monnaie sûre et pratique.

Top 10 recommandé pour l'application de trading d'actifs numériques crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Top 10 recommandé pour l'application de trading d'actifs numériques crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Cet article recommande les dix principales plates-formes de trading de crypto-monnaie qui méritent d'être prêtées, notamment Binance, Okx, Gate.io, Bitflyer, Kucoin, Bybit, Coinbase Pro, Kraken, Bydfi et Xbit décentralisées. Ces plateformes ont leurs propres avantages en termes de quantité de devises de transaction, de type de transaction, de sécurité, de conformité et de fonctionnalités spéciales. Le choix d'une plate-forme appropriée nécessite une considération complète en fonction de votre propre expérience de trading, de votre tolérance au risque et de vos préférences d'investissement. J'espère que cet article vous aide à trouver le meilleur costume pour vous-même

Binance Binance Site officiel Dernière version Portail de connexion

Feb 21, 2025 pm 05:42 PM

Binance Binance Site officiel Dernière version Portail de connexion

Feb 21, 2025 pm 05:42 PM

Pour accéder à la dernière version du portail de connexion du site Web de Binance, suivez simplement ces étapes simples. Accédez au site officiel et cliquez sur le bouton "Connectez-vous" dans le coin supérieur droit. Sélectionnez votre méthode de connexion existante. Entrez votre numéro de mobile ou votre mot de passe enregistré et votre mot de passe et complétez l'authentification (telles que le code de vérification mobile ou Google Authenticator). Après une vérification réussie, vous pouvez accéder à la dernière version du portail de connexion du site Web officiel de Binance.