Périphériques technologiques

Périphériques technologiques

IA

IA

Quel bruit ! ChatGPT comprend-il la langue ? PNAS : étudions d'abord ce qu'est la « compréhension »

Quel bruit ! ChatGPT comprend-il la langue ? PNAS : étudions d'abord ce qu'est la « compréhension »

Quel bruit ! ChatGPT comprend-il la langue ? PNAS : étudions d'abord ce qu'est la « compréhension »

La question de savoir si une machine peut réfléchir à cette question revient à se demander si un sous-marin sait nager. ——Dijkstra

Bien avant la sortie de ChatGPT, l'industrie avait déjà flairé les changements apportés par les grands modèles.

Le 14 octobre de l'année dernière, les professeurs Melanie Mitchell et David C. Krakauer de l'Institut de Santa Fe ont publié une revue sur arXiv, enquêtant de manière approfondie sur toutes les questions sur "si les modèles linguistiques pré-entraînés à grande échelle" peuvent comprendre le langage " , cet article décrit les arguments « pour » et « contre » ainsi que les questions clés de la science plus large du renseignement qui découlent de ces arguments.

Lien papier : https://arxiv.org/pdf/2210.13966.pdf

Revue publiée : "Proceedings of the National Academy of Sciences" (PNAS)

Version trop longue à lire :

Le principal argument en faveur de la « compréhension » est que les grands modèles de langage peuvent accomplir de nombreuses tâches qui semblent nécessiter une compréhension.

Le principal argument contre la « compréhension » est que d'un point de vue humain, la compréhension des grands modèles de langage est très fragile, par exemple l'incapacité de comprendre les changements subtils entre les invites et les modèles de langage n'ont pas d'expérience de la vie réelle à vérifier ; leurs modèles de langage multimodal et de connaissances peuvent atténuer ce problème.

Le problème le plus critique est que personne n'a encore de définition fiable de « ce qu'est la compréhension », et ils ne savent pas comment tester la capacité de compréhension des modèles de langage. Les tests destinés aux humains ne sont pas nécessairement adaptés aux tests. grandes langues. Capacité de compréhension du modèle.

En résumé, les grands modèles linguistiques peuvent comprendre le langage, mais peut-être d'une manière différente de celle des humains.

Les chercheurs pensent qu'une nouvelle science de l'intelligence peut être développée pour étudier en profondeur différents types de compréhension, découvrir les avantages et les limites des différents modes de compréhension, et en même temps intégrer les différences cognitives découlant des différentes formes de compréhension.

La première auteure de l'article, Melanie Mitchell, est professeur à l'Institut de Santa Fe. Elle a obtenu un doctorat à l'Université du Michigan en 1990 et son mentor était Hofstadter. Gödel, Escher, Bach : Collected Works") Ses principaux intérêts de recherche sont le raisonnement analogique, les systèmes complexes, les algorithmes génétiques et les automates cellulaires.

Qu’est-ce que « comprendre » exactement ?

« Qu'est-ce que la compréhension ? » a toujours intrigué les philosophes, les spécialistes des sciences cognitives et les éducateurs. Les chercheurs utilisent souvent les humains ou d'autres animaux comme référence pour la « capacité de compréhension ».

Jusqu'à récemment, avec l'essor des systèmes d'intelligence artificielle à grande échelle, en particulier des grands modèles de langage (LLM), un débat féroce a été déclenché au sein de la communauté de l'intelligence artificielle quant à savoir si les machines peuvent désormais être considérées comme capables comprendre le langage de la nature comprendre les situations physiques et sociales que le langage décrit.

Il ne s'agit pas d'un débat purement académique. Le degré et la manière dont les machines comprennent le monde ont un impact significatif sur la mesure dans laquelle les humains peuvent faire confiance à l'IA pour effectuer des tâches telles que conduire des voitures, diagnostiquer des maladies, prendre soin des personnes âgées et prendre soin des personnes âgées. éduquer les enfants aux tâches liées à l’humain. Prendre des mesures fortes et transparentes.

Le débat actuel montre qu'il existe certaines différences dans la façon dont la communauté universitaire envisage la compréhension des systèmes intelligents, en particulier dans les modèles mentaux qui s'appuient sur une « corrélation statistique » et des « mécanismes causals évidents ».

Cependant, il existe toujours un consensus général sur la compréhension des machines dans la communauté de recherche en IA, c'est-à-dire que bien que les systèmes d'IA présentent un comportement apparemment intelligent dans de nombreuses tâches spécifiques, ils ne comprennent pas à quoi ils ont affaire dans le même la façon dont les humains traitent les données.

Par exemple, les logiciels de reconnaissance faciale ne comprennent pas que le visage fait partie du corps, ni le rôle des expressions faciales dans l'interaction sociale, ni comment les humains utilisent le concept de visage de manière presque infinie. un certain nombre de façons.

De même, les programmes de synthèse vocale et de traduction automatique ne comprennent pas la langue qu’ils traitent, et les systèmes de conduite autonome ne comprennent pas le contact visuel subtil ou le langage corporel que les conducteurs et les piétons utilisent pour éviter les accidents.

En fait, la fragilité souvent citée de ces systèmes d’intelligence artificielle, à savoir les erreurs imprévisibles et le manque de généralisation robuste, est un indicateur clé de la compréhension de l’IA.

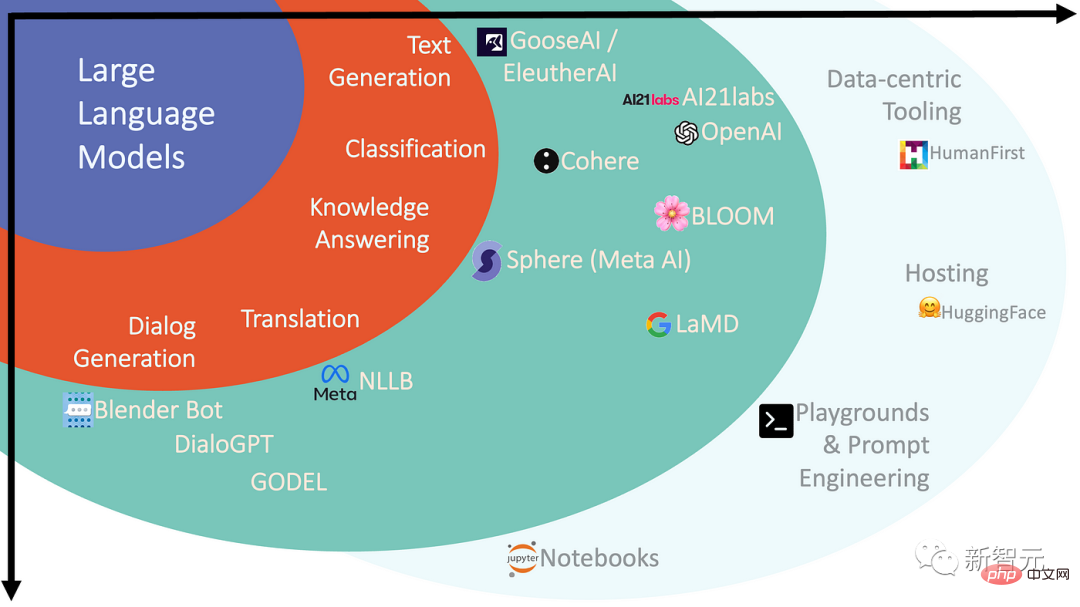

Au cours des dernières années, l'audience et l'influence des grands modèles de langage (LLM) dans le domaine de l'intelligence artificielle ont augmenté, et cela a également changé le point de vue de certaines personnes sur les perspectives de compréhension automatique du langage.

Les modèles de pré-entraînement à grande échelle, également appelés modèles de base, sont des réseaux de neurones profonds avec des milliards, voire des milliards de paramètres (poids), qui sont exécutés sur des corpus massifs de langage naturel (y compris des textes en ligne, des livres en ligne, etc.) obtenus après " pré-formation".

La tâche du modèle pendant la formation est de prédire les parties manquantes de la phrase d'entrée, cette méthode est donc également appelée « apprentissage auto-supervisé ». Le réseau résultant est un modèle statistique complexe qui peut obtenir les mots dans le contenu. données de formation et comment les phrases sont liées les unes aux autres.

Ce modèle peut être utilisé pour générer du langage naturel et être affiné pour des tâches spécifiques en langage naturel, ou encore formé pour mieux correspondre à « l'intention de l'utilisateur », mais pour les non-professionnels et les scientifiques, qu'est-ce qu'exactement un modèle de langage ? La manière dont ces tâches sont accomplies reste un mystère.

Le fonctionnement interne des réseaux de neurones est largement opaque, et même les chercheurs qui construisent ces réseaux ont une intuition limitée pour les systèmes de cette envergure.

Le neuroscientifique Terrence Sejnowski décrit ainsi la capacité d'émergence des LLM :

Après avoir franchi un certain seuil, c'est comme si des extraterrestres apparaissaient soudainement et pouvaient être utilisés d'une manière humaine et terrifiante. de communiquer avec nous. Une seule chose est claire pour le moment : les grands modèles de langage ne sont pas humains, certains aspects de leur comportement semblent intelligents, mais si ce n’est pas l’intelligence humaine, quelle est la nature de leur intelligence ?

Pour la compréhension contre la compréhension

Malgré les performances impressionnantes des grands modèles de langage, les LLM de pointe sont toujours sensibles à la fragilité et aux erreurs non humaines.

Cependant, on peut observer que les performances du réseau se sont considérablement améliorées avec l'expansion de son nombre de paramètres et de la taille du corpus de formation, ce qui a également conduit certains chercheurs dans ce domaine à affirmer que tant qu'il y a un nombre suffisamment grand ensemble de données de réseau et de formation, modèle linguistique (version multimodale) Peut-être une version multimodale - qui mènera à l'intelligence et à la compréhension au niveau humain.

Un nouveau slogan d'intelligence artificielle a émergé : L'échelle est tout ce dont vous avez besoin !

Cette déclaration reflète également le débat sur les modèles de langage à grande échelle dans la communauté des chercheurs en intelligence artificielle :

Une école de pensée croit que les modèles de langage peuvent véritablement comprendre le langage et raisonner de manière générale (bien qu'il ait pas encore atteint le niveau des humains).

Par exemple, le système LaMDA de Google est pré-entraîné sur le texte puis affiné sur les tâches conversationnelles, capable de tenir des conversations avec des utilisateurs dans un très large éventail de domaines.

L'autre école estime que les grands modèles pré-entraînés comme GPT-3 ou LaMDA, quelle que soit la fluidité de leur langage, ne peuvent pas posséder de compréhension car ces modèles n'ont aucune expérience pratique et aucun modèle mental. du monde.

Les modèles linguistiques sont uniquement formés pour prédire les mots dans un grand nombre de collections de textes, leur permettant d'apprendre la forme du langage, mais loin d'apprendre le sens qui se cache derrière le langage.

Un système entraîné uniquement sur le langage ne se rapprochera jamais de l'intelligence humaine, même s'il est désormais entraîné jusqu'à la mort de l'univers. Il est clair que ces systèmes ne sont destinés qu’à des niveaux de compréhension superficiels et ne se rapprocheront jamais de la pensée globale du corps que nous voyons chez les humains.

Un autre chercheur estime que lorsqu'on parle de ces systèmes, la compréhension de l'intelligence, des agents et par extension est erronée et que les modèles de langage sont en fait des référentiels compressés de connaissances humaines, s'apparentant davantage à une bibliothèque ou à une encyclopédie, plutôt qu'à un agent.

Par exemple, les humains savent ce que « démangeaison » signifie quand cela nous fait rire, car nous avons des corps ; un modèle de langage peut utiliser le mot « démangeaison », mais il n'a évidemment pas ressenti ce sentiment. pour convertir un mot dans Maps en un sentiment plutôt qu'en un autre mot.

Ceux du côté des « LLM ne comprennent pas » soutiennent que si la maîtrise des grands modèles de langage est surprenante, notre surprise reflète notre manque d'intuition sur ce que les corrélations statistiques peuvent générer à l'échelle de ces modèles.

Une enquête menée en 2022 auprès de chercheurs actifs dans la communauté du traitement du langage naturel montre des divisions claires dans ce débat.

Quand il a été demandé à 480 personnes interrogées si elles étaient d'accord avec l'affirmation selon laquelle les LLM peuvent comprendre le langage en principe, selon laquelle "les modèles de langage génératifs formés uniquement sur le texte peuvent être utilisés pour comprendre le langage naturel dans un sens"

Les résultats de l'enquête étaient également divisés, la moitié (51 %) étant d’accord et l’autre moitié (49 %) en désaccord.

La compréhension des machines est différente de celle des humains

Bien que les deux côtés du débat sur la « capacité de compréhension LLM » aient suffisamment d'intuition pour soutenir leurs points de vue respectifs, les méthodes basées sur les sciences cognitives actuellement disponibles pour acquérir une compréhension plus profonde de la compréhension ne sont pas suffisantes pour répondre à la question. question. Des questions comme celle-ci à propos du LLM.

En fait, certains chercheurs ont appliqué des tests psychologiques (conçus à l'origine pour évaluer les mécanismes de compréhension et de raisonnement humains) aux LLM et ont découvert que dans certains cas, les LLM montrent des réponses de type humain aux tests de théorie de l'esprit et présentent des réactions humaines. comme les capacités et les préjugés dans les évaluations du raisonnement.

Bien que ces tests soient considérés comme des agents fiables pour évaluer les capacités humaines de généralisation, ce n'est peut-être pas le cas pour les systèmes d'intelligence artificielle.

Les grands modèles de langage ont une capacité particulière à apprendre les corrélations entre leurs données d'entraînement et les jetons en entrée, et peuvent utiliser cette corrélation pour résoudre des problèmes. Les humains utilisent plutôt une compression qui reflète leur concept d'expérience du monde réel.

Lors de l'application de tests conçus pour les humains aux LLM, l'interprétation des résultats peut s'appuyer sur des hypothèses sur la cognition humaine qui peuvent tout simplement ne pas être vraies pour ces modèles.

Pour progresser, les scientifiques devront développer de nouveaux critères et méthodes de détection pour comprendre les mécanismes des différents types d'intelligence et de compréhension, y compris les nouvelles formes d'« entités bizarres et semblables à l'esprit » que nous avons créées, actuellement. il y a également eu des travaux connexes.

À mesure que les modèles deviennent plus grands et que des systèmes plus performants sont développés, le débat sur la compréhension dans les LLM souligne la nécessité « d’élargir notre science de l’intelligence » afin que la « compréhension » soit possible et significative, tant pour les humains que pour les machines.

Le neuroscientifique Terrence Sejnowski souligne que les opinions divergentes des experts sur l'intelligence des LLM montrent que nos vieilles idées basées sur l'intelligence naturelle ne suffisent pas.

Si les LLM et les modèles associés peuvent réussir en exploitant les corrélations statistiques à une échelle sans précédent, ils peuvent peut-être être considérés comme une « nouvelle forme de compréhension », capable d'atteindre des capacités prédictives extraordinaires et surhumaines, comme AlphaZero et AlphaFold de DeepMind. systèmes, qui apportent une forme « exotique » d’intuition respectivement aux domaines du jeu d’échecs et de la prédiction de la structure des protéines.

On peut donc dire qu'au cours des dernières années, le domaine de l'intelligence artificielle a créé des machines dotées de nouveaux modes de compréhension, très probablement un concept entièrement nouveau, et ces nouveaux concepts seront développés à mesure que nous progressons dans la poursuite de la nature insaisissable de l’intelligence continuera à s’enrichir.

Les problèmes qui nécessitent une grande quantité de connaissances codées et ont des exigences de performance élevées continueront de promouvoir le développement de modèles statistiques à grande échelle, tandis que ceux ayant des connaissances limitées et des mécanismes causals solides seront bénéfiques à la compréhension de l'intelligence humaine.

Le défi pour l'avenir est de développer de nouvelles méthodes scientifiques pour révéler la compréhension détaillée des différentes formes d'intelligence, discerner leurs forces et leurs limites, et apprendre à intégrer ces modes cognitifs véritablement différents.

Référence :

https://www.pnas.org/doi/10.1073/pnas.2215907120

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

3 façons de changer de langue sur iPhone

Feb 02, 2024 pm 04:12 PM

3 façons de changer de langue sur iPhone

Feb 02, 2024 pm 04:12 PM

Ce n'est un secret pour personne que l'iPhone est l'un des gadgets électroniques les plus conviviaux, et l'une des raisons pour cela est qu'il peut être facilement personnalisé à votre guise. Dans Personnalisation, vous pouvez changer la langue en une langue différente de celle que vous avez sélectionnée lors de la configuration de votre iPhone. Si vous maîtrisez plusieurs langues ou si le paramètre de langue de votre iPhone est incorrect, vous pouvez le modifier comme nous l'expliquons ci-dessous. Comment changer la langue de l'iPhone [3 méthodes] iOS permet aux utilisateurs de changer librement la langue préférée sur l'iPhone pour s'adapter aux différents besoins. Vous pouvez changer la langue d'interaction avec Siri pour faciliter la communication avec l'assistant vocal. Dans le même temps, lorsque vous utilisez le clavier local, vous pouvez facilement basculer entre plusieurs langues pour améliorer l'efficacité de la saisie.

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Étapes d'installation : 1. Téléchargez le logiciel ChatGTP depuis le site officiel ou la boutique mobile de ChatGTP ; 2. Après l'avoir ouvert, dans l'interface des paramètres, sélectionnez la langue chinoise 3. Dans l'interface de jeu, sélectionnez le jeu homme-machine et définissez la langue. Spectre chinois ; 4. Après avoir démarré, entrez les commandes dans la fenêtre de discussion pour interagir avec le logiciel.

Comment définir la langue de l'ordinateur Win10 sur le chinois ?

Jan 05, 2024 pm 06:51 PM

Comment définir la langue de l'ordinateur Win10 sur le chinois ?

Jan 05, 2024 pm 06:51 PM

Parfois, nous installons simplement le système informatique et constatons que le système est en anglais. Dans ce cas, nous devons changer la langue de l'ordinateur en chinois. Alors, comment changer la langue de l'ordinateur en chinois dans le système Win10 ? . Comment changer la langue de l'ordinateur dans Win10 en chinois 1. Allumez l'ordinateur et cliquez sur le bouton Démarrer dans le coin inférieur gauche. 2. Cliquez sur l'option de paramètres à gauche. 3. Sélectionnez « Heure et langue » sur la page qui s'ouvre. 4. Après l'ouverture, cliquez sur « Langue » sur la gauche. 5. Ici, vous pouvez définir la langue de l'ordinateur souhaitée.

Comment développer un chatbot intelligent en utilisant ChatGPT et Java

Oct 28, 2023 am 08:54 AM

Comment développer un chatbot intelligent en utilisant ChatGPT et Java

Oct 28, 2023 am 08:54 AM

Dans cet article, nous présenterons comment développer des chatbots intelligents à l'aide de ChatGPT et Java, et fournirons quelques exemples de code spécifiques. ChatGPT est la dernière version du Generative Pre-training Transformer développé par OpenAI, une technologie d'intelligence artificielle basée sur un réseau neuronal qui peut comprendre le langage naturel et générer du texte de type humain. En utilisant ChatGPT, nous pouvons facilement créer des discussions adaptatives

Chatgpt peut-il être utilisé en Chine ?

Mar 05, 2024 pm 03:05 PM

Chatgpt peut-il être utilisé en Chine ?

Mar 05, 2024 pm 03:05 PM

chatgpt peut être utilisé en Chine, mais ne peut pas être enregistré, ni à Hong Kong et Macao. Si les utilisateurs souhaitent s'inscrire, ils peuvent utiliser un numéro de téléphone mobile étranger pour s'inscrire. Notez que lors du processus d'enregistrement, l'environnement réseau doit être basculé vers. une adresse IP étrangère.

Comment créer un robot de service client intelligent en utilisant ChatGPT PHP

Oct 28, 2023 am 09:34 AM

Comment créer un robot de service client intelligent en utilisant ChatGPT PHP

Oct 28, 2023 am 09:34 AM

Comment utiliser ChatGPTPHP pour créer un robot de service client intelligent Introduction : Avec le développement de la technologie de l'intelligence artificielle, les robots sont de plus en plus utilisés dans le domaine du service client. L'utilisation de ChatGPTPHP pour créer un robot de service client intelligent peut aider les entreprises à fournir des services client plus efficaces et personnalisés. Cet article explique comment utiliser ChatGPTPHP pour créer un robot de service client intelligent et fournit des exemples de code spécifiques. 1. Installez ChatGPTPHP et utilisez ChatGPTPHP pour créer un robot de service client intelligent.

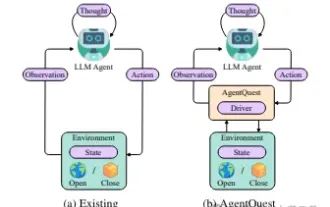

Explorer les limites des agents : AgentQuest, un cadre de référence modulaire pour mesurer et améliorer de manière globale les performances des grands agents de modèles de langage

Apr 11, 2024 pm 08:52 PM

Explorer les limites des agents : AgentQuest, un cadre de référence modulaire pour mesurer et améliorer de manière globale les performances des grands agents de modèles de langage

Apr 11, 2024 pm 08:52 PM

Basées sur l'optimisation continue de grands modèles, les agents LLM, ces puissantes entités algorithmiques ont montré leur potentiel pour résoudre des tâches de raisonnement complexes en plusieurs étapes. Du traitement du langage naturel à l'apprentissage profond, les agents LLM deviennent progressivement le centre d'intérêt de la recherche et de l'industrie. Ils peuvent non seulement comprendre et générer le langage humain, mais également formuler des stratégies, effectuer des tâches dans divers environnements et même utiliser des appels d'API et du codage pour créer. solutions. Dans ce contexte, l'introduction du framework AgentQuest constitue une étape importante. Il fournit non seulement une plate-forme d'analyse comparative modulaire pour l'évaluation et l'avancement des agents LLM, mais fournit également aux chercheurs des outils puissants pour suivre et améliorer les performances de ces agents à un moment donné. niveau plus granulaire