Depuis que le test de Turing a été proposé dans les années 1950, les gens explorent la capacité des machines à traiter l'intelligence linguistique. La langue est essentiellement un système complexe d’expression humaine, régi par des règles grammaticales. Par conséquent, le développement d’algorithmes d’IA puissants, capables de comprendre et de maîtriser le langage, présente d’énormes défis. Au cours des deux dernières décennies, les méthodes de modélisation du langage ont été largement utilisées pour la compréhension et la génération du langage, notamment les modèles de langage statistiques et les modèles de langage neuronal.

Ces dernières années, les chercheurs ont produit des modèles de langage pré-entraînés (PLM) en pré-entraînant des modèles Transformer sur des corpus à grande échelle, et ont démontré de puissantes capacités à résoudre diverses tâches de PNL. Et les chercheurs ont découvert que la mise à l’échelle du modèle peut apporter des améliorations de performances. Ils ont donc étudié plus en détail l’effet de la mise à l’échelle en augmentant la taille du modèle. Il est intéressant de noter que lorsque la taille des paramètres dépasse un certain niveau, ce modèle de langage plus large obtient des améliorations significatives des performances et fait émerger des fonctionnalités qui ne sont pas présentes dans le petit modèle, telles que l'apprentissage contextuel. Pour les distinguer des PLM, ces modèles sont appelés grands modèles de langage (LLM).

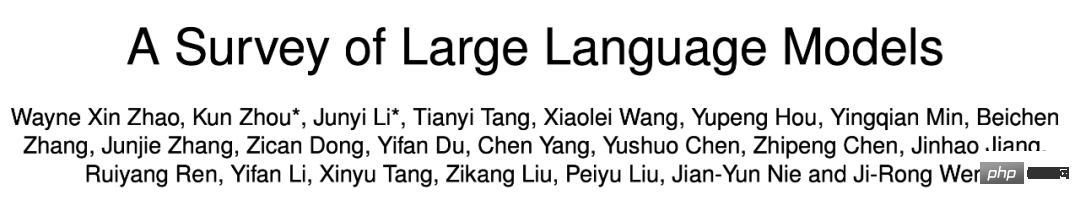

De Google T5 en 2019 à la série OpenAI GPT, de grands modèles avec des tailles de paramètres explosives continuent d'émerger. On peut dire que la recherche sur les LLM a été grandement encouragée tant dans le monde universitaire que dans l'industrie. En particulier, l'émergence du modèle de conversation à grande échelle ChatGPT à la fin du mois de novembre de l'année dernière a attiré l'attention de tous les horizons. Les progrès techniques dans les LLM ont eu un impact important sur l’ensemble de la communauté de l’IA et révolutionneront la façon dont les gens développent et utilisent les algorithmes d’IA.

Considérant les progrès technologiques rapides des LLM, plus de deux douzaines de chercheurs de l'Université Renmin de Chine ont examiné les derniers progrès des LLM sous trois aspects : les connaissances de base, les découvertes clés et les technologies dominantes, avec une attention particulière à la pré-formation et adaptation des LLM Tuning, utilisation et évaluation des capacités. En outre, ils ont résumé et développé les ressources disponibles pour les LLM et discuté des orientations de développement futures et d'autres questions. Cette revue constitue une ressource d’apprentissage extrêmement utile pour les chercheurs et les ingénieurs du domaine.

Lien papier : https://arxiv.org/abs/2303.18223

Avant de saisir le texte, jetons d'abord un coup d'œil aux différents grands modèles de langage (des dizaines de milliards de paramètres) qui ont émergé depuis 2019 Ci-dessus) Chronologie, dans laquelle le grand modèle marqué en jaune a été open source.

Dans la première section, le chercheur a présenté en détail le contexte, les capacités et les technologies clés des LLM.

Contexte sur les LLM

Généralement, les grands modèles de langage (LLM) font référence à des modèles de langage contenant des centaines de milliards (ou plus) de paramètres entraînés sur de grandes quantités de données textuelles, tels que les modèles GPT- 3, PaLM, Galactica et LLaMA. Plus précisément, LLM est construit sur l'architecture Transformer, où les couches d'attention multi-têtes sont empilées dans un réseau neuronal très profond. Les LLM existants utilisent principalement une architecture de modèle (c'est-à-dire Transformer) et des objectifs de pré-formation (c'est-à-dire la modélisation du langage) similaires aux petits modèles de langage. Comme principale différence, LLM met à l'échelle la taille du modèle, les données de pré-formation et le calcul total (facteur de mise à l'échelle) dans une large mesure. Ils peuvent mieux comprendre le langage naturel et générer un texte de haute qualité basé sur un contexte donné (comme une invite). Cette amélioration de capacité peut être décrite en partie par une loi de mise à l'échelle, dans laquelle les performances augmentent à peu près suite à de fortes augmentations de la taille du modèle. Cependant, selon la loi d'échelle, certaines capacités (par exemple l'apprentissage contextuel) sont imprévisibles et ne peuvent être observées que lorsque la taille du modèle dépasse un certain niveau.

La capacité émergente des LLM

La capacité émergente des LLM est formellement définie comme « la capacité qui n'existe pas dans les petits modèles mais apparaît dans les grands modèles », ce qui distingue le LLM du précédent PLM. traits les plus distinctifs. Lorsque cette nouvelle capacité apparaît, elle introduit également une fonctionnalité notable : lorsque l’échelle atteint un certain niveau, les performances sont nettement supérieures au hasard. Par analogie, ce nouveau modèle est étroitement lié au phénomène des transitions de phase en physique. En principe, cette capacité peut également être liée à certaines tâches complexes, tandis que les gens sont davantage préoccupés par les capacités générales qui peuvent être appliquées pour résoudre plusieurs tâches. Voici une brève introduction à trois capacités émergentes représentatives du LLM :

Apprentissage contextuel. GPT-3 introduit formellement des capacités d'apprentissage contextuel : en supposant que le modèle de langage ait été fourni avec des instructions en langage naturel et plusieurs descriptions de tâches, il peut générer le résultat attendu de l'instance de test en complétant la séquence de mots du texte d'entrée sans formation ni gradient supplémentaire. mises à jour.

Instructions à suivre. LLM fonctionne bien sur de petites tâches en affinant un mélange d'ensembles de données multitâches formatés avec des descriptions en langage naturel (c'est-à-dire des instructions), qui sont également décrites sous forme d'instructions. À ce titre, le réglage des instructions permet à LLM d'effectuer de nouvelles tâches en comprenant les instructions des tâches sans utiliser d'échantillons explicites, ce qui peut considérablement améliorer les capacités de généralisation.

Raisonnement étape par étape. Pour les petits modèles de langage, il est souvent difficile de résoudre des tâches complexes impliquant plusieurs étapes de raisonnement, telles que des problèmes de mots dans des matières mathématiques. Dans le même temps, grâce à la stratégie de raisonnement en chaîne de pensée, LLM peut résoudre de telles tâches pour arriver à la réponse finale en utilisant le mécanisme d'invite impliquant des étapes de raisonnement intermédiaires. Vraisemblablement, cette capacité peut être acquise grâce à une formation au codage.

Technologies clés

Examinons ensuite les technologies clés des LLM, notamment la mise à l'échelle, la formation, la stimulation des capacités, l'optimisation de l'alignement, l'utilisation des outils, etc.

Zoom. La mise à l'échelle est un facteur clé pour augmenter la capacité du modèle des LLM. Initialement, GPT-3 a augmenté les paramètres du modèle à 175 milliards, puis PaLM a encore augmenté les paramètres du modèle à 540 milliards. Les paramètres à grande échelle sont essentiels aux capacités émergentes. La mise à l'échelle ne concerne pas seulement la taille du modèle, mais également la taille des données et l'effort de calcul total.

Formation. En raison de la grande échelle, former avec succès un LLM doté de solides capacités est très difficile. Des algorithmes de formation distribués sont donc nécessaires pour apprendre les paramètres réseau des LLM, souvent en utilisant une combinaison de diverses stratégies parallèles. Pour prendre en charge la formation distribuée, des frameworks d'optimisation tels que DeepSpeed et Megatron-LM sont utilisés pour faciliter la mise en œuvre et le déploiement d'algorithmes parallèles. De plus, les techniques d'optimisation sont importantes pour la stabilité de l'entraînement et les performances du modèle, telles que le redémarrage des pics de perte d'entraînement et l'entraînement de précision mixte. Le récent GPT-4 a développé une infrastructure spéciale et des méthodes d'optimisation pour exploiter des modèles beaucoup plus petits afin de prédire les performances de grands modèles.

Stimulation des capacités. Après avoir été pré-formés sur un corpus à grande échelle, les LLM sont dotés de la capacité potentielle à résoudre des tâches générales. Cependant, ces capacités peuvent ne pas être explicitement démontrées lorsque les LLM effectuent une tâche spécifique. Par conséquent, il est très utile de concevoir des instructions de tâches appropriées ou des stratégies contextuelles spécifiques pour stimuler ces capacités. Par exemple, les invites de la chaîne de réflexion peuvent aider à résoudre des tâches de raisonnement complexes via des étapes de raisonnement intermédiaires. De plus, les instructions peuvent être optimisées pour les LLM avec des descriptions de tâches en langage naturel afin d'améliorer la généralisation aux tâches invisibles.

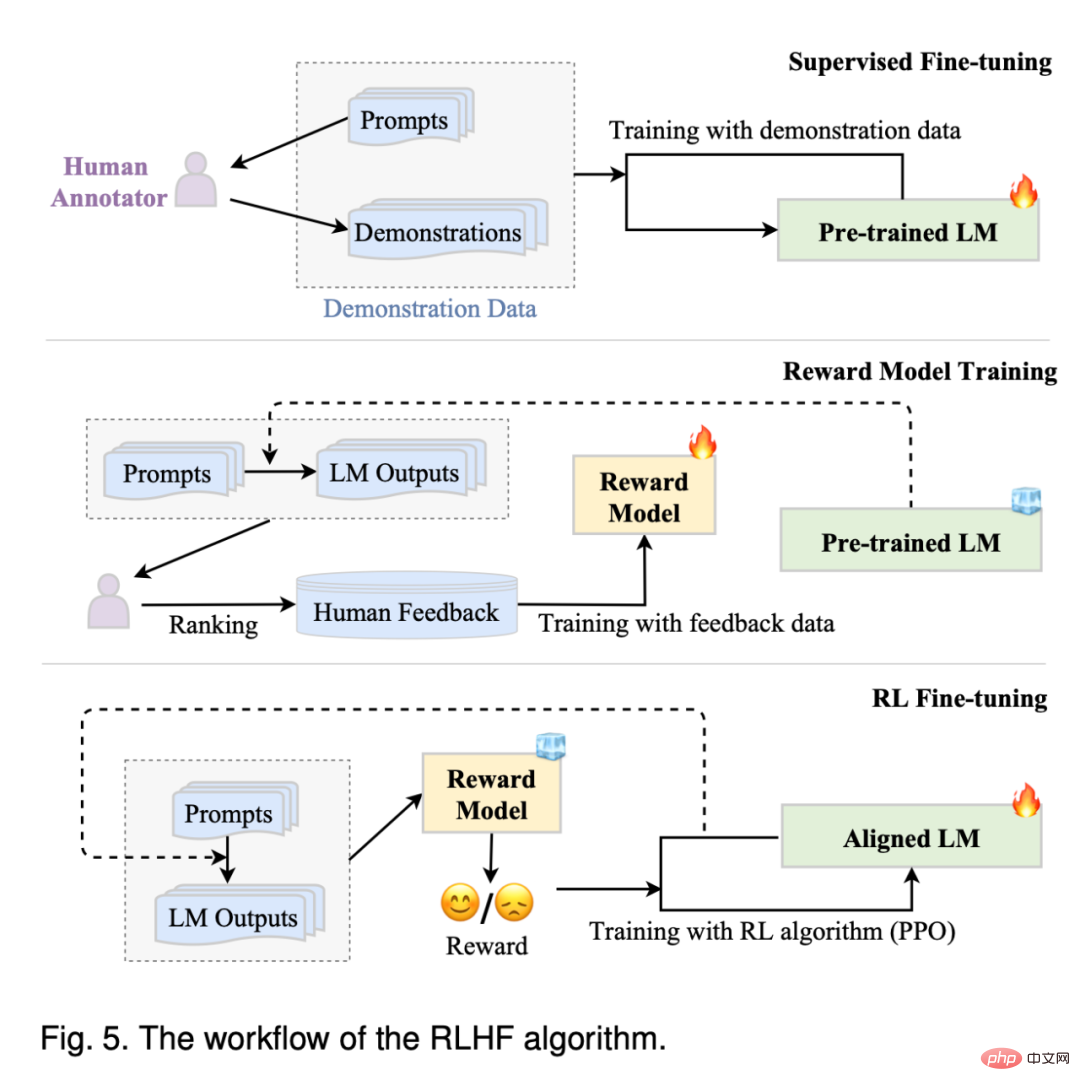

Réglage de l'alignement. Étant donné que les LLM sont formés pour capturer les caractéristiques des données des corpus de pré-formation (y compris les données de haute et de mauvaise qualité), ils sont susceptibles de générer un contenu textuel toxique, biaisé et nuisible. Pour aligner les LLM sur les valeurs humaines, InstructGPT a conçu une méthode de réglage efficace qui exploite l'apprentissage par renforcement et les commentaires humains afin que les LLM puissent suivre les instructions attendues. ChatGPT est développé sur une technologie similaire à InstructGPT et présente de fortes capacités d'alignement pour produire des réponses inoffensives de haute qualité.

Utilisation des outils. Les LLM sont essentiellement des générateurs de texte formés sur des corpus de texte brut à grande échelle et ne fonctionnent donc pas aussi bien sur des tâches telles que les calculs numériques où le texte est mal exprimé. De plus, les capacités des LLM sont limitées par les données préalables à la formation et ne peuvent pas capturer les dernières informations. En réponse à ces problèmes, des personnes ont proposé d'utiliser des outils externes pour combler les lacunes des LLM, comme l'utilisation de calculatrices pour effectuer des calculs précis et l'utilisation de moteurs de recherche pour récupérer des informations inconnues. ChatGPT utilise également des plug-ins externes pour acquérir de nouvelles connaissances en ligne. Ce mécanisme peut étendre considérablement les capacités des LLM.

Compte tenu des problèmes techniques complexes et des énormes besoins en ressources informatiques, développer ou répliquer des LLM n'est en aucun cas une tâche facile. Une approche possible consiste à tirer des leçons des LLM existants et à réutiliser les ressources accessibles au public pour un développement progressif ou une recherche expérimentale.

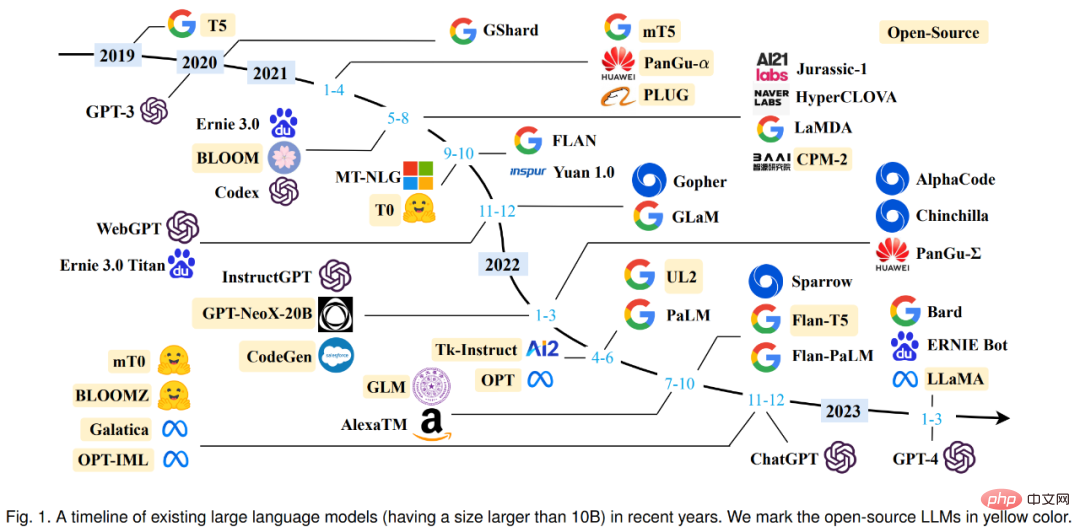

Dans la section 3, le chercheur résume principalement les points de contrôle ou API de modèles open source, les corpus disponibles et les bibliothèques utiles pour le LLM. Le tableau 1 ci-dessous présente les données statistiques de grands modèles comportant plus de 10 milliards de paramètres ces dernières années.

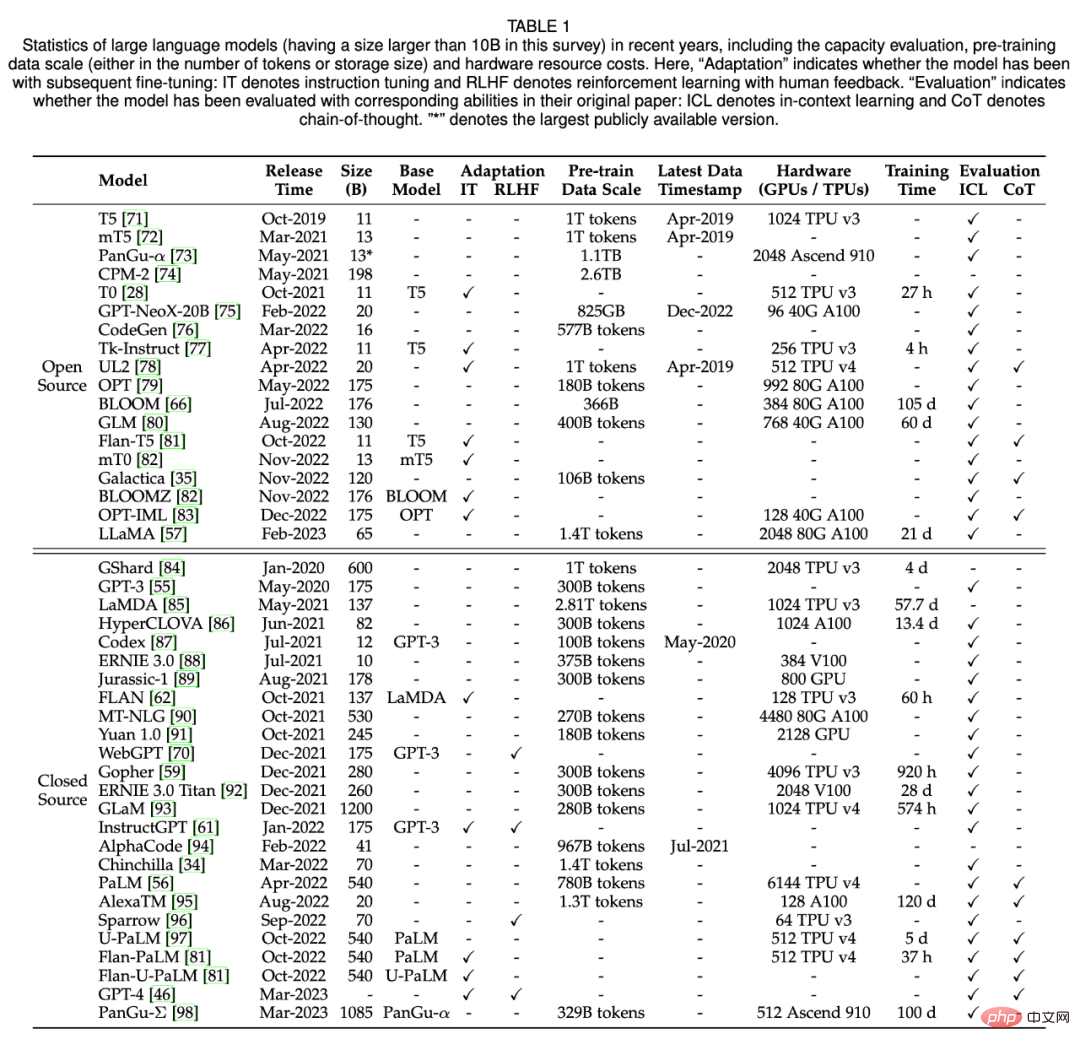

Le tableau 2 ci-dessous répertorie les sources de données couramment utilisées.

La pré-formation renforce la base de capacités des LLM. Grâce à une pré-formation sur des corpus à grande échelle, les LLM peuvent acquérir une compréhension linguistique de base et des compétences de production. Dans ce processus, la taille et la qualité du corpus de pré-formation sont essentielles pour que les LLM atteignent de solides capacités. De plus, pour pré-entraîner efficacement les LLM, les architectures de modèles, les méthodes d'accélération et les techniques d'optimisation doivent toutes être soigneusement conçues. Dans la section 4, le chercheur discute d'abord de la collecte et du traitement des données dans la section 4.1, puis présente les architectures de modèles couramment utilisées dans la section 4.2, et enfin introduit les techniques de formation pour une optimisation stable et efficace des LLM dans la section 4.3.

Collecte de données

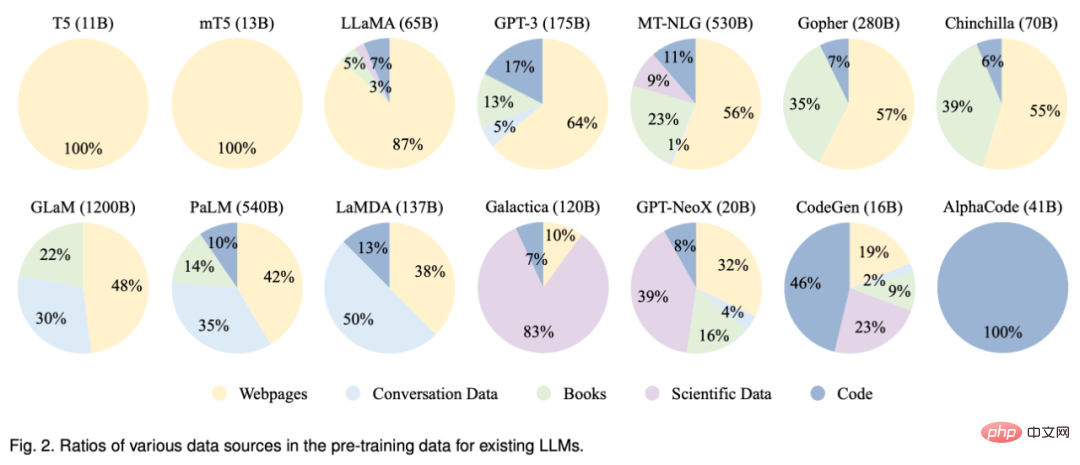

Pour développer un LLM puissant, il est crucial de collecter une grande quantité de corpus en langage naturel à partir de diverses sources de données. Les LLM existants utilisent principalement divers ensembles de données de textes publics comme corpus de pré-formation. La figure 2 ci-dessous répertorie la répartition des sources de données pré-entraînées pour les LLM existants.

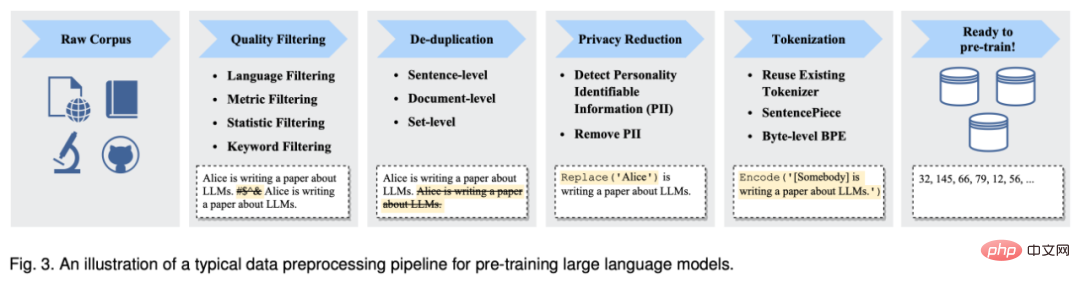

Après avoir collecté une grande quantité de données textuelles, ils doivent être pré-entraînés pour construire un corpus de pré-formation, y compris le débruitage, la suppression des redondances et la suppression des données non pertinentes et potentiellement toxiques. La figure 3 ci-dessous montre le pipeline de prétraitement des données de pré-formation pour les LLM.

Architecture

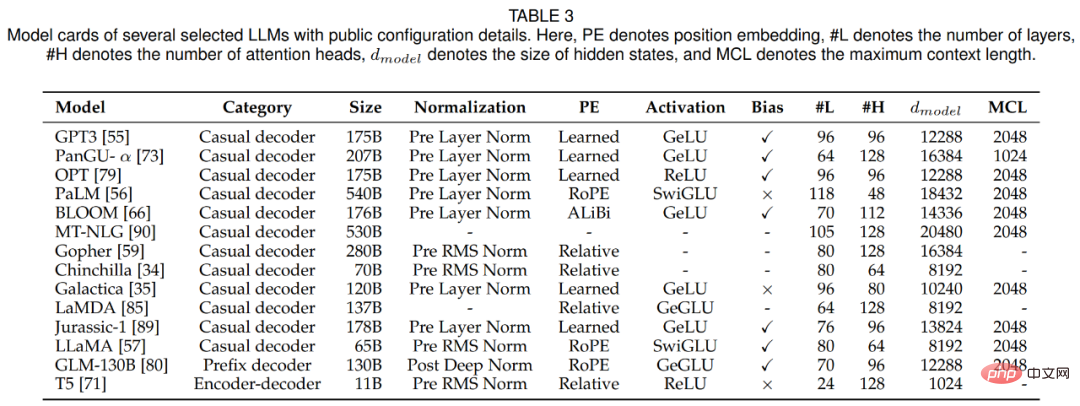

Dans cette section, le chercheur passe en revue la conception architecturale des LLM, c'est-à-dire l'architecture principale, les objectifs de pré-formation et les configurations détaillées. Le tableau 3 ci-dessous répertorie les modèles de fiches pour plusieurs LLM représentatifs avec des détails accessibles au public.

En raison de son excellente parallélisation et de sa capacité, l'architecture Transformer est devenue l'épine dorsale du développement de divers LLM, permettant d'adapter des modèles de langage à des centaines de milliards de paramètres. D'une manière générale, les architectures principales des LLM existants peuvent être grossièrement divisées en trois grandes catégories, à savoir le codeur-décodeur, le décodeur ad hoc et le décodeur de préfixe.

Depuis l'émergence de Transformer, diverses améliorations ont été proposées pour améliorer sa stabilité d'entraînement, ses performances et son efficacité de calcul. Dans cette partie, les chercheurs discutent des configurations correspondantes des quatre parties principales de Transformer, notamment la normalisation, le codage de position, la fonction d'activation, le mécanisme d'attention et le biais.

La pré-formation joue un rôle très critique, en encodant les connaissances générales d'un corpus à grande échelle en paramètres de modèle à grande échelle. Pour la formation des LLM, il existe deux tâches de pré-formation couramment utilisées : la modélisation du langage et l'auto-encodage du débruitage.

Formation de modèles

Dans cette section, le chercheur passe en revue les paramètres, techniques et techniques importants pour la formation des LLM.

Pour l'optimisation des paramètres des LLM, les chercheurs ont proposé des paramètres de formation par lots, de taux d'apprentissage, d'optimiseur et de stabilité de formation couramment utilisés.

À mesure que la taille des modèles et des données augmente, il est devenu difficile de former efficacement des modèles LLM avec des ressources informatiques limitées. En particulier, deux problèmes techniques majeurs doivent être résolus, tels que l'augmentation de la formation par saisie et le chargement de modèles plus volumineux dans la mémoire GPU. Cette section passe en revue plusieurs méthodes largement utilisées dans les travaux existants pour relever les deux défis ci-dessus, à savoir le parallélisme 3D, ZeRO et la formation de précision mixte, et donne des suggestions sur la façon de les exploiter pour la formation.

Après la pré-formation, les LLM peuvent acquérir la capacité générale à résoudre diverses tâches. Pourtant, un nombre croissant de recherches suggèrent que les capacités des LLM peuvent être davantage adaptées à des objectifs spécifiques. Dans la section 5, les chercheurs présentent en détail deux méthodes principales pour régler les LLM pré-entraînés, à savoir le réglage des instructions et le réglage de l'alignement. La première approche consiste principalement à améliorer ou à débloquer les capacités des LLM, tandis que la seconde approche consiste à rendre le comportement des LLM cohérent avec les valeurs ou les préférences humaines.

Instruction Tuning

Essentiellement, le réglage des instructions est une méthode de réglage fin des LLM pré-entraînés sur une collection d'exemples formatés sous forme de langage naturel, ce qui est très pertinent pour le réglage fin supervisé et formation rapide multitâche. Afin d'effectuer le réglage des instructions, nous devons d'abord collecter ou créer une instance du format d'instruction. Nous utilisons ensuite généralement ces instances formatées pour affiner les LLM selon une méthode d'apprentissage supervisé (par exemple, formés à l'aide d'une perte de séquence à séquence). Lorsque leurs instructions sont adaptées, les LLM peuvent démontrer des capacités supérieures à généraliser à des tâches invisibles, même dans des environnements multilingues.

Une enquête récente fournit un aperçu systématique de la recherche sur le réglage des instructions. En revanche, cet article se concentre sur l'impact du réglage des instructions sur les LLM et fournit des directives ou des stratégies détaillées, par exemple la collecte et le réglage. De plus, cet article traite de l'utilisation du réglage des instructions pour répondre aux besoins réels des utilisateurs, qui a été largement utilisé dans les LLM existants tels que InstructGPT et GPT-4.

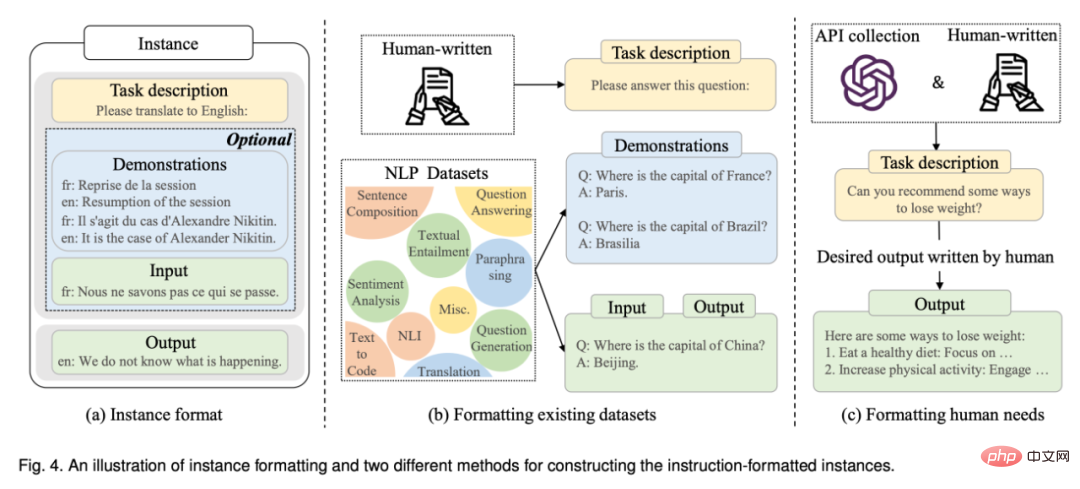

Construction d'instance formatée : généralement, une instance au format instruction se compose d'une description de tâche (appelée instruction), d'une paire d'entrées-sorties et d'un petit nombre de démonstrations (facultatif). Les recherches existantes ont publié une grande quantité de données étiquetées formatées en langage naturel comme une ressource publique importante (voir le tableau 5 pour une liste des ressources disponibles). Ensuite, cet article présente les deux principales manières de construire des instances formatées (voir l'illustration de la figure 4), puis aborde plusieurs facteurs clés dans la construction d'instances.

Stratégie de réglage des instructions : contrairement à la pré-formation, le réglage des instructions est généralement plus efficace car seul un nombre modeste d'instances est utilisé pour la formation. Bien que le réglage des instructions puisse être considéré comme un processus de formation supervisé, son optimisation diffère de la pré-formation sur plusieurs aspects, tels que l'objectif de formation (c'est-à-dire la perte de séquence à séquence) et la configuration d'optimisation (par exemple, une taille de lot plus petite) et le taux d'apprentissage. ), qui nécessitent une attention particulière dans la pratique. En plus de ces configurations d'optimisation, le réglage des instructions doit également prendre en compte deux aspects importants :

Alignement Tuning

Cette section présente d'abord le contexte de l'alignement et ses définitions et normes, puis se concentre sur la collecte de données de retour humain pour aligner les LLM, et enfin discute de l'utilisation de The technologie clé de l’apprentissage par renforcement par rétroaction humaine pour l’ajustement de l’alignement.

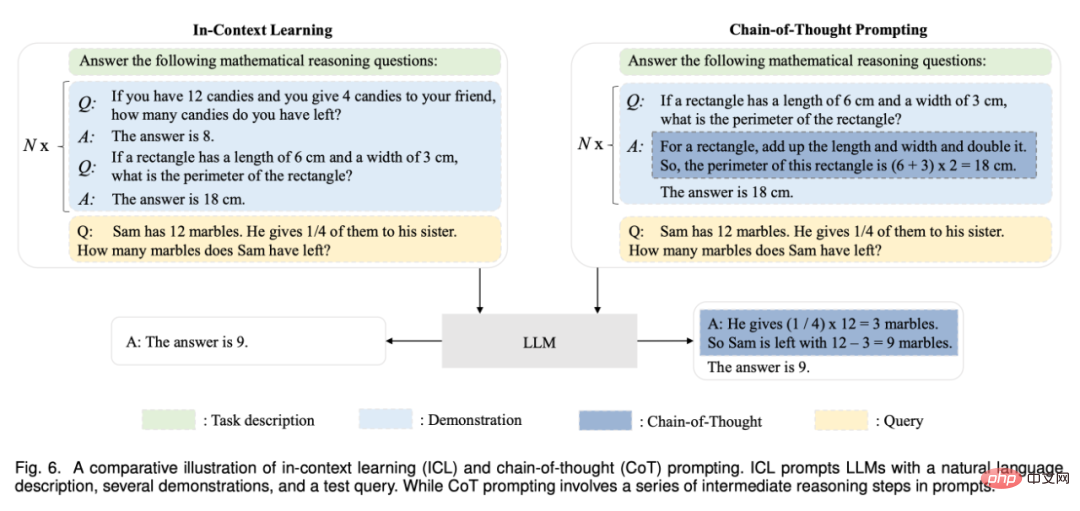

Après une pré-formation ou une adaptation, l'une des principales façons d'utiliser les LLM est de concevoir des stratégies rapides appropriées pour résoudre diverses tâches. Une approche rapide typique est l'apprentissage en contexte, qui formule des descriptions de tâches ou des démonstrations sous la forme d'un texte en langage naturel. De plus, la méthode d’incitation par chaîne de pensée peut améliorer l’apprentissage contextuel en incorporant une série d’étapes de raisonnement intermédiaires dans l’invite. Dans la section 6, les chercheurs présentent en détail les détails de ces deux techniques.

Apprentissage contextuel

En tant que forme d'invite spéciale, l'apprentissage contextuel (ICL) a été proposé pour la première fois dans GPT-3, et il est devenu une méthode typique pour utiliser les LLM.

Invite de chaîne de réflexion

Chain of Thoughts (CoT) est une stratégie d'invite améliorée qui peut améliorer les performances du LLM dans des tâches de raisonnement complexes, telles que le raisonnement arithmétique, le raisonnement de bon sens et le raisonnement symbolique. Plutôt que de simplement créer l'invite à partir de paires d'entrées-sorties comme ICL, CoT intègre dans l'invite des étapes de raisonnement intermédiaires qui mènent au résultat final. Dans la section 6.2, nous détaillons l'utilisation de CoT par rapport à ICL et discutons quand et pourquoi CoT est efficace.

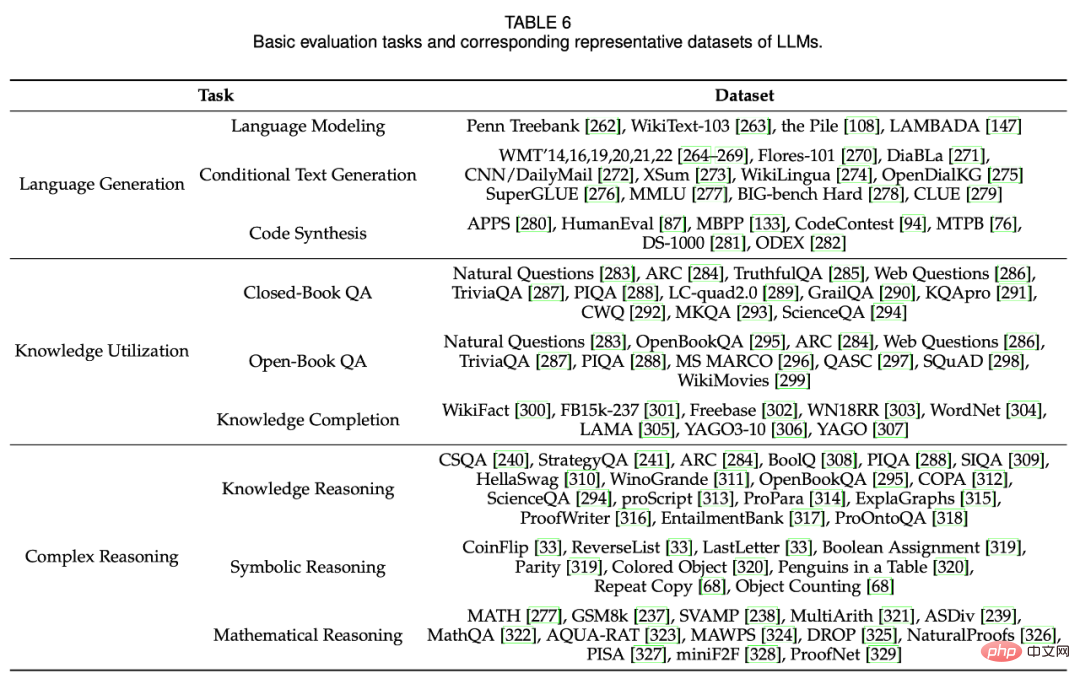

Pour étudier l'efficacité et la supériorité des LLM, les chercheurs ont utilisé un grand nombre de tâches et de critères de référence pour l'évaluation et l'analyse empiriques. La section 7 présente d'abord les tâches d'évaluation de base pour trois LLM pour la production et la compréhension du langage, puis présente plusieurs tâches avancées pour les LLM avec des paramètres ou des objectifs plus complexes, et enfin discute des références et des analyses empiriques existantes.

Tâche d'évaluation de base

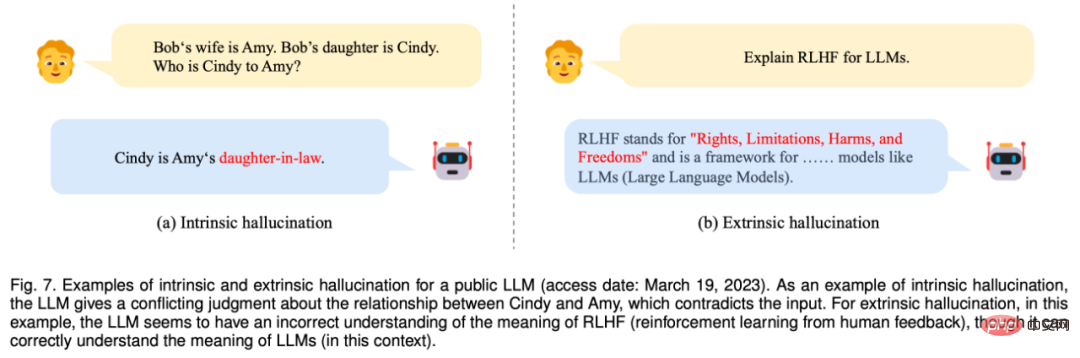

Figure 7 : Un exemple d'illusions internes et externes exposant le LLM (Consulté le 19 mars 2023). À titre d'exemple d'hallucination interne, LLM donne un jugement sur la relation entre Cindy et Amy qui contredit l'entrée. Pour les hallucinations extrinsèques, dans ce cas, LLM semble avoir une compréhension incorrecte de ce que signifie RLHF (apprentissage par renforcement à partir de la rétroaction humaine), même s'il comprend correctement ce que signifie LLM.

Évaluation avancée des tâches

En plus des tâches d'évaluation de base ci-dessus, les LLM démontrent également certaines capacités avancées qui nécessitent une évaluation spéciale. Dans la section 7.2, les chercheurs discutent de plusieurs capacités représentatives de haut niveau et des méthodes d'évaluation correspondantes, notamment l'alignement manuel, l'interaction avec l'environnement externe et le fonctionnement des outils.

Dans la dernière section, le chercheur a résumé la discussion de cette enquête et a présenté les défis et les orientations de développement futures des LLM sous les aspects suivants.

Théorie et principes : Afin de comprendre le mécanisme de fonctionnement de base du LLM, l'un des plus grands mystères est de savoir comment l'information est distribuée, organisée et utilisée à travers de très grands réseaux de neurones profonds. Il est important de révéler les principes ou éléments sous-jacents qui constituent la base des capacités des LLM. En particulier, la mise à l’échelle semble jouer un rôle important dans l’amélioration des capacités des LLM. Les recherches existantes ont montré que lorsque la taille des paramètres d'un modèle de langage augmente jusqu'à un point critique (tel que 10B), certaines capacités émergentes apparaissent de manière inattendue (saut soudain de performance), notamment l'apprentissage contextuel, le suivi d'instructions et l'apprentissage progressif. raisonnement par étapes. Ces capacités « émergentes » sont fascinantes mais aussi déroutantes : quand et comment les LLM les acquièrent-ils ? Certaines recherches récentes ont soit mené des expériences à grande échelle étudiant les effets des capacités émergentes et les facteurs qui les permettent, soit utilisé des cadres théoriques existants pour expliquer des capacités spécifiques. Un article technique perspicace ciblant la famille de modèles GPT traite également spécifiquement de ce sujet, mais il manque encore des théories et des principes plus formels pour comprendre, décrire et expliquer les capacités ou le comportement des LLM. Étant donné que les capacités émergentes présentent de grandes similitudes avec les transitions de phase, des théories ou des principes interdisciplinaires (par exemple, la question de savoir si les LLM peuvent être considérés comme une sorte de système complexe) peuvent être utiles pour expliquer et comprendre le comportement des LLM. Ces questions fondamentales méritent d’être explorées par la communauté des chercheurs et sont importantes pour développer la prochaine génération de LLM.

Architecture modèle : Transformer, composé de couches d'auto-attention multi-têtes empilées, est devenu une architecture courante pour la création de LLM en raison de son évolutivité et de son efficacité. Diverses stratégies ont été proposées pour améliorer les performances de cette architecture, telles que la configuration d'un réseau neuronal et la formation parallèle évolutive (voir la discussion dans la section 4.2.2). Afin d'améliorer encore la capacité du modèle (telle que la capacité de dialogue multi-tours), les LLM existants conservent généralement une longue longueur de contexte. Par exemple, GPT-4-32k a une longueur de contexte extrêmement grande de 32 768 jetons. Par conséquent, une considération pratique consiste à réduire la complexité temporelle (coût quadratique primitif) encourue par les mécanismes standard d’auto-attention.

De plus, il est important d'étudier l'impact de variantes de Transformer plus efficaces sur la construction de LLM, comme une attention éparse a été utilisée dans GPT-3. L’oubli catastrophique constitue également un défi pour les réseaux neuronaux, ce qui a également un impact négatif sur les LLM. Lorsque les LLM sont adaptés à de nouvelles données, les connaissances acquises précédemment sont susceptibles d'être détruites. Par exemple, le réglage fin des LLM pour certaines tâches spécifiques affectera leurs capacités générales. Une situation similaire se produit lorsque les LLM sont alignés sur les valeurs humaines, ce qu’on appelle une taxe d’alignement. Par conséquent, il est nécessaire d’envisager d’étendre l’architecture existante avec des mécanismes ou des modules plus flexibles pour prendre en charge efficacement les mises à jour des données et la spécialisation des tâches.

Formation de modèles : en pratique, la pré-formation de LLM utilisables est très difficile en raison de l'énorme effort de calcul et de la sensibilité à la qualité des données et aux techniques de formation. Par conséquent, en tenant compte de facteurs tels que l’efficacité du modèle, l’optimisation de l’efficience et la stabilité de la formation, il devient particulièrement important de développer des méthodes de pré-formation plus systématiques et plus économiques pour optimiser les LLM. Développez davantage de vérifications de modèles ou de diagnostics de performances (tels que la mise à l'échelle prévisible dans GPT-4) pour détecter les anomalies dès le début de la formation. En outre, cela nécessite également une prise en charge matérielle plus flexible ou des mécanismes de planification des ressources pour mieux organiser et utiliser les ressources dans les clusters informatiques. Étant donné que la pré-formation des LLM à partir de zéro est coûteuse, un mécanisme approprié doit être conçu pour pré-entraîner ou affiner en permanence les LLM en fonction de points de contrôle de modèles accessibles au public (par exemple, LLaMA et Flan-T5). Pour ce faire, plusieurs problèmes techniques doivent être résolus, notamment l’incohérence des données, les oublis catastrophiques et la spécialisation des tâches. À ce jour, il manque encore des points de contrôle de modèles open source pour des LLM reproductibles avec des journaux complets de prétraitement et de formation (par exemple, des scripts pour préparer les données de pré-formation). Fournir davantage de modèles open source pour la recherche sur les LLM serait extrêmement précieux. En outre, il est également important de développer des stratégies d'ajustement et des mécanismes d'étude plus améliorés pour stimuler efficacement les capacités du modèle.

Utilisation des modèles : étant donné que le réglage fin est coûteux dans les applications du monde réel, les invites sont devenues une méthode importante pour utiliser les LLM. En combinant des descriptions de tâches et des exemples de démonstration dans des invites, l'apprentissage contextuel (une forme spéciale d'invite) donne aux LLM de bonnes performances sur de nouvelles tâches, surpassant même dans certains cas les modèles affinés avec des données complètes. De plus, afin d'améliorer la capacité de raisonnement complexe, des techniques avancées d'invite ont été proposées, telles que la stratégie de chaîne de pensée (CoT), qui intègre des étapes de raisonnement intermédiaires dans les invites. Cependant, la méthode d'invite existante présente toujours les inconvénients suivants. Premièrement, la conception d'invites nécessite beaucoup de main-d'œuvre, donc générer automatiquement des invites efficaces pour résoudre diverses tâches sera très utile ; deuxièmement, certaines tâches complexes (telles que les preuves formelles et les calculs numériques) nécessitent des connaissances spécifiques ou des règles logiques. les règles peuvent ne pas être décrites en langage naturel ou prouvées avec des exemples, il est donc important de développer des méthodes d'invite avec plus d'informations et un formatage des tâches plus flexible ; troisièmement, les stratégies d'invite existantes se concentrent principalement sur les performances à un seul tour, elles sont donc très utiles. développer des mécanismes d'invite interactifs pour résoudre des tâches complexes (par exemple via des conversations en langage naturel), comme l'a démontré ChatGPT.

Sécurité et alignement : malgré leurs capacités considérables, les LLM souffrent de problèmes de sécurité similaires à ceux des petits modèles de langage. Par exemple, les LLM montrent une tendance à générer des textes hallucinatoires, comme ceux qui semblent raisonnables mais peuvent ne pas correspondre aux faits. Pire encore, les LLM peuvent être motivés par des instructions intentionnelles visant à produire des textes nuisibles, biaisés ou toxiques pour des systèmes malveillants, entraînant ainsi des risques potentiels d'abus. Pour une discussion détaillée d'autres problèmes de sécurité liés aux LLM (tels que la confidentialité, la dépendance excessive, la désinformation et les opérations d'impact), les lecteurs sont renvoyés au rapport technique GPT-3/4. Comme principale méthode pour éviter ces problèmes, l'apprentissage par renforcement à partir de la rétroaction humaine (RLHF) a été largement utilisé, qui intègre les humains dans la boucle de formation pour développer de bons LLM. Afin d'améliorer la sécurité du modèle, il est également important d'ajouter des invites liées à la sécurité pendant le processus RLHF, comme indiqué dans GPT-4. Cependant, le RLHF s'appuie fortement sur des données de feedback humain de haute qualité provenant d'étiqueteurs professionnels, ce qui rend difficile sa mise en œuvre correcte dans la pratique. Par conséquent, il est nécessaire d'améliorer le cadre RLHF pour réduire le travail des étiqueteurs humains et rechercher une méthode d'annotation plus efficace pour garantir la qualité des données. Par exemple, des LLM peuvent être adoptés pour faciliter le travail d'annotation. Récemment, l'équipe rouge a été adoptée pour améliorer la sécurité du modèle des LLM, qui utilise des invites contradictoires collectées pour affiner les LLM (c'est-à-dire éviter les attaques d'équipe rouge). En outre, il est également utile d'établir un mécanisme d'apprentissage pour les LLM grâce à la communication avec les humains. Les commentaires donnés par les humains via le chat peuvent être directement utilisés par les LLM pour leur auto-amélioration.

Applications et écosystème : étant donné que les LLM présentent de fortes capacités à résoudre une variété de tâches, ils peuvent être utilisés dans un large éventail d'applications du monde réel (par exemple, suivre des instructions spécifiques en langage naturel). En tant qu'avancée significative, ChatGPT a le potentiel de changer la façon dont les humains accèdent aux informations, conduisant à la sortie du nouveau Bing. Dans un avenir proche, il est prévisible que les LLM auront un impact significatif sur les technologies de recherche d’informations, notamment les moteurs de recherche et les systèmes de reconnaissance.

De plus, avec la mise à niveau technologique des LLM, le développement et l'utilisation d'assistants d'information intelligents seront grandement favorisés. À une échelle plus large, cette vague d’innovation technologique tend à établir un écosystème d’applications sous licence par les LLM (par exemple, la prise en charge des plug-ins par ChatGPT) qui seront étroitement liées à la vie humaine. Enfin, l’essor des LLM constitue une source d’inspiration pour l’exploration de l’intelligence artificielle générale (AGI). Il promet de développer des systèmes plus intelligents (potentiellement dotés de signaux multimodaux) que jamais. Dans le même temps, dans ce processus de développement, la sécurité de l'intelligence artificielle devrait être l'une des principales préoccupations, c'est-à-dire laisser l'intelligence artificielle apporter des avantages plutôt que de nuire à l'humanité.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Application de l'intelligence artificielle dans la vie

Application de l'intelligence artificielle dans la vie

Quel est le concept de base de l'intelligence artificielle

Quel est le concept de base de l'intelligence artificielle

Que faire si le système d'installation ne trouve pas le disque dur

Que faire si le système d'installation ne trouve pas le disque dur

disque système win10 occupé à 100%

disque système win10 occupé à 100%

Utilisation du contacteur AC

Utilisation du contacteur AC

Langage C pour trouver le multiple le plus petit commun

Langage C pour trouver le multiple le plus petit commun

Qu'est-ce qu'un ETF Bitcoin Futures ?

Qu'est-ce qu'un ETF Bitcoin Futures ?

Comment télécharger du HTML

Comment télécharger du HTML