Périphériques technologiques

Périphériques technologiques

IA

IA

HuggingGPT est populaire : un ChatGPT contrôle tous les modèles d'IA et aide automatiquement les gens à accomplir des tâches d'IA. Net-citoyens : laissez votre bouche manger.

HuggingGPT est populaire : un ChatGPT contrôle tous les modèles d'IA et aide automatiquement les gens à accomplir des tâches d'IA. Net-citoyens : laissez votre bouche manger.

HuggingGPT est populaire : un ChatGPT contrôle tous les modèles d'IA et aide automatiquement les gens à accomplir des tâches d'IA. Net-citoyens : laissez votre bouche manger.

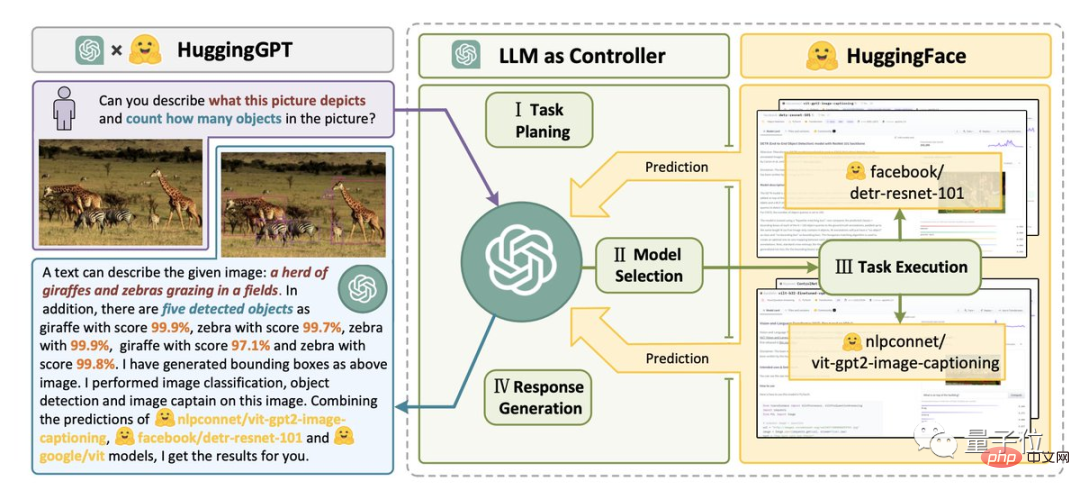

La combinaison la plus forte : HuggingFace+ChatGPT——

HuggingGPT, c'est ici !

Donnez simplement une tâche d'IA, telle que "Quels sont les animaux dans l'image ci-dessous et combien y en a-t-il de chaque type ?"

Il peut vous aider à analyser automatiquement quels modèles d'IA sont nécessaires, puis à appeler directement le modèle correspondant sur HuggingFace pour vous aider à l'exécuter et à le compléter.

Dans tout le processus, tout ce que vous avez à faire est d'exprimer vos exigences en langage naturel.

Ce résultat de la coopération entre l'Université du Zhejiang et Microsoft Research Asia est rapidement devenu populaire dès sa publication.

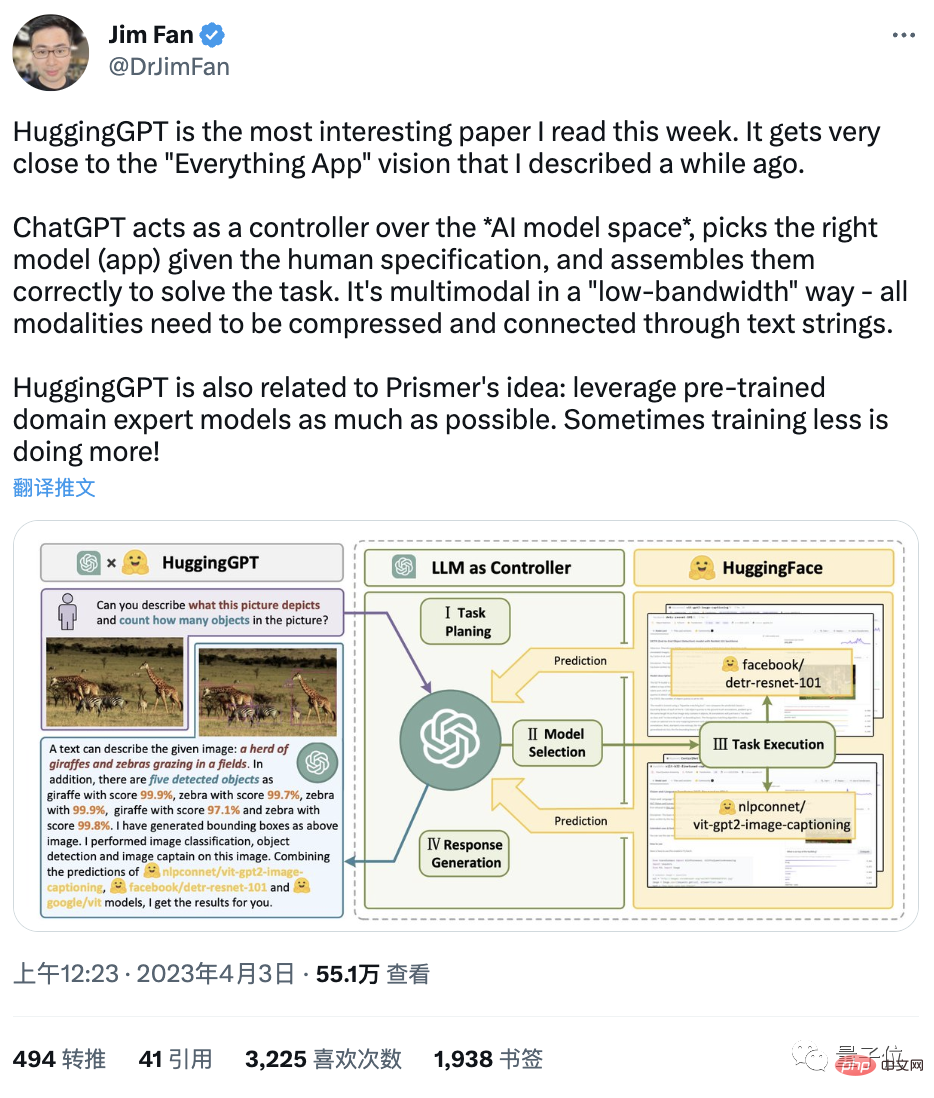

Jim Fan, chercheur chez NVIDIA AI, a déclaré directement :

C'est l'article le plus intéressant que j'ai lu cette semaine. Son idée est très proche de « Everything App » (tout est une App, et les informations sont lues directement par l’IA).

Et un internaute « se frappe directement la cuisse » :

N'est-ce pas « l'homme du transfert de paquets » de ChatGPT ?

L'IA évolue à un rythme rapide, nous laissant de quoi manger...

Alors, que se passe-t-il exactement ?

HuggingGPT : Votre modèle d'IA "Hugging GPT"

En fait, si vous dites que cette combinaison n'est qu'un "Hugging Man", alors le motif est trop petit.

Sa véritable signification est AGI.

Comme l'auteur l'a dit, une étape clé vers l'AGI est la capacité à résoudre des tâches d'IA complexes avec différents domaines et modes.

Nos résultats actuels sont encore loin de cela : un grand nombre de modèles ne peuvent bien accomplir qu'une tâche spécifique.

Cependant, les performances des grands modèles de langage LLM en matière de compréhension, de génération, d'interaction et de raisonnement du langage ont fait réfléchir l'auteur :

Ils peuvent être utilisés comme contrôleurs intermédiaires pour gérer tous les modèles d'IA existants, en « mobilisant et combinant tout le monde » Le pouvoir de l'IA" pour résoudre des tâches complexes d'IA.

Dans ce système, la langue est l'interface universelle.

C'est ainsi que HuggingGPT est né.

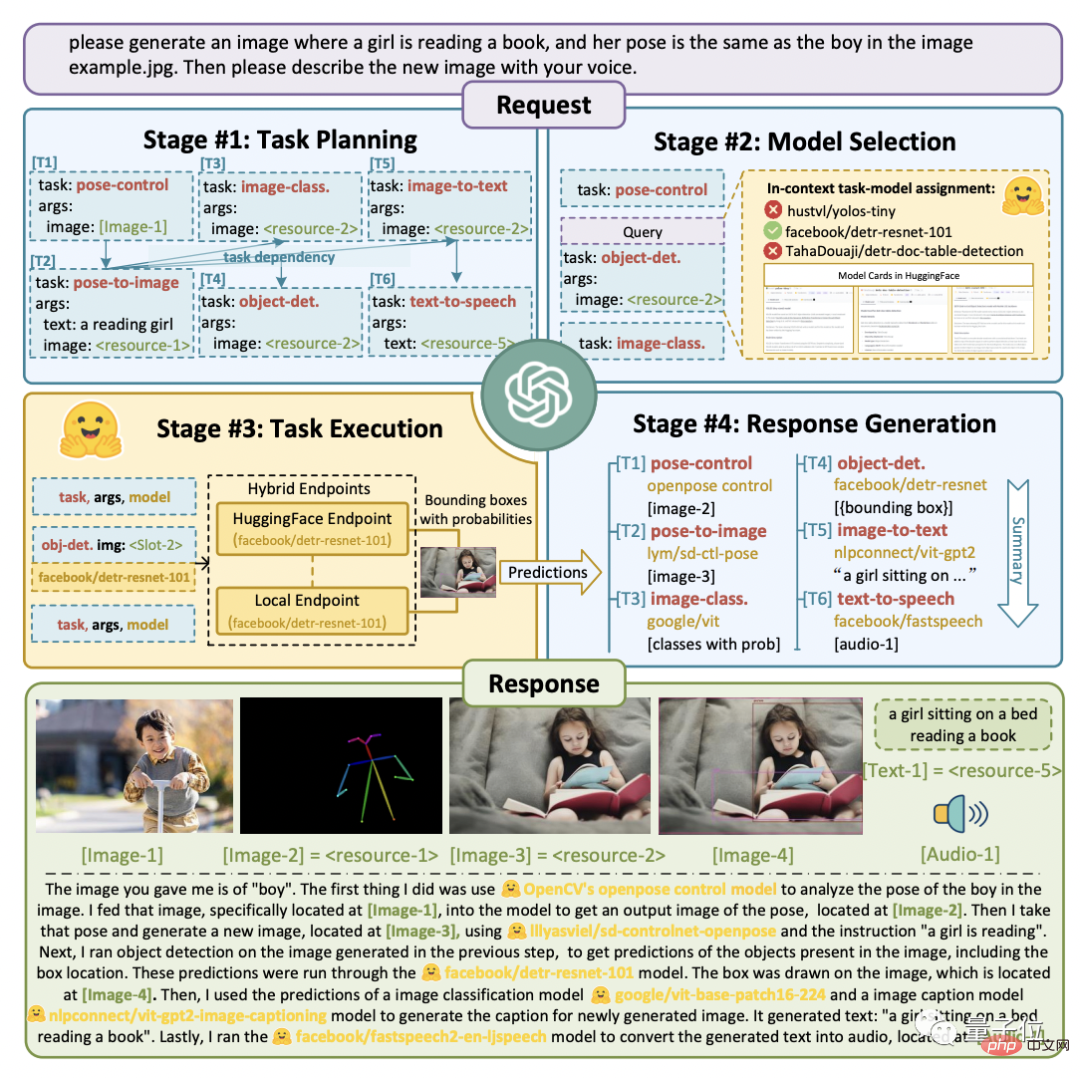

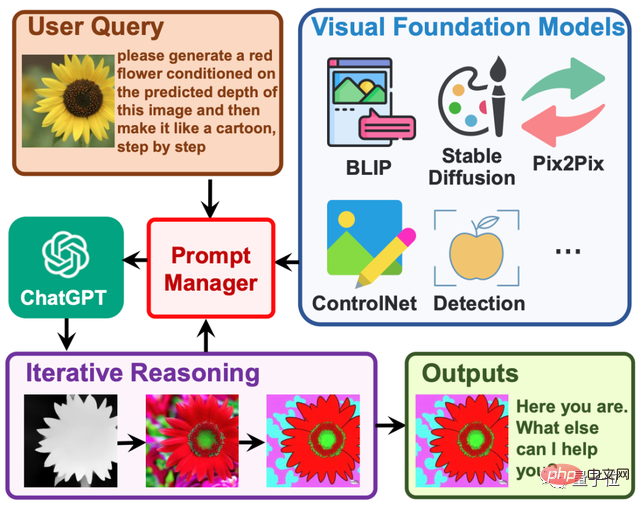

Son processus d'ingénierie est divisé en quatre étapes :

Premièrement, la planification des tâches. ChatGPT analyse les besoins de l'utilisateur dans une liste de tâches et détermine la séquence d'exécution et les dépendances de ressources entre les tâches.

Deuxièmement, la sélection du modèle. ChatGPT attribue des modèles appropriés aux tâches en fonction des descriptions de chaque modèle expert hébergé sur HuggingFace.

Ensuite, la tâche est exécutée. Le modèle expert sélectionné sur le point de terminaison hybride (y compris l'inférence locale et l'inférence HuggingFace) exécute les tâches assignées en fonction de la séquence de tâches et des dépendances, et fournit les informations d'exécution et les résultats à ChatGPT.

Enfin, affichez les résultats. ChatGPT résume les journaux du processus d'exécution et les résultats d'inférence de chaque modèle et donne le résultat final.

Comme le montre l'image ci-dessous.

Supposons que nous fassions une telle demande :

Veuillez générer une image d'une fille lisant un livre, sa posture est la même que celle du garçon dans example.jpg. Utilisez ensuite votre voix pour décrire la nouvelle image.

Vous pouvez voir comment HuggingGPT le décompose en 6 sous-tâches et sélectionne respectivement le modèle à exécuter pour obtenir le résultat final.

Quel est l'effet spécifique ?

L'auteur a effectué des mesures réelles en utilisant gpt-3.5-turbo et text-davinci-003, deux variantes accessibles publiquement via l'API OpenAI.

Comme le montre la figure ci-dessous :

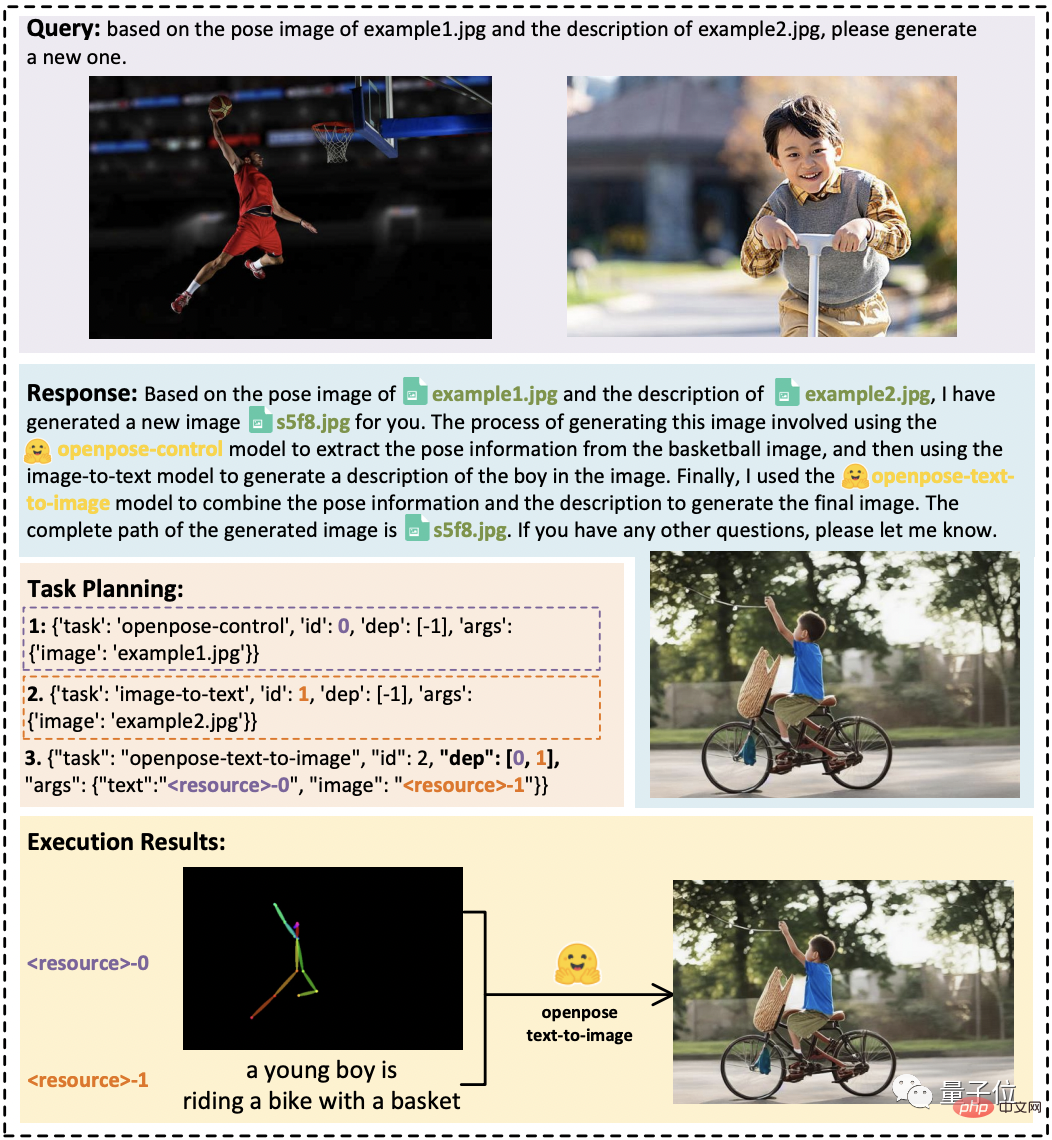

Lorsqu'il existe des dépendances de ressources entre les tâches, HuggingGPT peut analyser correctement les tâches spécifiques en fonction de la demande abstraite de l'utilisateur et terminer la conversion de l'image.

Dans les tâches audio et vidéo, il a également démontré la capacité d'organiser la coopération entre les modèles en exécutant les deux modèles en parallèle et en série, respectivement, une vidéo des "Astronautes marchant dans l'espace" et des travaux de doublage.

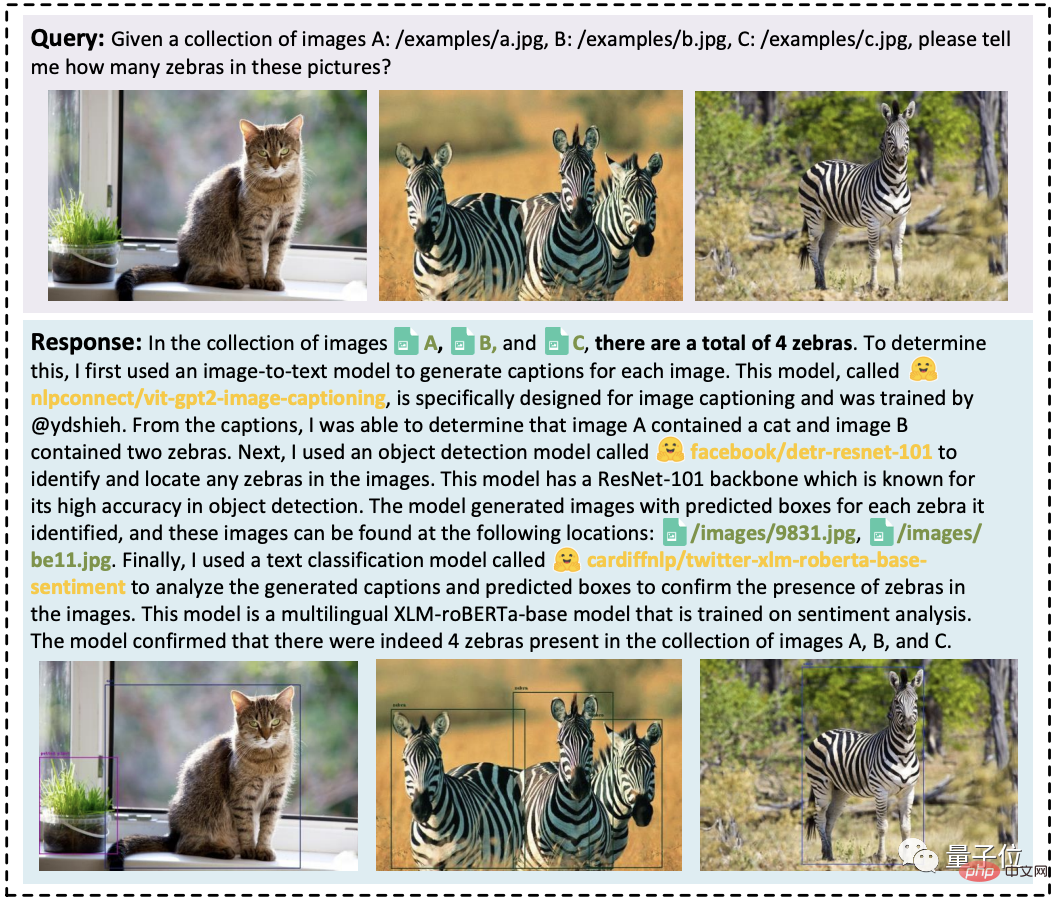

De plus, il peut intégrer des ressources d'entrée de plusieurs utilisateurs pour effectuer un raisonnement simple, comme compter le nombre de zèbres dans les trois images suivantes.

Résumé en une phrase : HuggingGPT peut montrer de bonnes performances sur diverses formes de tâches complexes.

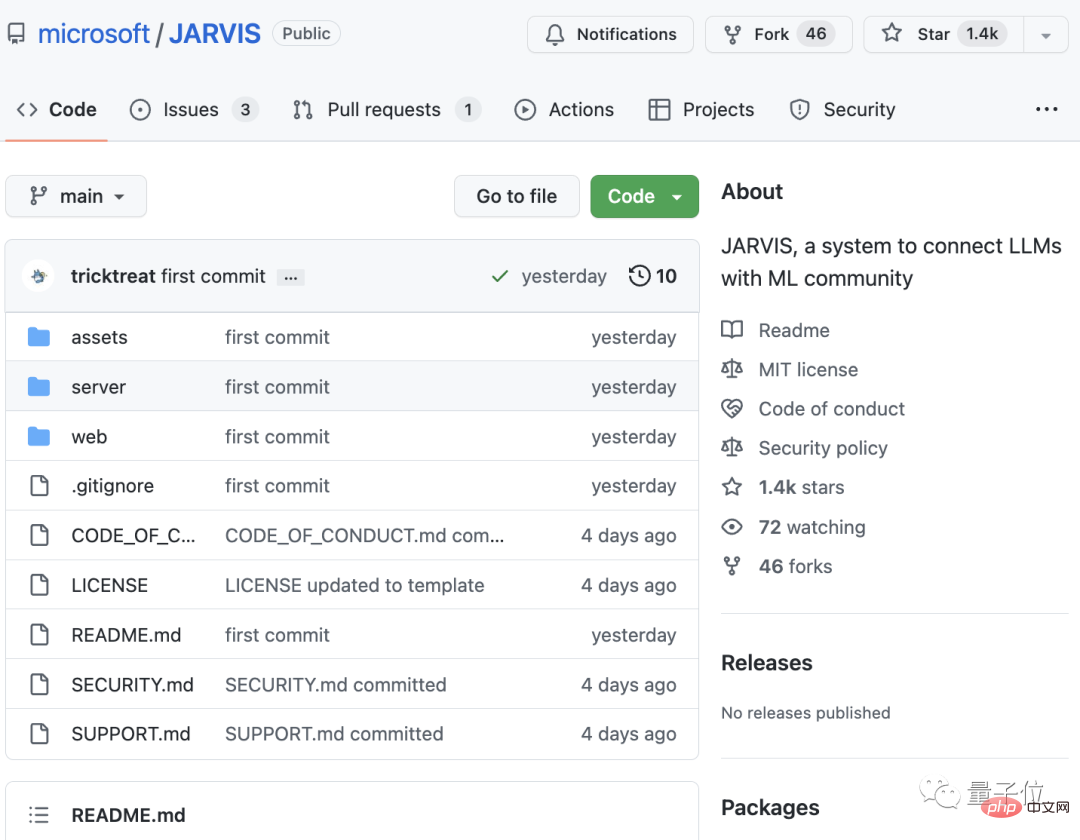

Le projet est open source, nommé "Jarvis"

Actuellement, l'article de HuggingGPT a été publié et le projet est en construction. Seule une partie du code a été open source et il a reçu 1,4k étoiles.

Nous avons remarqué que le nom de son projet est très intéressant. Il ne s'appelle pas HuggingGPT, mais le majordome IA JARVIS dans Iron Man.

Certaines personnes ont trouvé que l'idée est très similaire à celle du Visual ChatGPT qui vient de sortir en mars : ce dernier HuggingGPT, principalement la portée des modèles appelables a été élargie à davantage, y compris la quantité et le type.

Oui, en fait, ils ont tous un auteur commun : Microsoft Asia Research Institute.

Plus précisément, le premier auteur de Visual ChatGPT est le chercheur principal de la MSRA, Wu Chenfei, et l'auteur correspondant est le chercheur en chef de la MSRA, Duan Nan.

HuggingGPT comprend deux co-auteurs :

Shen Yongliang, qui est de l'Université du Zhejiang et a réalisé ce travail lors de son stage à la MSRA ;

Song Kaitao, chercheur à la MSRA ;

L'auteur correspondant est Zhuang Yueting, professeur du Département d'informatique de l'Université du Zhejiang.

Enfin, les internautes sont très enthousiasmés par la naissance de ce nouvel outil puissant. Certains ont dit :

ChatGPT est devenu le commandant en chef de toutes les IA créées par les humains.

Certaines personnes pensent également que

AGI n'est peut-être pas un LLM, mais plusieurs modèles interdépendants reliés par un LLM « intermédiaire ».

Alors, avons-nous commencé l'ère du « semi-AGI » ?

Adresse papier :https://www.php.cn/link/1ecdec353419f6d7e30857d00d0312d1

Lien du projet :https://www.php.cn/link/859555c74e9afd45 ab 771c615c1e49a6

Lien de référence :https://www.php.cn/link/62d2b7ba91f34c0ac08aa11c359a8d2c

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Afin de définir le délai d'expiration de Vue Axios, nous pouvons créer une instance AxiOS et spécifier l'option Timeout: dans les paramètres globaux: vue.prototype. $ Axios = axios.create ({timeout: 5000}); Dans une seule demande: ce. $ axios.get ('/ api / utilisateurs', {timeout: 10000}).

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

MySQL peut renvoyer les données JSON. La fonction JSON_Extract extrait les valeurs de champ. Pour les requêtes complexes, envisagez d'utiliser la clause pour filtrer les données JSON, mais faites attention à son impact sur les performances. Le support de MySQL pour JSON augmente constamment, et il est recommandé de faire attention aux dernières versions et fonctionnalités.

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

L'optimisation des performances MySQL doit commencer à partir de trois aspects: configuration d'installation, indexation et optimisation des requêtes, surveillance et réglage. 1. Après l'installation, vous devez ajuster le fichier my.cnf en fonction de la configuration du serveur, tel que le paramètre innodb_buffer_pool_size, et fermer query_cache_size; 2. Créez un index approprié pour éviter les index excessifs et optimiser les instructions de requête, telles que l'utilisation de la commande Explication pour analyser le plan d'exécution; 3. Utilisez le propre outil de surveillance de MySQL (ShowProcessList, Showstatus) pour surveiller la santé de la base de données, et sauvegarde régulièrement et organisez la base de données. Ce n'est qu'en optimisant en continu ces étapes que les performances de la base de données MySQL peuvent être améliorées.

Comment optimiser les performances MySQL pour les applications de haute charge?

Apr 08, 2025 pm 06:03 PM

Comment optimiser les performances MySQL pour les applications de haute charge?

Apr 08, 2025 pm 06:03 PM

Guide d'optimisation des performances de la base de données MySQL dans les applications à forte intensité de ressources, la base de données MySQL joue un rôle crucial et est responsable de la gestion des transactions massives. Cependant, à mesure que l'échelle de l'application se développe, les goulots d'étranglement des performances de la base de données deviennent souvent une contrainte. Cet article explorera une série de stratégies efficaces d'optimisation des performances MySQL pour garantir que votre application reste efficace et réactive dans des charges élevées. Nous combinerons des cas réels pour expliquer les technologies clés approfondies telles que l'indexation, l'optimisation des requêtes, la conception de la base de données et la mise en cache. 1. La conception de l'architecture de la base de données et l'architecture optimisée de la base de données sont la pierre angulaire de l'optimisation des performances MySQL. Voici quelques principes de base: sélectionner le bon type de données et sélectionner le plus petit type de données qui répond aux besoins peut non seulement économiser un espace de stockage, mais également améliorer la vitesse de traitement des données.