Périphériques technologiques

Périphériques technologiques

IA

IA

Réexaminer l'IA, la découverte et la preuve de concept de l'émergence de symboles dans les réseaux de neurones

Réexaminer l'IA, la découverte et la preuve de concept de l'émergence de symboles dans les réseaux de neurones

Réexaminer l'IA, la découverte et la preuve de concept de l'émergence de symboles dans les réseaux de neurones

Cet article se concentre sur deux travaux récents pour discuter de l'émergence de concepts symboliques dans les réseaux de neurones, c'est-à-dire la question de "Si la représentation des réseaux de neurones profonds est symbolique ?" Si nous contournons la perspective de « l’amélioration de la technologie des applications » et réexaminons l’IA du point de vue du « développement scientifique », il est sans aucun doute d’une grande importance de prouver que le phénomène d’émergence de symboles dans les modèles d’IA est d’une grande importance.

1. Tout d'abord, la plupart des recherches actuelles sur l'interprétabilité tentent d'interpréter les réseaux de neurones comme un modèle « clair », « sémantique » ou « logique ». Cependant, si l’émergence symbolique des réseaux de neurones ne peut pas être prouvée et si les composants représentationnels intrinsèques des réseaux de neurones comportent réellement de nombreuses composantes chaotiques, alors la plupart des recherches sur l’interprétabilité perdront leur base factuelle de base.

2. Deuxièmement, si l'émergence symbolique des réseaux de neurones ne peut être prouvée, le développement du deep learning sera très probablement bloqué au niveau de facteurs périphériques tels que la « structure », la « fonction de perte », les « données », etc., et ne sera pas en mesure d'analyser directement le niveau cognitif de haut niveau pour réaliser un apprentissage interactif au niveau des connaissances. Le développement dans cette direction nécessite un support théorique plus propre et plus clair.

Par conséquent, cet article le présente principalement sous les trois aspects suivants.

1. Comment définir les concepts symboliques modélisés par les réseaux de neurones, afin de découvrir de manière fiable le phénomène d'émergence symbolique des réseaux de neurones.

2. Pourquoi les concepts symboliques quantifiés peuvent être considérés comme des concepts crédibles (parcimonie, correspondance universelle des représentations des réseaux neuronaux, transférabilité, classification, interprétation des indicateurs d'interprétabilité historiques).

3. Comment prouver l'émergence de concepts symboliques - c'est-à-dire prouver théoriquement que lorsque le modèle d'IA est dans certaines circonstances (une condition non stricte), la logique de représentation du modèle d'IA peut être déconstruite en un très petit nombre de symboles transférables L'utilité de classification du concept de transformation (cette partie sera discutée publiquement fin avril).

Adresse papier : https://arxiv.org/pdf/2111.06206.pdf

Adresse papier : https://arxiv.org /pdf/ 2302.13080.pdf

Les auteurs de l'étude comprennent Li Mingjie, étudiant en deuxième année de maîtrise à l'Université Jiao Tong de Shanghai, et Ren Jie, étudiant en doctorat de troisième année à l'Université Jiao Tong de Shanghai. Jie a étudié auprès du professeur Zhang Quanshi. Leur équipe de laboratoire mène toute l’année des recherches sur l’interprétabilité des réseaux de neurones. Pour le domaine de l'interprétabilité, les chercheurs peuvent l'analyser sous différents angles, notamment expliquer la représentation, expliquer la performance, relativement fiable et raisonnable, et certains déraisonnables. Cependant, si nous discutons plus en détail, il existe deux visions fondamentales pour l'explication des réseaux de neurones, à savoir « Est-ce que peut représenter clairement et rigoureusement le concept modélisé par les réseaux de neurones » et « Peut-il être expliqué avec précision ? Trouver les facteurs qui déterminent les performances des réseaux de neurones".

Dans le sens « d'expliquer les concepts modélisés par les réseaux de neurones », il y a une question centrale à laquelle tous les chercheurs doivent faire face : « La représentation des réseaux de neurones est-elle symboliquement conceptuelle ? ». Si la réponse à cette question n'est pas claire, alors les recherches ultérieures seront difficiles à mener - si la représentation du réseau neuronal lui-même est chaotique, et alors le chercheur force un tas de "concepts symboliques" ou de "logique causale" à expliquer, ce sera Vous veniez dans la mauvaise direction ? L'hypothèse d'une représentation symbolique des réseaux de neurones est à la base de recherches approfondies dans ce domaine, mais la démonstration de cette question rend souvent les gens incapables de démarrer.

Le premier réflexe de la plupart des chercheurs à propos des réseaux de neurones est : Cela ne peut pas être symbolique, n’est-ce pas ? Les réseaux de neurones ne sont pas des modèles graphiques après tout. Dans un article rédigé par Cynthia et al., "Arrêtez d'expliquer les modèles d'apprentissage automatique en boîte noire pour les décisions à enjeux élevés et utilisez plutôt des modèles interprétables" [3], on pense à tort que les gens sont des explications post-hoc des réseaux de neurones. C'est intrinsèquement peu fiable. .

Alors, la représentation intrinsèque des réseaux de neurones est vraiment très déroutante ? Plutôt que clair, clairsemé et symbolique ? En nous concentrant sur cette question, nous avons défini l'interaction de jeu [4, 5], prouvé le goulot d'étranglement de la représentation des réseaux neuronaux [6] et étudié les caractéristiques de la représentation des concepts visuels par les réseaux neuronaux [7, 8], prouvant ainsi que le concept d'interaction est étroitement lié au réseau neuronal. La relation entre transformation et robustesse [9,10,11,12] a été améliorée, et la valeur de Shapley a été améliorée [13]. la périphérie du noyau de la « représentation symbolique » et n'a pas pu l'explorer directement Si la représentation du réseau neuronal est symbolique.

Nous commençons ici par la conclusion - Dans la plupart des cas, la représentation des réseaux de neurones est claire, clairsemée et symbolique. Il y a de nombreuses preuves théoriques et de nombreuses démonstrations expérimentales derrière cette conclusion. En termes de théorie, nos recherches actuelles ont prouvé certaines propriétés qui peuvent soutenir la « symbolisation », mais la preuve actuelle n'est pas suffisante pour donner une réponse rigoureuse et claire à la « représentation symbolisée ». Dans les mois à venir, nous aurons des preuves plus rigoureuses et plus complètes.

Comment définir le concept modélisé par le réseau de neurones

Avant d'analyser le réseau de neurones, il faut clarifier "comment définir le concept modélisé par le réseau". En fait, il y a eu des études pertinentes sur cette question avant [14,15], et les résultats expérimentaux sont relativement excellents - Cependant, nous pensons que la définition du « concept » devrait être « rigoureux » en théorie ” mathématique garantie.

Par conséquent, nous avons défini l'indice I(S) dans l'article [1] pour quantifier l'utilité du concept S pour la sortie du réseau, où S fait référence à toutes les variables d'entrée qui composent ce concept rassemblé. Par exemple, étant donné un réseau de neurones et une phrase d'entrée x = "Je pense que c'est une main verte.", chaque mot peut être considéré comme l'une des variables d'entrée du réseau, et les trois mots "a" et "vert" dans la phrase , "main" peut constituer un concept potentiel S={a, green, hand}. Chaque concept S représente la relation « ET » entre variables d'entrée dans S : Ce concept est déclenché quand et seulement si toutes les variables d'entrée dans S apparaissent, contribuant ainsi à l'utilitaire I(S) de sortie du réseau. Lorsqu'une variable de S est masquée, l'utilité de I (S) est supprimée de la sortie réseau d'origine. Par exemple, pour le concept S={a, green, hand}, si le mot « main » dans la phrase d'entrée est bloqué, alors ce concept ne sera pas déclenché, et la sortie réseau ne contiendra pas l'utilité de ce concept. EST).

Nous avons prouvé que la sortie du réseau neuronal peut toujours être divisée en la somme des utilités de tous les concepts déclenchés. C'est-à-dire qu'en théorie, pour un échantillon contenant n unités d'entrée, il y a au plus

différentes méthodes d'occlusion. On peut toujours utiliser l'utilité d'"un petit nombre de concepts" pour "avec précision". adapter" le réseau de neurones "Tous

valeurs de sortie sur différents échantillons d'occlusion, prouvant ainsi la "rigueur" de I(S) . La figure ci-dessous donne un exemple simple.

De plus, nous avons prouvé dans l'article [1] que I (S) satisfait 7 propriétés en théorie des jeux, illustrant davantage la fiabilité de cet indicateur.

De plus, nous avons également prouvé que le concept d'interaction de jeu I (S) peut expliquer le mécanisme de base d'un grand nombre d'indicateurs classiques de la théorie des jeux, tels que la valeur de Shapley [16], l'indice d'interaction de Shapley [17] et l'indice de Shapley. -Indice d'interaction Taylor [18]. Plus précisément, nous pouvons représenter ces trois indicateurs comme des formes de différentes sommes linéaires de concepts d’interaction.

En fait, les travaux préliminaires de l'équipe de recherche ont défini la valeur de référence optimale de la valeur de Shapley sur la base de l'indice de concept d'interaction de jeu [13], et ont exploré le « concept visuel prototype » modélisé par le réseau neuronal visuel. et son « esthétique »[8].

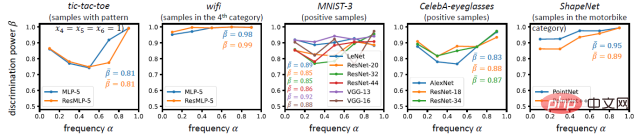

Le réseau neuronal modèle-t-il des représentations conceptuelles claires et symboliques

Avec cet indicateur, nous explorons plus en détail la question centrale mentionnée ci-dessus : si le réseau neuronal peut vraiment résumer les représentations symboliques claires des tâches de formation Représentation symbolique et conceptuelle ? Le concept d'interaction défini peut-il réellement représenter une « connaissance » significative, ou s'agit-il simplement d'une métrique délicate qui est purement mathématique et n'a pas de signification claire ? À cette fin, nous répondons à cette question sous les quatre aspects suivants : la représentation de la conceptualisation symbolique doit satisfaire à la parcimonie, à la transférabilité entre les échantillons, à la transférabilité entre les réseaux et à la classification.

Exigence 1 (parcalité des concepts) : Les concepts modélisés par le réseau neuronal doivent être clairsemés.

Différent du connexionnisme, une caractéristique du symbolisme est que les gens espèrent utiliser un petit nombre de concepts clairsemés pour représenter le connaissances apprises par le réseau plutôt que d’utiliser un grand nombre de concepts denses. Lors d’expériences, nous avons constaté que parmi un grand nombre de concepts potentiels, il n’existe qu’un très petit nombre de concepts saillants. Autrement dit, l'utilité d'interaction I (S) de la plupart des concepts interactifs s'approche de 0, elle peut donc être ignorée. Seul un très petit nombre de concepts interactifs ont une utilité d'interaction significative I (S). ne dépend que de l’utilité d’interaction d’un petit nombre de concepts. En d’autres termes, l’inférence du réseau neuronal pour chaque échantillon peut être expliquée succinctement par l’utilité d’un petit nombre de concepts saillants.

Exigence 2 (Transférabilité entre échantillons) : Le concept modélisé par le réseau de neurones doit être transférable entre différents échantillons

C'est loin d'être suffisant pour satisfaire la parcimonie sur un seul échantillon. ces expressions conceptuelles clairsemées doivent être transférables entre différents échantillons. Si le même concept d’interaction peut être représenté dans différents échantillons, et si différents échantillons extraient toujours des concepts d’interaction similaires, alors ce concept d’interaction est plus susceptible de représenter une connaissance significative et universelle. Au contraire, si la plupart des concepts d’interaction ne sont représentés que sur un ou deux échantillons spécifiques, alors l’interaction définie de cette manière est plus susceptible d’être une métrique délicate avec uniquement des définitions mathématiques mais aucune signification physique. Lors d’expériences, nous avons constaté qu’il existe souvent un dictionnaire de concepts plus petit, capable d’expliquer la plupart des concepts modélisés par les réseaux de neurones pour des échantillons de la même catégorie.

Nous avons également visualisé certains concepts et constaté que le même concept produit généralement des effets similaires sur différents échantillons, ce qui vérifie également la transférabilité des concepts entre différents échantillons.

Exigence trois (transférabilité entre réseaux) : Il devrait y avoir une transférabilité entre les concepts modélisés par différents réseaux de neurones

De même, ces concepts devraient pouvoir être appris de manière stable par différents réseaux de neurones, qu'il s'agisse de réseaux avec des initialisations différentes ou des architectures différentes. Bien que les réseaux de neurones puissent être conçus avec des architectures complètement différentes et des caractéristiques de modèle de différentes dimensions, si différents réseaux de neurones sont confrontés à la même tâche spécifique, ils peuvent atteindre « le même objectif par des chemins différents », c'est-à-dire si différents réseaux de neurones peuvent apprendre de manière stable des méthodes similaires. Un ensemble de concepts d'interaction, on peut alors penser que cet ensemble de concepts d'interaction est la représentation fondamentale de cette tâche. Par exemple, si différents réseaux de détection de visage modélisent tous l’interaction entre les yeux, le nez et la bouche, alors on peut penser qu’une telle interaction est plus « essentielle » et « fiable ». Lors d'expériences, nous avons constaté que les concepts les plus saillants sont plus faciles à apprendre par différents réseaux en même temps, et que la proportion relative des interactions saillantes est modélisée conjointement par différents réseaux de neurones.

Exigence 4 (Classification des concepts) : Le concept modélisé par le réseau neuronal doit être classifiable

Enfin, pour les tâches de classification, si un concept a une classification élevée, alors il doit avoir un positif cohérent effet (ou un effet négatif constant) sur la classification de la plupart des échantillons. Une classifiabilité plus élevée peut vérifier que le concept peut entreprendre indépendamment la tâche de classification, ce qui en fait plus probablement un concept fiable plutôt qu'une caractéristique intermédiaire immature. Nous avons également conçu des expériences pour vérifier cette propriété et avons constaté que les concepts modélisés par les réseaux de neurones ont tendance à avoir des propriétés de classification plus élevées.

Pour résumer, les quatre aspects ci-dessus montrent que dans la plupart des cas, la représentation des réseaux de neurones est claire, clairsemée et symbolique. Bien entendu, les réseaux de neurones ne sont pas toujours capables de modéliser des concepts aussi clairs et symboliques. Dans quelques cas extrêmes, les réseaux de neurones ne peuvent pas apprendre des concepts clairsemés et transférables. Pour plus de détails, veuillez consulter notre article [2 ].

De plus, nous exploitons cette interaction pour expliquer les grands modèles [22].

L'importance de la représentation symbolique des réseaux de neurones dans l'interprétabilité des réseaux de neurones

1 Du point de vue du développement du domaine de l'interprétabilité, l'importance la plus directe est de trouver une certaine base pour « expliquer les réseaux de neurones ». au niveau conceptuel". Si la représentation du réseau neuronal lui-même n'est pas symbolique, alors l'explication du réseau neuronal à partir du niveau conceptuel symbolique ne peut qu'effleurer la surface, et les résultats de l'explication doivent être spécieux et ne peuvent pas déduire de manière substantielle le développement ultérieur de profondes connaissances. apprentissage.

2. À partir de 2021, nous construirons progressivement un système théorique basé sur l'interaction ludique. Il s'avère que, sur la base de l'interaction de jeu, nous pouvons expliquer uniformément deux questions fondamentales : « Comment quantifier les connaissances modélisées par les réseaux de neurones » et « Comment expliquer la capacité de représentation des réseaux de neurones ». Dans le sens de « comment quantifier les connaissances modélisées par les réseaux de neurones », en plus des deux travaux mentionnés dans cet article, les travaux préliminaires du groupe de recherche se sont basés sur des indicateurs de concept d'interaction de jeu pour définir la valeur de référence optimale de la valeur de Shapley [ 13] , et explorez le « concept visuel prototype » et son « esthétique » modélisée par le réseau neuronal visuel [7,8].

3. Dans le sens de « comment expliquer la capacité de représentation des réseaux de neurones », l'équipe de recherche a prouvé le goulot d'étranglement des réseaux de neurones dans la représentation de différentes interactions [6] et a étudié comment les réseaux de neurones déterminent les capacités de représentation des réseaux de neurones. réseaux à travers les concepts d'interaction qu'ils modélisent. Sa généralisation [12, 19], étudiant la relation entre les concepts interactifs modélisés par les réseaux de neurones et leur robustesse et transférabilité contradictoires [9, 10, 11, 20], prouve que les réseaux de neurones bayésiens sont plus difficile à construire. Modéliser des concepts d’interaction complexes [21].

Pour en savoir plus, veuillez vous référer à :

https://zhuanlan.zhihu.com/p/264871522/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Master SQL Limit Clause: Contrôlez le nombre de lignes dans une requête

Apr 08, 2025 pm 07:00 PM

Master SQL Limit Clause: Contrôlez le nombre de lignes dans une requête

Apr 08, 2025 pm 07:00 PM

Clause SQLLIMIT: Contrôlez le nombre de lignes dans les résultats de la requête. La clause limite dans SQL est utilisée pour limiter le nombre de lignes renvoyées par la requête. Ceci est très utile lors du traitement de grands ensembles de données, des affichages paginés et des données de test, et peut améliorer efficacement l'efficacité de la requête. Syntaxe de base de la syntaxe: selectColumn1, Column2, ... FromTable_NamelimitNumber_Of_Rows; Number_OF_ROWS: Spécifiez le nombre de lignes renvoyées. Syntaxe avec décalage: selectColumn1, Column2, ... FromTable_Namelimitoffset, numéro_of_rows; décalage: sauter

Méthode de Navicat pour afficher le mot de passe de la base de données MongoDB

Apr 08, 2025 pm 09:39 PM

Méthode de Navicat pour afficher le mot de passe de la base de données MongoDB

Apr 08, 2025 pm 09:39 PM

Il est impossible de visualiser le mot de passe MongoDB directement via NAVICAT car il est stocké sous forme de valeurs de hachage. Comment récupérer les mots de passe perdus: 1. Réinitialiser les mots de passe; 2. Vérifiez les fichiers de configuration (peut contenir des valeurs de hachage); 3. Vérifiez les codes (May Code Hardcode).

Comment rédiger le dernier tutoriel sur la déclaration d'insertion SQL

Apr 09, 2025 pm 01:48 PM

Comment rédiger le dernier tutoriel sur la déclaration d'insertion SQL

Apr 09, 2025 pm 01:48 PM

L'instruction INSERT SQL est utilisée pour ajouter de nouvelles lignes à une table de base de données, et sa syntaxe est: Insérer dans Table_Name (Column1, Column2, ..., Columnn) VALEUR (VALEUR1, Value2, ..., Valuen);. Cette instruction prend en charge l'insertion de plusieurs valeurs et permet d'insérer des valeurs nulles dans des colonnes, mais il est nécessaire de s'assurer que les valeurs insérées sont compatibles avec le type de données de la colonne pour éviter de violer les contraintes d'unicité.

Master la clause Order Order by dans SQL: Trier efficacement les données

Apr 08, 2025 pm 07:03 PM

Master la clause Order Order by dans SQL: Trier efficacement les données

Apr 08, 2025 pm 07:03 PM

Explication détaillée de la clause SqlorderBy: le tri efficace de la clause de données d'ordre de données est une déclaration clé de SQL utilisée pour trier les ensembles de résultats de requête. Il peut être organisé en ordre ascendant (ASC) ou ordre décroissant (DESC) dans des colonnes uniques ou plusieurs colonnes, améliorant considérablement la lisibilité des données et l'efficacité de l'analyse. OrderBy Syntax selectColumn1, Column2, ... FromTable_NameOrderByColumn_Name [ASC | DESC]; Column_name: Triez par colonne. ASC: Ascendance Order Sort (par défaut). DESC: Trier en ordre décroissant. ORDERBY Fonctionnalités principales: Tri multi-colonnes: prend en charge le tri de plusieurs colonnes et l'ordre des colonnes détermine la priorité du tri. depuis

Navicat se connecte au code et à la solution d'erreur de base de données

Apr 08, 2025 pm 11:06 PM

Navicat se connecte au code et à la solution d'erreur de base de données

Apr 08, 2025 pm 11:06 PM

Erreurs et solutions courantes Lors de la connexion aux bases de données: nom d'utilisateur ou mot de passe (erreur 1045) Blocs de pare-feu Connexion (erreur 2003) Délai de connexion (erreur 10060) Impossible d'utiliser la connexion à socket (erreur 1042) Erreur de connexion SSL (erreur 10055) Trop de connexions Résultat de l'hôte étant bloqué (erreur 1129)

Navicat Connection Timeout: Comment résoudre

Apr 08, 2025 pm 11:03 PM

Navicat Connection Timeout: Comment résoudre

Apr 08, 2025 pm 11:03 PM

Raisons du délai d'expiration de la connexion NAVICAT: instabilité du réseau, base de données animée, blocage du pare-feu, problèmes de configuration du serveur et paramètres NAVICAT inappropriés. Étapes de la solution: Vérifiez la connexion réseau, l'état de la base de données, les paramètres du pare-feu, ajustez la configuration du serveur, vérifiez les paramètres NAVICAT, redémarrez le logiciel et le serveur et contactez l'administrateur pour obtenir de l'aide.

Comment ajouter une nouvelle colonne dans SQL

Apr 09, 2025 pm 02:09 PM

Comment ajouter une nouvelle colonne dans SQL

Apr 09, 2025 pm 02:09 PM

Ajoutez de nouvelles colonnes à une table existante dans SQL en utilisant l'instruction ALTER TABLE. Les étapes spécifiques comprennent: la détermination des informations du nom de la table et de la colonne, rédaction des instructions de la table ALTER et exécution des instructions. Par exemple, ajoutez une colonne de messagerie à la table des clients (VARCHAR (50)): Alter Table Clients Ajouter un e-mail VARCHAR (50);

Comment afficher le mot de passe de la base de données dans Navicat pour MongoDB?

Apr 08, 2025 pm 09:21 PM

Comment afficher le mot de passe de la base de données dans Navicat pour MongoDB?

Apr 08, 2025 pm 09:21 PM

Navicat pour MongoDB ne peut pas afficher le mot de passe de la base de données car le mot de passe est crypté et contient uniquement des informations de connexion. La récupération de mots de passe nécessite MongoDB lui-même et l'opération spécifique dépend de la méthode de déploiement. Sécurité d'abord, développez de bonnes habitudes de mot de passe et n'essayez jamais d'obtenir des mots de passe à partir d'outils tiers pour éviter les risques de sécurité.