Dans le domaine informatique, le mot d'invite (Prompt) fait référence à la première chaîne orientée vers la gauche avant la sortie de l'algorithme. Par exemple, les premiers C:> sous MSDOS, ~: sous Linux et >>> sous IPython sont tous des mots d'invite. En 2023, les mots d’invite sont devenus le moyen le plus naturel et le plus intuitif d’interagir avec des modèles linguistiques à grande échelle (LLM).

Si ChatGPT est comparé à la magie magnifique des romans de Harry Potter, alors les mots d'invite sont comme les incantations lors de l'invocation de la magie. Que vous puissiez bien utiliser cette magie dépend de si vous récitez le sort clairement ou avec un "accent". Pour la même magie, différentes personnes chantent le sort, et le pouvoir est différent. On dit qu'il existe mille Hamlets pour mille lecteurs, mais la malédiction Avada Kedavra de mille sorciers n'est pas aussi efficace que le chant de Voldemort seul (bien sûr, peu importe la qualité du chant de Voldemort, il n'est pas aussi efficace que celui de Harry). ).

Donc, votre capacité à faire bon usage de ChatGPT et des modèles linguistiques à grande échelle dépend en grande partie de la qualité de vos mots d'invite. En fait, non seulement les modèles de langage, y compris les modèles de génération de texte en image IA tels que DALL·E et Stable Diffusion, qui étaient très populaires il y a quelques mois, les mots d'invite ont également un grand impact sur le style et la qualité de leur génération. art.

(C'est aussi un burger, et c'est aussi un modèle Stable Diffusion 2.1. Même si le mot invite dans le burger à gauche est "Trending on Artstation", ce n'est pas appétissant. Alors voici le problème, celui de droite Pouvez-vous deviner quel est le mot d'invite ? )

Mais quand il s'agit du mot d'invite, il est inévitable que les gens l'adorent et le détestent. Les gens qui l’aiment y voient une fusion de technologie et d’art, tandis que ceux qui le détestent y voient une pierre d’achoppement qui entrave l’avancement de l’apprentissage automatique et de l’IA. Le fondateur de

Sam Altman estime que Prompt Engineering est une technologie noire qui utilise la programmation en langage naturel et constitue sans aucun doute une compétence à haut rendement. Il existe de nombreuses astuces sur Internet et sur les forums qui les collectent, les organisent et même les vendent à des prix élevés et offrent des récompenses. De nombreuses personnes considèrent les mots rapides comme le code source de l'AIGC à cette époque, et des cours en ligne correspondants ont commencé à émerger.

En conséquence, le célèbre géant du deep learning Yann LeCun estime que l'existence de l'ingénierie des mots rapides est due au manque de compréhension des LLM du monde réel. Il estime que le besoin de mots rapides dans les LLM n'est qu'un état temporaire, ce qui montre simplement qu'il y a encore beaucoup de place à l'amélioration dans les LLM actuels. Grâce à l'innovation continue de la technologie des LLM, les LLM auront bientôt la capacité de comprendre le monde réel, et d'ici là, le mot projet perdra de sa valeur.

Le futur est trop loin, mais objectivement parlant du développement actuel du LLM, l'existence de mots prompts a une certaine signification. Tout comme l'interaction entre les personnes dans le monde réel nécessite certaines compétences de communication, Vous pouvez également considérer les mots rapides comme des compétences de communication lorsque les gens interagissent avec des machines . De bons mots rapides peuvent vous aider à obtenir de meilleurs résultats lorsque vous utilisez les LLM, tout comme dans le monde réel, les personnes qui s'expriment bien et s'expriment bien peuvent souvent se coordonner pour faire le travail plus rapidement.

Bien qu'en 2023, le langage naturel soit devenu un moyen de communication unifié entre les personnes, et entre les personnes et les machines, communiquer avec les machines LLM est toujours plus difficile que de parler avec les gens. Premièrement, les LLM ne peuvent pas comprendre les nuances, le ton ou le contexte de la même manière que les humains, ce qui signifie que les mots indicateurs doivent être soigneusement conçus pour les rendre sans ambiguïté et facilement compris par le modèle. Vous pouvez imaginer que vous avez beaucoup discuté avec LLM, puis LLM a répondu froidement : « Parlez comme un être humain ». Deuxièmement, en raison des limites du corpus de formation, les LLM peuvent avoir certaines limites dans la compréhension du langage. Certaines expressions logiques longues, l'élaboration, l'inversion et même le raisonnement et l'induction simples dans le monde réel ne peuvent pas être parfaitement comprises et exécutées dans les LLM. Et certains mots de code dans les LLM sont générés à partir du corpus de formation (comme les plus célèbres « Pensons étape par étape / Pensons étape par étape » et « Ci-dessous est mon meilleur coup / Ci-dessous est ma meilleure prédiction » en GPT). pas courant dans la communication quotidienne entre les gens. Celles-ci ont encore compliqué le projet de mot d'invite et l'ont promu au rang de ce qu'on appelle la « métaphysique ».

Pour les utilisateurs chinois dont la langue maternelle n'est pas l'anglais, les mots rapides sont également le plus gros problème qui les empêche d'essayer les LLM. En regardant l'été 2022, lorsque Midjourney et Stable Diffusion étaient à leur apogée sur le marché anglais, la réponse de la communauté nationale n'a pas été enthousiaste. La raison en est que les mots d'invite de Midjourney et Stable Diffusion sont principalement en anglais, ce qui nécessite une grande quantité de vocabulaire et de réserves de culture pop lors de la construction. Ceci est extrêmement peu convivial pour les utilisateurs chinois qui souhaitent essayer de nouvelles choses. Une partie de la raison pour laquelle ChatGPT est populaire dans la communauté chinoise est due à sa bonne prise en charge en chinois, ce qui abaisse considérablement le seuil pour les utilisateurs chinois. Le chinois, en tant que l'une des langues les plus parlées au monde, est toujours gêné par les mots rapides ; on ne peut désormais qu'imaginer à quel point c'est difficile pour les petites langues.

En bref, l'existence d'un projet de mots rapides a sa rationalité. Un bon mot de rappel peut en effet apporter deux fois plus de résultat avec moitié moins d'effort. De bons mots d'invite peuvent nous aider à comprendre les capacités et les limites des grands modèles de langage, à explorer en profondeur son potentiel et à mieux jouer son rôle dans les pratiques de production. L'exemple le plus célèbre est Context learning (In-context learning).

En réalité, le processus d'optimisation des mots d'invite nécessite des itérations répétées d'essais et d'erreurs, ce qui est extrêmement fastidieux et nécessite également une certaine réserve de connaissances ; Cela amène les gens à se demander : à l’ère actuelle de l’IA, les mots d’invite peuvent-ils être générés automatiquement ?

Dans la réponse au tweet de Yann LeCun critiquant les mots prompts, nous avons remarqué cette réponse : « L'ingénierie des mots prompts est comme la description et la définition d'un problème en science ; le même problème est décrit par différentes personnes, bonnes ou mauvaises, ; facile ou difficile, résoluble ou insoluble. Par conséquent, il n'y a rien de mal à l'existence du projet de mot d'invite, et le projet de mot d'invite lui-même peut également être automatisé." Cet internaute a également donné un produit : "La plus belle invite mots" (PromptPerfect.jina.ai). En d'autres termes, ce nouveau paradigme consistant à utiliser des algorithmes pour optimiser les mots rapides a été mis en œuvre avec succès !

Lien d'expérience : https://promptperfect.jina.ai

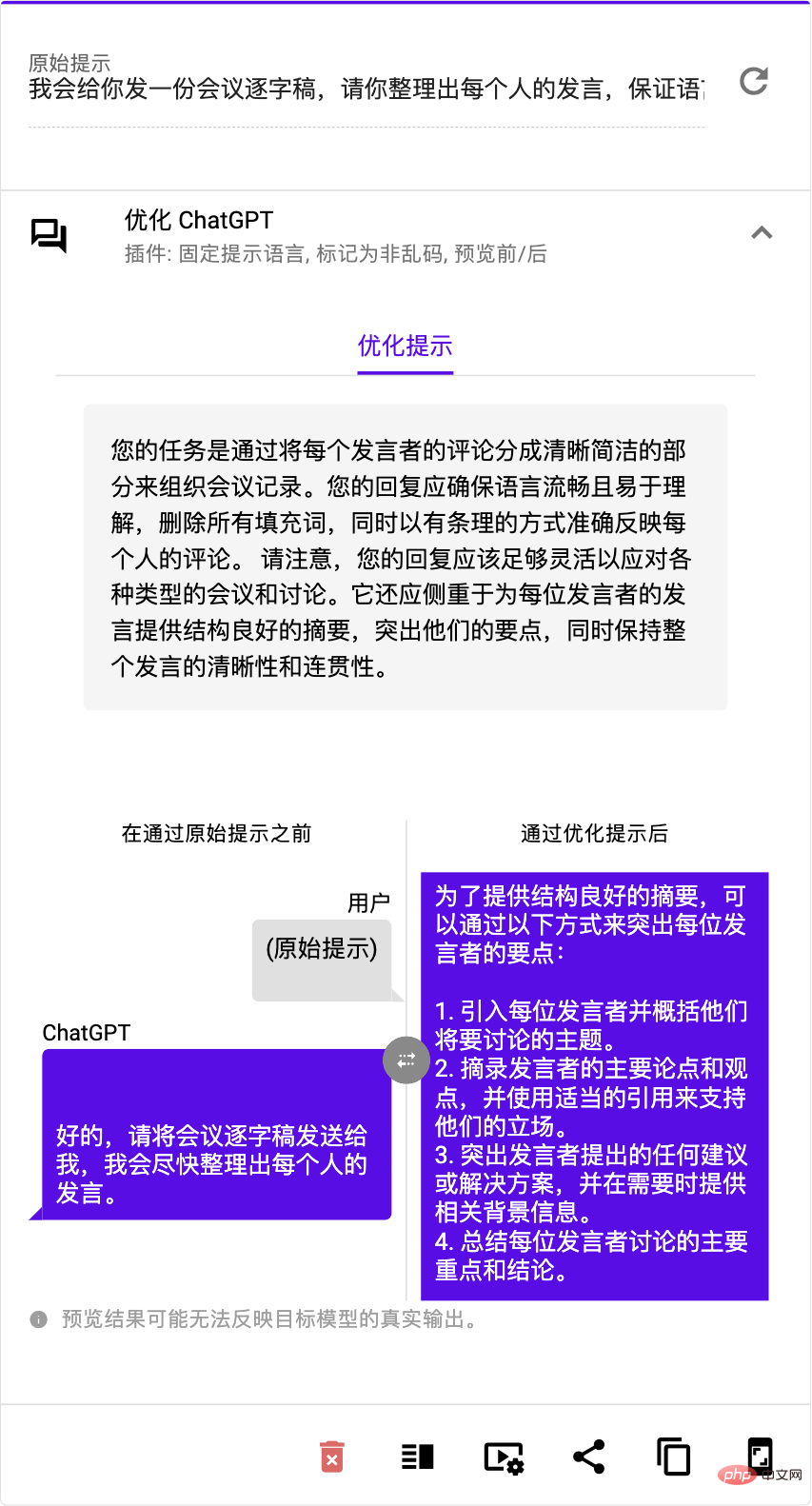

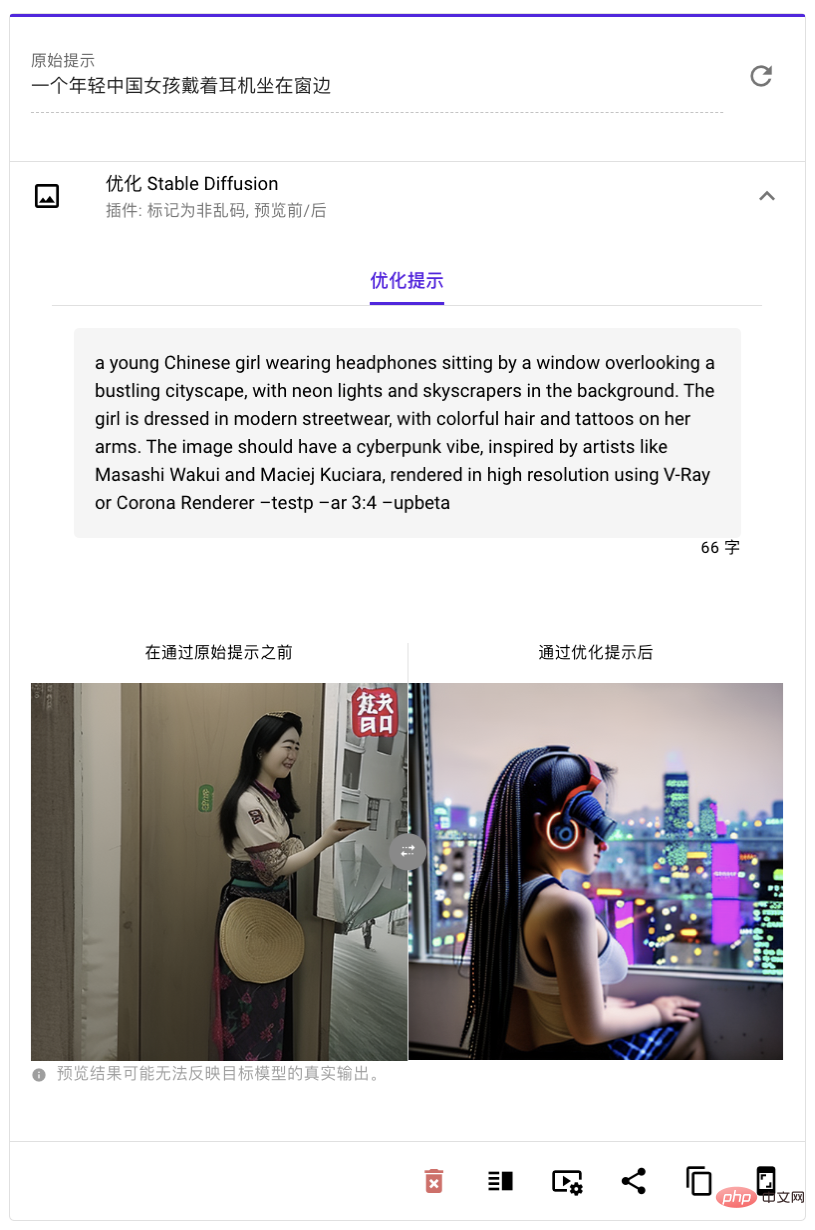

promptperfect.jina.ai mentionné dans cette réponse utilise la magie pour apprivoiser la magie et laisser l'IA guider l'IA après votre entrée. le mot d'invite, il affichera le « plus beau mot d'invite » optimisé et vous permettra de prévisualiser la sortie du modèle avant et après l'optimisation. Cela permet d'obtenir un cycle vertueux allant de "garbage-(invite)-in-garbage-(content)-out" à "bonne entrée - bonne sortie". Selon la documentation officielle du produit, il prend non seulement en charge l'optimisation des mots d'invite ChatGPT la plus populaire, mais prend également en charge GPT 3, Stable Diffusion et Dall-E. Ensuite, évaluons la technologie et les compétences de cet "AI Prompt Word Engineer" - PromptPerfect.

1. Transformez les exigences linguistiques parlées en mots rapides clairs et cohérents

Optimiser les mots rapides nécessite de comprendre la structure du langage et de savoir quelles phrases et quels mots peuvent « activer » l'intelligence des LLM. Sans ces réserves, les mots d'invite ne sont pas clairs et la langue parlée est en désordre, il est alors facile de se laisser induire en erreur par LLM. "Les plus beaux mots d'invite" peuvent apprendre à partir de données massives et comprendre en profondeur des connaissances linguistiques plus approfondies pour produire des mots d'invite plus précis, clairs et efficaces. Quels que soient le type de besoins et de tâches que vous souhaitez, ils peuvent être directement personnalisés Personnalisé pour. fournir l’expression la plus précise.

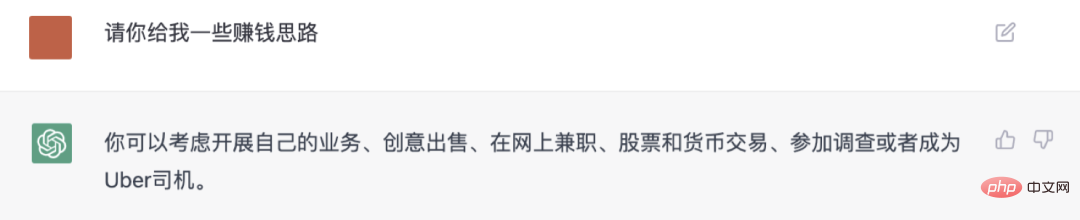

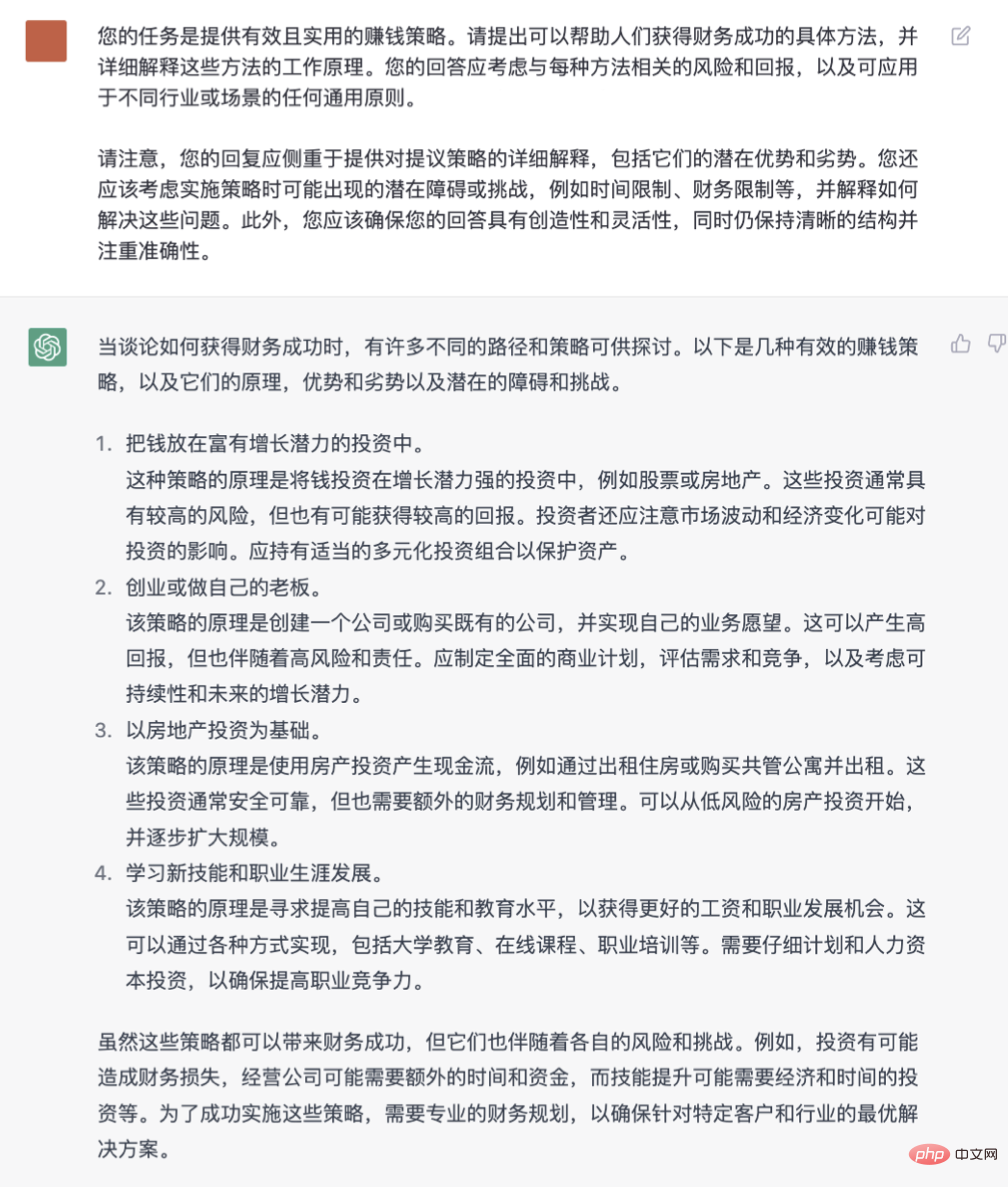

Lorsque vous faites face à GPT3 ou ChatGPT, le mot d'invite bloqué peut être dû à une capacité de communication limitée et à une difficulté à exprimer des questions ou des instructions claires, ce qui affecte sérieusement la qualité de la réponse du modèle. Nous essayons d'utiliser "Le plus beau mot d'invite" pour optimiser certaines instructions courantes, comme indiqué ci-dessous. "Le plus beau mot d'invite" élargit le contexte du mot d'invite original simple et approximatif "Veuillez m'envoyer des idées pour gagner de l'argent" et affiche un message parfait.

Utilisez les "plus beaux mots de rappel" s'appuyer sur la technologie

Photo Par rapport aux mots d'invite d'origine, les "plus beaux mots d'invite"

, rendant les mesures générées par ChatGPT plus pratique et efficace Il a en effet été grandement amélioré visiblement à l'œil nu.

2. Maîtrisez facilement les « compétences orales » des différents LLM/LM

Différents LLM ont des tempéraments et des habitudes différents. Si vous souhaitez communiquer efficacement avec eux, vous devez acquérir les compétences orales locales. Sinon, il sera facile d’entamer une conversation poulet-canard. C'est comme lorsque vous maîtrisiez enfin le sort de diffusion stable, pour découvrir que la méthode de conversation de ChatGPT est complètement différente et que vous deviez tout recommencer. "Les plus beaux mots d'invite" aident les utilisateurs à éviter le coût d'apprentissage de différents modèles, qu'il s'agisse de ChatGPT, GPT 3, Stable Diffusion ou Dall·E, etc.

Différents LLM ont des tempéraments et des habitudes différents. Si vous souhaitez communiquer efficacement avec eux, vous devez acquérir les compétences orales locales. Sinon, il sera facile d’entamer une conversation poulet-canard. C'est comme lorsque vous maîtrisiez enfin le sort de diffusion stable, pour découvrir que la méthode de conversation de ChatGPT est complètement différente et que vous deviez tout recommencer. "Les plus beaux mots d'invite" aident les utilisateurs à éviter le coût d'apprentissage de différents modèles, qu'il s'agisse de ChatGPT, GPT 3, Stable Diffusion ou Dall·E, etc.

3. Optimisation en un clic des mots d'invite chinois pour générer des mots d'invite en anglais parfaits

Par rapport au ChatGPT monomodal, dans le domaine de la peinture par IA, c'est difficile de bien parler anglais. Même si vous avez un tas de mots de rappel, vous pourriez toujours être frustré parce que vous n'avez pas assez de vocabulaire, que vous ne savez pas comment le décrire et que vous ne trouvez pas les bons mots de rappel. "Les plus beaux mots rapides" peuvent transformer directement les mots rapides auxquels vous pensez en chinois en mots rapides anglais

, ce qui les rend plus faciles à utiliser et plus efficaces. Vous n'avez pas à travailler dur pour apprendre. divers adjectifs anglais les utilisateurs chinois peuvent également démarrer facilement. Parfois, lorsque nous utilisons DALL・E ou Stable Diffusion pour générer des images, nous avons du mal à obtenir de bons résultats. Cela peut être dû au fait que notre anglais n’est pas assez bon ou que notre imagination n’est pas assez riche pour proposer des images ou des scènes spécifiques. Donc les images qui sortent sont floues ou bizarres. Nous essayons d'utiliser le « Le plus beau mot d'invite » pour optimiser certaines commandes courantes. Par exemple, dans l'image ci-dessous, le « Le plus beau mot d'invite » transforme la « Scène de rue impressionniste de Pékin » originale, simple, rugueuse et légèrement ennuyeuse. une phrase avec une description riche, un anglais super génial ! Les mots rapides pour l'impressionnisme, les écouteurs et le style futur ne peuvent pas être affichés du tout. C'est plus clair quand tests, le " Le plus beau mot d'invite" génère un "sort" long mais extrêmement précis, qui améliore directement l'esthétique, l'imagination et l'expérience du mot d'invite original, rendant l'image plus vivante et exprimant plus précisément nos attentes initiales.  4. API que les développeurs peuvent appeler directement

4. API que les développeurs peuvent appeler directement

Si vous souhaitez optimiser les mots d'invite en grande quantité ou les intégrer directement dans le système existant, alors

Si vous souhaitez optimiser les mots d'invite en grande quantité ou les intégrer directement dans le système existant, alors

vous pouvez directement appeler la "plus belle invite "words", afin que des lots de mots d'invite de haute qualité puissent être générés plus rapidement

La technologie et l'équipe derrière elle

Nous avons remarqué que "The Most Beautiful Prompt Word" a attiré beaucoup d'attention depuis son lancement le 28 février, et tout le monde veut l'utiliser pour optimiser divers scénarios . mot rapide. En seulementquelques jours , il a attiré

des milliers d'utilisateurs optimisé près de 10 000 mots d'invite et a reçu de nombreux éloges sur diverses plateformes. Après tout, tant que les mots d'invite qu'il génère sont utilisés, les objets produits par le grand modèle peuvent être à la fois créatifs et beaux. "Les plus beaux mots d'invite" pour trouver les meilleurs mots d'invite pour différents modèles de langage, il utilise deux technologies avancées d'apprentissage automatique :

Apprentissage par renforcement et apprentissage contextuel

L'apprentissage contextuel est son professeur, lui apprenant à apprendre à travers de multiples exemples. Mais au lieu d’empiler tous les exemples, il divise de nombreux exemples en plusieurs groupes, puis laisse le modèle de langage les coder lui-même. De cette façon, les « plus beaux mots d'invite » peuvent utiliser davantage d'exemples pour enseigner le modèle, générant ainsi des mots d'invite plus précis et plus efficaces. En utilisant ces deux astuces, « Les plus beaux mots d'invite » peut optimiser les mots d'invite pour différents modèles de langage, améliorant ainsi considérablement l'efficacité et la précision, tout comme un athlète de haut niveau entraîné par des entraîneurs et des enseignants. Ce type de modèle génératif à grande échelle, qu'il s'agisse d'un modèle de génération de langage ou d'un modèle génératif multimodal, est actuellement basé sur le langage. Cependant, à l’avenir, nous verrons certainement l’émergence de modèles génératifs plus multimodaux. Nous avons découvert que l'équipe R&D de « The Most Beautiful Prompt Word » est en fait Jina AI, une entreprise de technologie émergente axée sur l'IA multimodale. Elle a été fondée en 2020 et a son siège à Berlin, en Allemagne, avec des installations de R&D à Berlin. Pékin et Shenzhen. Jina AI se concentre sur la recherche et le développement de la technologie d'IA multimodale et est largement utilisée dans les domaines de la recherche et de la génération. Auparavant, Jina AI a publié une série de projets open source comme suit et a reçu un total de près de 40 000 étoiles. sur GitHub par des développeurs du monde entier. Suivez, permettant aux développeurs de mettre en œuvre rapidement des applications d'IA multimodales :

Dans cette époque où l'IA générative franchit de multiples barrières modales comme un tsunami, les « plus beaux mots d'invite » peuvent directement améliorer la productivité des grands modèles et apporter des améliorations significatives en termes d'efficacité. Nous avons également remarqué que Jina. AI a également développé With Rational (rationale.jina.ai), un outil d'aide à la décision basé sur ChatGPT, il vous suffit de saisir une ou plusieurs décisions dans votre esprit, et Rational générera pour vous un rapport exclusif d'évaluation des décisions dans les 10 heures. secondes. Il peut être utilisé dans le cadre de consultations, d’évaluations, de recherches, de planifications, de rapports et d’autres scénarios pour améliorer l’efficacité de la prise de décision. En tant qu'outil d'aide à la décision d'intelligence artificielle doté d'une « pensée critique », Rational peut élargir votre réflexion, affiner vos opinions et prendre des décisions rationnelles en vous aidant à lister les avantages et les inconvénients de différentes décisions, à générer des rapports SWOT, à effectuer des analyses multicritères ou analyse de cause à effet, etc. prise de décision. 2023 pourrait être une année révolutionnaire pour les startups. Avec l'ouverture de l'API ChatGPT, les applications d'IA pour le côté C en 2023 seront comme 2000 Tout comme à l'ère d'Internet, il y a eu une énorme explosion : des centaines d'applications API ChatGPT sont lancées chaque jour, et elles sont réparties dans divers domaines, brisant les règles existantes et bouleversant l'écologie de nombreux domaines. Certains géants traditionnels sont confrontés à des défis, certaines barrières traditionnelles sont sur le point de s'effondrer et certaines industries traditionnelles sont confrontées à l'innovation. Pour nous, si nous voulons prendre pied dans la nouvelle ère de l'IA, nous devons nous tenir sur les épaules de géants, chanter le sort parfait et utiliser la magie pour résoudre diverses tâches de génération

Après tout, le mot d'invite parfait. n'est qu'une des applications L'âme de ChatGPT.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!