Périphériques technologiques

Périphériques technologiques

IA

IA

AIGC se développe trop vite ! Meta lance le premier synthétiseur vidéo 4D textuel : les modélisateurs de jeux 3D seront-ils également licenciés ?

AIGC se développe trop vite ! Meta lance le premier synthétiseur vidéo 4D textuel : les modélisateurs de jeux 3D seront-ils également licenciés ?

AIGC se développe trop vite ! Meta lance le premier synthétiseur vidéo 4D textuel : les modélisateurs de jeux 3D seront-ils également licenciés ?

Les modèles de génération

IA ont fait d'énormes progrès au cours de la période écoulée. En ce qui concerne le domaine image, les utilisateurs peuvent générer des images en saisissant des invites en langage naturel (telles que DALL-E 2, Stable Diffusion) ou dans la dimension temporelle. . Développez pour générer des vidéos continues (comme Phenaki), ou développez dans la dimension spatiale pour générer directement des modèles 3D (comme Dreamfusion).

Mais jusqu'à présent, ces tâches sont encore dans un état de recherche isolé, et il n'y a pas d'intersection technique les unes avec les autres.

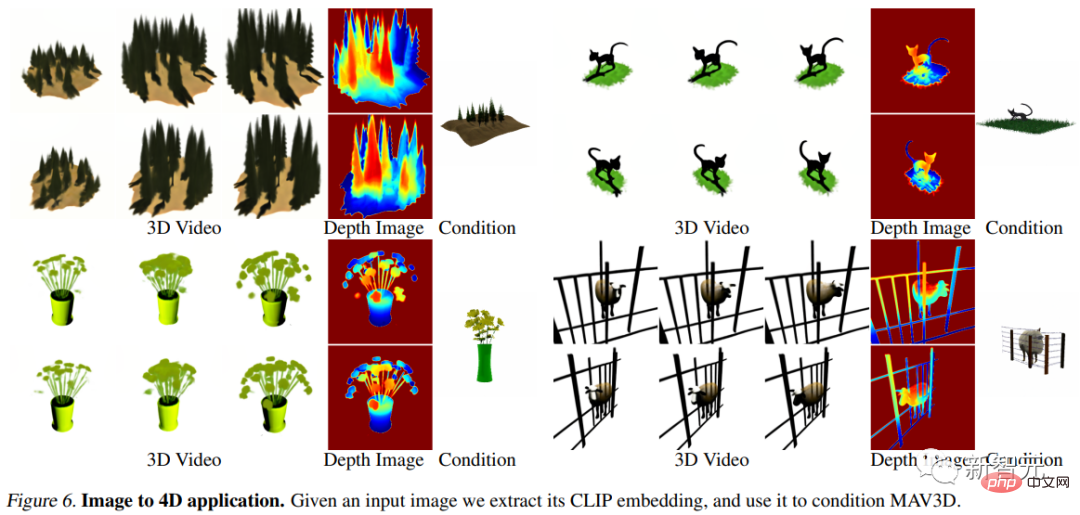

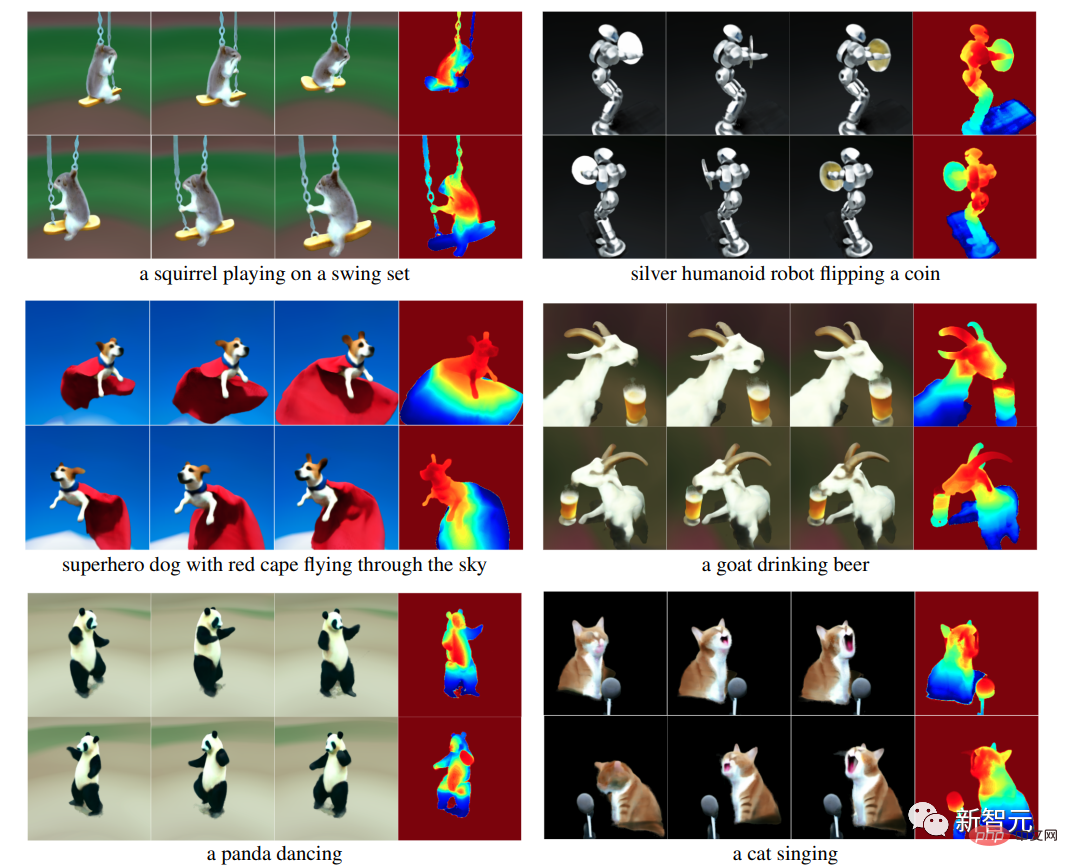

Récemment, des chercheurs de Meta AI ont combiné les avantages des modèles génératifs vidéo et 3D et ont proposé un tout nouveau système de génération de texte en quatre dimensions (3D + temps) MAV3D (MakeA-Video3D), qui prend la description en langage naturel comme input et génère une représentation de scène dynamique en trois dimensions qui peut être rendue depuis n'importe quelle perspective.

Lien papier : https://arxiv.org/abs/2301.11280

Lien du projet : https://make-a-video3d.github.io/

MAV3D est également le premier modèle capable de générer des scènes dynamiques tridimensionnelles basées sur des descriptions textuelles données. La méthode proposée dans cet article utilise un champ de rayonnement neuronal (NeRF) dynamique 4D pour optimiser la représentation de la scène, la densité et la cohérence du mouvement en interrogeant un modèle basé sur la diffusion texte-vidéo (T2V) et la dynamique générée par le texte fourni La sortie vidéo peut être visualisée depuis n'importe quelle position et angle de caméra et composée dans n'importe quel environnement 3D.

Cette méthode peut être utilisée pour générer des ressources 3D pour les jeux vidéo, les effets visuels ou la réalité augmentée et virtuelle.

Différent des tâches de génération d'images et de génération de vidéos, il existe une grande quantité de données de sous-titres disponibles pour la formation sur Internet, mais il n'y a même pas de

Différent des tâches de génération d'images et de génération de vidéos, il existe une grande quantité de données de sous-titres disponibles pour la formation sur Internet, mais il n'y a même pas de

.

La formation

MAV3D ne nécessite aucune donnée 3D ou 4D, le modèle T2V doit uniquement être entraîné sur des paires texte-image et des vidéos non étiquetées. Dans la partie expérimentale, les chercheurs ont mené des expériences quantitatives et qualitatives complètes pour prouver l'efficacité de la méthode, qui a considérablement amélioré la base de référence interne précédemment établie.

Texte sur scène dynamique 4D

En raison du manque de données de formation, les chercheurs ont conçu plusieurs idées pour résoudre cette tâche.

Une approche pourrait consister à trouver un générateur vidéo 2D pré-entraîné et à extraire une reconstruction 4D de la vidéo générée. Cependant, reconstruire la forme d'objets déformables à partir de vidéos reste un problème très difficile, à savoir la

Non-Rigid Structure from Motion (NRSfM). Si vous disposez de plusieurs points de vue simultanés sur un objet, la tâche devient simple. Bien que les configurations multi-caméras soient rares dans les données du monde réel, les chercheurs pensent que les générateurs vidéo existants génèrent implicitement des modèles de points de vue arbitraires de la scène.

C'est-à-dire que le générateur vidéo peut être utilisé comme une configuration multi-caméras « statistiques » pour reconstruire la géométrie et la photométrie d'objets déformables.

C'est-à-dire que le générateur vidéo peut être utilisé comme une configuration multi-caméras « statistiques » pour reconstruire la géométrie et la photométrie d'objets déformables.

L'algorithme MAV3D y parvient en optimisant le champ de rayonnement neuronal dynamique (NeRF) et en décodant le texte d'entrée en vidéo, en échantillonnant des points de vue aléatoires autour de l'objet.

L'utilisation directe du générateur vidéo pour optimiser le NeRF dynamique n'a pas donné de résultats satisfaisants. Il reste encore plusieurs problèmes à surmonter lors du processus de mise en œuvre :

1. est nécessaire Représentation dynamique de la scène 3D

2. Une source de données pour l'apprentissage supervisé est nécessaire car il n'existe actuellement pas d'ensemble de données de paire à grande échelle (texte, 4D) pour l'apprentissage

3. être dans l'espace et étendre la résolution de la sortie dans la dimension temporelle, car la sortie 4D nécessite beaucoup de mémoire et de puissance de calcul

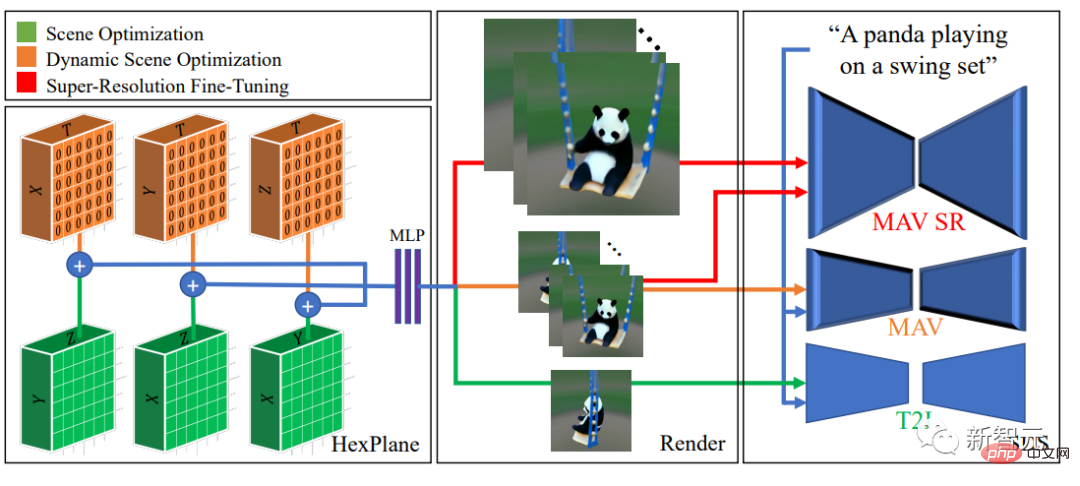

Modèle MAV3D

Le modèle MAV3D est basé sur les derniers travaux sur les champs de rayonnement neuronal (NeRF) ; , combinant des NeRF efficaces (statiques) et des résultats dans des NeRF dynamiques et représentant la scène 4D comme une collection de six plans caractéristiques multi-résolution.

Pour superviser cette représentation sans données correspondantes (texte, 4D), les chercheurs proposent un pipeline de formation en plusieurs étapes pour le rendu dynamique des scènes et démontrent l'efficacité de chaque composant pour obtenir des résultats de haute qualité.

Une observation clé est que l'optimisation directe de scènes dynamiques à l'aide du Score Distillation Sampling (SDS) à l'aide de modèles Text-to-Video (T2V) peut conduire à des artefacts visuels et à une convergence sous-optimale.

Les chercheurs ont donc choisi d'utiliser d'abord le modèle texte-image (T2I) pour faire correspondre la scène 3D statique avec des invites de texte, puis d'améliorer dynamiquement le modèle de scène 3D.

De plus, un nouveau terme de perte SDS et de régularisation de mouvement sensible au temps est introduit dans le modèle, dont il a été prouvé expérimentalement qu'il était essentiel pour un mouvement réaliste et stimulant.

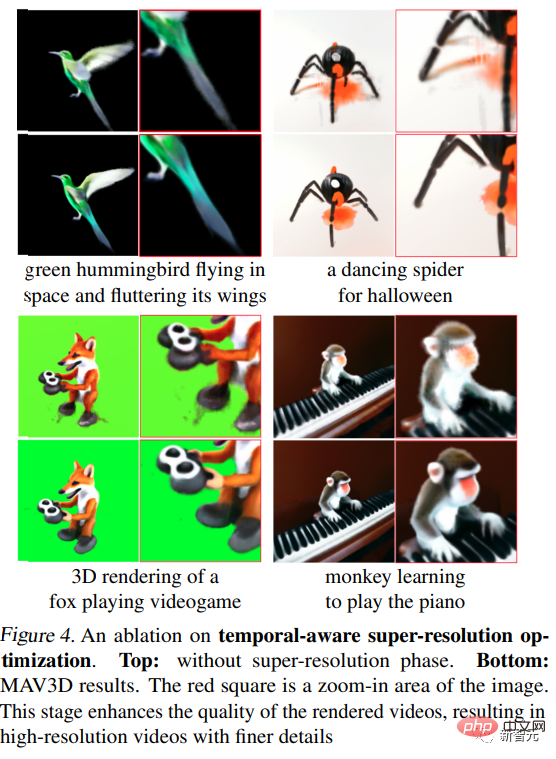

et adapté à une sortie de résolution plus élevée avec une étape supplémentaire de réglage fin de super-résolution sensible au temps.

Enfin, le SDS du module super-résolution du modèle T2V est utilisé pour obtenir des informations de gradient haute résolution pour l'apprentissage supervisé du modèle de scène 3D, augmentant sa fidélité visuelle et permettant le traitement d'images de plus haute résolution pendant le processus d’inférence. La sortie est échantillonnée.

Partie expérimentale

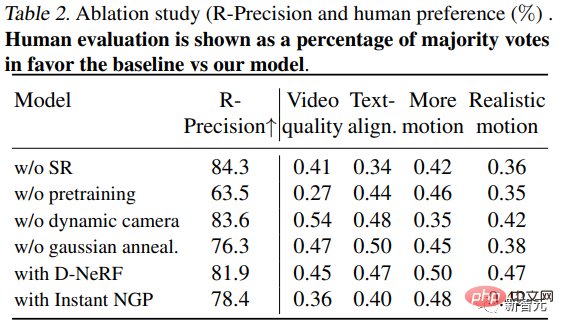

Métriques d'évaluation

Utilisez CLIP R-Precision pour évaluer la vidéo générée, qui peut être utilisée pour mesurer la cohérence entre le texte et la scène générée, et peut refléter les invites de saisie du précision de la recherche d'images rendues. Les chercheurs ont utilisé la variante ViT-B/32 de CLIP et extrait les images dans différentes vues et pas de temps.

En plus de cela, quatre métriques qualitatives sont utilisées, qui peuvent être dérivées en demandant aux annotateurs humains leurs préférences parmi les deux vidéos générées(i) la qualité de la vidéo (ii) la fidélité aux signaux textuels (iii) la quantité ; de l'exercice ; et (iv) l'authenticité de l'exercice .

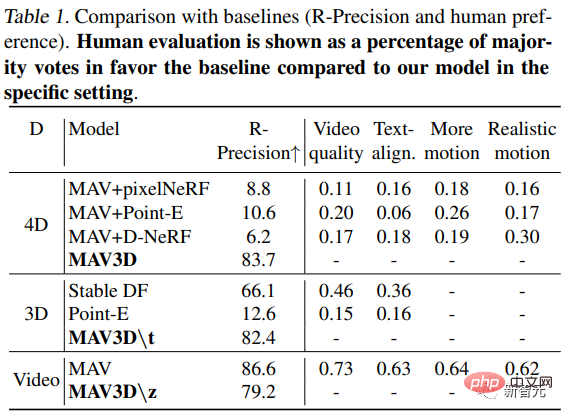

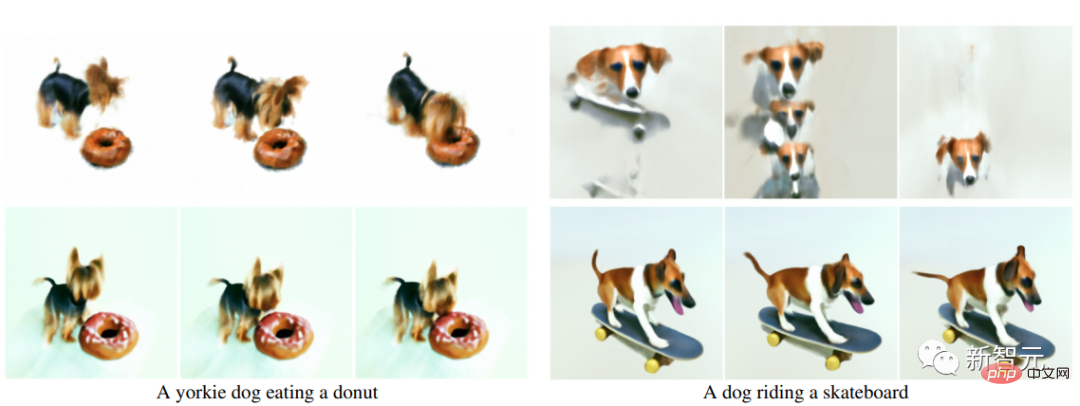

Comparaison texte en 4D

Comme il n'existait aucune méthode pour convertir du texte en 4D auparavant, les chercheurs ont établi trois lignes de base basées sur la méthode de génération T2V à des fins de comparaison. Trois méthodes différentes sont utilisées pour convertir des séquences en représentations de scènes tridimensionnelles.

La première séquence est obtenue grâce au moteur de rendu de scène neuronale one-shot (Point-E) ; la seconde est générée en appliquant pixelNeRF indépendamment à chaque image ; la troisième est générée en appliquant D-NeRF en combinaison avec la caméra COLMAP Extracted ; position.

On peut voir que la méthode dépasse le modèle de base sur la métrique objective de précision R et est mieux notée par les annotateurs humains sur toutes les métriques.

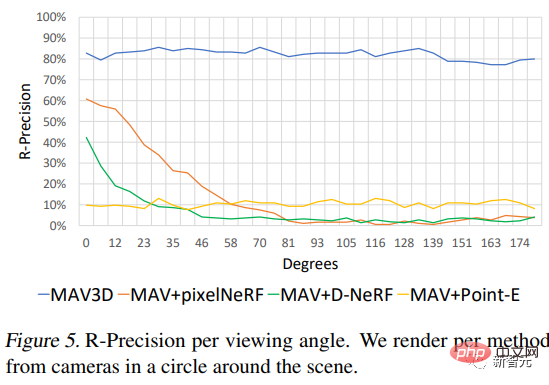

De plus, les chercheurs ont également exploré les performances de la méthode sous différents angles de vision de la caméra.

Expérience d'ablation

1. Modèle formé sans réglage fin de la super-résolution (SR) de la scène, avec le même nombre d'étapes que MAV3D (étape 3), les annotateurs humains préfèrent les modèles. formés avec SR en termes de qualité, d’alignement du texte et de mouvement.

De plus, le réglage fin de la super-résolution améliore la qualité des vidéos rendues, créant ainsi des vidéos haute résolution avec des détails plus fins et moins de bruit.

2. Pas de pré-entraînement : Lorsque les étapes d'optimisation directe des scènes dynamiques (sans pré-entraînement de scène statique) sont les mêmes que celles de MAV3D, le résultat est une qualité de scène bien inférieure ou une mauvaise convergence : 73 % et 65 % du temps, les modèles pré-entraînés en statique sont préférés en termes de qualité vidéo et de mouvement réaliste.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

MySQL peut renvoyer les données JSON. La fonction JSON_Extract extrait les valeurs de champ. Pour les requêtes complexes, envisagez d'utiliser la clause pour filtrer les données JSON, mais faites attention à son impact sur les performances. Le support de MySQL pour JSON augmente constamment, et il est recommandé de faire attention aux dernières versions et fonctionnalités.

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Une explication détaillée des attributs d'acide de base de données Les attributs acides sont un ensemble de règles pour garantir la fiabilité et la cohérence des transactions de base de données. Ils définissent comment les systèmes de bases de données gérent les transactions et garantissent l'intégrité et la précision des données même en cas de plantages système, d'interruptions d'alimentation ou de plusieurs utilisateurs d'accès simultanément. Présentation de l'attribut acide Atomicité: une transaction est considérée comme une unité indivisible. Toute pièce échoue, la transaction entière est reculée et la base de données ne conserve aucune modification. Par exemple, si un transfert bancaire est déduit d'un compte mais pas augmenté à un autre, toute l'opération est révoquée. BeginTransaction; UpdateAccountSsetBalance = Balance-100Wh

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe

MySQL ne peut pas être installé après le téléchargement

Apr 08, 2025 am 11:24 AM

MySQL ne peut pas être installé après le téléchargement

Apr 08, 2025 am 11:24 AM

Les principales raisons de la défaillance de l'installation de MySQL sont les suivantes: 1. Problèmes d'autorisation, vous devez s'exécuter en tant qu'administrateur ou utiliser la commande sudo; 2. Des dépendances sont manquantes et vous devez installer des packages de développement pertinents; 3. Conflits du port, vous devez fermer le programme qui occupe le port 3306 ou modifier le fichier de configuration; 4. Le package d'installation est corrompu, vous devez télécharger et vérifier l'intégrité; 5. La variable d'environnement est mal configurée et les variables d'environnement doivent être correctement configurées en fonction du système d'exploitation. Résolvez ces problèmes et vérifiez soigneusement chaque étape pour installer avec succès MySQL.

Laravel Eloquent Orm dans Bangla Partial Model Search)

Apr 08, 2025 pm 02:06 PM

Laravel Eloquent Orm dans Bangla Partial Model Search)

Apr 08, 2025 pm 02:06 PM

Laravelelognent Model Retrieval: Faconttement l'obtention de données de base de données Eloquentorm fournit un moyen concis et facile à comprendre pour faire fonctionner la base de données. Cet article présentera en détail diverses techniques de recherche de modèles éloquentes pour vous aider à obtenir efficacement les données de la base de données. 1. Obtenez tous les enregistrements. Utilisez la méthode All () pour obtenir tous les enregistrements dans la table de base de données: usApp \ Modèles \ Post; $ poters = post :: all (); Cela rendra une collection. Vous pouvez accéder aux données à l'aide de Foreach Loop ou d'autres méthodes de collecte: ForEach ($ PostsAs $ POST) {echo $ post->