Périphériques technologiques

Périphériques technologiques

IA

IA

Application et recherche de recherche d'industrie basée sur un modèle de langage pré-entraîné

Application et recherche de recherche d'industrie basée sur un modèle de langage pré-entraîné

Application et recherche de recherche d'industrie basée sur un modèle de langage pré-entraîné

1. Contexte de la recherche dans l'industrie du bas Elle comprend :

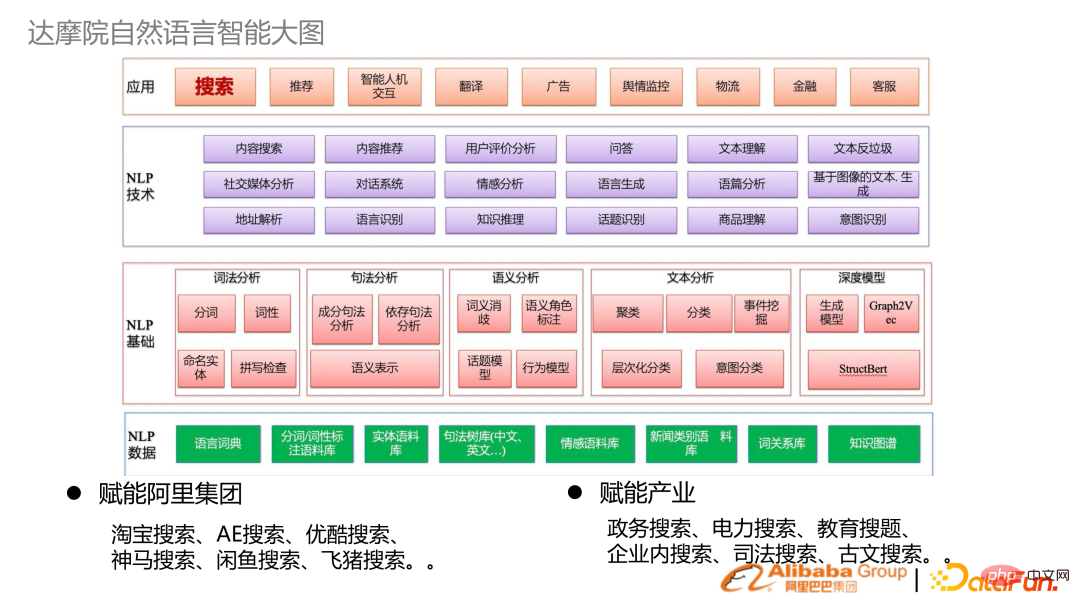

Données PNL, lexique de base de la PNL, sémantique syntaxique, technologie d'analyse et technologie PNL de niveau supérieur

Application industrielle : en plus de la recherche fondamentale, la DAMO Academy permet également à Alibaba Group, et combiné avec Alibaba Cloud pour responsabiliser les industries. De nombreux scénarios industriels d’autonomisation sont recherchés.

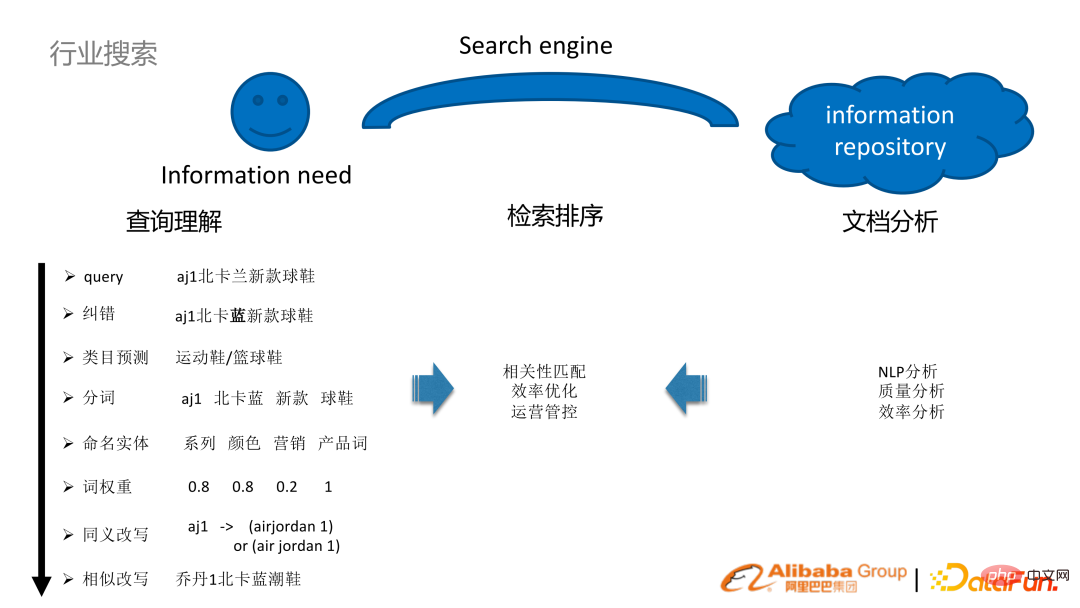

- La nature de la recherche sur l'Internet industriel et grand public est la même : les utilisateurs ont des besoins d'acquisition d'informations et disposent en même temps de bibliothèques de ressources d'information. , via les moteurs de recherche Reliez les deux.

Prenons le scénario du commerce électronique comme exemple. Par exemple, un utilisateur recherche de nouvelles baskets bleues aj1 North Carolina dans une boutique en ligne. Afin de mieux comprendre la requête d'un tel utilisateur, une série de tâches doivent être effectuées :

Analyse de la compréhension de la requête : correction d'erreurs NLP, prédiction des catégories de segmentation de mots, poids des mots de reconnaissance d'entités, réécriture de requêtes et autres technologies.

(hors ligne) analyse de documents : analyse NLP, analyse de la qualité et de l'efficacité

Récupération et tri : grâce à l'analyse des requêtes et des documents, combinée à certains mécanismes de récupération et de tri du moteur de recherche lui-même , il est possible d'atteindre l'objectif de relier les deux.

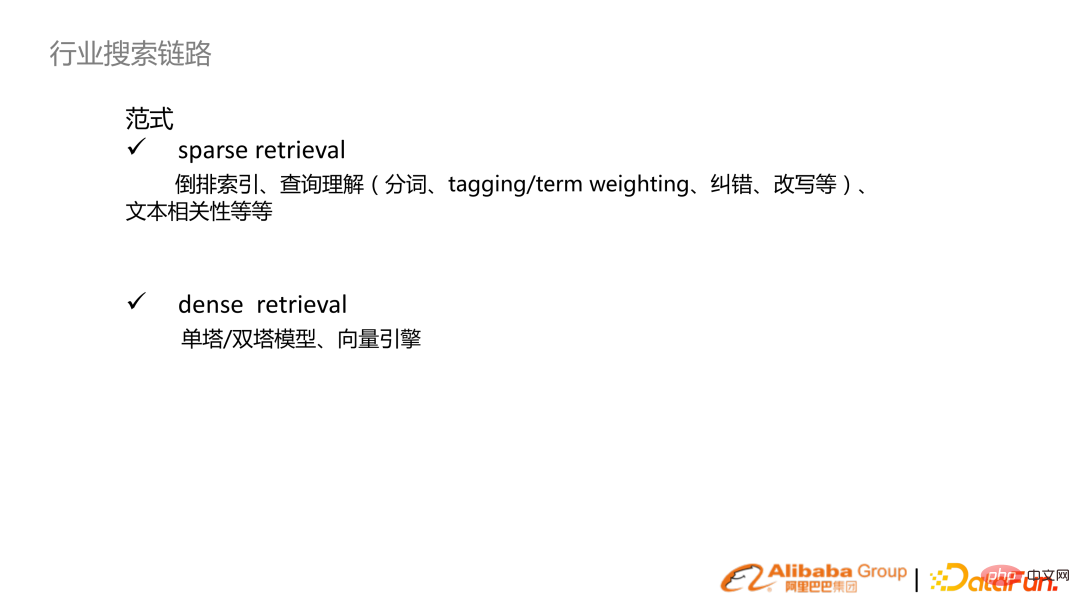

- 3. Liens de recherche de l'industrie

- S'il est divisé selon le paradigme de recherche, il est généralement divisé en récupération clairsemée et récupération dense.

récupération fragmentée : traditionnellement basée sur des mots ou basée sur des mots pour créer un index inversé, et sur cette base pour créer une série de fonctionnalités pour la compréhension des requêtes, y compris un tri par pertinence du texte, etc. ;

Récupération dense : avec l'essor des modèles de langage pré-entraînés, des modèles à tour unique et à double tour sont implémentés sur la base de la base pré-entraînée, puis combinés avec des moteurs vectoriels pour établir des mécanismes de recherche.

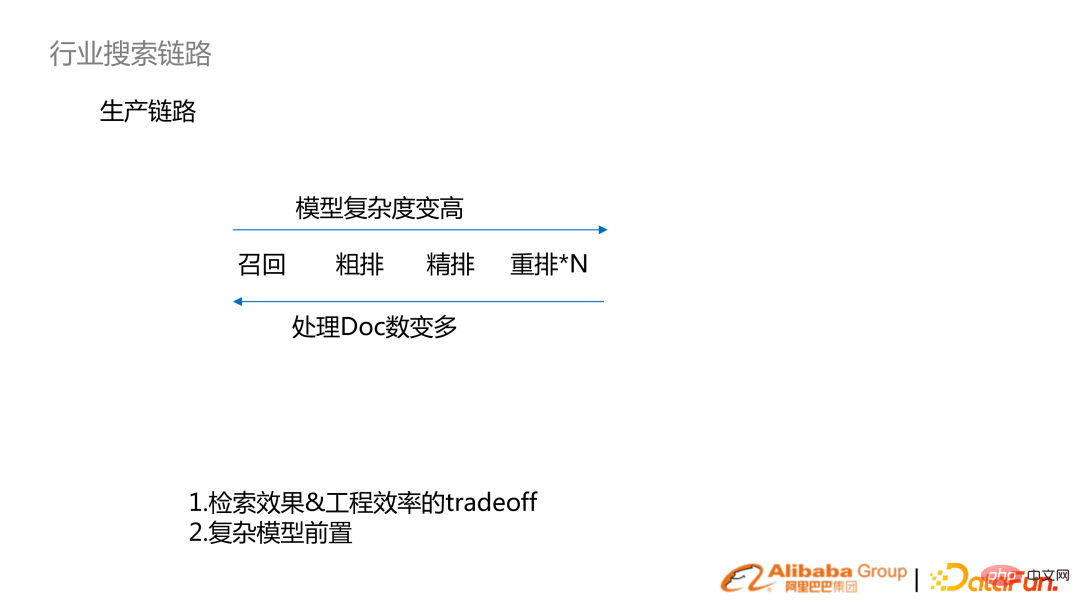

Généralement, la recherche est divisée en une telle division semblable à un lien : rappel, tri (tri grossier, tri fin, réarrangement).

- Phase de rappel : Rappel de mots clés de la récupération clairsemée traditionnelle

- De gauche à droite, la complexité du modèle et la précision des effets deviennent plus élevées. De droite à gauche, le nombre de documents traités augmente. Prenons l'exemple du commerce électronique Taobao, comme le rappel (milliards), le classement préliminaire (centaines de milliers), le classement fin (centaines, milliers) et le réarrangement (dizaines).

- La recherche de liens de production est un système où l'effet de récupération et l'efficacité de l'ingénierie sont des compromis. À mesure que la puissance de calcul augmente, les modèles complexes commencent à être remplacés. Par exemple, les modèles finement triés vont désormais progressivement passer à l’étape de tri grossier voire de rappel.

- 4. Recherche sur Internet grand public et Internet industriel

- La différence entre la recherche dans différents Scénarios industriels Il est très grand. Ici, il est divisé en recherche Internet grand public et recherche Internet industrielle :

- Groupes d'utilisateurs et UV : La recherche Internet grand public UV est très grande et l'Internet industriel s'adresse à employés au sein du gouvernement et des entreprises.

- : les exigences QPS Internet grand public seront très élevées et une grande quantité de comportement des utilisateurs sera accumulée, ce qui nécessite une analyse des journaux en temps réel et une formation de modèles en temps réel. Les exigences pour l’Internet industriel seront moindres. Direction de l'algorithme

- : L'Internet grand public bénéficiera davantage de l'analyse et de la modélisation massives du comportement des utilisateurs hors ligne, quasi-ligne et en ligne. Le comportement des utilisateurs de l'Internet industriel est clairsemé, ils accorderont donc plus d'attention à la compréhension du contenu, comme la PNL ou la compréhension visuelle, les orientations de recherche incluent l'apprentissage par transfert et à faibles ressources. 2. Recherche sur les technologies connexes

- La recherche est étroitement liée au cadre du système : y compris les données hors ligne, le cadre du service de recherche (partie verte), le système d'algorithme de technologie de recherche (partie bleue), Sa base est le système de modèle de langage pré-entraîné Alicemind, qui effectue également l'analyse de documents, la compréhension des requêtes, la corrélation, etc.

-

1. Système AliceMind

AliceMind est un système de modèle de langage hiérarchique de pré-formation construit par DAMO Academy. Contient des modèles généraux de pré-formation, multilingues, multimodaux, de dialogue, etc., et constitue la base de toutes les tâches de PNL.

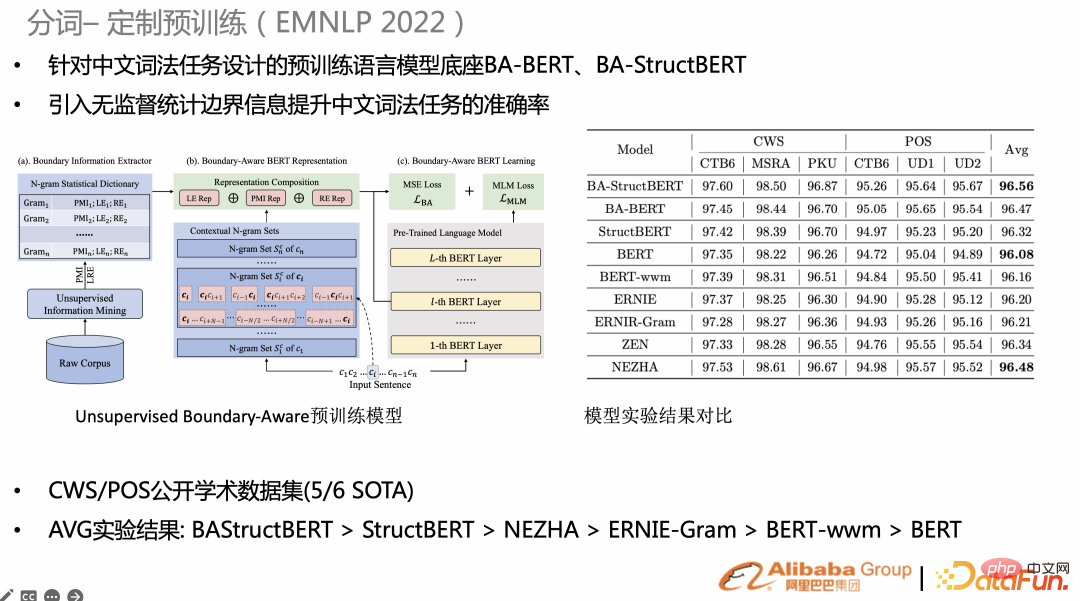

2. Segmentation des mots

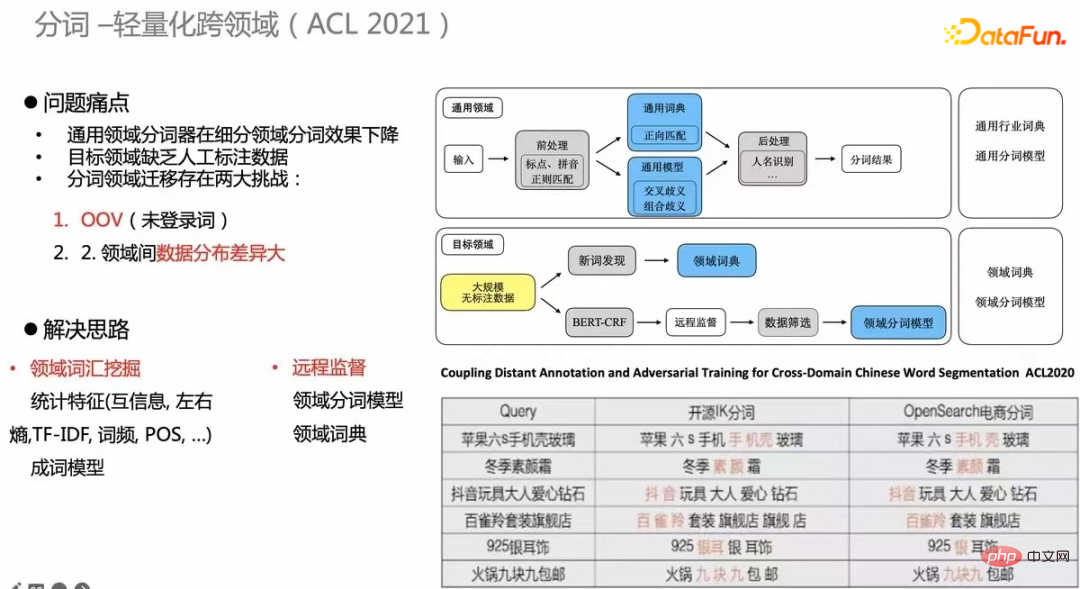

La segmentation des mots (capacité atomique) de la recherche détermine la granularité de l'index de récupération et est également liée à la pertinence ultérieure et à la granularité BM25. Pour les tâches spécifiques à une tâche, si vous personnalisez une pré-formation, l'effet sera meilleur qu'une pré-formation générale. Par exemple, des recherches récentes espèrent ajouter des informations statistiques non supervisées à la tâche de pré-entraînement BERT native, telles que des mots statistiques, la granularité de Gram ou l'entropie limite, puis ajouter une perte de mse à la pré-entraînement. Sur CWS/POS et NER (photo de droite), de nombreuses tâches ont atteint SOTA.

Une autre recherche est transversale. Le coût de l'étiquetage des données et de la construction de tâches de supervision à chaque fois est très élevé, il est donc nécessaire de construire un mécanisme de segmentation de mots non supervisé inter-domaines. Le tableau dans le coin inférieur droit est un exemple. La qualité de la segmentation des mots du commerce électronique a été considérablement améliorée par rapport à la segmentation des mots open source. Cette méthode a également été publiée dans ACL2020.

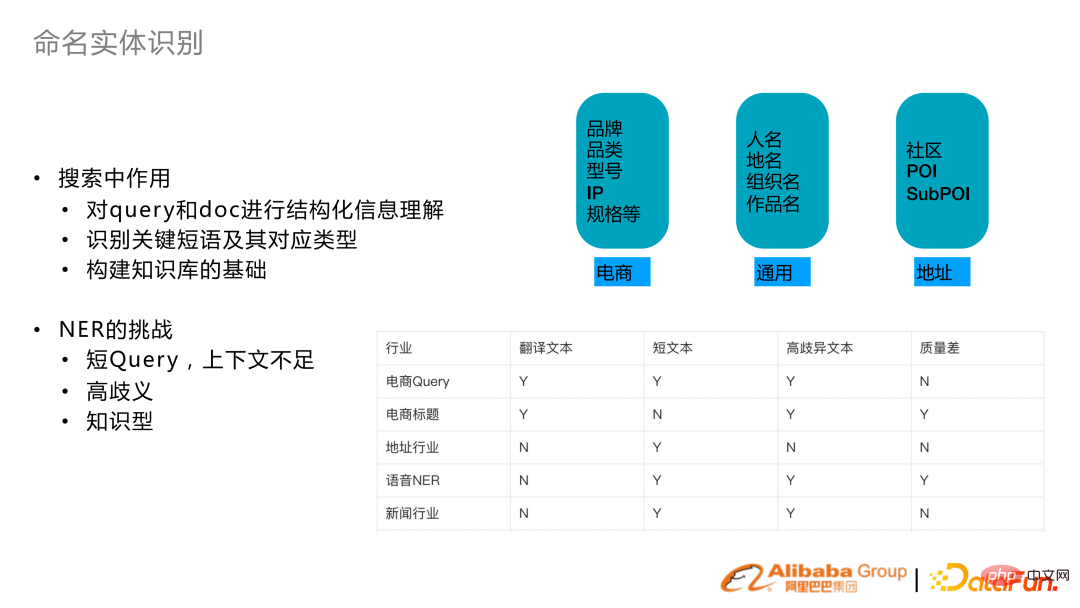

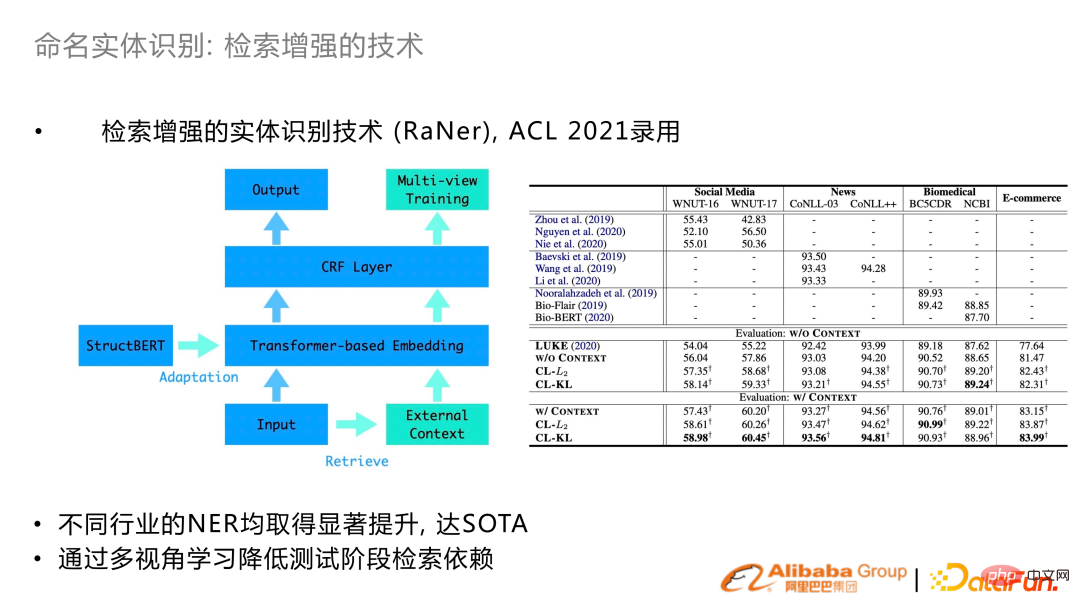

3. Reconnaissance d'entité nommée

La reconnaissance d'entité nommée par recherche implique principalement une compréhension structurée de la requête et du document, et identifie les expressions et types clés. Dans le même temps, la construction du graphe de connaissances de recherche repose également sur la fonction NER.

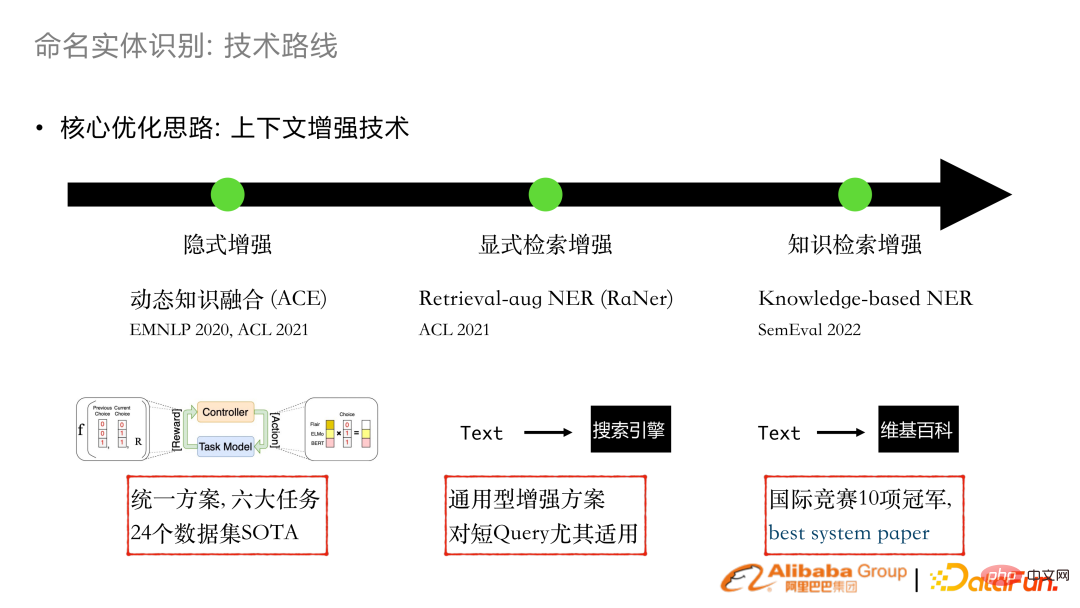

La recherche de NER comporte également certains défis. La raison principale est que les requêtes sont souvent relativement courtes et manquent de contexte. Par exemple, l’entité de requête dans le commerce électronique est très ambiguë et bien informée. Par conséquent, l'idée principale d'optimisation du NER ces dernières années est d'améliorer la représentation du NER à travers le contexte ou l'introduction de connaissances.

a réalisé le combo de travail d'amélioration implicite en 2020 et 2021. En intégrant dynamiquement un extracteur de mots existant ou des représentations GLUE, il peut être implémenté sur de nombreuses tâches commerciales pour atteindre SOTA.

En 2021, une amélioration de la récupération explicite sera développée. Un morceau de texte recevra un contexte amélioré via le moteur de recherche et sera intégré dans la structure du transformateur. Ce travail a été publié dans ACL 2021.

Sur la base de ce travail, nous avons participé à l'évaluation NER multilingue SemEval 2022 et avons remporté 10 championnats, ainsi que le meilleur article système.

Amélioration de la récupération : en plus de la phrase d'entrée elle-même, un contexte supplémentaire est récupéré et lié à l'entrée, combiné à la perte de KL pour faciliter l'apprentissage. Obtention de SOTA dans de nombreux ensembles de données open source.

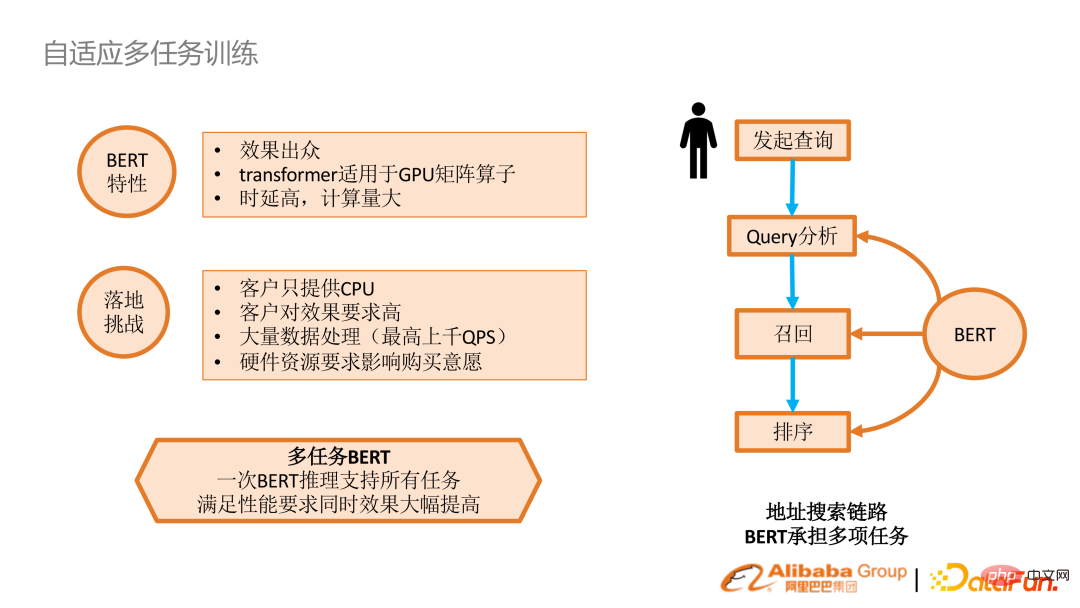

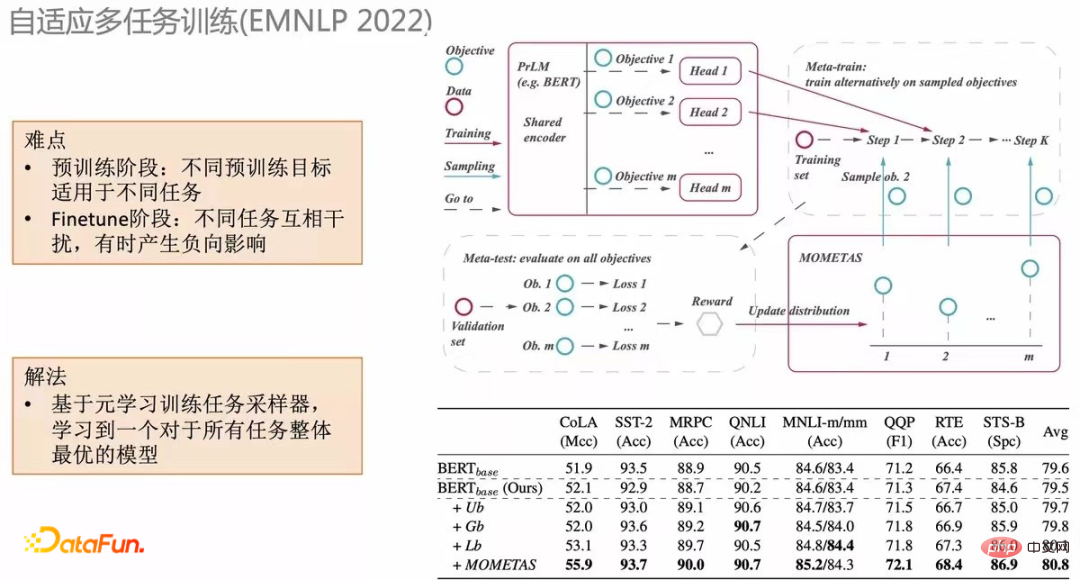

4. Formation multitâche adaptative

BERT lui-même est très efficace, mais il existe peu de clusters GPU en production réelle, et chaque tâche doit être effectuée, ce qui coûte cher en termes de performances d'inférence. Nous réfléchissons à la possibilité de faire une inférence une seule fois, puis adaptons chaque tâche individuellement après l'encodeur, afin d'obtenir de meilleurs résultats.

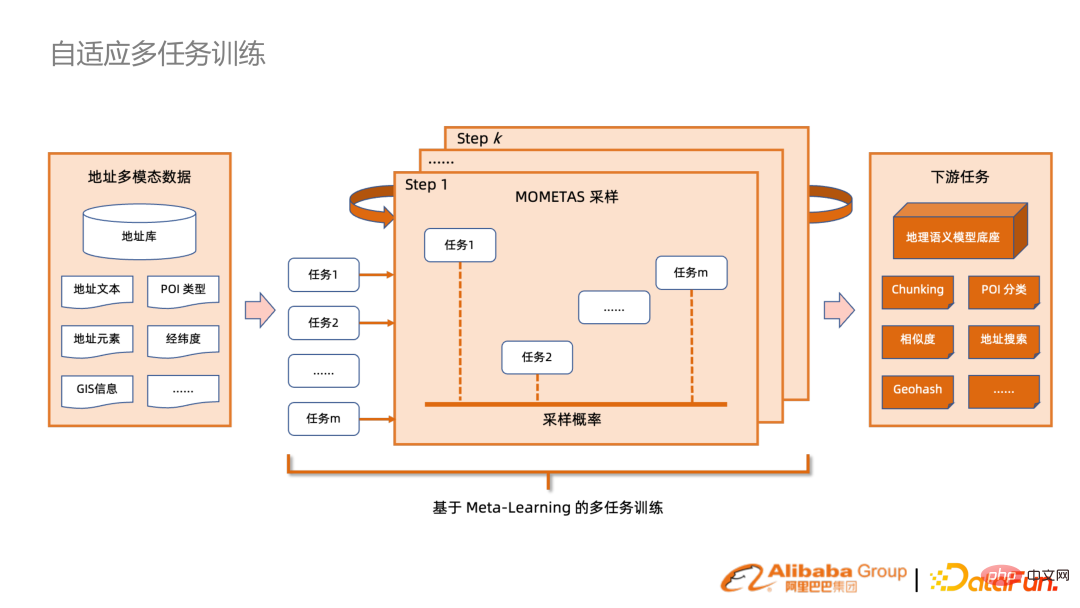

Une manière intuitive consiste à incorporer des tâches d'analyse de requêtes PNL via le cadre de méta-tâches. Mais la méta-tâche traditionnelle est une distribution uniformément échantillonnée. Nous proposons MOMETAS, une méthode adaptative basée sur le méta-apprentissage qui adapte automatiquement l'échantillonnage à différentes tâches. Dans le processus d'apprentissage de plusieurs tâches, nous utiliserons périodiquement les données de validation pour tester afin de voir les effets de l'apprentissage de différentes tâches. la récompense guide à son tour l’échantillonnage de la formation précédente. (Tableau ci-dessous) La combinaison de ce mécanisme sur de nombreuses tâches présente de nombreuses améliorations par rapport à l'UB (distribution uniforme).

Appliquez le mécanisme ci-dessus aux scénarios de recherche dans de nombreux secteurs. Les avantages sont que BERT n'est codé et stocké qu'une seule fois et peut être directement réutilisé dans de nombreuses tâches en aval, ce qui peut considérablement améliorer les performances.

5. Rechercher et rappeler un modèle de langage pré-entraîné

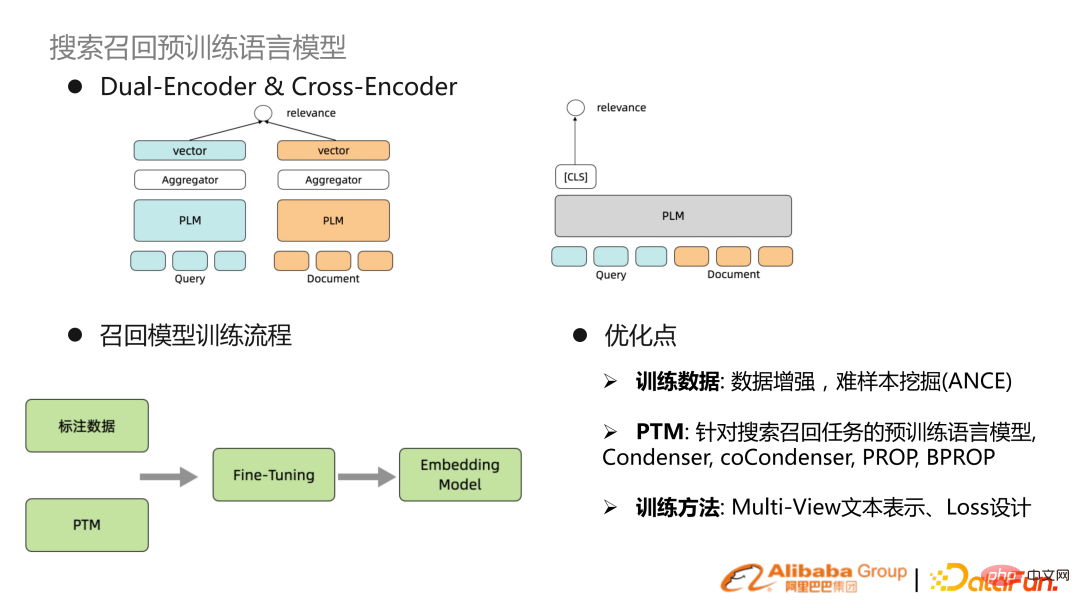

La récupération en profondeur n'est rien de plus qu'une double tour ou une seule tour. Le paradigme d'entraînement courant est le signal supervisé et le modèle pré-entraîné. obtenu par intégration fine, caractérise la requête et la doc. Les voies d'optimisation récentes concernent principalement l'amélioration des données ou l'exploration d'échantillons difficiles, et l'autre consiste à optimiser des modèles de langage pré-entraînés. Le BERT natif n'est pas une représentation textuelle particulièrement adaptée à la recherche, il existe donc des modèles de langage pré-entraînés pour la recherche de représentations textuelles. D'autres optimisations résident dans la représentation du texte multi-vues et la conception spéciale des pertes.

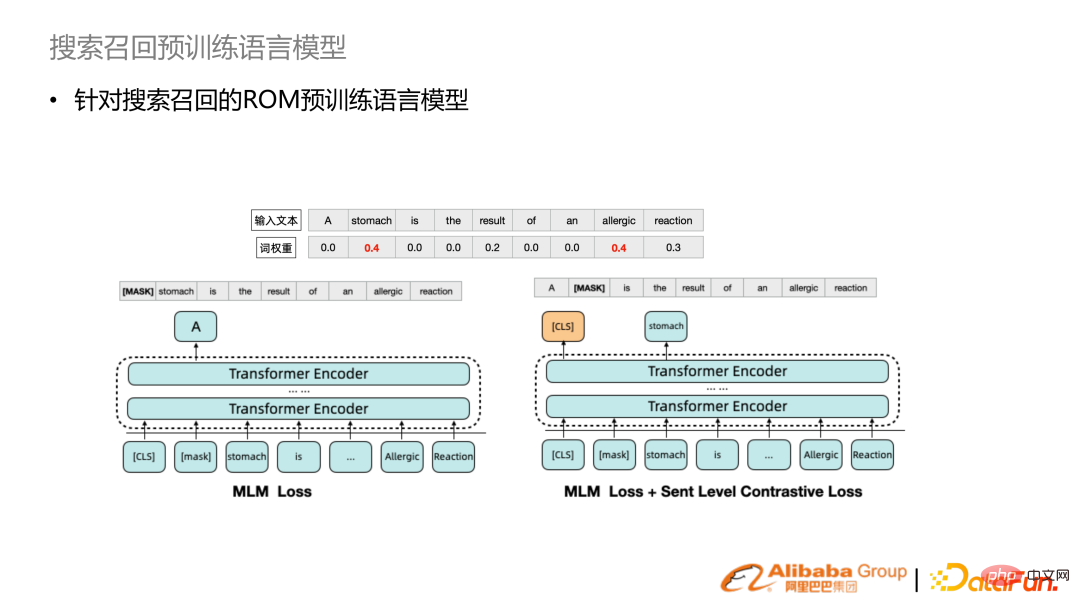

Par rapport à l'échantillonnage aléatoire du BERT natif, nous combinons les poids des mots de recherche pour augmenter les mots avec des poids de mots plus élevés afin d'augmenter la probabilité d'échantillonnage, et les représentations apprises sont plus adaptées à la recherche et au rappel. De plus, un apprentissage comparatif au niveau de la phrase est ajouté. En combinant ces deux mécanismes, un modèle de langage pré-entraîné de ROM est proposé.

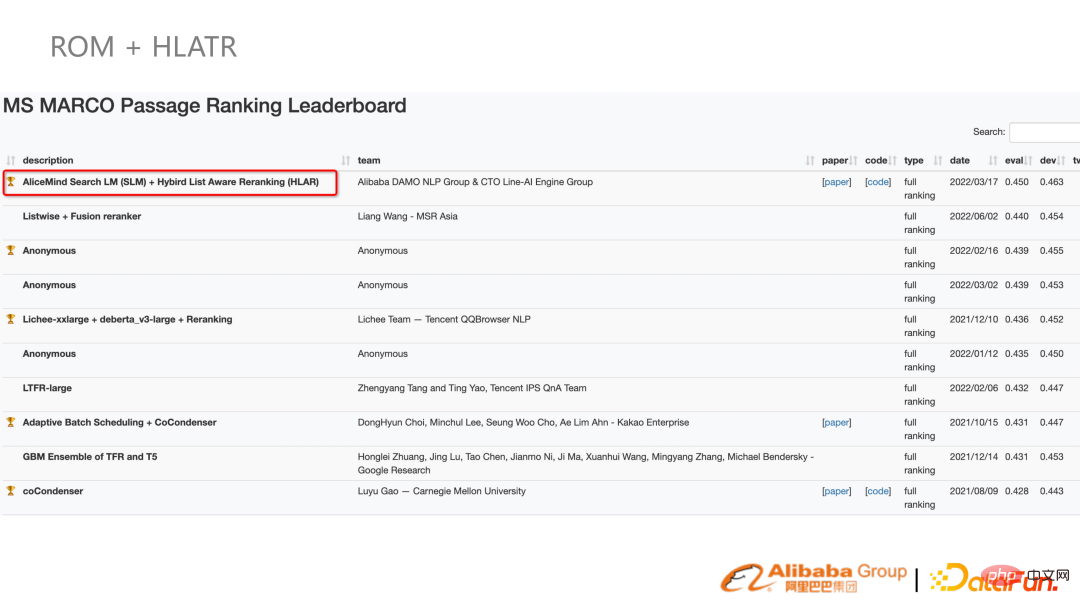

Faites des expériences au MS MARCO et comparez les méthodes précédentes pour obtenir les meilleurs résultats. Dans les tâches réelles de recherche de scènes, cela peut également apporter de grandes améliorations. Dans le même temps, ce modèle a également participé aux classements MS.

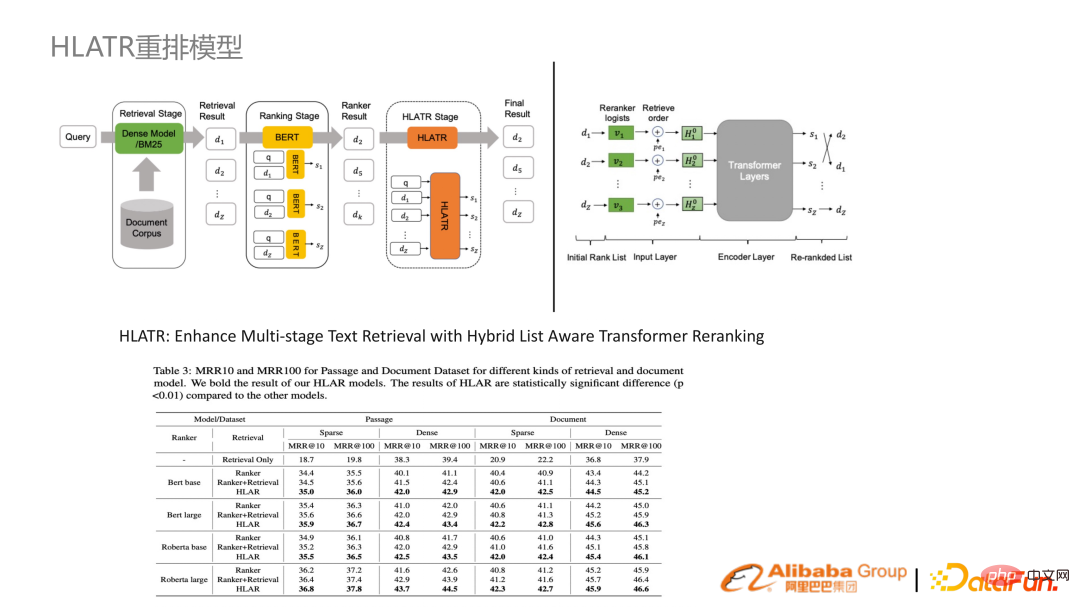

6. Modèle de reclassement HLATR

En plus de l'étape de rappel ROM, dans les étapes de classement fin et de reclassement, un ensemble de reclassements Transformer prenant en compte la liste est proposé, qui permettra d'affiner de nombreuses catégories. Les résultats du transformateur sont organiquement intégrés via le transformateur, ce qui entraîne une amélioration relativement importante.

En combinant les deux solutions ROM et HLATR, les résultats de mars à maintenant (juillet) sont toujours SOTA.

3. Application de recherche d'industrie

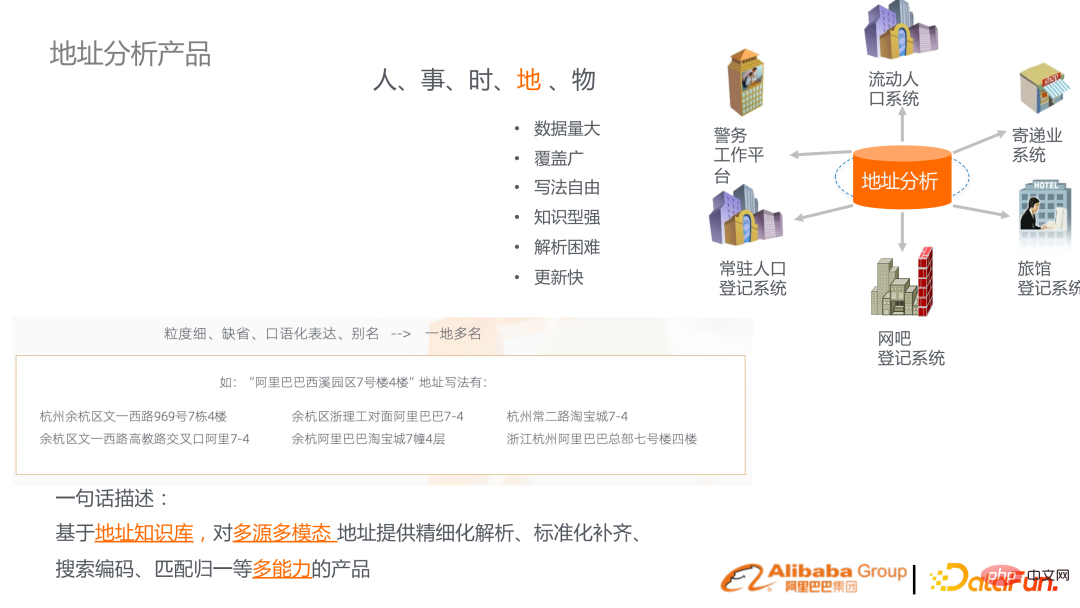

1. Produit d'analyse d'adresses

Le produit d'analyse d'adresse développé par DAMO Academy est basé sur le fait qu'il existe de nombreuses adresses de correspondance dans divers secteurs. Les adresses de correspondance chinoises présentent de nombreuses caractéristiques, telles que de nombreux défauts dans les expressions familières. En même temps, l'adresse elle-même est une personne ou une chose, et c'est une unité d'entité importante qui relie de nombreuses entités dans le monde objectif. Par conséquent, sur cette base, un ensemble de graphiques de connaissances d'adresses a été établi pour fournir l'analyse, la complétion, la recherche et l'analyse d'adresses.

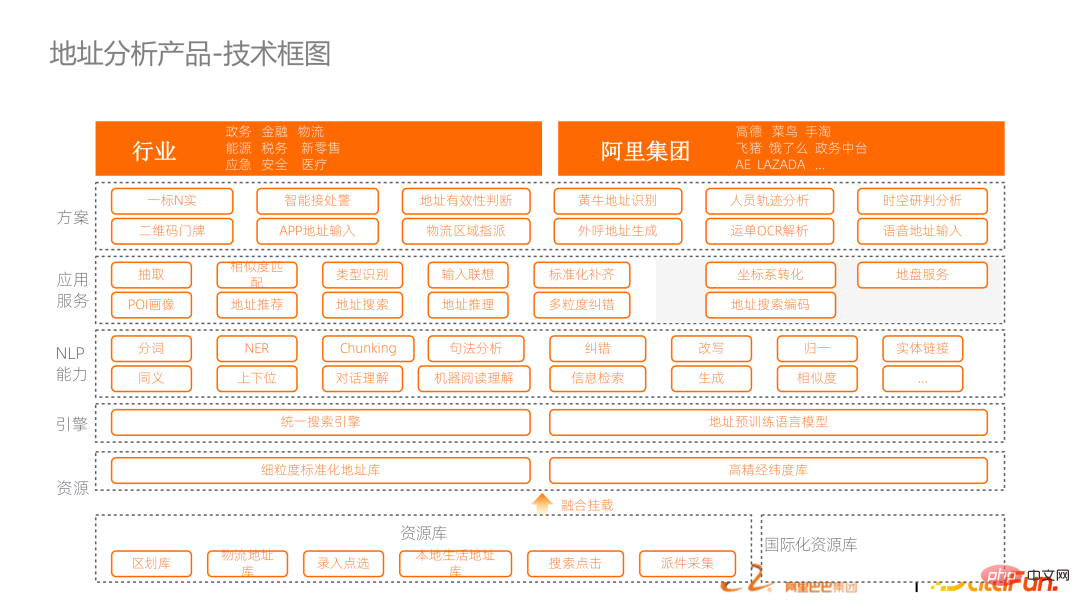

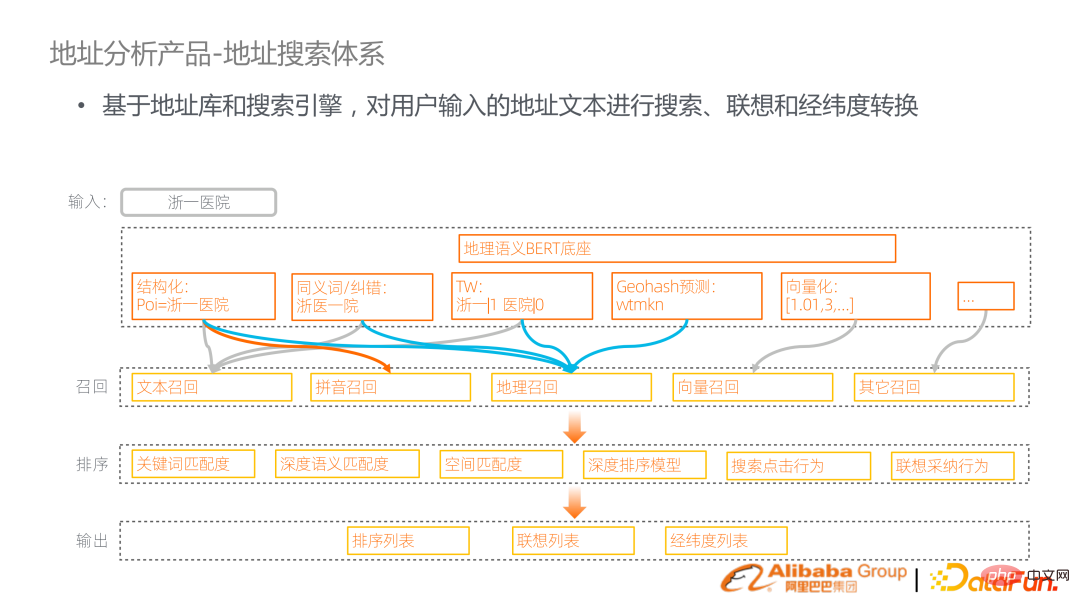

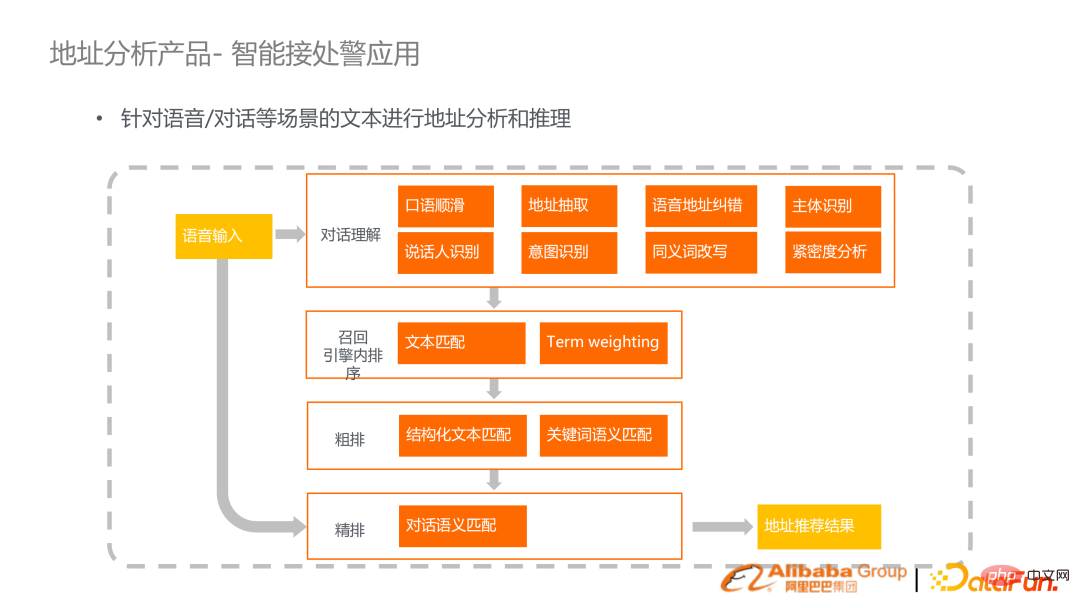

Voici le schéma fonctionnel technique du produit. De bas en haut, il comprend la construction du graphe de connaissances des adresses et du modèle linguistique de pré-formation des adresses, y compris un cadre basé sur un moteur de recherche pour connecter l'ensemble du lien. Les capacités de référence mentionnées ci-dessus sont fournies sous forme d'API et intégrées dans des solutions industrielles.

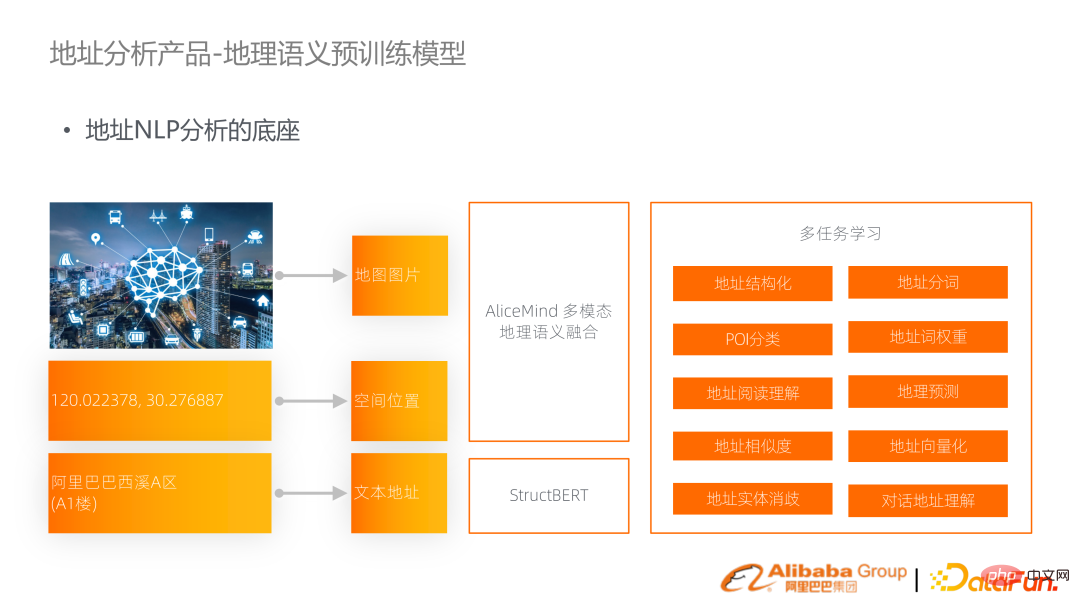

L'un des points les plus importants de cette technologie est le modèle linguistique pré-entraîné de la sémantique géographique. Une adresse sera représentée sous forme de chaîne dans le texte, mais en fait, elle est souvent représentée par une longitude et une latitude dans l'espace, et il y a des images correspondantes sur la carte. Par conséquent, les informations de ces trois modalités sont organiquement intégrées dans un modèle de langage géo-sémantique multimodal pour prendre en charge les tâches sur place.

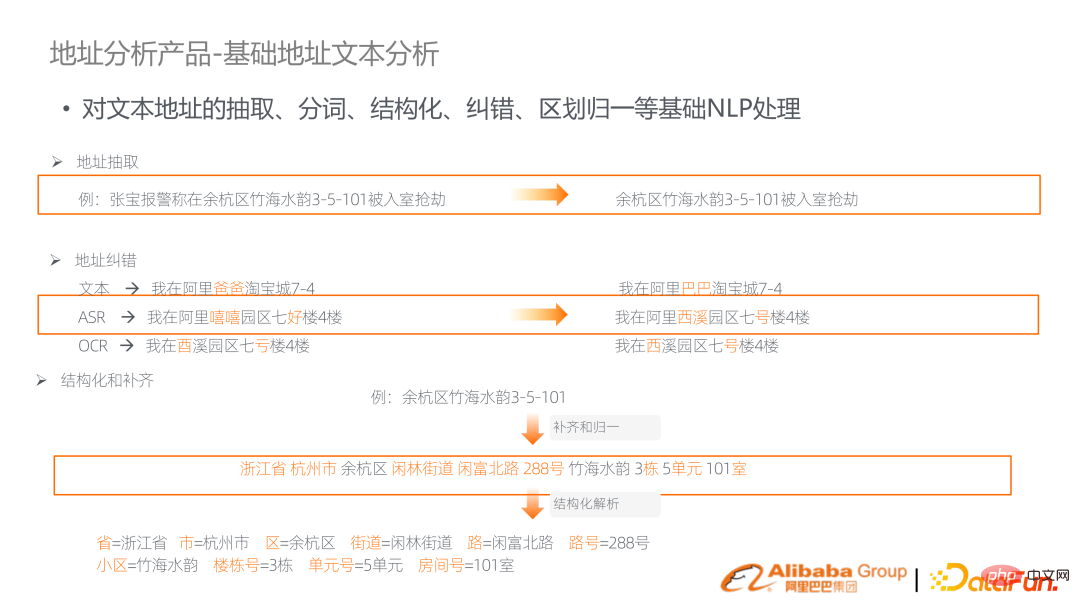

Comme mentionné ci-dessus, de nombreuses capacités de base liées aux adresses sont requises, telles que la segmentation des mots, la correction d'erreurs, la structuration et d'autres analyses.

Le lien principal est de les combler en reliant le modèle linguistique géographique de pré-formation, en abordant les tâches de base et en déclenchant les moteurs de recherche. Par exemple, si vous recherchez l'hôpital n°1 du Zhejiang, vous pouvez y effectuer une structuration, une correction des synonymes, une pondération des termes, une vectorisation et une prédiction Geohash. Effectuer un rappel basé sur les résultats de l'analyse. Ce lien est un lien de recherche standard qui effectue le rappel de texte, le rappel de pinyin, le rappel de vecteurs et ajoute également un rappel géographique. Le rappel est suivi d'un tri en plusieurs étapes, y compris la fusion de fonctionnalités multigranulaires.

L'application intuitive du système de recherche d'adresse consiste à remplir l'adresse dans la scène de suggestion, ou à rechercher dans la carte Amap, qui doit être mappée à un point de l'espace.

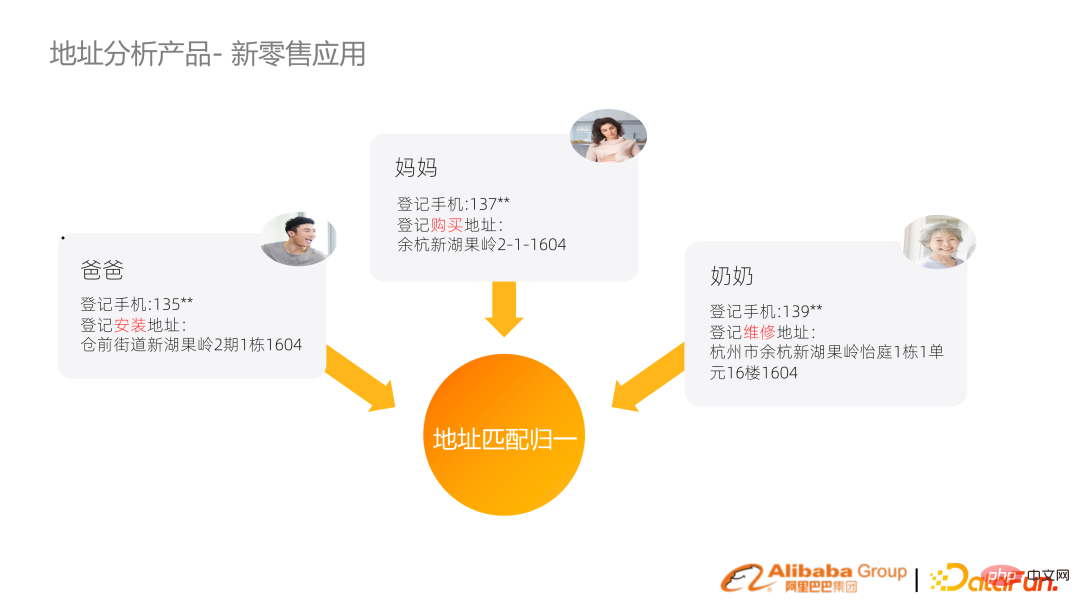

Ensuite, nous présenterons deux solutions d'application relativement industrielles. Le premier est le nouveau Family ID de vente au détail. L'exigence principale est de maintenir un système de gestion des clients. Cependant, les informations sur les utilisateurs dans chaque système ne sont pas connectées et une intégration efficace ne peut pas être réalisée.

Par exemple, un fabricant de marque vend un climatiseur et la famille enregistre diverses adresses et numéros de téléphone portable en raison de l'achat, de l'installation et de la maintenance, mais les adresses correspondantes sont en fait la même adresse. La technologie établie de normalisation de la recherche d'adresses normalise les adresses avec différentes représentations, génère des empreintes digitales et regroupe différents identifiants d'utilisateur dans le concept de famille.

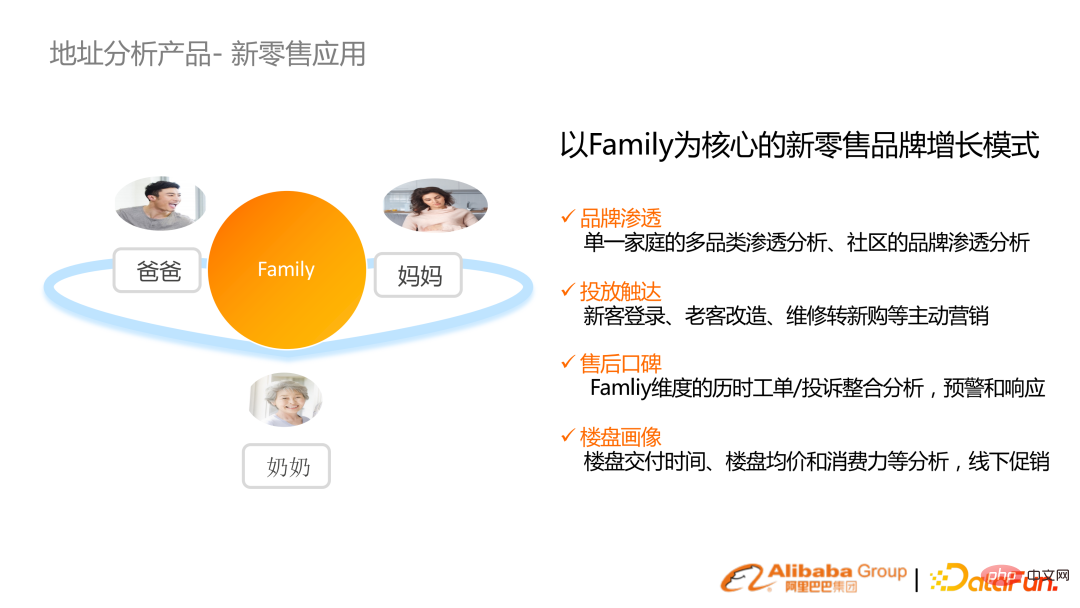

Grâce au concept d'agrégation familiale, une meilleure analyse de pénétration, un placement publicitaire et d'autres activités de marketing dans le cadre d'un nouveau commerce de détail peuvent être obtenus.

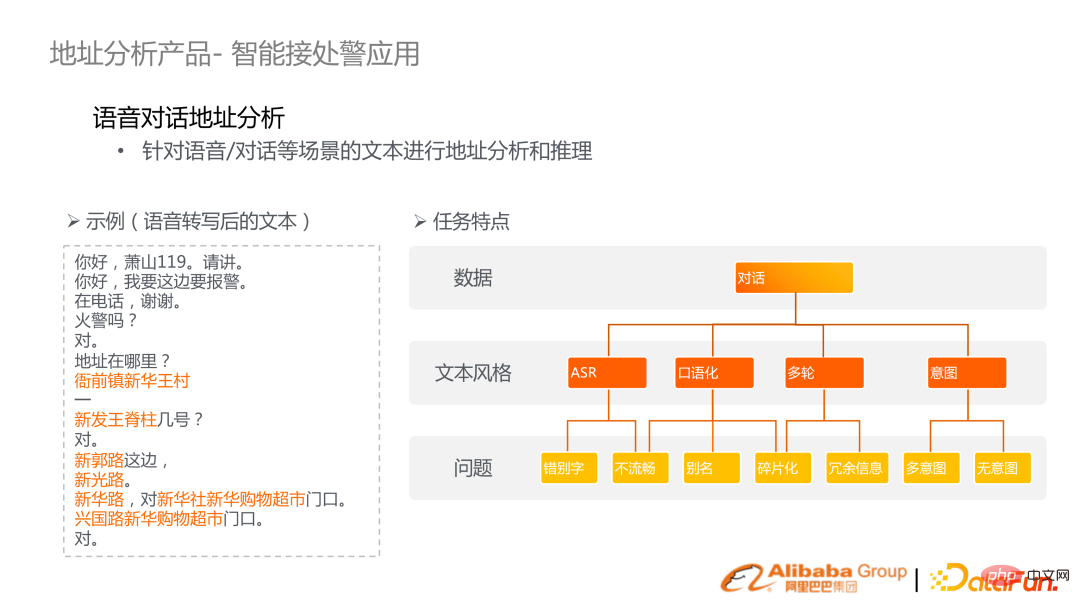

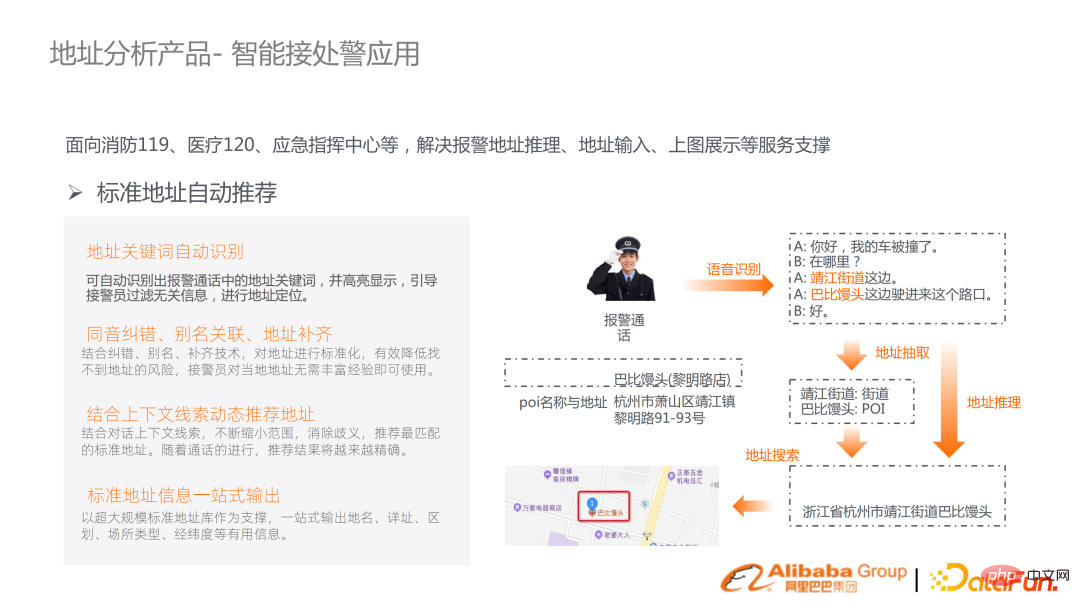

Un autre scénario d'application est 119, 129, des applications de réception d'alarme d'urgence et autres intelligentes. Parce que la sécurité des personnes et des biens est en jeu, chaque seconde compte. Nous espérons améliorer cette efficacité en combinant les technologies de reconnaissance vocale et de compréhension sémantique de texte.

(exemple à gauche) La scène présente de nombreuses caractéristiques, telles que des fautes de frappe, un manque de fluidité, un langage familier et d'autres problèmes de transcription ASR. L’objectif est de déduire l’emplacement d’une alarme sur la base d’une analyse automatisée de la transcription vocale.

Nous avons proposé une solution système complète, comprenant la compréhension des dialogues, la correction fluide du langage parlé, la reconnaissance des intentions et une combinaison d'un ensemble de recherches allant du rappel au brouillon mécanisme de sélection et de sélection fine pour finalement mettre en œuvre la recommandation d'adresse. Le lien est relativement mature et a été mis en œuvre dans les systèmes de protection incendie de centaines de villes en Chine ; les pompiers identifient des emplacements spécifiques à partir de conversations d'alarme, combinent des recommandations, des correspondances et adressent des clôtures pour déterminer les emplacements spécifiques et envoyer des alarmes en conséquence.

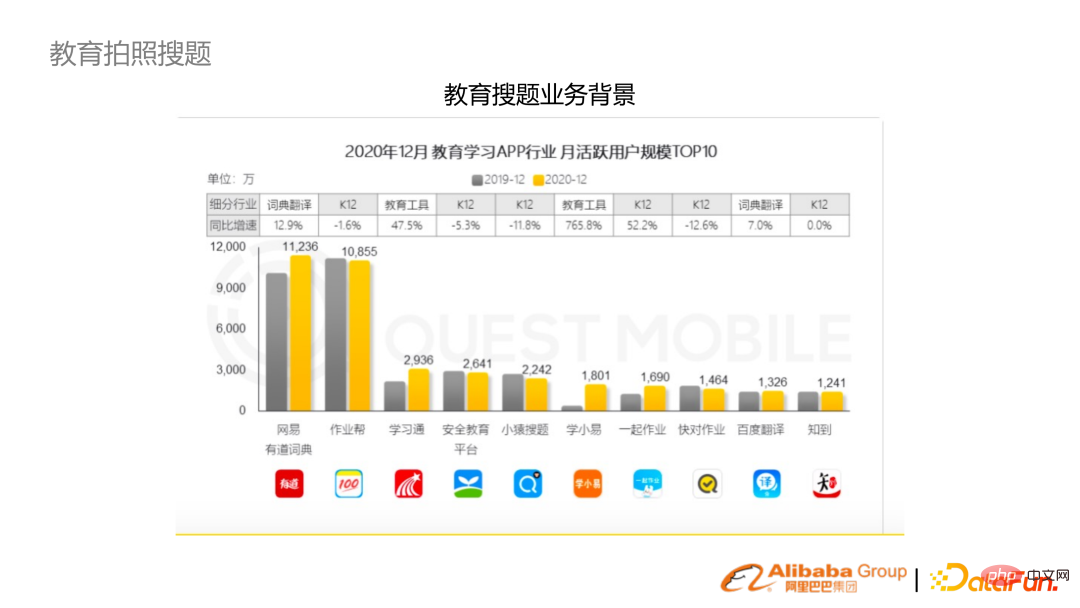

2. Questions de recherche de photos éducatives

Ensuite, nous présenterons le secteur de la collection de photos dans le secteur de l'éducation, qui est également très demandé en To C et pour les enseignants.

La question de recherche de photos possède plusieurs fonctionnalités. Elle dispose d'une banque de questions mise à jour progressivement et dispose d'une large base d'utilisateurs. De plus, les domaines correspondant aux différentes disciplines et tranches d’âge sont très pointus. En même temps, il s’agit d’un algorithme multimodal, avec un ensemble de liens allant de l’OCR à la compréhension et à la recherche sémantiques ultérieures.

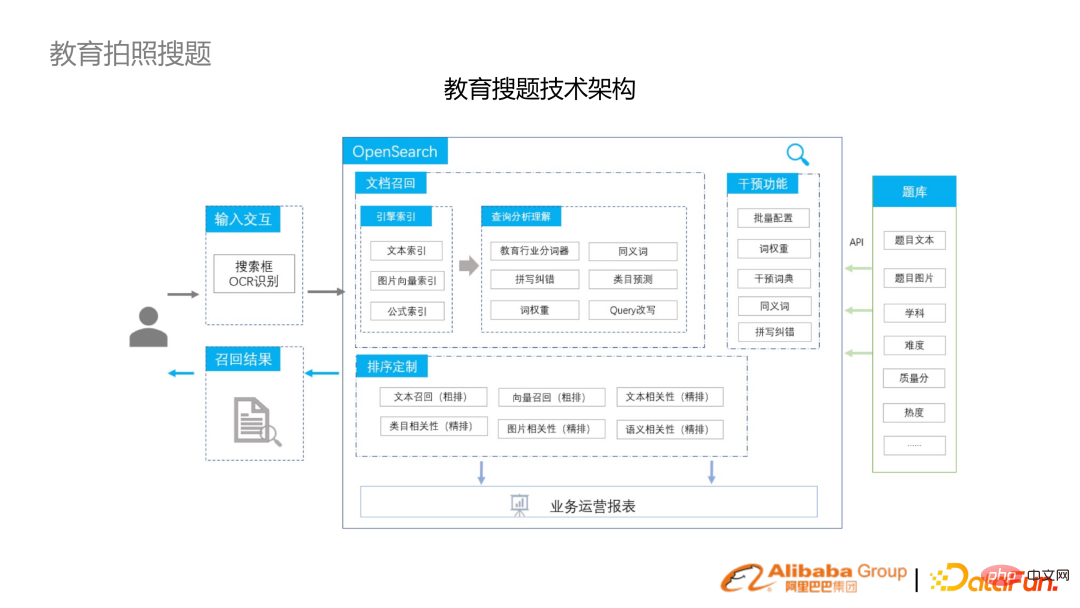

Ces dernières années, un ensemble complet de liens allant des algorithmes aux systèmes a été construit pour la collection de photos.

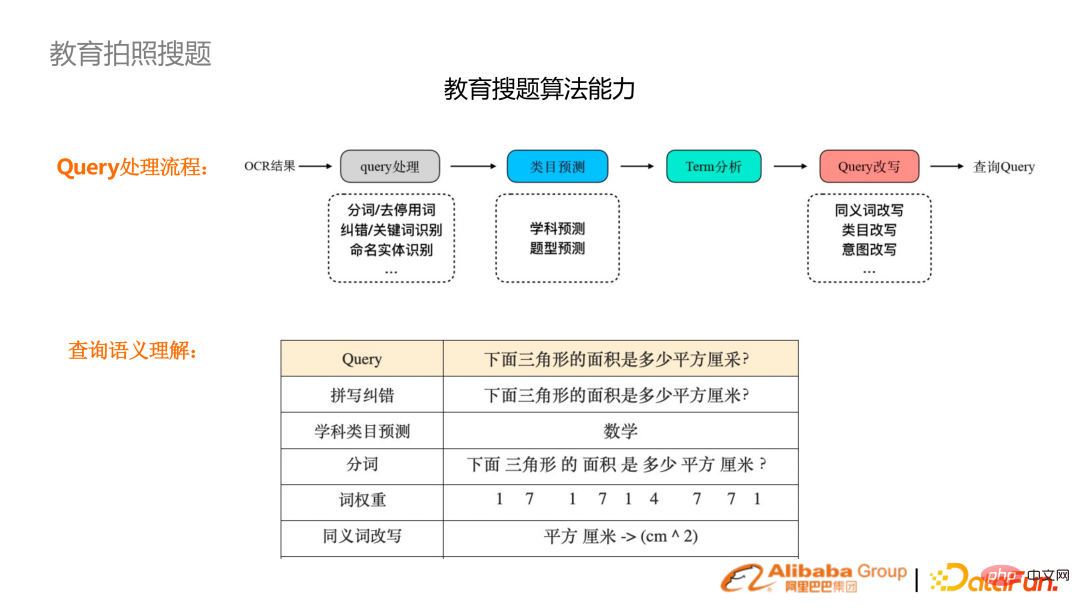

Par exemple, après avoir pris une photo avec un téléphone portable et la reconnaissance OCR, une série de tâches telles que la correction orthographique, la prédiction du sujet, la segmentation des mots et la pondération des mots seront effectuées pour faciliter la récupération.

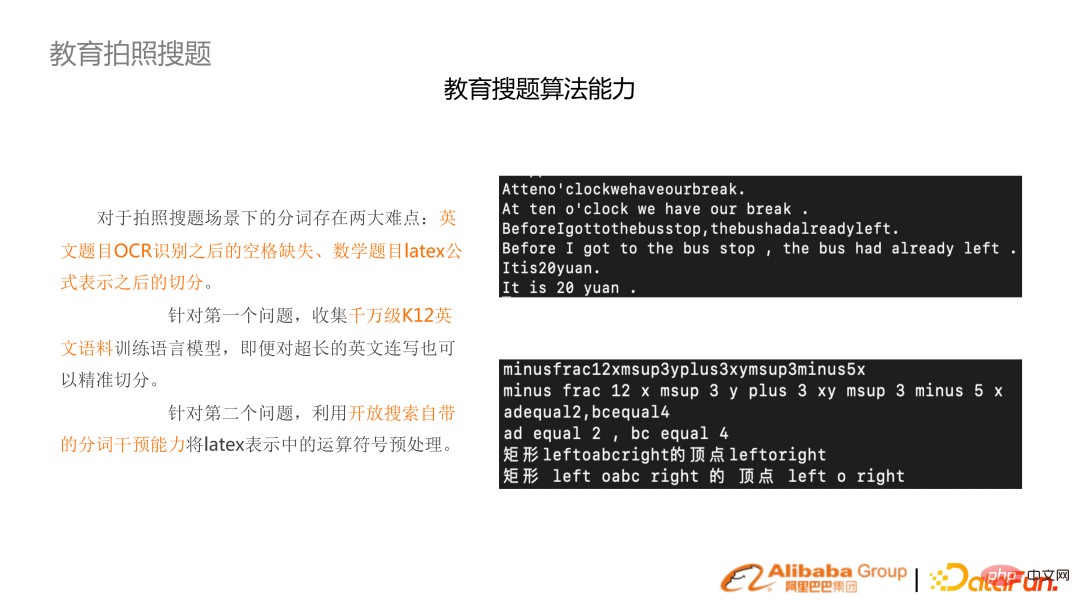

Étant donné que l'OCR ne reconnaît pas les espaces en anglais, un ensemble de modèles d'algorithmes de pré-formation en anglais K12 ont été formés pour segmenter l'anglais.

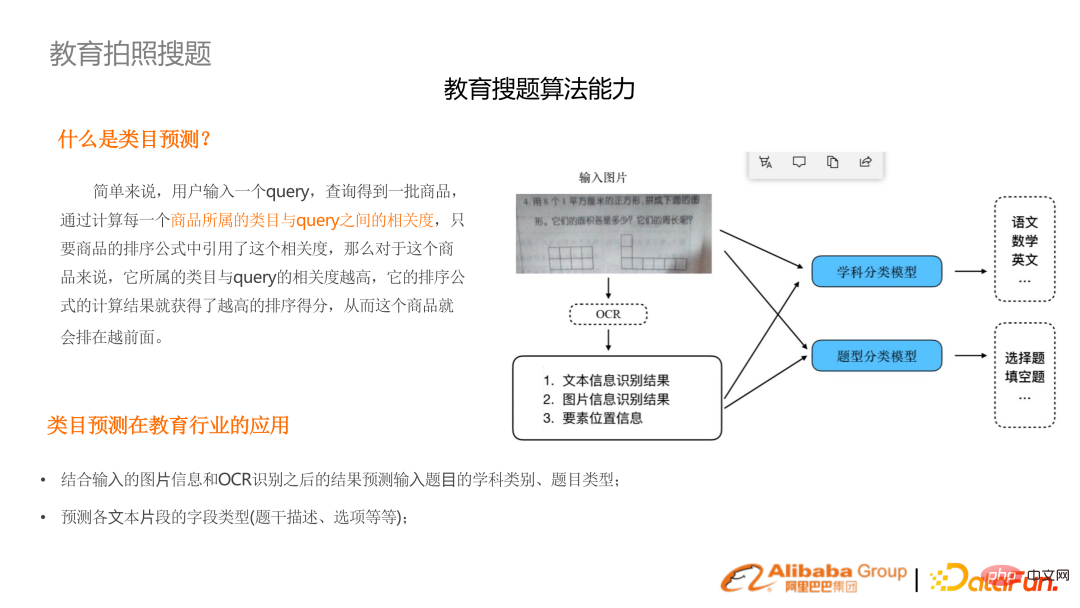

Dans le même temps, les sujets et les types de questions sont inconnus et doivent être prédits à l'avance. Utilisez la multimodalité pour combiner des images et du texte afin de comprendre l’intention.

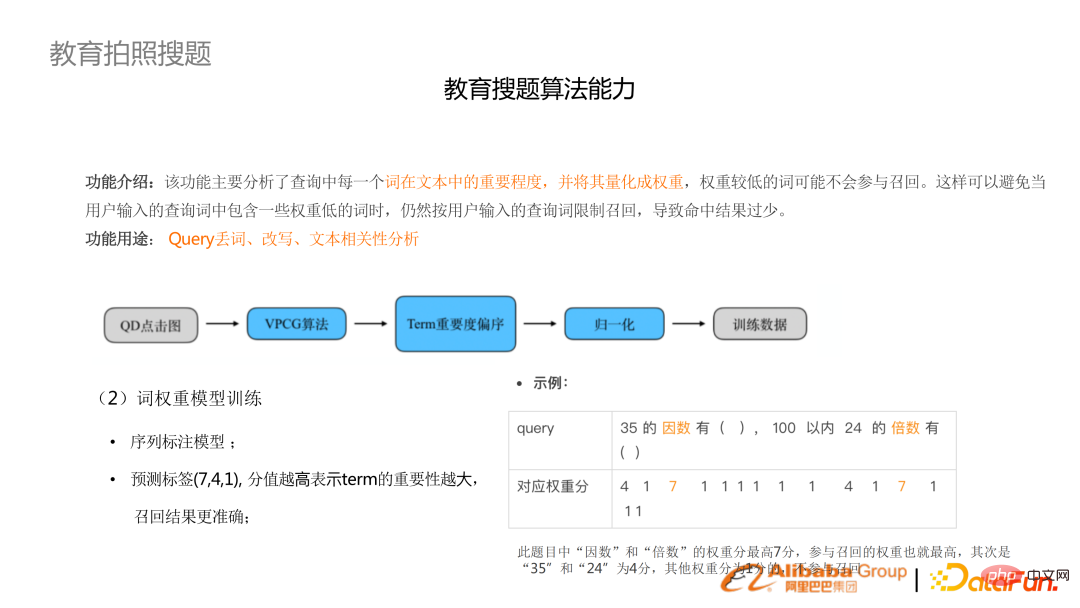

Les questions de recherche de photos sont différentes des recherches d'utilisateurs ordinaires. Les recherches d'utilisateurs ont tendance à avoir des requêtes plus courtes, tandis que les questions de recherche de photos sont souvent une question complète. De nombreux mots dans la question sont sans importance et il est nécessaire de procéder à une analyse du poids des mots, de supprimer les mots sans importance ou de les trier pour les déclasser.

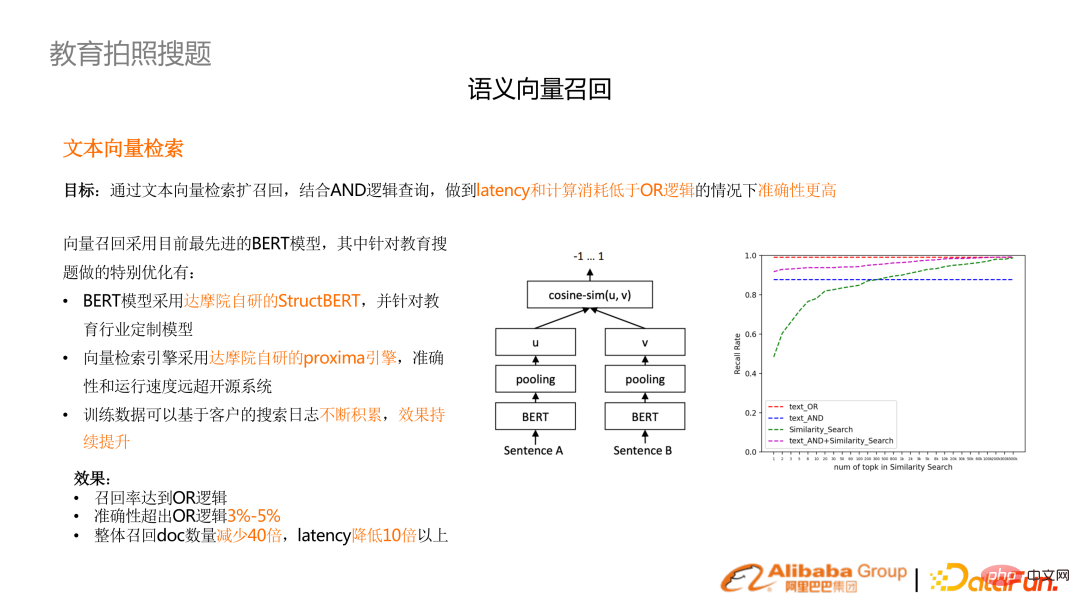

L'effet d'optimisation le plus évident dans la scène de recherche de photos est le rappel vectoriel. Les exigences de performances rendent difficile l'utilisation du mécanisme de rappel OU et nécessitent l'utilisation de la logique ET. La caractéristique correspondante est qu'il y a relativement peu de rappels. Pour améliorer le rappel, vous devez créer davantage de modules redondants tels que la pondération des termes et la correction des erreurs. (Image de droite) L'effet de rappel multicanal du texte et du vecteur dépasse celui de la logique OU pure et la latence est réduite de 10 fois.

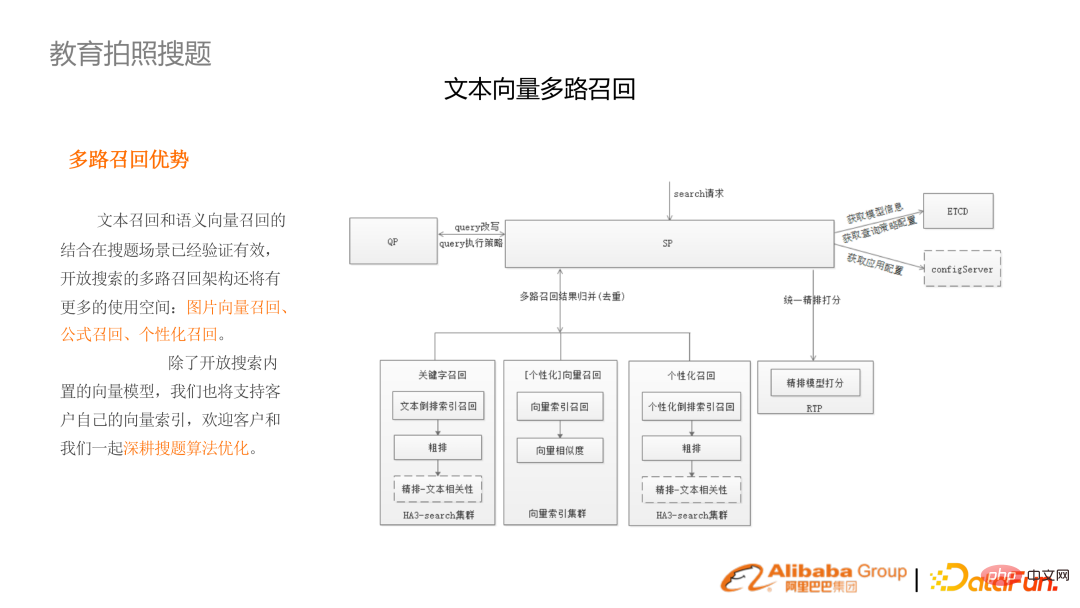

Les liens de recherche de photos incluent le rappel de vecteurs d'images, le rappel de formule et le rappel personnalisé.

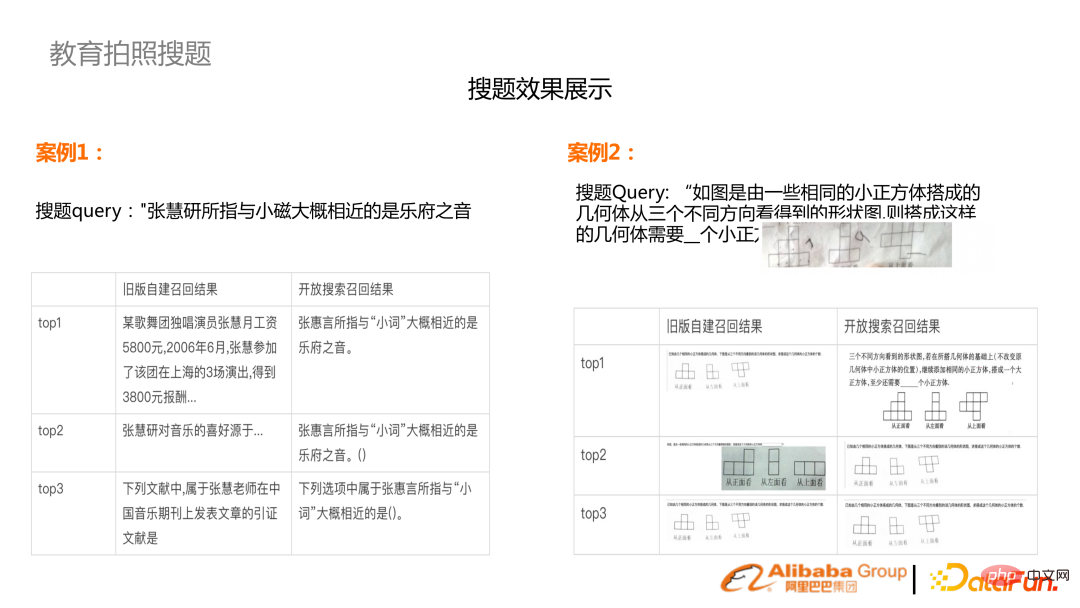

Donnez deux exemples. Le premier est le résultat OCR du texte brut. (Colonne de gauche) L'ancien résultat est basé sur ES, simple rappel OU, plus le résultat de BM25 (colonne de droite). Le lien après le rappel multicanal et le rappel de corrélation a été grandement. amélioré.

La seconde consiste à prendre des photos contenant des graphiques, qui doivent être combinés avec un rappel d'image sur plusieurs canaux.

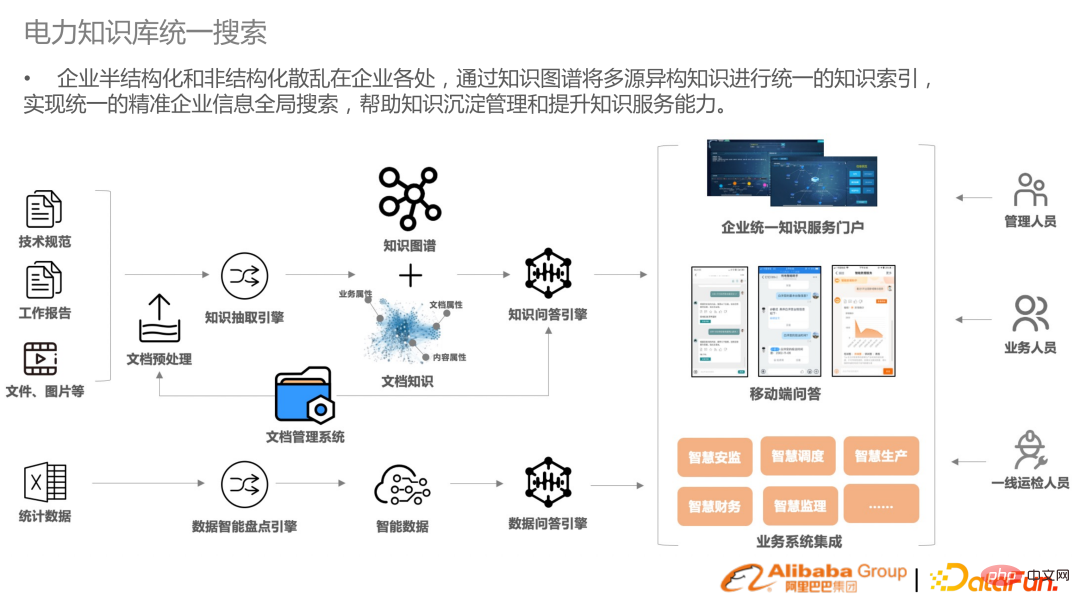

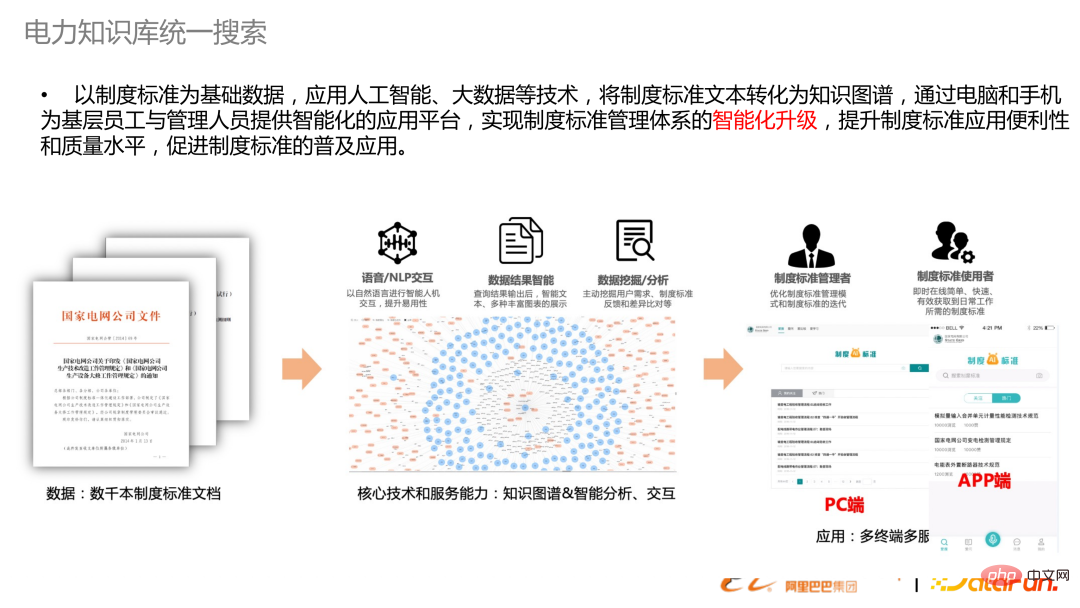

3. Recherche unifiée de la base de connaissances puissante

Il existe de nombreuses données semi-structurées et non structurées dans la recherche d'entreprise, fournissant une recherche unifiée pour aider les entreprises à intégrer les données ressources . Non seulement dans le domaine de l’énergie électrique, d’autres industries ont également des besoins similaires. La recherche ici n'est plus une recherche étroite, mais inclut également l'IA du prétraitement des documents et la construction de graphiques de connaissances, ainsi que la possibilité de relier ultérieurement les questions et réponses. Ce qui précède est un diagramme schématique de la création d'un ensemble de textes standards institutionnels dans la base de connaissances sur l'énergie électrique, de la structuration à la récupération jusqu'à l'application.

- Planification fine étape : Modèles relativement complexes et pertinents, qui peuvent être combinés avec le modèle d'efficacité commerciale (LTR)

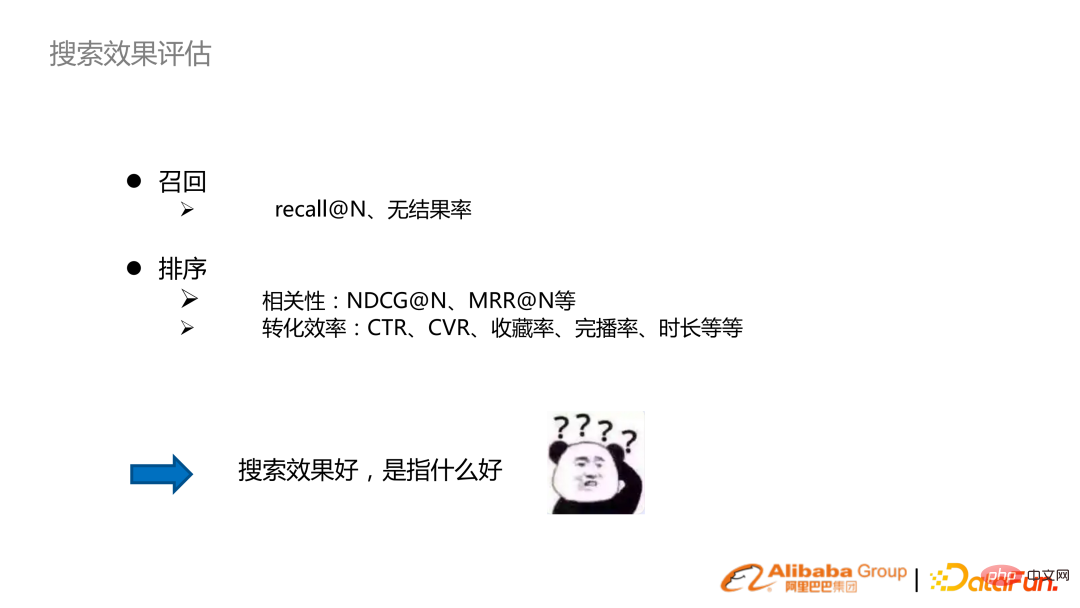

Rappel : taux de rappel ou d'absence de résultat

Pertinence : NDCG, MRR

Pertinence : NDCG, MRR

Efficacité de conversion : taux de clics, taux de conversion

Indicateurs de poursuite de recherche

: En consommant Internet, en plus de rechercher des recherches précises et consultables, nous recherchons également des taux de conversion élevés. Dans l'Internet industriel, il s'agit davantage du besoin de mise en correspondance des informations, il faut donc se concentrer sur le rappel et la pertinence.

- Exigences du système d'ingénierie

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comprenez la tokenisation en un seul article !

Apr 12, 2024 pm 02:31 PM

Comprenez la tokenisation en un seul article !

Apr 12, 2024 pm 02:31 PM

Les modèles de langage raisonnent sur le texte, qui se présente généralement sous la forme de chaînes, mais l'entrée du modèle ne peut être que des nombres, le texte doit donc être converti sous forme numérique. La tokenisation est une tâche fondamentale du traitement du langage naturel. Elle peut diviser une séquence de texte continue (telle que des phrases, des paragraphes, etc.) en une séquence de caractères (telle que des mots, des phrases, des caractères, des signes de ponctuation, etc.) en fonction de besoins spécifiques. Les unités qu'il contient sont appelées un jeton ou un mot. Selon le processus spécifique illustré dans la figure ci-dessous, les phrases de texte sont d'abord divisées en unités, puis les éléments individuels sont numérisés (mappés en vecteurs), puis ces vecteurs sont entrés dans le modèle pour le codage, et enfin sortis vers des tâches en aval pour obtenir en outre le résultat final. La segmentation du texte peut être divisée en Toke en fonction de la granularité de la segmentation du texte.

Ajustement efficace des paramètres des modèles de langage à grande échelle - Série de réglage fin BitFit/Prefix/Prompt

Oct 07, 2023 pm 12:13 PM

Ajustement efficace des paramètres des modèles de langage à grande échelle - Série de réglage fin BitFit/Prefix/Prompt

Oct 07, 2023 pm 12:13 PM

En 2018, Google a publié BERT. Une fois publié, il a vaincu les résultats de pointe (Sota) de 11 tâches PNL d'un seul coup, devenant ainsi une nouvelle étape dans le monde de la PNL. dans la figure ci-dessous, à gauche se trouve le préréglage du modèle BERT, à droite le processus de réglage fin pour des tâches spécifiques. Parmi eux, l'étape de réglage fin est destinée au réglage fin lorsqu'il est ensuite utilisé dans certaines tâches en aval, telles que la classification de texte, le balisage de parties de discours, les systèmes de questions et réponses, etc. BERT peut être affiné sur différents tâches sans ajuster la structure. Grâce à la conception des tâches d'un « modèle de langage pré-entraîné + réglage fin des tâches en aval », il apporte de puissants effets de modèle. Depuis lors, le « modèle linguistique de pré-formation + réglage fin des tâches en aval » est devenu la formation dominante dans le domaine de la PNL.

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

L'ensemble de données ScienceAI Question Answering (QA) joue un rôle essentiel dans la promotion de la recherche sur le traitement du langage naturel (NLP). Des ensembles de données d'assurance qualité de haute qualité peuvent non seulement être utilisés pour affiner les modèles, mais également évaluer efficacement les capacités des grands modèles linguistiques (LLM), en particulier la capacité à comprendre et à raisonner sur les connaissances scientifiques. Bien qu’il existe actuellement de nombreux ensembles de données scientifiques d’assurance qualité couvrant la médecine, la chimie, la biologie et d’autres domaines, ces ensembles de données présentent encore certaines lacunes. Premièrement, le formulaire de données est relativement simple, et la plupart sont des questions à choix multiples. Elles sont faciles à évaluer, mais limitent la plage de sélection des réponses du modèle et ne peuvent pas tester pleinement la capacité du modèle à répondre aux questions scientifiques. En revanche, les questions et réponses ouvertes

Trois secrets pour déployer de grands modèles dans le cloud

Apr 24, 2024 pm 03:00 PM

Trois secrets pour déployer de grands modèles dans le cloud

Apr 24, 2024 pm 03:00 PM

Compilation|Produit par Xingxuan|51CTO Technology Stack (ID WeChat : blog51cto) Au cours des deux dernières années, j'ai été davantage impliqué dans des projets d'IA générative utilisant de grands modèles de langage (LLM) plutôt que des systèmes traditionnels. Le cloud computing sans serveur commence à me manquer. Leurs applications vont de l’amélioration de l’IA conversationnelle à la fourniture de solutions d’analyse complexes pour diverses industries, ainsi que de nombreuses autres fonctionnalités. De nombreuses entreprises déploient ces modèles sur des plates-formes cloud, car les fournisseurs de cloud public fournissent déjà un écosystème prêt à l'emploi et constituent la voie de moindre résistance. Cependant, cela n’est pas bon marché. Le cloud offre également d'autres avantages tels que l'évolutivité, l'efficacité et des capacités informatiques avancées (GPU disponibles sur demande). Il existe certains aspects peu connus du déploiement de LLM sur les plateformes de cloud public

RoSA : une nouvelle méthode pour un réglage fin efficace des paramètres de grands modèles

Jan 18, 2024 pm 05:27 PM

RoSA : une nouvelle méthode pour un réglage fin efficace des paramètres de grands modèles

Jan 18, 2024 pm 05:27 PM

À mesure que les modèles de langage évoluent à une échelle sans précédent, un réglage précis des tâches en aval devient prohibitif. Afin de résoudre ce problème, les chercheurs ont commencé à s’intéresser à la méthode PEFT et à l’adopter. L'idée principale de la méthode PEFT est de limiter la portée du réglage fin à un petit ensemble de paramètres afin de réduire les coûts de calcul tout en atteignant des performances de pointe sur les tâches de compréhension du langage naturel. De cette manière, les chercheurs peuvent économiser des ressources informatiques tout en maintenant des performances élevées, ouvrant ainsi la voie à de nouveaux points chauds de recherche dans le domaine du traitement du langage naturel. RoSA est une nouvelle technique PEFT qui, grâce à des expériences sur un ensemble de références, s'est avérée surpasser les précédentes méthodes adaptatives de bas rang (LoRA) et de réglage fin clairsemé pur utilisant le même budget de paramètres. Cet article approfondira

Idéalement formé le plus grand ViT de l'histoire ? Google met à niveau le modèle de langage visuel PaLI : prend en charge plus de 100 langues

Apr 12, 2023 am 09:31 AM

Idéalement formé le plus grand ViT de l'histoire ? Google met à niveau le modèle de langage visuel PaLI : prend en charge plus de 100 langues

Apr 12, 2023 am 09:31 AM

Les progrès du traitement du langage naturel ces dernières années proviennent en grande partie de modèles de langage à grande échelle. Chaque nouveau modèle publié pousse la quantité de paramètres et de données d'entraînement vers de nouveaux sommets, et en même temps, les classements de référence existants seront abattus ! Par exemple, en avril de cette année, Google a publié le modèle de langage PaLM (Pathways Language Model) composé de 540 milliards de paramètres, qui a surpassé avec succès les humains dans une série de tests de langage et de raisonnement, en particulier ses excellentes performances dans des scénarios d'apprentissage sur petits échantillons. PaLM est considéré comme la direction de développement du modèle de langage de nouvelle génération. De la même manière, les modèles de langage visuel font des merveilles et les performances peuvent être améliorées en augmentant la taille du modèle. Bien sûr, s'il ne s'agit que d'un modèle de langage visuel multitâche

Meta lance le modèle de langage IA LLaMA, un modèle de langage à grande échelle avec 65 milliards de paramètres

Apr 14, 2023 pm 06:58 PM

Meta lance le modèle de langage IA LLaMA, un modèle de langage à grande échelle avec 65 milliards de paramètres

Apr 14, 2023 pm 06:58 PM

Selon les informations du 25 février, Meta a annoncé vendredi, heure locale, qu'elle lancerait un nouveau modèle de langage à grande échelle basé sur l'intelligence artificielle (IA) pour la communauté des chercheurs, rejoignant ainsi Microsoft, Google et d'autres sociétés stimulées par ChatGPT pour rejoindre l'intelligence artificielle. .Concurrence intelligente. LLaMA de Meta est l'abréviation de « Large Language Model MetaAI » (LargeLanguageModelMetaAI), qui est disponible sous une licence non commerciale pour les chercheurs et les entités du gouvernement, de la communauté et du monde universitaire. La société mettra le code sous-jacent à la disposition des utilisateurs, afin qu'ils puissent modifier eux-mêmes le modèle et l'utiliser pour des cas d'utilisation liés à la recherche. Meta a déclaré que les exigences du modèle en matière de puissance de calcul

BLOOM peut créer une nouvelle culture pour la recherche sur l'IA, mais des défis demeurent

Apr 09, 2023 pm 04:21 PM

BLOOM peut créer une nouvelle culture pour la recherche sur l'IA, mais des défis demeurent

Apr 09, 2023 pm 04:21 PM

Traducteur | Révisé par Li Rui | Sun Shujuan Le projet de recherche BigScience a récemment publié un grand modèle de langage BLOOM. À première vue, cela ressemble à une autre tentative de copie du GPT-3 d'OpenAI. Mais ce qui distingue BLOOM des autres modèles de langage naturel (LLM) à grande échelle, ce sont ses efforts pour rechercher, développer, former et publier des modèles d'apprentissage automatique. Ces dernières années, les grandes entreprises technologiques ont caché des modèles de langage naturel (LLM) à grande échelle comme de stricts secrets commerciaux, et l'équipe BigScience a placé la transparence et l'ouverture au centre de BLOOM dès le début du projet. Le résultat est un modèle linguistique à grande échelle qui peut être étudié et étudié et mis à la disposition de tous. B