Périphériques technologiques

Périphériques technologiques

IA

IA

Vous avez toujours peur de ne pas pouvoir jouer à ChatGPT ? Vous pouvez également faire l'expérience d'un dialogue intelligent avec ces douzaines d'alternatives open source

Vous avez toujours peur de ne pas pouvoir jouer à ChatGPT ? Vous pouvez également faire l'expérience d'un dialogue intelligent avec ces douzaines d'alternatives open source

Vous avez toujours peur de ne pas pouvoir jouer à ChatGPT ? Vous pouvez également faire l'expérience d'un dialogue intelligent avec ces douzaines d'alternatives open source

Cela fait presque quatre mois depuis la sortie initiale de ChatGPT. Au cours de cette période, les performances étonnantes de ChatGPT ont amené les gens à se demander si l'AIGC serait réalisé à l'avance.

Cependant, un secret bien connu est qu'il est peu probable que ChatGPT soit open source. Associé à l'énorme investissement en puissance de calcul et aux données de formation massives, il a posé de nombreux obstacles à la communauté des chercheurs pour copier son processus de mise en œuvre.

Face à l'assaut de ChatGPT, les alternatives open source sont un bon choix Si elles réalisent des fonctions similaires, elles peuvent également permettre de comprendre le mécanisme de fonctionnement de ChatGPT à travers des alternatives.

Avec les progrès de la technologie, de nombreux autres nouveaux modèles d'IA similaires à ChatGPT ont maintenant émergé. Dans cet article, nous ferons le point sur les projets de remplacement open source de ChatGPT. Le contenu sera divisé en deux parties, l'une est un résumé des projets open source de type ChatGPT et l'autre est un complément au résumé du projet.

Résumé du projet

L'auteur du projet, nichtdax, a compilé 9 projets de remplacement ChatGPT open source. Ils seront ensuite présentés un par un.

Adresse du projet : https://github.com/nichtdax/awesome-totally-open-chatgpt

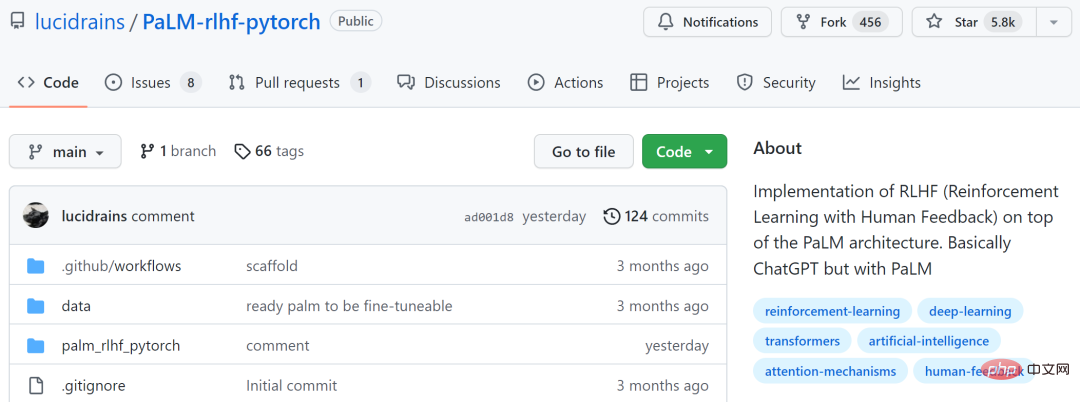

PaLM-rlhf-pytorch

ème Un projet est "PaLM-rlhf-pytorch" et l'auteur du projet est Phil Wang. Ce projet est une implémentation de RLHF (Reinforcement Learning with Human Feedback) au-dessus de l'architecture PaLM, qui est essentiellement ChatGPT utilisant PaLM.

Ce projet a reçu 5,8k étoiles sur GitHub.

Adresse du projet : https://github.com/lucidrains/PaLM-rlhf-pytorch

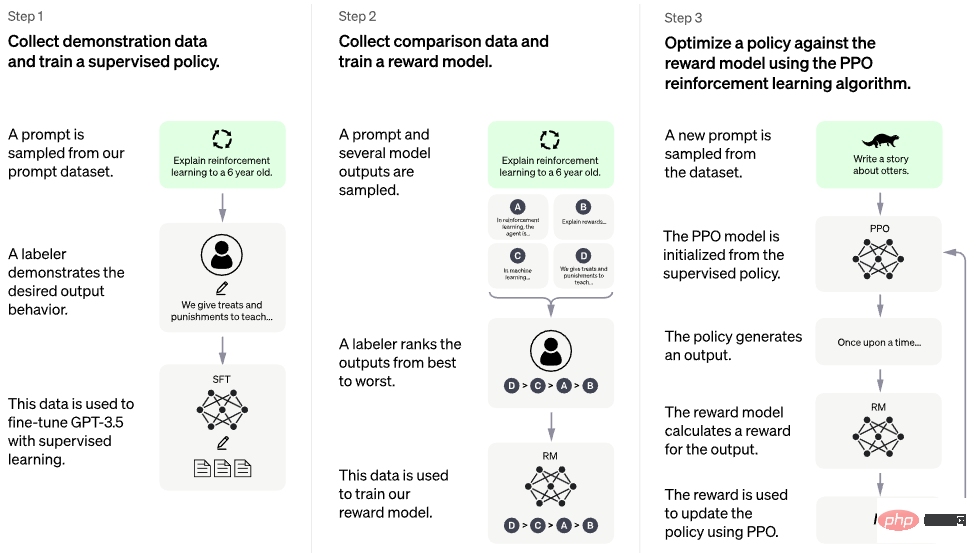

L'image ci-dessous montre le processus de formation.

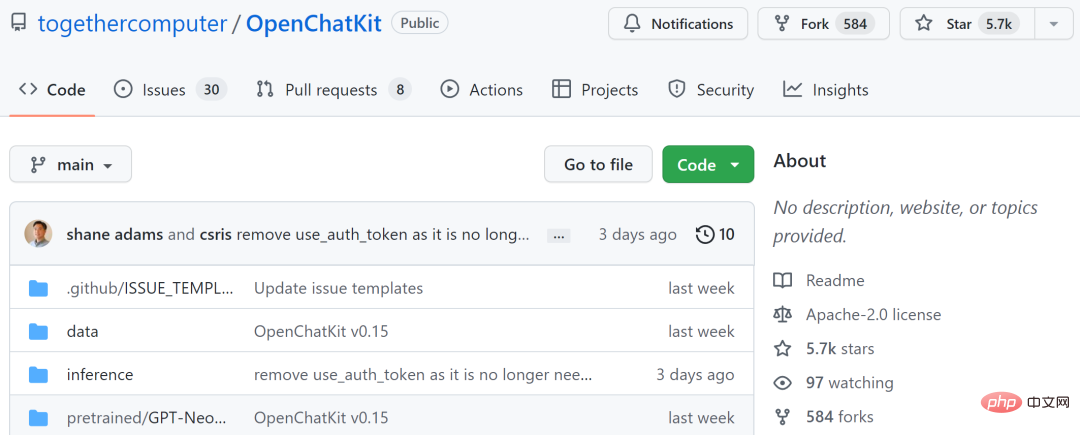

OpenChatKit

Le deuxième projet est "OpenChatKit", qui fournit une puissante base open source pour créer des chatbots spécialisés et généraux pour diverses applications. Le kit comprend un modèle de langage de 20 milliards de paramètres optimisé par les instructions, un modèle de réglage de 6 milliards de paramètres et un système de récupération évolutif qui couvre les dernières réponses d'un référentiel personnalisé.

OpenChatKit est formé sur l'ensemble de données de formation OIG-43M, qui est une union de Together, LAION et Ontocord.ai. L'auteur du projet a déclaré qu'il ne s'agissait pas seulement de la sortie d'un modèle, mais aussi du début d'un projet open source. Ils publient un ensemble d'outils et de processus et les améliorent continuellement grâce aux contributions de la communauté.

Ce projet a reçu 5,7k étoiles sur GitHub.

Adresse du projet : https://github.com/togethercomputer/OpenChatKit

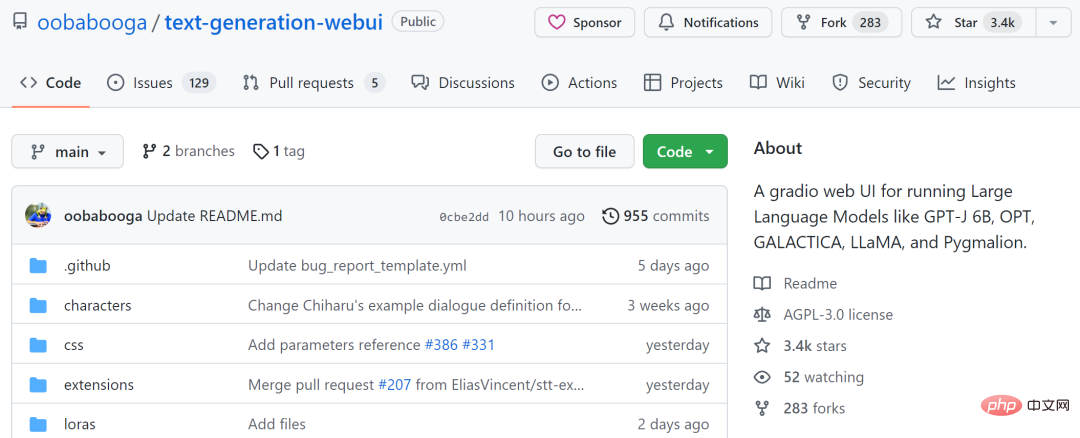

text-generation-webui

Le troisième projet est "text-generation-webui", qu'il est une interface utilisateur Web dégradée permettant d'exécuter de grands modèles de langage tels que GPT-J 6B, OPT, GALACTICA, LLaMA et Pygmalion. Ce projet vise à être le AUTOMATIC1111/stable-diffusion-webui de génération de texte.

Les fonctionnalités incluent l'utilisation de menus déroulants pour basculer entre différents modèles, fournissant un mode bloc-notes similaire au terrain de jeu OpenAI, un mode de discussion pour les conversations et les jeux de rôle, générant une belle sortie HTML pour GPT-4chan, et plus encore.

Le projet a reçu 3,4k sur GitHub.

Adresse du projet : https://github.com/oobabooga/text-generation-webui

KoboldAI-Client

Le quatrième projet est "KoboldAI-Client", qu'il est une interface frontale basée sur un navigateur qui implémente l'écriture assistée par l'IA via plusieurs modèles d'IA locaux et distants.

KoboldAI-Client fournit un ensemble standard d'outils comprenant la mémoire, les notes de l'auteur, les informations sur le monde, la sauvegarde et le chargement, les paramètres d'IA réglables, les options de formatage et la possibilité d'importer un jeu d'aventure textuel AI Dungeon existant. Vous pouvez activer le mode Aventure ou jouer à des jeux comme AI Dungeon Unleashed.

Ce projet a reçu 1,4k sur GitHub.

Adresse du projet : https://github.com/KoboldAI/KoboldAI-Client

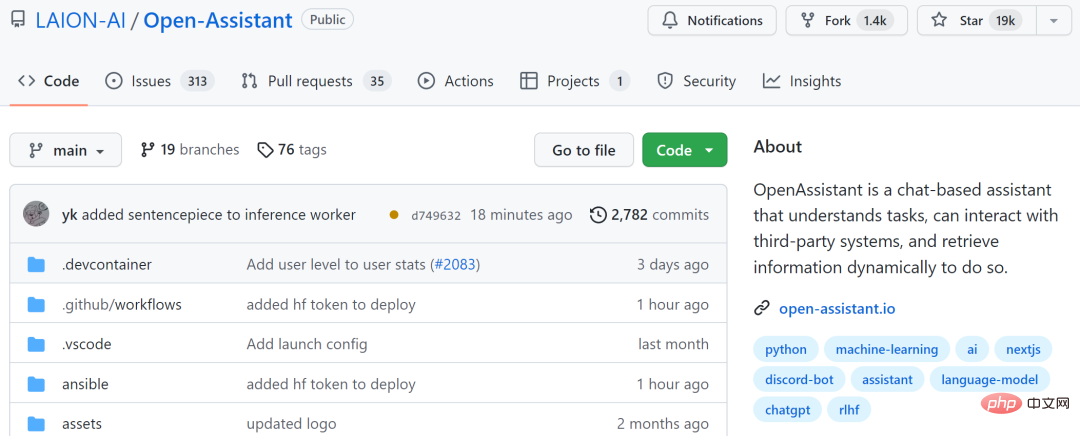

Open-Assistant

Le cinquième projet est "Open-Assistant", qui vise à rendre de grands modèles de langage basés sur le chat accessibles à tous. Les auteurs du projet espèrent déclencher une révolution dans l’innovation linguistique, tout comme une diffusion stable aide le monde à créer de l’art et des images de nouvelles manières.

L'auteur du projet prévoit de collecter des échantillons d'exécution d'instructions générés manuellement de haute qualité (instructions + réponses), avec un objectif supérieur à 50 000. Pour chaque indication collectée, ils échantillonneront plusieurs résultats d'achèvement. Ensuite, entrez dans la phase de formation RLHF basée sur le modèle d’instruction et de récompense.

Ce projet a reçu 19 000 étoiles sur GitHub.

Adresse du projet : https://github.com/LAION-AI/Open-Assistant

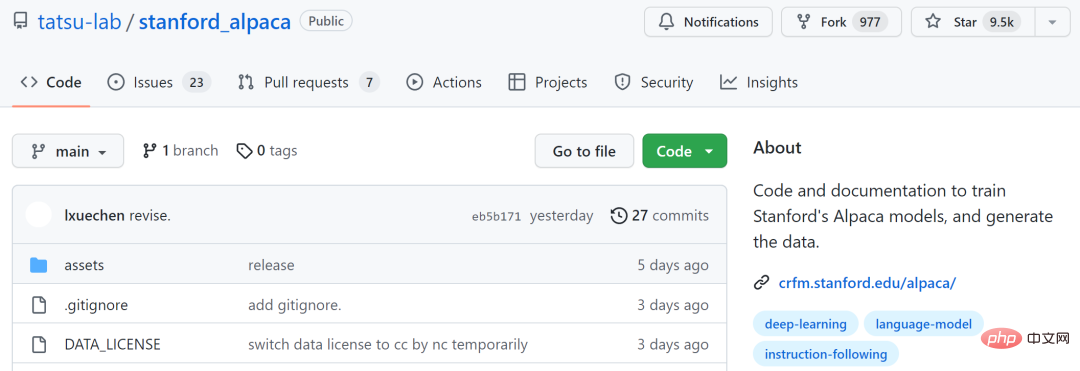

stanford_alpaca

Le sixième projet est "stanford_alpaca", qui vise à construire et partager un modèle LLaMA que les instructions suivent. Ce dépôt contient 52 000 données pour affiner le modèle, du code pour générer les données et du code pour affiner le modèle.

Ce projet a reçu 9,5k étoiles sur GitHub.

Adresse du projet : https://github.com/tatsu-lab/stanford_alpaca

ChatRWKV

Le septième projet est "ChatRWKV", qui est similaire à ChatGPT, mais est alimenté par le modèle RWKV (100 % RNN) est pris en charge et est open source. Selon les auteurs du projet, RWKV est actuellement le seul modèle RNN capable d'égaler les transformateurs en termes de qualité et d'évolutivité, tout en étant plus rapide et en économisant de la VRAM.

Ce projet a reçu 3,5k étoiles sur GitHub.

Adresse du projet : https://github.com/BlinkDL/ChatRWKV

ChatGLM-6B

Le huitième projet est le modèle de langage conversationnel open source et bilingue chinois-anglais Zhipu AI de la société, transformé à partir des réalisations technologiques de Tsinghua. Il est basé sur l'architecture du modèle de langage général (GLM) et a. 6,2 milliards de paramètres. Combiné à la technologie de quantification de modèle, les utilisateurs peuvent le déployer localement sur des cartes graphiques grand public (un minimum de 6 Go de mémoire vidéo est requis au niveau de quantification INT4).

ChatGLM-6B utilise une technologie similaire à ChatGPT, optimisée pour les questions et réponses et le dialogue en chinois. Après une formation bilingue en chinois et en anglais avec environ 1T d'identifiants, complétée par un réglage fin supervisé, un libre-service de feedback, un apprentissage par renforcement du feedback humain et d'autres technologies, les 6,2 milliards de paramètres ChatGLM-6B ont été capables de générer des réponses tout à fait cohérentes avec préférences humaines.

Cependant, en raison de la petite échelle de ChatGLM-6B, il est actuellement connu pour avoir un certain nombre de limitations, telles que des erreurs de logique factuelle/mathématique, une génération possible de contenu nuisible/biaisé, de faibles capacités contextuelles et une auto-évaluation. Confusion et génération d'instructions anglaises qui contredisent complètement les instructions chinoises.

Ce projet a reçu 6 000 étoiles sur GitHub.

Adresse du projet : https://github.com/THUDM/ChatGLM-6B

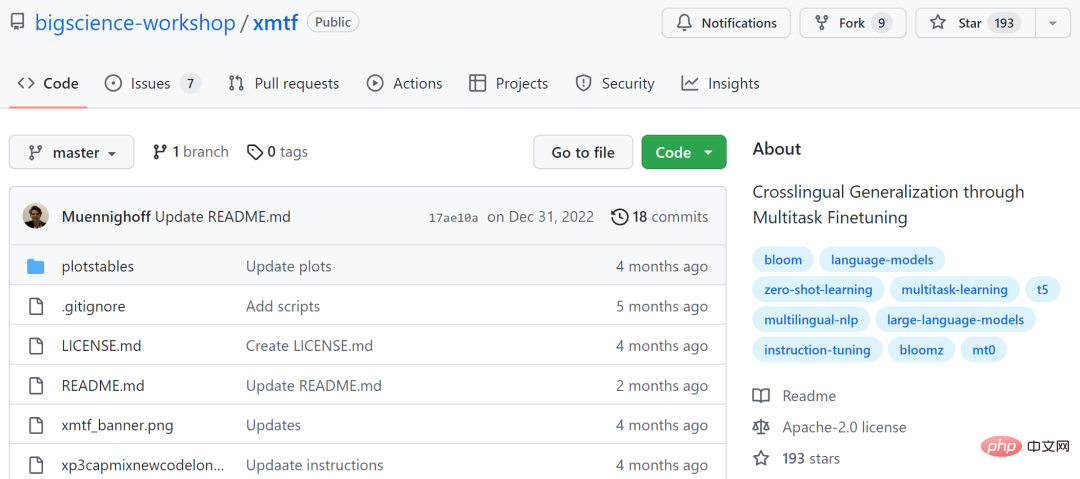

xmtf

Le neuvième projet est "xmtf", qui contient le document de création "Généralisation multilingue " Tous les composants de BLOOMZ, mT0 et xP3 introduits dans "via Multitask Finetuning".

Parmi eux, BLOOMZ est un modèle multilingue de 176 milliards de paramètres et en libre accès ; mT0 (fait ici spécifiquement référence au T5X de Google est un ensemble de données supervisé en 46 langues, avec des invites en anglais et une traduction automatique) ;

Adresse du projet : https://github.com/bigscience-workshop/xmtf

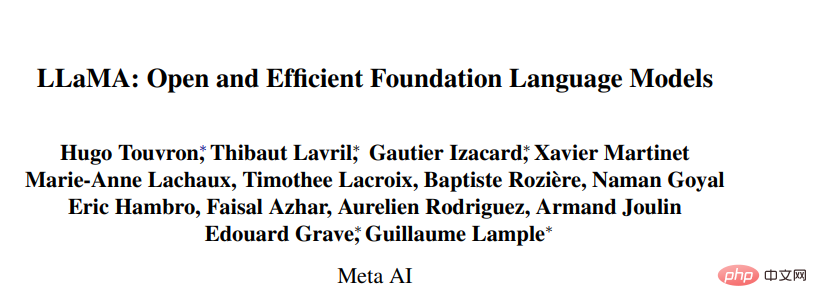

En plus des modèles mentionnés ci-dessus, le projet de remplacement ChatGPT comprend également de grands modèles basés sur Meta open source Quelques études sur la série LLaMA (Large Language Model Meta AI). Le nombre de paramètres dans cette série de modèles varie de 7 milliards à 65 milliards. Le modèle LLaMA avec 13 milliards de paramètres peut surpasser GPT-3 (175 milliards de paramètres) « sur la plupart des benchmarks » et peut fonctionner sur un seul GPU V100 tandis que le plus grand modèle LLaMA avec 65 milliards de paramètres est comparable à Google Chinchilla-70B et PaLM- ; 540B.

- Lien papier : https://research.facebook.com/publications/llama-open-and-efficient-foundation-lingual-models/

- Lien GitHub : https://github. com/facebookresearch/llama

Sur la base de cette recherche, les développeurs ont également proposé plusieurs projets open source.

llama.cpp peut exécuter LLaMA sans GPU

Le projetllama.cpp a implémenté LLaMA fonctionnant sur MacBook et les développeurs ont exécuté avec succès LLaMA 7B sur Raspberry Pi avec 4 Go de RAM. En résumé, les développeurs peuvent exécuter des modèles LLaMA même s’ils ne disposent pas de GPU.

Adresse du projet : https://github.com/ggerganov/llama.cpp

ChatLLaMA

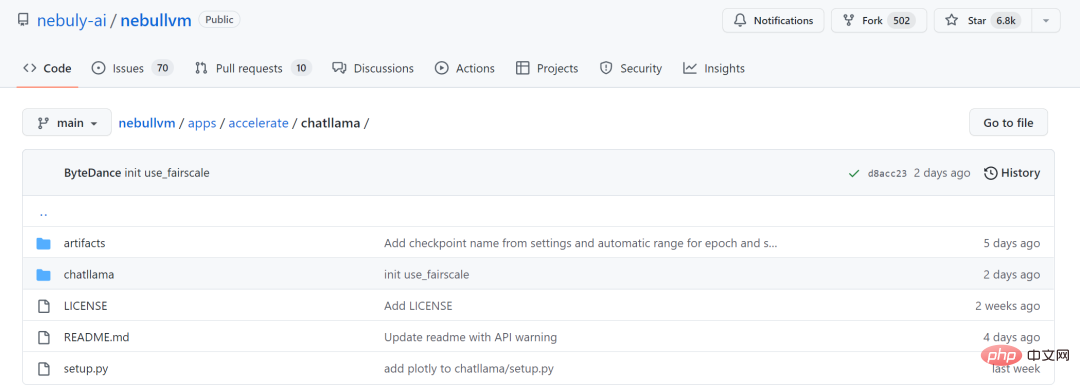

La série grand modèle LLaMA n'utilisant pas la méthode RLHF, la startup Nebuly AI a open source la méthode d'entraînement de la version RLHF de LLaMA (ChatLLaMA). Son processus de formation est similaire à ChatGPT et le projet permet de créer des services de style ChatGPT basés sur des modèles LLaMA pré-entraînés. Par rapport à ChatGPT, LLaMA a une architecture plus petite, mais le processus de formation et l'inférence sur un seul GPU sont plus rapides et moins chers ; la bibliothèque prend également en charge toutes les architectures de modèles LLaMA (7B, 13B, 33B, 65B), afin que les utilisateurs puissent déduire leurs préférences de performances. affiner le modèle.

Adresse du projet : https://github.com/nebuly-ai/nebullvm/tree/main/apps/accelerate/chatllama

Dans l'attente de voir davantage de projets open source nous rejoindre l'avenir.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Dix outils d'annotation de texte gratuits open source recommandés

Mar 26, 2024 pm 08:20 PM

Dix outils d'annotation de texte gratuits open source recommandés

Mar 26, 2024 pm 08:20 PM

L'annotation de texte est le travail d'étiquettes ou de balises correspondant à un contenu spécifique dans le texte. Son objectif principal est d’apporter des informations complémentaires au texte pour une analyse et un traitement plus approfondis, notamment dans le domaine de l’intelligence artificielle. L'annotation de texte est cruciale pour les tâches d'apprentissage automatique supervisées dans les applications d'intelligence artificielle. Il est utilisé pour entraîner des modèles d'IA afin de mieux comprendre les informations textuelles en langage naturel et d'améliorer les performances de tâches telles que la classification de texte, l'analyse des sentiments et la traduction linguistique. Grâce à l'annotation de texte, nous pouvons apprendre aux modèles d'IA à reconnaître les entités dans le texte, à comprendre le contexte et à faire des prédictions précises lorsque de nouvelles données similaires apparaissent. Cet article recommande principalement de meilleurs outils d'annotation de texte open source. 1.LabelStudiohttps://github.com/Hu

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

15 outils d'annotation d'images gratuits open source recommandés

Mar 28, 2024 pm 01:21 PM

15 outils d'annotation d'images gratuits open source recommandés

Mar 28, 2024 pm 01:21 PM

L'annotation d'images est le processus consistant à associer des étiquettes ou des informations descriptives à des images pour donner une signification et une explication plus profondes au contenu de l'image. Ce processus est essentiel à l’apprentissage automatique, qui permet d’entraîner les modèles de vision à identifier plus précisément les éléments individuels des images. En ajoutant des annotations aux images, l'ordinateur peut comprendre la sémantique et le contexte derrière les images, améliorant ainsi la capacité de comprendre et d'analyser le contenu de l'image. L'annotation d'images a un large éventail d'applications, couvrant de nombreux domaines, tels que la vision par ordinateur, le traitement du langage naturel et les modèles de vision graphique. Elle a un large éventail d'applications, telles que l'assistance aux véhicules pour identifier les obstacles sur la route, en aidant à la détection. et le diagnostic des maladies grâce à la reconnaissance d'images médicales. Cet article recommande principalement de meilleurs outils d'annotation d'images open source et gratuits. 1.Makesens

Recommandé : Excellent projet de détection et de reconnaissance des visages open source JS

Apr 03, 2024 am 11:55 AM

Recommandé : Excellent projet de détection et de reconnaissance des visages open source JS

Apr 03, 2024 am 11:55 AM

La technologie de détection et de reconnaissance des visages est déjà une technologie relativement mature et largement utilisée. Actuellement, le langage d'application Internet le plus utilisé est JS. La mise en œuvre de la détection et de la reconnaissance faciale sur le front-end Web présente des avantages et des inconvénients par rapport à la reconnaissance faciale back-end. Les avantages incluent la réduction de l'interaction réseau et de la reconnaissance en temps réel, ce qui réduit considérablement le temps d'attente des utilisateurs et améliore l'expérience utilisateur. Les inconvénients sont les suivants : il est limité par la taille du modèle et la précision est également limitée ; Comment utiliser js pour implémenter la détection de visage sur le web ? Afin de mettre en œuvre la reconnaissance faciale sur le Web, vous devez être familier avec les langages et technologies de programmation associés, tels que JavaScript, HTML, CSS, WebRTC, etc. Dans le même temps, vous devez également maîtriser les technologies pertinentes de vision par ordinateur et d’intelligence artificielle. Il convient de noter qu'en raison de la conception du côté Web

Le document multimodal Alibaba 7B comprenant le grand modèle remporte le nouveau SOTA

Apr 02, 2024 am 11:31 AM

Le document multimodal Alibaba 7B comprenant le grand modèle remporte le nouveau SOTA

Apr 02, 2024 am 11:31 AM

Nouveau SOTA pour des capacités de compréhension de documents multimodaux ! L'équipe Alibaba mPLUG a publié le dernier travail open source mPLUG-DocOwl1.5, qui propose une série de solutions pour relever les quatre défis majeurs que sont la reconnaissance de texte d'image haute résolution, la compréhension générale de la structure des documents, le suivi des instructions et l'introduction de connaissances externes. Sans plus tarder, examinons d’abord les effets. Reconnaissance et conversion en un clic de graphiques aux structures complexes au format Markdown : Des graphiques de différents styles sont disponibles : Une reconnaissance et un positionnement de texte plus détaillés peuvent également être facilement traités : Des explications détaillées sur la compréhension du document peuvent également être données : Vous savez, « Compréhension du document " est actuellement un scénario important pour la mise en œuvre de grands modèles linguistiques. Il existe de nombreux produits sur le marché pour aider à la lecture de documents. Certains d'entre eux utilisent principalement des systèmes OCR pour la reconnaissance de texte et coopèrent avec LLM pour le traitement de texte.

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Étapes d'installation : 1. Téléchargez le logiciel ChatGTP depuis le site officiel ou la boutique mobile de ChatGTP ; 2. Après l'avoir ouvert, dans l'interface des paramètres, sélectionnez la langue chinoise 3. Dans l'interface de jeu, sélectionnez le jeu homme-machine et définissez la langue. Spectre chinois ; 4. Après avoir démarré, entrez les commandes dans la fenêtre de discussion pour interagir avec le logiciel.

Fraichement publié! Un modèle open source pour générer des images de style anime en un seul clic

Apr 08, 2024 pm 06:01 PM

Fraichement publié! Un modèle open source pour générer des images de style anime en un seul clic

Apr 08, 2024 pm 06:01 PM

Permettez-moi de vous présenter le dernier projet open source AIGC-AnimagineXL3.1. Ce projet est la dernière itération du modèle texte-image sur le thème de l'anime, visant à offrir aux utilisateurs une expérience de génération d'images d'anime plus optimisée et plus puissante. Dans AnimagineXL3.1, l'équipe de développement s'est concentrée sur l'optimisation de plusieurs aspects clés pour garantir que le modèle atteigne de nouveaux sommets en termes de performances et de fonctionnalités. Premièrement, ils ont élargi les données d’entraînement pour inclure non seulement les données des personnages du jeu des versions précédentes, mais également les données de nombreuses autres séries animées bien connues dans l’ensemble d’entraînement. Cette décision enrichit la base de connaissances du modèle, lui permettant de mieux comprendre les différents styles et personnages d'anime. AnimagineXL3.1 introduit un nouvel ensemble de balises et d'esthétiques spéciales

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Le FP8 et la précision de quantification inférieure en virgule flottante ne sont plus le « brevet » du H100 ! Lao Huang voulait que tout le monde utilise INT8/INT4, et l'équipe Microsoft DeepSpeed a commencé à exécuter FP6 sur A100 sans le soutien officiel de NVIDIA. Les résultats des tests montrent que la quantification FP6 de la nouvelle méthode TC-FPx sur A100 est proche ou parfois plus rapide que celle de INT4, et a une précision supérieure à celle de cette dernière. En plus de cela, il existe également une prise en charge de bout en bout des grands modèles, qui ont été open source et intégrés dans des cadres d'inférence d'apprentissage profond tels que DeepSpeed. Ce résultat a également un effet immédiat sur l'accélération des grands modèles : dans ce cadre, en utilisant une seule carte pour exécuter Llama, le débit est 2,65 fois supérieur à celui des cartes doubles. un