Essayer de faire comprendre le langage humain aux ordinateurs a toujours été une difficulté insurmontable dans le domaine de l’intelligence artificielle.

Les premiers modèles de traitement du langage naturel utilisaient généralement des fonctionnalités conçues artificiellement, obligeant des linguistes spécialisés à écrire manuellement des modèles. Cependant, les résultats finaux n'étaient pas idéaux et même la recherche sur l'IA est tombée dans un hiver froid.

Chaque fois que je licencie un linguiste, le système de reconnaissance vocale devient plus précis.

Chaque fois que je licencie un linguiste, les performances de la reconnaissance vocale augmentent.

——Frederick Jelinek

Avec les modèles statistiques et les modèles de pré-formation à grande échelle, l'extraction de caractéristiques n'est plus nécessaire, mais elle est toujours nécessaire à faire. Spécifiez les tâches d'annotation des données, et le problème le plus critique est : le modèle formé ne comprend toujours pas le langage humain.

Alors, devrions-nous partir de la forme originale du langage et réétudier : comment les humains ont-ils acquis la capacité de parler ?

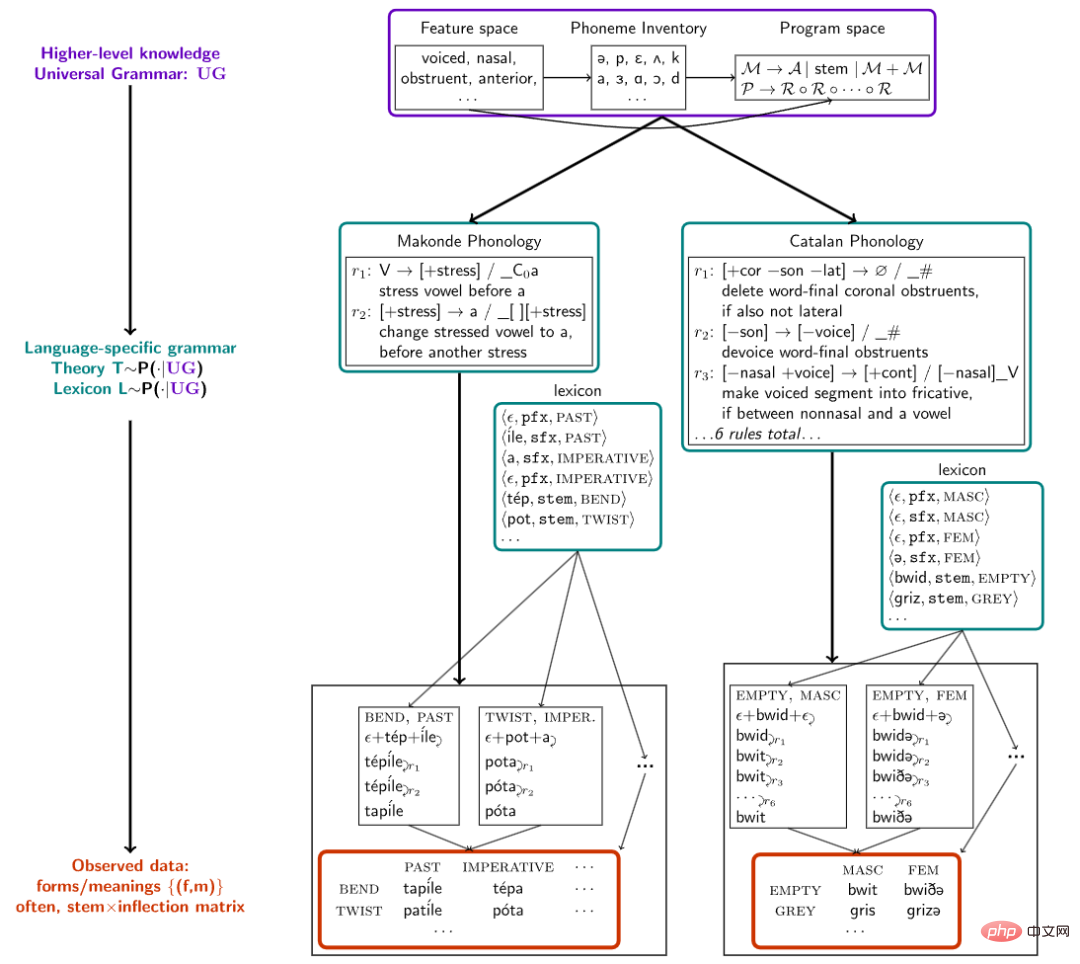

Des chercheurs de l'Université Cornell, du MIT et de l'Université McGill ont récemment publié un article dans Nature Communications proposant un cadre de synthèse algorithmique de modèles dans la partie la plus fondamentale du langage humain, à savoir les phonèmes lexicaux. En morpho-phonologie, on a commencé à apprendre à l'IA à apprendre langage et construire la morphologie du langage directement à partir des sons.

Lien papier : https://www.nature.com/articles/s41467-022-32012-w

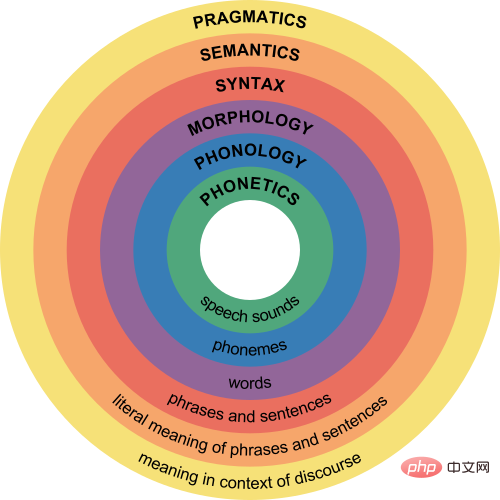

La morphologie et la phonologie sont l'une des branches de la linguistique, se concentrant principalement sur les morphèmes (c'est-à-dire les plus petites unités de sens) Les changements sonores qui se produisent lorsqu'ils sont combinés en mots tentent de donner une série de règles pour prédire les changements sonores réguliers des phonèmes dans la langue.

Par exemple, le morphème pluriel en anglais s'écrit -s ou -es, mais il existe trois prononciations [s], [z] et [Öz]. Par exemple, cats se prononce /kæts/ et dogs est prononcé. prononcé /dagz/ , les chevaux se prononcent /hɔrsåz/.

Lorsque les humains apprennent à convertir la prononciation plurielle, ils se rendent d'abord compte que le suffixe pluriel est en fait /z/ basé sur la morphologie ; puis basé sur la phonologie, le suffixe est basé sur la phonologie du radical, comme les consonnes sourdes. Lorsqu'ils sont convertis en /s/ ou /Öz/

D'autres langues ont également les mêmes règles lexicales phonémiques. Les chercheurs ont collecté 70 ensembles de données provenant de manuels phonémiques dans 58 langues, chaque ensemble de données ne contient que des dizaines à des centaines de. mots et ne contenant que quelques phénomènes grammaticaux, des expériences ont montré que la méthode de recherche de structures grammaticales dans une langue naturelle peut également simuler le processus d'apprentissage du langage par les nourrissons.

En effectuant une inférence bayésienne hiérarchique sur ces ensembles de données linguistiques, les chercheurs ont découvert que le modèle peut acquérir de nouvelles règles morphophonémiques à partir d'un ou de quelques exemples seulement et est capable d'extraire des modèles communs à plusieurs langues et de les exprimer de manière compacte et compréhensible par l'homme. formulaire.

L'intelligence humaine se reflète principalement dans la capacité à établir une théorie du monde cognitif. Par exemple, après la formation du langage naturel, les linguistes ont résumé un ensemble de règles pour aider les enfants. Apprenez une langue spécifique plus rapidement, mais le modèle d'IA actuel ne peut pas résumer les règles et former un cadre théorique pouvant être compris par d'autres.

Avant de construire un modèle, nous devons résoudre un problème fondamental : "Comment décrire un mot." Par exemple, le processus d'apprentissage d'un mot comprend la compréhension du concept, de l'intention, de l'utilisation, de la prononciation et de la signification du mot.

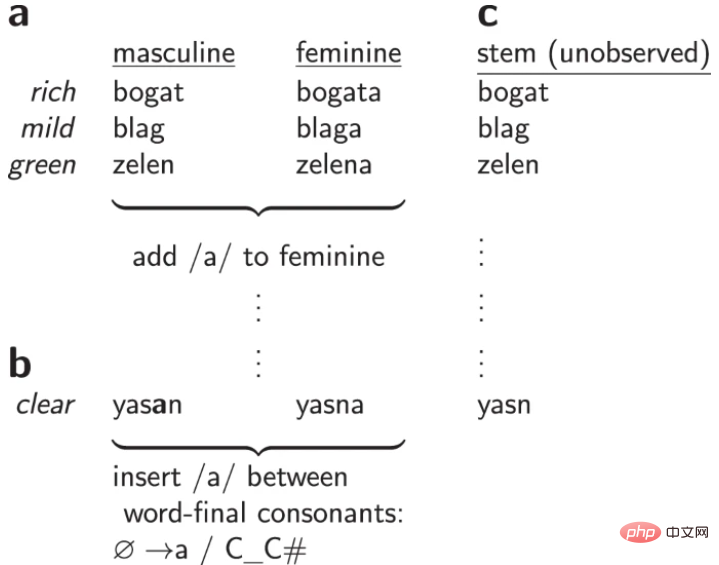

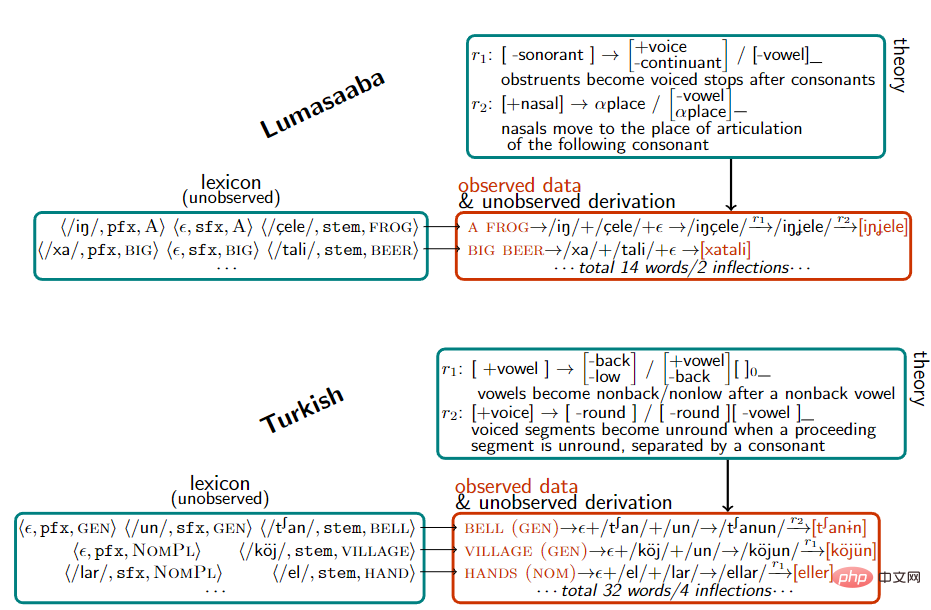

Lors de la construction du vocabulaire, les chercheurs ont représenté chaque mot comme une paire de , par exemple, ouvert est représenté par εn/, [stem: OPEN]>, le passé est représenté par /, [tense: PAST]> et l'ouvert combiné est représenté par εnd/, [stem: OPEN, [tense: PAST]]>

Après avoir obtenu l'ensemble de données, les chercheurs ont construit un modèle pour expliquer la génération de règles grammaticales sur un ensemble de paires par inférence de probabilité postérieure maximale pour expliquer les changements de mots.

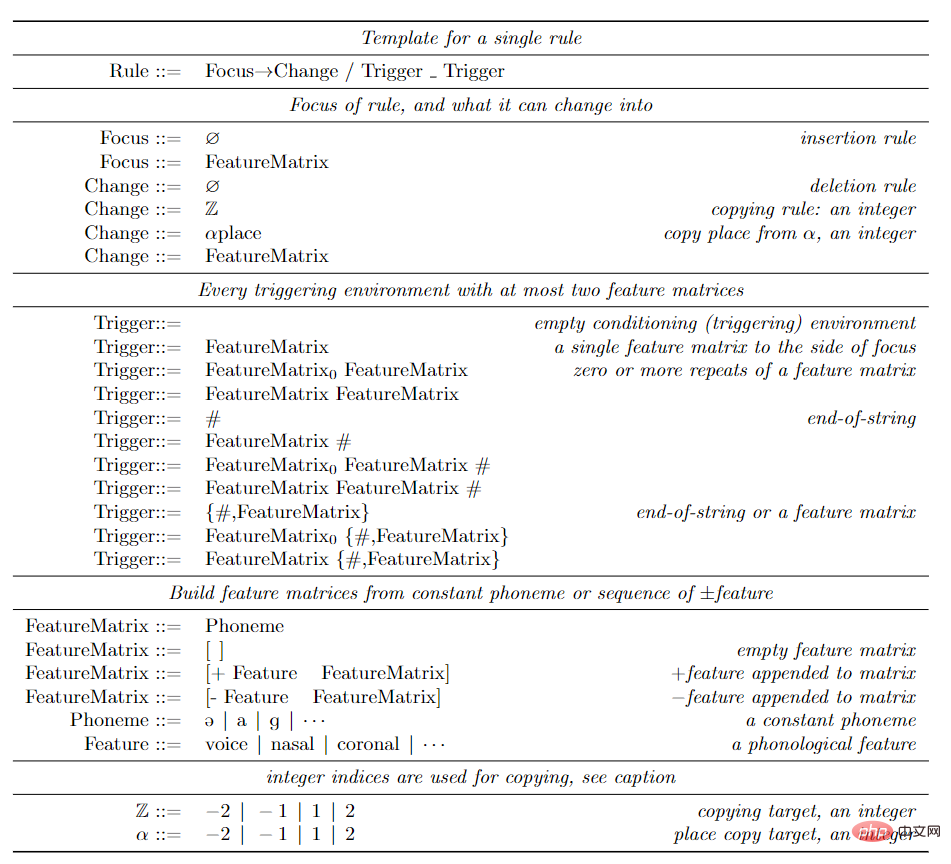

Dans la représentation des sons, les phonèmes (sons atomiques) sont représentés comme des vecteurs de caractéristiques binaires, telles que /m/, /n/, qui sont des sons nasaux, puis des règles phonétiques sont définies en fonction de cet espace de caractéristiques .

Les chercheurs utilisent la méthode classique d'expression de règles, c'est-à-dire la mémoire dépendante du contexte, parfois également appelée règles de style SPE, qui sont largement utilisées dans la représentation du modèle sonore de l'anglais.

(focus)→(structural_change)/(left_trigger)_(right_trigger), ce qui signifie que tant que l'environnement de déclenchement gauche/droite est proche de la gauche/droite du focus, le le phonème focus changera en fonction de la structure Convert.

L'environnement de déclenchement précise la connexion des traits (représentant l'ensemble des phonèmes). Par exemple, en anglais, tant que le phonème de gauche est [-sonorant], la prononciation à la fin du mot sera. passez de /d/ à /t/ , la règle écrite est [-sonorant] → [-voice]/[-voice -sonorant]_# Par exemple, après avoir marché, appliquez cette règle, la prononciation est convertie de /wɔkd/. à /wɔkt/.

Lorsque de telles règles sont contraintes de ne pas s'appliquer cycliquement à leurs propres sorties, les règles et lexiques correspondent à des fonctions rationnelles bidirectionnelles, qui à leur tour correspondent à des transductions à états finis. Nous soutenons que l'espace des convertisseurs d'états finis est suffisamment expressif pour couvrir les phénomènes empiriques connus en morphophonétique et représente une limite au pouvoir descriptif des utilisations pratiques de la théorie phonétique.

Afin d'apprendre cette grammaire, les chercheurs ont adopté la méthode Bayesian Program Learning (BPL). Modélisez chaque règle de grammaire T comme un programme dans un langage de programmation qui capture les contraintes spécifiques au domaine de l'espace du problème. La structure linguistique commune à toutes les langues est appelée grammaire universelle. Cette approche peut être considérée comme un exemple moderne d'une approche linguistique de longue date et utilise des représentations génératives compréhensibles par l'homme pour formaliser la grammaire universelle.

Après avoir défini le problème que BPL doit résoudre, l'espace de recherche de tous les programmes est infini, ne donne aucune indication sur la façon de résoudre ce problème et manque de méthodes comme la descente de gradient ou la chaîne de Markov Monte Carlo Dans le cas de stationnarité locale exploitée par de tels algorithmes d'optimisation locale, les chercheurs ont adopté une stratégie de synthèse de programme basée sur des contraintes pour transformer le problème d'optimisation en un problème de satisfaction de contraintes combinatoires et ont utilisé un solveur de satisfiabilité booléenne (SAT) pour le résoudre.

Ces solveurs mettent en œuvre une recherche exhaustive mais relativement efficace et garantissent qu'une solution optimale sera trouvée si le temps est suffisant. La plus petite grammaire cohérente avec certaines données peut être résolue à l'aide du synthétiseur procédural Sketch, mais doit respecter la limite supérieure de la taille de la grammaire.

Mais en pratique, les techniques de recherche exhaustives utilisées par les solveurs SAT ne peuvent pas s'adapter aux quantités massives de règles nécessaires pour interpréter de grands corpus.

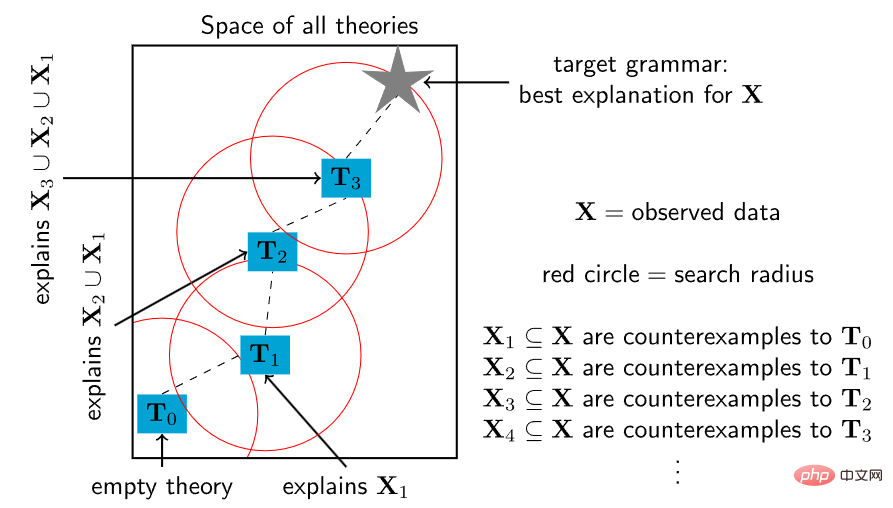

Pour adapter le solveur à des théories vastes et complexes, les chercheurs se sont inspirés d'une caractéristique fondamentale de l'acquisition du langage par les enfants et de la construction de théories par les scientifiques.

Les enfants n'apprennent pas une langue du jour au lendemain, mais enrichissent progressivement leur compréhension de la grammaire et du vocabulaire à travers des étapes intermédiaires du développement du langage. De même, une théorie scientifique complexe peut commencer par un simple noyau conceptuel et se développer ensuite progressivement pour englober un nombre croissant de phénomènes linguistiques.

Sur la base des idées ci-dessus, les chercheurs ont conçu un algorithme de synthèse de programme, en partant d'un petit programme, puis en utilisant à plusieurs reprises le solveur SAT pour trouver de petits points de modification afin qu'il puisse expliquer de plus en plus de données. Plus précisément, trouvez un contre-exemple à la théorie actuelle, puis utilisez un solveur pour explorer de manière exhaustive l'espace de toutes les petites modifications de la théorie qui peuvent s'adapter à ce contre-exemple.

Mais cette méthode heuristique n'a pas la garantie d'intégrité du solveur SAT : bien qu'elle appelle à plusieurs reprises un solveur SAT complet et précis, elle ne garantit pas de trouver une solution optimale, mais chaque appel répété est meilleur que d'appeler directement l'ensemble du solveur SAT. beaucoup plus difficile à optimiser. Parce que contraindre chaque nouvelle théorie à être proche de sa théorie précédente dans l'espace théorique entraîne un rétrécissement polynomial du problème de satisfaction des contraintes, rendant le temps de recherche exponentiellement plus long pour les solveurs SAT dans le pire des cas.

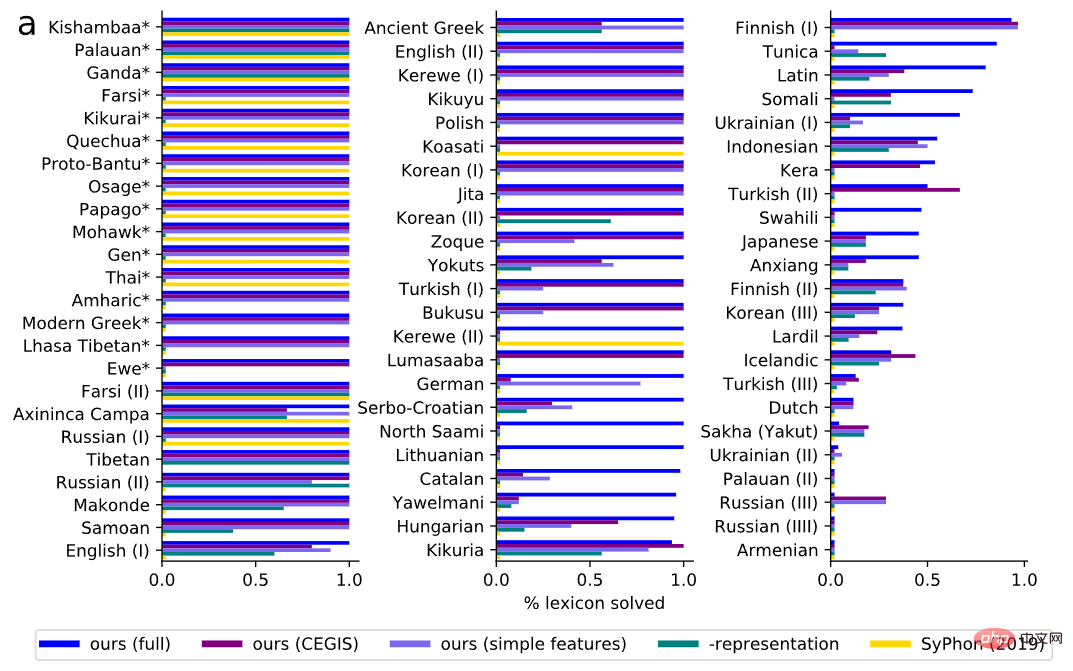

Au cours de la phase d'évaluation expérimentale, les chercheurs ont collecté 70 questions tirées de manuels de linguistique, chacune nécessitant une analyse complète de certaines formes de théorie en langage naturel. Les problèmes varient en difficulté et couvrent une grande variété de phénomènes du langage naturel.

Les langues naturelles sont également diverses, y compris les langues tonales, par exemple, en Kerewe (une langue bantoue en Tanzanie), compter c'est /kubala/, mais compter c'est /kukíbála/, où l'accent marque un ton aigu .

Il existe également des langues avec une harmonie vocalique. Par exemple, la Turquie a /el/ et /t∫an/, qui représentent respectivement des mains et des cloches, et /el-ler/ et /t∫an-lar/, qui représentent respectivement des mains et des cloches. représentent respectivement les mains et la forme plurielle des cloches et de nombreux autres phénomènes linguistiques, tels que l'assimilation et les formes extensionnelles.

En évaluation, nous mesurons d’abord la capacité du modèle à découvrir le vocabulaire correct. Par rapport au vocabulaire de la vérité terrain, le modèle a trouvé une grammaire qui correspondait correctement à l'ensemble du vocabulaire de la question dans 60 % des points de référence et interprétait correctement une grande partie du vocabulaire dans 79 % des questions.

Souvent, le vocabulaire correct pour chaque problème est plus spécifique que la règle correcte, et toutes les règles qui produisent des données complètes à partir du vocabulaire correct doivent être équivalentes sur le plan observationnel à toutes les règles sous-jacentes que le modèle peut proposer. Par conséquent, la cohérence avec le lexique de vérité sous-jacent doit être utilisée comme mesure pour mesurer si les règles synchronisées se comportent correctement sur les données, et cette évaluation est liée à la qualité des règles.

Pour tester cette hypothèse, les chercheurs ont sélectionné au hasard 15 questions et consulté un linguiste professionnel pour évaluer les règles découvertes. Le rappel (la proportion de règles de parole réelles correctement récupérées) et la précision (la proportion de règles récupérées qui se sont réellement produites) ont été mesurés simultanément. Sous les indicateurs de précision et de rappel, on constate que l'exactitude des règles est positivement corrélée à l'exactitude du vocabulaire.

Lorsque le système obtient tout le lexique correct, il introduit rarement des règles non pertinentes (haute précision) et obtient presque toujours toutes les règles correctes (rappel élevé).

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

qu'est-ce que le HDMI

qu'est-ce que le HDMI

Quelle devise est l'USD ?

Quelle devise est l'USD ?

Maximiser la page Web

Maximiser la page Web

Solution à l'erreur de syntaxe lors de l'exécution de Python

Solution à l'erreur de syntaxe lors de l'exécution de Python

CSS au-delà de l'affichage...

CSS au-delà de l'affichage...

Les étincelles Douyin peuvent-elles être rallumées si elles sont éteintes depuis plus de trois jours ?

Les étincelles Douyin peuvent-elles être rallumées si elles sont éteintes depuis plus de trois jours ?

Comment commenter le code en HTML

Comment commenter le code en HTML

Quelles sont les méthodes permettant à Docker d'entrer dans le conteneur ?

Quelles sont les méthodes permettant à Docker d'entrer dans le conteneur ?