Périphériques technologiques

Périphériques technologiques

IA

IA

Débarrassez-vous du « clickbait », autre chef-d'œuvre open source de l'équipe Tsinghua !

Débarrassez-vous du « clickbait », autre chef-d'œuvre open source de l'équipe Tsinghua !

Débarrassez-vous du « clickbait », autre chef-d'œuvre open source de l'équipe Tsinghua !

En tant que personne qui a du mal à nommer, la chose la plus gênante pour moi lorsque j'écris des dissertations au lycée est que je peux écrire de bons articles mais que je ne sais pas quel est le titre. Après avoir commencé à créer un compte public, j'ai perdu beaucoup. de cheveux à chaque fois que je pensais à un titre...

Récemment, j'ai enfin découvert la lumière du "naming waste" sur GitHub, une application intéressante à grand modèle lancée par l'Université Tsinghua et la communauté open source OpenBMB : "Title Capture ". Saisissez le contenu du texte pour générer un sujet d'actualité en un seul clic. titre !

Prêt à l'emploi dès la sortie de la boîte. Après l'avoir essayé, tout ce que je peux dire c'est : ça sent bon !

Expérience en ligne : https://live.openbmb.org/ant

GitHub : https://github.com/OpenBMB/CPM-Live

mentionné Pour Pour cet artefact qui fait la une des journaux, nous devons d'abord parler de son "corps" - le grand modèle CPM-Ant.

CPM-Ant est le premier modèle de dizaines de milliards à être formé en direct en Chine. La formation a duré 68 jours et s'est achevée le 5 août 2022 et a été officiellement publiée par OpenBMB !

- Cinq fonctionnalités exceptionnelles

- Quatre avancées innovantes majeures

- Le processus de formation est peu coûteux et respectueux de l'environnement !

- La chose la plus importante est - complètement open source !

En tant que première formation en direct de grands modèles chinois, CPM-Ant fournit une solution pratique réalisable dans la formation, le réglage fin, la compression, le raisonnement, l'application, etc. de grands modèles. Nous espérons fournir à différents adeptes différents aide et références.

Maintenant, jetons un coup d'œil au rapport sur le contenu des résultats de la version CPM-Ant !

Présentation du modèle

CPM-Ant est un modèle de langage chinois pré-entraîné open source avec 10B de paramètres. C'est également la première étape du processus de formation en direct CPM-Live.

L'ensemble du processus de formation est peu coûteux et respectueux de l'environnement. Il ne nécessite pas d'exigences matérielles ni de coûts de fonctionnement élevés. Il est basé sur la méthode de réglage delta et a obtenu d'excellents résultats au test de référence CUGE.

Le code, les fichiers journaux et les paramètres de modèle associés à CPM-Ant sont entièrement open source dans le cadre d'un accord de licence ouvert. En plus du modèle complet, OpenBMB propose également diverses versions compressées pour s'adapter à différentes configurations matérielles.

Les cinq fonctionnalités exceptionnelles de CPM-Ant :

(1) Efficacité informatique

Grâce à la boîte à outils BMTrain[1], il peut utiliser pleinement la capacité des ressources informatiques distribuées à former efficacement de grands modèles.

La formation de CPM-Ant a duré 68 jours et a coûté 430 000 yuans, soit 1/20 du coût d'environ 1,3 million de dollars de la formation du modèle T5-11B par Google. Les émissions de gaz à effet de serre de la formation CPM-Ant sont d'environ 4872 kg CO₂e, tandis que les émissions de la formation T5-11B sont de 46,7 t CO₂e[9]. La solution CPM-Ant représente environ 1/10 de ses émissions.

(2) Excellentes performances

Avec l'outil OpenDelta[3], il est très pratique d'adapter CPM-Ant aux tâches en aval grâce à un réglage fin incrémentiel.

Les expériences montrent que CPM-Ant obtient les meilleurs résultats sur 3/6 tâches CUGE en ajustant uniquement 6,3 millions de paramètres. Ce résultat surpasse les autres modèles entièrement paramétrés avec précision. Par exemple : le nombre de paramètres précis de CPM-Ant n'est que de 0,06 % de celui du CPM2 (paramètres 11B affinés).

(3) Économie de déploiement

Avec l'aide des boîtes à outils BMCook[7] et BMInf[4], CPM-Ant peut être piloté avec des ressources informatiques limitées.

Basé sur BMInf, il peut remplacer le cluster informatique et effectuer une inférence de grand modèle sur un seul GPU (même une carte graphique grand public telle que GTX 1060). Pour rendre le déploiement de CPM-Ant plus économique, OpenBMB utilise BMCook pour compresser davantage le modèle 10B d'origine en différentes versions. Le modèle compressé (7B, 3B, 1B, 300M) peut s'adapter aux besoins de différents scénarios à faibles ressources.

(4) Facile à utiliser

Qu'il s'agisse du modèle 10B original ou de la version compressée associée, il peut être facilement chargé et exécuté avec quelques lignes de code.

OpenBMB ajoutera également CPM-Ant à ModelCenter[8], facilitant ainsi le développement ultérieur du modèle.

(5) Démocratie ouverte

Le processus de formation de CPM-Ant est complètement ouvert.

OpenBMB publie tous les codes, fichiers journaux et archives de modèles en libre accès. CPM-Ant adopte également une licence ouverte qui permet la commercialisation.

Une pratique complète de formation de grands modèles

Pour les fabricants et les instituts de recherche capables de former de grands modèles, le processus de formation CPM-Ant fournit un enregistrement réel complet de formation de grands modèles chinois.

OpenBMB a publié la conception du modèle, le programme de formation, les exigences en matière de données et le code de mise en œuvre de la série de modèles CPM-Live. Sur la base de l'architecture de modèle de CPM-Live, il est possible de concevoir et de mettre en œuvre rapidement et facilement de grandes solutions de formation de modèles et d'organiser les données commerciales pertinentes pour terminer la recherche préalable du modèle et la préparation des données.

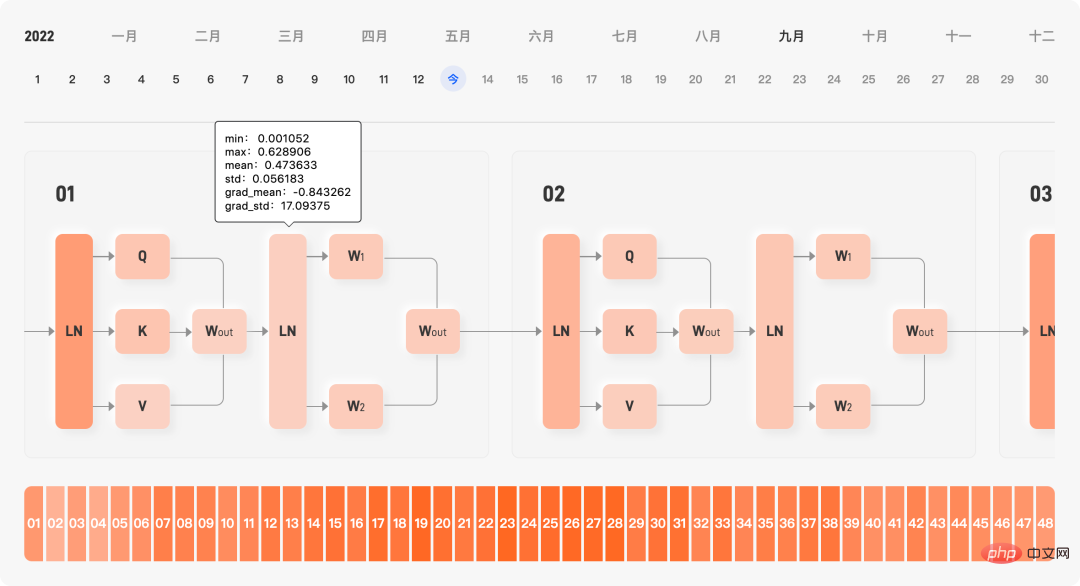

Le site officiel enregistre toutes les dynamiques d'entraînement au cours du processus d'entraînement, y compris la fonction de perte, le taux d'apprentissage, les données apprises, le débit, la taille du gradient, la courbe de coût et l'affichage en temps réel de la moyenne et de l'écart type des paramètres internes de le modèle, grâce à cette dynamique de formation, permet aux utilisateurs de diagnostiquer rapidement s'il y a des problèmes dans le processus de formation du modèle.

Affichage en temps réel des paramètres internes de la formation du modèle

De plus, les étudiants R&D d'OpenBMB mettent à jour chaque jour le résumé du dossier de formation en temps réel. Le résumé comprend la valeur de perte et la valeur de gradient. , la progression globale, et enregistre également les rencontres. Certains problèmes et bugs rencontrés au cours du processus de formation aident les utilisateurs à comprendre à l'avance les différents « creux » qui peuvent être rencontrés lors de la formation du modèle.

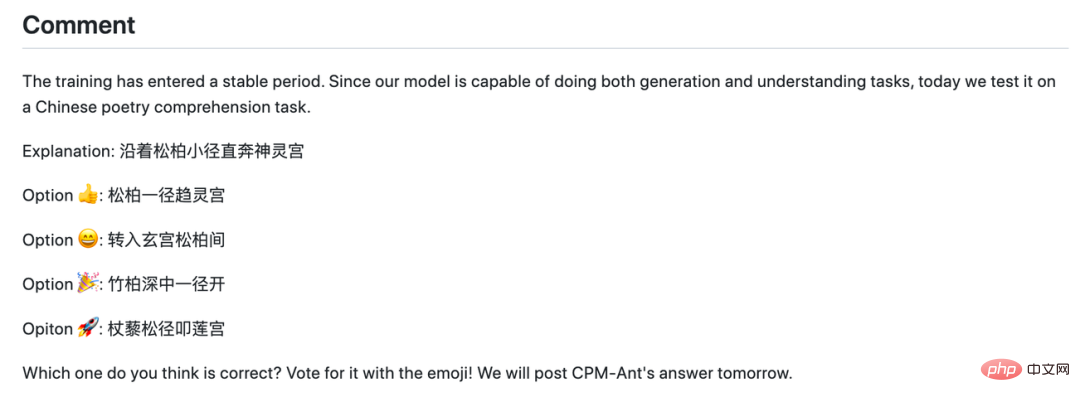

Les jours où la formation des modèles est "calme", le responsable R&D lancera également des citations célèbres, présentera les derniers articles et lancera même une activité de devinettes.

Une activité de devinette dans le journal

De plus, OpenBMB fournit également des solutions de formation rentables pour les entreprises qui ont réellement de grands besoins de formation de modèles, grâce à une technologie d'accélération de la formation pertinente, les coûts de formation ont augmenté. été réduite à des niveaux acceptables.

En utilisant la boîte à outils BMTrain[1], la puissance de calcul de dizaines de milliards de formations CPM-Ant de grands modèles ne coûte que 430 000 yuans (le coût actuel est calculé en fonction des prix du cloud public, le coût réel sera inférieur), soit 11B grand modèle T5 externe Environ 1/20 du coût estimé de 1,3 million de dollars !

Une solution de réglage fin très efficace qui a créé à plusieurs reprises SOTA

Comment CPM-Ant peut-il nous aider dans l'adaptation des tâches en aval ?

Pour les chercheurs sur de grands modèles, OpenBMB fournit une solution d'évaluation des performances de grands modèles basée sur un réglage fin efficace des paramètres, qui facilite une adaptation rapide des tâches en aval et une évaluation des performances du modèle.

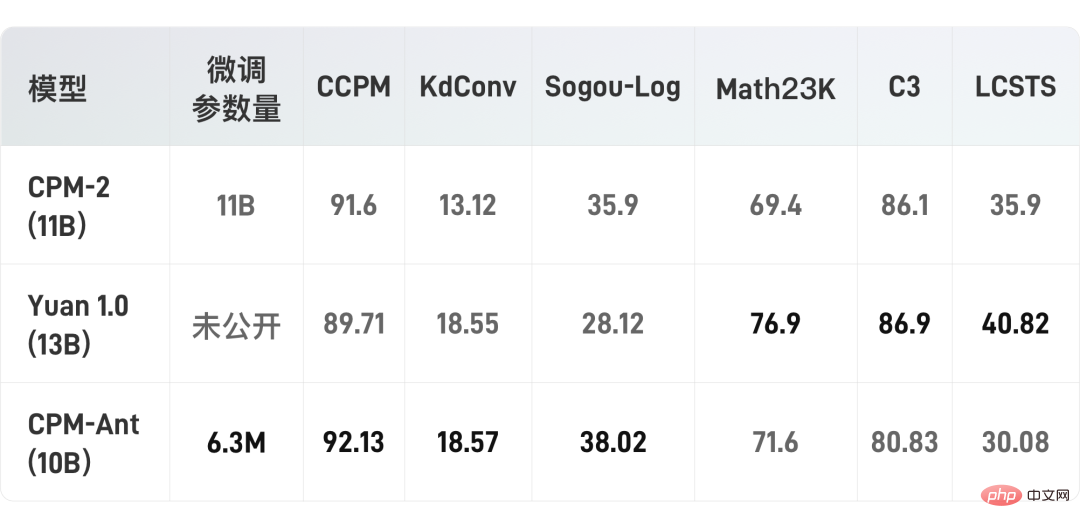

Utilisez un réglage fin efficace des paramètres, connu sous le nom de réglage delta, pour évaluer les performances de CPM-Ant sur six tâches en aval. LoRA [2] a été utilisé dans l'expérience, qui insère deux matrices réglables de bas rang dans chaque couche d'attention et gèle tous les paramètres du modèle original. Grâce à cette approche, seuls 6,3 millions de paramètres ont été affinés par tâche, ce qui représente seulement 0,067 % du total des paramètres.

Avec l'aide d'OpenDelta[3], OpenBMB a mené toutes les expériences sans modifier le code du modèle original. Il convient de noter qu'aucune méthode d'augmentation des données n'a été utilisée lors de l'évaluation du modèle CPM-Ant sur les tâches en aval. Les résultats expérimentaux sont présentés dans le tableau suivant :

On peut constater qu'avec seulement un réglage fin de quelques paramètres, les performances du modèle d'OpenBMB ont dépassé le CPM-2 et la source 1.0 sur trois ensembles de données.

Certaines tâches (telles que LCSTS) peuvent être difficiles à apprendre lorsqu'il y a très peu de paramètres affinés. Le processus de formation de CPM-Live se poursuivra et les performances de chaque tâche seront encore peaufinées.

Les étudiants intéressés peuvent visiter le lien GitHub ci-dessous pour découvrir CPM-Ant et OpenDelta en premier, et explorer davantage les capacités de CPM-Ant sur d'autres tâches !

https://github.com/OpenBMB/CPM-Live

Une série de méthodes d'inférence respectueuses du matériel

Les performances des grands modèles sont étonnantes, mais des exigences matérielles et des coûts de fonctionnement élevés ont a toujours été un problème pour de nombreux utilisateurs. Pour les utilisateurs de grands modèles, OpenBMB propose une série de méthodes d'utilisation respectueuses du matériel, qui permettent d'exécuter plus facilement différentes versions de modèles dans différents environnements matériels.

Grâce à la boîte à outils BMInf[4], CPM-Ant peut fonctionner dans un environnement à faibles ressources tel qu'une seule carte 1060 !

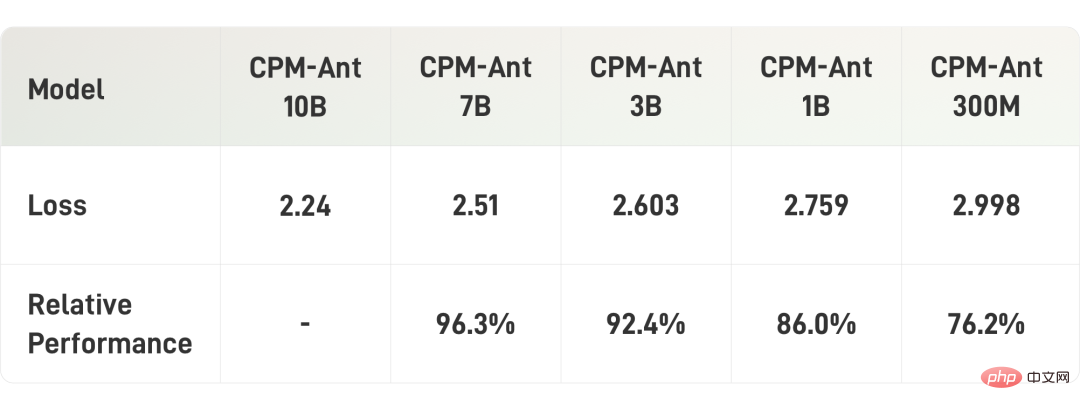

De plus, OpenBMB compresse également CPM-Ant. Ces modèles compressés incluent CPM-Ant-7B/3B/1B/0.3B. Toutes ces tailles de compression de modèles peuvent correspondre aux tailles classiques des modèles de langage open source pré-entraînés existants.

Étant donné que les utilisateurs peuvent effectuer un développement ultérieur sur les points de contrôle publiés, OpenBMB utilise principalement l'élagage structuré indépendant des tâches pour compresser CPM-Ant. Le processus de taille est également progressif, c'est-à-dire de 10B à 7B, de 7B à 3B, de 3B à 1B et enfin de 1B à 0,3B.

Dans le processus d'élagage spécifique, OpenBMB formera une matrice de masque dynamique apprenable, puis utilisera cette matrice de masque pour élaguer les paramètres correspondants. Enfin, les paramètres sont élagués en fonction du seuil de la matrice de masque, qui est déterminé en fonction de la parcimonie cible. Pour plus de détails sur la compression, veuillez vous référer au blog technique [5].

Le tableau suivant montre les résultats de la compression du modèle :

Maintenant que le contenu hardcore est terminé, comment le grand modèle peut-il nous aider à « obtenir le titre » ?

Une application amusante et inattendue de grands modèles

Basée sur CPM-Ant, tous les développeurs et passionnés de grands modèles peuvent développer des applications textuelles intéressantes.

Afin de vérifier davantage l'efficacité du modèle et de fournir des exemples, OpenBMB a affiné un générateur de titres basé sur CPM-Ant pour démontrer les capacités du modèle.

Collez simplement le contenu du texte dans la zone de texte ci-dessous, cliquez pour le générer, et vous pourrez obtenir le titre passionnant fourni par le grand modèle !

Le titre du premier article du rapport de résultats CPM-Ant est généré par le générateur

Cette démo sera continuellement peaufinée et d'autres effets spéciaux seront ajoutés à l'avenir pour améliorer l'expérience utilisateur

Les utilisateurs intéressés peuvent également utiliser CPM-Ant pour créer leurs propres applications d'affichage. Si vous avez des idées d'application, avez besoin d'assistance technique ou rencontrez des problèmes lors de l'utilisation de la démo, vous pouvez lancer une discussion sur le forum CPM-Live [6] à tout moment !

La sortie de CPM-Ant est la première étape de CPM-Live, mais ce n'est que la première phase de formation qu'OpenBMB continuera à mener une série de formations à l'avenir.

Petit spoiler, la prochaine session de formation ajoutera de nouvelles fonctionnalités telles que le support multilingue, les entrées et sorties structurées, etc. Bienvenue à tous pour continuer à faire attention !

Portail|Lien du projet

Adresse GitHub du projet :

https://github.com/OpenBMB/CPM-Live

Adresse de l'expérience de démonstration (accès PC uniquement) :

https : //live.openbmb.org/ant

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

Recommandé : Excellent projet de détection et de reconnaissance des visages open source JS

Apr 03, 2024 am 11:55 AM

Recommandé : Excellent projet de détection et de reconnaissance des visages open source JS

Apr 03, 2024 am 11:55 AM

La technologie de détection et de reconnaissance des visages est déjà une technologie relativement mature et largement utilisée. Actuellement, le langage d'application Internet le plus utilisé est JS. La mise en œuvre de la détection et de la reconnaissance faciale sur le front-end Web présente des avantages et des inconvénients par rapport à la reconnaissance faciale back-end. Les avantages incluent la réduction de l'interaction réseau et de la reconnaissance en temps réel, ce qui réduit considérablement le temps d'attente des utilisateurs et améliore l'expérience utilisateur. Les inconvénients sont les suivants : il est limité par la taille du modèle et la précision est également limitée ; Comment utiliser js pour implémenter la détection de visage sur le web ? Afin de mettre en œuvre la reconnaissance faciale sur le Web, vous devez être familier avec les langages et technologies de programmation associés, tels que JavaScript, HTML, CSS, WebRTC, etc. Dans le même temps, vous devez également maîtriser les technologies pertinentes de vision par ordinateur et d’intelligence artificielle. Il convient de noter qu'en raison de la conception du côté Web

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles